반년 넘게 텍스트를 이미지로 변환한 후 Meta 및 Google과 같은 거대 기술 기업은 텍스트를 비디오로라는 새로운 전장에 시선을 돌렸습니다.

지난 주 Meta는 고품질의 짧은 동영상을 생성할 수 있는 도구인 Make-A-Video를 발표했습니다. 이 도구를 사용하여 생성된 동영상은 매우 상상력이 풍부합니다.

물론 Google도 뒤처지지 않습니다. 방금 이 회사의 CEO인 Sundar Pichai는 Imagen Video와 Phenaki라는 두 가지 텍스트-비디오 도구인 이 분야의 최신 성과를 직접 발표했습니다. 전자는 영상 품질에 초점을 맞춘 반면, 후자는 주로 영상 길이에 중점을 두었습니다. 각각의 장점이 있다고 할 수 있습니다.

아래 설거지를 하는 테디베어는 Imagen Video를 사용하여 생성되었습니다. 보시다시피 사진의 해상도와 일관성이 어느 정도 보장됩니다.

생성 모델링은 DALL-E 2, Imagen, Parti, CogView 및 Latent Diffusion과 같은 최근 텍스트-이미지 AI 시스템에서 상당한 발전을 이루었습니다. . 특히 확산 모델은 밀도 추정, 텍스트-음성, 이미지-이미지, 텍스트-이미지 및 3D 합성과 같은 다양한 생성 모델링 작업에서 큰 성공을 거두었습니다.

Google이 원하는 것은 텍스트에서 비디오를 생성하는 것입니다. 이전 비디오 생성 작업은 자기회귀 모델, 자기회귀 사전확률을 사용한 잠재변수 모델, 그리고 최근에는 비자기회귀 잠재변수 방법을 사용하는 제한된 데이터세트에 중점을 두었습니다. 확산 모델은 또한 뛰어난 중해상도 비디오 생성 기능을 보여주었습니다.

이를 바탕으로 Google은 계단식 비디오 확산 모델을 기반으로 한 텍스트 조건부 비디오 생성 시스템인 Imagen Video를 출시했습니다. 텍스트 프롬프트가 주어지면 Imagen Video는 고정된 T5 텍스트 인코더, 기본 비디오 생성 모델, 계단식 시공간 비디오 초해상도 모델로 구성된 시스템을 통해 고화질 비디오를 생성할 수 있습니다.

논문 주소: https://imagen.research.google/video/paper.pdf

논문에서 구글은 시스템을 고화질 텍스트로 확장하는 방법을 자세히 설명합니다. 특정 해상도에서 완전히 컨벌루션된 시공간 초해상도 모델을 선택하고 확산 모델의 v-매개변수화를 선택하는 등의 설계 결정을 포함한 비디오 모델. Google은 또한 이전의 확산 기반 이미지 생성 연구 결과를 비디오 생성 설정으로 성공적으로 마이그레이션했습니다.

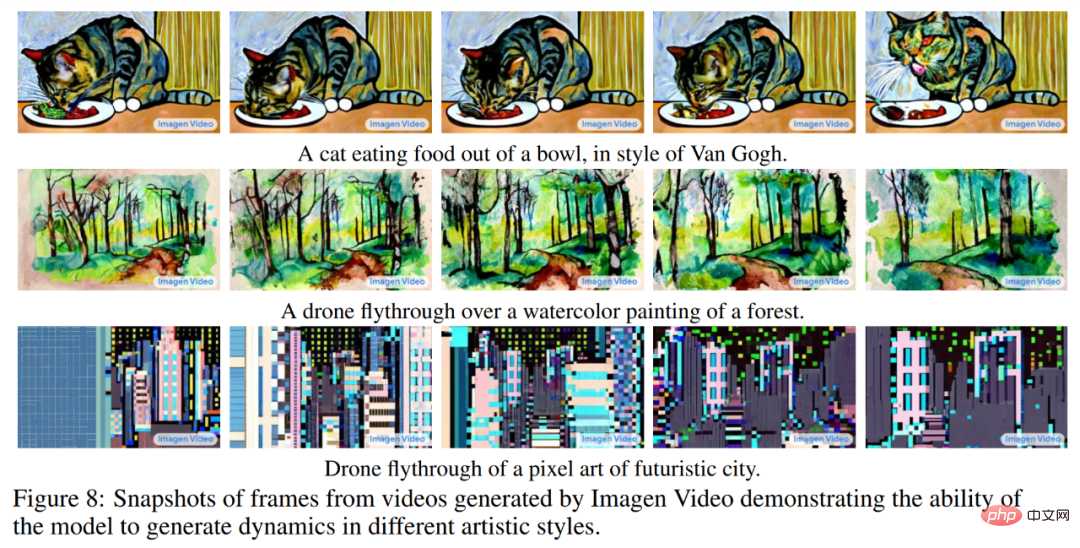

Google은 Imagen Video가 이전 작업에서 생성된 24fps 64프레임 128×128 비디오를 128프레임 1280×768 HD 비디오로 업스케일할 수 있다는 것을 발견했습니다. 또한 Imagen Video는 높은 수준의 제어 가능성과 세계 지식을 갖추고 있으며 다양한 예술적 스타일의 비디오 및 텍스트 애니메이션을 생성할 수 있으며 3D 객체 이해 기능을 갖추고 있습니다.

자동차를 운전하는 팬더 등 Imagen Video에서 생성된 추가 동영상을 감상해 보세요.

우주를 여행하는 나무 보트:

더 많은 동영상을 보려면 다음을 참조하세요. : https:/ /imagen.research.google/video/

방법 및 실험

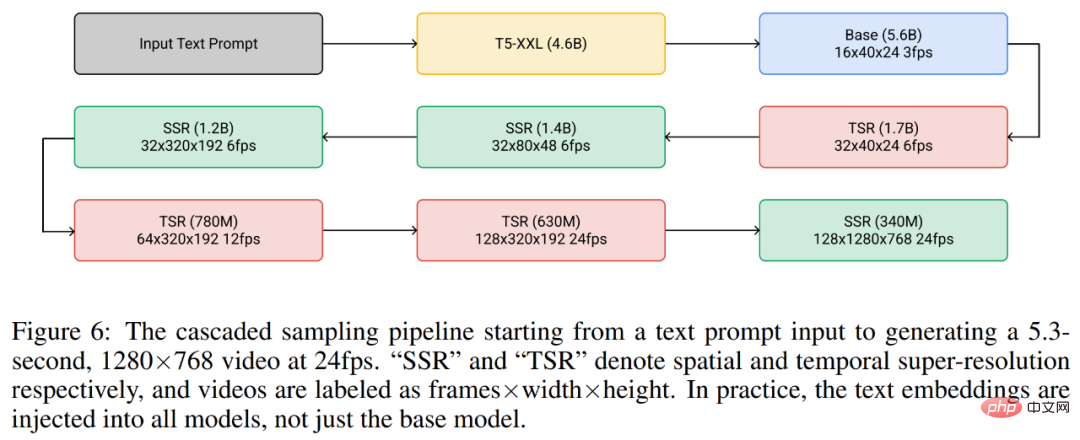

전체적으로 Google의 비디오 생성 프레임워크는 텍스트 조건부 비디오 생성, 공간 초해상도 및 시간 초해상도를 각각 수행하는 7개의 하위 비디오 확산 모델의 계단식입니다. 전체 캐스케이드를 사용하여 Imagen Video는 초당 24프레임으로 1280×768 HD 비디오(약 1억 2,600만 픽셀) 프레임 128개를 생성할 수 있습니다.

한편 Imagen Video는 점진적 증류의 도움으로 각 하위 모델에서 단 8개의 확산 단계를 사용하여 고품질 비디오를 생성합니다. 이를 통해 비디오 생성 시간이 약 18배 빨라집니다.

아래 그림 6은 고정된 텍스트 인코더 1개, 기본 비디오 확산 모델 1개, SSR(공간 초해상도) 3개, TSR(시간적 초해상도) 모델 3개를 포함한 Imagen Video의 전체 계단식 파이프라인을 보여줍니다. 7개의 비디오 확산 모델에는 총 116억 개의 매개변수가 있습니다.

생성 과정에서 SSR 모델은 모든 입력 프레임의 공간 해상도를 향상시키는 반면, TSR 모델은 입력 프레임 사이의 중간 프레임을 채워 시간 해상도를 향상시킵니다. 모든 모델은 전체 프레임 블록을 동시에 생성하므로 SSR 모델에 눈에 띄는 아티팩트가 발생하지 않습니다.

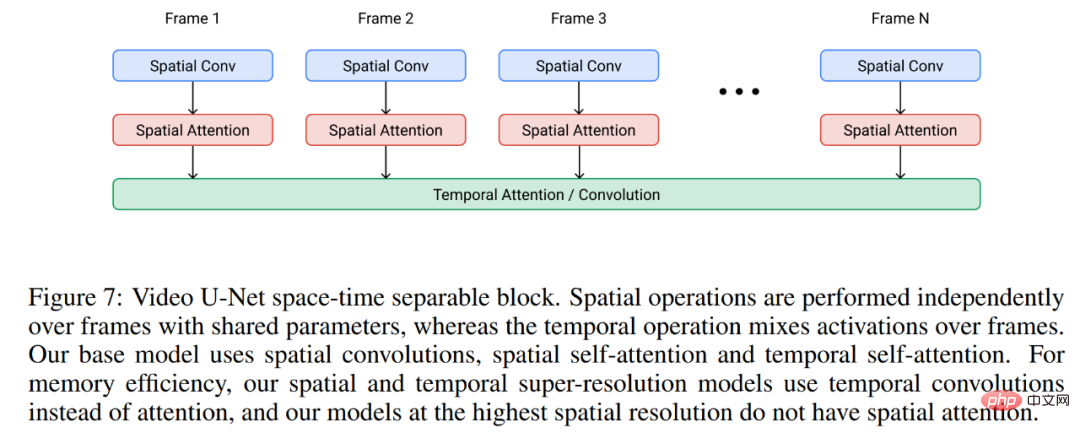

Imagen Video는 아래 그림 7과 같이 비디오 U-Net 아키텍처를 기반으로 구축되었습니다.

실험에서 Imagen Video는 공개적으로 사용 가능한 LAION-400M 이미지-텍스트 데이터세트, 1,400만 개의 비디오-텍스트 쌍 및 6,000만 개의 이미지-텍스트 쌍에 대해 훈련되었습니다. 결과적으로 위에서 언급한 것처럼 Imagen Video는 고화질 비디오를 생성할 수 있을 뿐만 아니라 순수하게 데이터로만 학습하는 비정형 생성 모델에는 없는 몇 가지 고유한 기능도 갖추고 있습니다.

아래 그림 8은 반 고흐의 그림 스타일이나 수채화 스타일 비디오와 같이 이미지 정보에서 학습된 예술적 스타일로 비디오를 생성하는 Imagen Video의 기능을 보여줍니다.

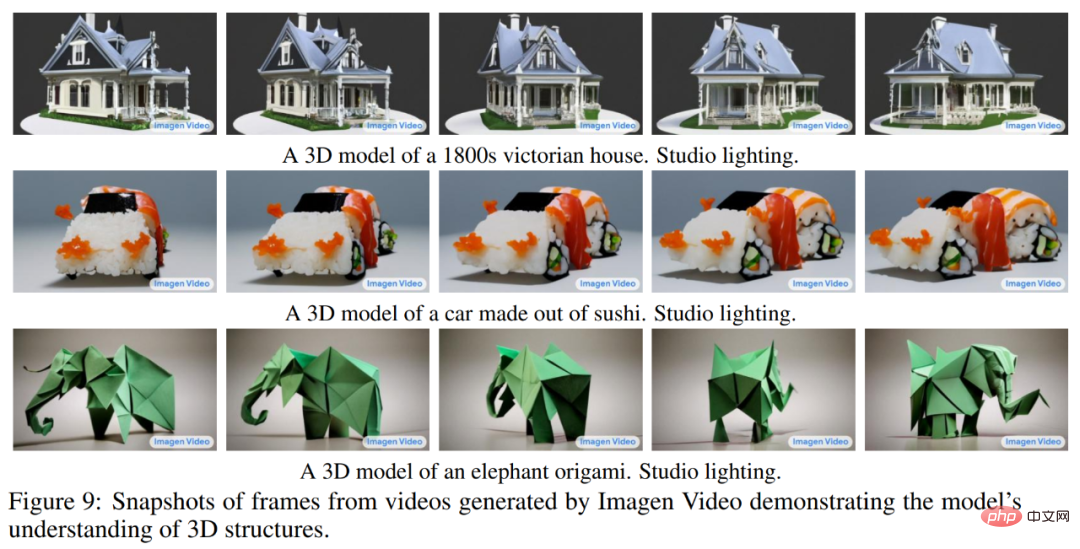

아래 그림 9는 물체의 일반적인 구조를 유지하면서 회전하는 물체의 비디오를 생성할 수 있는 Imagen Video의 3D 구조를 보여줍니다.

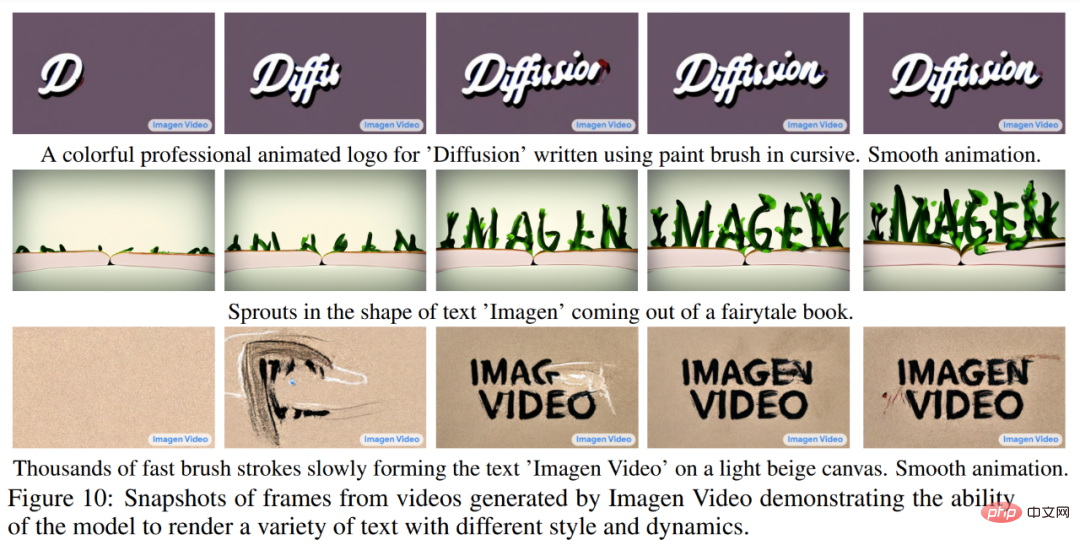

아래 그림 10은 Imagen Video가 다양한 애니메이션 스타일의 텍스트를 안정적으로 생성할 수 있는 방법을 보여줍니다. 그 중 일부는 기존 도구를 사용하여 생성하기 어렵습니다.

더 자세한 실험 내용은 원본 논문을 참고해주세요.

동영상은 본질적으로 일련의 이미지이지만 일관성 있는 긴 동영상을 생성하는 것이 그리 쉽지 않다는 것을 알고 있습니다. 데이터가 부족하고 작업 자체가 계산적으로 까다롭습니다.

더 문제가 되는 것은 이전처럼 이미지 생성에 사용되는 짧은 텍스트 프롬프트로는 일반적으로 동영상에 대한 완전한 설명을 제공하기에 충분하지 않다는 것입니다. 비디오에 필요한 것은 일련의 프롬프트나 스토리입니다. 이상적으로 비디오 생성 모델은 임의의 길이의 비디오를 생성할 수 있어야 하며 생성된 비디오 프레임을 특정 시간 t의 즉각적인 변화에 따라 조정할 수 있어야 합니다. 이 능력이 있어야만 모델이 생성한 작품을 "움직이는 이미지"가 아닌 "비디오"라고 부를 수 있으며, 예술, 디자인 및 콘텐츠 제작 분야에서 실제 창의적 응용의 길을 열 수 있습니다.

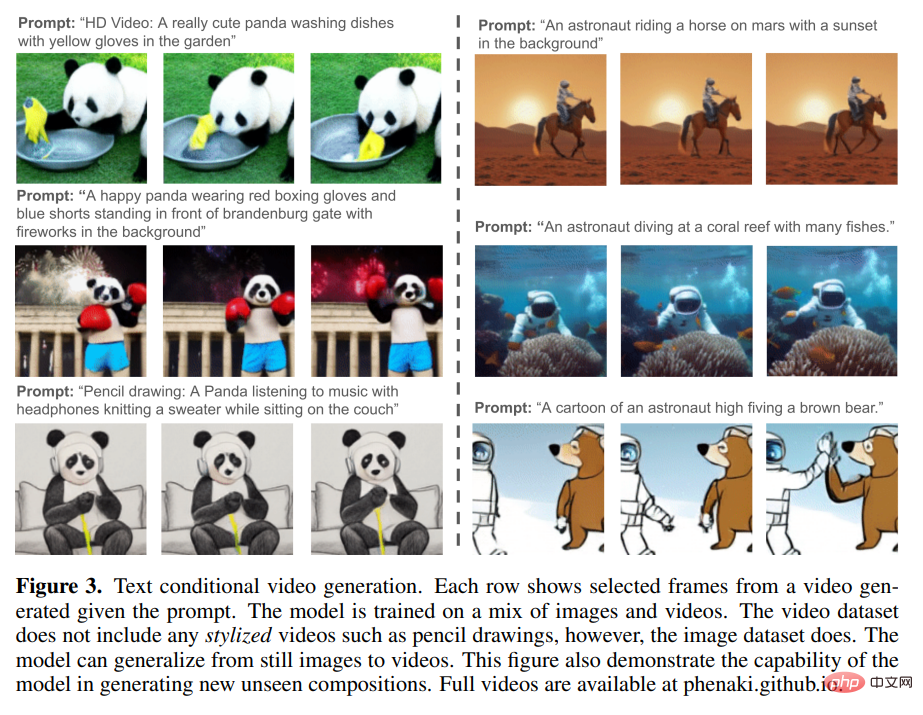

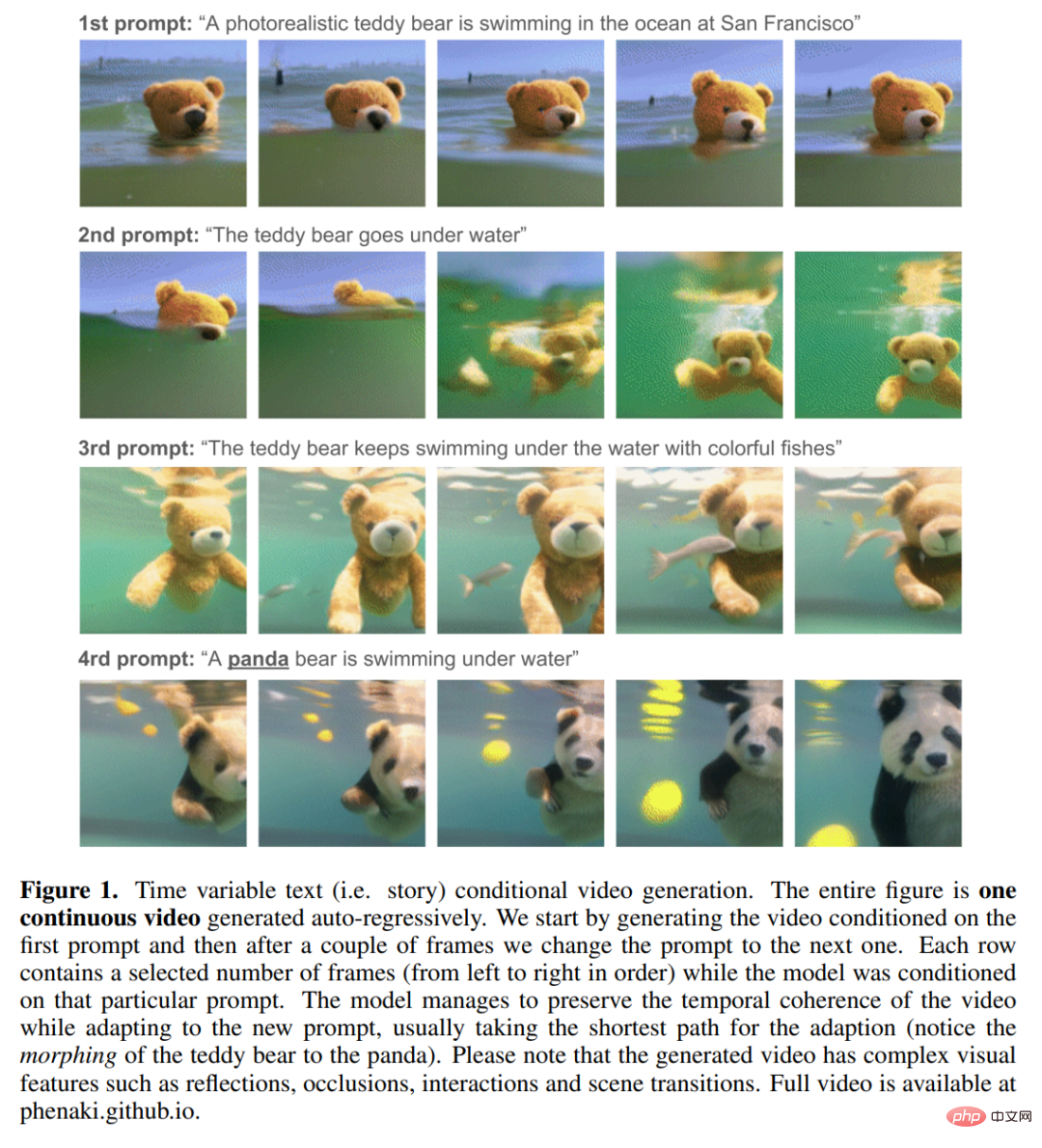

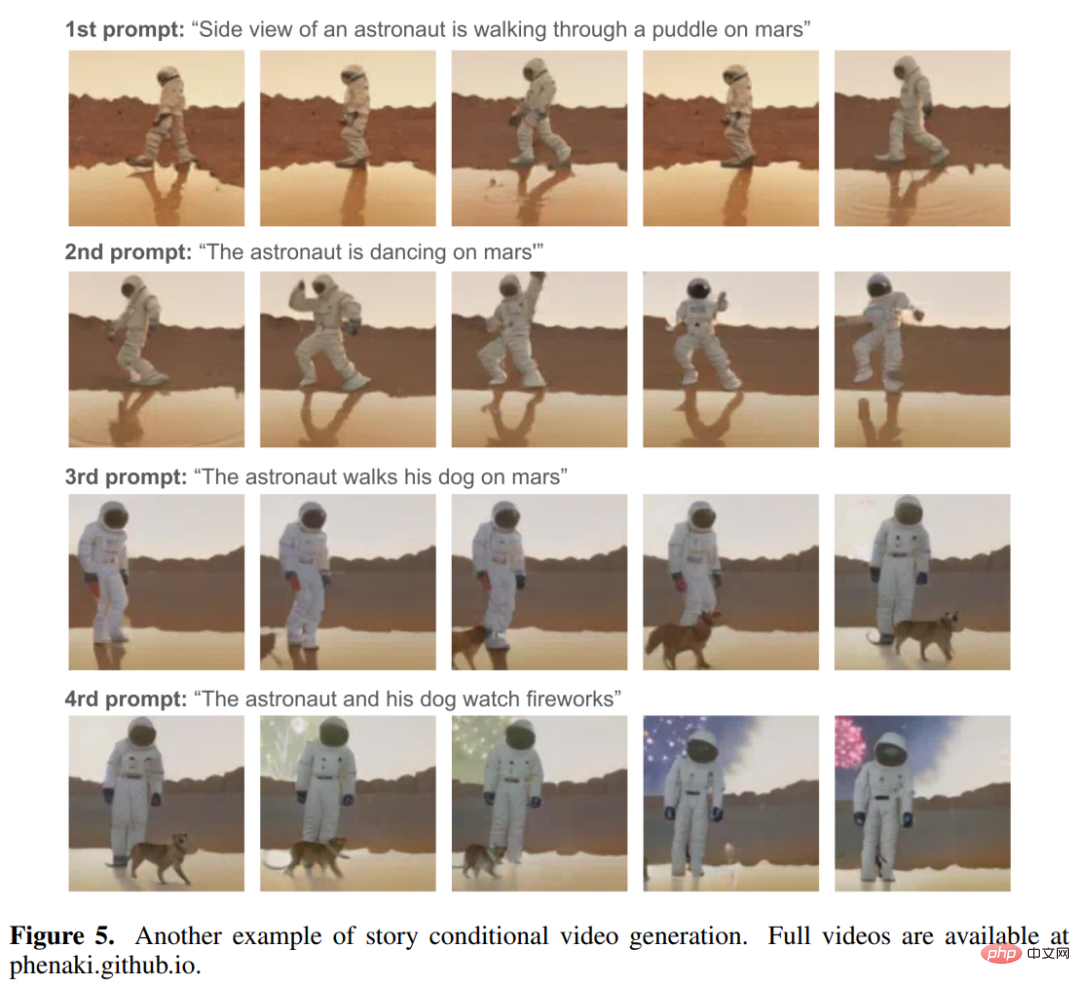

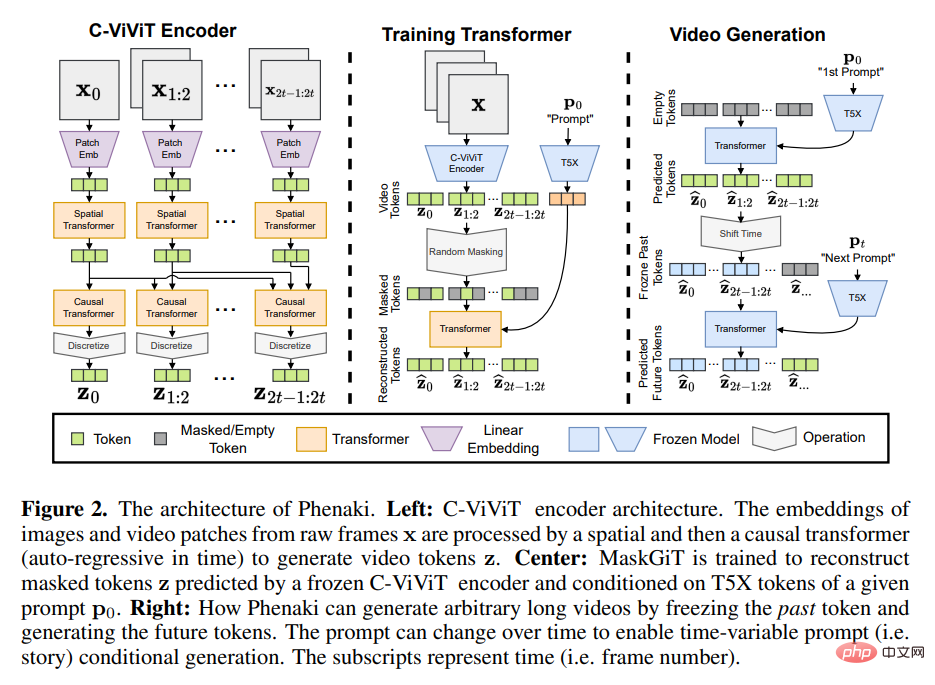

Google 및 기타 기관의 연구자들은 "우리가 아는 한 스토리 기반 조건부 비디오 생성은 이전에 탐구된 적이 없으며 이 목표를 향해 나아가는 최초의 초기 논문입니다."라고 말했습니다. 학습할 스토리 기반 데이터 세트가 없기 때문에 연구자는 이러한 작업을 완료하기 위해 기존의 딥 러닝 방법(단순히 데이터에서 학습)에만 의존할 방법이 없습니다. 그래서 그들은 이 작업을 수행하기 위해 특별히 모델을 설계했습니다. 이 새로운 텍스트-비디오 모델은 "텍스트-비디오" 및 "텍스트-이미지" 데이터를 사용하여 공동 학습하는 Phenaki라고 합니다. 모델에는 다음과 같은 기능이 있습니다. 1. 프롬프트가 새로운 개념의 조합이더라도 오픈 도메인 프롬프트 조건에서 시간적으로 일관성 있는 다양한 비디오를 생성합니다(아래 그림 3 참조). 모델 훈련에 사용된 비디오가 1.4초(8프레임/초)에 불과하더라도 생성된 비디오의 길이는 몇 분일 수 있습니다. 2. 스토리를 기반으로 비디오를 생성합니다(예: 일련의 프롬프트). ), 그림 1 및 아래 그림 5에 표시됨: 다음 애니메이션에서 Phenaki 생성 비디오의 일관성과 다양성을 볼 수 있습니다. 이러한 기능을 구현하려면 연구하세요. 기존 비디오 인코더는 고정된 크기의 비디오만 디코딩하거나 프레임을 독립적으로 인코딩할 수 있기 때문에 이에 의존할 수 없습니다. 이 문제를 해결하기 위해 그들은 새로운 인코더-디코더 아키텍처인 C-ViViT를 도입했습니다. C-ViViT는 다음을 수행할 수 있습니다. PHENAKI 모델 아키텍처 자동 회귀 텍스트-이미지 및 텍스트-비디오에 대한 이전 연구에서 영감을 받은 Phenaki의 디자인은 주로 두 부분으로 구성됩니다(아래 그림 2 참조). Discrete 임베딩(즉, 토큰)을 위한 인코더-디코더 모델과 텍스트 임베딩을 비디오 토큰으로 변환하는 변환기 모델입니다. 비디오의 압축된 표현을 얻는 것은 텍스트에서 비디오를 생성하는 데 있어 주요 과제 중 하나입니다. 이전 작업에서는 VQ-GAN과 같은 프레임별 이미지 인코더나 VideoVQVAE와 같은 고정 길이 비디오 인코더를 사용했습니다. 전자는 임의 길이의 비디오 생성을 허용하지만 실제로 사용 시에는 인코더가 비디오를 시간 내에 압축할 수 없고 토큰이 연속 프레임에서 매우 중복되기 때문에 비디오가 짧아야 합니다. 후자가 토큰 수 측면에서 더 효율적이지만 임의 길이의 비디오 생성을 허용하지 않습니다. Phenaki에서 연구원의 목표는 비디오 토큰 수를 최대한 압축하면서 가변 길이 비디오를 생성하여 현재 컴퓨팅 리소스 제약 내에서 Transformer 모델을 사용할 수 있도록 하는 것입니다. 이를 위해 그들은 비디오 생성을 위한 추가 아키텍처 변경을 포함하는 ViViT의 원인 변형인 C-ViViT를 도입합니다. 이는 시간적 자동 회귀를 유지하면서 시간적 및 공간적 차원 모두에서 비디오를 압축할 수 있습니다. 이 기능을 사용하면 임의 길이의 자동 회귀 비디오를 생성할 수 있습니다. 텍스트 임베딩을 얻기 위해 Phenaki는 사전 훈련된 언어 모델인 T5X도 사용합니다. 구체적인 내용은 원문을 참고해주세요.

위 내용은 이미지 생성에 지친 Google은 해상도와 길이를 동시에 도전하는 두 가지 강력한 도구인 텍스트 → 비디오 생성으로 전환했습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!