얼마 전 Yuanyu 지능형 개발 팀은 ChatGPT와 유사한 기능적 대화 대형 모델 ChatYuan을 훈련하고 웹 버전에서 평가판 인터페이스를 열었습니다.

이제 자신의 컴퓨터에 ChatYuan을 배포할 수도 있습니다!

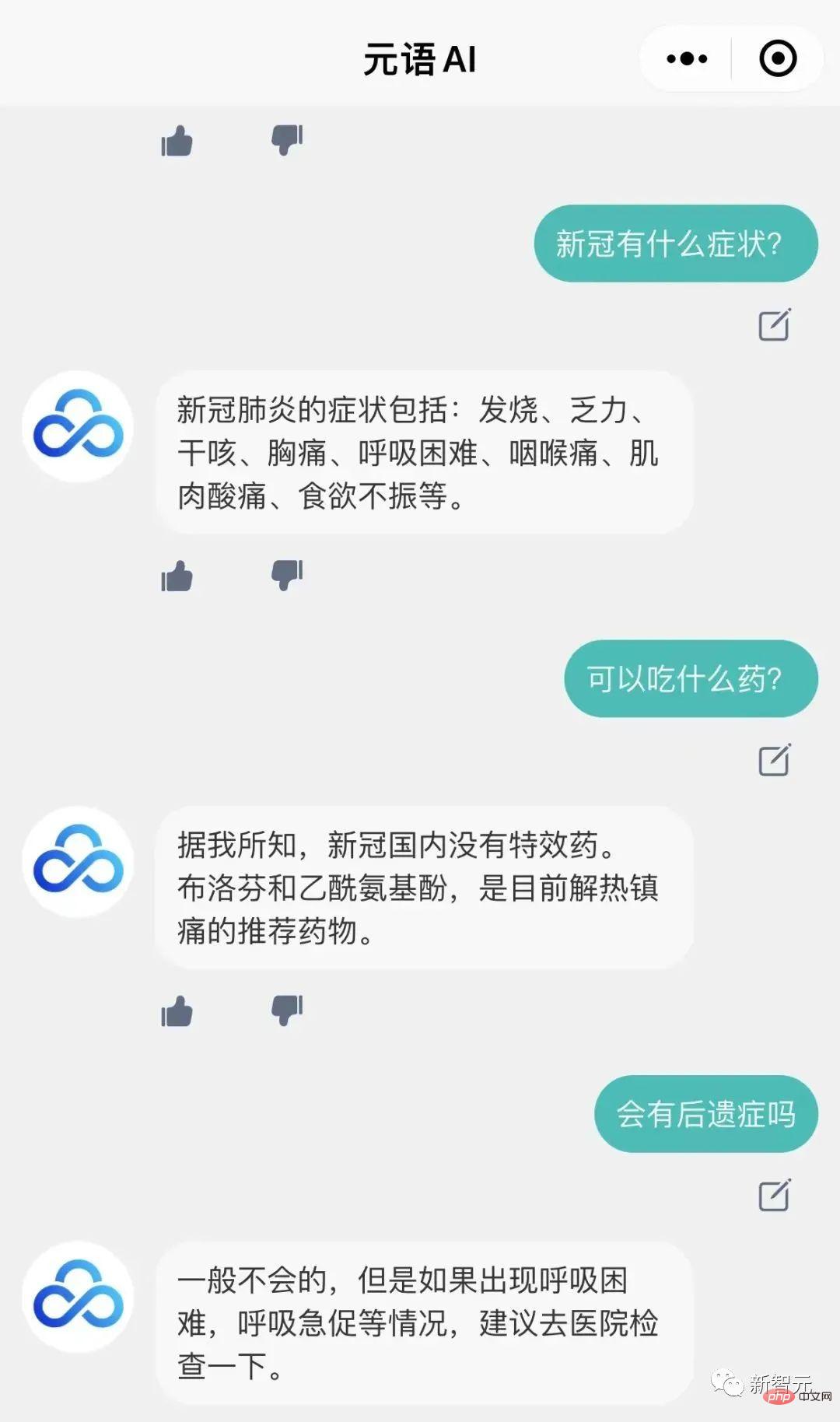

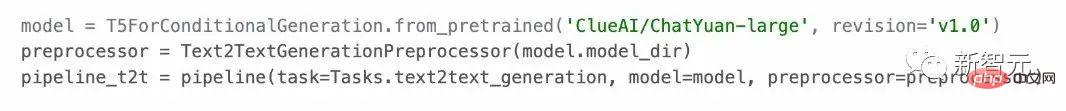

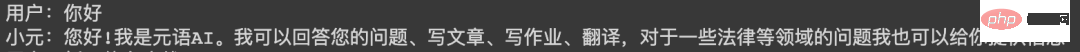

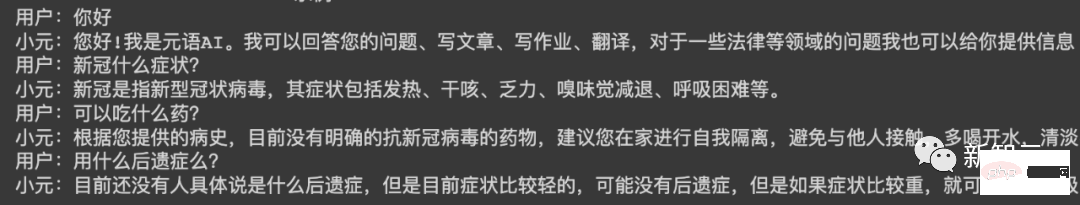

모델을 질의응답 시나리오에 활용할 수 있고, 문맥에 따른 대화 및 다양한 생성 작업을 진행할 수 있으며, 문예 창작도 가능하며, 법률, 코로나19 등 분야의 질문에도 답변할 수 있습니다. .

그리고 모든 중국어 과제에서 제로 샘플 학습을 지원합니다. 사용자는 프롬프트를 제공하여 사용할 수 있습니다. 텍스트 생성, 정보 추출 및 이해 카테고리에서 약 30가지 중국어 과제를 지원합니다.

ChatYuan은 수억 개의 기능적 질문 및 답변과 다단계 대화 데이터가 결합된 PromptCLUE-large를 기반으로 추가 학습됩니다. 이 모델은 7억 7천만 개의 매개변수와 약 6G의 비디오 메모리를 로드하고 사용할 수 있습니다. 해당 모델은 현재 다운로드가 가능합니다.

PromptCLUE는 1,000억 개의 토큰 중국어 코퍼스를 사전 학습하고, 총 1.5조 개의 중국어 토큰을 학습했으며, 수백 가지 작업에 대한 Prompt 작업 기반 교육을 진행합니다.

분류, 감정 분석, 추출 등과 같은 작업 이해를 위해 다양한 생성 작업에 맞게 라벨 시스템을 맞춤화할 수 있으며 샘플링을 자유롭게 생성할 수 있습니다.

1. Github

프로젝트 주소 : https://github.com/clue-ai/ChatYuan

2.

프로젝트 주소 : https://huggingface.co/ClueAI/ChatYuan-large-v1

3.모델스코프

프로젝트 주소: https://modelscope.cn/models/ClueAI/ChatYuan-large

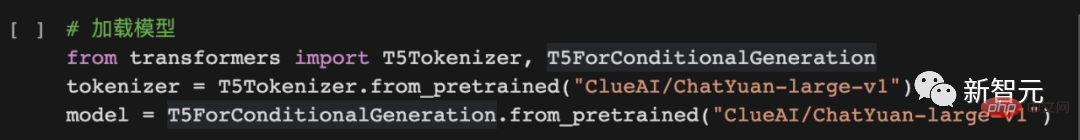

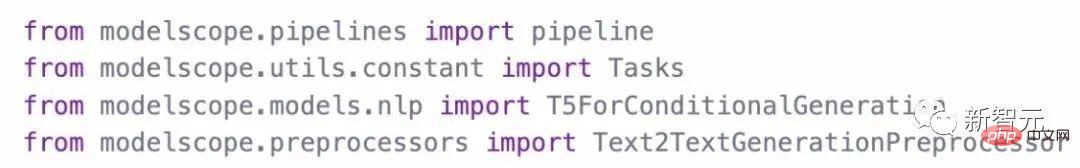

모델 로드:

예측 추론 모델 사용 방법 :

4.PaddlePaddle

프로젝트 주소 : https://aistudio.ba iduo.com du.com/aistudio/projectdetail /5404182

모델 주소: https://huggingface.co/ClueAI/ChatYuan-large-v1-paddle

1. 데이터 정리하기

데이터는 통일된 형식으로 구성되며 입력(Input)과 출력(Output)의 두 부분으로 구성됩니다.

1회 질문 및 답변 또는 생성:

입력: 작업 설명 + 입력 텍스트

출력: 시스템이 예측해야 하는 텍스트("Xiaoyuan" 다음에 표시됨) 아래 사진 내용입니다.

다중 대화의 경우:

입력: 작업 설명 + 위 + 입력 텍스트

출력: 아래 그림과 같이 시스템이 예측해야 하는 텍스트 "Xiao Yuan" 다음 내용.

단방향 대화 데이터 형식:

다단계 대화 데이터 형식:

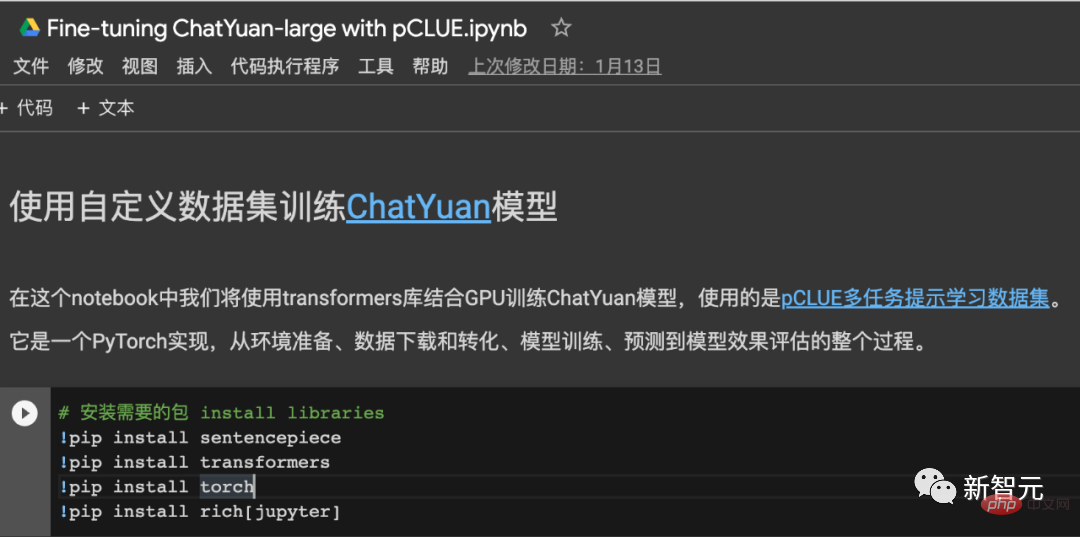

2. 훈련 모델

훈련 코드는 다음을 참조하세요.

훈련, 예측 및 효과 검증을 위한 pCLUE 데이터 세트 사용, pytorch 구현 - 온라인 Colab.

Github 프로젝트: https://colab.research.google.com/drive/1lEyFhEfoc-5Z5xqpEKkZt_iMaojH1MP_?usp=sharing

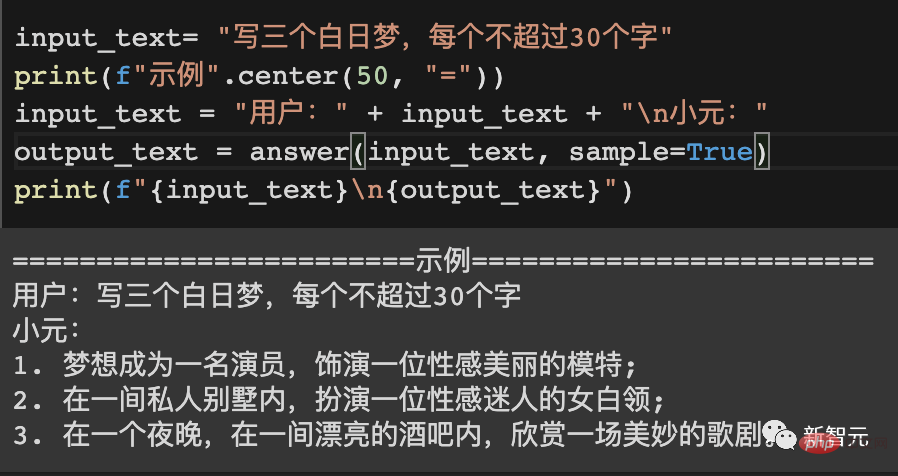

====== =====예시 1==========

사용자:

무엇을 할 수 있나요

Xiaoyuan:

안녕하세요! 저는 Yuanyu AI입니다. 귀하의 질문에 답변하고, 기사를 작성하고, 과제를 작성하고, 번역할 수 있으며 법률 및 기타 분야의 문제에 대한 정보도 제공할 수 있습니다.

==========예 2==========

사용자:

겨울에 대한 시를 써 보세요

Xiao Yuan:

겨울밤은 조용하고 차갑고,

구름이 하늘에 떠있고,

얼어붙은 하얀 눈 위에,

눈처럼 차갑습니다.

눈송이가 얼음이 되어

눈이 내리는 것처럼

추운 겨울,

봄의 기쁨을 느껴보세요.

겨울에는

바람과 눈이 점차 그치고,

침묵이 있었고,

집에 행복과 따뜻함을 가져다주세요.

==========예 3==========

사용자:

유치원 교육 전공 인턴십에서 학생에 대한 측면 문제가 있을 수 있으니 개선방안을 제안해주세요. 800 단어

Xiaoyuan:

유치원 교육 전공 인턴십 중에는 학생들의 전문 지식 부족, 협력 의식 부족, 기본 책임감 부족, 등, 우리는 이러한 문제를 해결하기 위한 조치를 취해야 합니다.

우선, 인턴십 과정에서 학생들의 팀의식 함양, 학생과 교사 간 협력 강화, 학부모와의 소통 강화, 의사소통 능력 향상이 필요합니다. 또한 학생들의 독립성을 강화하고, 학생들이 독립적으로 생각하는 법을 배우며, 교사 및 부모와 의사소통하는 법을 배우며, 독립성을 배양해야 합니다.

또한 일상 업무에서 학생들에게 적절한 기회와 기회를 제공하여 학생들이 사회와 더 많이 접촉하고 더 많은 사회 활동에 참여할 수 있도록 해야 하며, 사회와 학교에 대한 이해를 심화하고 주도성을 키울 수 있어야 합니다. , 긍정과 혁신의 정신.

마지막으로 학생들이 인턴십 중에 겪는 문제, 특히 학생들의 협동심 부족, 의존성, 공유 방법을 모르거나 미루는 습관 등에도 주의를 기울여야 합니다. 이러한 학생들은 우리의 관심을 끌고 합리적인 개선 방안을 마련해야 합니다. , 이러한 문제를 개선합니다.

ChatYuan은 PromptCLUE를 기반으로 추가 교육을 통해 얻은 모델입니다. 텍스트 이해 및 정보 추출 작업을 제거하고 질문 및 답변, 대화 및 다양한 생성 작업의 학습 및 훈련을 강화합니다. 모델이 필요할 때 관련 없는 컨텍스트를 무시할 수 있도록 추가됩니다. 사용자 피드백 데이터 학습이 추가되어 모델은 특정 일반 언어 이해 기능과 특정 작업 생성 기능을 가질 뿐만 아니라 사용자 의도에 더 잘 대응할 수 있습니다.

PromptCLUE 학습 과정

현재 버전에서는 질문과 답변, 대화 및 다양한 창의적 글쓰기 또는 텍스트 생성을 수행할 수 있습니다. 온라인 버전과 비교하면 일부 상황에서는 의도 이해 및 생성 기능이 여전히 상당한 개선의 여지가 있으며 추론이나 복잡한 작업을 제대로 수행할 수 없습니다. 기존 버전은 피드백을 바탕으로 더욱 개선될 예정입니다.

위 내용은 국내 ChatGPT 배포에는 비디오 메모리 6G만 필요합니다! ChatYuan 모델 다운로드 가능: 업계 최초의 기능적 대화 오픈 소스 중국 대형 모델의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!