2022년에는 '원성투' 모델이 인기를 끌 것 같은데, 2023년에는 어떤 모델이 인기를 끌까요?

기계 학습 엔지니어 Daniel Bourke의 대답은 다음과 같습니다. 그 반대입니다!

아니요, 새로 출시된 '그림 기반 텍스트' 모델이 인터넷에서 폭발적인 인기를 얻었고, 그 뛰어난 효과로 인해 많은 네티즌들이 다시 게시하고 좋아요를 눌렀습니다.

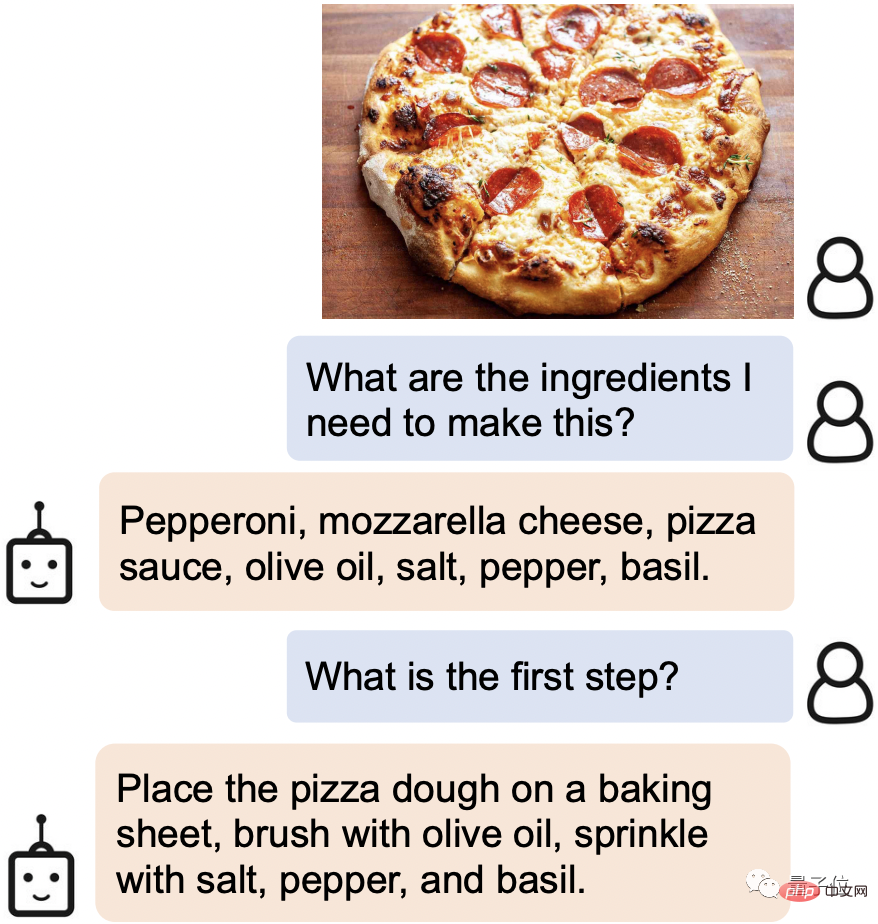

기본적인 "그림을 보고 대화하기" 기능뿐만 아니라, 사랑의 시 쓰기, 줄거리 설명, 그림 속 물체에 대한 대화 디자인 등 모든 기능을 원활하게 처리할 수 있는 AI입니다!

예를 들어, 온라인에서 맛있는 음식을 찾았을 때 사진을 보내면 필요한 재료와 요리 단계가 즉시 인식됩니다.

사진에 있는 일부 음식도 Leeuwenhoek의 세부 정보일 수도 있습니다. 분명히 "봤다".

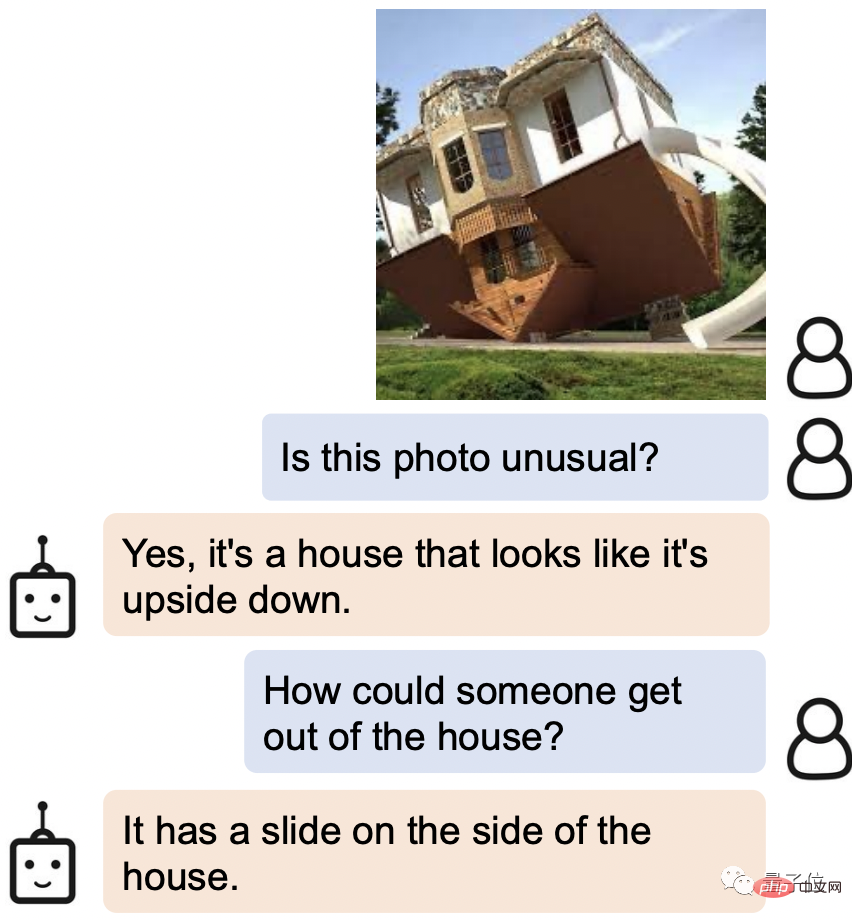

사진 속 뒤집힌 집에서 어떻게 빠져나오느냐고 묻자 AI의 대답은: 옆쪽에 미끄럼틀이 있는 거 아닌가요?

이 새로운 AI는 BLIP-2(Bootstrapping Language-Image Pre-training 2)라고 불리며, 코드는 현재 오픈 소스입니다.

가장 중요한 점은 BLIP-2는 이전 연구와 달리 보편적인 사전 학습 프레임워크를 사용하기 때문에 자신의 언어 모델에 임의로 연결할 수 있다는 점입니다.

일부 네티즌들은 인터페이스를 ChatGPT로 바꾼 후 이미 강력한 조합을 고민하고 있습니다.

저자 중 한 명인 Steven Hoi는 BLIP-2가 미래에 "ChatGPT의 다중 모드 버전"이 될 것이라고 말했습니다.

그렇다면 BLIP-2의 또 다른 놀라운 점은 무엇일까요? 함께 아래를 내려다보세요.

BLIP-2는 게임 플레이가 매우 다양하다고 할 수 있습니다.

사진만 제공하면 대화도 가능하고 스토리텔링, 추론, 개인화된 텍스트 생성 등 다양한 요구사항을 충족할 수 있습니다.

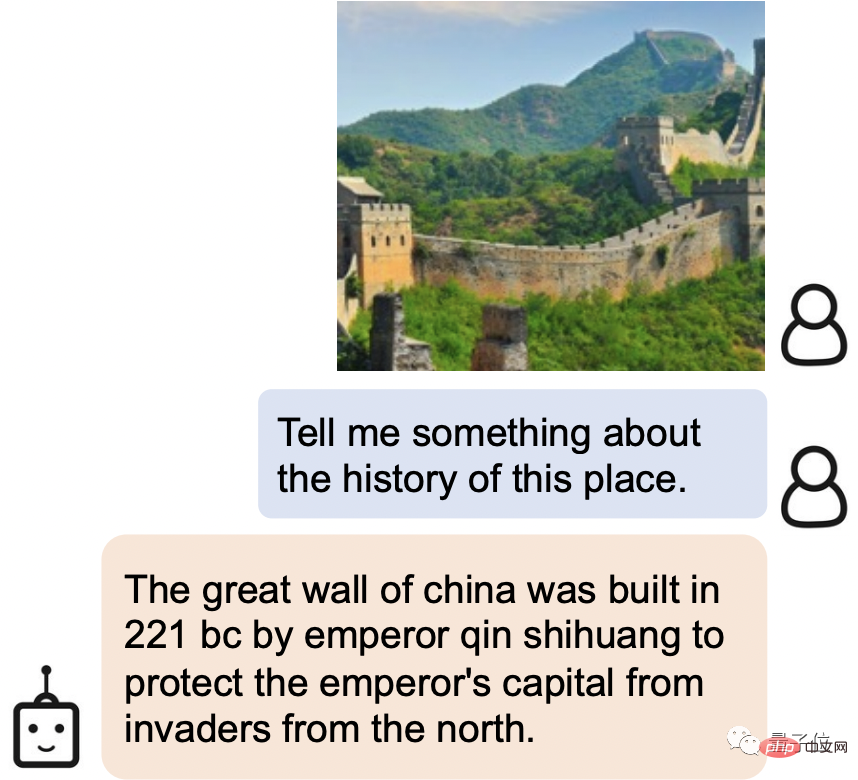

예를 들어 BLIP-2는 사진 속의 명승지를 만리장성으로 쉽게 식별할 수 있을 뿐만 아니라 만리장성의 역사도 소개합니다.

중국의 만리장성은 기원전 221년에 진시황이 건설했습니다. 북방의 침략으로부터 제국의 수도를 지켜라.

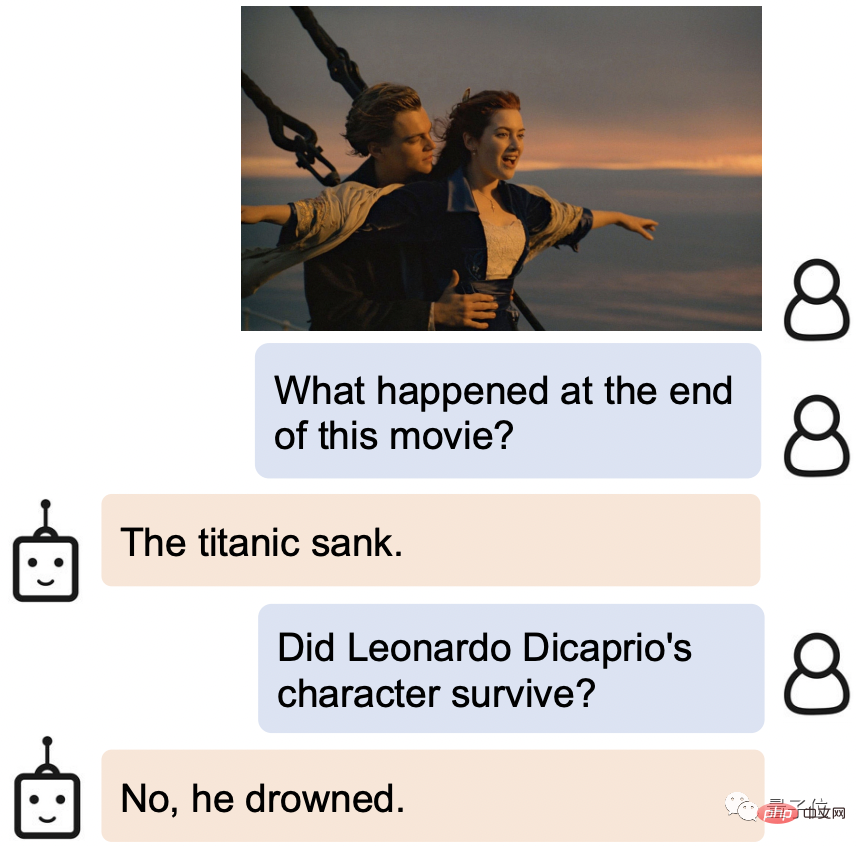

영화 스틸을 제공하면 BLIP-2는 그것이 어디서 왔는지 알 뿐만 아니라 이야기의 결말도 알고 있습니다. 즉, 타이타닉이 침몰하고 영웅이 익사했습니다.

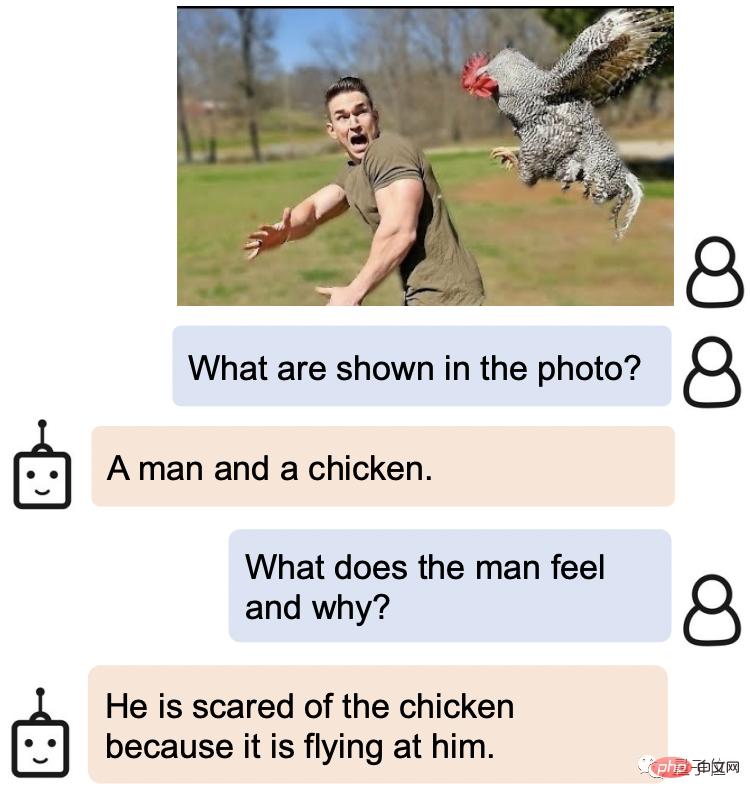

BLIP-2는 인간의 표정도 매우 정확하게 파악하고 있습니다.

사진 속 남자의 표정이 어떠하며 왜 그러냐는 질문에 BLIP-2의 대답은 "닭이 자신을 향해 날아오니까 무서워서였다"고 답했습니다.

더 놀라운 점은 BLIP-2가 많은 공개 질문에서도 매우 좋은 성능을 발휘한다는 것입니다.

아래 그림을 바탕으로 로맨틱한 문장을 쓰도록 요청하세요.

답은 다음과 같습니다. 사랑은 일몰과 같아서, 다가오는 것을 보기 힘들지만, 일어나면 너무 아름답습니다.

이 분은 완벽한 이해력을 가지고 있을 뿐만 아니라, 문학적 소양도 뛰어납니다!

그림 속 두 동물에 대한 대화를 생성하도록 하세요. BLIP-2는 오만한 고양이 x 바보 개 설정도 쉽게 처리할 수 있습니다.

고양이: 야 개야, 네 등에 올라타도 될까?

개: 물론이죠, 왜 안 되겠어요?

고양이: 눈밭을 걷는데 지쳤어요.

그렇다면 BLIP-2는 어떻게 이렇게 강력한 이해 능력을 발휘할 수 있을까요?

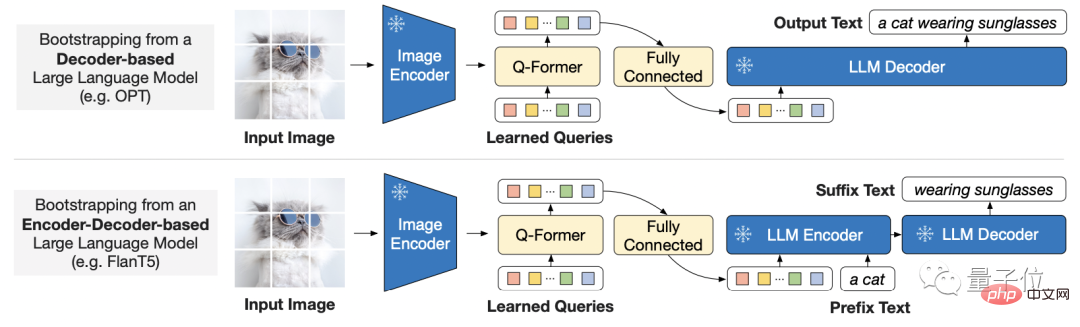

대규모 모델의 엔드 투 엔드 교육 비용 증가를 고려하여 BLIP-2는 일반적이고 효율적인 사전 교육 전략을 사용합니다.

기성품에서 고정된 사전 학습된 이미지 인코더 및 고정된 대규모 언어 모델의 안내된 시각적 언어 사전 학습입니다.

이는 누구나 자신이 사용하고 싶은 모델을 선택할 수 있다는 의미이기도 합니다.

모드 간 격차를 해소하기 위해 연구원은 경량 쿼리 변환기를 제안했습니다.

이 Transformer는 두 단계로 사전 훈련됩니다.

첫 번째 단계는 고정 이미지 인코더에서 학습하는 시각적 언어 표현을 부트스트랩하고, 두 번째 단계는 고정 언어 모델에서 언어 생성 학습까지 비전을 부트스트랩합니다.

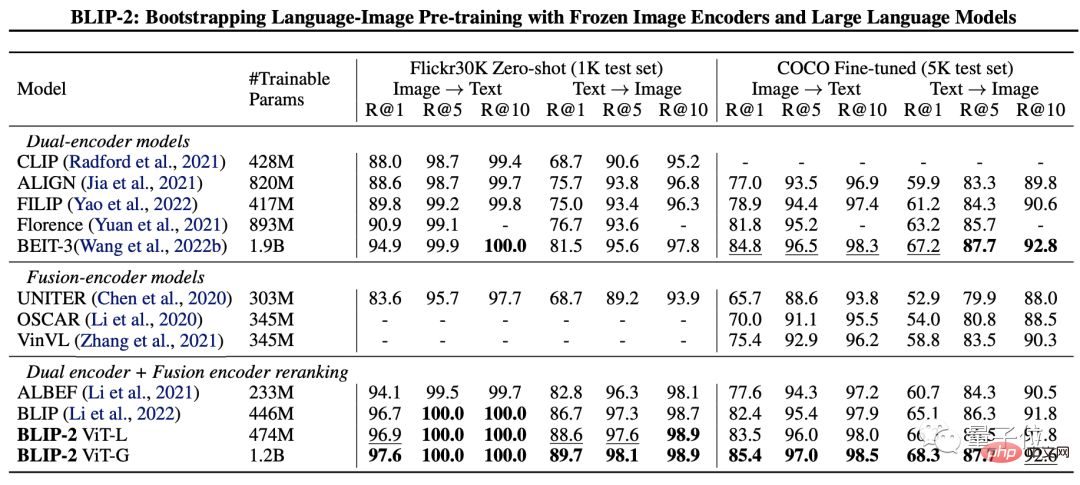

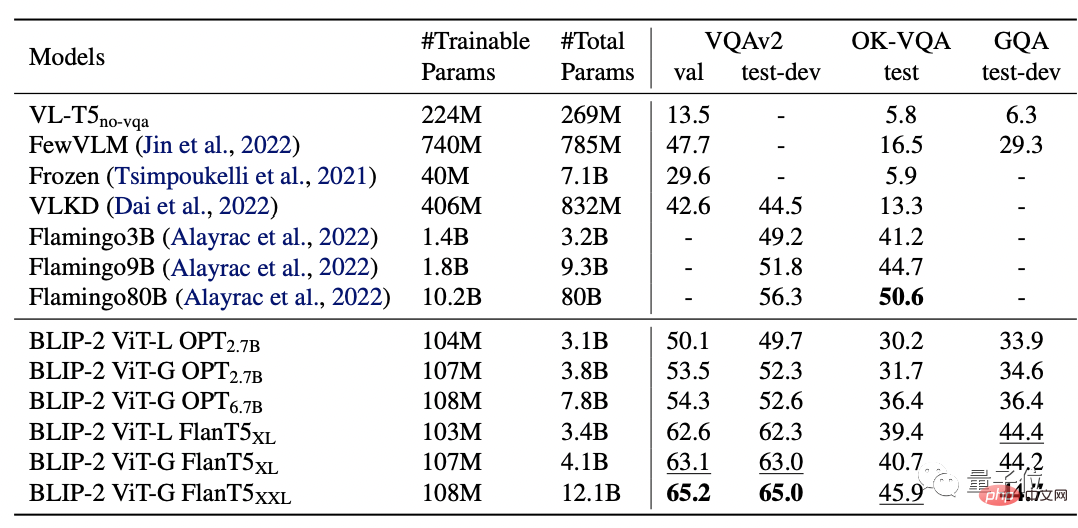

연구진은 BLIP-2의 성능을 테스트하기 위해 제로샷 이미지 텍스트 생성, 시각적 질문 답변, 이미지 텍스트 검색 및 이미지 캡션 작업에 대해 평가했습니다.

최종 결과는 BLIP-2가 여러 시각적 언어 작업에서 SOTA를 달성한 것으로 나타났습니다.

그 중 BLIP-2는 제로샷 VQAv2에서 Flamingo 80B보다 8.7% 더 높고 훈련 매개변수가 54배 감소했습니다.

그리고 더 강력한 이미지 인코더나 더 강력한 언어 모델이 더 나은 성능을 제공한다는 것은 분명합니다.

연구원은 논문 끝부분에서 BLIP-2가 여전히 단점, 즉 맥락 학습 능력이 부족하다는 점을 언급했다는 점을 언급할 가치가 있습니다.

각 샘플에는 하나의 이미지만 포함되어 있습니다. 텍스트 쌍, 현재 단일 시퀀스에서 여러 이미지-텍스트 쌍 간의 상관 관계를 학습하는 것은 불가능합니다.

BLIP-2의 연구팀은 Salesforce Research 소속입니다.

제1저자는 1년 전 런칭한 BLIP의 제1저자이기도 한 Junnan Li입니다.

현재 세일즈포스 아시아 연구소의 선임연구원이다. 홍콩대학교에서 학사, 싱가포르 국립대학교에서 박사학위를 취득했습니다.

자기 지도 학습, 준지도 학습, 약한 지도 학습, 시각 언어 등 연구 분야가 매우 넓습니다.

다음은 BLIP-2의 논문 링크와 GitHub 링크입니다. 관심 있는 친구들은 골라보세요~

페이퍼 링크: https://arxiv.org/pdf/2301.12597.pdf

GitHub 링크: https: / /github.com/salesforce/LAVIS/tree/main/projects/blip2

참조 링크: [1]https://twitter.com/mrdbourke/status/1620353263651688448

[2]https://twitter. /LiJunnan0409/status/1620259379223343107

위 내용은 ChatGPT에게 사진 읽는 방법을 가르치는 방법은 다음과 같습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!