쑨원대학교 인간-기계 지능 융합 연구소(HCP)는 AIGC 및 다중 모드 대형 모델에서 유익한 성과를 거두었으며 최근 AAAI 2023 및 CVPR 2023에서 10개 이상의 논문에 선정되었습니다. 글로벌 연구 기관의 첫 번째 계층입니다.

작업 중 하나는 인과 모델을 사용하여 튜닝 시 다중 모달 대형 모델의 제어 가능성과 일반화를 크게 개선한 것입니다. "마스크된 이미지는 강력한 미세 조정을 위한 반사실 샘플입니다."

링크: https://arxiv.org/abs/2303.03052

사전 훈련된 대규모 모델을 사용하여 다운스트림 작업을 미세 조정하는 것은 현재 인기 있는 딥 러닝 패러다임입니다. . 특히, 최근 사전 학습된 대규모 언어 모델인 ChatGPT의 뛰어난 성능으로 인해 이러한 기술 패러다임이 널리 인식되었습니다. 대규모 데이터로 사전 학습한 후 이러한 대규모 사전 학습 모델은 실제 환경에서 변화하는 데이터 분포에 적응할 수 있으므로 일반 시나리오에서 강력한 견고성을 보여줍니다.

그러나 미리 훈련된 대형 모델이 다운스트림 장면 데이터로 미세 조정되어 특정 애플리케이션 작업에 적응할 때 대부분의 경우 이러한 데이터는 특이합니다. 이러한 데이터를 사용하여 사전 훈련된 대형 모델을 미세 조정하면 모델의 견고성이 저하되어 사전 훈련된 대형 모델을 기반으로 적용하기가 어려워지는 경우가 많습니다. 특히 시각적 모델의 경우 이미지의 다양성이 언어를 훨씬 뛰어넘기 때문에 다운스트림 미세 조정 학습으로 인해 비전 관련 사전 학습된 대형 모델의 견고성이 저하되는 문제가 특히 두드러집니다.

이전 연구 방법은 일반적으로 모델 통합 및 기타 방법을 통해 모델 매개변수 수준에서 암시적으로 미세 조정된 사전 훈련된 모델의 견고성을 유지합니다. 그러나 이들 연구에서는 미세 조정이 모델의 분포를 벗어난 성능 저하로 이어지는 본질적인 이유를 분석하지 않았으며, 위에서 언급한 대형 모델의 미세 조정 후 견고성이 감소하는 문제를 명확하게 해결하지 못했습니다.

본 연구는 크로스 모달 대형 모델을 기반으로 사전 학습된 대형 모델의 강인성 손실에 대한 본질적인 이유를 인과성 관점에서 분석하고 이에 따라 모델의 강인성을 크게 향상시킬 수 있는 방법을 제안합니다. 모델을 미세 조정하세요. 이 방법을 사용하면 모델이 다운스트림 작업에 적응하면서 강력한 견고성을 유지할 수 있으며 실제 응용 프로그램의 요구 사항을 더 잘 충족할 수 있습니다.

2021년 OpenAI에서 출시한 대규모 교차 모달 사전 학습 모델 CLIP(Contrastive Language-Image Pre-training)을 예로 들어 보겠습니다. CLIP은 대조 이미지-텍스트를 기반으로 하는 대규모 교차 모달 사전 학습 모델입니다. 공동 학습 모델은 Stable Diffusion과 같은 생성 모델의 기초입니다. 이 모델은 약 4억 개의 이미지-텍스트 쌍이 포함된 대규모 다중 소스 데이터에 대해 훈련되었으며 어느 정도 분포 변화에 강력한 인과 관계를 학습합니다.

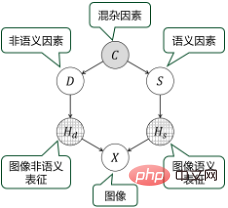

그러나 단일 기능 다운스트림 데이터로 CLIP을 미세 조정하는 경우 훈련 이미지의 비의미적 표현과 의미적 표현이 매우 얽혀 있기 때문에 모델에서 학습한 이러한 인과 지식을 파괴하기 쉽습니다. 예를 들어 CLIP 모델 전송을 "농장"의 다운스트림 시나리오에 적용하면 많은 훈련 이미지에 풀밭에 있는 "소"가 표시됩니다. 이 시점에서 미세 조정 훈련을 통해 모델은 잔디의 "소"가 아닌 의미론적 표현에 의존하여 이미지의 의미론을 예측하는 방법을 학습할 수 있습니다. 그러나 이 상관관계가 반드시 맞는 것은 아닙니다. 예를 들어 "소"가 도로에 나타날 수도 있습니다. 따라서 모델을 미세 조정하고 훈련한 후에는 견고성이 감소하고 적용 중 출력 결과가 극도로 불안정해지고 제어성이 부족해질 수 있습니다.

팀의 다년간의 대형 모델 구축 및 학습 경험을 바탕으로 이 작업은 사전 학습된 모델의 미세 조정으로 인해 발생하는 견고성 감소 문제를 인과 관계의 관점에서 재검토합니다. 인과관계 모델링 및 분석을 기반으로 본 연구에서는 이미지 마스크를 기반으로 반사실적 샘플을 구성하고 마스크 이미지 학습을 통해 모델 견고성을 향상시키는 미세 조정 학습 방법을 제안합니다.

구체적으로, 다운스트림 훈련 이미지의 허위 상관 관계를 깨기 위해 이 작업은 비의미적 영역을 조작하기 위해 이미지의 특정 영역의 콘텐츠를 마스킹하고 대체하는 CAM(클래스 활성화 맵) 기반 방법을 제안합니다. 이미지의 의미 표현 또는 의미론적 표현은 반사실적 샘플을 생성합니다. 미세 조정된 모델은 증류를 통해 사전 훈련된 모델에 의해 이러한 반사실적 샘플의 표현을 모방하는 방법을 학습할 수 있으므로 의미적 요인과 비의미적 요인의 영향을 더 효과적으로 분리하고 다운스트림 필드의 분포 이동에 대한 적응성을 향상시킬 수 있습니다.

실험에 따르면 이 방법은 다운스트림 작업에서 사전 훈련된 모델의 성능을 크게 향상시키는 동시에 기존 대형 모델 미세 조정 훈련 방법에 비해 견고성을 향상시키는 데 상당한 이점이 있습니다.

이 작업의 중요한 의의는 사전 훈련된 대형 모델이 딥러닝 패러다임에서 물려받은 '블랙박스'를 어느 정도 열고, '해석 가능성'과 '제어 가능성' 문제를 해결한다는 점입니다. 대형 모델 중요한 탐색을 통해 사전 훈련된 대형 모델을 통한 실질적인 생산성 향상에 더 가까워졌습니다.

중산대학교 HCP 팀은 Transformer 메커니즘이 등장한 이후 수년 동안 대형 모델 기술 패러다임에 대한 연구에 참여해 왔으며 대형 모델의 훈련 효율성을 향상하고 인과 모델을 도입하는 데 전념하고 있습니다. 대형 모델의 "제어성" 문제를 해결합니다. 수년에 걸쳐 팀은 시각, 언어, 음성 및 교차 양식에 대한 여러 대규모 사전 훈련 모델을 독립적으로 연구하고 개발했습니다. Huawei의 Noah's Ark Laboratory와 공동으로 개발한 "Wukong" 교차 모드 대형 모델(링크: https:/ /arxiv.org/abs/2202.06767)이 전형적인 경우입니다.

팀 소개

쑨원대학교 인간-컴퓨터 지능 융합 연구실(HCP Lab)은 다중 모드 인지 컴퓨팅, 로봇 공학 및 임베디드 시스템, 메타버스 및 디지털 휴먼, 제어 가능한 콘텐츠 생성, 현장에서 체계적인 연구를 수행하고, 제품 프로토타입의 심층적인 응용 시나리오를 만들고, 다수의 원천 기술을 수출하고, 기업가 팀을 육성합니다. 이 연구실은 2010년 IAPR 연구원인 Lin Liang 교수가 설립했으며 중국 이미지 그래픽 학회 과학기술상 1등상, Wu Wenjun 자연과학상, 지방 자연과학 1등상 등을 수상했습니다. Liang Xiaodan, Wang Keze와 같은 국가 수준의 젊은 인재를 양성했습니다.

위 내용은 Sun Yat-sen University HCP 연구실의 새로운 혁신: 인과 패러다임을 사용하여 다중 모드 대형 모델 업그레이드의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!