로봇공학 분야는 눈부신 발전을 이루었고, 이러한 발전은 로봇이 미래에 더 많은 일을 할 수 있음을 시사합니다. 하지만 문제도 있습니다. 생성 모델에 비해 로봇의 발전은 아직 조금 뒤처져 있고, 특히 GPT-3와 같은 모델의 등장으로 이러한 격차가 더욱 두드러지기 때문입니다.

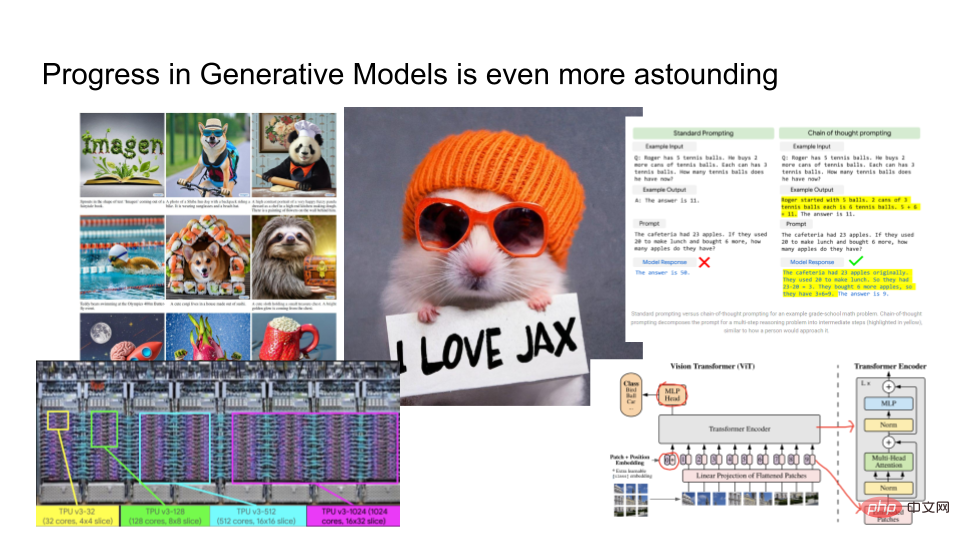

생성 모델의 결과는 놀라울 정도로 좋습니다. 위 그림의 왼쪽은 구글이 출시한 Imagen의 출력 결과이다. "주황색 모자를 쓰고 종이를 들고 JAX를 사랑한다고 말하는 햄스터"와 같은 텍스트를 제공할 수 있습니다. 주어진 텍스트를 기반으로 Imagen은 합리적인 이미지를 렌더링합니다. 또한 Google은 농담이 재미있는 이유 등을 설명하는 데 사용할 수 있는 대규모 언어 모델 PaLM도 교육했습니다. TPUv4와 같은 고급 하드웨어로 모델을 훈련하고, 컴퓨터 비전 분야의 연구자들은 Vision Transformers와 같은 매우 복잡한 아키텍처를 개발하고 있습니다.

생성 모델은 로봇 공학에 비해 매우 빠르게 발전하고 있습니다. 둘 사이의 연관성은 무엇입니까?

이 기사에서는 노르웨이 로봇 회사 "Halodi Robotics"의 AI 담당 부사장인 Eric Zhang이 "어떻게 하면 로봇을 생성 모델처럼 만들 수 있을까?"를 소개합니다. 》. 다음은 기사의 주요 내용이다.

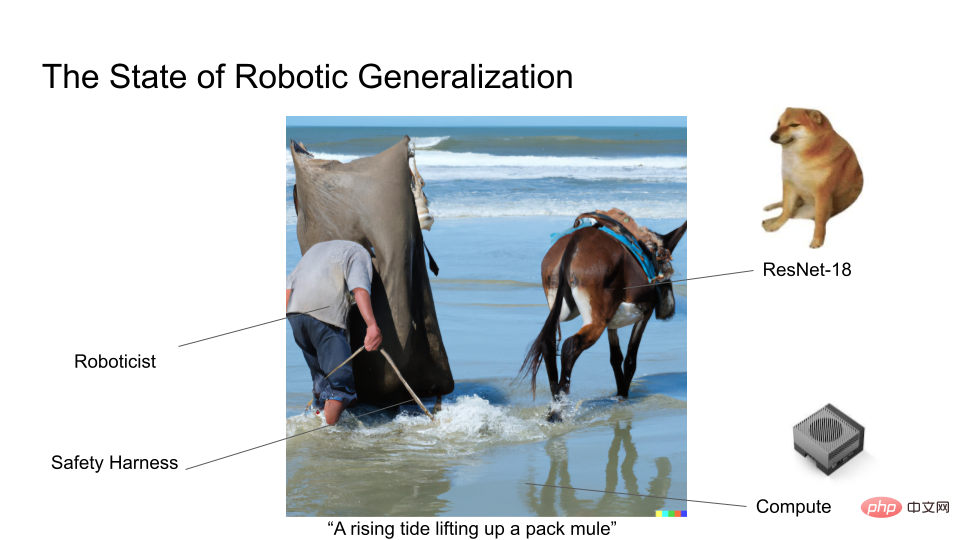

로봇 분야의 전문가로서 제너레이티브 모델 분야의 발전이 좀 부러워요. 왜냐하면 로봇공학 분야에서는 아마도 대부분의 연구자들이 7년 된 딥러닝 아키텍처인 ResNet18을 아직도 사용하고 있을 것이기 때문입니다. 우리는 생성 모델처럼 거대한 데이터 세트로 모델을 훈련하지 않으므로 헤드라인을 장식하는 로봇공학 연구 노력은 거의 없습니다.

우리는 Moravec Paradox를 알고 있습니다. 인지 작업과 비교할 때 로봇을 유연하게 조작하는 것은 직관적으로 로봇이 물체를 집어 들고 운반하도록 하는 것이 단어를 이미지로 바꾸거나 농담을 그렇게 인상적으로 설명하는 것 같지 않습니다.

먼저 생성 모델을 정의합니다. 생성 모델은 단순히 이미지를 렌더링하거나 많은 양의 텍스트를 생성하는 것 이상입니다. 이는 또한 모든 확률적 기계 학습을 이해하는 데 사용할 수 있는 프레임워크이기도 합니다. 생성 모델에는 두 가지 핵심 질문이 있습니다.

1. 모델링하려는 데이터 범주에 몇 비트가 있습니까?

2. 모델을 얼마나 잘 만들 수 있나요?

AlexNet은 2012년에 획기적인 발전을 이루었습니다. 1000개의 카테고리를 예측할 수 있으며 Log2(1000개의 클래스)는 약 10개의 클래스 비트입니다. AlexNet은 10비트 정보를 포함하는 이미지 기반 생성 모델로 생각할 수 있습니다. 모델링 작업의 난이도를 MS-CoCo 자막 작업으로 업그레이드하면 모델에는 약 100비트의 정보가 포함됩니다. 예를 들어 DALLE 또는 Imagen을 사용하여 텍스트에서 이미지로 이미지 생성을 수행하는 경우 여기에는 약 1000비트의 정보가 포함됩니다.

보통 범주를 많이 모델링할수록 범주에 포함된 조건부 확률을 계산하는 데 더 많은 컴퓨팅 성능이 필요합니다. 이것이 범주 수가 늘어날수록 모델이 커지는 이유입니다. 점점 더 큰 모델을 훈련할수록 데이터의 특징을 활용하여 더 풍부한 구조를 학습할 수 있게 됩니다. 이것이 바로 생성 모델과 자기 지도 학습이 광범위한 사람의 라벨링 없이도 대량의 입력에 대해 딥 러닝을 수행하는 인기 있는 방법이 된 이유입니다.

Rich Sutton은 자신의 기사 "The Bitter Lesson"에서 다음과 같이 지적했습니다. 인공 지능의 발전은 대부분 이 컴퓨팅 붐에서 이루어진 것 같지만 다른 측면에서는 거의 발전하지 못한 것 같습니다. Vision 알고리즘, NLP 및 Yann LeCun의 LeCake는 모두 이러한 컴퓨팅 붐의 혜택을 받고 있습니다.

이 트렌드는 우리에게 어떤 영감을 주나요? 더 많은 데이터를 처리할 수 있는 과도하게 매개변수화된 모델이 있고 모델이 강력한 컴퓨팅 성능 및 교육 목표와 함께 네트워크의 모든 기능을 캡처할 수 있는 경우 딥 러닝은 거의 항상 가능합니다.

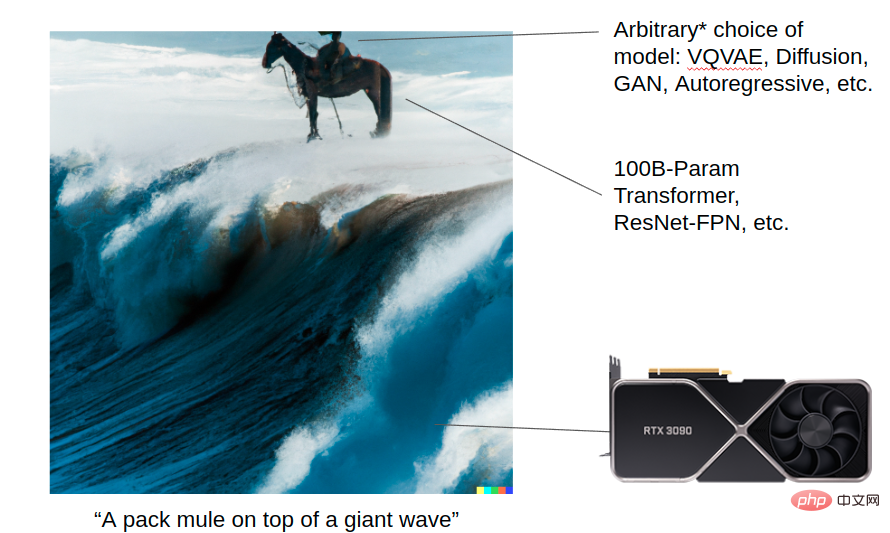

DALL-E 2가 거대한 파도를 타고 있는 노새 이미지를 생성하도록 하세요. 이 그림은 생성 모델이 컴퓨팅 붐의 도움으로 어떻게 놀라운 결과를 얻을 수 있는지 보여줍니다. 강력한 컴퓨팅 성능(Transformer, Resnet 등)을 보유하고 있으며 모델링을 위해 VQVAE, Diffusion, GAN, Autoregressive 및 기타 알고리즘을 선택할 수 있습니다. 각 알고리즘의 세부 사항은 오늘날 중요하지만 컴퓨터가 충분히 강력해지면 미래에는 중요하지 않을 수도 있습니다. 그러나 장기적으로 볼 때 모델 규모와 우수한 아키텍처는 이러한 모든 발전의 기반입니다.

이에 비해 아래 그림은 로봇공학 분야의 일반화 연구 현황을 보여줍니다. 현재 많은 로봇공학 연구자들은 여전히 소형 모델을 훈련하고 있으며 아직 Vision Transformer를 사용하지 않았습니다!

로봇 연구에 종사하시는 분들이라면 누구나 로봇이 현실 세계에서 더 널리 활용되고 더 큰 역할을 할 수 있기를 바라실 겁니다. 생성 모델 분야에서 연구자들은 비교적 적은 문제에 직면하는 반면, 로봇공학 연구 분야에서는 생성 모델에 종사하는 연구자들이 직면하지 않는 로봇 배치의 어려움, 노이즈 데이터 등의 문제에 자주 직면합니다.

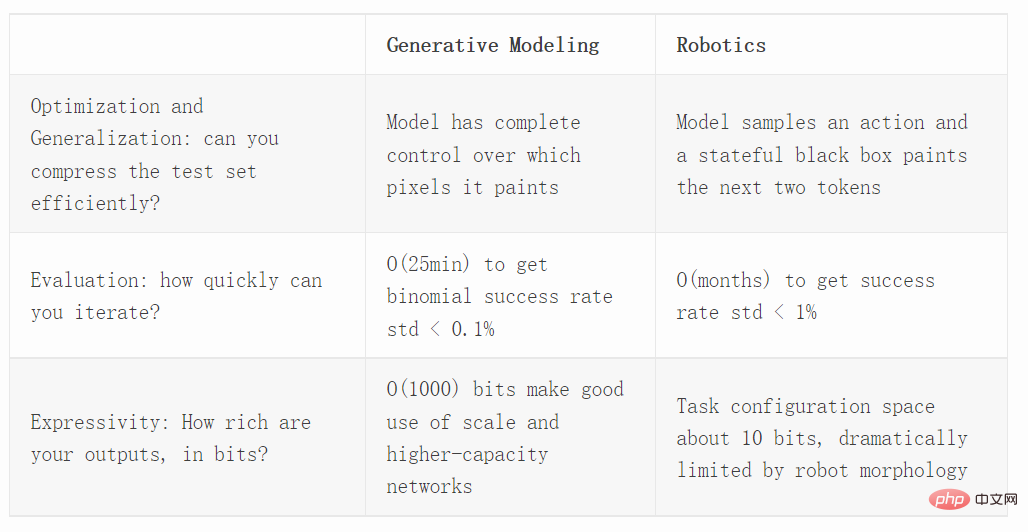

다음으로 최적화, 평가, 표현 능력을 포함한 세 가지 차원에서 생성 모델과 로봇 공학을 비교합니다.

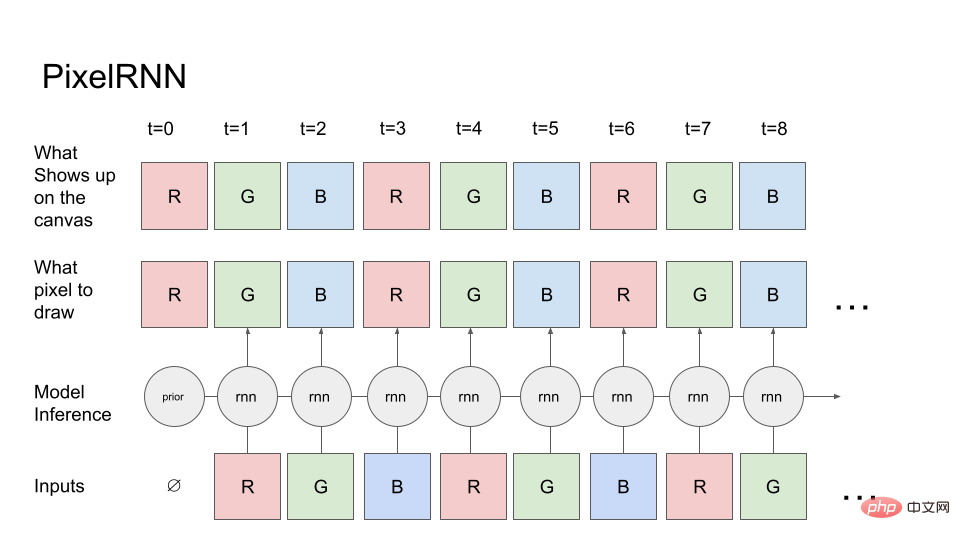

먼저 간단한 생성 모델인 PixelRNN을 살펴보겠습니다.

첫 번째 픽셀의 빨간색 채널부터 시작하여(빨간색 채널의 사전 확률이 알려져 있음) 모델은 캔버스(맨 위 행)에 어떤 픽셀을 그리고 싶은지 알려줍니다. 캔버스는 지시된 대로 정확하게 그려지므로 픽셀 값을 캔버스에 복사한 다음 캔버스를 모델로 다시 읽어 녹색 채널인 다음 채널을 예측합니다. 그런 다음 R 및 G 캔버스의 값이 RNN으로 피드백되어 최종적으로 RGBRGBRGB... 시퀀스가 생성됩니다.

실제 이미지 생성 작업에서는 확산이나 변환기를 사용할 수 있습니다. 그러나 단순화를 위해 우리는 순방향 실행 RNN만 사용합니다.

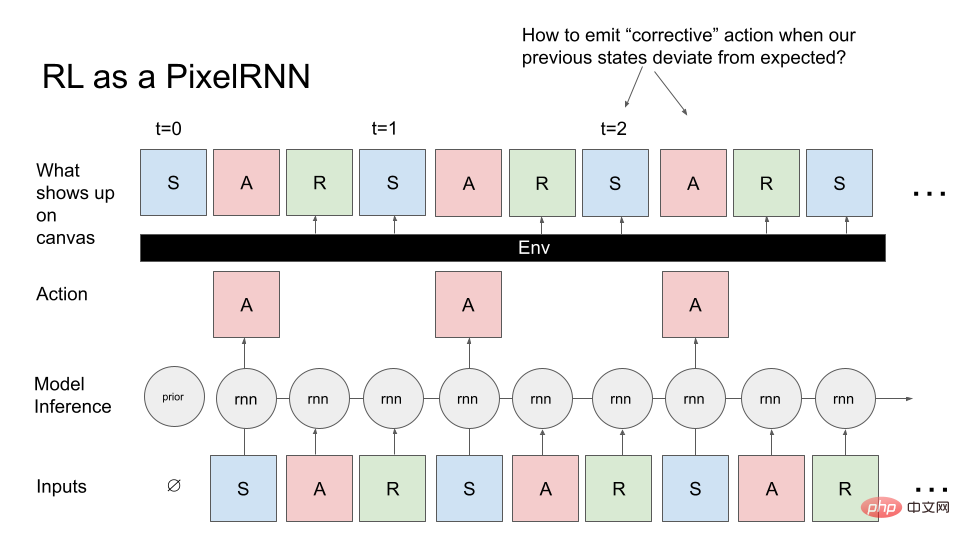

이제 일반 제어 문제를 PixelRNN으로 변환해 보겠습니다. 이미지를 생성하는 대신, 우리는 상태, 행동, 보상의 시퀀스인 MDP(Markov Decision Processes)를 생성하려고 합니다. 우리는 어떤 작업을 수행하는 에이전트(예: 로봇)에 해당하는 MDP를 생성하려고 합니다. 여기서 다시 사전 지식부터 시작하고 모델은 강화 학습(RL) 환경의 초기 상태를 샘플링합니다. 이는 모델에 대한 첫 번째 입력이고 RNN은 첫 번째 픽셀(A)을 샘플링하며 캔버스는 지시된 대로 정확하게 A를 생성합니다. 그러나 이미지 생성과 달리 캔버스는 항상 이전 RNN 출력을 반환하며 현재 작업은 다음 두 픽셀(R, S)이 현재 환경에 의해 결정된다는 것입니다. 즉, 작업과 모든 이전 상태를 받아들이고 R을 계산합니다. S 왠지.

우리는 RL 환경을 RNN 작업을 수행하는 Painter 객체로 생각할 수 있습니다. 캔버스에 직접 원하는 콘텐츠를 그리는 대신 임의로 복잡한 기능을 사용하여 픽셀을 그립니다.

앞서 이미지를 그린 PixelRNN과 비교해 보면 이 작업은 확실히 더 까다롭습니다. 원하는 이미지를 샘플링하려고 하면 블랙 박스가 있고 이 블랙 박스가 이미지에 영향을 미치기 때문입니다. 콘텐츠가 어려움을 야기합니다.

그리는 과정에서 겪게 되는 대표적인 문제: 환경이 예상치 못한 상태를 그리게 되면, 우리가 그리려고 하는 이미지로 돌아갈 수 있도록 시정 지시를 내리는 방법에 문제가 생길 것입니다. 또한 이미지 생성과 달리 실제로 MDP 이미지를 순차적으로 생성해야 하며 편집을 위해 돌아갈 수 없으므로 최적화 문제도 발생합니다.

PPO와 같은 RL 방법이 어떻게 일반화되는지 이해하려면 제어되지 않은 환경에서 이를 벤치마킹하고 이를 이미지 생성 기술에 적용한 다음 최신 생성 모델과 비교해야 합니다. Hinton과 Nair의 2006년 작업에서는 스프링 시스템을 사용하여 MNIST 디지털 합성을 모델링했습니다. DeepMind는 RL 방법을 사용하여 이 이미지 합성 작업의 일부를 복제합니다.

이미지 생성은 수천 개의 다양한 시나리오에 걸쳐 일반화해야 하는 필요성을 실제로 강조하기 때문에 최적화 및 제어를 연구하는 훌륭한 벤치마크입니다.

Decision Transformer, Trajectory Transformer 및 Multi-Game Decision Transformer와 같은 최근 프로젝트는 거꾸로 된 RL 기술이 일반화에 좋은 역할을 한다는 것을 보여주었습니다. 그렇다면 거꾸로 된 RL 기술은 온라인(PPO) 또는 오프라인 RL 알고리즘(CQL)과 어떻게 비교됩니까? 또한 평가하기 쉽고 밀도(전문가의 전체 관찰에 대한 가능성 모델)를 평가하고 테스트 가능성을 측정할 때 주어진 RL 알고리즘 선택이 많은 수의 이미지로 일반화될 수 있는지 여부를 확인할 수 있습니다.

특정 작업에 대한 로봇의 성공률을 추정하려면 이항 분포를 사용할 수 있습니다.

이항 분포의 분산은 p(1−p)/N이고, p는 표본 평균(추정 성공률)입니다. 최악의 경우 p=50%(최대 분산)인 경우 표준 편차를 1% 미만으로 낮추려면 3000개의 샘플이 필요합니다.

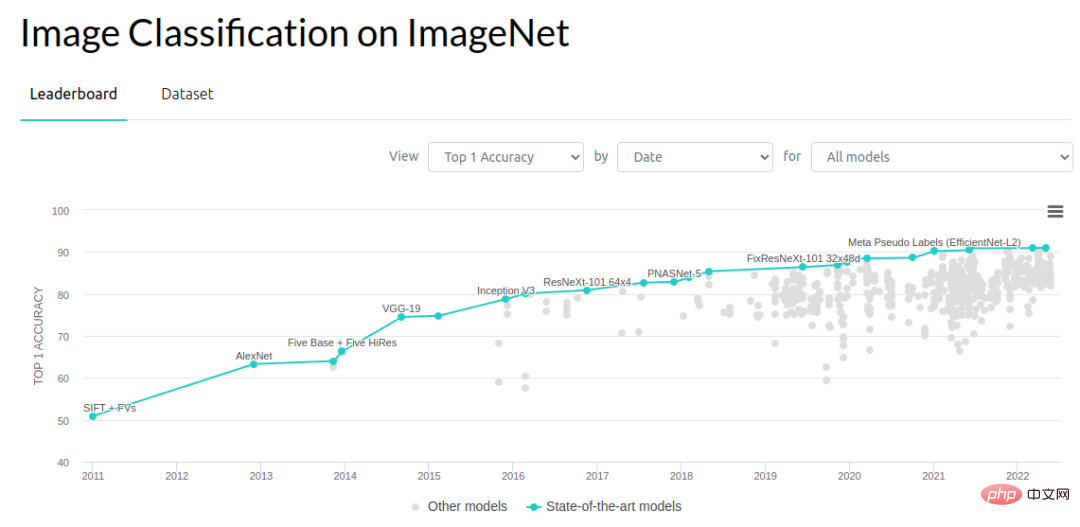

컴퓨터 비전의 관점에서 보면 0.1~1% 범위의 개선이 발전의 중요한 원동력입니다. ImageNet 객체 인식 문제는 2012년부터 많은 발전을 이루었습니다. 2012년부터 2014년까지 오류율이 3% 감소한 후 매년 약 1%씩 감소했습니다. 이 작업을 수행하는 방법에 대해 많은 사람들이 노력하고 있습니다. 어쩌면 올해(2022년)는 벤치마크 개선의 병목 현상에 이르렀을지도 모르지만, 2012년부터 2018년까지 7년 동안 연구자들은 많은 진전과 성과를 거두었습니다.

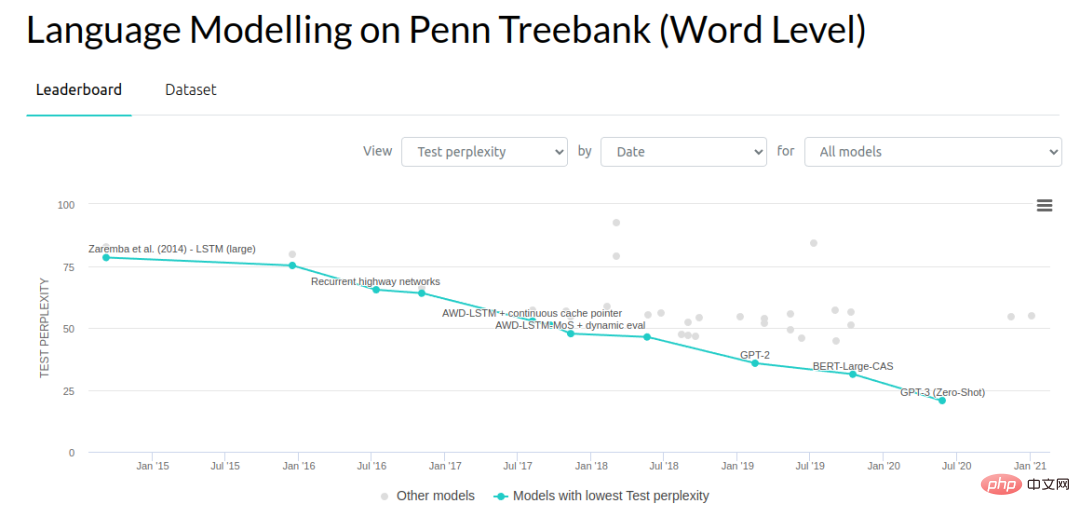

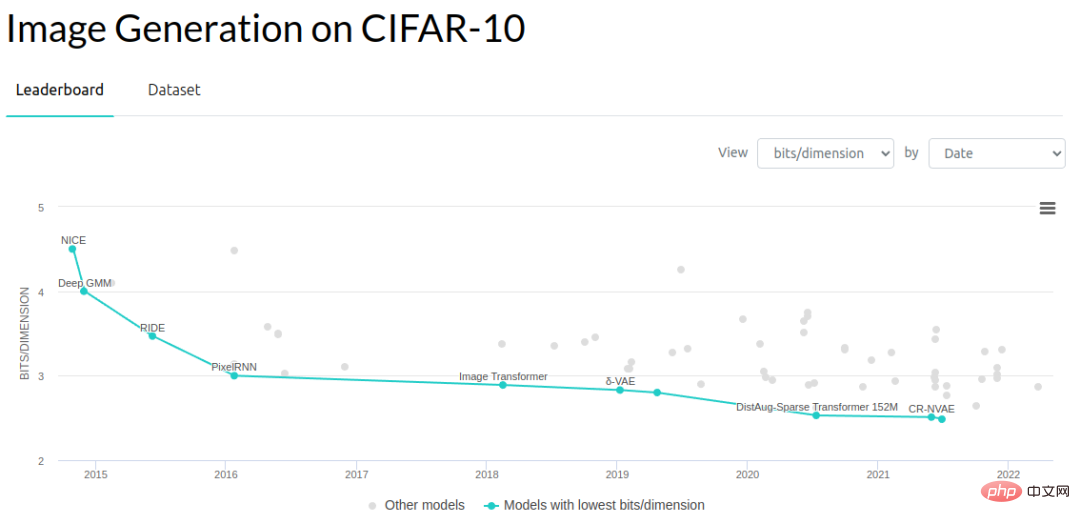

생성 모델링의 다른 영역에서 연구자들은 언어 모델의 복잡성과 이미지에 대한 생성 모델의 차원당 비트 수를 줄여 왔습니다.

다음은 일반적인 벤치마크의 평가 속도를 대략적으로 비교한 것입니다. 2012 ImageNet 객체 인식 테스트 세트에는 150,000개의 이미지가 있습니다. 이미지당 추론 속도를 10ms로 가정하고 각 이미지를 연속적으로 평가하면 각 테스트 예시를 평가하는 데 약 25분 정도 소요됩니다(실제로 배치 처리가 가능하므로 평가가 훨씬 빠릅니다). 하지만 여기서는 평가 작업을 수행하는 로봇이 하나만 있고 이미지를 지속적으로 처리해야 한다고 가정합니다.

방대한 이미지가 있기 때문에 0.1% 이내의 표준오차 추정치를 얻을 수 있습니다. 실제로 이 분야의 발전을 위해 0.1%의 표준 오차는 필요하지 않습니다. 아마도 1%면 충분할 것입니다.

복잡성 평가 측면에서 엔드투엔드 성능도 중요한 부분입니다. 시뮬레이션된 작업에서 신경망의 엔드투엔드 성능 평가를 수행하는 방법을 살펴보겠습니다. Habitat Sim은 사용 가능한 가장 빠른 시뮬레이터 중 하나이며 신경망 추론과 환경 스테핑 간의 오버헤드를 최소화하도록 설계되었습니다. 시뮬레이터는 초당 10,000단계를 수행할 수 있지만 신경망의 순방향 전달은 약 10ms이므로 이 병목 현상으로 인해 에피소드당 평가 시간이 2초가 됩니다(일반적인 탐색 에피소드가 200단계라고 가정). 이는 실제 로봇을 실행하는 것보다 훨씬 빠르지만 단일 컴퓨터 비전 샘플을 평가하는 것보다 훨씬 느립니다.

ImageNet에서 수행한 것과 유사한 수준의 다양성을 갖춘 엔드투엔드 로봇 시스템을 평가한다면 일반적인 평가는 수십만 개의 평가 시나리오를 처리하는 데 1주일이 소요됩니다. 각 에피소드에는 실제로 약 200개의 추론 패스가 있기 때문에 이는 완전히 합리적인 비교는 아니지만 단일 에피소드 내의 이미지를 독립적인 검증 세트로 처리할 수는 없습니다. 다른 에피소드 측정항목이 없으면 작업이 성공했는지 여부만 알 수 있으므로 에피소드 내의 모든 추론은 이항 추정의 단일 샘플에만 기여합니다. 사진보다는 수만 편의 에피소드를 바탕으로 성공률을 추정해야합니다. 물론 다른 정책 평가 방법을 사용해 볼 수도 있지만 이러한 알고리즘은 기본적으로 작동할 만큼 신뢰할 수 없습니다.

다음 단계에서는 실제 로봇에 대한 현장 평가를 진행합니다. 실제 세계에서는 각 에피소드를 평가하는 데 약 30초가 소요됩니다. 따라서 10명의 운영자로 구성된 팀이 평가를 수행하고 각 운영자가 하루에 300개의 에피소드를 완료할 수 있다면 하루에 약 3000개의 평가를 수행할 수 있습니다.

모델을 평가하는 데 하루 종일 걸리면 하루에 하나의 아이디어만 시도할 수 있기 때문에 생산성에 큰 제한이 따릅니다. 따라서 우리는 성능을 0.1%씩 점진적으로 향상시키는 작은 아이디어나 매우 극단적인 아이디어를 더 이상 작업할 수 없습니다. 우리는 성능을 크게 향상시킬 수 있는 방법을 찾아야 했습니다. 보기에는 좋아 보이지만 실제로 실행하기는 어렵습니다.

로봇 학습의 반복 프로세스를 고려할 때 평가 시도 횟수가 훈련 데이터를 훨씬 초과하기 쉽습니다! 수개월 간의 논스톱 평가를 통해 약 수만 개의 에피소드가 생성되었으며 이는 이미 대부분의 로봇공학 딥 러닝 데모 데이터 세트보다 더 큽니다.

몇 년 전만해도 연구자들은 로봇 팔이 문을 여는 것과 같은 문제를 해결하고 있었지만 이러한 전략은 잘 일반화되지 않았습니다. 연구자들은 일반적으로 약 10회에 걸쳐 일련의 평가를 수행합니다. 그러나 실제로 10~50번의 시행은 통계적 견고성을 보장하기에 충분하지 않습니다. 좋은 결과를 얻으려면 최종 평가를 위해 실제로 1000회 이상의 시도를 수행해야 합니다.

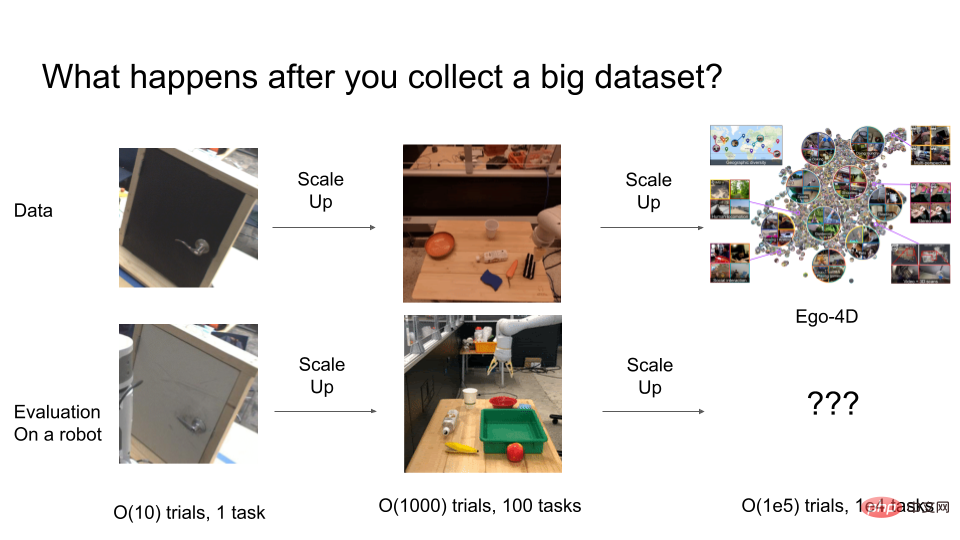

하지만 임상시험이 더 확대되면 어떻게 될까요? O(100,000)개의 동작을 갖는 매우 일반적인 로봇 시스템을 훈련해야 한다면 그러한 일반 시스템을 평가하는 데 얼마나 많은 시도가 필요합니까? 이때 감정비용이 극도로 비싸진다.

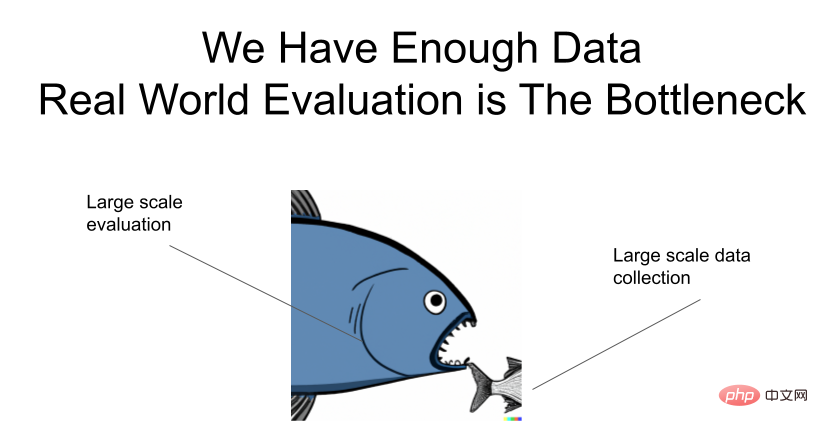

다시 한번 강조합니다. 데이터는 충분하지만 평가에 병목 현상이 있습니다!

다음은 범용 로봇 시스템 평가 속도를 높이는 방법에 대한 몇 가지 아이디어입니다.

일반화 문제와 로봇을 따로 공부하는 것도 한 가지 방법입니다. 실제로 딥러닝 커뮤니티는 이미 이를 달성했습니다. 대부분의 컴퓨터 비전 및 생성 모델링 연구자들은 자신의 아이디어를 실제 로봇에서 직접 테스트하지는 않지만, 모델이 강력한 일반화 기능을 달성하면 신속하게 로봇으로 전환될 것으로 기대합니다. 컴퓨터 비전 분야에서 개발된 ResNets는 많은 로봇 시각적 모션 모델링 옵션을 크게 단순화합니다. 연구자가 다른 신경망 아키텍처를 시도하고 싶을 때마다 실제 로봇에서 자신의 아이디어를 테스트해야 한다고 상상해 보십시오! 또 다른 성공 사례는 파악 계획을 위한 기본 기하학적 추론에서 이미지-텍스트 모델의 강력한 다중 모드 일반화 기능을 분리하는 CLIPort입니다.

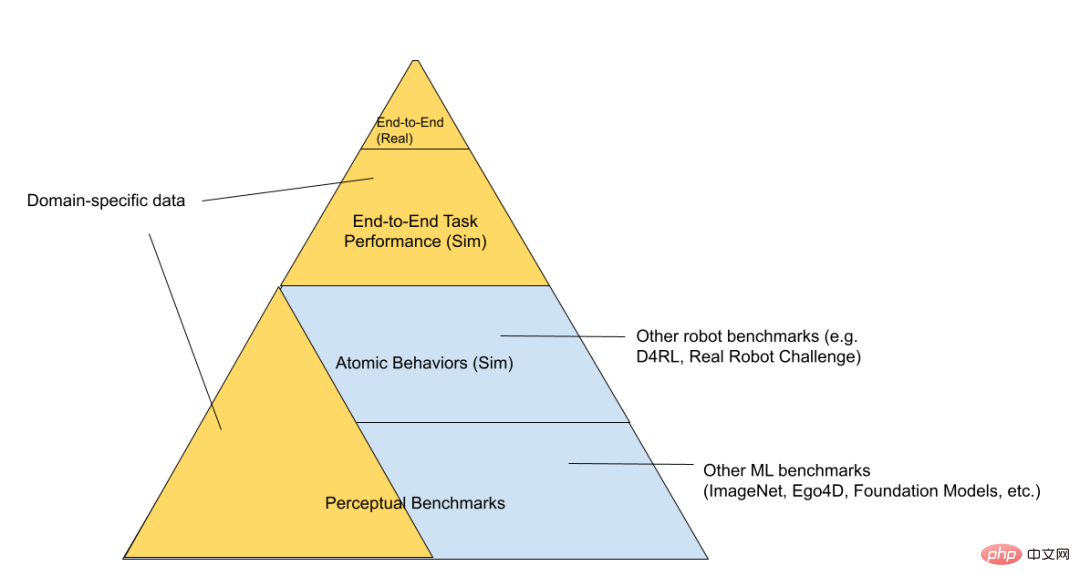

RL 기술 스택을 "시뮬레이트된 장난감 환경", "시뮬레이트된 로봇" 및 "실제 로봇"(평가 난이도가 높아지는 순서로 정렬)의 세 가지 계층으로 더 나눌 수 있습니다.

피라미드 하단에는 캐글 대회 벤치마크 등 일반 벤치마크가 있습니다. 올라가면 "베어 메탈" 방식으로 문제를 연구하는 일련의 "장난감 제어 문제"가 있습니다. 시뮬레이터와 신경망만 실행되고 배터리 관리 등 실제 로봇과 관련된 모든 코드가 실행됩니다. , 존재하지 않는다. 피라미드 위로 더 올라가면 해결하려는 문제와 더 관련성이 높은 더 구체적인 영역으로 연결됩니다. 예를 들어, "시뮬레이션된 로봇"과 "실제 로봇"은 동일한 작업에 사용될 수 있으며 동일한 기본 로봇 코드를 재사용할 수 있습니다. 시뮬레이션된 장난감 환경은 일반 알고리즘을 연구하는 데 사용될 수 있지만 최종 로봇공학 분야와 중복되는 부분은 적습니다. "평가 피라미드"의 맨 위에는 우리가 해결하려는 실제 로봇 작업이 있습니다. 이 프로세스를 직접 반복하는 것은 매우 느리기 때문에 우리 모두는 여기서 가능한 한 적은 시간을 보내고 싶어합니다. 낮은 수준에서 훈련되고 평가된 기본 모델이 최상위 수준에서 모든 평가를 수행하지 않고도 어떤 아이디어가 효과적인지 이해하는 데 도움이 되기를 바랍니다.

마찬가지로 해당 분야도 이미 이러한 분리된 방식으로 운영되고 있습니다. 로봇에 기여하는 데 관심이 있는 대부분의 사람들이 반드시 로봇을 작동할 필요는 없습니다. 그들은 결국 로봇에 유용할 수 있는 시각적 표현과 아키텍처를 훈련할 수 있습니다. 물론, 분리의 단점은 지각 기준선의 개선이 로봇 능력의 개선과 항상 일치하는 것은 아니라는 것입니다. 예를 들어, mAP 측정항목이 의미론적 분할이나 비디오 분류 정확도 또는 심지어 무손실 압축 벤치마크(이론적으로 궁극적으로 기여해야 함)를 개선하는 동안 표현 목표의 개선이 실제로 다운스트림 작업의 개선으로 어떻게 매핑되는지 알 수 없습니다. 따라서 궁극적으로 실제 병목 현상이 발생하는 위치를 이해하려면 엔드투엔드 시스템을 테스트해야 합니다.

Google은 "Unsupervised Learning of Unsupervised Learning of Disentangled Representations"라는 멋진 논문을 발표한 적이 있습니다. 그들은 완전히 비지도된 표현 학습 방법이 평가 및 평가를 수행하지 않는 한 다운스트림 작업에서 상당한 성능 향상을 가져오지 못한다는 것을 입증했습니다. 우리가 관심을 갖는 최종 다운스트림 기준을 사용하여 모델을 선택합니다.

논문 주소: https://arxiv.org/pdf/1811.12359.pdf

평가 비용을 줄이는 또 다른 방법은 데이터 수집 및 평가 프로세스를 일관되게 유지하는 것입니다. 평가 데이터와 전문가 운영 데이터를 동시에 수집할 수 있습니다. 특정 개입을 통해 HG-dagger 데이터를 수집할 수 있으므로 유용한 훈련 데이터를 수집할 수 있습니다. 동시에 에피소드당 평균 개입 횟수를 통해 전략이 충분히 좋은지 대략적으로 알 수 있습니다. 또한 이항 메트릭 대신 스칼라 메트릭을 관찰할 수도 있습니다. 이러한 메트릭의 각 에피소드는 단일 성공/실패보다 더 많은 정보를 생성하기 때문입니다.

자율적인 데이터 수집을 위해 RL 알고리즘을 사용하는 것은 평가와 데이터 수집을 결합하는 또 다른 방법이지만, 이 방법을 사용하려면 수동으로 에피소드에 점수를 매기거나 신중하게 설계된 보상 기능을 사용해야 합니다. 이러한 모든 접근 방식을 사용하려면 현실 세계에 많은 수의 로봇을 배치해야 하지만, 현실 세계에서는 계속 반복되면서 여전히 어려움을 겪고 있습니다.

평가 알고리즘을 더 빠르게 만드는 방법은 sim-to-real 마이그레이션 알고리즘을 개선하는 것입니다. 많은 로봇을 병렬로 시뮬레이션할 수 있으므로 제약이 없습니다. Mohi Khansari, Daniel Ho, Yuqing Du 등은 시뮬레이션과 실제의 표현을 불변으로 정규화하는 "작업 일관성 손실"이라는 기술을 개발했습니다. 따라서 전략은 시뮬레이션에 있습니다. 동작은 실제와 유사해야 합니다. 시뮬레이션에서 평가된 전략을 실제 전략으로 마이그레이션할 때 시뮬레이션의 더 높은 성능 메트릭이 실제로 실제의 더 높은 성능 메트릭과 일치하는지 확인하려고 합니다. sim2real 간격이 작을수록 시뮬레이션 실험의 지표는 더 신뢰할 수 있습니다.

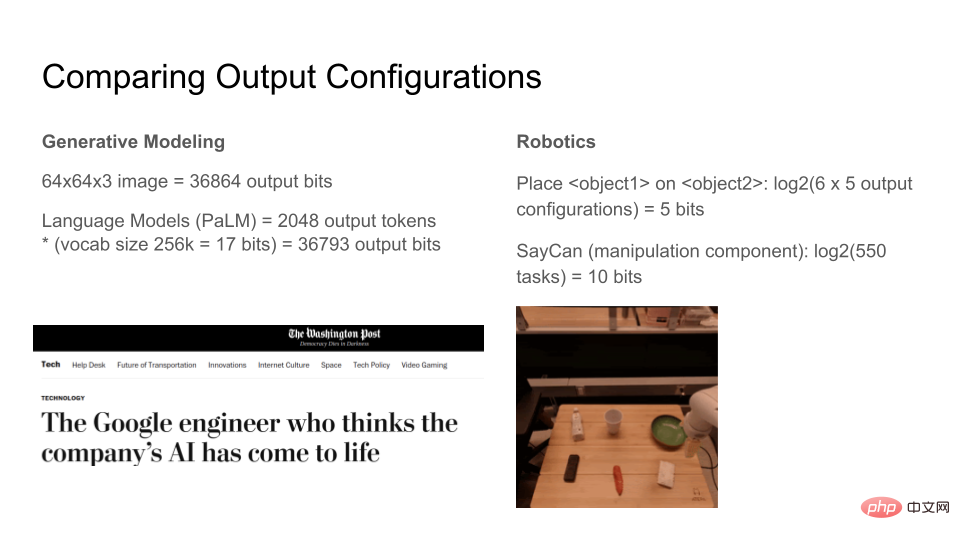

현대 생성 모델이 얼마나 많은 비트를 출력할 수 있는지 살펴보겠습니다. 채널당 8비트의 64x64x3 RGB 이미지는 36864비트입니다. 언어 모델은 원하는 수의 토큰을 생성할 수 있지만 출력 창을 2048개의 토큰으로 고정하면 각 토큰은 17비트이므로 총 36793비트가 됩니다. 따라서 이미지와 텍스트 생성 모델 모두 약 37kbit를 합성할 수 있습니다. 모델의 표현력이 더욱 풍부해짐에 따라 이러한 모델에 대한 사람들의 인식은 질적으로 도약할 것입니다. 어떤 사람들은 언어 모델이 매우 표현력이 뛰어나기 때문에 부분적으로 의식이 있다고 생각하기 시작했습니다!

비교하면 현재 로봇의 표현력은 얼마나 되나요? 여기서는 테이블 위에 6개의 항목이 있는 단순화된 실제 환경을 설계합니다. 로봇의 작업은 총 100개의 작업에 대해 한 항목을 다른 항목 위로 이동하거나 특정 항목을 운반하는 것입니다. log2(100)은 약 7비트인데, 이는 "주어진 세계 상태에서 로봇은 원자를 N 상태 중 하나로 이동할 수 있으며, 여기서 N은 7비트로 설명될 수 있다"는 의미입니다. Google의 SayCan 알고리즘은 단일 신경망으로 약 550개의 작업을 수행할 수 있는데, 이는 현재 로봇 딥 러닝 표준으로 볼 때 총 약 10비트만으로 상당히 인상적입니다.

이 비교는 둘 사이의 정보 정의가 다르기 때문에 완벽하게 합리적이지 않습니다. 여기서는 한 작업 세트의 상대적 복잡성을 다른 작업 세트에 대해 측정할 때 대략적인 직관을 제공하기 위해 제공됩니다. 뭐가 중요한지.

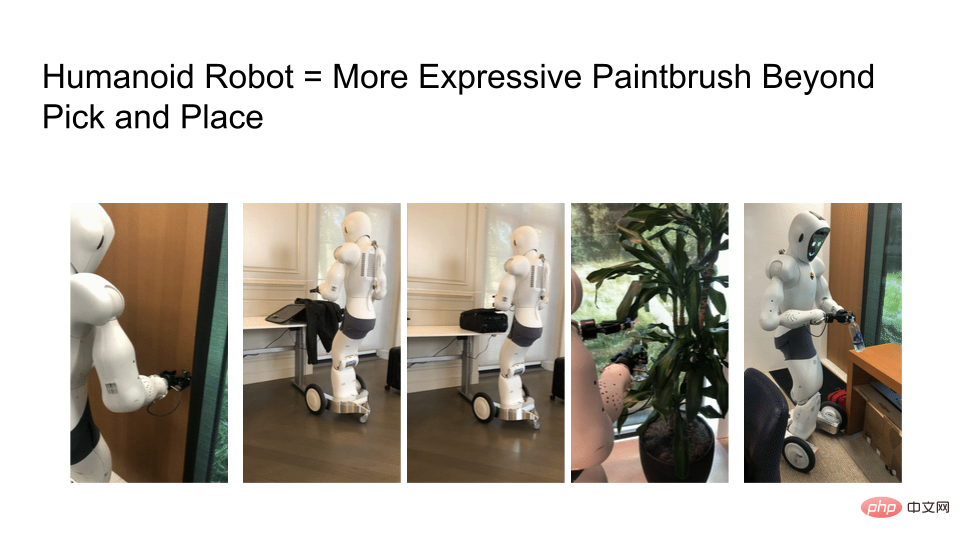

우리가 직면한 과제 중 하나는 로봇의 기능이 여전히 제한적이라는 것입니다. Ego4D 데이터세트를 보면 많은 작업에 두 손이 필요하지만 오늘날 대부분의 로봇은 여전히 바퀴 달린 단일 팔 모바일 조작기를 사용합니다. 그들은 움직이거나 어디로도 갈 수 없으며, 분명히 우리가 가지고 있는 것은 많은 흥미로운 작업을 배제하는 "로봇 팔"뿐입니다.

표현력이 풍부한 로봇에 대한 연구가 더 필요하지만, 로봇 학습 알고리즘의 표현력은 하드웨어에 따라 제한됩니다. 아래는 로봇이 문을 열고, 여행가방을 포장하고, 지퍼를 잠그고, 식물에 물을 주고, 물병 뚜껑을 뒤집는 모습입니다. 로봇 하드웨어가 실제 인간과 가까워질수록 인간 중심의 세계에서 할 수 있는 일의 수가 기하급수적으로 늘어납니다.

로봇의 표현력이 더욱 다양해짐에 따라 인터넷 규모의 훈련 데이터뿐만 아니라 인터넷 규모의 평가 프로세스도 필요합니다. LLM(대형 언어 모델)의 진행 상황을 살펴보면 현재 튜닝과 기존 모델이 할 수 있는 것과 할 수 없는 것을 살펴보는 많은 논문이 있습니다.

예를 들어 BigBench의 벤치마크는 일련의 작업을 컴파일하고 이러한 모델에서 무엇을 얻을 수 있는지 묻습니다. OpenAI를 통해 인터넷 사용자는 DALLE-2 및 GPT-3 모델을 평가할 수 있습니다. LLM 모델의 세부 사항은 한 연구원이 마스터하기 어렵기 때문에 엔지니어링 및 제품 팀은 사용자 참여 AI 실험을 통해 학습할 수 있습니다.

마지막으로 독자님들께 질문드리자면, 로봇공학 분야에서 GPT-3이나 DALLE-2 API와 동등한 기술은 무엇인가요? 이러한 등가 기술을 통해 인터넷 커뮤니티의 연구자들은 로봇 연구에 의문을 제기하고 로봇이 실제로 무엇을 할 수 있는지 이해할 수 있을까요?

마지막으로 표를 사용하여 최적화, 평가 및 표현성 간의 비교를 요약합니다.

위 내용은 생성 모델과 비교했을 때, 로봇 공학 연구에서는 왜 몇 년 전과 같은 오래된 방법을 여전히 사용합니까?의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!