현재 시퀀스 모델링 작업에서 Transformer는 가장 강력한 신경망 아키텍처라고 할 수 있으며 사전 훈련된 Transformer 모델은 프롬프트를 조건 또는 상황 내 학습으로 사용하여 다양한 다운스트림 작업에 적응할 수 있습니다.

대규모 사전 학습된 Transformer 모델의 일반화 능력은 텍스트 완성, 언어 이해, 이미지 생성 등 여러 분야에서 검증되었습니다.

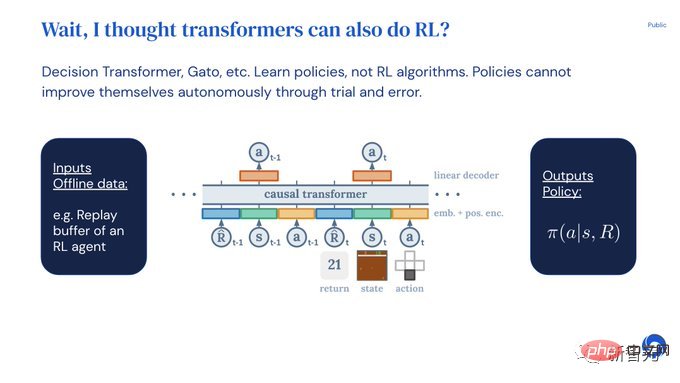

작년부터 오프라인 강화 학습(오프라인 RL)을 시퀀스 예측 문제로 처리하여 모델이 오프라인 데이터에서 정책을 학습할 수 있음을 증명하는 관련 연구가 있었습니다.

하지만 현재 방법은 학습이 포함되지 않은 데이터(예: 증류로 고정된 전문가 정책)에서 정책을 학습하거나 학습이 포함된 데이터(예: 에이전트의 재생 버퍼)에서 학습하지만 컨텍스트가 너무 작으면 정책 개선 사항을 포착할 수 없습니다.

DeepMind 연구원들은 관찰을 통해 원칙적으로 강화 학습 알고리즘 훈련에서 학습의 순차적 특성이 강화 학습 프로세스 자체를 "인과 순서 예측 문제"로 모델링할 수 있다는 사실을 발견했습니다 .

구체적으로 Transformer의 컨텍스트가 학습 업데이트로 인한 정책 개선을 포함할 만큼 길다면 고정된 정책을 나타낼 수 있을 뿐만 아니라 이전의 상태, 작업 및 보상도 나타낼 수 있어야 합니다. 이에 중점을 두고 정책개선 운영자로 대표됩니다.

이는 또한 모든 RL 알고리즘이 모방 학습을 통해 충분히 강력한 시퀀스 모델로 정제되고 상황 내 RL 알고리즘으로 변환될 수 있는 기술적 타당성을 제공합니다.

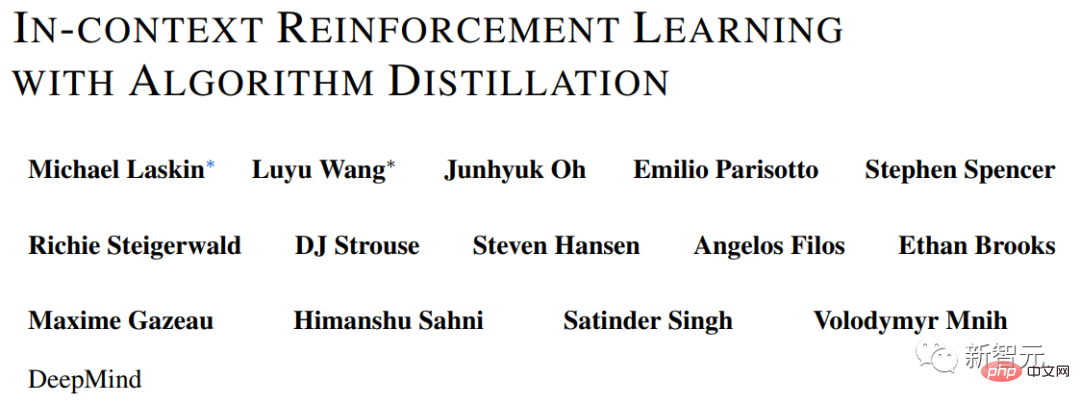

이를 바탕으로 DeepMind는 인과관계 모델을 구축하여 강화학습 알고리즘을 신경망으로 추출하는 AD(Algorithm Distillation)를 제안했습니다.

논문 링크:https://arxiv.org/pdf/2210.14215.pdf

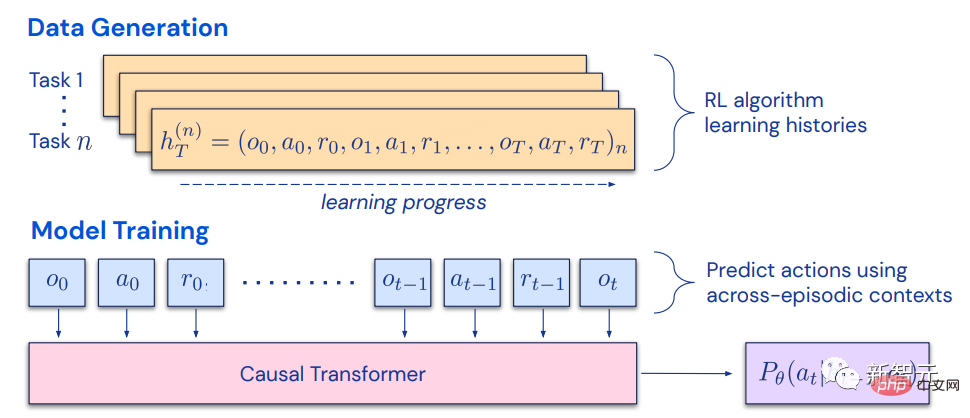

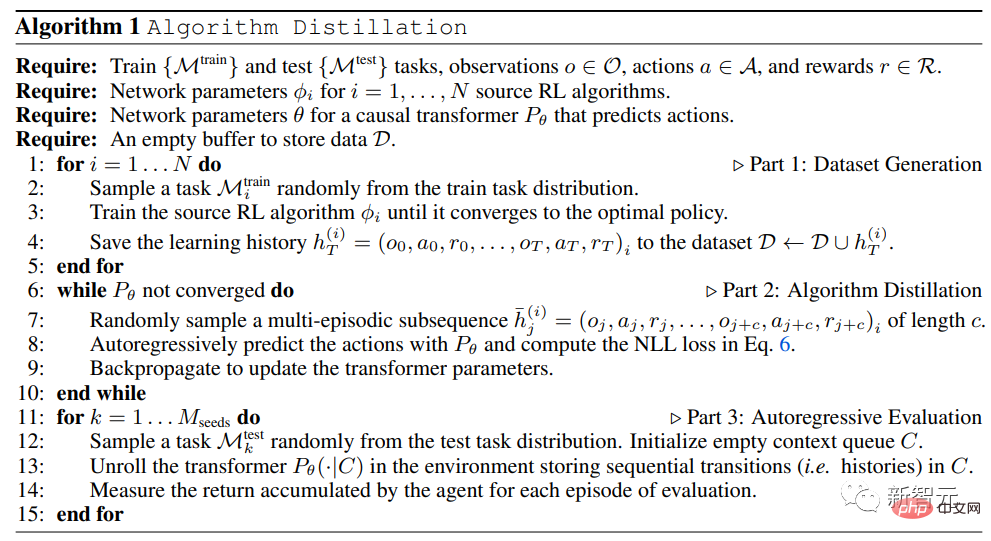

알고리즘 증류는 소스 RL을 통해 강화 학습을 교차 에피소드 시퀀스 예측 문제로 처리합니다. 알고리즘 학습 이력 데이터 세트를 생성한 후, 학습 이력을 컨텍스트로 기반으로 자동 회귀를 통해 행동을 예측하여 인과 변환기를 훈련합니다.

전문가 시퀀스의 사후 학습 또는 시퀀스 정책 예측 구조와 달리 AD는 네트워크 매개변수를 업데이트하지 않고도 상황에 맞게 정책을 완전히 개선할 수 있습니다.

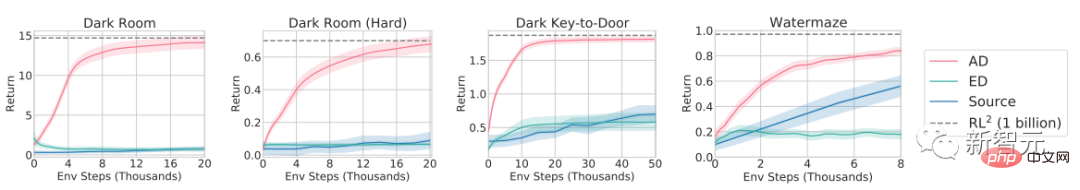

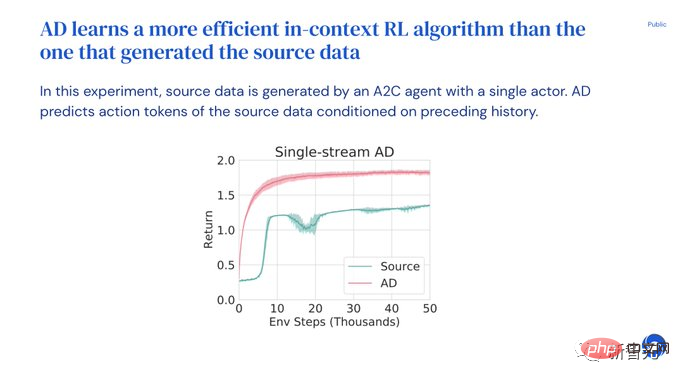

실험 결과는 AD가 희소 보상, 결합된 작업 구조, 픽셀 기반 관찰을 통해 다양한 환경에서 강화 학습을 수행할 수 있으며, 소스 데이터를 생성하는 RL 알고리즘보다 AD 학습이 데이터 효율성이 더 높다는 것을 입증합니다. .

AD는 또한 모방 손실이 있는 오프라인 데이터의 시퀀스 모델링을 통해 상황 내 강화 학습 방법을 시연하는 최초의입니다.

2021년 일부 연구자들은 Transformer가 모방 학습을 통해 오프라인 RL 데이터에서 단일 작업 정책을 학습할 수 있다는 사실을 처음으로 발견했으며 이후 동일 도메인 및 교차 도메인 모두에서 다중 작업 정책을 추출하도록 확장되었습니다. 설정.

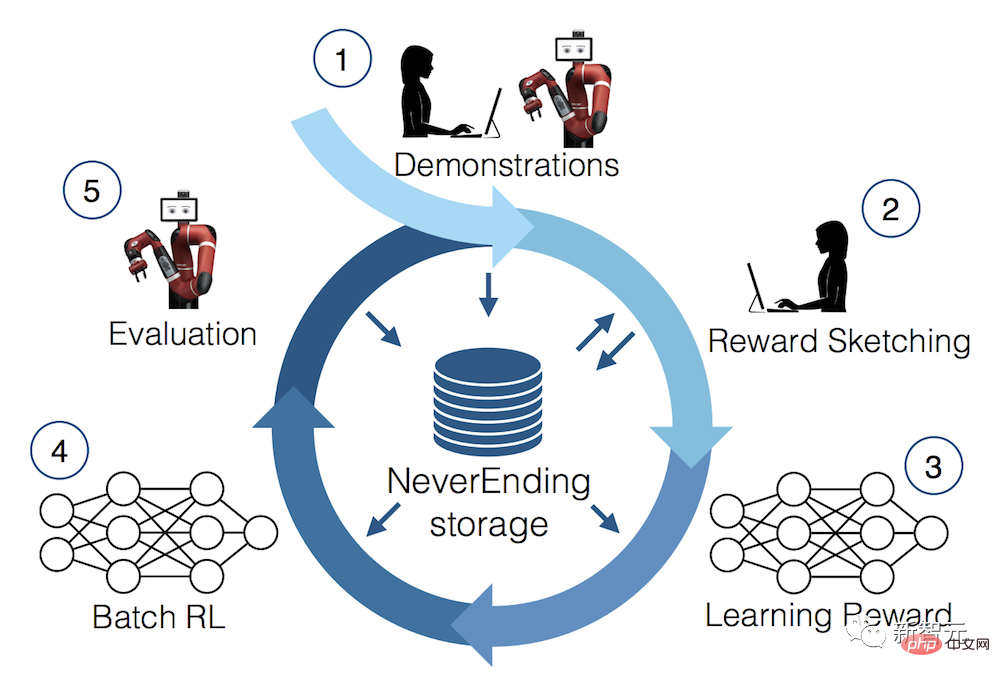

이 연구는 일반적인 다중 작업 정책을 추출하기 위한 유망한 패러다임을 제안합니다. 먼저 환경 상호 작용에 대한 크고 다양한 데이터 세트를 수집한 다음 시퀀스 모델링을 통해 데이터에서 정책을 추출합니다.

모방 학습을 통해 오프라인 RL 데이터로부터 정책을 학습하는 방법을 오프라인 정책 증류라고도 하며 간단히 정책 증류(PD)라고도 합니다.

PD의 아이디어는 매우 간단하고 확장하기 쉽지만 PD에는 큰 결함이 있습니다. 생성된 전략은 환경과의 추가 상호 작용으로 개선되지 않습니다.

예를 들어 MultiGame Decision Transformer(MGDT)는 다수의 Atari 게임을 플레이할 수 있는 반환 조건부 정책을 학습한 반면, Gato는 상황 추론 작업을 통해 다양한 환경에서 작업을 해결하는 정책을 학습했지만 둘 다 None 방법 시행착오를 통해 전략을 개선합니다.

MGDT는 모델의 무게를 미세 조정하여 변압기를 새로운 작업에 적응시키는 반면 Gato는 새로운 작업에 적응하기 위해 전문가의 시연 팁이 필요합니다.

간단히 말하면 정책 증류 방법은 강화 학습 알고리즘이 아닌 정책을 학습합니다.

연구원들이 정책 증류가 시행착오를 통해 개선될 수 없다는 가설을 세운 이유는 학습 진행 상황을 보여주지 않는 데이터로 학습되기 때문입니다.

알고리즘 증류(AD)는 RL 알고리즘의 학습 기록에서 인과 시퀀스 예측 손실을 최적화하여 본질적인 정책 개선 연산자를 학습하는 방법입니다.

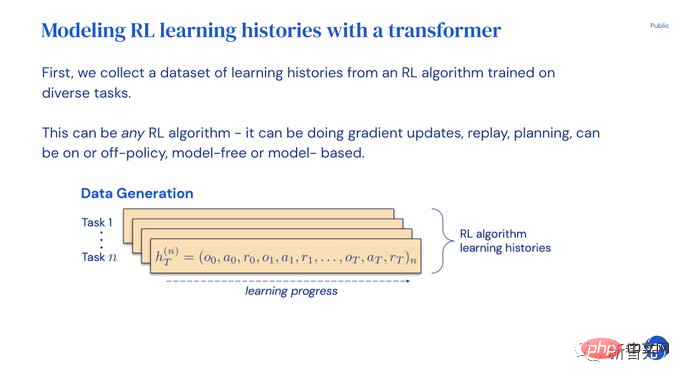

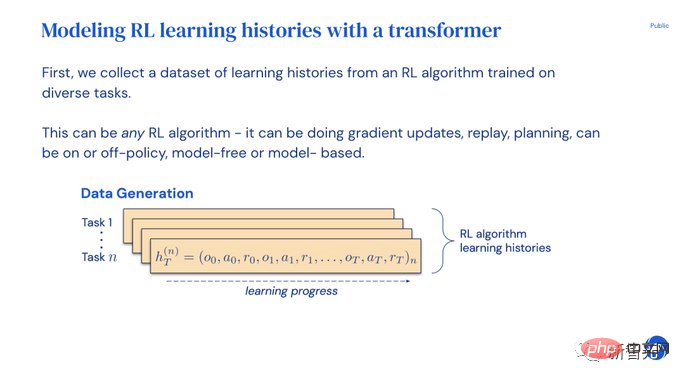

AD에는 두 가지 구성 요소가 포함됩니다.

1 많은 개별 작업에 대한 RL 알고리즘의 훈련 기록을 저장하여 대규모 다중 작업 데이터 세트를 생성합니다.

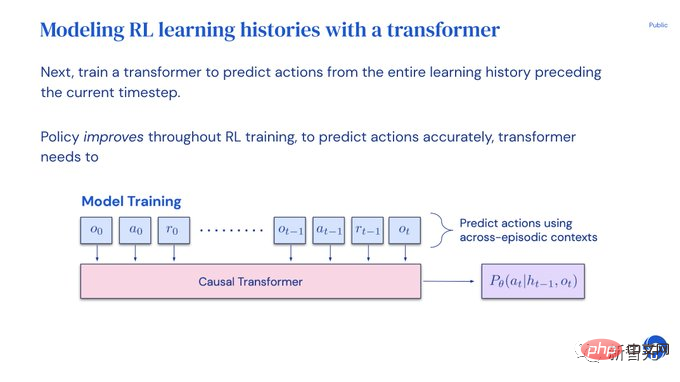

2 이전 학습 기록을 배경으로 사용하여 행동을 인과적으로 모델링합니다.

소스 RL 알고리즘의 교육 프로세스 전반에 걸쳐 정책이 계속 개선되므로 AD는 교육 기록의 특정 지점에서 작업을 정확하게 시뮬레이션하기 위해 연산자를 개선하는 방법을 배워야 합니다.

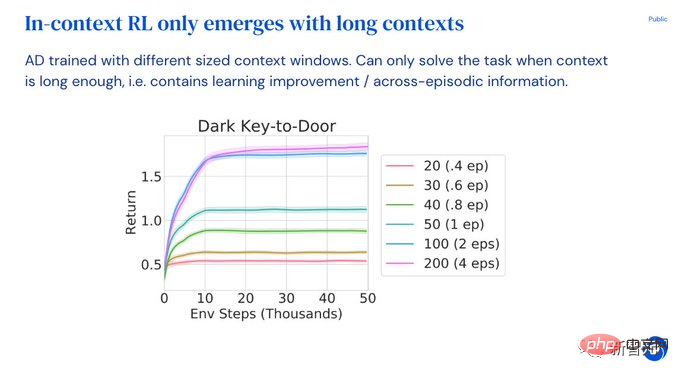

가장 중요한 점은 훈련 데이터의 개선 사항을 포착할 수 있을 만큼 Transformer의 컨텍스트 크기가 충분히 커야 한다는 것입니다(예: 시대 전반에 걸쳐).

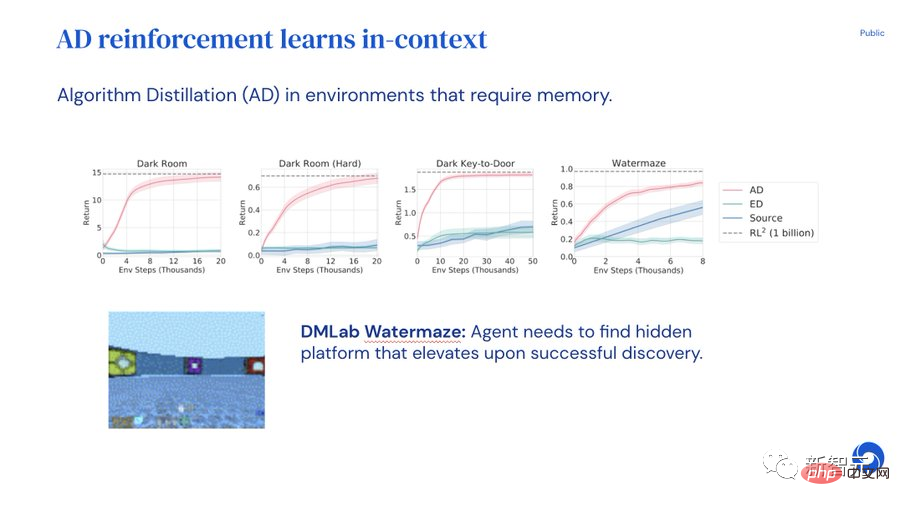

실험 부분에서는 컨텍스트 내 RL 기능에서 AD의 장점을 탐색하기 위해 연구자들은 사전 훈련 후 제로 샷 일반화로 해결할 수 없는 환경, 즉, 각 환경마다 요구되는 다양한 작업이 지원되며, 작업에 대한 해결책은 관찰을 통해 모델이 쉽게 추론할 수 없습니다. 동시에 에피소드 전반에 걸쳐 인과적 변환기를 훈련할 수 있도록 에피소드는 충분히 짧아야 합니다.

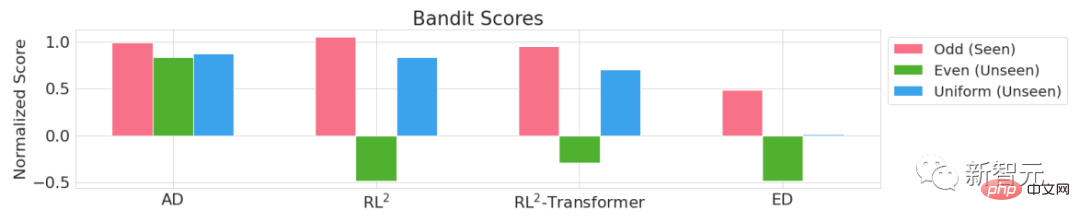

Adversarial Bandit, Dark Room, Dark Key-to-Door, DMLab Watermaze 4가지 환경의 실험 결과에서 볼 수 있듯이 그래디언트 기반 RL 알고리즘을 모방하여 큰 인과 변환기를 사용했습니다. 상황이 충분하면 AD는 상황에 따라 새로운 작업 학습을 완전히 강화할 수 있습니다.

AD는 상황 내 탐색, 시간적 크레딧 할당 및 일반화를 수행할 수 있습니다. AD에서 학습한 알고리즘은 Transformer 훈련을 위한 소스 데이터를 생성하는 알고리즘보다 데이터 효율적입니다.

논문의 이해를 돕기 위해 논문 저자 중 한 명인 Michael Laskin이 트위터에 PPT 설명을 게시했습니다.

알고리즘 증류 실험에 따르면 Transformer는 가중치, 프롬프트 또는 미세 조정을 업데이트하지 않고도 시행착오를 통해 모델을 자율적으로 개선할 수 있습니다. 단일 Transformer는 자체 데이터를 수집하고 새로운 작업에 대한 보상을 극대화할 수 있습니다.

Transformer가 맥락에서 학습하는 방법을 보여주는 성공적인 모델이 많이 있지만 Transformer는 아직 맥락에서 학습을 강화하는 것으로 입증되지 않았습니다.

새로운 작업에 적응하려면 개발자는 프롬프트를 수동으로 지정하거나 모델을 조정해야 합니다.

Transformer가 강화 학습에 적응하고 즉시 사용할 수 있다면 좋지 않을까요?

하지만 Decision Transformers나 Gato는 오프라인 데이터에서만 전략을 학습할 수 있으며 반복 실험을 통해 자동으로 개선할 수는 없습니다.

AD(Algorithmic Distillation)의 사전 학습 방법을 사용하여 생성된 Transformer는 상황에 맞게 강화 학습을 수행할 수 있습니다.

먼저 강화 학습 알고리즘의 여러 복사본을 훈련하여 다양한 작업을 해결하고 학습 기록을 저장하세요.

학습 기록 데이터 세트가 수집되면 Transformer는 이전 학습 기록의 동작을 예측하도록 훈련될 수 있습니다.

정책은 역사적으로 개선되었으므로 조치를 정확하게 예측하면 Transformer가 정책 개선을 모델링하게 됩니다.

전체 프로세스는 매우 간단합니다. Transformer는 일반적인 강화 학습 모델과 같은 Q 값이 없고, 긴 작업-작업-보상 시퀀스가 없으며, DT 조건과 같은 반환도 없습니다.

맥락에서 강화 학습에는 추가 오버헤드가 없으며 AD가 새 작업에 대한 보상을 최대화할 수 있는지 관찰하여 모델을 평가합니다.

Transformer는 상황에 따라 가중치가 고정될 때 수익을 탐색하고 활용하며 최대화합니다!

반면에 Expert Distillation(Gato와 가장 유사)은 수익을 탐색하거나 극대화할 수 없습니다.

AD는 모든 RL 알고리즘을 추출할 수 있습니다. 연구원들은 UCB 및 DQNA2C를 시도했습니다. 흥미로운 발견은 AD가 상황별 RL 알고리즘 학습에서 더 효율적이라는 것입니다.

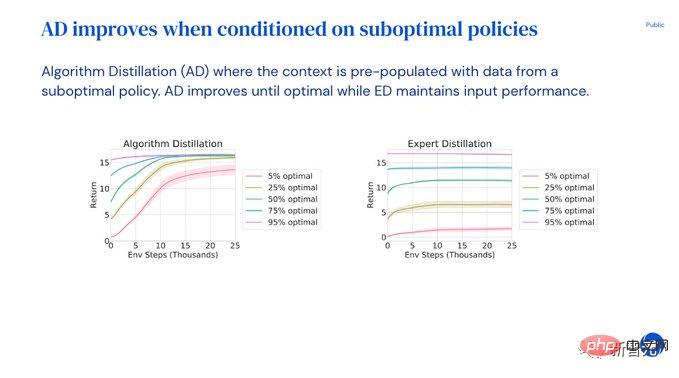

사용자는 프롬프트와 최적이 아닌 데모를 입력할 수도 있으며 모델은 최적의 솔루션을 얻을 때까지 자동으로 전략을 개선합니다!

그리고 전문 증류 ED는 차선의 데모 성능만 유지할 수 있습니다.

Context RL은 Transformer의 컨텍스트가 충분히 길고 여러 에피소드에 걸쳐 있는 경우에만 나타납니다.

AD에는 효과적인 모델 개선 및 식별 작업을 위해 충분한 긴 기록이 필요합니다.

실험을 통해 연구자들은 다음과 같은 결론에 도달했습니다.

위 내용은 강화학습의 또 다른 혁명! DeepMind는 탐색 가능한 사전 훈련된 강화 학습 Transformer인 '알고리즘 증류'를 제안합니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!