2D 및 3D 센서(예: RGB 센서, LiDAR 또는 레이더)를 사용한 인간 자세 추정은 자율 주행 및 VR과 같은 애플리케이션을 통해 지난 몇 년 동안 큰 발전을 이루었습니다. 그러나 이러한 센서에는 기술적으로나 실제 사용에 있어서 몇 가지 제한 사항이 있습니다. 우선 비용이 많이 들고, 일반 가정이나 중소기업에서는 LiDAR와 레이더 센서를 감당할 수 없는 경우가 많습니다. 둘째, 이러한 센서는 일상 및 가정용으로 사용하기에는 전력을 너무 많이 소모합니다.

RGB 카메라의 경우 좁은 시야와 열악한 조명 조건은 카메라 기반 방법에 심각한 영향을 미칠 수 있습니다. 폐색은 카메라 기반 모델이 이미지에서 합리적인 포즈 예측을 생성하는 것을 방해하는 또 다른 장애물이 됩니다. 실내 장면은 가구가 사람을 가로막는 경우가 많기 때문에 특히 어렵습니다. 더욱이, 개인 정보 보호 문제로 인해 비공개 장소에서 이러한 기술을 사용하는 데 방해가 되며 많은 사람들이 자신의 행동을 기록하기 위해 집에 카메라를 설치하는 것을 꺼려합니다. 그러나 의료 분야에서는 안전, 건강 및 기타 이유로 인해 많은 노인들이 카메라 및 기타 센서의 도움을 받아 실시간 모니터링을 수행해야 하는 경우가 있습니다.

최근 CMU의 세 연구원은 "DensePose From WiFi"라는 논문에서 어떤 경우에는 인체 인식을 위한 RGB 이미지 대신 WiFi 신호를 사용할 수 있다고 제안했습니다. 조명과 차폐는 실내 감시용 WiFi 솔루션에 거의 영향을 미치지 않습니다. WiFi 신호는 개인 정보를 보호하는 데 도움이 되며 필요한 장비는 저렴합니다. 중요한 점은 많은 가정에 WiFi가 설치되어 있으므로 이 기술이 잠재적으로 노인의 건강을 모니터링하거나 가정 내 의심스러운 행동을 식별하는 데까지 확장될 수 있다는 것입니다.

논문 주소: https://arxiv.org/pdf/2301.00250.pdf

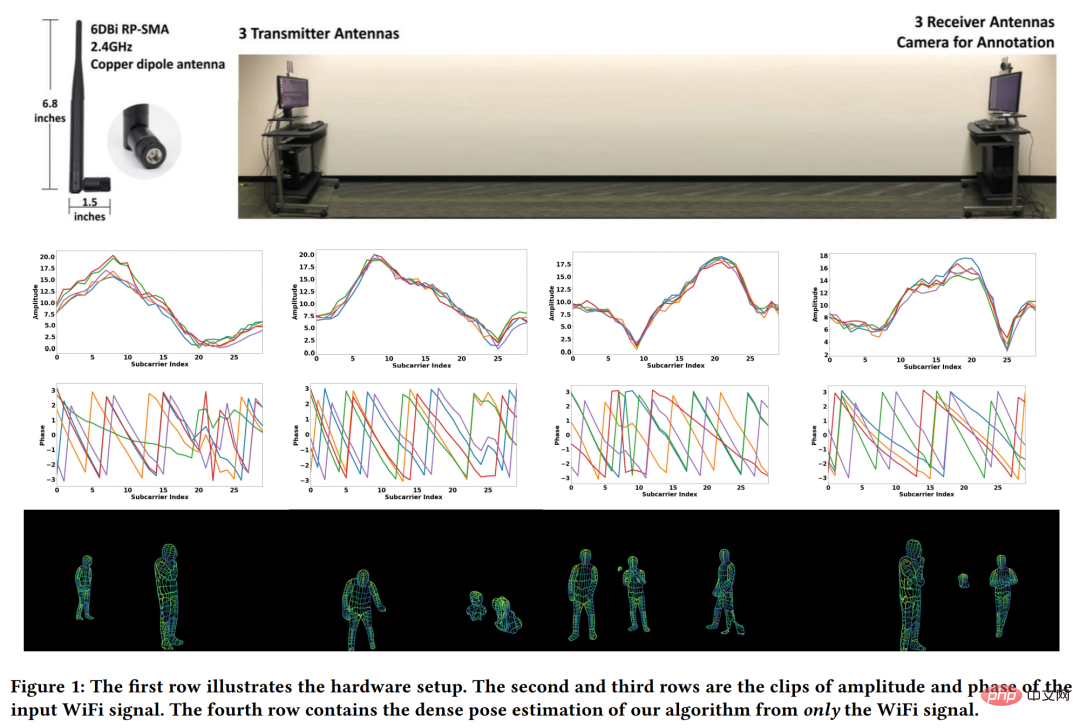

연구원이 해결하고자 하는 문제는 아래 그림 1의 첫 번째 행에 나와 있습니다. 3개의 WiFi 송신기와 3개의 해당 수신기가 있으면 여러 사람이 있는 복잡한 환경에서 밀집된 인간 자세 대응을 감지하고 복원할 수 있습니까(그림 1의 네 번째 줄)? 많은 WiFi 라우터(예: TP-Link AC1750)에는 3개의 안테나가 있으므로 이 방법에는 해당 라우터 2개만 필요합니다. 각 라우터의 가격은 약 30달러입니다. 이는 전체 설정이 LiDAR 및 레이더 시스템보다 여전히 훨씬 저렴하다는 것을 의미합니다.

그림 1의 네 번째 행의 효과를 달성하기 위해 연구원은 컴퓨터 비전의 딥러닝 아키텍처에서 영감을 얻어 WiFi 기반으로 조밀한 포즈 추정을 수행할 수 있는 신경망 아키텍처를 제안하고 이를 구현했습니다. 가림막이 있고 여러 사람이 있는 장면에서는 WiFi 신호만 사용하여 조밀한 포즈를 추정합니다.

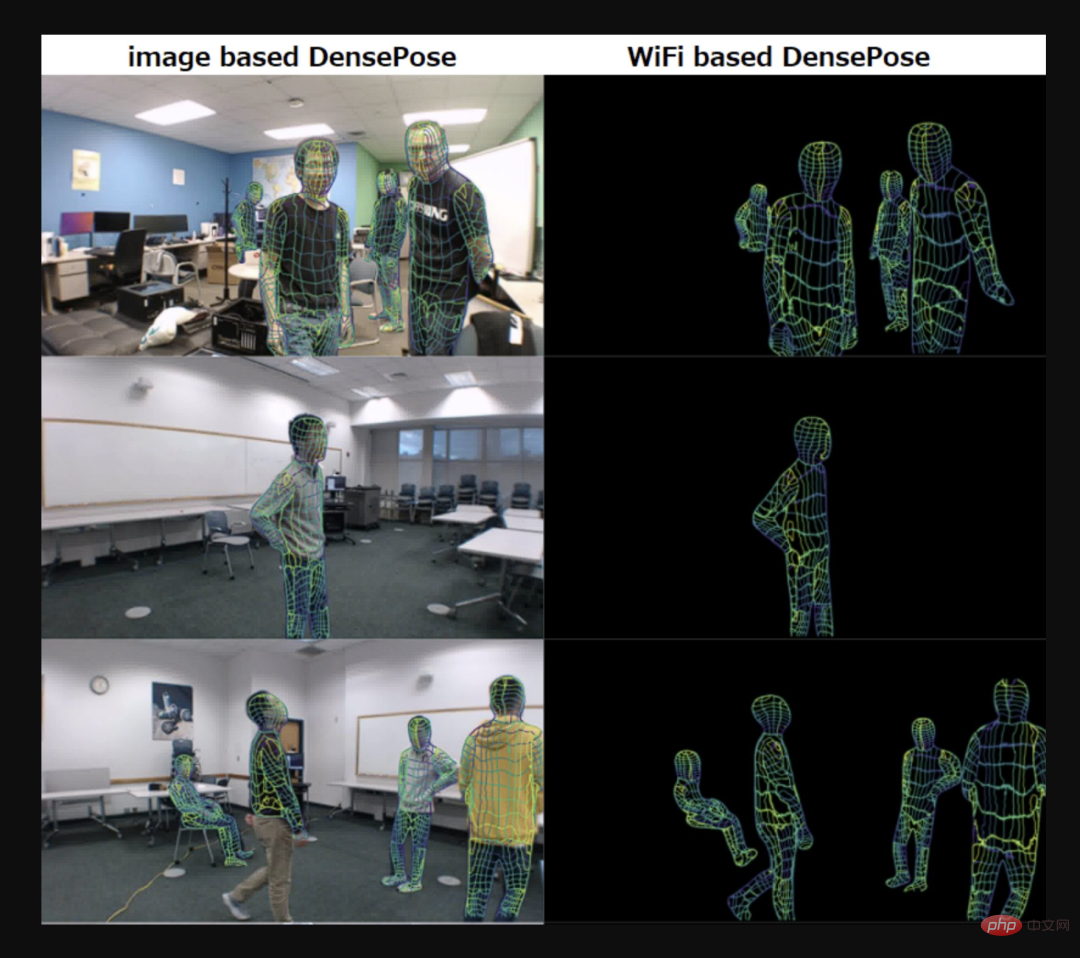

아래 왼쪽 사진은 이미지 기반의 DensePose, 오른쪽 사진은 WiFi 기반의 DensePose입니다.

사진 출처: Twitter @AiBreakfast

또한, 논문의 첫 번째 저자와 두 번째 저자가 모두 중국인이라는 점을 언급할 가치가 있습니다. 논문의 첫 번째 저자인 Jiaqi Geng은 작년 8월 CMU에서 로봇공학 석사 학위를 취득했으며, 두 번째 저자인 Dong Huang은 현재 CMU의 선임 프로젝트 과학자입니다.

방법 소개

WiFi를 사용하여 인체 표면의 UV 좌표를 생성하려면 세 가지 구성 요소가 필요합니다. 첫째, 진폭 및 위상 단계를 통해 원래 CSI(채널 상태 정보를 나타냄) 전송 신호 파동 및 수신 신호가 정리되고 처리된 다음 처리된 CSI 샘플이 이중 분기 인코더-디코더 네트워크를 통해 2D 기능 맵으로 변환된 다음 2D 기능 맵이 DensePose-RCNN( 주로 2D 이미지를 3D 인체 모델로 변환하여 UV 맵을 추정합니다.

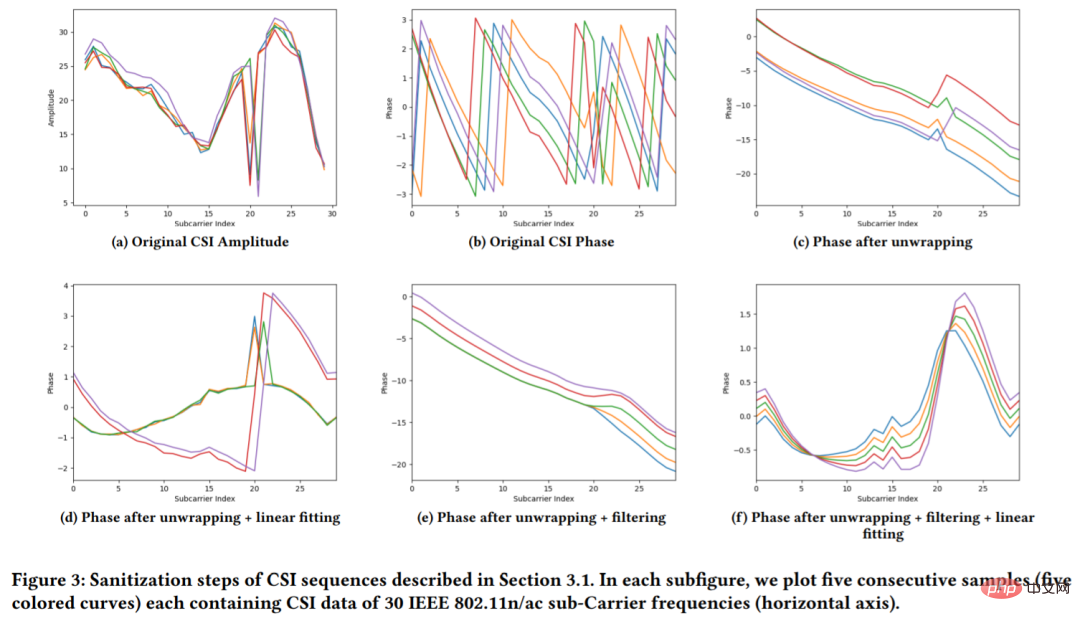

원래 CSI 샘플은 잡음이 많습니다(그림 3 (b) 참조). 뿐만 아니라 대부분의 WiFi 기반 솔루션은 CSI 신호 위상을 무시하고 신호 진폭에 중점을 둡니다(그림 3 (a) 참조). 그러나 단계 정보를 삭제하면 모델 성능에 부정적인 영향을 미칠 수 있습니다. 따라서 본 연구에서는 CSI 정보를 보다 잘 활용하기 위해 안정적인 위상 값을 얻기 위해 삭제 처리를 수행합니다.

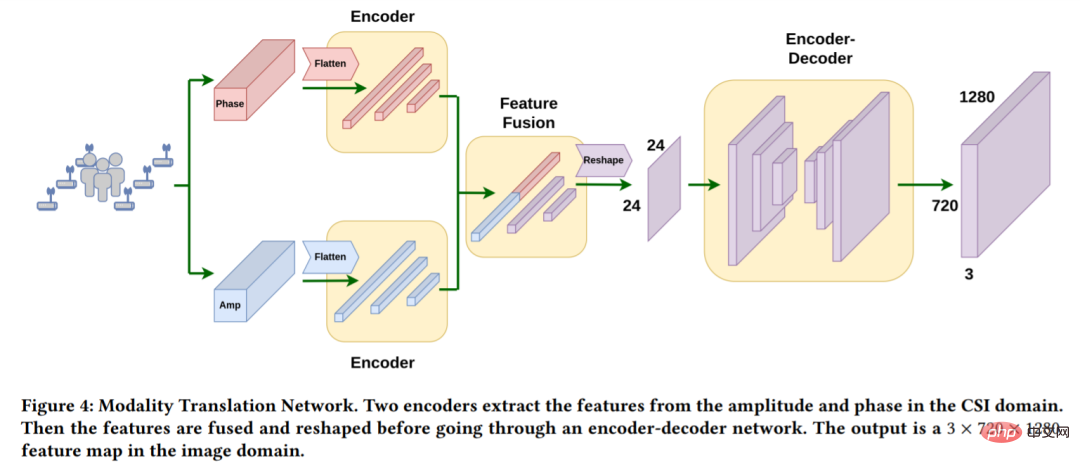

1차원 CSI 신호에서 공간 영역의 UV 매핑을 추정하려면 먼저 네트워크 입력을 CSI 영역에서 공간 영역으로 변환해야 합니다. 이 기사는 Modality Translation Network(그림 4 참조)를 사용하여 완성되었습니다. 몇 가지 작업을 수행하면 WiFi 신호에 의해 생성된 이미지 영역에서 3×720×1280 장면 표현을 얻을 수 있습니다.

이미지 도메인에서 3×720×1280 장면 표현을 얻은 후 본 연구에서는 DensePose-RCNN, WiFi-DensePose RCNN과 유사한 네트워크 아키텍처를 채택하여 인체 UV 맵을 예측합니다. 구체적으로, WiFi-DensePose RCNN(그림 5)에서는 ResNet-FPN을 백본으로 사용하고 획득된 3×720×1280 이미지 특징 맵에서 공간 특징을 추출합니다. 그런 다음 출력은 지역 제안 네트워크에 공급됩니다. 다양한 소스의 보완 정보를 더 잘 활용하기 위해 WiFi-DensePose RCNN에는 DensePose 헤드와 Keypoint 헤드라는 두 가지 분기도 포함되어 있으며, 그 후 처리 결과가 병합되어 정제 장치에 입력됩니다.

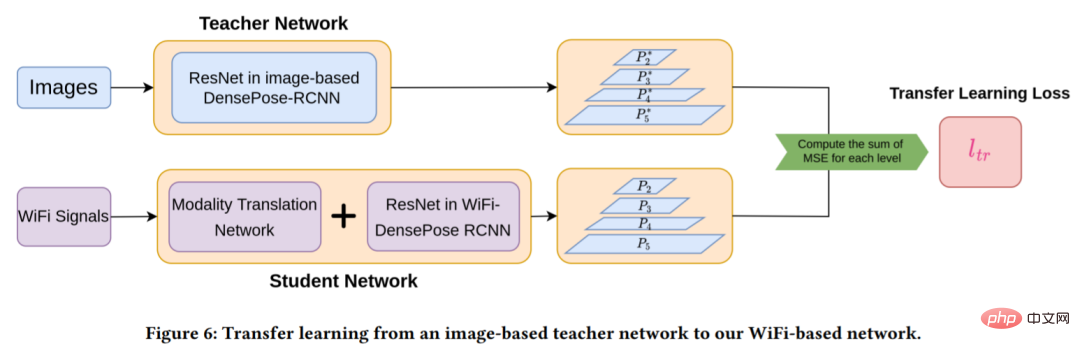

그러나 무작위 초기화를 통해 Modality Translation Network 및 WiFi-DensePose RCNN 네트워크를 훈련하려면 많은 시간(약 80시간)이 필요합니다. 훈련 효율성을 높이기 위해 본 연구에서는 이미지 기반 DensPose 네트워크를 WiFi 기반 네트워크로 마이그레이션했습니다(자세한 내용은 그림 6 참조).

이미지 기반 네트워크 가중치를 사용하여 WiFi 기반 네트워크를 직접 초기화할 수 없으므로 본 연구에서는 먼저 이미지 기반 DensePose-RCNN 모델을 교사 네트워크로 학습했으며 학생 네트워크는 모달리티로 구성됩니다. 번역 네트워크 및 WiFi-DensePose RCNN 구성. 이는 학생 모델과 교사 모델에서 생성된 다층 특징 맵 간의 차이를 최소화하는 것이 목적입니다.

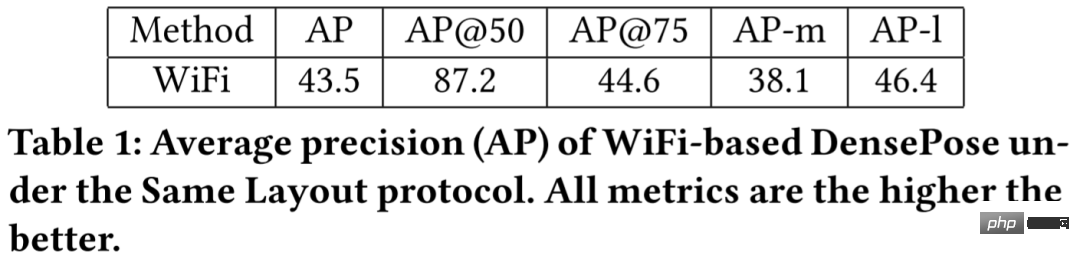

표 1 결과는 WiFi 기반 방법이 87.2라는 매우 높은 AP@50 값을 얻었음을 보여주며, 이는 모델이 사람 경계 상자의 대략적인 위치를 효과적으로 감지할 수 있음을 보여줍니다. AP@75는 35.6의 값으로 상대적으로 낮으며 이는 인체 세부 사항이 완벽하게 추정되지 않음을 나타냅니다.

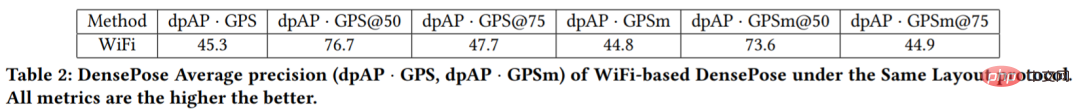

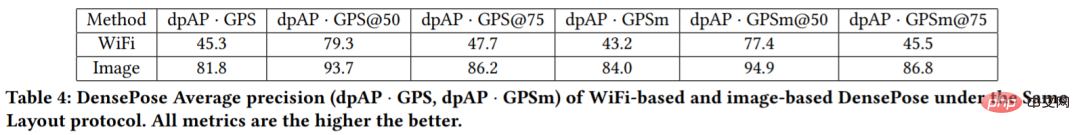

표 2의 결과는 dpAP・GPS@50 및 dpAP・GPSm@50 값이 더 높지만, dpAP・GPS@75 및 dpAP・GPSm@75 값이 더 낮은 것을 보여줍니다. 이는 우리 모델이 인간 몸통의 자세를 잘 추정하지만 팔다리와 같은 세부 사항을 감지하는 데 여전히 어려움이 있음을 보여줍니다.

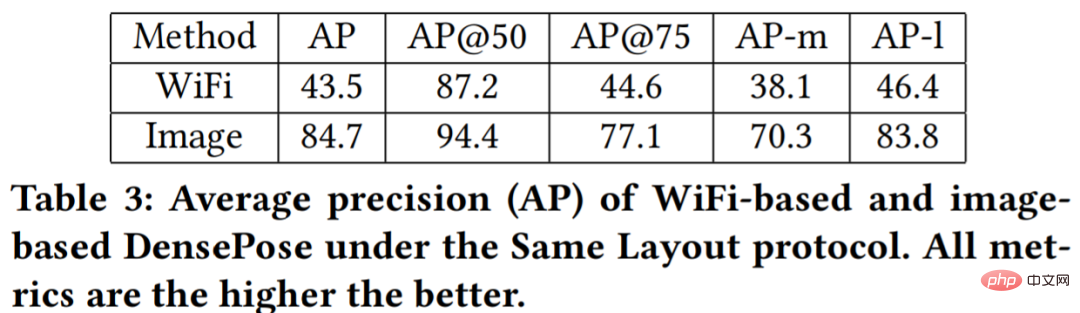

표 3과 표 4의 정량적 결과를 보면 이미지 기반 방식이 WiFi 기반 방식에 비해 매우 높은 AP를 제공하는 것으로 나타났습니다. WiFi 기반 모델의 AP-m 값과 AP-l 값의 차이는 상대적으로 작습니다. 연구에 따르면 이는 카메라에서 멀리 있는 사람들이 이미지에서 공간을 덜 차지하여 해당 물체에 대한 정보가 적기 때문이라고 합니다. 대신 WiFi 신호에는 피사체의 위치에 관계없이 전체 장면에 대한 모든 정보가 포함됩니다.

위 내용은 폐쇄를 두려워하지 않는 전신 추적, CMU의 중국인 두 명이 WiFi 신호를 기반으로 DensePose를 만들었습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!