구글의 바드(Bard)가 뒤집혔지만, 여전히 구글의 AI 강점은 과소평가할 수 없습니다.

제프 딘이 주도하는 구글 리서치 연말 요약 시리즈 "Google Research, 2022 & Beyond"가 연초부터 꾸준히 업데이트되어 최근 4호까지 업데이트 되었습니다.

이번 호의 주제는 "모델 효율성 향상"입니다. Google 엔지니어들이 어떤 아이디어를 생각해 냈는지 살펴보겠습니다!

지난 10년 동안 딥 러닝은 새로운 알고리즘과 아키텍처의 통합, 데이터 볼륨의 상당한 증가, 컴퓨팅 성능의 향상으로 인해 폭발적인 발전을 경험했습니다.

10년 전과 비교하면 인공 지능과 기계 학습 모델은 더 깊고 복잡한 네트워크 구조, 더 많은 매개변수, 훈련에 사용되는 더 많은 데이터를 통해 더 크고 복잡해졌습니다. 이를 통해 함께 가장 혁신적인 결과를 얻을 수 있습니다. 머신러닝의 역사에서.

이러한 모델이 프로덕션 및 비즈니스 애플리케이션에 점점 더 많이 배포됨에 따라 모델의 추론 효율성과 운영 비용이 이차적 요소에서 주요 제한 요소로 바뀌었습니다.

이와 관련하여 Google의 대응은 주로 다음 네 가지 문제를 해결하기 위해 기계 학습 효율성에 집중적으로 투자하는 것입니다.

1. 효율적인 모델 아키텍처(Efficient Architecture)

2. 데이터 효율성

3. 훈련 효율성

4. 추론 효율성

효율성 외에도 모델은 신뢰성, 보안, 개인 정보 보호 및 신선도와 관련된 많은 문제에 직면합니다.

이 기사에서는 위의 문제를 해결하기 위해 Google Research에서 개발한 일련의 새로운 알고리즘에 중점을 둘 것입니다.

기본적인 질문은: 효율성을 향상시키기 위해 모델을 매개변수화하는 더 좋은 방법이 있습니까?

2022년 Google Research는 컨텍스트를 검색하고 전문가를 혼합하여 변환기(대부분의 대규모 기계 학습 모델의 핵심)를 더 효율적으로 만들어 외부 지식을 주입함으로써 모델을 향상시키는 새로운 기술에 중점을 두고 있습니다.

컨텍스트 증강 모델

더 높은 품질과 효율성을 추구하기 위해 신경 모델은 대규모 데이터베이스 또는 훈련 가능한 메모리의 외부 컨텍스트에서 향상될 수 있습니다.

검색된 컨텍스트를 활용함으로써 신경망은 내부 매개변수에 많은 양의 세계 지식을 기억할 필요가 없으며 더 나은 매개변수 효율성, 해석 가능성 및 현실성을 달성할 수 있습니다.

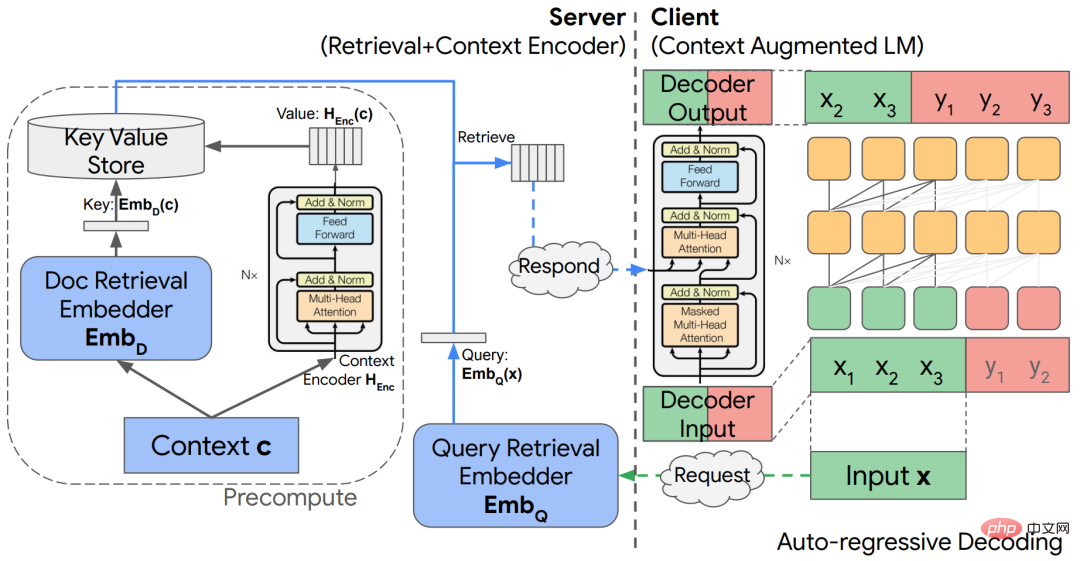

"컨텍스트 증강 언어 모델링을 위한 분리된 컨텍스트 처리" 기사에서 연구자들은 외부 컨텍스트를 언어 모델에 통합하기 위해 분리된 코덱 아키텍처를 기반으로 하는 간단한 아키텍처를 탐색합니다.

문서 링크: https://arxiv.org/abs/2210.05758

이 모델은 자동 회귀 언어 모델링 영역을 열면서 계산 노력을 크게 절약할 수 있으며 경쟁 결과는 다음과 같습니다. 질의응답 과제에 주어졌습니다.

사전 훈련된 LLM(대형 언어 모델)은 대규모 훈련 세트의 자체 감독을 통해 많은 정보를 소비하지만 이러한 모델의 "세계 지식"이 입력 컨텍스트와 어떻게 상호 작용하는지 불분명합니다.

연구원은 KAFT(지식 인식 미세 조정)를 통해 반사실적 컨텍스트와 관련 없는 컨텍스트를 표준 지도 데이터 세트에 결합하여 LLM 섹스의 제어 가능성과 견고성을 향상시킵니다.

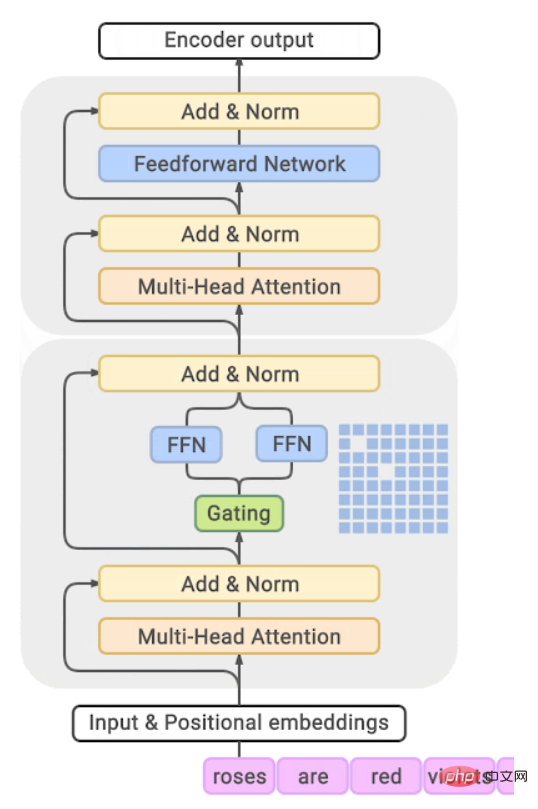

모듈형 심층 네트워크를 탐색할 때의 문제점 중 하나는 해당 컴퓨팅 모듈로 개념 데이터베이스를 설계하는 방법입니다. 연구원들은 포인터 모듈을 포함하는 외부 LSH 테이블에 스케치 형식으로 "기억 이벤트"를 저장하는 이론적 아키텍처를 제안했습니다. 스케치를 처리합니다.

컨텍스트 증강 모델의 또 다른 퍼즐 조각은 대규모 데이터베이스에서 정보를 빠르게 검색하기 위한 가속기입니다.

연구원들은 TPU의 성능 모델과 일치하고 예상 재현율에 대한 분석적 보장을 제공하여 최적의 성능을 제공하는 TPU 기반 최근접 이웃 검색 알고리즘을 개발했습니다.

검색 알고리즘에는 일반적으로 많은 수의 하이퍼파라미터와 설계 선택이 포함되어 있어 새로운 작업에 대한 최적화가 어렵습니다. 따라서 연구원들은 하이퍼파라미터를 원하는 대로 자동으로 조정하는 새로운 제한된 최적화 알고리즘을 제안했습니다. 입력으로 알고리즘은 경험적으로 속도 재현의 파레토 경계에 매우 가까운 조정을 생성하고 표준 벤치마크에서 최고의 성능을 제공합니다.

전문가 혼합 모델

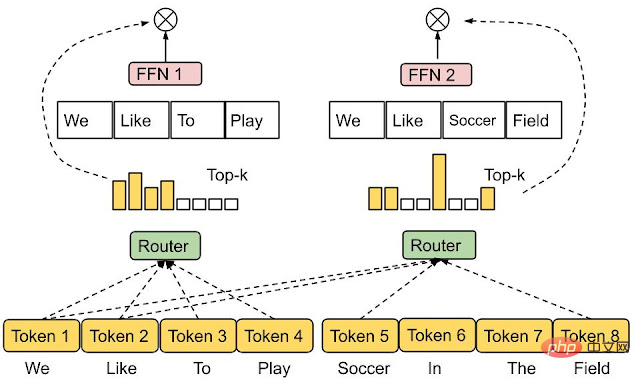

전문가 혼합(MoE, Mixture-of-experts) 모델은 과도하게 증가하지 않고 신경망 모델의 용량을 늘리는 효과적인 수단임이 입증되었습니다. 계산 비용. MoE의 기본 아이디어는 여러 전문가 하위 네트워크에서 네트워크를 구축하는 것입니다. 여기서 각 입력은 적절한 전문가 하위 네트워크에 의해 처리됩니다.

따라서 MoE는 표준 신경망에 비해 전체 모델의 작은 부분만 호출하므로 GLaM과 같은 언어 모델 응용 프로그램의 효율성이 향상됩니다.

특정 입력에 참여하기 위해 어떤 전문가가 적극적으로 참여해야 하는지 결정하는 것은 라우팅 기능에 따라 다릅니다. 개발자는 각 전문가 모델이 적절하고 적합하지 않을 것이라고 기대하기 때문에 라우팅 설계는 매우 어렵습니다. 활용도가 낮거나 과도하게 활용됩니다.

최근 연구에서 연구원들은 각 입력 토큰을 상위 k 전문가에게 할당하는 대신 각 전문가를 상위 k 토큰에 할당하는 새로운 라우팅 메커니즘인 전문가 선택 라우팅을 제안했습니다. 여러 전문가가 자연스럽게 입력 토큰을 처리하도록 허용하면서 전문가의 로드 밸런싱을 자동으로 조정할 수 있습니다

문서 링크: https: //openreview.net/pdf?id=jdJo1HIVinI

Efficient Transformers

Transformer는 현재 비전부터 자연어 이해까지 일련의 기능을 통해 가장 인기 있는 시퀀스-투-시퀀스 모델로, 까다로운 작업에서 매우 강력한 성능을 보여주었습니다.

이 유형의 모델의 핵심 구성 요소는 "쿼리"와 "키"(값) 가중치 조합 간의 유사성을 계산하여 적절한 "값"을 구성하는 주의 계층입니다. 성능은 강력하지만 Attention 메커니즘의 계산 효율성은 높지 않으며 복잡성은 일반적으로 입력 시퀀스 길이의 두 번째 거듭제곱입니다.

Transformer의 규모가 계속 확장됨에 따라 중요한 문제 중 하나에 대한 연구는 매우 중요합니다. 즉, 효과적인 주의 원리를 이해할 수 있는 자연 발생 구조나 패턴 학습 모델이 있는지 여부입니다.

이와 관련하여 Google Research에서는 중간 MLP 레이어의 학습 임베딩을 연구한 결과 매우 희소하다는 사실을 발견했습니다. 예를 들어 T5 대형 모델에는 0이 아닌 항목이 1% 미만이라는 사실도 추가로 나타납니다.

의 경우 모델 성능에 영향을 주지 않고 FLOP를 줄일 수 있습니다. 문서 링크: https://arxiv.org/pdf/2210.06313.pdf

연구원들은 최근 의사결정 트리에 의존하는 표준 주의 계산의 대안인 Treeformer 모델을 제안했습니다. 이 모델은 쿼리와 관련된 작은 키 집합을 직관적으로 신속하게 식별하고 이 집합 강제 연산에만 주의를 기울일 수 있도록 해줍니다. 경험을 바탕으로 Treeformer는 Attention 레이어의 FLOP를 30배까지 줄일 수 있습니다.

동시에 연구자들은 Attention과 Greedy 알고리즘을 결합한 차별화 가능한 특징 선택 방법인 Sequential Attention을 도입했으며 이 기술은 대규모 모델에 직접적이고 원활하게 적용할 수 있음이 입증되었습니다.

Transformer의 효율성을 높이는 또 다른 방법은 Attention 레이어에서 소프트맥스 계산 속도를 높이는 것입니다.

소프트맥스 커널의 하위 순위 근사 연구를 기반으로 연구원들은 소프트맥스 커널의 최초의 "양수 및 경계가 있는" 무작위 특징 근사치를 제공하는 새로운 유형의 무작위 특징을 제안했으며, 시퀀스 길이는 선형적으로 계산됩니다. .

논문 링크: https://arxiv.org/abs/2205.15317

또한 인과 코딩 및 상대 위치 인코딩과 같은 다중 주의 마스킹을 다루는 첫 번째 메커니즘을 제안했습니다. .

효과적인 최적화 방법은 최신 기계 학습 애플리케이션의 초석이며 대규모 환경에서 특히 중요합니다.

이 경우 Adam과 같은 1차 적응 방법이라도 계산이 많이 필요한 경향이 있어 훈련의 안정성이 매우 어려워집니다.

또한 이러한 방법은 신경망의 아키텍처와 관련이 없는 경우가 많으며 모델 아키텍처 내의 구조적 정보를 고려하지 않아 훈련 효율성이 낮습니다. 이는 또한 최신 신경망 모델을 보다 효과적으로 최적화하는 새로운 기술을 장려합니다. .

Google Research는 원래 확률론적 경사하강법(SGD)과 비교할 때 새로운 스케일 불변 Transofmre 네트워크 및 새로운 클리핑 방법을 포함하여 Transofmre 네트워크 교육을 위해 모델 아키텍처를 기반으로 한 몇 가지 새로운 교육 기술을 개발했습니다. ) 결합하면 훈련이 가속화될 수 있습니다.

논문 링크: https://arxiv.org/pdf/2202.00980.pdf

이 방법을 사용하여 연구원들은 처음으로 간단한 SGD만을 사용하여 효율적으로 훈련하는 것을 달성했습니다. 적응성이 없는 BERT.

또한 연구진은 1차 최적화와 동일한 컴퓨팅 및 메모리 리소스를 사용하면서 2차 최적화와 유사한 성능을 얻기 위해 새로운 방법인 LocoProp을 제안했습니다.

LocoProp은 신경망을 레이어 조합으로 분해하여 신경망의 모듈식 보기를 얻습니다. 그런 다음 각 레이어는 자체 손실 함수와 출력 목표 및 가중치 조정자를 가질 수 있습니다. 이 설정을 사용하면 적절한 순방향 및 역방향 그래디언트 전달 후 LocoProp은 각 레이어의 "로컬 손실"에 대한 병렬 업데이트를 계속 수행합니다.

논문 링크: https://proceedings.mlr.press/v151/amid22a.html

실제로 이러한 업데이트는 이론적, 경험적으로 High와 유사합니다. -차수 최적화 프로그램인 LocoProp은 딥 오토인코더 벤치마크에서 고차 최적화 프로그램과 비슷한 성능을 달성하면서 훨씬 더 빠릅니다.

SGD와 같은 옵티마이저의 주요 가정은 각 데이터 포인트가 분포에서 독립적이고 동일하게 샘플링된다는 것입니다. 그러나 강화 학습과 같은 실제 응용 설정에서는 모델( 또는 에이전트)는 자체 예측을 기반으로 생성된 데이터에서 학습해야 합니다.

연구원들은 이러한 상황에서 선형 동적 시스템, 비선형 동적 시스템 및 강화 학습의 Q-학습에 사용할 수 있는 역방향 경험 재생 기능을 갖춘 SGD라는 새로운 알고리즘 방법을 제안했습니다.

논문 링크:https://arxiv.org/abs/2103.05896

또한 이 방법의 개선된 버전인 IER이 실험적으로 입증되었습니다. -the-art, 다양한 인기 RL 벤치마크에서 가장 안정적인 경험 재생 기술입니다.

심층 신경망은 대규모 데이터세트에 크게 의존하며 이로 인해 스토리지 비용과 잠재적인 보안/개인정보 보호 문제가 발생합니다.

이 문제를 해결하는 유망한 방법은 데이터 하위 집합 선택입니다. 여기서 학습자의 목표는 많은 훈련 샘플에서 가장 유익한 하위 집합을 찾아 전체 훈련 세트의 훈련에 접근(또는 개선)하는 것입니다. .

연구원들은 학습자가 한 번에 하나의 샘플을 샘플링하여 컨텍스트 및 정답 레이블에 액세스할 수 있지만 오버헤드를 제한하기 위해 임의의 모델 패밀리와 함께 작동하도록 설계된 하위 집합 선택 프레임워크를 분석했습니다. , 충분히 큰 샘플 배치가 선택되면 해당 상태만 업데이트될 수 있습니다. 즉, 모델 가중치를 추가로 훈련할 수 있습니다.

이를 기반으로 중요도 샘플링을 통해 샘플을 선택하는 IWeS라는 알고리즘을 개발했습니다. 여기서 각 샘플에 할당된 샘플링 확률은 이전에 선택한 배치에 대해 훈련된 모델의 엔트로피를 기반으로 합니다. 이 논문은 일반화 및 샘플링 속도의 한계를 보여주는 이론적 분석을 제공합니다.

문서 링크: https://arxiv.org/pdf/2301.12052.pdf

대규모 네트워크 교육의 또 다른 문제는 그들이 수행하는 작업에 부정적인 영향을 미칠 수 있다는 것입니다. 훈련 데이터 및 데이터 간 분포 변경은 매우 민감하며, 특히 모든 배포 시간 시나리오를 포함하지 않을 수 있는 제한된 양의 훈련 데이터를 처리할 때 더욱 그렇습니다.

최근 연구에서는 "극단적인 단순 편향"이 신경망의 취약성 뒤에 있는 핵심 문제라는 가설을 세웠으며, 최신 연구에서는 이 가설을 실현 가능하게 하여 두 가지 새로운 보완 방법인 DAFT와 FRR을 개발했습니다. 이 조합은 훨씬 더 많은 것을 제공합니다. 강력한 신경망. 특히, 이 두 가지 방법은 학습 네트워크의 견고성을 향상시키기 위해 적대적인 미세 조정과 역 특징 예측을 사용합니다.

논문 링크: https://arxiv.org/pdf/2006.07710.pdf

신경망의 크기를 늘리면 성능이 향상되는 것으로 나타났습니다. 예측 정확도 그러나 실제 세계에서 이러한 장점을 활용하는 것은 대규모 모델에 대한 추론 비용이 엄청날 수 있기 때문에 어려운 일입니다. 이 문제는 정확도를 희생하지 않고 서비스 효율성을 향상시키는 전략을 촉발하기도 했습니다.

연구원들은 이 목표를 달성하기 위해 특히 지식 증류 및 적응형 컴퓨팅을 기반으로 하는 다양한 전략을 제안했습니다.

Distillation

Distillation은 대규모 신경 모델의 잠재적 적용 가능성을 크게 확장하는 간단하고 효과적인 모델 압축 방법이며, 광고 추천과 같은 일련의 실제 응용 분야에서 매우 효과적인 것으로 입증되었습니다.

대부분의 증류 사용 사례에는 기본 모델을 특정 도메인에 직접 적용하는 작업이 포함되며, 이 작업을 수행해야 하는 시기와 이유에 대한 이해가 제한되어 있습니다. Google의 연구에서는 특정 상황에 맞게 증류를 조정하는 방법을 살펴보고 증류 성공을 결정하는 요소를 체계적으로 조사합니다.

알고리즘 측면에서 연구원들은 교사 모델이 제공하는 레이블의 노이즈를 신중하게 모델링함으로써 교육 사례에 가중치를 다시 부여하는 원칙적인 방법과 교사 레이블을 사용하여 데이터의 하위 집합을 샘플링하는 강력한 방법을 개발했습니다.

논문 링크: https://arxiv.org/abs/2210.06711

"교사 지도 교육" 과정에서 연구자들은 새로운 증류 프레임워크를 제안했습니다. 고정된 데이터 세트에 라벨을 지정하기 위해 교사를 수동적으로 사용하는 대신, 라벨링을 위한 정보 샘플 선택을 안내하는 데 교사가 적극적으로 사용됩니다. 제한된 데이터 또는 롱테일 설정에서 증류 공정이 더 효율적입니다. ㅋㅋㅋ 인코더는 (쿼리, 문서) 쌍의 관련성을 평가하는 중요한 설정이기도 합니다.

논문 링크: https://proceedings.mlr.press/v162/menon22a/menon22a.pdf

논문에서는 크로스 엔코더와 듀얼 엔코더 간의 성능 격차를 연구한 이유가 있습니다. , 이는 듀얼 인코더의 용량 제한이라기보다는 일반화의 결과일 수 있다고 밝혔습니다.

신중하게 구성된 증류 손실 기능은 이러한 상황을 완화하고 크로스 인코더와 듀얼 인코더 간의 성능 격차를 줄일 수 있습니다.

이어서 Teacher 모델의 임베딩 일치를 통한 이중 인코더 증류의 추가 개선이 EmbedDistil에서 추가로 연구되었습니다. 이 전략은 또한 교사 문서 임베딩을 상속하고 고정하는 것이 매우 효과적인 것으로 입증된 크고 작은 듀얼 인코더 모델에서 정보를 추출하는 데 사용될 수 있습니다.

논문 링크: https://arxiv.org/abs/2301.12005

학생들을 측정하기 위해 감독된 복잡성의 증류를 통해 이론에 대한 새로운 관점을 제공합니다. 교사 라벨을 예측할 수 있습니다.

문서 링크: https://arxiv.org/abs/2301.12245

신경 접선 커널(NTK) 이론을 사용하여 다음과 같은 몇 가지 개념적 결론이 도출됩니다. 능력 격차는 증류에 영향을 미칠 수 있습니다. 교사의 라벨은 순전히 무작위 학생 라벨과 유사하게 나타날 수 있습니다.

논문 링크: https://arxiv.org/abs/2301.12923

동시에 증류가 학생의 과소적합으로 이어지는 지점이 교사 모델에도 어려움 문제는 직관적으로 학생들이 합리적으로 모델링할 수 있는 샘플에 제한된 능력을 집중하는 데 도움이 될 수 있습니다.

적응형 계산

적응형 계산

증류는 추론 비용을 줄이는 효과적인 방법이지만 그 효과는 모든 샘플에서 균일하게 나타납니다. 직관적으로 일부 "간단한" 샘플은 상대적으로 "더 어려운" 샘플보다 계산이 덜 필요할 수 있습니다. " 견본.

적응형 컴퓨팅의 목표는 이러한 샘플 종속 계산을 수행할 수 있는 메커니즘을 설계하는 것입니다.

CALM(Confident Adaptive Language Modeling)은 T5와 같은 Transformer 기반 텍스트 생성기에 대한 제어된 조기 종료 기능을 도입합니다.

문서 링크: https://arxiv.org/abs/2207.07061

이러한 형태의 적응형 계산에서 모델은 초기 종료가 발생하는 Transformer 레이어를 동적으로 수정합니다. 게이트는 통계적 성능 보장을 충족하도록 보정된 결정 임계값과 함께 신뢰도 측정항목을 사용합니다.

이렇게 하면 모델은 가장 어려운 예측을 위해 전체 디코더 레이어 스택만 계산하고, 더 간단한 예측을 위해서는 몇 개의 디코더 레이어만 계산하면 됩니다. 실제로 모델은 예측을 위해 평균적으로 약 1/3 많은 레이어를 사용하므로 동일한 수준의 발전 품질을 유지하면서 속도가 2~3배 향상됩니다.

일반적으로 사용되는 적응형 계산 메커니즘은 두 개 이상의 기본 모델로 구성됩니다. 핵심 문제는 단순히 현재 모델의 예측을 사용할지 아니면 예측을 다운스트림 모델로 연기할지 결정하는 것입니다. 결정을 연기하기 위한 감독으로 적절한 신호를 활용할 수 있는 적절한 손실 기능입니다.

Google Research는 기존 손실 함수를 체계적으로 연구했으며 레이블 평활화의 암시적 적용으로 인해 훈련 샘플에 적합하지 않을 수 있음을 입증했습니다. 또한 논문에서는 이러한 상황이 지연 규칙의 사후 훈련을 통해 완화될 수 있음을 보여주었습니다. 어떤 방식으로든 모델 내부를 수정할 필요가 없습니다.

문서 링크: https://openreview.net/pdf?id=_jg6Sf6tuF7

검색 응용 프로그램의 경우 표준 의미 검색 기술은 대형 모델에서 생성된 각 임베딩에 사용됩니다. 고정 표현, 즉, 표현의 크기와 기능은 다운스트림 작업 및 관련 컴퓨팅 환경이나 제약 조건에 관계없이 대부분 고정되어 있습니다.

Matryoshka 표현 학습은 배포 환경에 따라 표현을 조정할 수 있는 유연성을 도입하여 표현이 좌표에서 자연스러운 순서를 가지도록 하여 리소스가 제한된 환경에서는 표현의 가장 높은 소수의 좌표만 사용합니다. 더 풍부하고 정밀성이 중요한 설정을 위해 더 많은 좌표를 사용할 수 있습니다.

문서 링크: https://openreview.net/pdf?id=9njZa1fm35

신경망 스캐닝과 같은 표준 근사 인접 이웃 검색 기술과 결합하면 MRL이 가능합니다. 최대 16배 더 낮은 수준을 제공하기 위해 동일한 재현율 및 정밀도 측정값을 계산합니다.

대규모 기계 학습 모델은 여러 영역에서 혁신적인 결과를 보여주지만 이러한 모델을 현실 세계에서 실현하려면 훈련 및 추론의 효율성이 중요한 요구 사항이 되고 있습니다.

Google Research는 새로운 기본 기술을 개발하여 대규모 기계 학습 모델을 효율적으로 만드는 데 상당한 투자를 해 왔으며, 이를 위해서는 앞으로도 지속적인 노력이 필요하며 기계 학습 모델을 더욱 강력하고 효율적으로 만들기 위한 핵심 과제를 계속해서 탐구할 것입니다. .

위 내용은 그 어느 때보다 빠르게 대형 모델을 훈련하고 추론할 수 있습니다! 구글의 2022년 연말 요약, 네 번째의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!