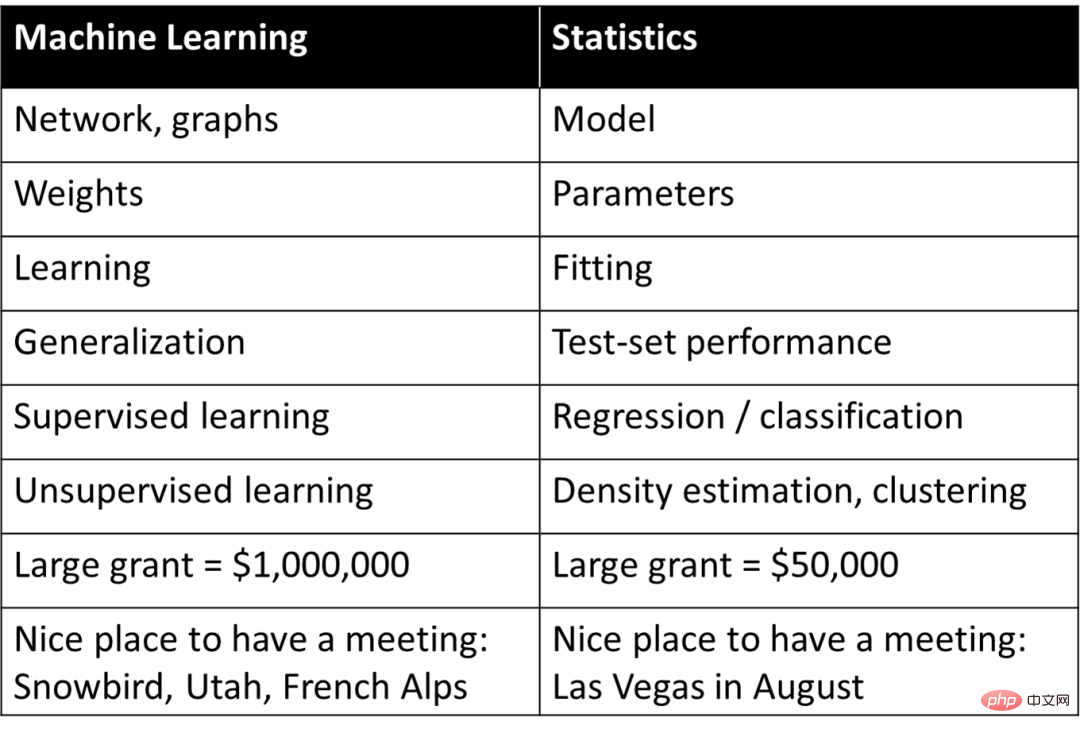

1990년대 스탠포드 대학의 생물정보학으로 유명한 Rob Tibshirani 교수는 기계 학습과 통계의 다양한 개념을 간단하고 대략적으로 대응시키기 위해 어휘를 작성했습니다.

On the one 한편, 이 표는 머신러닝에 대한 기본적인 이해를 제공하지만 동시에 딥러닝이나 머신러닝의 개념을 단순히 통계학의 단어 의미로 요약하고 있어 딥러닝의 본질에 대한 대부분의 사람들의 의구심을 불러일으키기도 합니다. : 딥러닝은 '간단한 통계'입니다.

그러나 심층적인 논의를 통해 이러한 인식은 연구자들이 딥러닝 성공의 본질적인 이유를 이해하는 데 어느 정도 방해가 되었습니다. 하버드의 저명한 교수이자 이론 컴퓨터 과학자인 보아즈 바락(Boaz Barak)은 올해 6월 '딥러닝과 (고전) 통계의 불안한 관계'라는 글에서 딥러닝과 통계학을 비교, 구별하며 딥러닝의 기본을 지적했다. .구성요소는 통계와 매우 다릅니다.

Boaz Barak은 다음과 같은 중요한 관찰을 했습니다. 모델의 목적 관점에서 예측과 관찰에 중점을 둔다면 블랙박스 특성을 갖춘 딥 러닝 모델이 최선의 선택이 될 수 있지만, 사물의 원인과 결과 관계를 이해하고 해석성이 향상되면 "간단한" 모델이 더 잘 수행될 수 있습니다. 이는 지난달 마이(Ma Yi), 조잉(Cao Ying), 선샹양(Shen Xiangyang) 세 명의 과학자가 제안한 지능의 두 가지 원칙 중 하나를 구성하는 '단순성' 개념과 일치한다.

동시에 Boaz Barak은 통계 모델 피팅과 수학 학습의 두 가지 시나리오 사례를 보여주며 딥 러닝과의 호환성에 대해 논의했습니다. 그는 딥 러닝의 수학과 코드가 피팅과 관련이 없다고 믿었습니다. 모델은 거의 동일하지만 더 깊은 수준에서 딥 러닝의 상당 부분을 "학생에게 기술 교육" 시나리오에서 포착할 수 있습니다.

통계 학습은 딥 러닝에서 중요한 역할을 하며 이에 대해서는 의심의 여지가 없습니다. 그러나 확실한 것은 통계적 관점이 딥러닝을 이해하기 위한 완전한 그림을 제공할 수 없다는 것입니다. 딥러닝의 다양한 측면을 이해하려면 여전히 다양한 관점에서 접근해야 합니다.

다음은 Boaz Barak의 토론입니다.

수천년 동안 과학자들은 관찰에 모델을 피팅해 왔습니다. 예를 들어, 과학 철학(Philosophy of Science) 책 표지에 언급된 것처럼, 이집트의 천문학자 프톨레마이오스는 행성 운동에 대한 독창적인 모델을 제안했습니다. 프톨레마이오스의 모델은 지구 중심적(즉, 행성이 지구를 중심으로 회전함)이었지만 뛰어난 예측 정확도를 제공하는 일련의 "손잡이"(특히 주전원)가 있었습니다. 대조적으로, 코페르니쿠스의 원래 태양 중심 모델은 태양 주위를 도는 행성의 원형 궤도를 가정했습니다. 이는 프톨레마이오스의 모델보다 간단하고("조정 가능한 손잡이"가 적음) 전체적으로 더 정확하지만 관찰 예측의 정확도는 떨어집니다 . (코페르니쿠스도 나중에 자신의 주전원을 추가하여 프톨레마이오스의 성능과 비교할 수 있게 되었습니다.)

프톨레마이오스 모델과 코페르니쿠스 모델은 비교할 수 없습니다. 예측을 위해 "블랙박스"가 필요한 경우 프톨레마이오스의 지구 중심 모델이 우수합니다. 그리고 "내부를 엿볼 수 있고" 별의 움직임을 설명하기 위한 이론적 출발점 역할을 할 수 있는 간단한 모델을 원한다면 코페르니쿠스의 모델이 더 좋습니다.

사실 케플러는 결국 코페르니쿠스의 모델을 타원형 궤도로 다듬고 행성 운동의 세 가지 법칙을 제안했는데, 이를 통해 뉴턴은 지구에 적용되는 것과 동일한 중력 법칙을 사용하여 이를 설명할 수 있었습니다. 이를 위해서는 태양 중심 모델이 단지 예측을 제공하는 "블랙 박스"가 아니라 "움직이는 부분"이 거의 없는 간단한 수학 방정식으로 제공되는 것이 중요합니다. 천문학은 수년 동안 통계 기술을 개발하는 데 영감의 원천이었습니다. 가우스와 르장드르는 (독립적으로) 1800년경에 소행성 및 기타 천체의 궤도를 예측하기 위해 최소 제곱 회귀를 발명했습니다. 1847년 코시의 경사하강법 발명도 천문학적 예측에 의해 동기가 부여되었습니다.

물리학에서는 (적어도 때때로) "모든 것을 가질 수 있습니다" - 오캄의 면도날과 같은 아이디어에서 입증된 것처럼 최고의 예측 정확도와 데이터에 대한 최고의 설명을 제공하는 "올바른" 이론을 찾으십시오. 가정 단순성 , 예측력, 설명적 통찰력은 모두 서로 일치합니다. 그러나 다른 많은 분야에서는 설명(또는 보다 일반적으로 통찰)과 예측이라는 두 가지 목표 사이에 긴장이 존재합니다. 관찰만을 예측하고 싶다면 '블랙박스'가 최선의 선택일 수 있습니다. 그러나 인과 모델, 일반 원칙 또는 중요한 특징을 추출하는 경우 이해하기 쉽고 설명하기 쉬운 간단한 모델이 더 나을 수 있습니다.

모델의 올바른 선택은 목적에 따라 다릅니다. 예를 들어, 많은 개인의 유전자 발현과 표현형(예: 특정 질병)이 포함된 데이터 세트를 생각해 보세요. 개인의 질병 가능성을 예측하는 것이 목표라면 해당 작업에 가장 적합한 모델을 사용하려는 경우가 많습니다. , 아무리 복잡하거나 얼마나 많은 유전자에 의존하든 상관 없습니다. 대조적으로, 귀하의 목표가 습식 실험실에서 추가 연구를 위해 몇 가지 유전자를 식별하는 것이라면 정교한 블랙박스가 매우 정확하더라도 사용이 제한될 것입니다.

2001년 Leo Breiman은 통계 모델링에 관한 그의 유명한 논문 "Statistical Modeling: The Two Cultures"에서 이 점을 효과적으로 설명했습니다. "데이터 모델링 문화"는 데이터를 설명하는 단순한 생성 모델에 중점을 두는 반면, "알고리즘 모델링 문화"는 데이터가 어떻게 생성되는지 이해하지 않고 데이터를 예측할 수 있는 모델을 찾는 데 중점을 둡니다. Breiman은 통계가 최초의 문화에 의해 너무 지배적이며 이러한 초점이 "관련 없는 이론과 의심스러운 과학적 결론으로 이어지며" "통계학자가 흥미로운 새로운 질문을 연구하는 것을 방해한다"고 믿습니다.

그러나 Breiman의 논문은 논란의 여지가 있습니다. Brad Efron은 일부 감정에 동의하지만, “첫 번째 보기에서 Leo Breiman의 흥미로운 논문은 조작할 손잡이가 많은 블랙박스를 선호하여 단순성과 과학적 통찰력을 거부하는 것처럼 보입니다. 같은." 그러나 최근 기사("Prediction, Estimation, and Attribution")에서 Efron은 "Breiman이 나보다 더 예지력이 있었던 것으로 밝혀졌습니다. 순수 예측 알고리즘은 21세기 통계의 각광을 받았고 그 발전은 방향은 Leo가 이전에 언급한 것과 거의 유사합니다 ”

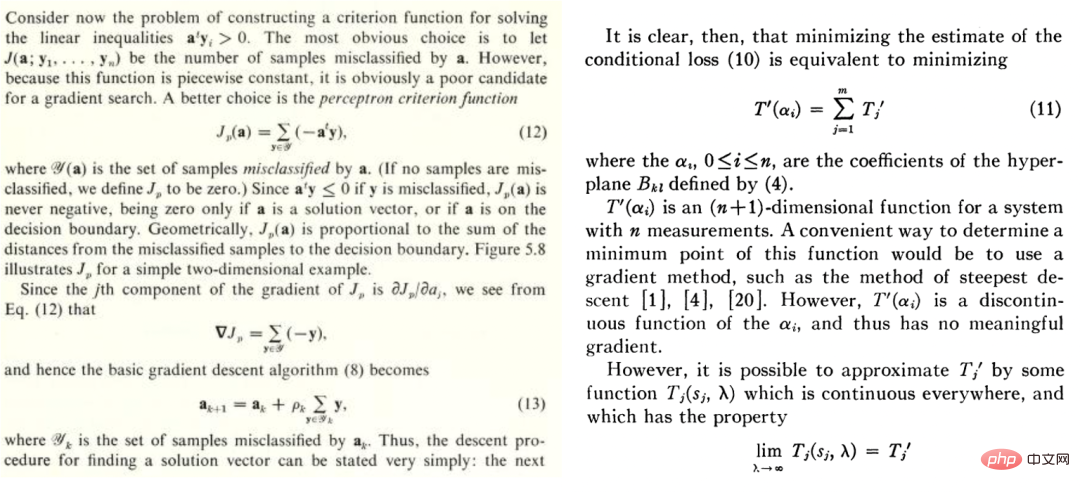

기계 학습이 "깊은"지 여부에 관계없이 Breiman이 말하는 두 번째 문화에 속합니다. 예측에 중점을 두는 이런 문화는 오래전부터 이어져 왔습니다. 예를 들어, Duda와 Hart의 1973년 교과서 "Deconstructing Distributions: A Pointwise Framework of Learning"과 Highleyman의 1962년 논문 "The Design and Analysis of Pattern Recognition Experiments"는 오늘날의 딥 러닝 실무자들에게 매우 잘 알려져 있습니다.

마찬가지로 Highleyman의 손글씨 문자 데이터세트와 이에 적합하게 사용된 아키텍처인 Chow(~58% 정확도)도 현대 독자의 공감을 불러일으킵니다.

1992년 Stuart Geman, Elie Bienenstock 및 Rene Doursat는 "신경망 및 편견/Varian 딜레마"라는 제목의 논문을 공동 집필했습니다. 이 논문에서는 "현재 피드포워드 신경망", "네트워크, 기계 인식 및 기계 학습의 어려운 문제를 해결하기에는 대체로 불충분합니다." 특히 그들은 범용 신경망이 어려운 작업을 성공적으로 해결할 수 없으며 신경망이 성공할 수 있는 유일한 방법은 손으로 디자인한 기능을 통해서만 가능하다고 주장합니다. 그들의 말은 다음과 같습니다. "중요한 기능은 통계적 방법을 통해 학습하기보다는 내장되거나 '내장'되어야 합니다.

" 돌이켜보면 그들은 완전히 틀렸습니다. 더욱이 Transformer와 같은 최신 신경망 아키텍처는 당시의 컨볼루션 네트워크보다 훨씬 더 다양합니다. 하지만 그들의 실수 뒤에 숨은 이유를 이해하는 것은 흥미롭습니다.

그들이 실수한 이유는 딥러닝이 확실히 다른 학습 방법과 다르기 때문인 것 같아요. 선험적인 현상은 딥 러닝이 최근접 이웃이나 랜덤 포레스트와 같은 예측 모델이 하나만 더 있는 것 같다는 것입니다. 더 많은 "손잡이"가 있을 수 있지만 이는 질적인 차이라기보다는 양적인 차이인 것 같습니다. PW Andreson의 말에 따르면 "더 많은 것이 다릅니다."

물리학에서는 규모가 몇 배나 변하면 이를 설명하기 위해 완전히 다른 이론이 필요한 경우가 많으며 딥러닝에서도 마찬가지입니다. 실제로 딥 러닝은 고전 모델(모수적 또는 비모수적)과 완전히 다르게 작동합니다. 상위 수준의 관점에서 방정식(및 Python 코드)은 동일해 보이지만.

이를 설명하기 위해 매우 다른 두 가지 예의 학습 과정을 살펴보겠습니다. 통계 모델을 적용하는 것과 학생들에게 수학을 배우도록 가르치는 것입니다.

일반적으로 통계 모델을 데이터에 피팅하는 단계는 다음과 같습니다.

1 일부 데이터 x와 y를 관찰합니다. x는 n의 행렬로 간주될 수 있습니다. 단순화를 위해 추가 노이즈가 사용되며  가 올바른 실제 레이블입니다. )

가 올바른 실제 레이블입니다. )  2. 일부 최적화 알고리즘을 실행하여

2. 일부 최적화 알고리즘을 실행하여  모델을 데이터에 맞춰

모델을 데이터에 맞춰  의 경험적 위험을 최소화할 수 있습니다. 즉, 최적화 알고리즘을 사용하여

의 경험적 위험을 최소화할 수 있습니다. 즉, 최적화 알고리즘을 사용하여

의 최소화된 수를 찾습니다. 여기서  는 손실 항(

는 손실 항( 이 y에 얼마나 가까운지 파악)이고

이 y에 얼마나 가까운지 파악)이고  은 선택적 정규화 항(편향을 시도함)입니다.

은 선택적 정규화 항(편향을 시도함)입니다.  더 간단한 모델 쪽으로).

더 간단한 모델 쪽으로).

3. 일반화 오류/손실 이 작기 때문에 우리 모델이 전체적으로 좋은 손실을 가질 수 있기를 바랍니다(이 예측은 실험 데이터가 있는 전체 데이터를 기반으로 얻은 것입니다).

이 작기 때문에 우리 모델이 전체적으로 좋은 손실을 가질 수 있기를 바랍니다(이 예측은 실험 데이터가 있는 전체 데이터를 기반으로 얻은 것입니다).

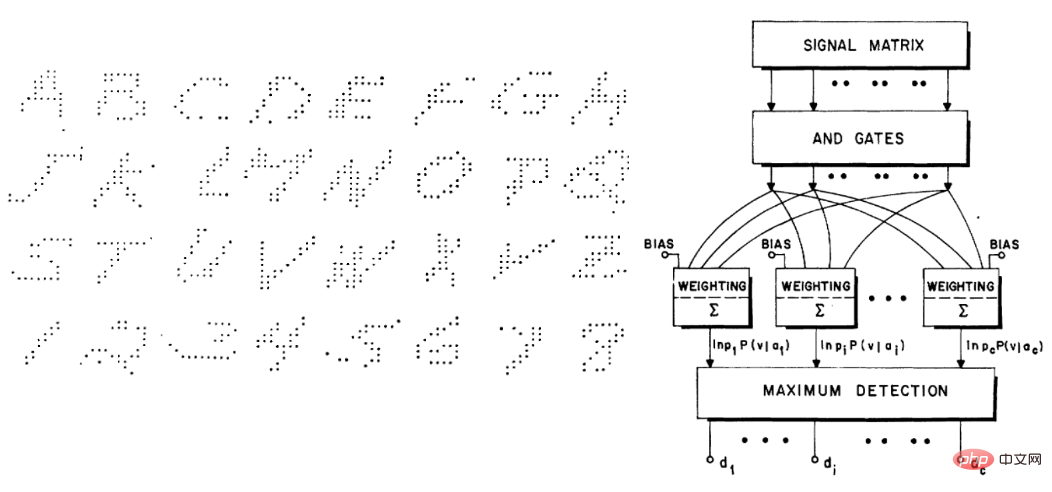

캡션: 잡음 관찰을 통해 재현된 뉴턴의 제1법칙에 대한 Bradley Efron의 만화

이 매우 일반적인 패러다임에는 최소 제곱 선형 회귀, 최근접 이웃, 신경망 훈련 및 더. 고전적인 통계 설정에서 우리는 다음을 관찰할 것으로 예상합니다.

편향/분산 균형: F를 최적화된 모델 집합으로 사용합니다. (볼록하지 않은 설정 및/또는 정규화 항목이 있는 경우 알고리즘 선택 및 정규화의 효과를 고려할 때 F를 무시할 수 없는 확률로 알고리즘에 의해 구현될 수 있는 모델 집합으로 둘 수 있습니다. )

F의 편차는 올바른 라벨에 대한 최상의 근사치이며  요소를 통해 달성할 수 있습니다. F 클래스가 클수록 편차가 작아집니다.

요소를 통해 달성할 수 있습니다. F 클래스가 클수록 편차가 작아집니다.  경우 편차는 0이 될 수도 있습니다. 그러나 F 클래스가 클수록 소속 범위를 좁히기 위해 더 많은 샘플이 필요하므로 알고리즘 출력 모델의 분산이 더 커집니다. 전체 일반화 오류는 편향 항과 분산 기여도의 합입니다.

경우 편차는 0이 될 수도 있습니다. 그러나 F 클래스가 클수록 소속 범위를 좁히기 위해 더 많은 샘플이 필요하므로 알고리즘 출력 모델의 분산이 더 커집니다. 전체 일반화 오류는 편향 항과 분산 기여도의 합입니다.

따라서 통계 학습은 종종 편향/분산 트레이드오프를 나타내며 올바른 모델 복잡성의 "Goldilocks 선택"을 통해 전체 오류를 최소화합니다. 실제로 Geman et al.은 "편향-분산 딜레마로 인한 근본적인 한계는 신경망을 포함한 모든 비모수적 추론 모델에 적용된다"고 말함으로써 신경망에 대한 비관론을 정당화했습니다.

더 많은 것이 항상 최선은 아닙니다. 통계 학습에서 더 많은 기능이나 데이터를 얻는다고 해서 반드시 성능이 향상되는 것은 아닙니다. 예를 들어, 관련 없는 기능이 많이 포함된 데이터에서 학습하는 것은 더 어렵습니다. 마찬가지로 데이터가 두 분포(예:  및

및  ) 중 하나에서 나오는 혼합 모델에서 학습하는 것은 개별 분포를 독립적으로 학습하는 것보다 어렵습니다.

) 중 하나에서 나오는 혼합 모델에서 학습하는 것은 개별 분포를 독립적으로 학습하는 것보다 어렵습니다.

수익률이 감소하고 있습니다. 많은 경우 예측 노이즈를 일부 매개변수  로 줄이는 데 필요한 데이터 포인트 수는 일부 매개변수 k 아래에서

로 줄이는 데 필요한 데이터 포인트 수는 일부 매개변수 k 아래에서  로 확장됩니다. 이 경우 "이륙"하려면 약 k개의 샘플이 필요하며, 일단 이렇게 하면 수익 감소 시스템에 직면하게 됩니다. 즉, 90% 정확도를 달성하는 데 n 포인트가 필요하다고 가정하면 정확도를 95%로 높이려면 약 3n개의 포인트가 더 필요합니다. 일반적으로 리소스(데이터, 모델 복잡성 또는 계산 등)가 증가함에 따라 우리는 새로운 질적 기능을 잠금 해제하기보다는 보다 세밀한 구별을 포착하기를 희망합니다.

로 확장됩니다. 이 경우 "이륙"하려면 약 k개의 샘플이 필요하며, 일단 이렇게 하면 수익 감소 시스템에 직면하게 됩니다. 즉, 90% 정확도를 달성하는 데 n 포인트가 필요하다고 가정하면 정확도를 95%로 높이려면 약 3n개의 포인트가 더 필요합니다. 일반적으로 리소스(데이터, 모델 복잡성 또는 계산 등)가 증가함에 따라 우리는 새로운 질적 기능을 잠금 해제하기보다는 보다 세밀한 구별을 포착하기를 희망합니다.

손실과 데이터에 대한 의존도가 높습니다. 고차원 데이터에 모델을 피팅할 때 작은 디테일이 결과에 큰 차이를 만들 수 있습니다. 통계학자들은 L1 또는 L2 정규화 도구와 같은 선택이 중요하다는 것을 알고 있습니다. 완전히 다른 데이터 세트를 사용하면 고차원 최적화 프로그램의 수에 따라 매우 달라질 것이라는 점은 말할 것도 없습니다.

데이터 포인트에는 자연스러운 "어려움"이 없습니다(적어도 일부 경우에는). 전통적으로 데이터 포인트는 분포와 독립적으로 샘플링됩니다. 결정 경계에 가까운 점은 분류하기가 더 어려울 수 있지만 측정의 고차원 집중을 고려하면 대부분의 점은 비슷한 거리를 가질 것으로 예상됩니다. 따라서 적어도 고전적인 데이터 분포에서는 포인트의 난이도 수준이 크게 다르지 않을 것으로 예상됩니다. 그러나 혼합 모델은 이 차이에 대해 서로 다른 난이도 수준을 나타낼 수 있으므로 위에서 언급한 다른 문제와 달리 이 차이는 통계적 설정에서 그리 놀라운 것은 아닙니다.

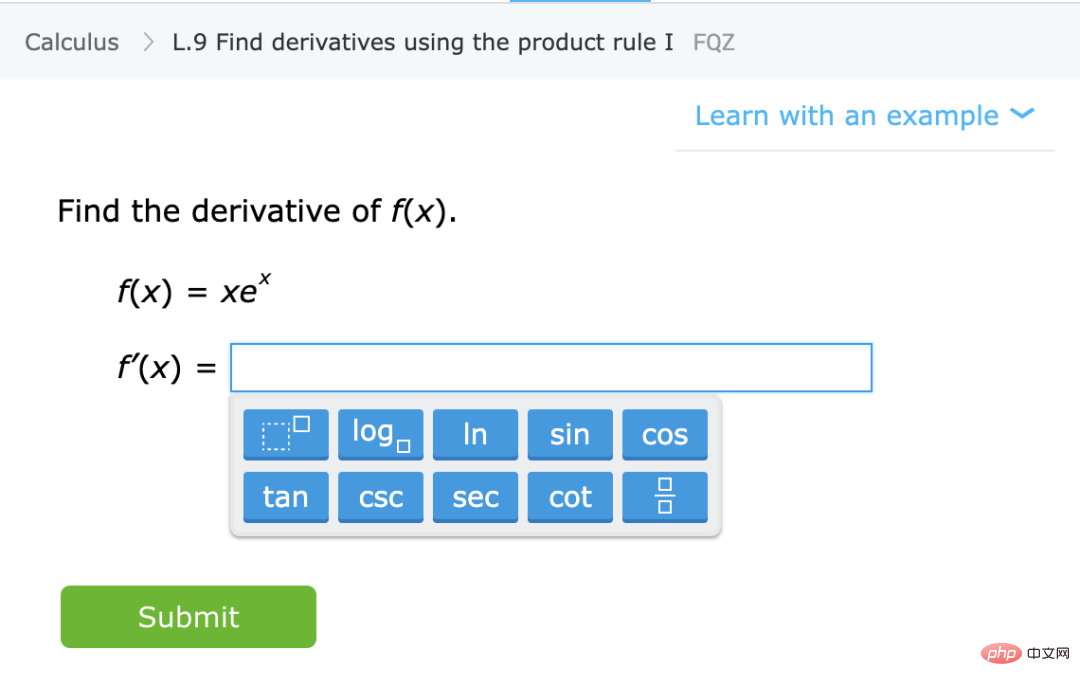

위와 대조적으로 학생들에게 특정 수학 주제(예: 도함수 계산)를 가르치고 일반적인 지침과 연습 문제를 제공하는 것에 대해 이야기해 보겠습니다. 이는 공식적으로 정의된 설정은 아니지만 몇 가지 질적 특성을 고려할 수 있습니다.

캡션: IXL 웹사이트에서 특정 수학 기술을 배우기 위한 연습

근사치가 아닌 기술 학습 분포. 이 경우 학생들은 수량 추정기/예측기보다는 기술을 배우고 있습니다. '기술'을 정의하는 것은 사소한 작업이 아니지만 질적으로 다른 목표입니다. 특히 함수 매핑 연습이 일부 관련 작업 X를 해결하기 위한 "블랙 박스"로 사용될 수 없더라도 이러한 문제를 해결할 때 학생들이 형성하는 내부 표현은 여전히 X에 유용하다고 믿습니다.

많을수록 더 즐겁습니다. 일반적으로 학생들은 더 많은 질문과 다양한 유형의 질문을 연습하면 더 나은 결과를 얻을 수 있습니다. 그러나 실제로 일부 미적분 문제와 일부 대수학 문제를 수행하는 "하이브리드 모델링"은 학생들의 미적분학 성과에 영향을 미치지 않으며 실제로 학습에 도움이 됩니다.

기능을 "탐색"하거나 잠금 해제하고 자동 표현으로 전환하세요. 어느 시점에서 문제 해결에 대한 수익이 감소하는 동안 학생들은 문제를 수행하는 것이 개념을 '클릭'하고 새로운 기능을 잠금 해제하는 데 도움이 되는 단계를 거치는 것 같습니다. 또한, 학생들이 특정 유형의 문제를 반복하면 해당 문제에 대한 능력과 표현이 더 낮은 수준으로 이동하여 이전에는 없었던 문제에 대해 어느 정도 자동성을 개발할 수 있게 됩니다.

성능은 손실 및 데이터와 부분적으로 독립적입니다. 수학 개념을 가르치는 방법은 여러 가지가 있으므로 학생들이 다른 책, 교육 방법 또는 채점 시스템을 사용하여 학습하더라도 결국 동일한 자료와 유사한 내부 표현을 배우게 됩니다.

어떤 질문은 더 어렵습니다. 수학 연습문제에서 우리는 서로 다른 학생들이 동일한 문제를 해결하기 위해 사용하는 방법에서 강한 상관관계를 종종 볼 수 있습니다. 문제의 난이도는 정해져 있는 것 같고, 퍼즐을 푸는 순서도 정해져 있어 학습 과정을 최적화할 수 있습니다. 이것이 실제로 IXL과 같은 플랫폼이 수행하는 작업입니다.

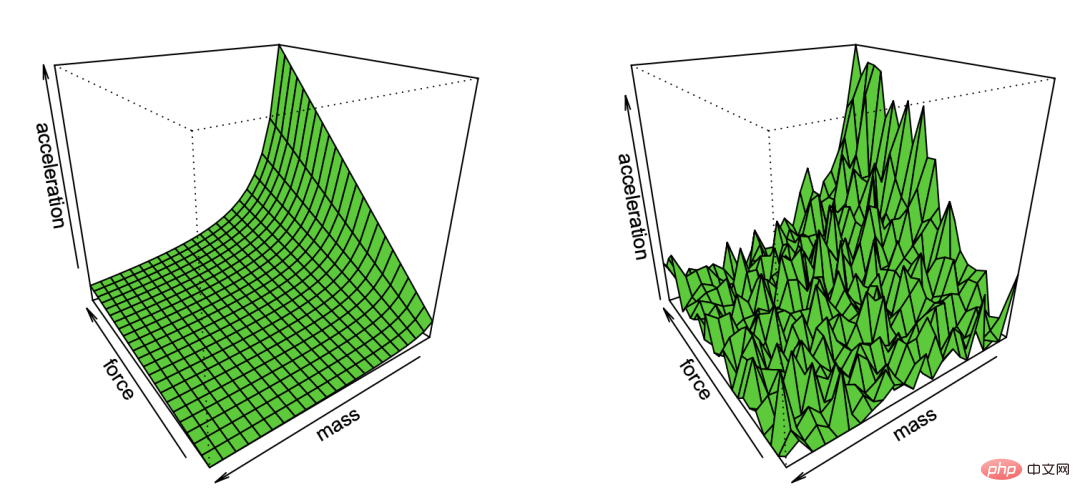

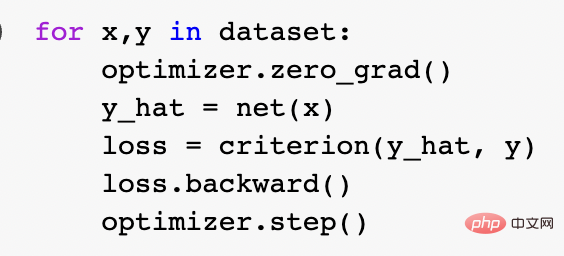

그렇다면 위의 두 가지 비유 중 어느 것이 현대 딥 러닝을 더 잘 설명하고, 구체적으로 왜 그렇게 성공적인가? 통계적 모델 피팅은 수학과 코드와 더 일관성이 있는 것 같습니다. 실제로 표준 Pytorch 훈련 루프는 위에서 설명한 대로 경험적 위험 최소화를 통해 심층 네트워크를 훈련합니다.

그러나 더 깊은 수준에서 이 두 설정 간의 관계는 그다지 명확하지 않습니다. 구체적으로, 특정 학습 과제를 수리하고 "자기 지도 학습 + 선형 프로브(선형 프로브)" 방법을 사용하여 분류 알고리즘을 훈련함으로써 수행할 수 있습니다.

1. 데이터가 시퀀스  라고 가정합니다. 여기서

라고 가정합니다. 여기서  는 특정 데이터 포인트(예: 특정 이미지)이고

는 특정 데이터 포인트(예: 특정 이미지)이고  는 레이블입니다.

는 레이블입니다.

2. 먼저 함수  를 나타내는 심층 신경망을 찾습니다. 이 함수는 일부 유형의 자기 감독 손실 함수를 최소화하여 레이블을 사용하지 않고 데이터 포인트만 사용하여

를 나타내는 심층 신경망을 찾습니다. 이 함수는 일부 유형의 자기 감독 손실 함수를 최소화하여 레이블을 사용하지 않고 데이터 포인트만 사용하여  학습됩니다. 이러한 손실 함수의 예로는 재구성 또는 Picture-in-Picture(다른 입력의 일부 부분에서 복구 )가 증가할 때 병렬 관계는 두 임의 지점 간의 병렬 관계보다 훨씬 작습니다.

학습됩니다. 이러한 손실 함수의 예로는 재구성 또는 Picture-in-Picture(다른 입력의 일부 부분에서 복구 )가 증가할 때 병렬 관계는 두 임의 지점 간의 병렬 관계보다 훨씬 작습니다.  3. 그런 다음 완전한 레이블이 지정된 데이터

3. 그런 다음 완전한 레이블이 지정된 데이터  를 사용하여 선형 분류기

를 사용하여 선형 분류기  (여기서 C는 클래스 수)를 피팅하여 교차 엔트로피 손실을 최소화합니다. 최종 분류자의 결과는

(여기서 C는 클래스 수)를 피팅하여 교차 엔트로피 손실을 최소화합니다. 최종 분류자의 결과는

매핑이었습니다. 3단계는 선형 분류에만 적합하므로 "마법"은 2단계(심층 네트워크의 자기 지도 학습)에서 발생합니다.  자기 지도 학습에서 볼 수 있는 몇 가지 속성은 다음과 같습니다.

자기 지도 학습에서 볼 수 있는 몇 가지 속성은 다음과 같습니다.  함수를 근사화하는 대신 기술을 학습합니다.

함수를 근사화하는 대신 기술을 학습합니다.  자기 지도 학습은 함수를 근사화하는 것이 아니라 다양한 다운스트림 작업에 사용할 수 있는 표현을 학습하는 것입니다. 이것이 자연어 처리의 지배적인 패러다임이라고 가정할 때, 다운스트림 작업이 선형 탐색, 미세 조정 또는 프롬프트에 의해 획득되는지 여부는 부차적입니다.

자기 지도 학습은 함수를 근사화하는 것이 아니라 다양한 다운스트림 작업에 사용할 수 있는 표현을 학습하는 것입니다. 이것이 자연어 처리의 지배적인 패러다임이라고 가정할 때, 다운스트림 작업이 선형 탐색, 미세 조정 또는 프롬프트에 의해 획득되는지 여부는 부차적입니다.

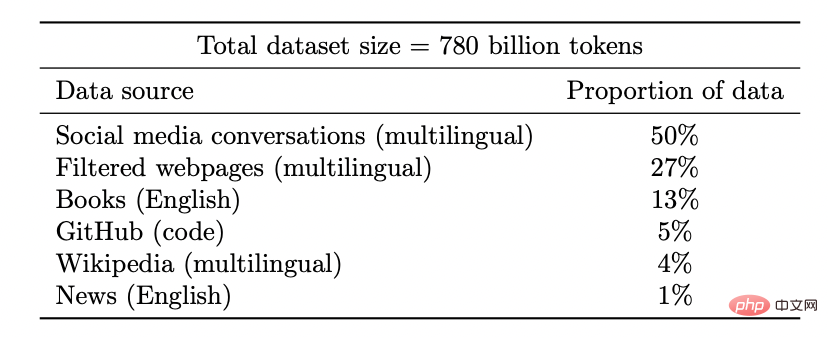

자기 지도 학습에서는 데이터 양이 늘어날수록 표현의 품질이 향상됩니다. 그리고 데이터는 다양할수록 좋습니다.

캡션: Google PaLM 모델의 데이터세트

리소스(데이터, 계산, 모델 크기)가 확장됨에 따라 딥 러닝 모델의 불연속적인 개선이 계속해서 나타나고 이는 일부 합성 환경에서도 입증됩니다.

캡션: 모델 크기가 증가함에 따라 PaLM 모델은 일부 벤치마크에서 몇 가지 개별적인 개선을 보여주고(위 그림에는 세 가지 크기 주의 사항만 있음) 농담 설명과 같은 몇 가지 놀라운 기능을 잠금 해제합니다.

성능은 손실이나 데이터와 크게 무관합니다. 하나 이상의 자체 감독 손실, 여러 대비 및 재구성 손실이 이미지에 사용됩니다. 언어 모델은 때때로 일방적인 재구성(다음 토큰 예측)을 사용하고 때로는 마스킹 모델을 사용합니다. 여기서 목표는 왼쪽 및 오른쪽 토큰에서 마스킹된 입력을 예측하는 것입니다.

약간 다른 데이터세트를 사용하는 것도 가능하며 이는 효율성에 영향을 미칠 수 있습니다. 그러나 "합리적인" 선택이 이루어지는 한 일반적으로 원래 리소스는 사용된 특정 손실이나 데이터세트보다 성능을 더 잘 예측합니다.

어떤 경우는 다른 경우보다 더 어렵습니다. 이는 자기 지도 학습에만 국한되지 않으며, 데이터 포인트에는 고유한 "난이도 수준"이 있을 수 있습니다.

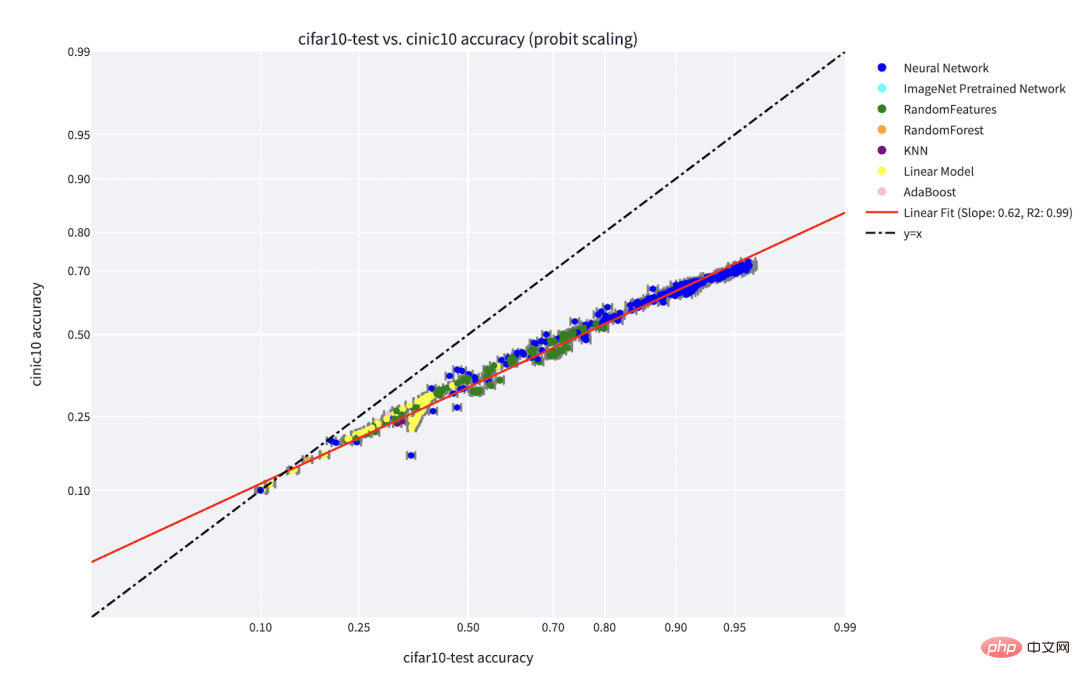

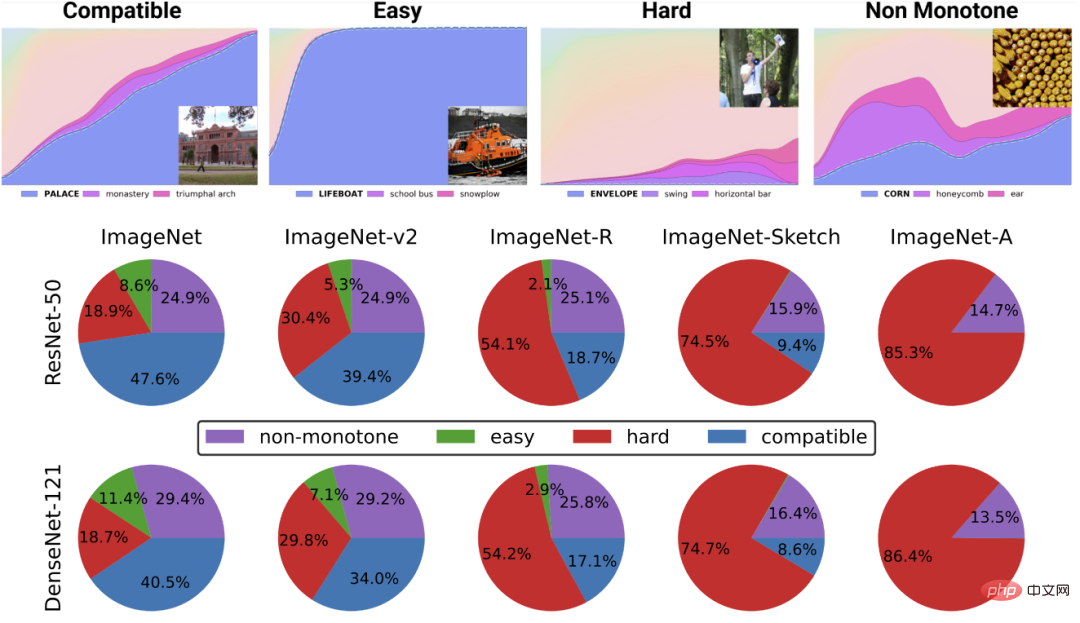

실제로 학습 알고리즘마다 "기술 수준"이 다르고 포인트마다 "난이도 수준"이 다르다는 몇 가지 실질적인 증거가 있습니다. (분류기 f가 x를 올바르게 분류할 확률, f의 기술이 1- 증가함) 방식으로, x의 난이도는 단방향으로 감소합니다.) "기술과 난이도" 패러다임은 Recht와 Miller 등이 발견한 "온라인 정확성" 현상에 대한 가장 명확한 설명이며, Kaplun, Ghosh, Garg 및 Nakkiran과 공동 집필한 논문에서 나는 또한 데이터 세트 다양한 입력에는 일반적으로 다양한 모델에 대해 견고한 것처럼 보이는 고유한 "난이도 서명"이 있습니다.

캡션: CIFAR-10에서 훈련되고 CINIC-10에서 테스트된 분류기에 대한 선 현상 정확도를 보여주는 Miller et al.의 그래프

캡션: 데이터 세트를 다음으로 분해합니다. Kaplun 및 Ghosh et al.의 "Deconstructing Distributions: A Pointwise Framework of Learning" 논문에서 다른 "난이도 프로필"을 참조하여 점점 더 많은 수의 리소스 분류기를 얻습니다. 위쪽 차트는 훈련 시간에 따라 색인된 분류기의 전역 정확도에 따라 가장 가능성이 높은 클래스에 대한 다양한 소프트맥스 확률을 보여줍니다. 아래쪽 원형 차트는 다양한 데이터 세트를 다양한 유형의 포인트로 분석한 것을 보여줍니다. 특히, 이 분해는 다양한 신경 아키텍처에서 유사합니다.

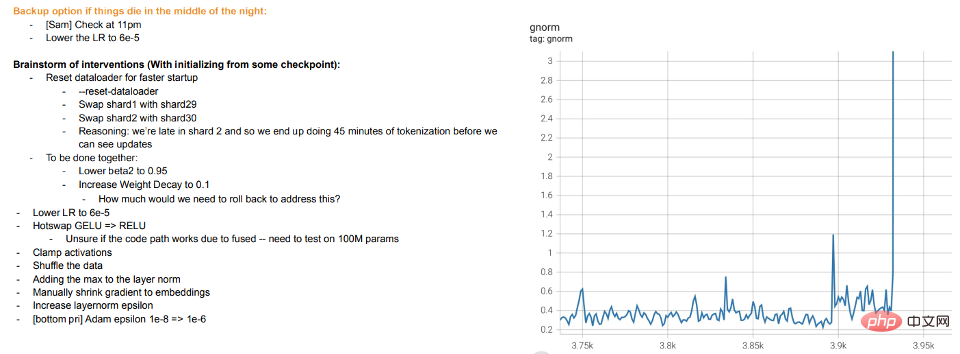

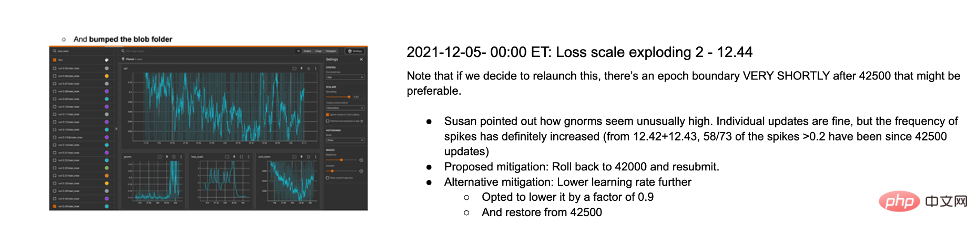

훈련은 가르치는 것입니다. 대형 모델의 최신 교육은 모델이 데이터에 적응하도록 하는 것, 학생이 이해하지 못하거나 피곤해 보일 때 "휴식"을 취하거나 다른 방법을 시도하는 것(교육 편차)보다는 학생을 가르치는 것과 더 비슷해 보입니다. Meta의 대규모 모델에 대한 교육 로그는 유익합니다. 하드웨어 문제 외에도 교육 중에 다른 최적화 알고리즘을 전환하고 "핫 스와핑" 활성화 기능(GELU에서 RELU로)을 고려하는 등의 일부 개입도 볼 수 있습니다. 표현을 학습하는 것이 아니라 데이터를 맞추는 것으로 모델 훈련을 생각한다면 후자는 별로 의미가 없습니다.

캡션: Meta의 훈련 로그에서 발췌아래 두 가지 사례가 논의됩니다.

지금까지 우리는 자기 지도 학습에 대해서만 논의했지만, 딥 러닝의 전형적인 예는 여전히 지도 학습입니다. 결국 딥 러닝의 "ImageNet 순간"은 ImageNet에서 비롯됩니다. 그렇다면 위에서 논의한 내용이 지도 학습에도 적용됩니까?

먼저, 지도형 대규모 딥 러닝의 출현은 어느 정도는 고품질의 대규모 레이블 데이터 세트(예: ImageNet)의 가용성 덕분에 역사적인 사고입니다. 대안적 역사를 상상하는 것은 가능합니다. 딥 러닝은 처음에는 비지도 학습을 통해 자연어 처리 분야에서 획기적인 발전을 이루었고 그 후에야 비전 및 지도 학습으로 옮겨갔습니다.

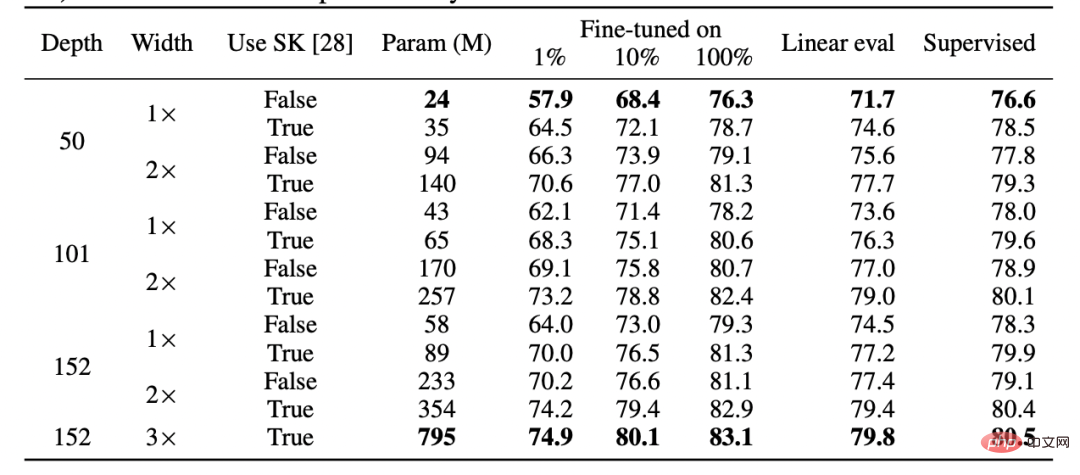

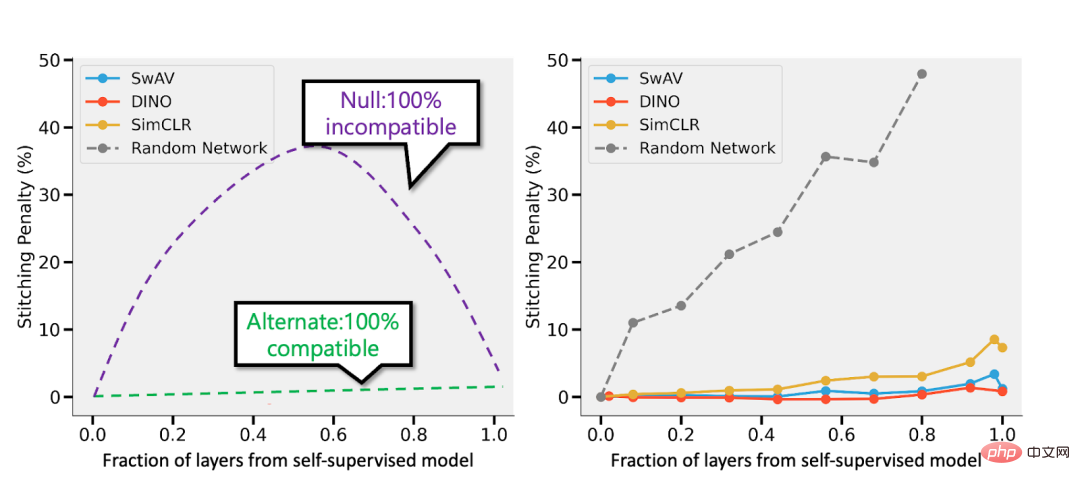

두 번째로, 지도 학습이 자기 지도 학습과 완전히 다른 손실 함수를 사용하더라도 "뒤에서" 유사하게 동작한다는 증거가 있습니다. 둘 다 일반적으로 동일한 성능을 달성합니다. 유사한 내부 표현을 학습한 내용이 "Revisiting Model Stitching to Compare Neural Representation" 논문에서도 발견되었습니다. 특히, 각각의  에 대해 지도 모델의 마지막 d-k 레이어와 자가 감독으로 훈련된 깊은 D 모델의 첫 번째 k 레이어를 "연결"하고 성능을 거의 변경하지 않고 유지할 수 있습니다.

에 대해 지도 모델의 마지막 d-k 레이어와 자가 감독으로 훈련된 깊은 D 모델의 첫 번째 k 레이어를 "연결"하고 성능을 거의 변경하지 않고 유지할 수 있습니다.

캡션: Hinton 팀의 논문 "Big Self-Supervised Models are Strong Semi-Supervised Learners"의 표. 지도 학습, 미세 조정(100%) 자체 지도 및 자체 지도 + 선형 감지 간의 성능의 일반적인 유사성에 주목하세요.

캡션: "신경 표현을 비교하기 위해 모델 스티칭 재검토" 논문에서 발췌 " 감독 및 감독 모델. 왼쪽 - 자기 지도 모델이 지도 모델보다 3% 덜 정확하다면, 완벽하게 호환되는 표현은 p 3%의 접합 패널티를 받게 됩니다(p 레이어가 자기 지도 모델에서 나온 경우). 모델이 완전히 호환되지 않는 경우 더 많은 모델을 함께 연결하면 정확도가 크게 떨어질 수 있습니다. 오른쪽 - 서로 다른 자체 감독 모델을 결합한 실제 결과입니다.

자기 지도 + 단순 모델의 장점은 기능 학습 또는 "딥 러닝 마법"(심층 표현 기능의 결과)을 통계적 모델 피팅(선형 또는 기타 "단순" 분류기로 수행됨)과 결합할 수 있다는 것입니다. 이 표현 위에서 구분됨).

마지막으로, "메타 학습"이 학습 표현과 동일시되는 경우가 많다는 사실은 추측에 불과하지만(자세한 내용은 "Rapid Learning or Feature Reuse? Towards Understanding the Effectiveness of MAML" 논문 참조) 모델이 표면적으로 무엇을 최적화하는지에 관계없이 이 기사의 아이디어를 뒷받침하는 또 다른 증거로 간주됩니다.

독자들은 제가 실제 응용 분야에서 통계 학습 모델과 딥 러닝 모델 간의 차이점에 대한 일반적인 예, 즉 "편향-분산 절충"이 부족하고 over-parameterization 모델의 뛰어난 일반화 능력.

이 예제에 대해 자세히 설명하지 않는 데에는 두 가지 이유가 있습니다.

첫째, 지도 학습이 실제로 자기 감독 + 단순한 "하위 수준" 학습과 동일하다면 일반화 능력은 다음과 같습니다. 설명하세요(자세한 내용은 논문 "자기 지도 학습의 경우 합리성은 일반화를 의미함"을 참조하세요).

둘째, 과잉 매개변수화가 딥 러닝 성공의 열쇠는 아니라고 생각합니다. 딥 네트워크가 특별한 이유는 샘플 수에 비해 크기가 크다는 것이 아니라 절대적으로 크기 때문입니다. 실제로 비지도/자기 지도 학습 모델에는 일반적으로 과도한 매개변수화가 없습니다. 대규모 언어 모델의 경우에도 데이터 세트가 더 클 뿐이지 성능이 덜 신비스러운 것은 아닙니다.

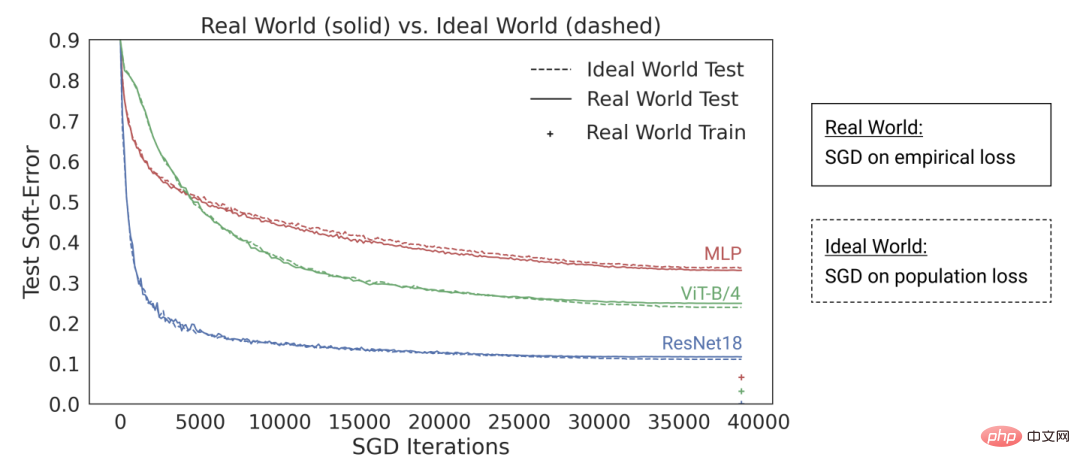

캡션: "The Deep Bootstrap Framework: Good Online Learners are Good Offline Generalizers"라는 논문에서 연구원들의 연구 결과는 오늘날의 딥 러닝 아키텍처가 "과다 매개변수화" 및 "과소 샘플링" 상태에 있음을 보여줍니다. 성능은 비슷하며(모델이 과적합될 때까지 여러 세대에 걸쳐 제한된 데이터에 대해 학습됨: 위 그림의 "실제 세계"), 또한 "과소 매개변수화된" 대 "온라인" 사례(모델이 한 세대 동안만 학습되는 경우) , 각 샘플은 한 번만 보입니다. 즉, 위 그림의 "이상적인 세계"입니다.)

통계 학습이 딥 러닝에서 중요한 역할을 한다는 것은 의심의 여지가 없습니다. 그러나 딥 러닝을 단순히 기존 모델보다 더 많은 손잡이에 맞는 모델로 생각한다면 성공의 이면에 있는 많은 요소를 놓치게 됩니다. 소위 '인간 학생'이라는 비유는 더욱 부적절하다.

딥 러닝은 동일한 규칙을 여러 번 반복 적용하더라도(예: 경험 손실이 있는 경사하강법) 매우 복잡한 결과를 생성한다는 점에서 생물학적 진화와 유사합니다. 신경망의 다양한 구성 요소는 표현 학습, 예측 피팅, 암시적 정규화 및 순수 노이즈를 포함하여 서로 다른 시간에 서로 다른 내용을 학습하는 것으로 보입니다. 우리는 딥러닝에 대한 질문에 답하는 것은 물론이고 질문할 수 있는 올바른 렌즈를 여전히 찾고 있습니다.

갈 길이 멀지만, 함께 응원하겠습니다.

위 내용은 이론적인 컴퓨터 과학자 보아즈 바라크(Boaz Barak): 딥 러닝은 '단순 통계'가 아니며 둘은 점점 더 멀어지고 있습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!