이미지 생성은 현재 AIGC 분야에서 가장 뜨거운 방향 중 하나입니다. DALL・E 2, Imagen, Stable Diffusion 등과 같은 최근 출시된 이미지 생성 모델은 이미지 생성의 새로운 시대를 열어 전례 없는 수준의 이미지 품질과 모델 유연성을 달성했습니다. 확산 모델은 또한 현재 지배적인 패러다임이 되었습니다. 그러나 확산 모델은 반복적 추론에 의존하는데, 반복 방법은 간단한 목표로 안정적인 학습을 달성할 수 있지만 추론 프로세스에는 높은 계산 비용이 필요하기 때문에 양날의 검입니다.

확산 모델 이전에는 생성적 적대 네트워크(GAN)가 이미지 생성 모델에서 일반적으로 사용되는 인프라였습니다. 확산 모델과 비교하여 GAN은 단일 순방향 패스를 통해 이미지를 생성하므로 본질적으로 더 효율적이지만 GAN을 확장하려면 훈련 프로세스의 불안정성으로 인해 네트워크 아키텍처와 훈련 요소를 신중하게 조정해야 합니다. 따라서 GAN은 단일 또는 다중 객체 클래스를 모델링하는 데 능숙하지만 (실제 세계는 물론이고) 복잡한 데이터 세트로 확장하는 것은 매우 어렵습니다. 결과적으로 이제 매우 큰 모델, 데이터 및 계산 리소스가 확산 및 자기회귀 모델에만 사용됩니다.

그러나 효율적인 생성 방법으로 많은 연구자들이 GAN 방법을 완전히 포기하지는 않았습니다. 예를 들어 NVIDIA는 최근 StyleGAN-T 모델을 제안했으며 다른 사람들은 GAN 기반 방법을 사용하여 GAN에 대한 CV 연구원의 추가 시도를 했습니다.

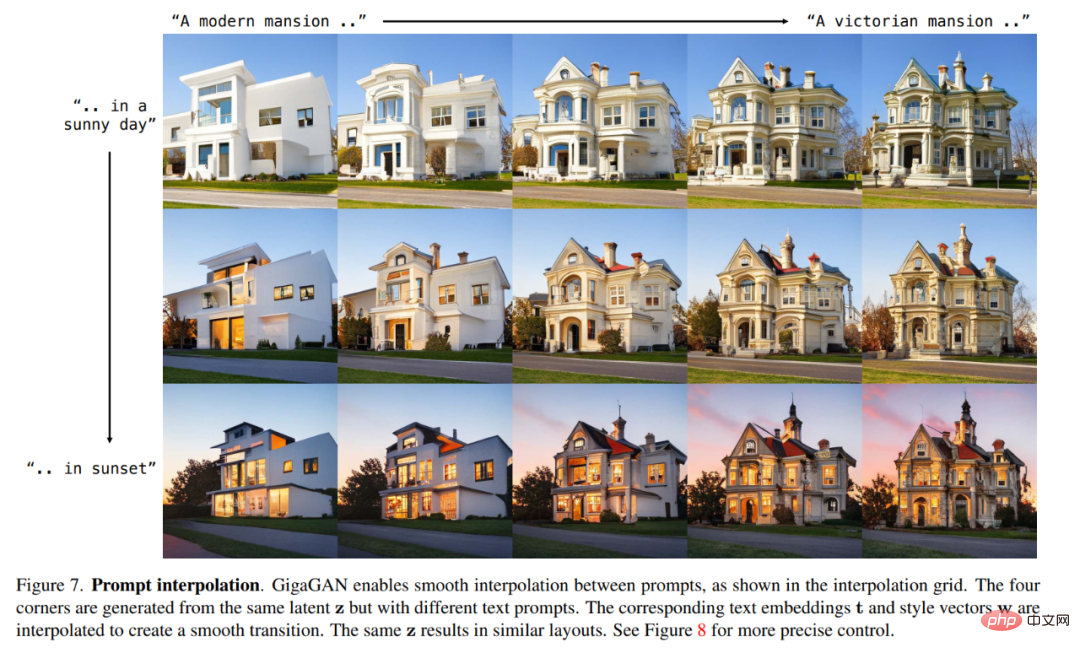

이제 CVPR 2023 논문에서 POSTECH, Carnegie Mellon University 및 Adobe Research Institute의 연구원들은 다음을 포함하여 GAN에 관한 몇 가지 중요한 문제를 공동으로 조사했습니다. GAN이 병목 현상을 겪고 있나요?

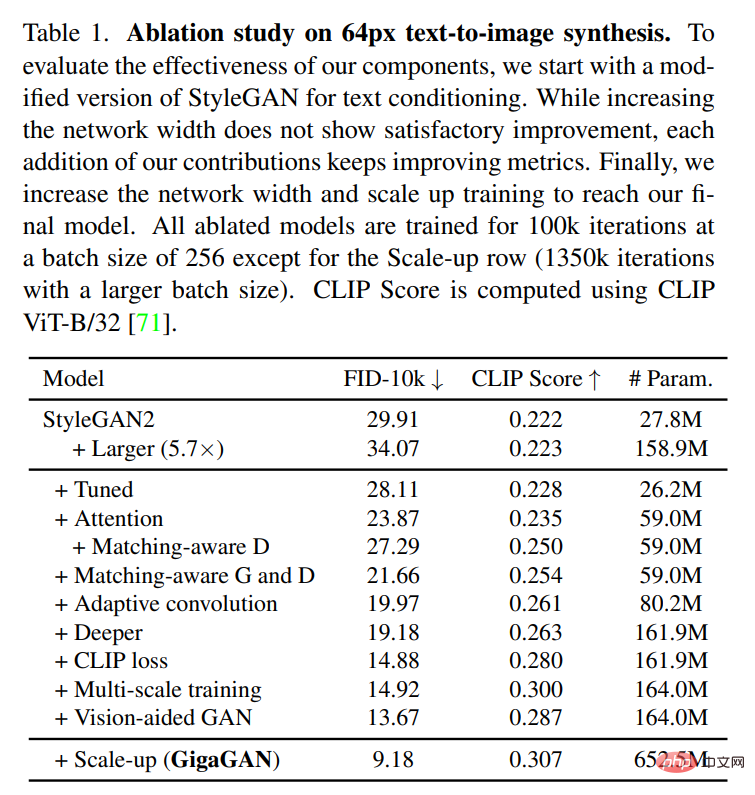

이 연구는 먼저 StyleGAN2를 사용하여 실험을 수행했으며 단순히 백본 네트워크를 확장하면 훈련이 불안정해지는 것을 관찰했습니다. 이를 바탕으로 연구진은 몇 가지 핵심 이슈를 파악하고 모델 용량을 늘리면서 훈련을 안정화할 수 있는 기술을 제안했습니다.

먼저, 이 연구에서는 필터 세트를 유지하고 샘플별 선형 조합을 사용하여 발생기의 용량을 효과적으로 확장합니다. 이 연구는 또한 확산 맥락에서 일반적으로 사용되는 몇 가지 기술을 채택하여 GAN에 유사한 이점을 제공한다는 것을 확인했습니다. 예를 들어, 셀프 어텐션(이미지만)과 교차 어텐션(이미지-텍스트)을 컨벌루션 레이어와 얽으면 모델 성능을 향상시킬 수 있습니다.

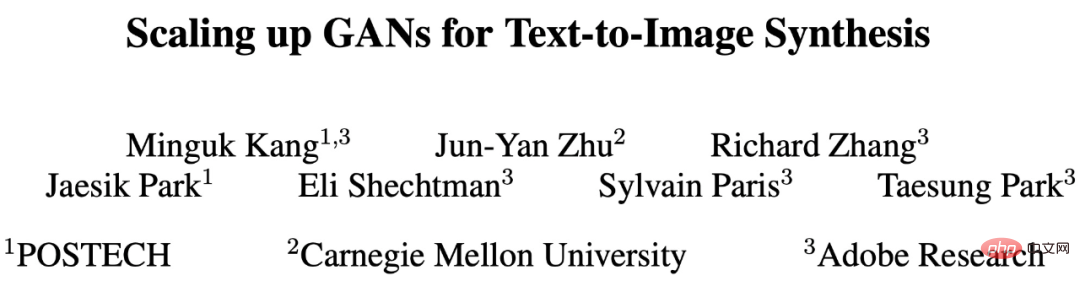

또한 이 연구에서는 다중 규모 훈련을 다시 도입하고 이미지-텍스트 정렬을 개선하고 출력의 저주파 세부 정보를 생성하는 새로운 방식을 제안합니다. 다중 규모 훈련을 통해 GAN 기반 생성기는 저해상도 블록의 매개변수를 보다 효율적으로 사용할 수 있으므로 이미지-텍스트 정렬 및 이미지 품질이 향상됩니다. 신중한 조정을 거쳐 이 연구는 10억 개의 매개변수를 가진 새로운 모델 GigaGAN을 제안하고 대규모 데이터 세트(예: LAION2B-en)에 대해 안정적이고 확장 가능한 교육을 달성합니다. 실험 결과는 아래 그림 1에 나와 있습니다.

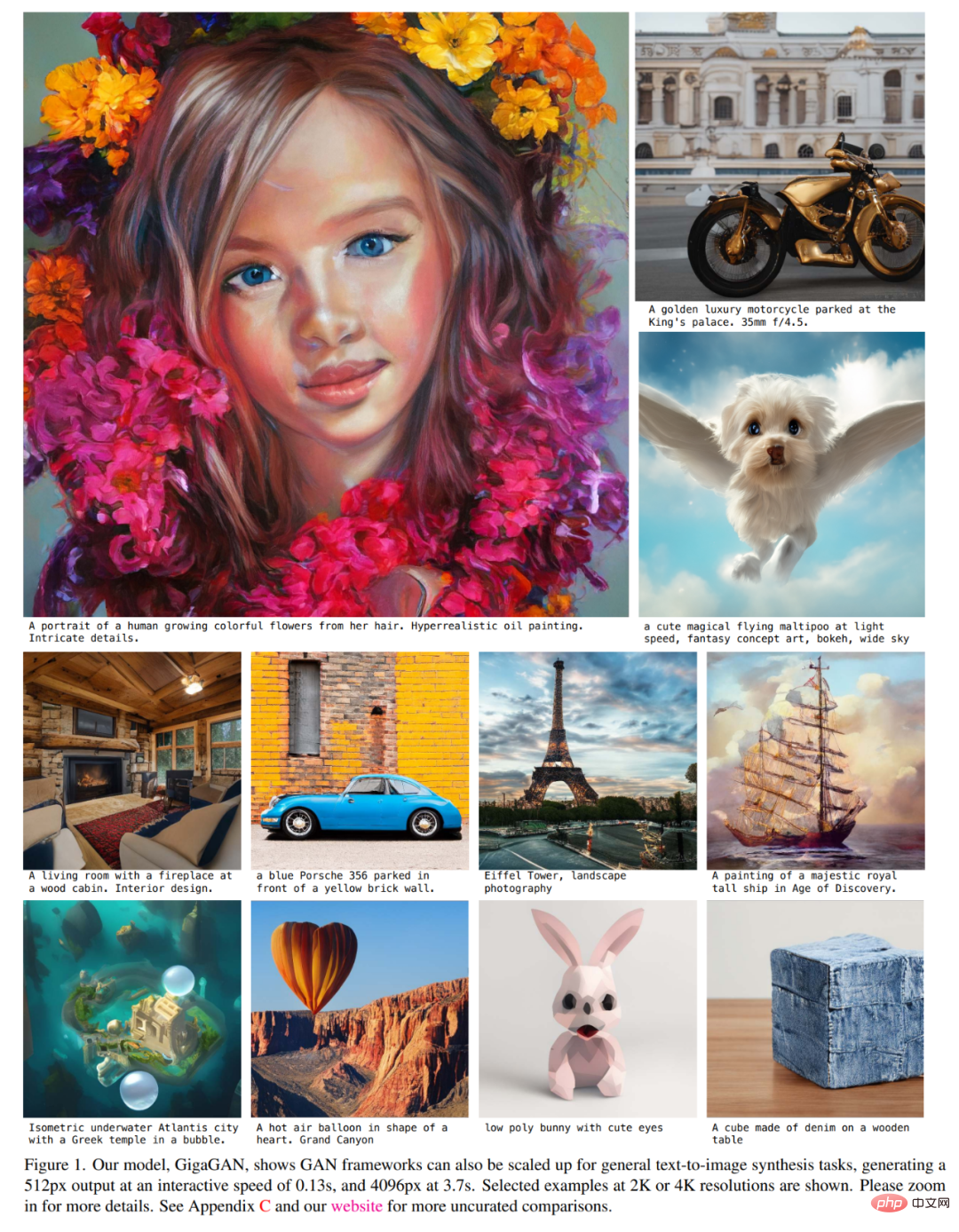

또한 이 연구는 다단계 접근 방식을 채택했습니다 [14, 104]. 먼저 64 × 64의 저해상도에서 이미지를 생성한 다음 512 × 512 해상도로 업샘플링합니다. 두 네트워크 모두 모듈식이며 플러그 앤 플레이 방식으로 사용할 수 있을 만큼 강력합니다.

이 연구는 아래 그림 2와 그림 3에 표시된 것처럼 텍스트 조건이 적용된 GAN 업샘플링 네트워크가 기본 확산 모델에 대한 효율적이고 고품질 업샘플러로 사용될 수 있음을 보여줍니다.

위의 개선으로 GigaGAN은 이전 GAN보다 훨씬 뛰어납니다. 즉, StyleGAN2보다 36배 더 크고 StyleGAN-XL 및 XMC-GAN보다 6배 더 큽니다. GigaGAN의 매개변수 수인 10억(1B)은 Imagen(3.0B), DALL・E 2(5.5B) 및 Parti(20B)와 같은 최근의 대규모 합성 모델에 비해 여전히 낮지만 연구원들은 아직 그렇지 않다고 말합니다. 모델의 변화를 관찰했습니다. 사이즈 품질이 포화 상태입니다.

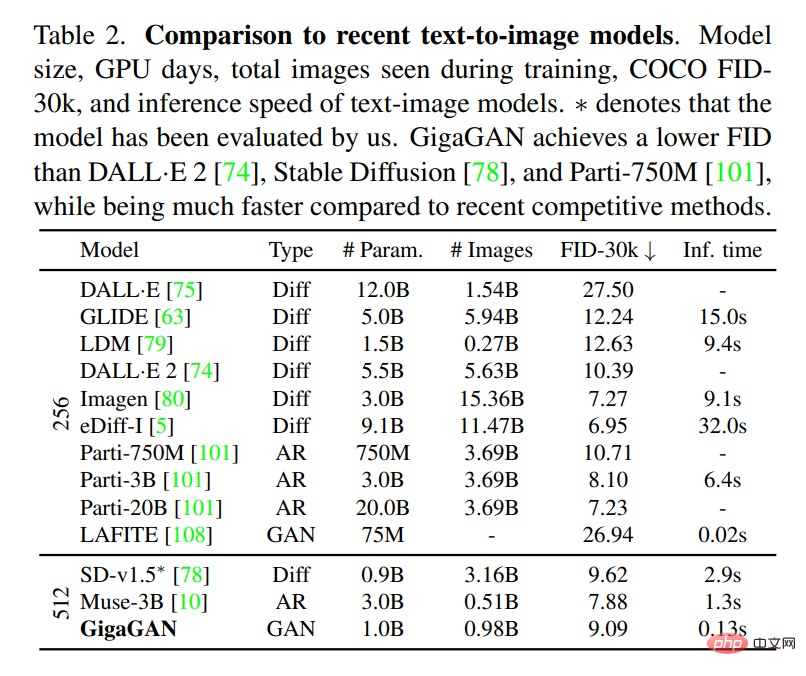

GigaGAN은 COCO2014 데이터세트에서 9.09의 제로 샘플 FID를 달성했는데, 이는 DALL・E 2, Parti-750M 및 Stable Diffusion보다 낮습니다.

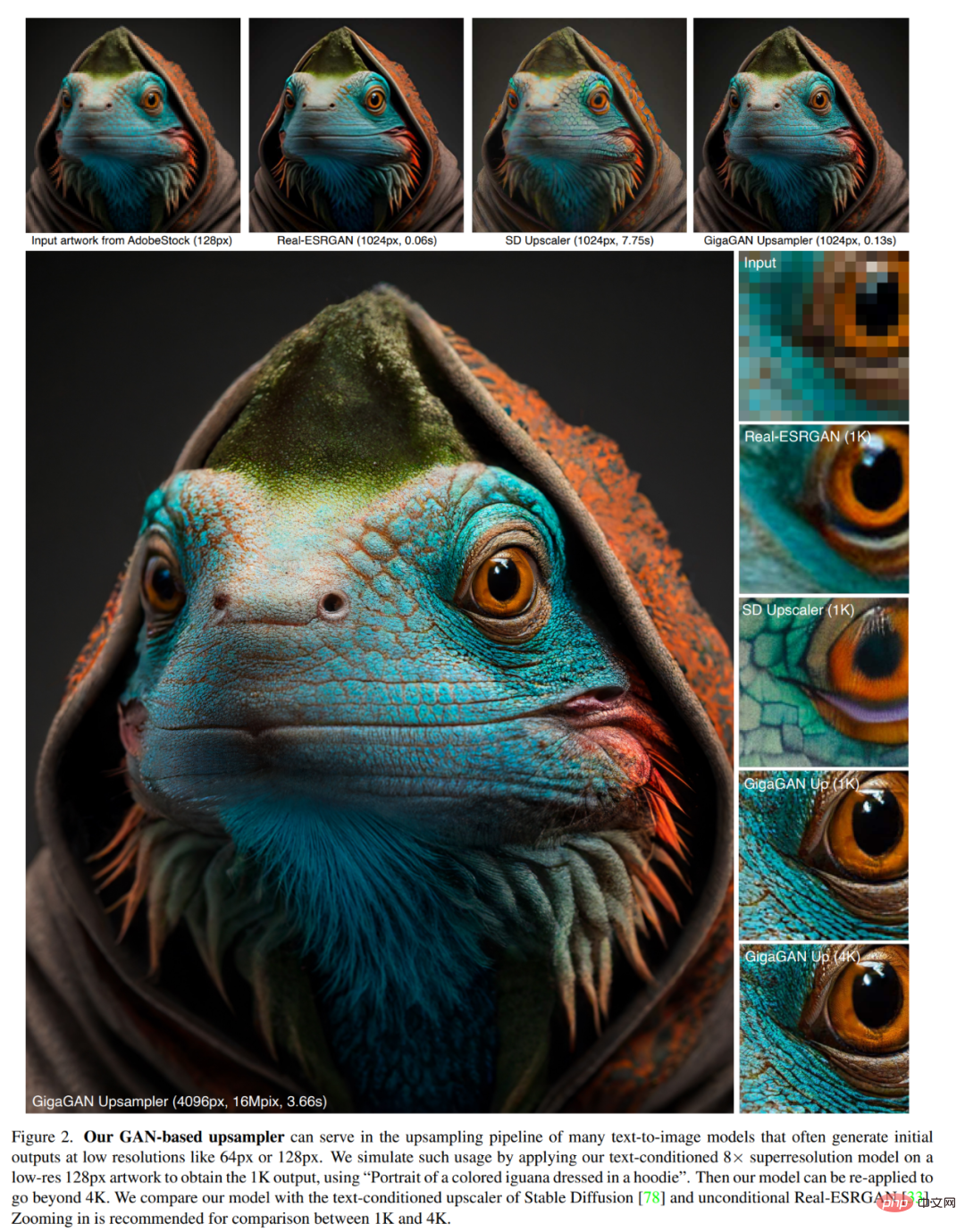

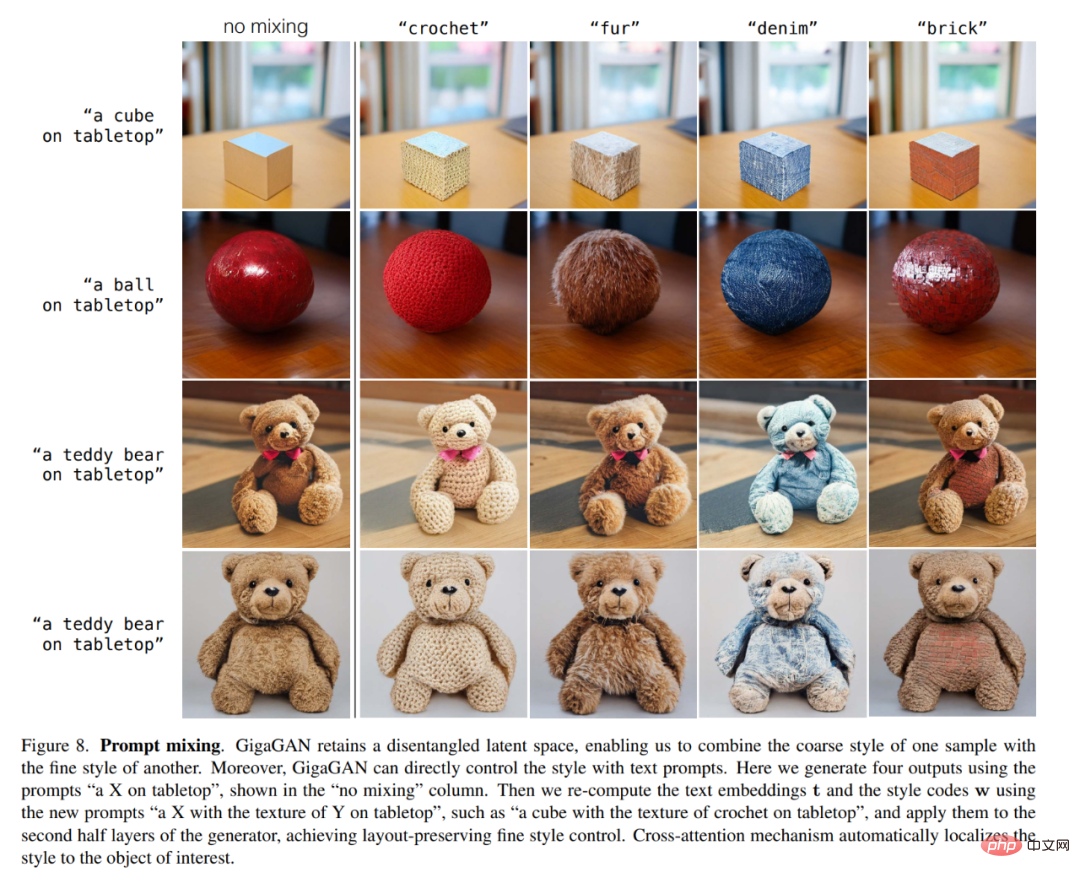

또한 확산 모델 및 자동 회귀 모델과 비교하여 GigaGAN은 세 가지 주요 실용적인 이점을 가지고 있습니다. 첫째, 수십 배 더 빨라져 0.13초 만에 512픽셀 이미지를 생성합니다(그림 1). 둘째, 단 3.66초 만에 4K 해상도의 초고해상도 이미지를 합성할 수 있다. 셋째, 스타일 블렌딩(그림 6), 프롬프트 보간(그림 7), 프롬프트 블렌딩(그림 8)과 같이 잘 연구된 제어 가능한 이미지 합성 애플리케이션에 적합한 제어 가능한 잠재 벡터 공간을 가지고 있습니다.

이 연구는 수십억 개의 실제 이미지에 대해 GAN 기반 10억 매개변수 규모 모델 GigaGAN을 성공적으로 교육했습니다. 이는 GAN이 텍스트-이미지 합성을 위한 실행 가능한 옵션으로 남아 있으며 연구자들이 공격적인 향후 확장을 위해 GAN을 고려해야 함을 시사합니다.

연구원들은 잠재 인코딩 z∼N (0, 1)∈R^128 및 텍스트 조건화 신호 c가 주어졌을 때 예측하도록 생성기 G(z, c)를 훈련했습니다. 이미지 x∈R^( H×W×3). 그들은 판별기 D(x, c)를 사용하여 이미지-텍스트 쌍이 포함된 훈련 데이터베이스 D의 샘플과 비교하여 생성된 이미지의 신뢰성을 판단합니다.

GAN은 단일 및 다중 클래스 데이터 세트에서 사실적인 이미지를 성공적으로 생성할 수 있지만 인터넷 이미지의 개방형 텍스트 조건부 합성은 여전히 어려움에 직면해 있습니다. 연구자들은 현재의 한계가 컨볼루션 레이어에 대한 의존성에서 비롯된다고 가정합니다. 즉, 동일한 컨볼루셔널 필터를 사용하여 이미지의 모든 위치에서 모든 텍스트 조건에 대한 범용 이미지 합성 기능을 모델링하는데 이는 어려운 일입니다. 이를 고려하여 연구자들은 입력 조건에 따라 컨볼루션 필터를 동적으로 선택하고 어텐션 메커니즘을 통해 장거리 종속성을 캡처하여 매개변수화에 더 많은 표현력을 주입하려고 합니다.

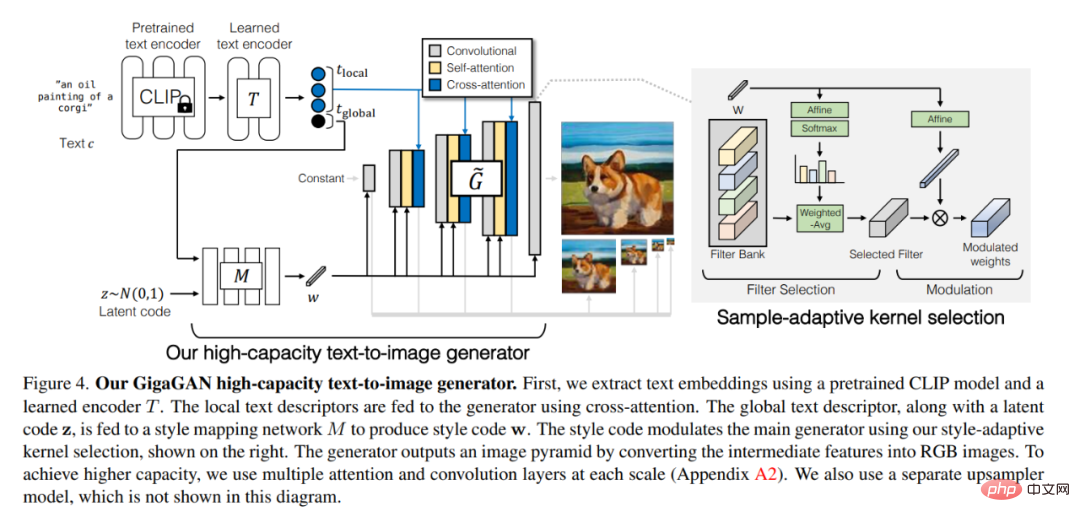

GigaGAN 대용량 텍스트 이미지 생성기는 아래 그림 4에 나와 있습니다. 먼저 사전 훈련된 CLIP 모델과 학습된 인코더 T를 사용하여 텍스트 임베딩을 추출합니다. Cross-Attention을 사용하여 생성기에 로컬 텍스트 설명자를 제공합니다. 전역 텍스트 설명자는 잠재 코드 z와 함께 스타일 매핑 네트워크 M에 입력되어 스타일 코드 w를 생성합니다. 스타일 코드는 오른쪽에 표시된 적응형 커널 선택 문서의 스타일을 사용하여 기본 생성기를 조정합니다.

생성기는 중간 특징을 RGB 이미지로 변환하여 이미지 피라미드를 출력합니다. 더 높은 용량을 달성하기 위해 각 규모에서 다중 Attention 및 Convolutional 레이어를 사용합니다(부록 A2). 그들은 또한 이 그림에 표시되지 않은 별도의 업샘플러 모델을 사용했습니다.

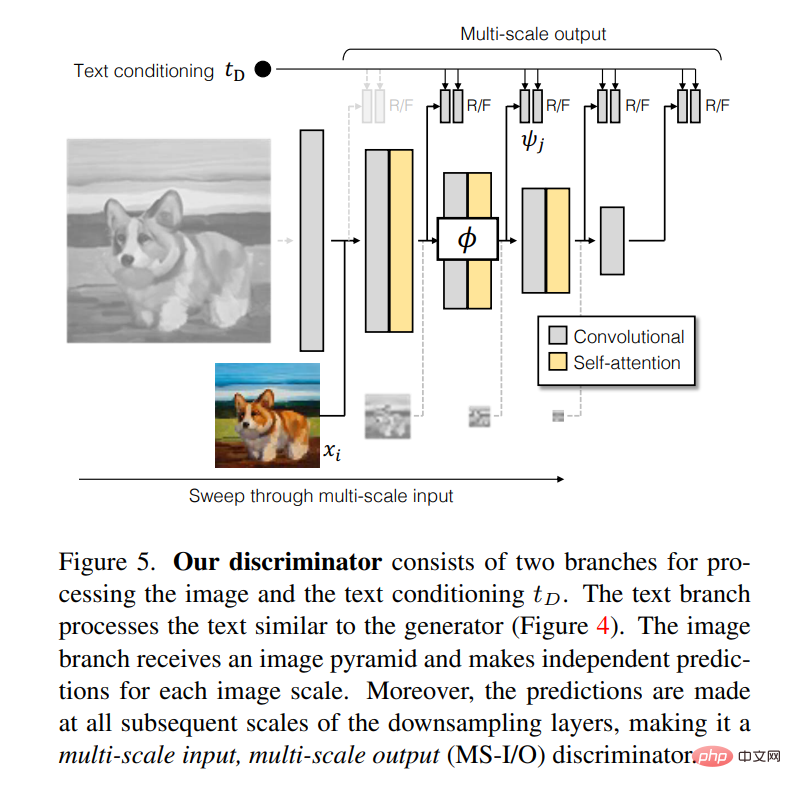

판별기는 이미지 및 텍스트 조건 t_D를 처리하기 위한 두 개의 분기로 구성됩니다. 텍스트 분기는 생성기와 유사하게 텍스트를 처리합니다(그림 4). 이미지 분기는 이미지 피라미드를 수신하고 각 이미지 규모에 대해 독립적인 예측을 수행합니다. 또한 다운샘플링 계층의 모든 후속 스케일에서 예측이 이루어지므로 이를 다중 스케일 입력, 다중 스케일 출력(MS-I/O) 판별자로 만듭니다.

논문에서 저자는 다섯 가지 실험을 기록했습니다.

첫 번째 실험에서는 각 기술 구성 요소를 하나씩 통합하여 제안한 방법의 효율성을 입증했습니다.

두 번째 실험에서는 모델의 그래프 생성 능력을 테스트한 결과 GigaGAN이 Stable Diffusion(SD-v1.5)과 비슷한 FID를 수행하는 동시에 더 나은 결과를 생성하는 것으로 나타났습니다. 확산 또는 자기회귀 모델이 훨씬 빠릅니다.

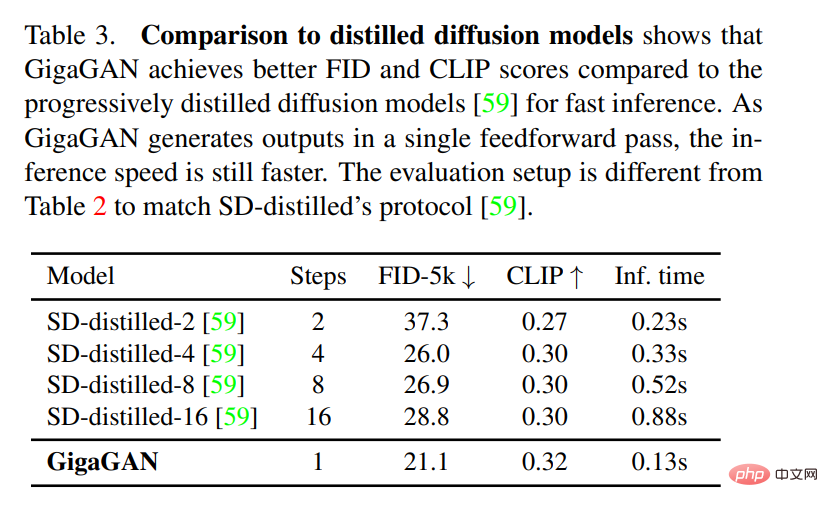

세 번째 실험에서는 GigaGAN을 증류 기반 확산 모델과 비교한 결과 GigaGAN이 증류 기반 확산 모델보다 더 빠르게 고품질 이미지를 합성할 수 있는 것으로 나타났습니다.

네 번째 실험에서는 조건부 및 무조건 초해상도 작업에서 다른 업샘플러와 비교하여 GigaGAN의 업샘플러의 장점을 확인했습니다. ㅋㅋㅋ 다이어그램은 위의 그림 6과 8을 참조하세요.

위 내용은 GAN의 반격: Zhu Junyan의 새로운 CVPR 작품 GigaGAN, 지도 출력 속도가 Stable Diffusion을 능가함의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!