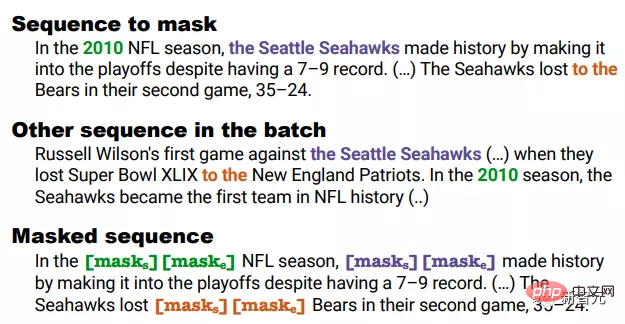

NLP 분야에서 대규모 언어 모델의 강력한 성능은 놀랍지만 훈련 비용이 너무 비싸고 업데이트하기 어려운 등 부정적인 비용도 심각합니다. , 롱테일 지식을 다루기가 어렵습니다.

그리고 언어 모델은 일반적으로 예측 레이어에서 제한된 어휘를 포함하는 소프트맥스 레이어를 사용하는데, 이는 기본적으로 희귀한 단어나 구문을 출력하지 않아 모델의 표현 능력을 크게 제한합니다.

모델의 롱테일 문제를 해결하기 위해 최근 워싱턴 대학의 Meta AI와 Allen Institute for Artificial Intelligence의 학자들이 공동으로 최초의 "NonParametric Masked Language Model"(NPM)을 제안했습니다. 참조 코퍼스의 각 문구에 대한 비모수적 분포로 대체됩니다.

문서 링크: https://arxiv.org/abs/2212.01349

코드 링크: https://github.com/facebookresearch/NPM

NPM은 대조 목표 및 배치 내 근사치를 사용할 수 있습니다. 완전한 자료를 검색합니다.

연구원들은 새로운 사실이나 희귀한 문구를 예측해야 할 필요성을 강조하는 시공간 변환 및 단어 수준 번역 작업을 포함하여 9개의 폐쇄형 작업과 7개의 개방형 작업에 대해 제로샷 평가를 실시했습니다.

결과는 검색 및 생성 방법의 사용 여부에 관계없이 NPM이 더 큰 매개변수 모델보다 훨씬 우수하다는 것을 보여줍니다. 예를 들어 매개변수가 500배 더 높은 GPT-3과 37배 더 높은 성능을 가진 OPT 13B가 훨씬 우수하고 NPM이 훨씬 좋습니다. 특히 희귀한 패턴(단어 의미 또는 사실)을 처리하고 희귀하거나 거의 보이지 않는 단어(예: 비라틴 문자)를 예측하는 데 효과적입니다.

이 문제는 기존 검색 및 생성 관련 작업을 결합하여 완화할 수 있지만, 이러한 모델의 최종 예측 부분에는 여전히 토큰을 예측하기 위한 소프트맥스 레이어가 필요하며, 근본적으로 문제를 해결하지 못합니다. 긴 꼬리 문제.

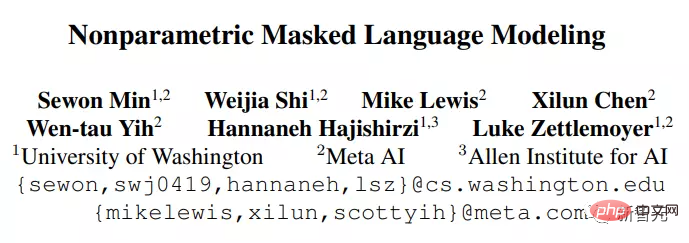

NPM은 인코더와 참조 코퍼스로 구성됩니다. 인코더는 텍스트를 고정 크기 벡터로 매핑한 다음 NPM이 여기에서 구문을 검색하여 [MASK]를 채웁니다.

보시다시피 NPM은 고정 출력 어휘 소프트맥스를 출력으로 사용하는 대신 구문에서 얻은 비모수 분포를 선택합니다.

그러나 비모수적 모델을 훈련하면 다음과 같은 두 가지 주요 문제도 발생합니다.

1. 훈련 과정에서 전체 말뭉치를 검색하는 것은 매우 시간이 많이 걸리고 노동 집약적입니다.

2. 디코더 없이 임의 길이의 구문을 예측하는 방법을 학습하는 것은 어려우며, 연구자들은 범위 마스킹 및 구문 수준 비교 목표를 확장하여 이 문제를 해결합니다.

요약하자면 NPM은 출력 어휘의 소프트맥스를 완전히 제거하고 n-그램 수를 예측하여 효과적인 무제한 출력 공간을 달성합니다.

결과 모델은 "매우 희귀한" 단어 또는 심지어 "완전히 보이지 않는" 단어(예: 한국어 단어)를 예측할 수 있으며 기존 모델이 할 수 없는 무제한 어휘를 효과적으로 지원할 수 있습니다.

NPM의 핵심 아이디어는 인코더를 사용하여 코퍼스의 모든 구문을 조밀한 벡터 공간에 매핑하는 것입니다. 추론 시 [MASK]로 쿼리가 주어지면 인코더를 사용하여 코퍼스에서 가장 가까운 구문을 찾아 [MASK]를 채웁니다.

순수 인코더(인코더 전용) 모델은 매우 경쟁력 있는 표현 모델이지만, 기존 인코딩 전용 모델은 알 수 없는 수의 토큰으로는 예측을 할 수 없어 미세 조정 없이는 사용이 제한됩니다.

NPM은 원하는 수의 토큰으로 [MASK]를 채울 문구를 검색하여 이 문제를 해결합니다.

Inference

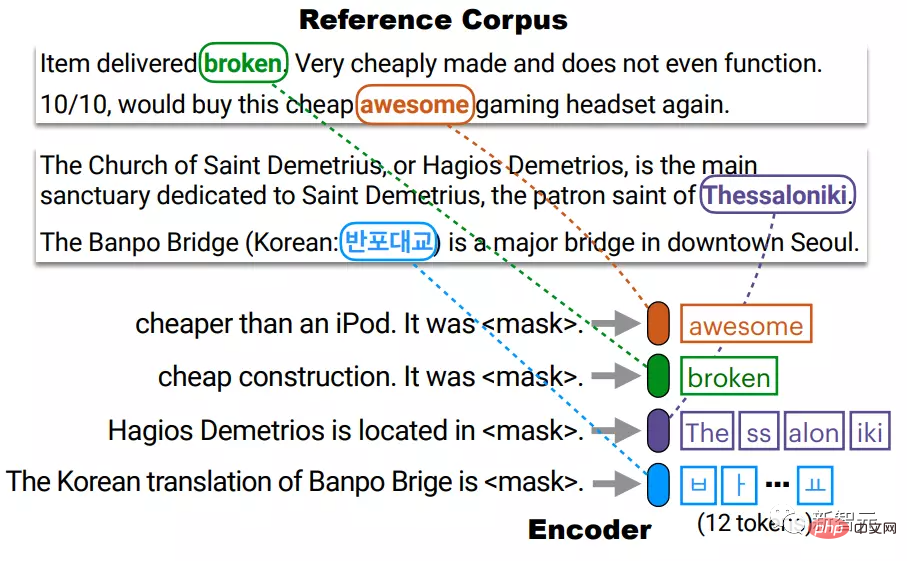

인코더는 참조 코퍼스 C의 각 고유 문구를 조밀한 벡터 공간에 매핑합니다.

테스트 시간에 인코더는 마스크된 쿼리를 동일한 벡터 공간에 매핑하고 [MASK]를 C에서 검색한 구문으로 채웁니다.

여기서 C는 훈련 코퍼스와 동일할 필요가 없으며 테스트 시 인코더를 재훈련하지 않고도 교체하거나 확장할 수 있습니다.

실제로는 코퍼스에 많은 수의 구문이 있고 이를 모두 색인화하는 데 비용이 많이 듭니다.

예를 들어, 최대 l개 토큰(l≒20)이 있는 구문을 고려하면 l×|C| 수의 벡터를 색인화해야 하는데 이는 시간이 많이 걸릴 수 있습니다.

연구원들은 C에서 서로 다른 토큰을 인덱싱하여 인덱스 크기를 l × |C|에서 |C|로 줄인 후 테스트 시 처음과 끝에서 k개의 최근접 이웃 검색을 수행했습니다. 모든 문구의 비모수적 분포를 근사화합니다.

예를 들어 4개의 BPE 토큰으로 구성된 Thessaloniki라는 문구는 c1과 c4의 연결로 표현되는데, 이는 각각 문구의 시작(The)과 끝(iki)에 해당합니다.

그런 다음 동일한 벡터 공간에 두 개의 벡터 q_start와 q_end를 사용하여 쿼리를 표현하고, 집계를 수행하기 전에 각 벡터를 사용하여 그럴듯한 구문의 시작과 끝을 검색합니다.

이 작업을 수행하는 전제는 시작과 끝의 표현이 충분히 좋다는 것입니다. 즉, q의 시작점은 c1에 충분히 가깝고 q의 끝점은 c4에 충분히 가깝습니다. 훈련 과정에서 보장되었습니다.

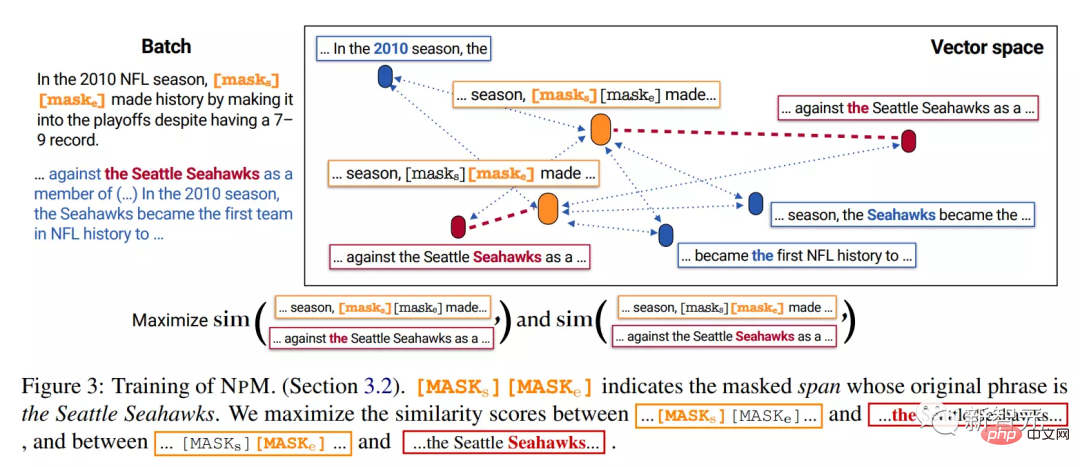

Training

NPM은 인코더가 텍스트를 밀도가 높은 벡터 공간에 매핑하도록 레이블이 지정되지 않은 텍스트 데이터에 대해 훈련되었습니다.

NPM 훈련에는 두 가지 주요 문제가 있습니다. 1) 완전한 말뭉치 검색은 훈련에 매우 많은 시간을 소모하게 합니다. 2) 토큰 대신 임의 길이의 구문으로 [MASK]를 채웁니다.

1. 마스킹 마스킹

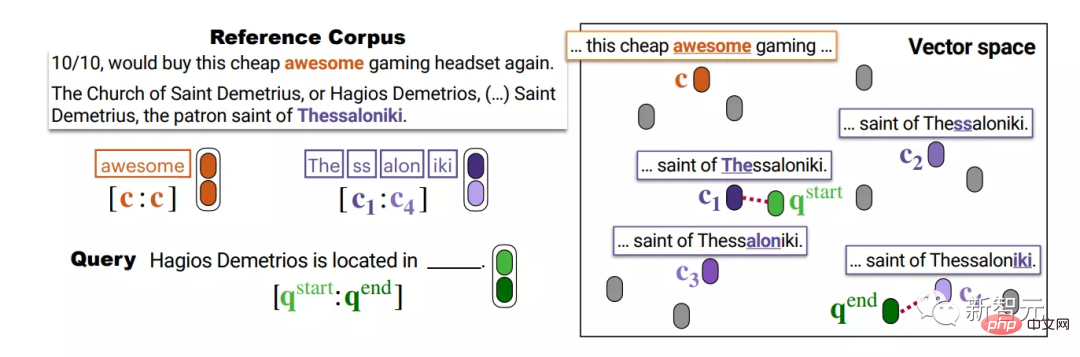

스팬 마스킹은 기하학적 분포에서 샘플링된 길이의 연속 토큰을 마스킹하는 것입니다.

연구원들은 이에 대해 다음과 같이 확장했습니다.

1) 일부 조각이 배치의 다른 시퀀스에서 동시에 발생하는 경우 훈련 중에 배치 내 양성을 보장하기 위해 마스크됩니다.

예를 들어 마스크를 쓴 클립 2010, Seattle Seahawks 및 to the all이 다른 시퀀스로 함께 등장합니다.

그러나 바이그램 "게임"의 경우 함께 마스크할 수는 없지만 두 개의 시퀀스로 나타나기도 하지만 함께 발생하지는 않습니다.

2) 조각의 각 토큰을 [MASK]로 교체하는 대신 전체 조각을 두 개의 특수 토큰 [MASKs][MASKe]로 교체하세요.

예를 들어 위의 예에서는 마스크된 세그먼트의 길이에 관계없이 [MASKs][MASKe]로 대체되어 각 세그먼트의 시작 및 끝 벡터를 얻을 수 있으므로 추론이 더 편리해집니다.

2. 훈련 목표

마스크된 세그먼트가 Seattle Seahawks라고 가정하면 테스트 중에 모델은 참조 코퍼스의 다른 시퀀스에서 Seattle Seahawks라는 문구를 검색해야 합니다.

추론 단계에서 모델은 [MASKs] 및 [MASKe]에서 벡터를 획득하고 이를 사용하여 각각 말뭉치에서 구문의 시작과 끝을 검색합니다.

따라서 훈련 목표는 [MASKs]의 벡터가 Seattle Seahawks의 에 더 가까워지고 다른 토큰과는 더 멀어지도록 장려해야 하며, 첫 번째가 되는 것과 같은 어떤 문구에서도 the가 되어서는 안 됩니다.

우리는 전체 코퍼스를 배치의 다른 시퀀스에 근사하도록 모델을 훈련함으로써 이를 수행합니다. 특히, 동일한 배치의 다른 시퀀스에서 Seattle Seahawks 세그먼트의 시작점과 끝점을 검색하도록 모델을 훈련합니다.

이 마스크 전략은 마스크된 각 범위에 일괄적으로 동시에 발생하는 세그먼트가 있음을 보장한다는 점에 유의해야 합니다.

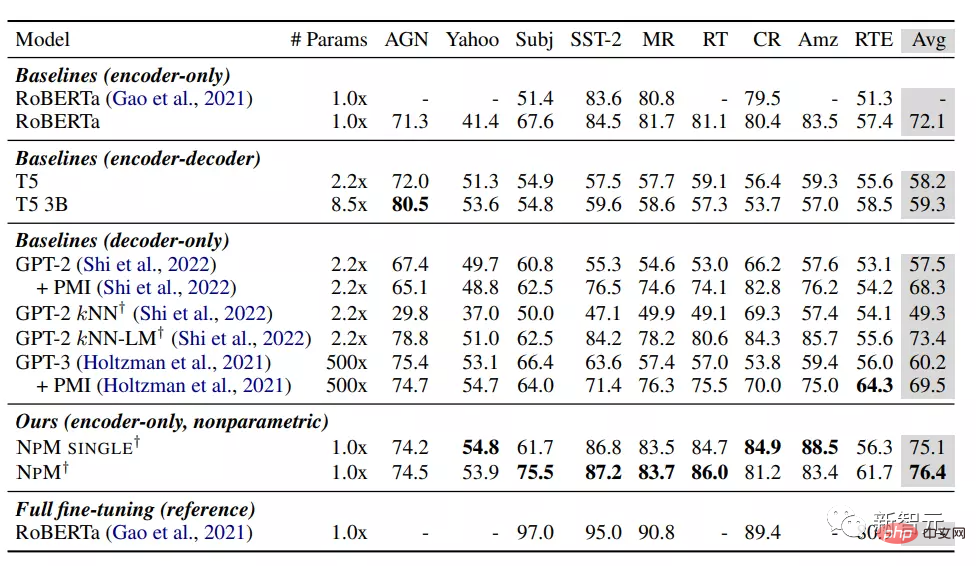

결과로 볼 때 NPM은 제로샷 설정에서 다른 기본 모델보다 더 나은 성능을 발휘합니다.

파라메트릭 모델 중 RoBERTa는 예상외로 GPT-3을 포함한 모델을 능가하는 최고의 성능을 달성했는데, 이는 아마도 순수 인코더 모델의 양방향성이 중요한 역할을 했기 때문일 것이며, 이는 인과 언어 모델이 적합하지 않을 수도 있음을 시사합니다. 분류를 위한 선택.

kNN-LM 방법은 파라메트릭 모델에 비모수적 구성 요소를 추가하며 그 성능은 다른 모든 기준보다 우수합니다. 그럼에도 불구하고 검색(kNN)에만 의존하는 것은 GPT-2에서 성능이 좋지 않아 추론 시에만 kNN을 사용하는 데 한계가 있음을 나타냅니다.

NPM SINGLE과 NPM 모두 모든 기준을 크게 능가하여 모든 데이터 세트에서 일관되게 우수한 성능을 달성했습니다. 이는 외부 지식이 명시적으로 필요하지 않은 작업에 대해서도 비모수적 모델이 매우 경쟁력이 있음을 보여줍니다.

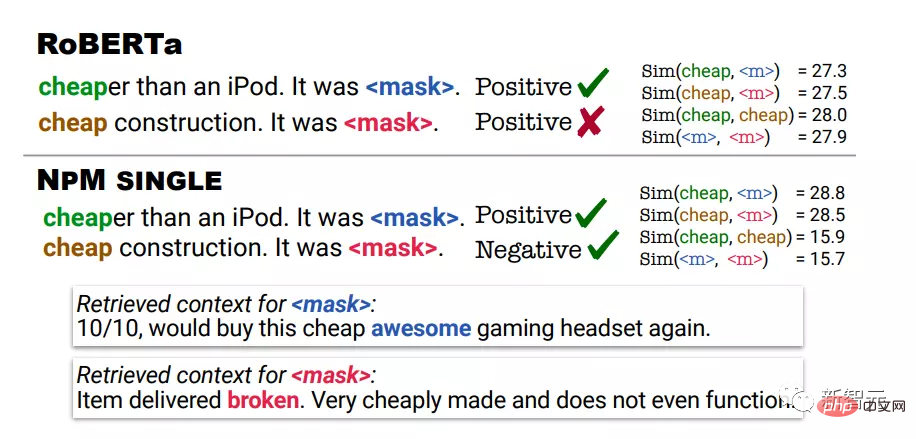

정성 분석은 감정 분석 작업에 RoBERTa 및 NPM의 예측 결과를 사용합니다. 첫 번째 예에서 저렴하다는 것은 비싸지 않다는 것을 의미하고, 두 번째 예에서 저렴하다는 것은 품질이 좋지 않다는 것을 의미합니다.

RoBERTa의 예측은 두 예 모두에서 긍정적인 반면, NPM은 입력과 동일한 컨텍스트에서 cheap가 사용된 컨텍스트를 검색하여 올바른 예측을 했습니다.

NPM의 표현 출력이 더 나은 단어 의미 명확성을 가져올 수 있다는 것도 확인할 수 있습니다. 예를 들어 RoBERTa는 저렴한 것과 저렴한 것 사이에 높은 유사성 점수를 할당합니다.

반면 NPM은 저렴한 것과 저렴한 것 사이에 낮은 유사성 점수를 성공적으로 할당했으며, 이는 대조 목표를 가진 이 비모수적 훈련이 효과적이며 표현 학습을 더 잘 향상시킬 수 있음을 보여줍니다. 반면에 kNN 추론은 훈련 없는 알고리즘은 완전히 불가능합니다. .

참고자료: https://arxiv.org/abs/2212.01349

위 내용은 Meta는 최초의 '비모수적' 마스크 언어 모델 NPM을 출시합니다. 매개변수 수의 500배로 GPT-3를 능가합니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!