최근 GAN(Generative Adversarial Network)을 기반으로 한 이미지 생성에 대한 연구가 상당한 진전을 이루었습니다. 고해상도의 사실적인 그림을 생성할 수 있는 것 외에도 개인화된 그림 편집, 그림 애니메이션 등과 같은 많은 혁신적인 응용 프로그램도 등장했습니다. 그러나 비디오 생성에 GAN을 사용하는 방법은 여전히 어려운 문제입니다.

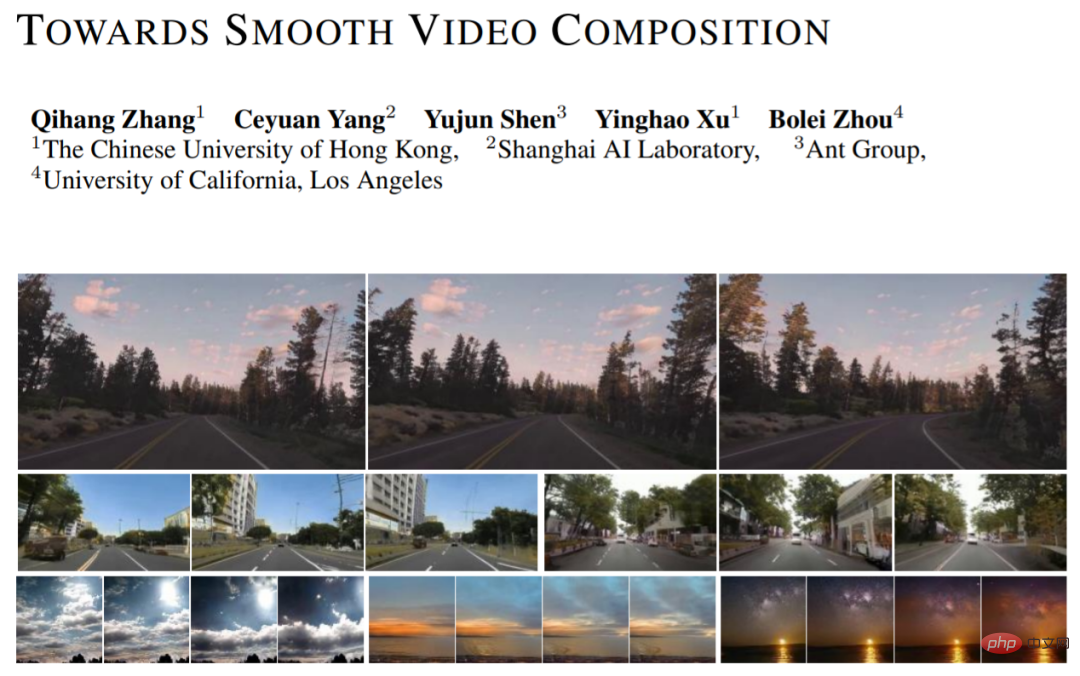

비디오 생성에는 단일 프레임 이미지를 모델링하는 것 외에도 복잡한 시간적 관계를 학습해야 합니다. 최근 홍콩중문대학교, 상하이 인공지능연구소, 앤트기술연구소, 캘리포니아대학교 로스앤젤레스캠퍼스 연구진이 새로운 영상 생성 방식(Towards Smooth Video Composition)을 제안했다. 기사에서 그들은 다양한 범위(단기 범위, 중간 범위, 장거리)의 타이밍 관계에 대한 세부 모델링 및 개선을 수행했으며 이전 작업과 비교하여 여러 데이터 세트에서 상당한 개선을 달성했습니다. 이 작업은 GAN 기반 비디오 생성을 위한 간단하고 효과적인 새로운 벤치마크를 제공합니다.

GAN 기반 이미지 생성 네트워크는 다음과 같이 표현될 수 있습니다. I=G(Z), 여기서 Z는 랜덤 변수, G는 생성 네트워크, I는 생성된 이미지입니다. 우리는 이 프레임워크를 비디오 생성 범주로 간단하게 확장할 수 있습니다: I_i=G(z_i), i=[1,...,N], 여기서 우리는 N개의 무작위 변수 z_i를 한 번에 샘플링하고 각 무작위 변수 z_i는 다음을 생성합니다. 그림 I_i의 A 프레임에 해당합니다. 생성된 영상은 생성된 이미지를 시간차원으로 쌓아서 얻을 수 있다.

MoCoGAN, StyleGAN-V 및 기타 연구에서는 이를 기반으로 분리된 표현을 제안했습니다: I_i=G(u, v_i), i=[1,...,N], 여기서 u는 제어 내용을 나타냅니다. 변수 v_i는 동작을 제어하는 랜덤 변수를 나타냅니다. 이 표현은 모든 프레임이 동일한 내용을 공유하고 고유한 모션을 갖는다고 주장합니다. 이러한 분리된 표현을 통해 일관된 콘텐츠 스타일과 변화하는 사실성을 갖춘 액션 비디오를 더 잘 생성할 수 있습니다. 신작에서는 StyleGAN-V의 디자인을 채택하여 베이스라인으로 사용하고 있다.

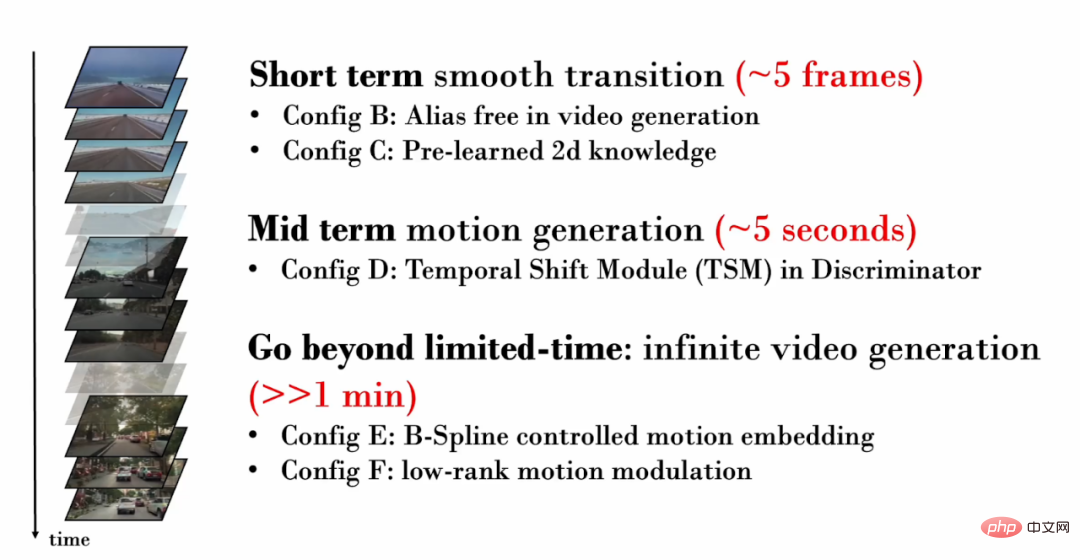

신작에서는 다양한 범위(단거리, 중간 범위, 장거리)의 타이밍 관계에 중점을 두고 각각 세부 모델링 및 개선을 수행합니다.

1. ) 타이밍 관계

먼저 몇 개의 프레임만 있는 비디오를 고려해 보겠습니다. 이러한 짧은 비디오 프레임에는 매우 유사한 콘텐츠가 포함되어 매우 미묘한 움직임만 표시되는 경우가 많습니다. 따라서 프레임 간 미묘한 움직임을 현실적으로 생성하는 것이 중요합니다. 그러나 StyleGAN-V로 생성된 동영상에서는 심각한 텍스처 고착이 발생합니다.

질감 접착이란 생성된 콘텐츠의 일부가 특정 좌표에 의존하여 고정된 영역에 "붙는" 현상을 일으키는 것을 말합니다. 이미지 생성 분야에서 StyleGAN3은 상세한 신호 처리, 확장된 패딩 범위 및 기타 작업을 통해 텍스처 접착 문제를 완화합니다. 이 작업은 동일한 기술이 비디오 생성에도 여전히 효과적이라는 것을 검증합니다.

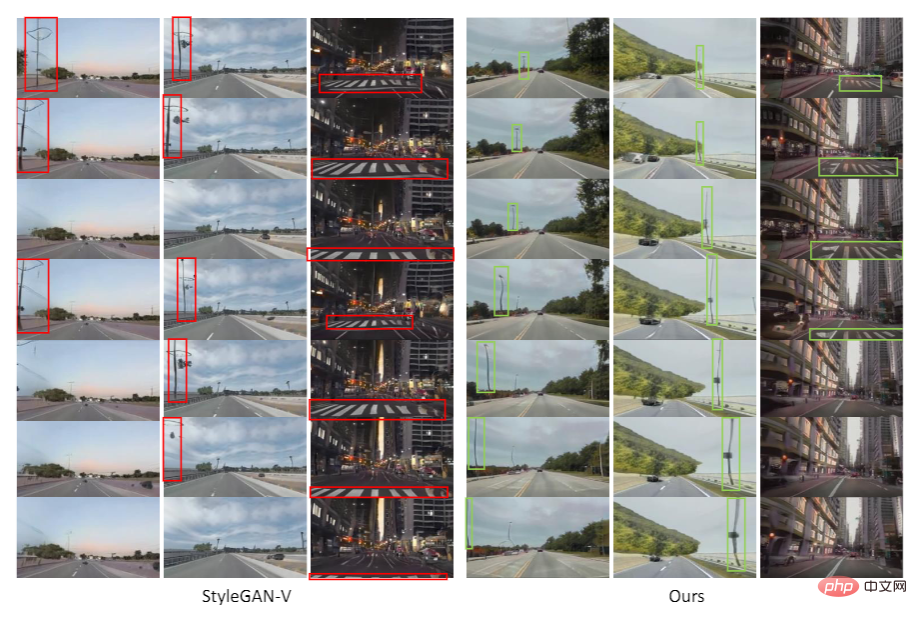

아래 시각화에서는 비디오의 각 프레임에서 동일한 위치에 있는 픽셀을 추적합니다. StyleGAN-V 영상에서 일부 콘텐츠가 고정된 좌표에 오랫동안 '고착'되어 시간이 지나도 움직이지 않아 시각화에서 '브러시 현상'이 발생하는 것을 쉽게 찾을 수 있습니다. 신작으로 제작된 영상에서는 모든 픽셀이 자연스러운 움직임을 보여준다.

그러나 연구원들은 StyleGAN3의 백본을 참조하면 이미지 생성 품질이 저하된다는 사실을 발견했습니다. 이 문제를 완화하기 위해 이미지 수준 사전 학습을 도입했습니다. 사전 훈련 단계에서 네트워크는 비디오에서 특정 프레임의 생성 품질만 고려하면 되며 시간 범위 모델링을 학습할 필요가 없으므로 이미지 분포에 대한 지식을 더 쉽게 배울 수 있습니다.

2. 중간 길이(~5초) 타이밍 관계

생성된 영상의 프레임 수가 많을수록 더욱 구체적인 동작을 보여줄 수 있습니다. 따라서 생성된 비디오에 사실적인 움직임이 있는지 확인하는 것이 중요합니다. 예를 들어, 1인칭 운전 영상을 생성하려면 점차적으로 멀어지는 지상과 거리 장면을 생성해야 하며, 다가오는 자동차도 자연스러운 주행 궤적을 따라야 합니다.

적대적 훈련에서는 생성 네트워크가 충분한 훈련 감독을 받도록 보장하기 위해 차별적 네트워크가 중요합니다. 따라서 비디오 생성에서 생성 네트워크가 현실적인 동작을 생성할 수 있도록 하기 위해 판별 네트워크는 여러 프레임의 시간적 관계를 모델링하고 생성된 비현실적인 모션을 캡처해야 합니다. 그러나 이전 작업에서 판별 네트워크는 시간 모델링을 수행하기 위해 간단한 연결 작업만 사용했습니다. y = cat(y_i). 여기서 y_i는 단일 프레임 특징을 나타내고 y는 시간 영역 융합 후 특징을 나타냅니다.

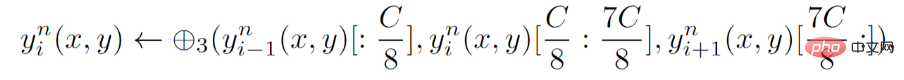

판별 네트워크에 대해 새로운 연구에서는 판별 네트워크의 각 계층에 TSM(Temporal Shift Module)을 도입하는 명시적 타이밍 모델링을 제안합니다. TSM은 행동 인식 분야에서 왔으며 간단한 교대 작업을 통해 시간적 정보 교환을 실현합니다.

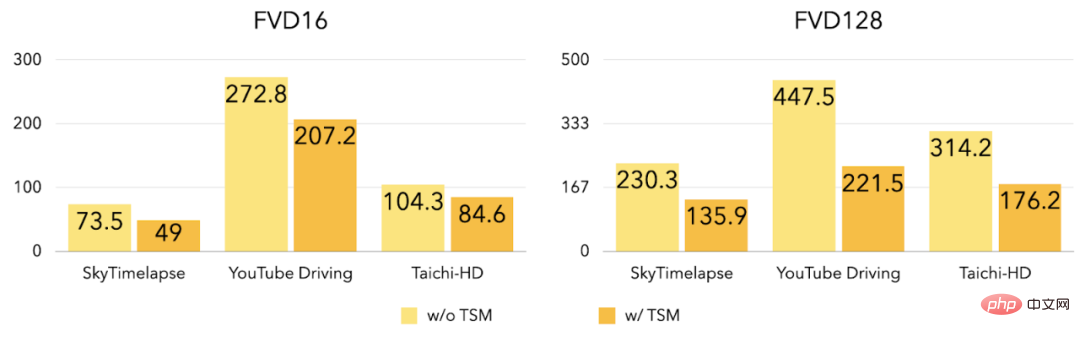

실험에 따르면 TSM 도입 후 세 가지 데이터 세트의 FVD16 및 FVD128이 크게 감소했습니다.

3. 무제한 비디오 생성

이전에 도입된 개선 사항은 주로 짧고 중간 길이의 비디오 생성에 중점을 두고 있으며, 새로운 작업에서는 고품질을 생성하는 방법을 추가로 탐색합니다. 동영상 모든 길이의 동영상(무제한 포함). 이전 작업(StyleGAN-V)은 무한히 긴 영상을 생성할 수 있지만 영상에는 매우 명백한 주기적인 지터가 포함되어 있습니다. 차량이 앞으로 이동하고, 횡단보도는 원래 정상적으로 뒤로 이동하다가 갑자기 앞으로 이동하도록 변경되었습니다. 이 연구에서는 모션 기능(모션 임베딩)의 불연속성이 이러한 지터 현상을 유발한다는 것을 발견했습니다.

이전 작업에서는 선형 보간을 사용하여 동작 특징을 계산했습니다. 그러나 선형 보간은 다음 그림과 같이 1차 불연속으로 이어집니다(왼쪽은 보간 다이어그램, 오른쪽은 T-SNE 특징 시각화). :

이전 작업에서는 선형 보간을 사용하여 동작 특징을 계산했습니다. 그러나 선형 보간은 다음 그림과 같이 1차 불연속으로 이어집니다(왼쪽은 보간 다이어그램, 오른쪽은 T-SNE 특징 시각화). :

본 연구에서는 B-spline 제어(B-Spline 기반 모션 임베딩)의 모션 특성을 제안합니다. B-스플라인을 통한 보간은 그림과 같이 시간에 대해 보다 부드러운 동작 특징을 얻을 수 있습니다(왼쪽은 보간 다이어그램, 오른쪽은 T-SNE 특징 시각화).

B-spline 제어의 동작 특성을 도입하여 지터 현상을 완화한 신작:

그림과 같이 StyleGAN-V로 생성한 영상에서 가로등과 땅이 갑자기 이동 방향을 바꿀 것입니다. 신작으로 제작된 영상에서는 움직임의 방향이 일관되고 자연스럽다.

동시에 신작에서는 주기적인 반복 콘텐츠의 발생을 더욱 완화하기 위해 액션 기능에 대한 낮은 순위 제약도 제안합니다.

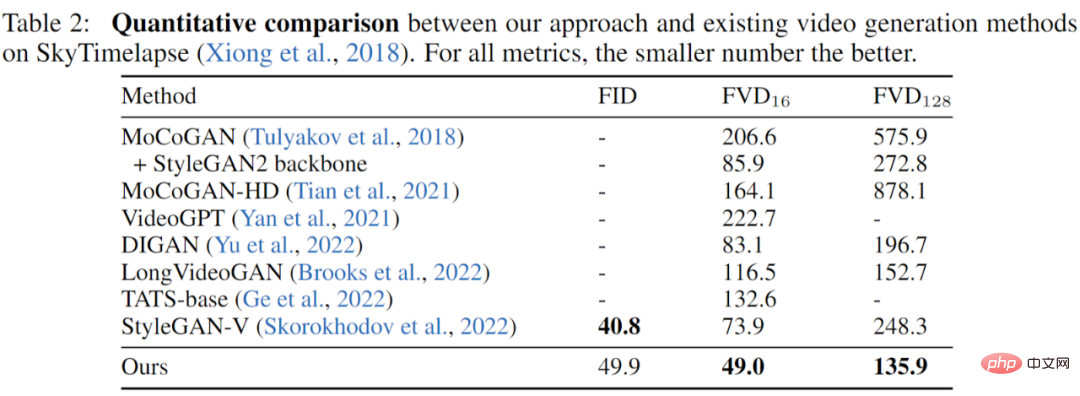

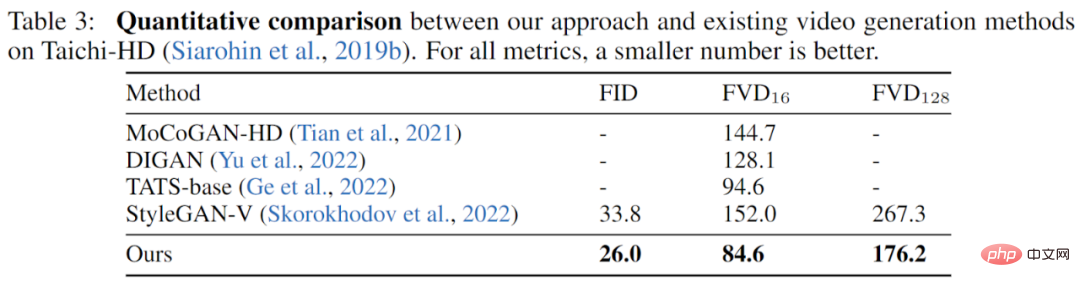

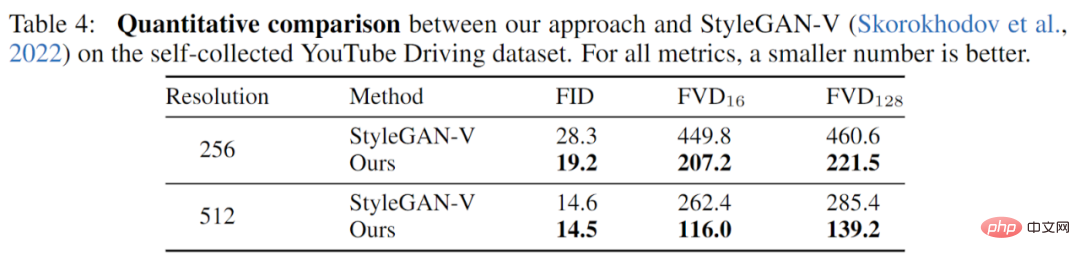

이 작품은 세 가지 데이터 세트(YouTube Driving, Timelapse, Taichi-HD)를 대상으로 완전히 실험되었으며 이전 작품과 완전히 비교된 결과, 화질(FID)에서 새 작품의 성능이 더 나은 것으로 나타났습니다. 비디오 품질(FVD)이 완전히 향상되었습니다.

SkyTimelapse 실험 결과:

Taichi-HD 실험 결과:

YouTube 운전 실험 결과:

신작은 GAN 모델을 기반으로 한 새로운 비디오 세대 벤치마크를 제안하며 다양한 규모의 타이밍 관계에서 시작하여 참신하고 효과적인 개선을 제안합니다. 여러 데이터세트에 대한 실험을 통해 새 작업이 이전 작업을 크게 뛰어넘는 비디오 품질을 성공적으로 달성한 것으로 나타났습니다.

위 내용은 GAN을 기반으로 부드러운 비디오가 생성되며 그 효과는 매우 인상적입니다. 텍스처 접착 없음, 지터 감소의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!