훈련받지 않은 일을 할 수 있기 때문에 대규모 언어 모델은 일종의 마법을 갖고 있는 것처럼 보이며 따라서 언론과 연구자들로부터 과대광고와 관심의 초점이 되었습니다.

대형 언어 모델을 확장할 때 작은 모델에서는 사용할 수 없는 몇 가지 새로운 기능이 가끔 등장합니다. "창의성"과 유사한 이러한 속성을 "창발" 기능이라고 하며, 이는 일반 인공 지능을 향한 한 단계를 나타냅니다.

현재 Google, Stanford, Deepmind 및 North Carolina 대학의 연구원들은 대규모 언어 모델에서 "신발" 능력을 탐구하고 있습니다.

Decoder 프롬프트 DALL-E

NLP(자연어 처리)는 대량의 텍스트 데이터에 대해 훈련된 언어 모델에 의해 혁명을 일으켰습니다. 언어 모델을 확장하면 다양한 다운스트림 NLP 작업에서 성능과 샘플 효율성이 향상되는 경우가 많습니다.

많은 경우 작은 모델의 성능 추세를 추론하여 대규모 언어 모델의 성능을 예측할 수 있습니다. 예를 들어, 언어 모델의 복잡성에 대한 규모의 영향은 7차수 이상에서 입증되었습니다.

그러나 일부 다른 작업의 성능은 예측 가능한 방식으로 향상되지 않았습니다.

예를 들어, GPT-3 논문에서는 여러 자리 덧셈을 수행하는 언어 모델의 능력이 100M에서 13B 매개변수의 모델에 대해 평평한 스케일링 곡선을 가지고 있음을 보여줍니다. 이는 대략 무작위이지만 노드에서 성능 점프를 유발합니다. .

NLP 연구에서 언어 모델의 사용이 증가함에 따라 예기치 않게 발생할 수 있는 이러한 기능을 더 잘 이해하는 것이 중요합니다.

Machine Learning Research(TMLR)에 최근 발표된 "Emergent Power of Large Language Models" 논문에서 연구자들은 확장 언어 모델이 생성하는 "창발" 능력의 수십 가지 예를 보여주었습니다.

이 "신생" 기능의 존재는 추가 확장이 언어 모델 기능의 범위를 더욱 확장할 수 있는지에 대한 의문을 제기합니다.

특정한 힌트와 미세 조정 방법은 더 큰 모델에서만 개선을 가져올 수 있습니다.

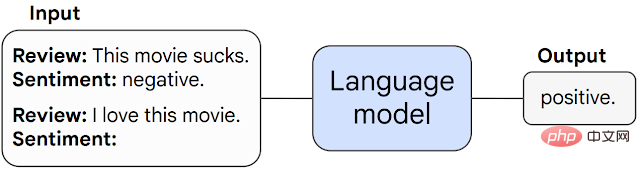

먼저 프롬프트 작업 능력에서 발생할 수 있는 "창출"에 대해 논의합니다.

이러한 유형의 작업에서는 사전 훈련된 언어 모델이 다음 단어 예측 작업을 수행하도록 유도되고 응답을 완료하여 작업을 수행합니다.

추가 미세 조정 없이도 언어 모델은 훈련 중에 볼 수 없는 작업을 수행할 수 있는 경우가 많습니다.

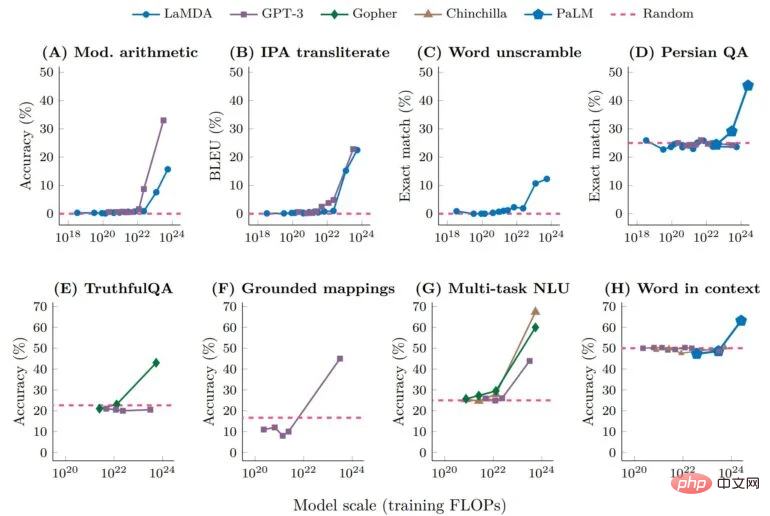

작업이 특정 규모 임계값에서 무작위 성능에서 무작위 성능 이상으로 예기치 않게 급등하는 경우 이를 "긴급" 작업이라고 부릅니다.

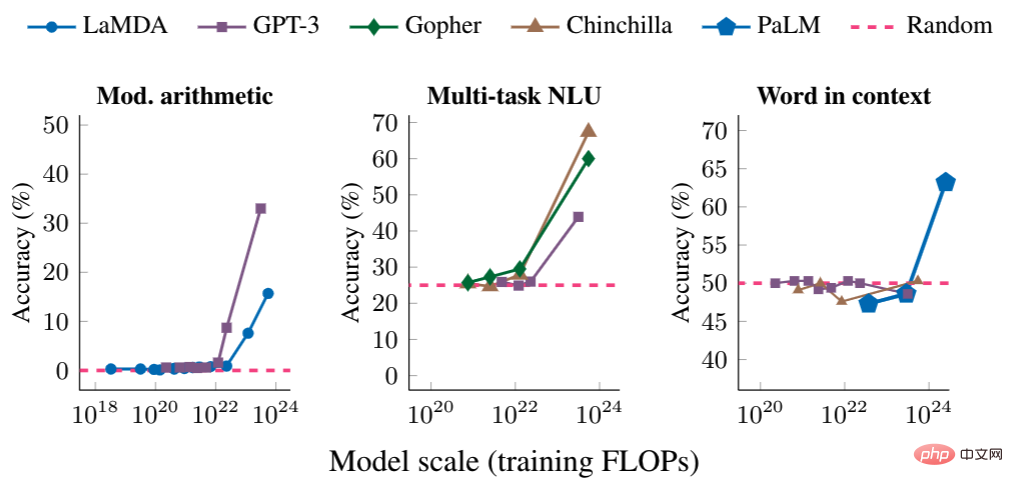

아래에서는 다단계 산술, 대학 수준 시험 응시, 단어의 의도된 의미 파악 등 "긴급" 성능을 갖춘 프롬프트 작업의 세 가지 예를 보여줍니다.

각 경우에 언어 모델은 성능이 급상승하는 특정 임계값에 도달할 때까지 모델 크기에 거의 의존하지 않고 성능이 좋지 않습니다.

충분한 규모의 모델의 경우 이러한 작업에 대한 성능은 무작위가 아닙니다. 예를 들어 산술 및 다중 작업 NLU 작업은 10^22를 초과하는 FLOP(초당 부동 소수점 연산)로 학습하고, 컨텍스트 학습 FLOP 작업에 포함된 단어 중 10의 24승을 초과하는 단어입니다.

두 번째 유형의 "긴급" 기능에는 언어 모델 기능을 향상시키는 프롬프트 전략이 포함됩니다.

프롬프트 전략은 다양한 작업에 적용할 수 있는 광범위한 프롬프트 패러다임입니다. 작은 모델에 실패하면 "긴급"으로 간주되며 충분히 큰 모델에서만 사용할 수 있습니다.

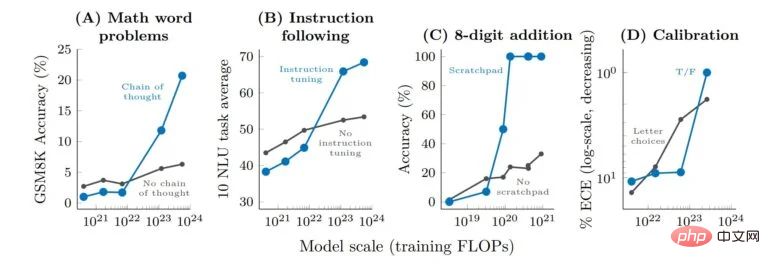

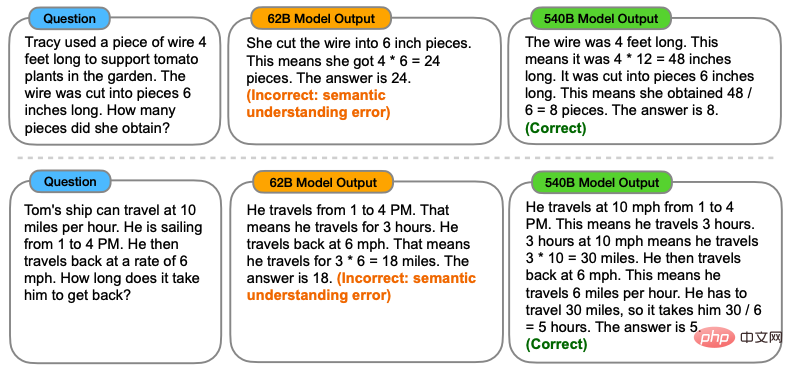

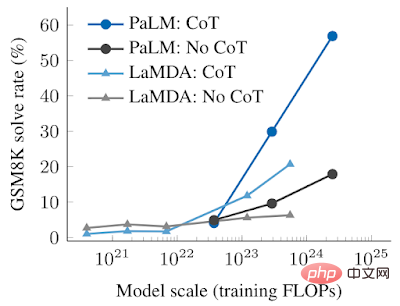

사고 연쇄 프롬프트는 프롬프트 모델이 최종 답변을 제공하기 전에 일련의 중간 단계를 생성하는 "긴급" 프롬프트 전략의 전형적인 예입니다.

사고 체인 프롬프트를 사용하면 언어 모델이 다단계 수학 단어 문제와 같은 복잡한 추론이 필요한 작업을 수행할 수 있습니다.

모델이 명시적인 훈련 없이도 사고 사슬 추론 능력을 습득할 수 있다는 점은 언급할 가치가 있습니다. 아래 그림은 사고 사슬 프롬프트의 예를 보여줍니다.

사고 연쇄 프롬프트의 실증 결과는 다음과 같습니다.

소형 모델의 경우 Thought Chain 프롬프트를 적용해도 까다로운 수학 단어 문제 벤치마크인 GSM8K에 적용할 때와 같이 표준 프롬프트보다 성능이 뛰어나지 않습니다.

그러나 대형 모델의 경우 Thought Chain 프롬프트는 GSM8K에서 57%의 해상도에 도달하여 테스트 성능이 크게 향상되었습니다.

그렇다면 "창발" 능력을 연구하는 의미는 무엇일까요?

대규모 언어 모델에서 "신생" 기능을 식별하는 것은 이 현상과 미래 모델 기능에 대한 잠재적 영향을 이해하는 첫 번째 단계입니다.

예를 들어, "신생" 퓨샷 힌트 기능과 전략은 사전 훈련에서 명시적으로 인코딩되지 않기 때문에 연구자는 현재 언어 모델의 퓨샷 힌트 기능의 전체 범위를 알지 못할 수도 있습니다.

또한, 추가 확장이 잠재적으로 더 큰 모델에 "신생" 기능을 제공할지 여부에 대한 질문도 매우 중요합니다.

연구원들은 이러한 문제가 아직 알려지지 않았다고 말합니다.

그러나 NLP 분야가 계속 발전함에 따라 스케일링으로 생성되는 "창발" 기능을 포함하여 언어 모델의 동작을 분석하고 이해하는 것이 매우 중요합니다.

위 내용은 매개 변수가 약간 개선되고 성능 지수가 폭발합니다! 구글: 대규모 언어 모델은 '신비한 기술'을 숨긴다의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!