ChatGPT의 지속적인 인기로 인해 이미 주요 기술 기업이 불안해졌습니다.

지난 주에 Meta는 새로운 대형 모델 시리즈인 LLaMA(대형 언어 모델 Meta AI)을 "오픈 소스"했으며 매개변수는 70억에서 650억까지입니다. 범위. LLaMA는 이전에 출시된 많은 대형 모델보다 매개변수가 적지만 성능이 우수하기 때문에 출시 당시 많은 연구자들이 흥분했습니다.

예를 들어, 130억 매개변수 LLaMA 모델은 "대부분의 벤치마크에서" 1,750억 매개변수 GPT-3보다 성능이 뛰어나고 단일 V100 GPU에서 실행될 수 있으며 가장 큰 650억 매개변수 LLaMA 모델은 Google의 Chinchilla와 비슷합니다. -70B 및 PaLM-540B.

매개변수 수를 줄이는 것은 일반 연구자나 상업단체에게는 좋은 일이지만, LLaMA가 과연 논문에서 말하는 대로 성능을 발휘할까요? 현재 ChatGPT와 비교하면 LLaMA는 거의 경쟁할 수 없나요? 이러한 질문에 답하기 위해 일부 연구자들은 이 모델을 테스트했습니다.

일부 회사에서는 이미 LLaMA의 단점을 보완하려고 노력하고 있으며, RLHF와 같은 훈련 방법을 추가하여 LLaMA의 성능을 향상시킬 수 있는지 확인하고 싶어합니다.

이 리뷰는 @Enryu라는 미디엄 작성자가 작성했습니다. 농담 해석, 제로샷 분류, 코드 생성이라는 세 가지 까다로운 작업에서 LLaMA와 ChatGPT의 성능을 비교합니다. 관련 블로그 포스팅은 "Mini-post: LLaMA를 먼저 살펴보세요" 입니다.

저자는 RTX 3090/RTX 4090에서 LLaMA 7B/13B 버전, 단일 A100에서 33B 버전을 실행하고 있습니다.

ChatGPT와 달리 다른 모델은 지침 미세 조정을 기반으로 하지 않으므로 프롬프트 구조가 다릅니다.

농담 설명

이것은 Google의 원본 PaLM 논문에서 시연된 사용 사례입니다. 농담이 주어지면 모델이 그것이 왜 재미있는지 설명하게 하세요. 이 임무에는 세계 지식과 몇 가지 기본 논리의 조합이 필요합니다. PaLM 이전의 모든 모델은 이를 수행할 수 없었습니다. 저자는 PaLM 논문에서 몇 가지 예시를 추출하고 LLaMA-7B, LLaMA-13B, LLaMA-33B의 성능을 ChatGPT와 비교했습니다.

보시다시피 결과는 끔찍합니다. 이 모델은 약간의 웃음을 자아내지만 실제로는 이해하지 못합니다. 단지 관련 텍스트 스트림을 무작위로 생성할 뿐입니다. ChatGPT는 LLaMA-33B만큼 성능이 좋지 않지만(다른 여러 모델은 더 나쁨) 다른 전략을 따릅니다. 즉, 답변 중 적어도 일부가 정확하기를 바라면서 많은 텍스트를 생성합니다(하지만 대부분은 분명히 아니요입니다). , 시험 중 질문에 답하는 모든 사람의 전략과 매우 유사합니까?

그러나 ChatGPT는 적어도 Schmidthuber에 대한 농담을 얻었습니다. 그러나 전반적으로 제로 샘플 농담 해석 작업에서 이러한 모델의 성능은 PaLM과는 거리가 멀습니다(PaLM의 예를 신중하게 선택하지 않는 한).

제로샷 분류

저자가 고려한 두 번째 작업은 더 어려운 작업인 클릭베이트 분류입니다. 인간조차도 클릭베이트가 무엇인지에 대해 동의할 수 없기 때문에 저자는 프롬프트에서 이러한 모델에 대한 몇 가지 예를 제공합니다(실제로는 제로 샘플이 아닌 작은 샘플). 다음은 LLaMa의 프롬프트입니다.

I will tell whether the following news titles are clickbait: 1) The WORST care homes in England: Interactive map reveals the lowest-rated 2,530 residences - so is there one near you? Clickbait: yes 2) Netflix's top 10 most-watched movies of all time Clickbait: yes 3) Peering Through the Fog of Inflation Clickbait: no 4) You’ll never believe which TV cook this cheeky chap grew up to be Clickbait: yes

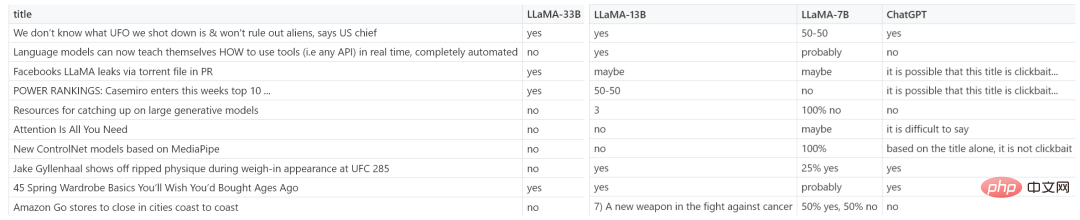

아래 그림은 LLaMA-7B, LLaMA-13B, LLaMA-33B 및 ChatGPT의 더 많은 예제 결과를 보여줍니다.

很明显,赢家为 LLaMA-33B,它是唯一一个能够遵循所有请求格式(yes/no)的模型,并且预测合理。ChatGPT 也还可以,但有些预测不太合理,格式也有错误。较小的模型(7B/13B)不适用于该任务。

代码生成

虽然 LLM 擅长人文学科,但在 STEM 学科上表现糟糕。LLaMA 虽然有基准测试结果,但作者在代码生成领域尝试了一些特别的东西,即将人类语言零样本地转换为 SQL 查询。这并不是很实用,在现实生活中直接编写查询会更有效率。这里只作为代码生成任务的一个示例。

在 prompt 中,作者提供表模式(table schema)以及想要实现的目标,要求模型给出 SQL 查询。如下为一些随机示例,老实说,ChatGPT 看起来效果更好。

-- We have a table `events` with columns `event_id`, `timestamp`, `user_id`, `rpc_method`. -- We want to count how many users issued request "Login" over the last week. -- SQL query for this is: -- 7b SELECT count (*) FROM events WHERE user_id IN (SELECT user_id FROM events WHERE timestamp >= NOW () - INTERVAL 7 DAY) AND rpc_method = 'Login'; -- 13b SELECT COUNT (*) FROM events WHERE rpc_method = "Login" AND UNIX_TIMESTAMP (timestamp) >= UNIX_TIMESTAMP (CURRENT_DATE - INTERVAL 7 DAY) -- 33b SELECT user_id, COUNT (DISTINCT user_id) AS total FROM events WHERE timestamp BETWEEN TIMESTAMP '2013-08-14 00:00:00' AND TIMESTAMP '2013-08-21 00:00:00' AND rpc_method = 'Login' GROUP BY user_id -- ChatGPT SELECT COUNT (DISTINCT user_id) FROM events WHERE rpc_method = 'Login' AND timestamp >= DATE_SUB (NOW (), INTERVAL 1 WEEK);

从测试结果来看,LLaMA 在一些任务上表现还不错,但在另一些任务上和 ChatGPT 还有一些差距。如果能像 ChatGPT 一样加入一些「训练秘籍」,效果会不会大幅提升?

虽然 LLaMA 发布之初就得到众多研究者的青睐,但是少了 RLHF 的加持,从上述评测结果来看,还是差点意思。

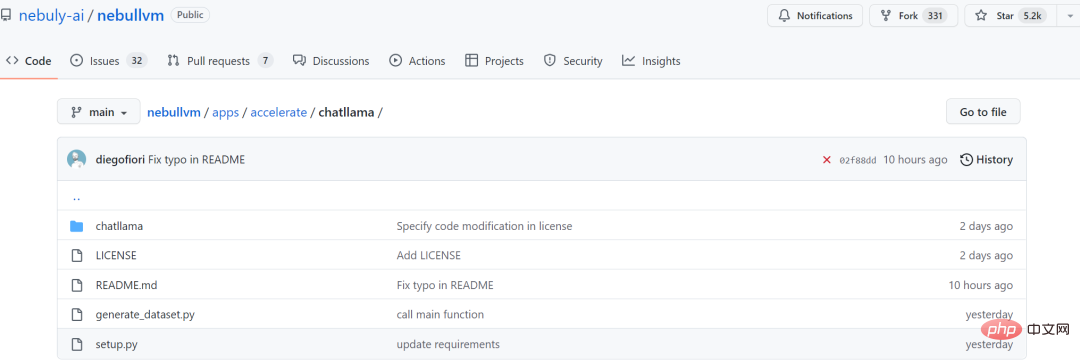

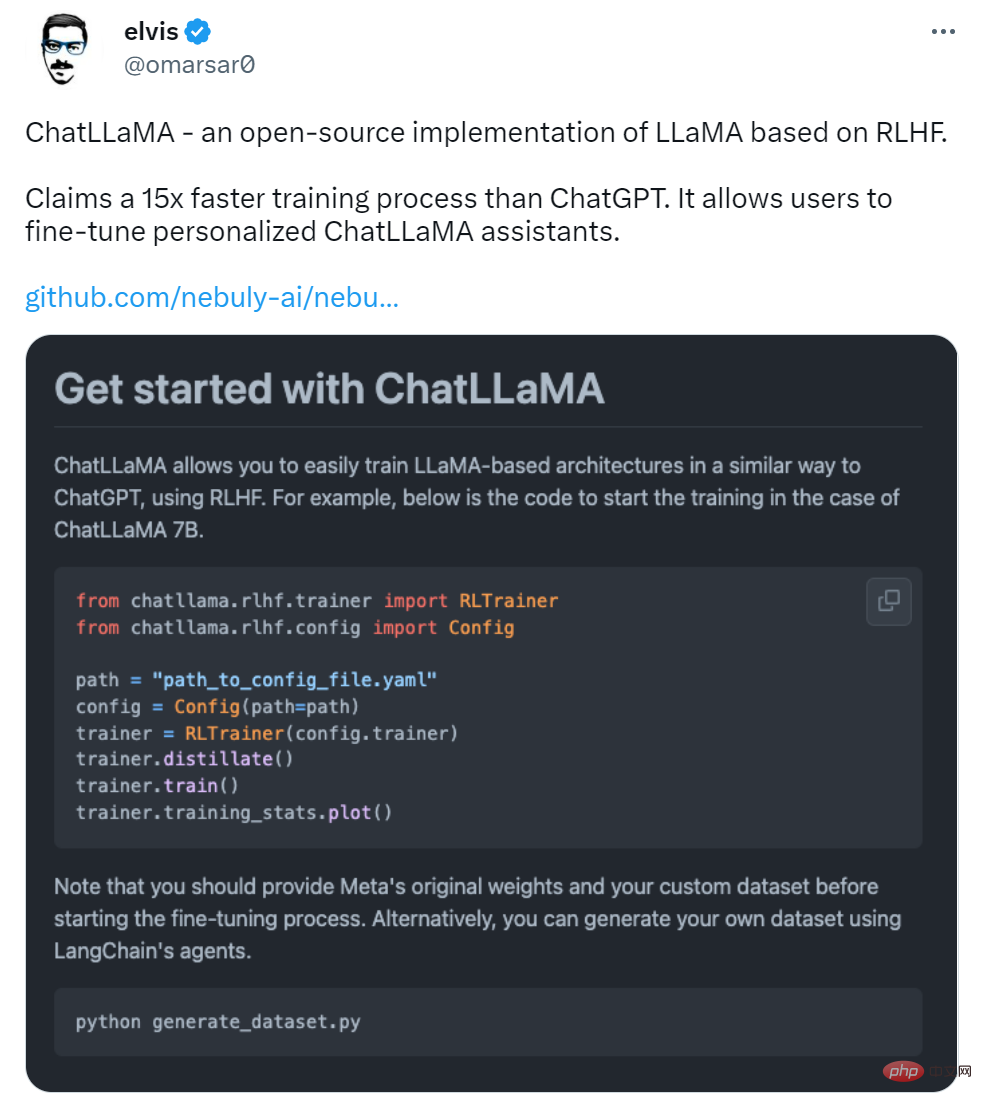

在 LLaMA 发布三天后,初创公司 Nebuly AI 开源了 RLHF 版 LLaMA(ChatLLaMA)的训练方法。它的训练过程类似 ChatGPT,该项目允许基于预训练的 LLaMA 模型构建 ChatGPT 形式的服务。项目上线刚刚 2 天,狂揽 5.2K 星。

项目地址:https://github.com/nebuly-ai/nebullvm/tree/main/apps/accelerate/chatllama

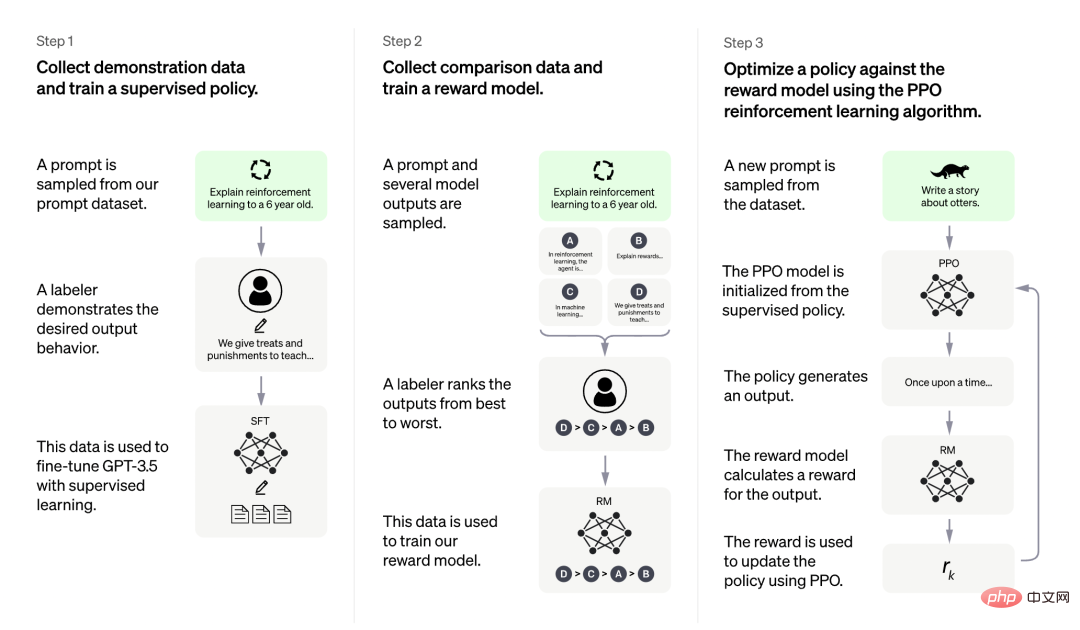

ChatLLaMA 训练过程算法实现主打比 ChatGPT 训练更快、更便宜,我们可以从以下四点得到验证:

图源:https://openai.com/blog/chatgpt

更是有研究者表示,ChatLLaMA 比 ChatGPT 训练速度最高快 15 倍。

不过有人对这一说法提出质疑,认为该项目没有给出准确的衡量标准。

项目刚刚上线 2 天,还处于早期阶段,用户可以通过以下添加项进一步扩展:

Nebuly AI 希望更多人加入进来,创造更高效和开放的 ChatGPT 类助手。

该如何使用呢?首先是使用 pip 安装软件包:

pip install chatllama-py

然后是克隆 LLaMA 模型:

git clone https://github.com/facebookresearch/llama.gitcd llama pip install -r requirements.txt pip install -e .

一切准备就绪后,就可以运行了,项目中介绍了 ChatLLaMA 7B 的训练示例,感兴趣的小伙伴可以查看原项目。

위 내용은 Meta의 오픈 소스 ChatGPT 대체품은 사용하기 쉽나요? 테스트 결과 및 수정 방법 공개, 2일 만에 별 52만개 돌파의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!