옵티마이저는 최적화 알고리즘이며 신경망 훈련에서 핵심적인 역할을 합니다. 최근 몇 년 동안 연구자들은 다수의 수동 최적화 프로그램을 도입했으며 그 중 대부분은 적응형 최적화 프로그램입니다. Adam 및 Adafactor 최적화 프로그램은 특히 언어, 비전 및 다중 양식 분야에서 여전히 신경망 훈련의 주류를 차지하고 있습니다.

최적화 프로그램을 수동으로 도입하는 것 외에도 프로그램이 자동으로 최적화 알고리즘을 검색하는 것도 또 다른 방향입니다. 이전에 누군가가 신경망을 훈련시켜 옵티마이저를 찾아내는 L2O(Learning to Optimization)를 제안한 바 있습니다. 그러나 이러한 블랙박스 최적화 프로그램은 일반적으로 제한된 수의 작은 작업에 대해 교육을 받고 대규모 모델로 일반화하는 데 어려움을 겪습니다.

다른 사람들은 강화 학습이나 몬테카를로 샘플링을 적용하여 새로운 최적화 도구를 발견하는 등 다른 접근 방식을 시도했습니다. 그러나 검색을 단순화하기 위해 이러한 방법은 일반적으로 검색 공간을 제한하므로 다른 최적화 프로그램을 발견할 가능성이 제한됩니다. 따라서 현재의 방식은 아직 SOTA 수준에 도달하지 못했습니다.

최근에는 작업을 평가할 때 기계 학습 파이프라인의 모든 구성 요소를 검색하려고 시도하는 AutoML-Zero를 언급할 가치가 있는데, 이는 최적화 도구를 찾는 데 매우 유용합니다.

본 기사에서 Google과 UCLA의 연구진은 프로그램 검색을 통해 심층 신경망 훈련을 위한 최적화 알고리즘을 발견하는 방법을 제안했고, 그 과정에서 Lion(EvoL ved S)을 발견했습니다. ign Momentum) 옵티마이저. 이 목표를 달성하려면 두 가지 과제에 직면하게 됩니다. 첫째, 무한히 희박한 프로그램 공간에서 고품질 알고리즘을 찾는 것이고, 둘째는 작은 작업부터 대규모 SOTA 작업까지 일반화할 수 있는 알고리즘을 선택하는 것입니다. 이러한 문제를 해결하기 위해 연구에서는 핫 스타트 및 재시작을 포함한 진화적 검색, 추상 실행, 퍼널 선택 및 프로그램 단순화를 포함한 다양한 기술을 사용합니다.

AdamW 및 다양한 적응형 최적화 프로그램(1차 및 2차 순간을 모두 저장해야 함)과 비교하여 Lion은 추진력만 필요하고 기호 연산을 활용하여 업데이트를 계산하며 추가로 메모리 사용량은 반으로 줄었다. 이는 대규모 모델이나 대규모 배치를 교육할 때 유용합니다. 예를 들어 AdamW는 이미지 크기 224 및 배치 크기 4096으로 ViT-B/16을 교육하려면 TPU V4가 16개 이상 필요한 반면 Lion은 8개만 필요합니다. 또 다른 실질적인 이점은 단순성으로 인해 Lion이 실험에서 더 빠른 런타임(단계/초)을 갖는다는 것입니다. 작업, 코드베이스 및 하드웨어에 따라 일반적으로 AdamW 및 Adafactor보다 2-15% 더 빠릅니다.

논문의 첫 번째 저자인 Xiangning Chen은 다음과 같이 말했습니다. 우리의 상징적 프로그램 검색은 운동량만 추적하는 효과적인 최적화 프로그램인 Lion을 찾았습니다. Adam과 비교하여 88.3%의 제로 샘플과 91.1%의 미세 조정 ImageNet 정확도를 달성했으며 최대 5x(ViT 대비), 2.3x(확산 모델 대비) 및 2x(LM 대비) 학습을 달성했습니다. 능률.

Lion은 다양한 모델(Transformer, MLP, ResNet, U-Net 및 Hybrid)과 작업(이미지 분류, 시각적 언어 대조 학습, 확산, 언어 모델링 및 미세 조정)에서 뛰어난 성능을 입증했습니다. ) 성능. 본 연구에서는 BASIC에서 Adafactor를 Lion으로 대체함으로써 ImageNet에서 제로샷 정확도 88.3%, 미세 조정 정확도 91.1%를 달성했으며(Pham et al., 2021), 이전 SOTA 결과를 각각 2%와 0.1 초과했습니다. .%.

또한 Lion은 JFT의 사전 훈련 계산을 최대 5배 줄이고 확산 모델의 훈련 효율성을 2.3배 향상하며 더 나은 FID 점수를 달성하고 언어 모델링 개선을 제공합니다. 비슷하거나 더 나은 성능, 비용 절감 계산 노력이 최대 2배 증가합니다.

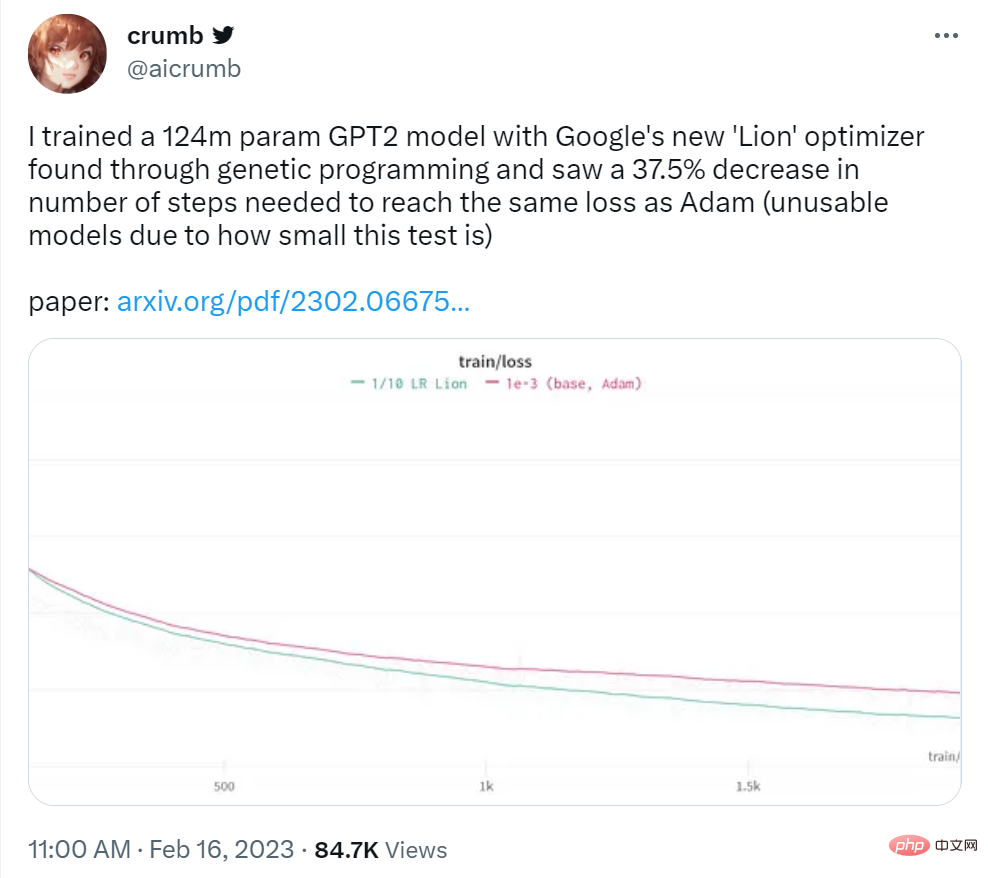

트위터 사용자 Crumb은 다음과 같이 말했습니다. 그는 Google의 Lion 옵티마이저를 사용하여 124M 매개변수 GPT2 모델을 훈련한 결과 Adam과 동일한 손실을 달성하는 데 필요한 단계 수가 37.5% 감소했다는 사실을 발견했습니다.

이미지 출처: https://twitter.com/aicrumb/status/1626053855329898496

프로그램 형태의 기호는 다음을 나타냅니다. 다음과 같은 장점이 있습니다. (1) 알고리즘은 프로그램으로 실행되어야 한다는 사실과 일치합니다. (2) 신경망과 같은 매개변수 모델과 비교하여 프로그램과 같은 기호 표현은 분석, 이해 및 새로운 작업으로의 전환이 더 쉽습니다. ; (3) 프로그램 길이를 사용할 수 있습니다. 다양한 프로그램의 복잡성을 추정하면 더 간단하고 종종 더 다양한 프로그램을 선택할 수 있습니다. 이 작업은 심층 신경망 훈련을 위한 최적화에 중점을 두지만 이 접근 방식은 일반적으로 다른 작업에도 적용 가능합니다 .

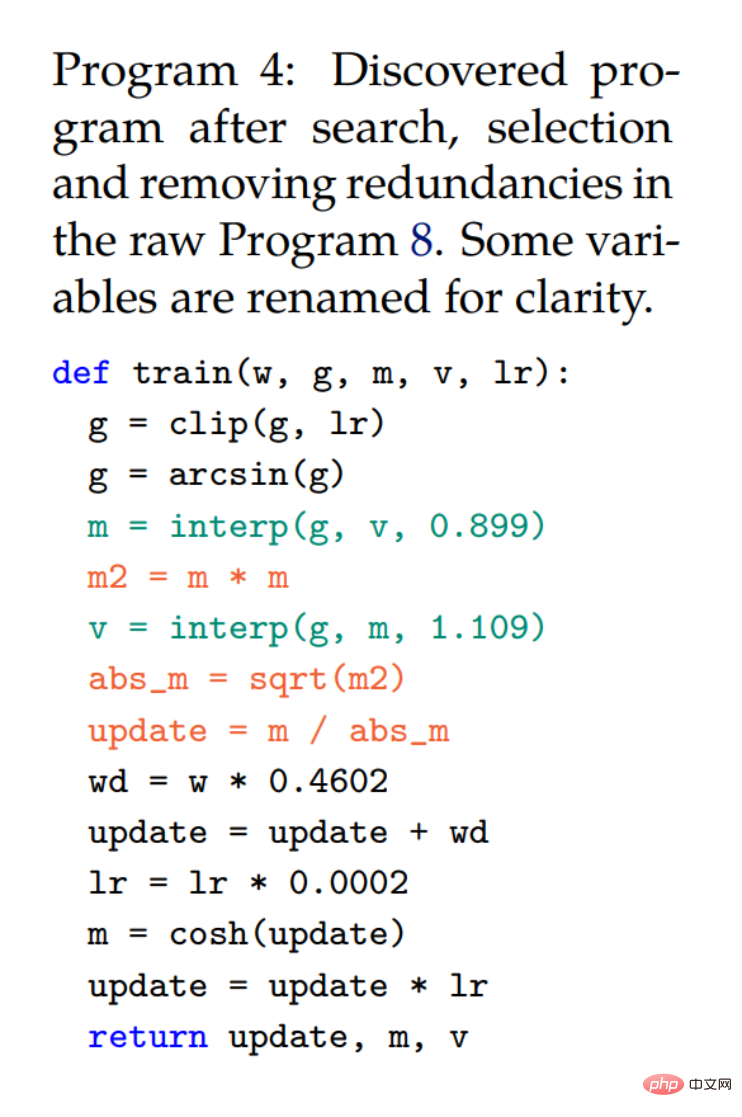

아래 그림에서 프로그램 2의 단순화된 코드 조각은 AdamW와 동일한 서명을 사용하여 발견된 알고리즘이 더 작거나 동일한 메모리 공간을 갖도록 보장합니다. AdamW의 예시 표현은 프로그램 3에 제공됩니다.

이 연구에서는 무한하고 희박한 검색 공간으로 인해 발생하는 문제를 해결하기 위해 다음 기술을 채택했습니다. 첫 번째는 단순하고 확장 가능하며 많은 AutoML 검색 작업에 성공하기 때문에 정규화를 적용하는 것입니다. 두 번째는 프로그램 공간의 중복성을 단순화하고 마지막으로 검색 비용을 줄이기 위해 이 연구에서는 모델 크기를 줄이고 비용을 절감하기 위해 대상 작업에 따른 학습 예제 수 및 목표 작업에서 벗어나는 단계 수입니다.

왼쪽: 다섯 가지 진화 탐색 실험의 평균과 표준 오류가 표시됩니다. 오른쪽: 검색이 진행됨에 따라 중복 문 비율과 캐시 적중률이 모두 증가합니다.

연구원들은 Lion이 검색 및 메타 검증에서 단순성, 높은 메모리 효율성, 강력한 성능을 갖추고 있다고 말했습니다.

파생

검색 및 퍼널 선택 프로세스를 통해 프로그램 4가 탄생했는데, 이는 원래 프로그램 8(부록)에서 중복된 설명을 자동으로 제거하여 얻은 것입니다. 연구원은 프로그램 1에서 최종 알고리즘(Lion)을 더욱 단순화하여 획득했습니다. 단순화 과정에서 프로그램 4에서 몇 가지 불필요한 요소가 제거되었습니다. 여기서 m은 다음 반복(라인 3)에서 재할당되므로 cosh 함수가 제거됩니다. arcsin 및 클립을 사용하는 설명도 연구원들이 이를 사용하지 않고도 품질 저하를 관찰하지 않았기 때문에 제거되었습니다. 세 개의 빨간색 진술은 기호 함수로 변환됩니다.

프로그램 4에서 m과 v가 함께 사용되지만 v는 운동량이 업데이트되는 방식만 변경하며(상수 ∼0.9 및 ∼1.1을 갖는 두 개의 보간 함수는 ∼0.99를 갖는 하나의 함수와 동일함) 사용할 필요가 없습니다. 별도로 추적합니다. 바이어스 수정은 방향을 변경하지 않으므로 더 이상 필요하지 않습니다.

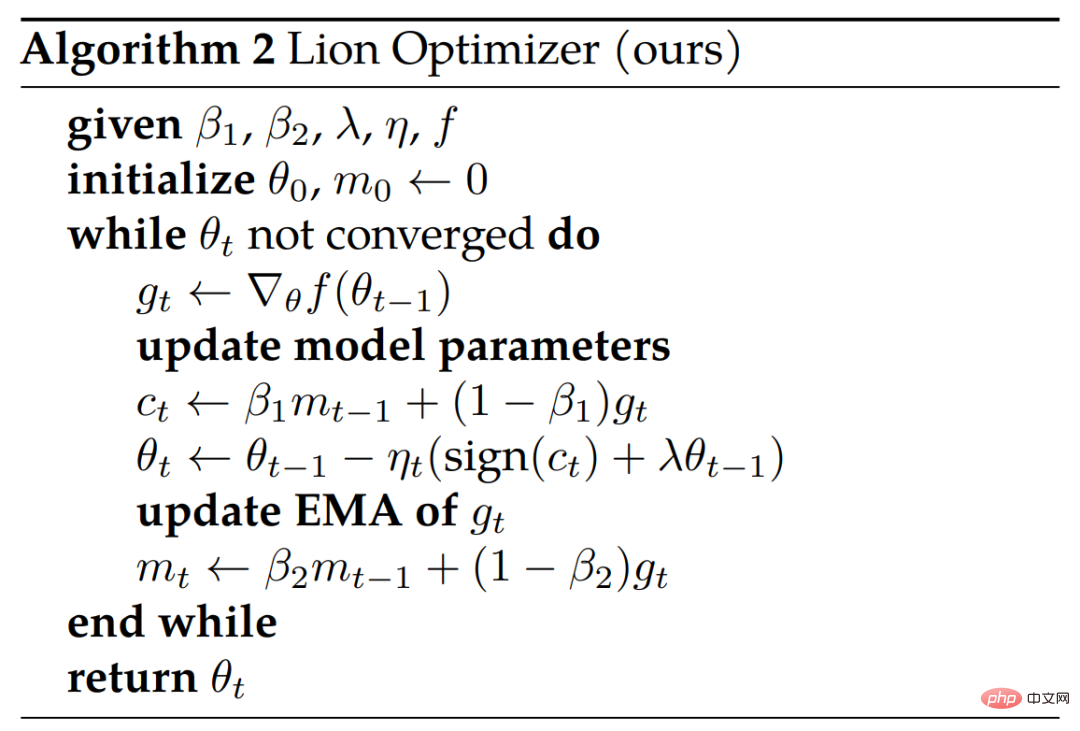

아래 알고리즘 2는 의사 코드를 보여줍니다.

분석

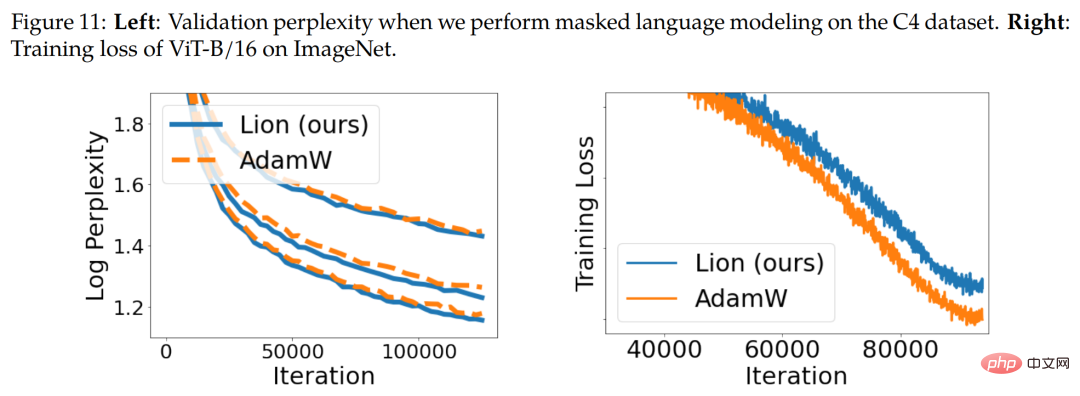

기호 업데이트 및 정규화. Lion 알고리즘은 다양한 적응형 최적화 프로그램과 원칙적으로 다른 기호 연산을 통해 모든 차원에서 균일한 크기의 업데이트를 생성합니다. 직관적으로 기호 연산은 업데이트에 노이즈를 추가하여 정규화의 한 형태로 작용하고 일반화를 돕습니다. 아래 그림 11(오른쪽)은 한 가지 증거를 보여줍니다.

모멘텀 추적. Lion에서 운동량을 추적하기 위한 기본 EMA 계수는 AdamW 및 운동량 SGD에서 일반적으로 사용되는 0.9와 비교하여 0.99(β_2)입니다. 이러한 EMA 요인 및 보간법 선택을 통해 Lion은 운동량 기울기의 10배 기록을 기억하는 것과 업데이트 시 현재 기울기에 더 많은 가중치를 부여하는 것 사이에서 균형을 유지할 수 있습니다.

초매개변수 및 배치 크기 선택. AdamW 및 Adafactor에 비해 Lion은 ϵ 및 인수분해 관련 매개변수가 필요하지 않기 때문에 더 간단하고 하이퍼 매개변수가 더 적습니다. Lion은 유사한 유효 가중치 감소 강도(lr * λ)를 달성하기 위해 더 작은 학습률, 즉 더 큰 분리된 가중치 감소가 필요합니다.

메모리 및 런타임 장점. Lion은 추진력만 절약하고 AdamW와 같은 널리 사용되는 적응형 최적화 프로그램보다 메모리 공간이 더 작습니다. 이는 대규모 모델을 교육하거나 대규모 배치로 작업할 때 유용합니다. 예를 들어 AdamW는 이미지 해상도 224, 배치 크기 4,096으로 ViT-B/16을 훈련하려면 최소 16개의 TPU V4 칩이 필요한 반면, Lion은 8개만 필요합니다(둘 다 bfloat16 추진력 사용).

실험 부분에서 연구원들은 다양한 벤치마크에서 Lion을 평가했는데, 주로 인기 있는 AdamW(또는 메모리가 병목 현상이 발생하는 경우 Adafactor)와 비교했습니다.

이미지 분류

연구원들은 이미지 분류 작업에 대한 다양한 데이터 세트와 아키텍처를 다루는 실험을 수행합니다. ImageNet에서 처음부터 훈련하는 것 외에도 두 개의 더 큰 성숙한 데이터 세트인 ImageNet-21K와 JFT에 대해서도 사전 훈련했습니다. 이미지 크기는 기본적으로 224입니다.

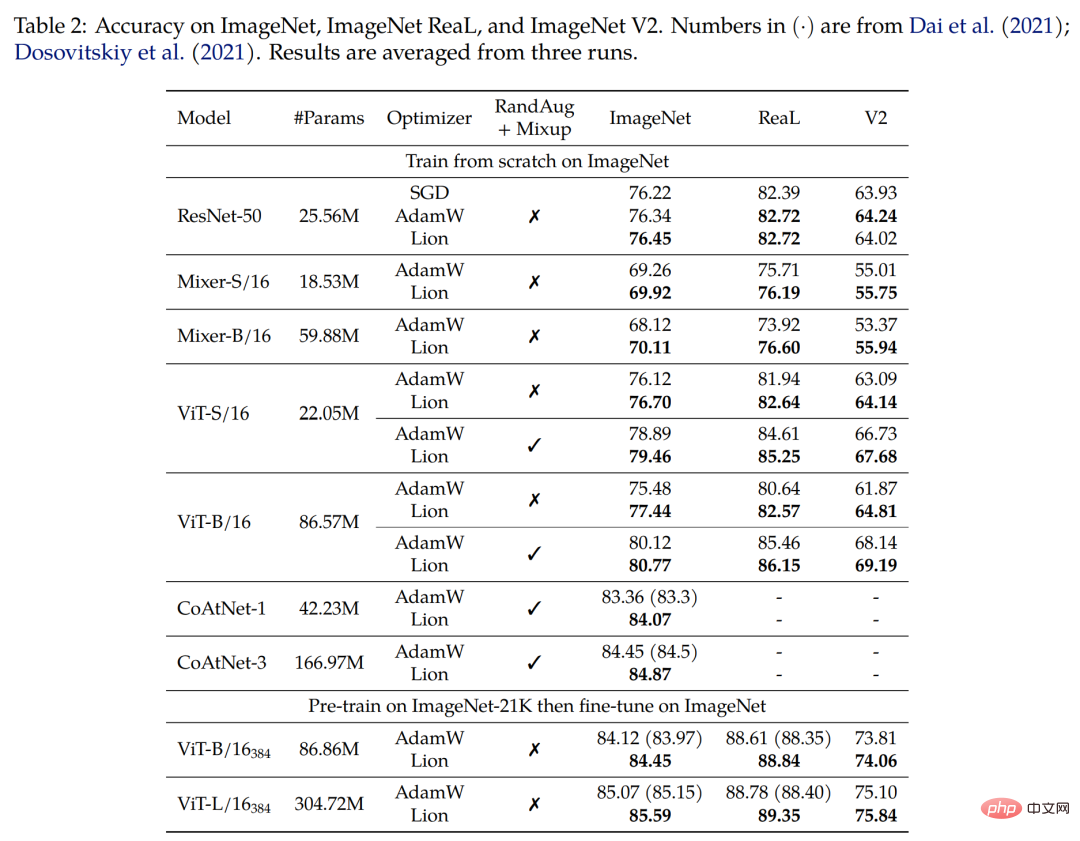

ImageNet에서 처음부터 처음으로 학습합니다. 연구원들은 배치 크기가 1,024인 90개의 에포크 동안 ResNet-50을 훈련시켰고, 다른 모델은 배치 크기가 4,096인 300개의 에포크 동안 훈련했습니다. 아래 표 2에서 볼 수 있듯이 Lion은 다양한 아키텍처에서 AdamW보다 훨씬 뛰어난 성능을 발휘합니다.

두 번째로 ImageNet-21K에서 사전 훈련합니다. 연구원들은 배치 크기가 4,096인 90세대 동안 ImageNet-21K에서 ViT-B/16 및 ViT-L/16을 사전 훈련했습니다. 아래 표 2는 훈련 세트가 10배 확대된 경우에도 Lion이 여전히 AdamW보다 성능이 우수하다는 것을 보여줍니다.

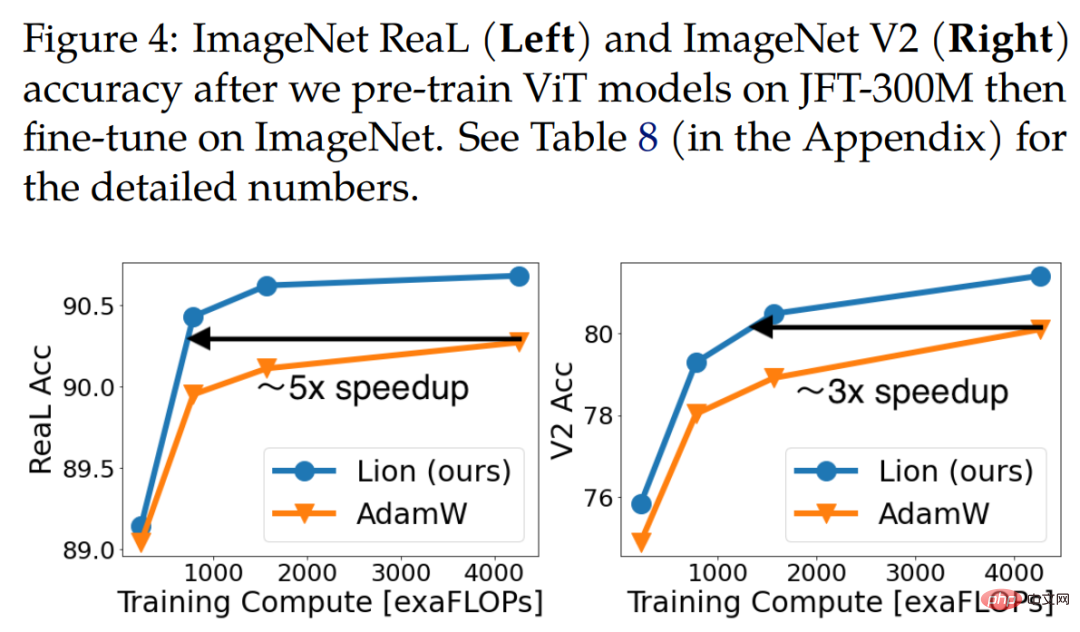

드디어 JFT 사전 훈련. 한계를 뛰어넘기 위해 연구자들은 JFT에 대해 수많은 실험을 수행합니다. 아래 그림 4는 JFT-300M의 다양한 사전 훈련 예산 하에서 세 가지 ViT 모델(ViT-B/16, ViT-L/16 및 ViT-H/14)의 정확도를 보여줍니다. Lion은 ViT-L/16이 ImageNet 및 ImageNet V2에서 훈련된 AdamW의 ViT-H/14 성능과 일치하도록 지원하지만 사전 훈련 비용은 3배 더 저렴합니다.

아래 표 3은 더 높은 해상도와 Polyak 평균화를 사용한 미세 조정 결과를 보여줍니다. 연구원들이 사용하는 ViT-L/16은 이전에 AdamW가 훈련한 ViT-H/14의 결과와 일치하지만 매개변수는 2배 더 적습니다. 사전 훈련 데이터 세트를 JFT-3B로 확장한 후 Lion에서 훈련된 ViT-g/14는 1.8배 더 적은 매개 변수로 이전 ViT-G/14 결과보다 성능이 뛰어납니다.

시각적 언어 대조 학습

이 섹션에서는 CLIP 스타일의 시각적 언어 대조 학습에 중점을 둡니다. 연구원들은 모든 매개변수를 처음부터 학습하는 대신 강력한 사전 훈련 모델을 사용하여 이미지 인코더를 초기화했습니다.

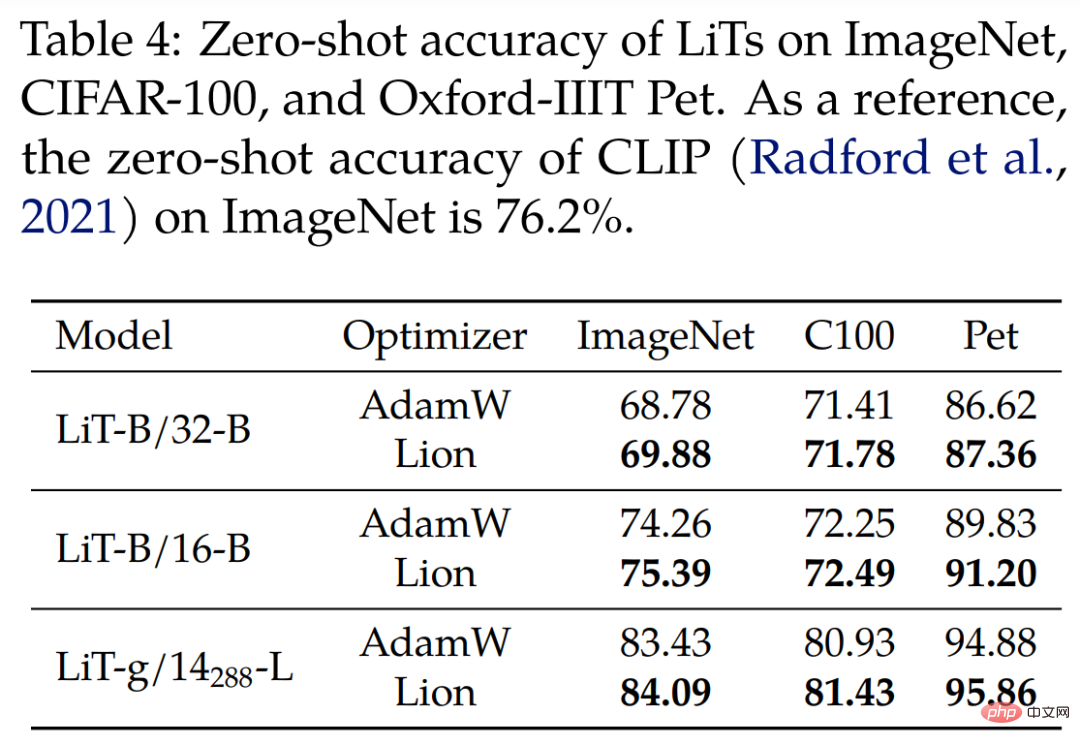

LiT(잠긴 이미지 텍스트 튜닝)의 경우 연구원들은 사전 훈련된 동일한 ViT를 사용하여 비교 방식으로 텍스트 인코더를 훈련함으로써 LiT에서 Lion과 AdamW를 비교했습니다. 아래 표 4는 3가지 모델 규모의 제로샷 이미지 분류 결과를 보여 주며 Lion은 AdamW에 비해 지속적인 개선을 보여줍니다.

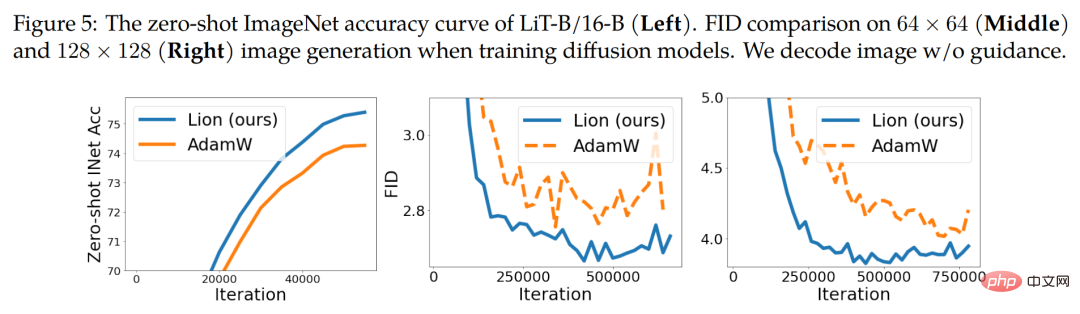

아래 그림 5(왼쪽)는 LiT-B/16-B에 대한 제로샷 학습 곡선의 예를 보여주며, 다른 두 데이터 세트에서도 비슷한 결과가 나타납니다.

확산 모델

최근 확산 모델은 이미지 생성 분야에서 큰 성공을 거두었습니다. 엄청난 잠재력을 고려하여 우리는 무조건적인 이미지 합성 및 다중 모드 텍스트-이미지 생성에 대해 Lion을 테스트했습니다.

ImageNet의 이미지 합성을 위해 연구원들은 2021년 논문 "Diffusion models beat gans on image 종합"에 소개된 개선된 U-Net 아키텍처를 사용하여 ImageNet에서 64×64, 128×128 및 256×256 이미지 생성을 수행했습니다. . 위 그림 5(가운데와 오른쪽)에 표시된 것처럼 Lion은 FID 점수에 대해 더 나은 품질과 더 빠른 수렴을 달성할 수 있습니다.

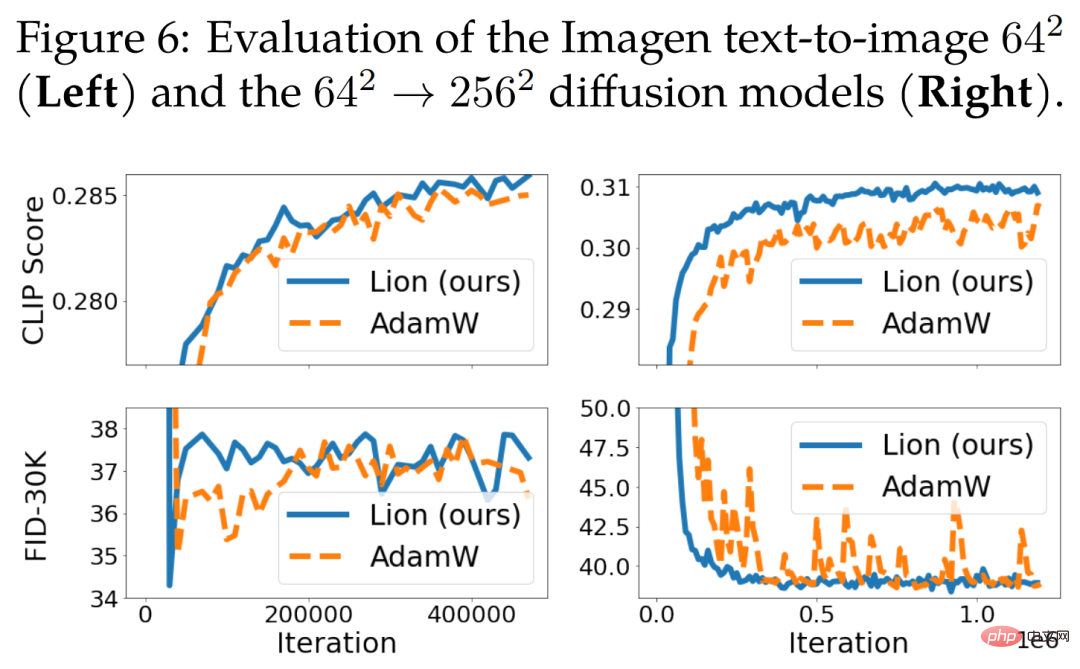

텍스트-이미지 생성의 경우 아래 그림 6은 학습 곡선을 보여줍니다. 64 × 64 기본 모델에서는 크게 개선되지 않았지만 Lion은 텍스트 조건부 초해상도 모델에서 AdamW보다 성능이 뛰어납니다. Lion은 AdamW에 비해 더 높은 CLIP 점수를 달성하고 노이즈가 있는 FID 측정항목이 더 작습니다.

언어 모델링 및 미세 조정

이 섹션에서는 언어 모델링 및 미세 조정에 중점을 둡니다. 순수 언어 작업에서 연구자들은 β_1과 β_2를 조정하면 AdamW와 Lion의 품질이 향상될 수 있음을 발견했습니다.

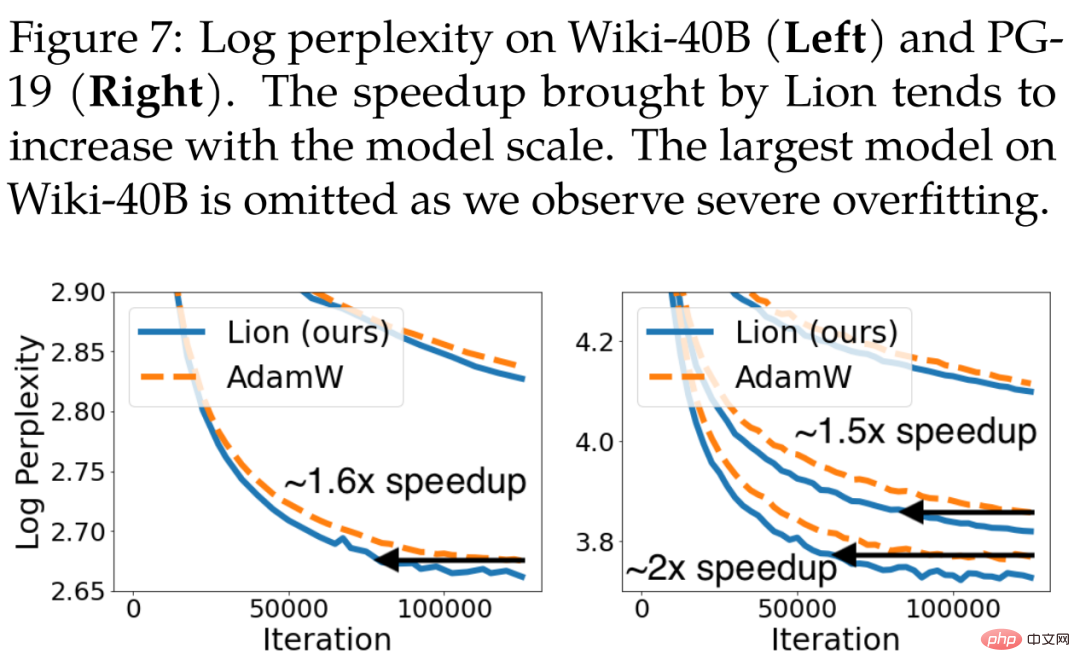

자동회귀 언어 모델링의 경우 아래 그림 7은 Wiki-40B의 토큰 수준 혼란과 PG-19의 단어 수준 혼란을 보여줍니다. Lion은 AdamW보다 지속적으로 낮은 검증 복잡성을 달성합니다. Wiki-40B 및 PG-19에서 중간 크기 모델을 훈련할 때 각각 1.6배 및 1.5배의 속도 향상을 달성합니다. PG-19는 모델이 대형화되면 속도가 2배 향상됩니다.

연구원들은 C4 데이터 세트에 대한 BERT 교육도 수행했는데, Lion은 검증 복잡성 측면에서 AdamW보다 약간 더 나은 성능을 보였습니다. 관련 학습 곡선은 아래 그림 11(왼쪽)에 나와 있습니다.

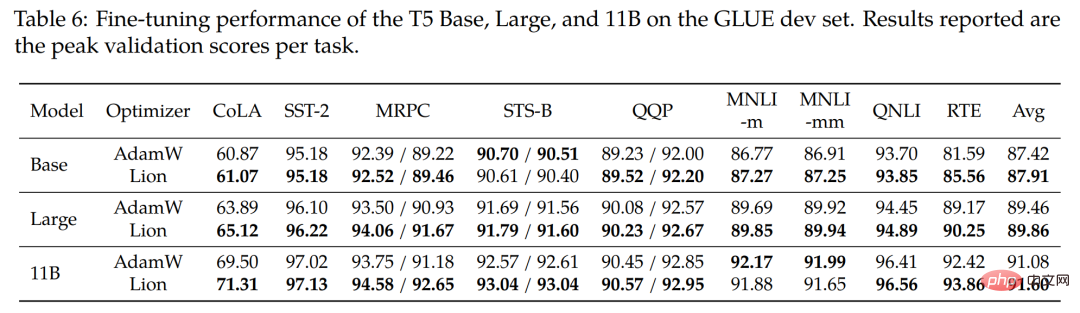

연구진은 GLUE 벤치마크에서 Base(220M), Large(770M) 및 가장 큰 11B T5 모델을 미세 조정했습니다. 아래 표 6은 GLUE 개발 세트의 결과를 보여줍니다. 평균적으로 Lion은 3가지 모델 크기 모두에서 AdamW를 능가합니다.

다른 인기 있는 최적화 프로그램과의 비교

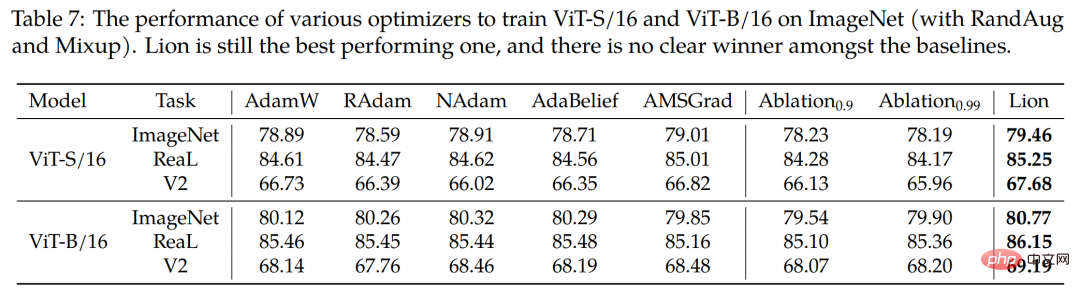

이 연구에서는 또한 네 가지 인기 있는 최적화 프로그램인 RAdam, NAdam, AdaBelief 및 AMSGrad를 사용하여 ImageNet 및 ViT-B/에서 ViT-S/16을 교육합니다. 16(RandAug 및 Mixup 사용). 아래 표 7에서 볼 수 있듯이 Lion은 여전히 최고의 성과를 내고 있습니다.

자세한 기술적인 내용은 원본 문서를 참조하세요.

위 내용은 AdamW를 완전히 박살내세요! Google의 새로운 최적화 프로그램은 메모리가 작고 효율성이 높습니다. 네티즌: GPT 2 교육은 정말 빠릅니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!