탁구 마니아가 로봇과 대결하게 놔두세요. 로봇의 발전 추세를 보면 누가 이기고 누가 질지 말하기가 정말 어렵습니다.

이 로봇은 민첩한 기동성, 유연한 다리 움직임, 뛰어난 잡는 능력을 갖추고 있으며... 다양한 도전적인 작업에 널리 사용되었습니다. 그러면 로봇은 인간과 긴밀한 상호 작용이 필요한 작업을 어떻게 수행합니까? 탁구를 예로 들자면 양측의 높은 수준의 협력이 필요하며 공이 매우 빠르게 움직이기 때문에 알고리즘에 큰 문제가 됩니다.

탁구에서는 속도와 정확성이 최우선이므로 학습 알고리즘에 대한 요구가 높습니다. 동시에 이 스포츠는 고도로 구조화된(고정되고 예측 가능한 환경) 및 다중 에이전트 협업(로봇이 인간 또는 다른 로봇과 싸울 수 있음)이라는 두 가지 주요 특징을 가지고 있어 인간과 컴퓨터의 상호 작용을 연구하고 강화 학습. 문제에 대한 이상적인 실험 플랫폼입니다.

Google의 로봇 공학 연구팀은 다중 사용자, 동적 및 대화형 환경에서 학습하는 로봇이 직면하는 문제를 연구하기 위해 이러한 플랫폼을 구축했습니다. Google은 또한 이러한 목적으로 그들이 연구하고 있는 두 가지 프로젝트인 Iterative-Sim2Real(i-S2R)과 GoalsEye를 소개하기 위해 특별한 블로그를 작성했습니다. i-S2R을 사용하면 봇이 인간 플레이어와 300개 이상의 경기를 치를 수 있었고, GoalsEye를 사용하면 봇이 아마추어로부터 몇 가지 유용한 전략(목표 조건 전략)을 배울 수 있었습니다.

i-S2R 전략을 사용하면 로봇이 인간과 싸울 수 있습니다. 로봇의 자세가 그다지 전문적이지는 않지만 공을 놓치지 않습니다. 즉, 고품질의 공을 플레이하는 것과 같은 느낌이 듭니다.

GoalsEye 전략은 마치 가리키는 곳을 치는 것처럼 테이블 위의 지정된 위치로 공을 되돌릴 수 있습니다.

GoalsEye 전략은 마치 가리키는 곳을 치는 것처럼 테이블 위의 지정된 위치로 공을 되돌릴 수 있습니다.

i-S2R: 시뮬레이터를 사용하여 인간과 협력하여 게임을 플레이합니다.

이 프로젝트에서 로봇은 인간과 협력하는 방법, 즉 가능한 한 오랫동안 인간과 스파링하는 방법을 배우도록 설계되었습니다. 인간 플레이어를 상대로 직접 훈련하는 것은 지루하고 시간이 많이 걸리기 때문에 Google은 시뮬레이션 기반 접근 방식을 채택했습니다. 그러나 이는 시뮬레이션 기반 방법으로 인간 행동, 폐쇄 루프 상호 작용 작업 등을 정확하게 시뮬레이션하는 것이 어렵다는 새로운 문제에 직면합니다.

Google은 i-S2R에서 인간-컴퓨터 상호 작용 작업에서 인간 행동을 학습할 수 있는 모델을 제안하고 이를 로봇 탁구 플랫폼에서 인스턴스화했습니다. Google은 아마추어 인간 선수들과 함께 최대 340개의 타구를 던질 수 있는 시스템을 구축했습니다(아래 참조).

인간과 로봇이 4분 동안 최대 340회 왕복 싸움을 펼칩니다.

로봇이 인간 행동을 정확하게 학습하도록 하는 것도 다음과 같은 문제에 직면합니다. 처음에는 충분하지 않습니다. 인간이 봇과 상호 작용하는 방식에 대한 고품질 데이터를 수집하지 않으면 좋은 봇 전략을 달성할 수 없습니다. 그러나 인간 행동 모델이 없으면 로봇 전략을 처음부터 얻을 수 없습니다. 이 문제는 닭이 먼저냐 달걀이 먼저냐 하는 것처럼 다소 복잡합니다. 한 가지 접근 방식은 실제 세계에서 직접 로봇 정책을 교육하는 것이지만 이는 느리고 비용이 많이 들며 인간이 개입할 때 더욱 악화되는 안전 관련 문제를 야기합니다.

i-S2R 방법

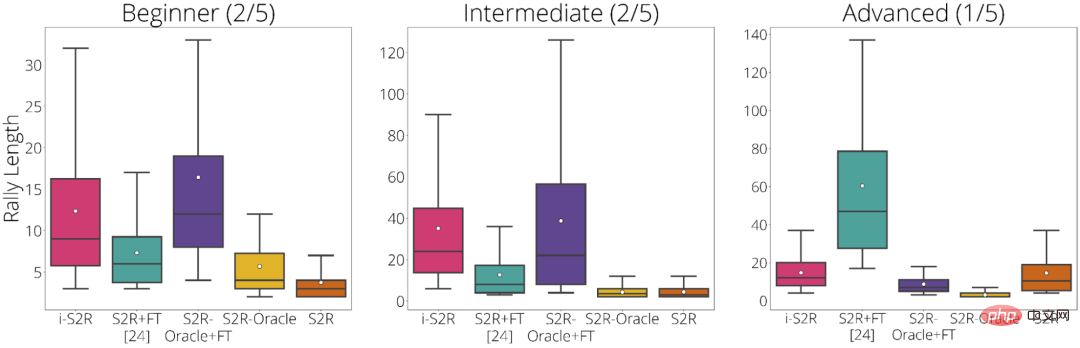

Google은 플레이어 유형에 따라 실험 결과를 초급(플레이어의 40%), 중급(플레이어의 40%), 고급(플레이어의 20%)으로 분류합니다. . 실험 결과에 따르면 i-S2R은 초보자와 중급 플레이어(플레이어의 80%) 모두에게 S2R+FT(시뮬레이션-실제 + 미세 조정)보다 훨씬 더 나은 성능을 발휘합니다.

플레이어 유형별 i-S2R 결과

GoalsEye에서 Google은 사용된 행동 복제 기술을 결합하여 정확한 타겟팅을 학습하는 방법도 시연했습니다. 전략.

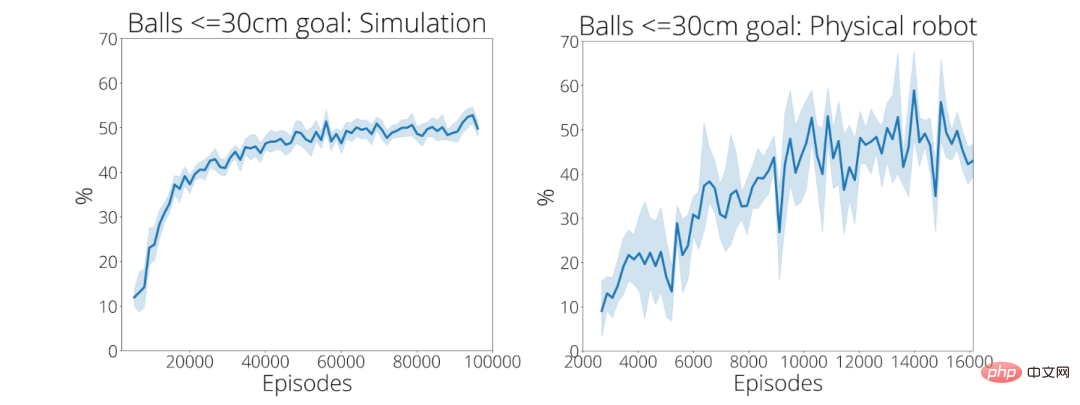

여기서 Google은 탁구의 정확성에 중점을 둡니다. 아래 그림과 같이 로봇이 테이블 위의 지정된 위치로 공을 정확하게 되돌릴 수 있기를 바랍니다. 다음과 같은 효과를 얻기 위해 LFP(Learning from Play)와 GCSL(Goal-Conditioned Supervised Learning)도 사용했습니다.

GoalsEye 전략은 직경 20cm의 원을 대상으로 합니다(왼쪽). 인간 플레이어는 동일한 목표를 겨냥할 수 있습니다(오른쪽)

처음 2,480개의 데모에서 Google의 훈련 전략은 반경 30cm의 원형 목표를 정확히 맞추는 비율이 9%에 불과했습니다. 약 13,500번의 시연 후에 공이 목표물에 도달하는 정확도는 43%(오른쪽 하단)로 증가했습니다.

이 두 프로젝트에 대한 자세한 소개는 다음 링크를 참조하세요:

위 내용은 구글은 4분 동안 300번 이상 플레이한 후 로봇에게 탁구를 가르쳤습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!