기술 발전이 가속화됨에 따라 인공지능(AI)이 의사결정 과정에서 점점 더 중요한 역할을 하고 있습니다. 인간은 정보를 처리하고 특정 조치를 권장하며 심지어 인간을 대신하여 조치를 취하기 위해 점점 더 알고리즘에 의존하고 있습니다.

그러나 AI가 결정, 특히 주관적, 도덕적, 윤리적 결정과 관련된 결정을 내리는 데 정말로 우리를 돕거나 심지어 대체할 수 있다면 이를 받아들일 수 있습니까?

최근 히로시마 대학 연구팀은 인공지능 의사결정 도입에 대한 인간의 반응을 조사했습니다. 구체적으로, 자율 주행 자동차와 인간의 상호 작용을 연구함으로써 "사회는 인공 지능의 윤리적 의사 결정을 내릴 준비가 되어 있습니까?"라는 질문을 탐구했습니다. 행동 및 실험경제학(Behavioral and Experimental Economics)에 게재되었습니다.

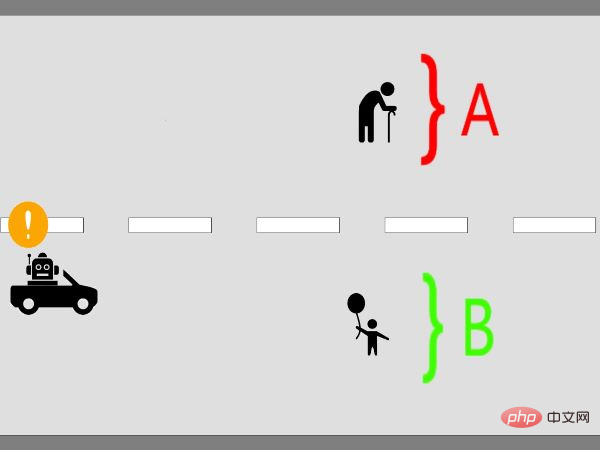

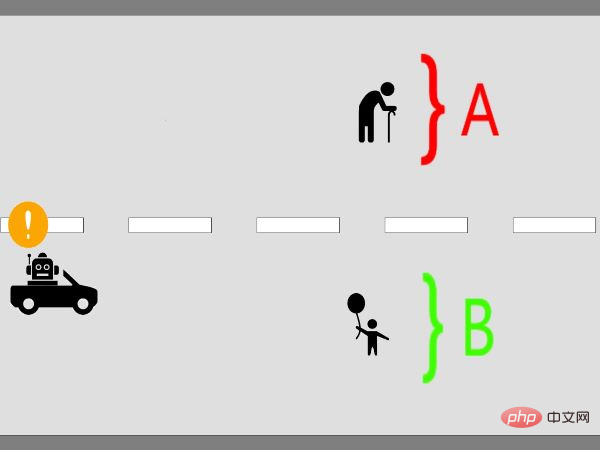

첫 번째 실험에서 연구자들은 529명의 인간 피험자에게 운전자가 직면할 수 있는 윤리적 딜레마를 제시했습니다. 연구원들이 만든 시나리오에서 자동차 운전자는 자신의 차가 한 그룹의 사람들과 충돌할지 아니면 다른 그룹에 부딪힐지 결정해야 했고 충돌은 불가피했습니다. 즉, 사고는 한 그룹의 사람들에게 심각한 피해를 주지만 다른 그룹의 사람들의 생명을 구할 수 있습니다.

실험에 참여한 인간 피험자들은 인간일 수도 있고 인공 지능일 수도 있는 자동차 운전자의 결정을 평가해야 했습니다. 이를 통해 연구자들은 사람들이 AI의 윤리적 의사결정에 대해 가질 수 있는 편견을 측정하는 것을 목표로 했습니다.

두 번째 실험에서는 563명의 인간 피험자가 AI가 사회의 일부가 된 후 사람들이 윤리적 의사 결정에 대해 어떻게 느끼는지 알아보기 위해 연구자가 제기한 여러 질문에 답했습니다.

이 실험에는 두 가지 상황이 있습니다. 하나는 자율주행차가 도덕적 결정을 내릴 수 있도록 허용하기로 결정한 가상의 정부와 관련된 것이고, 또 다른 시나리오에서는 자율주행차가 도덕적 결정을 내릴 수 있도록 허용할지 여부에 대해 주체가 "투표"할 수 있도록 허용하는 시나리오입니다. 두 경우 모두 피험자는 기술이 내린 결정을 지지하거나 반대하기로 선택할 수 있습니다.

두 번째 실험은 인공지능을 사회에 도입하는 두 가지 대안적 방법의 효과를 테스트하기 위해 고안되었습니다.

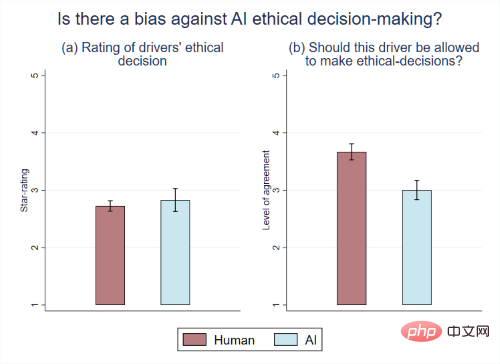

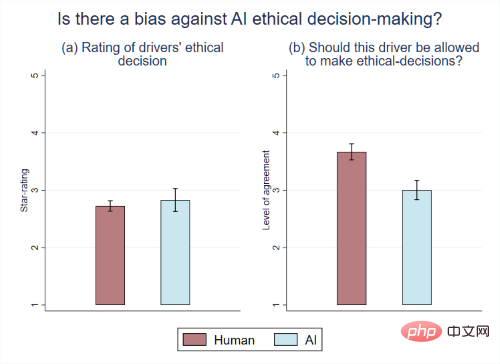

연구원들은 피험자들에게 인간이나 AI 운전자의 도덕적 결정을 평가하도록 요청했을 때 어느 쪽도 선호하지 않는다는 점을 관찰했습니다. 그러나 피험자들에게 도로에서 AI가 윤리적 결정을 내릴 수 있도록 허용해야 하는지에 대한 의견을 물었을 때 피험자들은 AI 구동 자동차에 대해 더 강한 의견을 보였습니다.

연구원들은 두 결과의 차이는 두 가지 요소의 조합으로 인해 발생한다고 믿습니다.

첫 번째 요소는 많은 사람들이 사회 전체가 인공 지능이 윤리 및 도덕과 관련된 결정을 내리는 것을 원하지 않는다고 믿기 때문에 이 문제에 대한 견해를 물으면 자신의 생각에 영향을 받게 된다는 것입니다. "

실제로 참가자들에게 자신의 답변과 사회의 답변을 명시적으로 구별하도록 요청했을 때 AI와 인간 운전자의 차이가 사라졌습니다." 히로시마대학교 인문사회과학대학원 조교수인 버넷(Johann Caro)이 말했습니다.

두 번째 요소는 이 신기술을 사회에 도입할 때 이와 관련된 주제에 대한 논의가 허용되는지 여부에 대한 결과이며 국가마다 다릅니다. “사람들이 정부를 신뢰하고 강력한 정부 제도를 갖고 있는 분야에서는 정보와 의사결정력이 주체가 AI의 윤리적 의사결정을 평가하는 방식에 기여하는 반면, 사람들이 정부를 불신하고 제도가 약한 분야에서는 의사결정이 능력을 저하시키는 방법 피험자가 인공 지능의 윤리적 결정을 평가하는 방법"이라고 Caro-Burnett는 말했습니다. "

우리는 사회가 AI의 윤리적 의사결정에 대한 두려움을 가지고 있다는 것을 발견했습니다. 그러나 이 두려움의 근원은 개인에게 내재된 것이 아닙니다. 사실 이러한 AI에 대한 거부는 개인이 사회의 인식이라고 믿는 것에서 비롯됩니다." 히로시마대학 인문대학 사회과학대학원 가네코 신지 교수는 이렇게 말했다.

그래픽 | 평균적으로 사람들은 AI 운전자의 윤리적 결정을 인간 운전자와 다르지 않게 평가했습니다. 그러나 사람들은 AI가 이동 중에 윤리적 결정을 내리는 것을 원하지 않으므로

명시적으로 요청하지 않을 때 AI 윤리적 의사 결정에 편향된 징후를 보이지 않습니다. 그러나 명시적으로 질문을 받았을 때 사람들은 AI에 대한 혐오감을 표현했습니다. 또한, 주제에 대한 논의와 정보가 증가함에 따라 선진국에서는 AI에 대한 수용이 증가하고 개발 도상국에서는 악화되었습니다.

연구원들은 신기술에 대한 이러한 거부는 주로 사회의 의견에 대한 개인적인 믿음 때문이며 다른 기계와 로봇에도 적용될 가능성이 있다고 믿습니다. "그러므로 개인의 선호가 어떻게 사회적 선호로 통합되는지를 결정하는 것이 중요합니다. 또한 우리의 결과에서 알 수 있듯이 그러한 결론은 국가마다 다를 수밖에 없습니다."라고 Kaneko는 말했습니다.

위 내용은 우리 사회는 AI가 결정을 내리도록 할 준비가 되어 있습니까?의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!