arXiv 논문 "Unifying Voxel-based Representation with Transformer for 3D ObjectDetection", 6월 22일, 홍콩 중문 대학교, 홍콩 대학교, Megvii Technology(Sun Jian 박사를 기념하여) 및 Simou Technology 등

본 논문에서는 UVTR이라는 통합 다중 모드 3D 개체 감지 프레임워크를 제안합니다. 이 방법은 복셀 공간의 다중 모드 표현을 통합하고 정확하고 강력한 단일 모드 또는 교차 모드 3D 감지를 가능하게 하는 것을 목표로 합니다. 이를 위해 양식별 공간은 먼저 복셀 특징 공간에 대한 다양한 입력을 나타내도록 설계되었습니다. 높이 압축 없이 복셀 공간을 보존하고 의미적 모호성을 완화하며 공간 상호 작용을 가능하게 합니다. 이러한 통합 접근 방식을 기반으로 지식 전달 및 모드 융합을 포함하여 다양한 센서의 고유한 특성을 완전히 활용하기 위한 교차 모드 상호 작용이 제안됩니다. 이러한 방식으로 포인트 클라우드의 형상 인식 표현과 이미지의 상황에 맞는 특징을 잘 활용하여 성능과 견고성을 높일 수 있습니다.

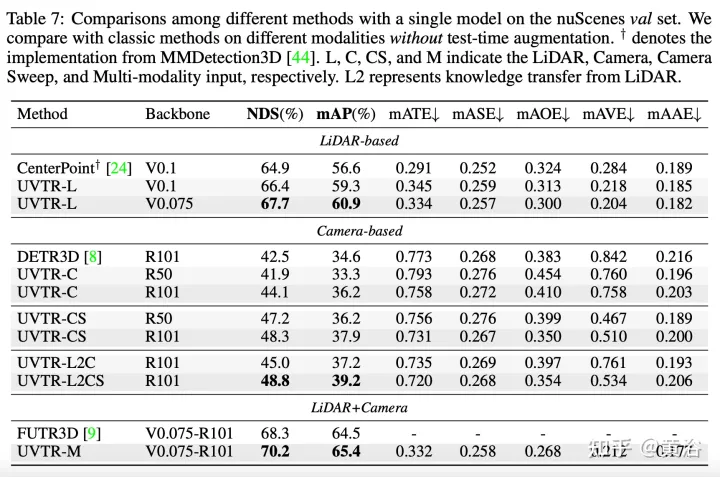

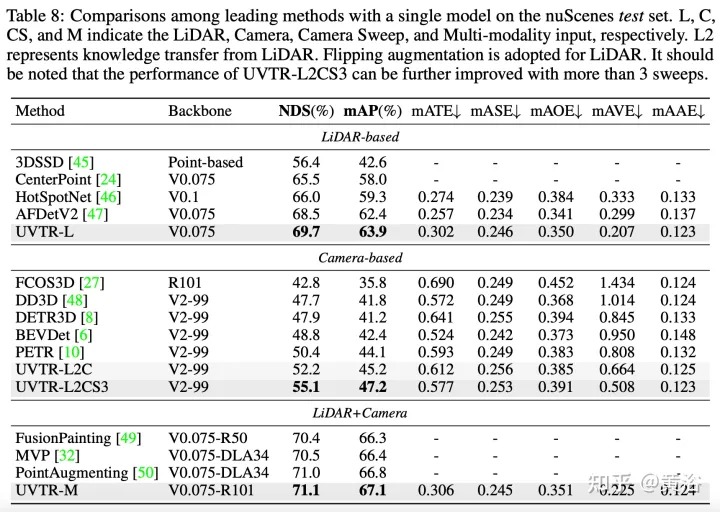

변환기 디코더는 학습 가능한 위치가 있는 통합 공간에서 특징을 효율적으로 샘플링하는 데 사용되며, 이는 개체 수준 상호 작용을 용이하게 합니다. 일반적으로 UVTR은 통합 프레임워크에서 다양한 양식을 표현하려는 초기 시도를 나타내며 단일 및 다중 모드 입력에 대한 이전 작업을 능가하고 nuScenes 테스트 세트, LiDAR, 카메라 및 다중 모드 출력의 NDS에서 최고의 성능을 달성합니다. 각각 69.7%, 55.1%, 71.1%였다.

코드: https://github.com/dvlab-research/UVTR.

그림과 같이

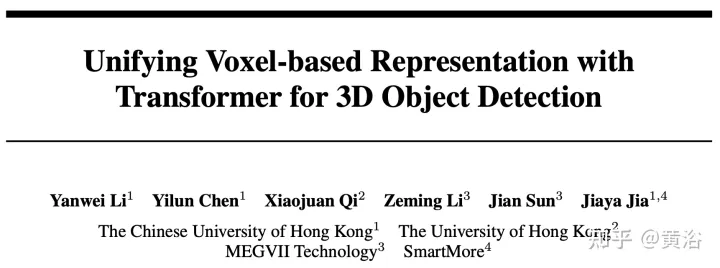

표현 통일 과정에서 입력은 다음과 같습니다. 크게 레벨흐름 표현과 특성 레벨흐름 표현으로 구분됩니다. 첫 번째 접근 방식의 경우 다중 모드 데이터가 네트워크 시작 부분에 정렬됩니다. 특히, (a)의 의사 포인트 클라우드는 예측된 깊이 보조 이미지에서 변환되고, (b)의 거리 뷰 이미지는 포인트 클라우드에서 투영됩니다. 의사 점 구름의 깊이 부정확성과 범위 보기 이미지의 3차원 기하학적 붕괴로 인해 데이터의 공간 구조가 파괴되어 결과가 좋지 않습니다. 특징 수준 방법의 경우 일반적인 방법은 그림 (c)와 같이 이미지 특징을 절두체로 변환한 다음 이를 BEV 공간으로 압축하는 것입니다. 그러나 광선과 같은 궤적 때문에 각 위치의 높이 정보(높이) 압축은 다양한 대상의 특징을 집계하여 의미적 모호성을 유발합니다. 동시에, 암시적 접근 방식은 3D 공간에서 명시적인 기능 상호 작용을 지원하기 어렵고 추가 지식 전달을 제한합니다. 따라서 모달 격차를 해소하고 다면적인 상호 작용을 촉진하려면 보다 통일된 표현이 필요합니다.

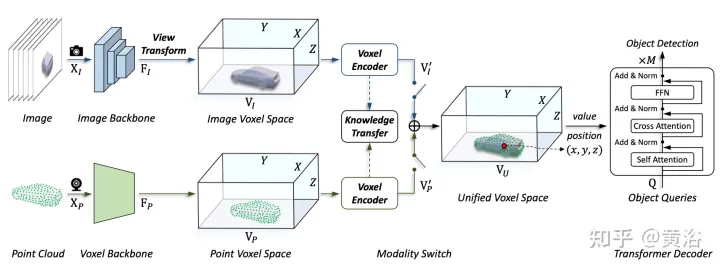

이 글에서 제안하는 프레임워크는 복셀 기반 표현과 변환기를 통합합니다. 특히, 복셀 기반의 명시적 공간에서 이미지와 포인트 클라우드의 특징 표현 및 상호 작용. 이미지의 경우 그림 (d)에 표시된 대로 예측된 깊이와 기하학적 제약 조건에 따라 이미지 평면에서 특징을 샘플링하여 복셀 공간이 구성됩니다. 포인트 클라우드의 경우 정확한 위치를 통해 자연스럽게 기능을 복셀과 연결할 수 있습니다. 그런 다음 공간적 상호 작용을 위해 복셀 인코더가 도입되어 인접한 특징 간의 관계를 설정합니다. 이러한 방식으로 교차 모달 상호 작용은 각 복셀 공간의 기능과 자연스럽게 진행됩니다. 대상 수준 상호 작용의 경우 그림 (d)에 표시된 대로 변형 가능한 변환기가 디코더로 사용되어 통합 복셀 공간의 각 위치(x, y, z)에서 대상 쿼리 관련 기능을 샘플링합니다. 동시에, 3차원 쿼리 위치의 도입은 BEV 공간에서 높이 정보(높이) 압축으로 인해 발생하는 의미 모호성을 효과적으로 완화합니다.

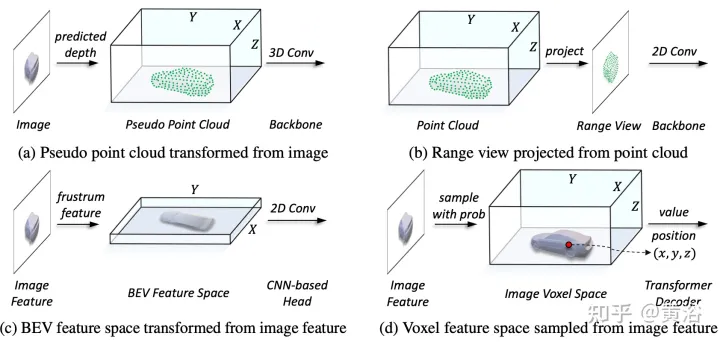

그림에 표시된 것처럼 다중 모달 입력의 UVTR 아키텍처는 다음과 같습니다. 단일 프레임 또는 다중 프레임 이미지와 포인트 클라우드가 주어지면 먼저 단일 백본에서 처리되고 양식별 공간 VI 및 VP로 변환됩니다. 여기서 뷰 변환은 이미지로 이루어집니다. 복셀 인코더에서는 기능이 공간적으로 상호 작용하며 훈련 중에 지식 전달이 쉽게 지원됩니다. 설정에 따라 모달 스위치를 통해 단일 모드 또는 다중 모드 기능을 선택하십시오. 마지막으로 학습 가능한 위치가 있는 통합 공간 VU에서 특징을 샘플링하고 변환기 디코더를 사용하여 예측합니다.

그림은 뷰 변환의 세부 사항을 보여줍니다.

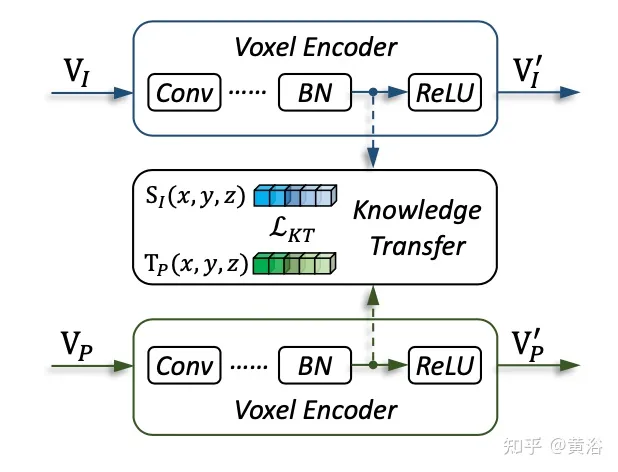

그림은 지식 이전의 세부 사항을 보여줍니다.

실험 결과는 다음과 같습니다.

위 내용은 Transformer는 3D 객체 감지를 위해 복셀 기반 표현을 통합합니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!