고차원 데이터의 저차원 표현을 학습하는 것은 비지도 학습의 기본 작업입니다. 이러한 표현을 통해 데이터의 본질을 간결하게 포착하고 저차원 입력을 기반으로 다운스트림 작업을 수행할 수 있기 때문입니다. VAE(Variational Autoencoder)는 중요한 표현 학습 방법이지만 객관적인 제어로 인해 표현 학습은 여전히 어려운 작업입니다. VAE의 증거 하한(ELBO) 목표는 생성적으로 모델링되지만 학습 표현은 이 목표를 직접적으로 목표로 삼지 않으며, 이는 얽힘 풀기와 같은 표현 학습 작업에 대한 특정 수정이 필요합니다. 이러한 수정은 때때로 모델에 암시적이고 바람직하지 않은 변경을 초래하여 제어된 표현 학습을 어려운 작업으로 만듭니다.

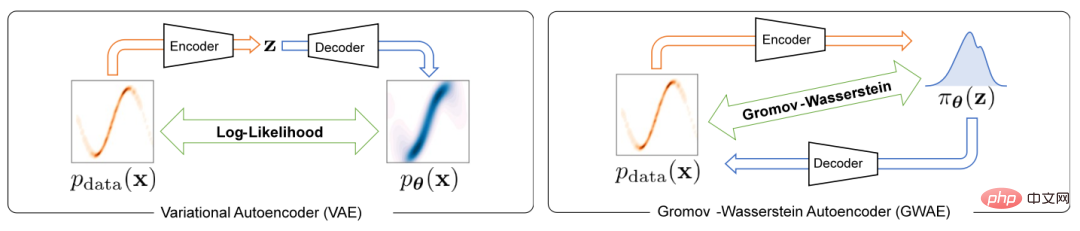

Variational Autoencoder의 표현 학습 문제를 해결하기 위해 본 논문에서는 Gromov-Wasserstein Autoencoders(GWAE)라는 새로운 생성 모델을 제안합니다. GWAE는 VAE(Variational Autoencoder) 모델 아키텍처를 기반으로 표현 학습을 위한 새로운 프레임워크를 제공합니다. 데이터 변수의 생성 모델링을 위한 기존 VAE 기반 표현 학습 방법과 달리 GWAE는 데이터와 잠재 변수 간의 최적 전송을 통해 유익한 표현을 얻습니다. Gromov-Wasserstein(GW) 측정법은 고려 중인 변수의 거리 구조에 초점을 맞춘 비교할 수 없는 변수(예: 서로 다른 차원을 가진 변수) 간의 최적의 전송을 가능하게 합니다. ELBO 목표를 GW 메트릭으로 대체함으로써 GWAE는 변형 자동 인코더의 표현 학습을 직접 목표로 데이터와 잠재 공간 간의 비교를 수행합니다(그림 1). 표현 학습의 이러한 공식화를 통해 학습된 표현은 메타 우선순위라고 불리는 유익한 것으로 간주되는 특정 속성(예: 분해성)을 가질 수 있습니다.

그림 1 VAE와 GWAE의 차이점

이 연구는 ICLR 2023에서 승인되었습니다.

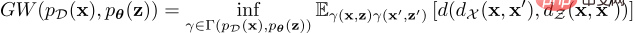

데이터 분포와 잠재적 사전 분포 간의 GW 목표는 다음과 같이 정의됩니다.

이 최적 전송 비용 공식은 비교할 수 없는 공간에서 분포의 불일치를 측정할 수 있지만 연속 분포의 경우 모든 커플링의 하한은 하한이므로 정확한 GW 값을 계산하는 것은 비현실적입니다. 이 문제를 해결하기 위해 GWAE는 자동 미분을 통해 기울기를 계산할 수 있는 GW 추정기를 추정하고 최소화하기 위해 완화된 최적화 문제를 해결합니다. 완화 목표는 추정된 GW 메트릭과 세 가지 정규화 손실의 합이며, 이는 모두 PyTorch와 같은 미분 가능한 프로그래밍 프레임워크에서 구현될 수 있습니다. 이 완화 목표는 주요 손실과 세 가지 정규화 손실, 즉 주요 추정 GW 손실, WAE 기반 재구성 손실, 병합된 충분 조건 손실 및 엔트로피 정규화 손실로 구성됩니다.

이 체계는 사전 분포를 유연하게 맞춤 설정하여 저차원 표현에 유익한 기능을 도입할 수도 있습니다. 구체적으로 이 문서에서는 세 가지 사전 모집단, 즉 다음을 소개합니다.

Neural Prior(NP) NP가 있는 GWAE에서는 완전히 연결된 신경망을 사용하여 사전 샘플링 장치를 구성합니다. 이 사전 분포군은 기본 변수에 대해 더 적은 가정을 하며 일반적인 상황에 적합합니다.

Factorized Neural Prior(FNP) FNP를 사용하는 GWAE에서 샘플러는 로컬로 연결된 신경망을 사용하여 구축되며, 여기서 각 잠재 변수에 대한 항목은 독립적으로 생성됩니다. 이 샘플러는 인수분해된 사전 표현과 용어 독립적 표현을 생성하며, 이는 대표 메타 우선, 분리를 위한 탁월한 방법입니다.

Gaussian Mixture Prior(GMP) GMP에서는 여러 가우시안 분포의 혼합으로 정의되며, Heavy 매개변수화 기술과 Gumbel-Max 기술을 사용하여 해당 샘플러를 구현할 수 있습니다. GMP를 사용하면 사전의 각 가우스 구성 요소가 클러스터를 캡처할 것으로 예상되는 표현에서 클러스터를 가정할 수 있습니다.

이 연구는 두 가지 주요 메타 우선순위인 분리 및 클러스터링을 사용하여 GWAE를 경험적으로 평가합니다.

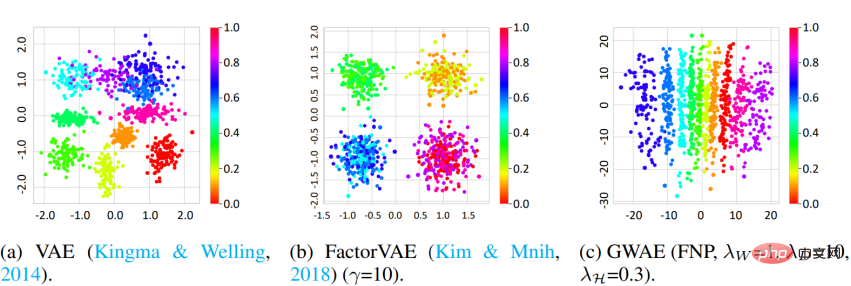

Disentanglement 이 연구에서는 3D Shapes 데이터 세트와 DCI 측정법을 사용하여 GWAE의 분리 기능을 측정했습니다. 결과는 FNP를 사용하는 GWAE가 단일 축에서 물체 색상 요소를 학습할 수 있음을 보여 주며, 이는 GWAE의 분리 기능을 보여줍니다. 정량적 평가는 또한 GWAE의 분리 성능을 보여줍니다.

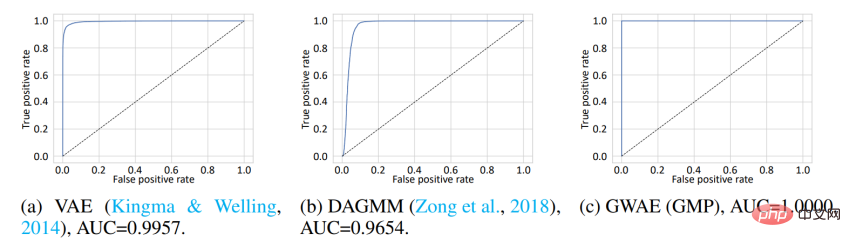

클러스터링 클러스터링 메타 우선순위를 기반으로 얻은 표현을 평가하기 위해 본 연구에서는 OoD(Out-of-Distribution) 탐지를 수행했습니다. MNIST 데이터세트는 ID(In-Distribution) 데이터로 사용되며 Omniglot 데이터세트는 OoD 데이터로 사용됩니다. MNIST에는 손으로 쓴 숫자가 포함되어 있지만 Omniglot에는 다양한 문자가 포함된 손으로 쓴 문자가 포함되어 있습니다. 본 실험에서 ID와 OoD 데이터 세트는 손으로 쓴 이미지의 도메인을 공유하지만 서로 다른 문자를 포함합니다. 모델은 ID 데이터에 대해 교육을 받은 다음 학습된 표현을 사용하여 ID 또는 OoD 데이터를 감지합니다. VAE 및 DAGMM에서 OoD 감지에 사용되는 변수는 사전 로그 우도이고, GWAE에서는 칸토로비치 전위입니다. GWAE의 이전 버전은 MNIST 클러스터를 캡처하기 위해 GMP를 사용하여 구성되었습니다. ROC 곡선은 모델의 OoD 감지 성능을 보여 주며 세 가지 모델 모두 거의 완벽한 성능을 달성했지만 GMP를 사용하여 구축된 GWAE는 AUC(곡선 아래 면적) 측면에서 가장 좋은 성능을 보였습니다.

또한 본 연구에서는 GWAE의 생성 능력을 평가했습니다.

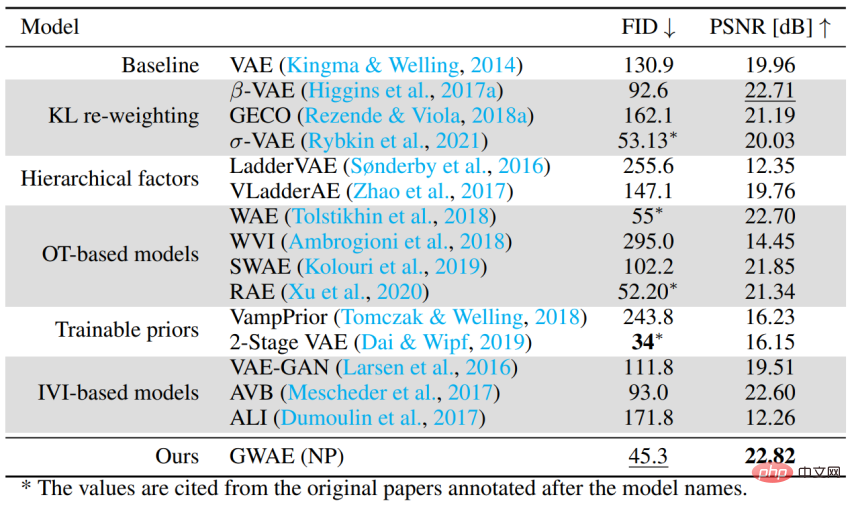

오토인코더 기반 생성 모델로서의 성능 특정 메타 우선 순위 없이 일반적인 사례를 처리하는 GWAE의 능력을 평가하기 위해 CelebA 데이터 세트를 사용하여 생성 성능을 평가했습니다. 실험에서는 FID를 사용하여 모델의 생성 성능을 평가하고 PSNR을 사용하여 자동 인코딩 성능을 평가합니다. GWAE는 NP를 사용하여 두 번째로 좋은 생성 성능과 최고의 자동 인코딩 성능을 달성하여 모델에서 데이터 분포를 캡처하고 표현에서 데이터 정보를 캡처하는 능력을 입증했습니다.

위 내용은 VAE 표현 학습 문제를 해결하기 위해 홋카이도 대학은 새로운 생성 모델 GWAE를 제안했습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!