이 글에서는 머신러닝 결과를 개선하는 데 사용되는 가장 일반적인 하이퍼파라미터 최적화 방법을 자세히 소개합니다.

번역가 | Zhu Xianzhong

Reviewer | Sun Shujuan

일반적으로 사람들이 머신러닝 모델을 개선하려고 할 때 가장 먼저 생각하는 해결책은 더 많은 훈련 데이터를 추가하는 것입니다. 추가 데이터는 종종 도움이 되지만(특정 상황 제외) 고품질 데이터를 생성하는 데는 비용이 많이 들 수 있습니다. 초매개변수 최적화는 기존 데이터를 사용하여 최고의 모델 성능을 얻음으로써 시간과 리소스를 절약합니다.

이름에서 알 수 있듯이 하이퍼파라미터 최적화는 최적화 기능을 충족하기 위해(즉, 연구 중인 데이터 세트에서 모델 성능을 최대화하기 위해) 기계 학습 모델에 대한 최상의 하이퍼파라미터 조합을 결정하는 프로세스입니다. 즉, 각 모델은 모델에 대한 최적의 하이퍼파라미터 조합을 달성할 때까지 변경할 수 있는 옵션의 여러 조정 "버튼"을 제공합니다. 하이퍼파라미터 최적화 중에 변경할 수 있는 매개변수의 예로는 학습률, 신경망 아키텍처(예: 숨겨진 레이어 수), 정규화 등이 있습니다.

이 글에서는 가장 많이 사용되는 세 가지 하이퍼파라미터 최적화 방법인 그리드 검색, 랜덤 검색, 베이지안 최적화를 개념적으로 소개하고 하나씩 구현해 보겠습니다.

독자의 참고를 위해 글의 시작 부분에 높은 수준의 비교표를 제공하고, 글의 나머지 부분에서는 비교표의 각 항목을 더 탐색하고 설명하고 구현해 보겠습니다.

표 1: 하이퍼파라미터 최적화 방법 비교

그리드 검색은 아마도 정의된 검색 공간에서 검색하는 하이퍼파라미터 최적화를 위한 가장 간단하고 직관적인 방법일 것입니다. 최고의 하이퍼파라미터 조합. 이 맥락에서 "검색 공간"은 전체 하이퍼파라미터와 최적화 중에 고려되는 해당 하이퍼파라미터의 값입니다. 예제를 통해 그리드 검색을 더 잘 이해해 봅시다.

3개의 매개변수만 있는 기계 학습 모델이 있다고 가정합니다. 각 매개변수는 표에 제공된 값을 사용할 수 있습니다.

parameter_1 = [1, 2, 3]

매개변수_2 = [a, b, c ]

매개변수_3 = [x, y, z]

이러한 매개변수의 어떤 조합이 모델의 최적화 기능을 최적화할지 알 수 없습니다(즉, 기계 학습 모델에 최상의 출력 제공). 그리드 검색에서는 이러한 매개변수의 모든 조합을 시도하고 각 매개변수에 대한 모델 성능을 측정한 후 최상의 성능을 제공하는 조합을 선택하기만 하면 됩니다. 이 예에서 매개변수 1은 3개의 값(예: 1, 2, 3)을 가질 수 있고, 매개변수 2는 3개의 값(예: a, b, c)을 가질 수 있으며, 매개변수 3은 3개의 값을 가질 수 있습니다. (예: x, y, z). 즉, 총 3*3*3=27개의 조합이 있습니다. 이 예의 그리드 검색에는 최고의 성능 조합을 찾기 위해 기계 학습 모델의 성능을 평가하는 27라운드가 포함됩니다.

보시다시피 이 방법은 매우 간단하지만(시행착오 작업과 유사) 몇 가지 제한 사항도 있습니다. 이 방법의 장점과 단점을 요약해 보겠습니다.

그 중 장점은 다음과 같습니다.

그리드 검색을 구현하기 위해 scikit-learn의 Iris 데이터 세트를 사용하여 Random Forest 분류 모델을 만듭니다. 이 데이터 세트에는 3가지 다른 붓꽃 꽃잎과 꽃받침 길이가 포함되어 있으며 이 분류 연습에 사용됩니다. 본 논문에서는 다양한 하이퍼파라미터 최적화 전략의 성능을 비교하는 것이 목표이므로 모델 개발은 부차적입니다. 모델 평가 결과와 각 하이퍼파라미터 최적화 방법이 선택한 하이퍼파라미터 세트에 도달하는 데 필요한 시간에 집중하시기 바랍니다. 실행 결과를 설명한 다음 이 기사에서 사용된 세 가지 방법에 대한 요약 비교표를 제공하겠습니다.

모든 하이퍼파라미터 값을 포함하는 검색 공간은 다음과 같이 정의됩니다.

search_space = {'n_estimators': [10, 100, 500, 1000],

'max_length': [2, 10, 25, 50, 100],

'min_samples_split': [2, 5, 10],

'min_samples_leaf': [1, 5, 10]}

위 검색 공간은 4*5*3*3=으로 구성됩니다. 전체 조합의 하이퍼파라미터는 180개입니다. 그리드 검색을 사용하여 다음과 같이 목적 함수를 최적화하는 조합을 찾습니다.

# 라이브러리 가져오기

from sklearn.model_selection import GridSearchCV

from sklearn.datasets import load_iris

from sklearn.ensemble import RandomForestClassifier

from sklearn.model_selection import cross_val_score

import time

# Iris 데이터세트 로드

iris = load_iris()

X, y = iris.data, iris.target

#초매개변수 검색 공간 정의

search_space = {'n_estimators': [10, 100, 500, 1000],

'max_length': [2 , 10, 25, 50, 100],

'min_samples_split': [2, 5, 10],

'min_samples_leaf': [1, 5, 10]}

#Define Random Forest Classifier

clf = RandomForestClassifier (random_state=1234)

# 옵티마이저 객체 생성

optimizer = GridSearchCV(clf, search_space, cv=5, Score='accuracy')

#총 소모량 계산에 사용할 수 있도록 시작 시간을 저장 Time

start_time = time.time()

# 피팅 데이터에 대한 옵티마이저

optimizer.fit(X, y)

# 총 시간을 계산할 수 있도록 종료 시간을 저장합니다

end_time = time .time ()

# 최적의 하이퍼파라미터 세트와 해당 점수를 인쇄합니다.

print(f"selected hyperparameters:")

print(optimizer.best_params_)

print("")

print(f"best_score: {optimizer. best_score_}")

print(f"elapsed_time: {round(end_time-start_time, 1)}")

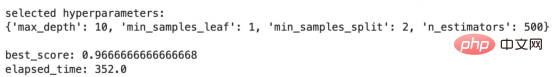

위 코드의 출력은 다음과 같습니다.

여기서 다음의 사용법을 볼 수 있습니다. 네트워크 그리드 검색은 하이퍼파라미터 값을 선택합니다. 그중 best_score는 선택된 하이퍼파라미터 세트를 사용한 평가 결과를 설명하고, elapsed_time은 내 로컬 노트북이 이 하이퍼파라미터 최적화 전략을 실행하는 데 걸린 시간을 설명합니다. 다음 방법으로 진행하면서 평가 결과와 경과 시간을 염두에 두고 비교하세요. 이제 무작위 검색에 대해 살펴보겠습니다.

이름에서 알 수 있듯이 무작위 검색은 정의된 검색 공간에서 하이퍼파라미터를 무작위로 샘플링하는 프로세스입니다. 그리드 검색과 달리 무작위 검색은 미리 정의된 반복 횟수(시간, 예산, 목표 등 사용 가능한 리소스에 따라)에 대해 하이퍼파라미터 값의 무작위 하위 집합만 선택하고 각 하이퍼파라미터 성능에 대한 기계 학습 모델을 계산합니다. 그런 다음 최상의 하이퍼파라미터 값을 선택합니다.

위의 접근 방식을 바탕으로 무작위 검색이 전체 그리드 검색보다 비용이 저렴하지만 여전히 다음과 같은 고유한 장점과 단점이 있다고 상상할 수 있습니다.

장점:

다음 방법에서는 그리드 문제와 무작위 검색의 "메모리리스" 단점을 해결하겠습니다. 하지만 이 방법을 논의하기 전에 무작위 검색을 구현해 보겠습니다.

아래 코드 조각을 사용하여 그리드 검색 구현에서 설명한 것과 동일한 문제에 대한 무작위 검색 하이퍼 매개변수 최적화를 구현합니다.

# 라이브러리 가져오기

from sklearn.model_selection import RandomizedSearchCV

from scipy.stats import randint

# RandomizedSearchCV 객체 생성

optimizer = RandomizedSearchCV(clf, param_distributinotallow=search_space,

n_iter=50, cv= 5, 점수='accuracy',

random_state=1234)

# 총 실행 시간을 계산하기 위해 시작 시간을 저장

start_time = time.time()

# 데이터에 옵티마이저 맞추기

optimizer .fit(X, y)

# 총 실행 시간을 계산하기 위해 종료 시간을 저장합니다.

end_time = time.time()

# 최상의 하이퍼파라미터 세트와 해당 점수를 인쇄합니다.

print(f"selected hyperparameters :" )

print(optimizer.best_params_)

print("")

print(f"best_score: {optimizer.best_score_}")

print(f"elapsed_time: {round(end_time-start_time, 1) }" )

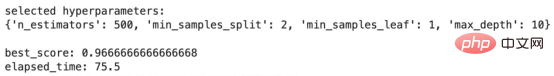

위 코드의 출력은 다음과 같습니다.

무작위 검색 결과

이러한 결과는 그리드 검색 결과와 비교하면 매우 흥미롭습니다. best_score는 동일하게 유지되지만 elapsed_time은 352.0초에서 75.5초로 감소합니다! 얼마나 인상적입니까! 즉, 무작위 검색 알고리즘은 그리드 검색에 필요한 시간의 약 21% 시간에 그리드 검색과 동일한 성능을 발휘하는 하이퍼파라미터 집합을 찾는 데 성공했습니다! 그러나 여기의 효율성은 훨씬 높습니다.

다음으로, 최적화 프로세스 중 모든 시도로부터 학습하는 베이지안 최적화라는 다음 방법으로 넘어가겠습니다.

베이지안 최적화는 확률 모델을 사용하여 이전 시도로부터 "학습"하고 검색 공간에서 최적의 하이퍼파라미터 조합으로 검색을 유도함으로써 기계 학습의 목적 함수를 최적화하는 하이퍼파라미터 최적화 방법입니다. 모델.

베이지안 최적화 방법은 4단계로 나눌 수 있는데, 아래에서 설명하겠습니다. 프로세스를 더 잘 이해하기 위해 다음 단계를 읽어 보시기 바랍니다. 하지만 이 방법을 사용하는 데 필요한 사전 지식은 없습니다.

베이지안 최적화에 대해 더 자세히 알아보고 싶다면 다음 게시물을 확인하세요.

"기계 학습의 베이지안 최적화 알고리즘", 주소는 다음과 같습니다.

https://medium.com/@fmnobar/conceptual-overview-of-bayesian-optimization-for-parameter-tuning-in -machine-learning-a3b1b4b9339f .

이제 베이지안 최적화의 작동 방식을 이해했으므로 장점과 단점을 살펴보겠습니다.

이점:

자세한 내용은 생략하고 베이지안 최적화를 구현하고 살펴보겠습니다. 결과.

이전 섹션과 유사하게 그리드 검색 구현에서 설명한 것과 동일한 문제에 대해 다음 코드 조각을 사용하여 베이지안 하이퍼파라미터 최적화를 구현하겠습니다.

# 라이브러리 가져오기

from skop import BayesSearchCV

# 베이지안 최적화 수행

optimizer = BayesSearchCV(estimator=RandomForestClassifier(),

search_spaces=search_space,

n_iter=10,

cv=5 ,

점수='정확도',

random_state=1234)

# 총 실행 시간을 계산하기 위해 시작 시간을 저장합니다.

start_time = time.time()

optimizer.fit(X, y)

# 총 실행 시간을 계산하기 위해 종료 시간을 저장합니다.

end_time = time.time()

# 최상의 하이퍼파라미터 세트와 해당 점수를 인쇄합니다.

print(f"selected hyperparameters:")

print(optimizer.best_params_ )

print("")

print(f"best_score: {optimizer.best_score_}")

print(f"elapsed_time: {round(end_time-start_time, 1)}")

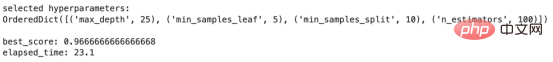

의 출력 위 코드는 다음과 같습니다:

베이지안 최적화 결과

또 다른 흥미로운 결과 모음! best_score는 그리드 및 무작위 검색으로 얻은 결과와 일치하지만 결과는 무작위 검색의 75.5초, 그리드 검색의 352.0초에 비해 23.1초만 걸렸습니다! 즉, 베이지안 최적화를 사용하면 그리드 검색보다 약 93% 정도 시간이 덜 걸립니다. 이는 더 크고 복잡한 모델과 검색 공간에서 훨씬 더 의미 있는 엄청난 생산성 향상입니다.

베이지안 최적화는 이전 반복에서 학습할 수 있기 때문에(무작위 및 그리드 검색과 반대) 10번의 반복만 사용하여 이러한 결과를 얻었습니다.

아래 표는 지금까지 논의된 세 가지 방법의 결과를 비교한 것입니다. "방법론" 열에서는 사용된 하이퍼파라미터 최적화 방법을 설명합니다. 그 다음에는 각 방법을 사용하여 선택한 하이퍼파라미터가 나옵니다. "최고 점수"는 특정 방법을 사용하여 얻은 점수이고, "경과 시간"은 내 로컬 노트북에서 최적화 전략을 실행하는 데 걸린 시간을 나타냅니다. 마지막 열인 효율성 향상에서는 그리드 검색을 기준으로 가정하고 그리드 검색과 비교하여 다른 두 가지 방법으로 얻은 효율성을 계산합니다(경과 시간 사용). 예를 들어 무작위 검색에는 75.5초가 걸리고 그리드 검색에는 352.0초가 걸리므로 그리드 검색 기준선 대비 무작위 검색의 효율성은 1–75.5/352.0=78.5%로 계산됩니다.

표 2 - 방법 성능 비교표

위 비교표의 두 가지 주요 결론:

이 글에서는 하이퍼파라미터 최적화가 무엇인지 논의하고 이 최적화 연습에 사용되는 가장 일반적인 세 가지 방법을 소개했습니다. 그런 다음 이 세 가지 방법을 각각 자세히 소개하고 분류 연습에서 구현합니다. 마지막으로 세 가지 방법을 구현한 결과를 비교합니다. 이전 시도에서 학습한 베이지안 최적화와 같은 방법은 효율성을 크게 향상시킬 수 있으며 이는 효율성이 결정 요인이 될 수 있는 심층 신경망과 같은 대규모 복잡한 모델에서 중요한 요소가 될 수 있습니다.

Zhu Xianzhong, 51CTO 커뮤니티 편집자, 51CTO 전문 블로거, 강사, 웨이팡 대학의 컴퓨터 교사이자 프리랜서 프로그래밍 업계의 베테랑입니다.

원제: 초매개변수 최적화 - 그리드 검색, 무작위 검색 및 베이지안 최적화 소개 및 구현, 저자: Farzad Mahmoodinobar

위 내용은 하이퍼파라미터 최적화 비교: 그리드 검색, 무작위 검색, 베이지안 최적화의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!