이 논문은 CVPR2023에 승인되었습니다.

이미지를 읽을 수 있는 GPT-4가 출시되었습니다! 하지만 사용하려면 줄을 서야 합니다. . .

먼저 시도해 보세요~

작은 모델을 추가하면 텍스트만 쉽게 이해하고 이미지를 읽을 수 있고 모든 종류의 까다로운 세부 사항을 해결할 수 있는 ChatGPT 및 GPT-3와 같은 대규모 언어 모델을 만들 수 있습니다. 한 손으로 꼬집는 것이 가능합니다.

그리고 이 작은 모델을 훈련하는 것은 단일 카드(RTX 3090)로 수행할 수 있습니다.

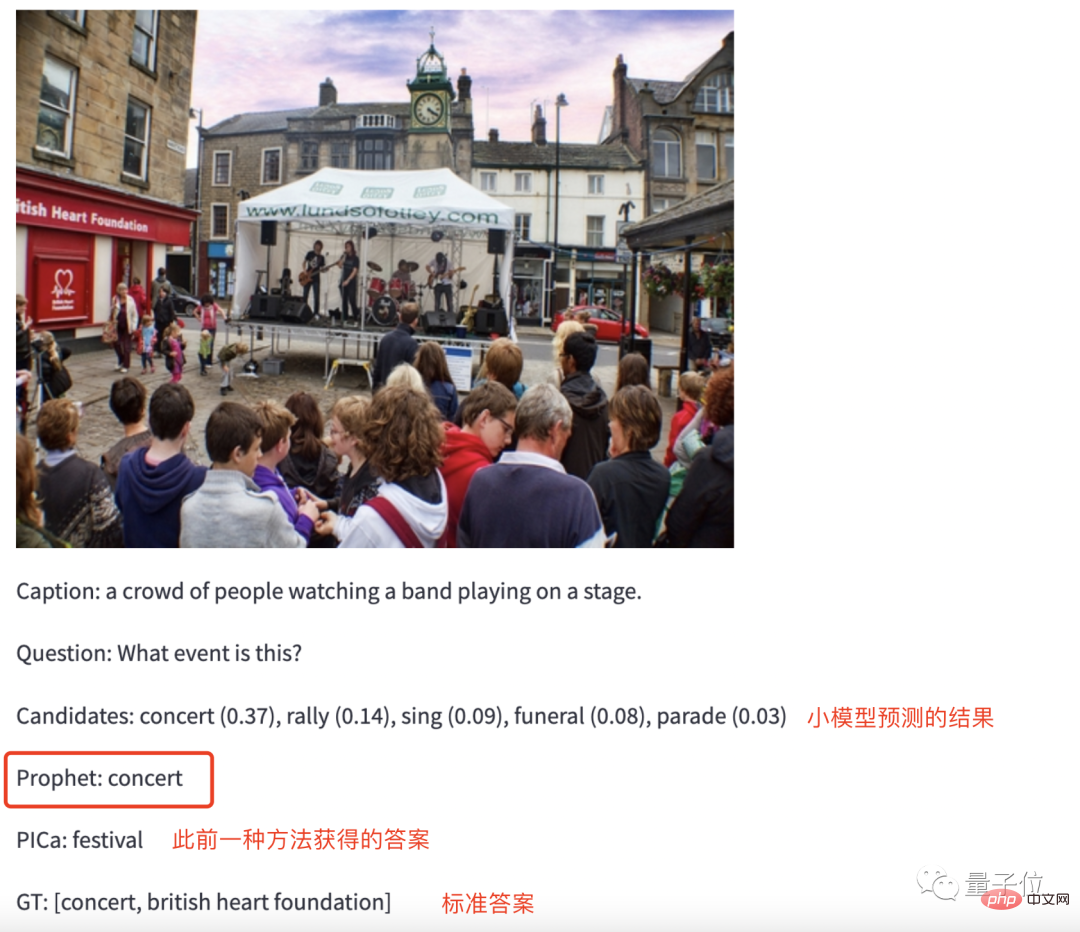

효과는 사진만 보세요.

예를 들어 훈련된 GPT-3에 "음악 현장" 사진을 입력하고 다음과 같이 질문해 보세요. 현장에서는 어떤 활동이 진행되고 있나요?

GPT-3는 망설임 없이 콘서트에 대한 답을 내놓았습니다.

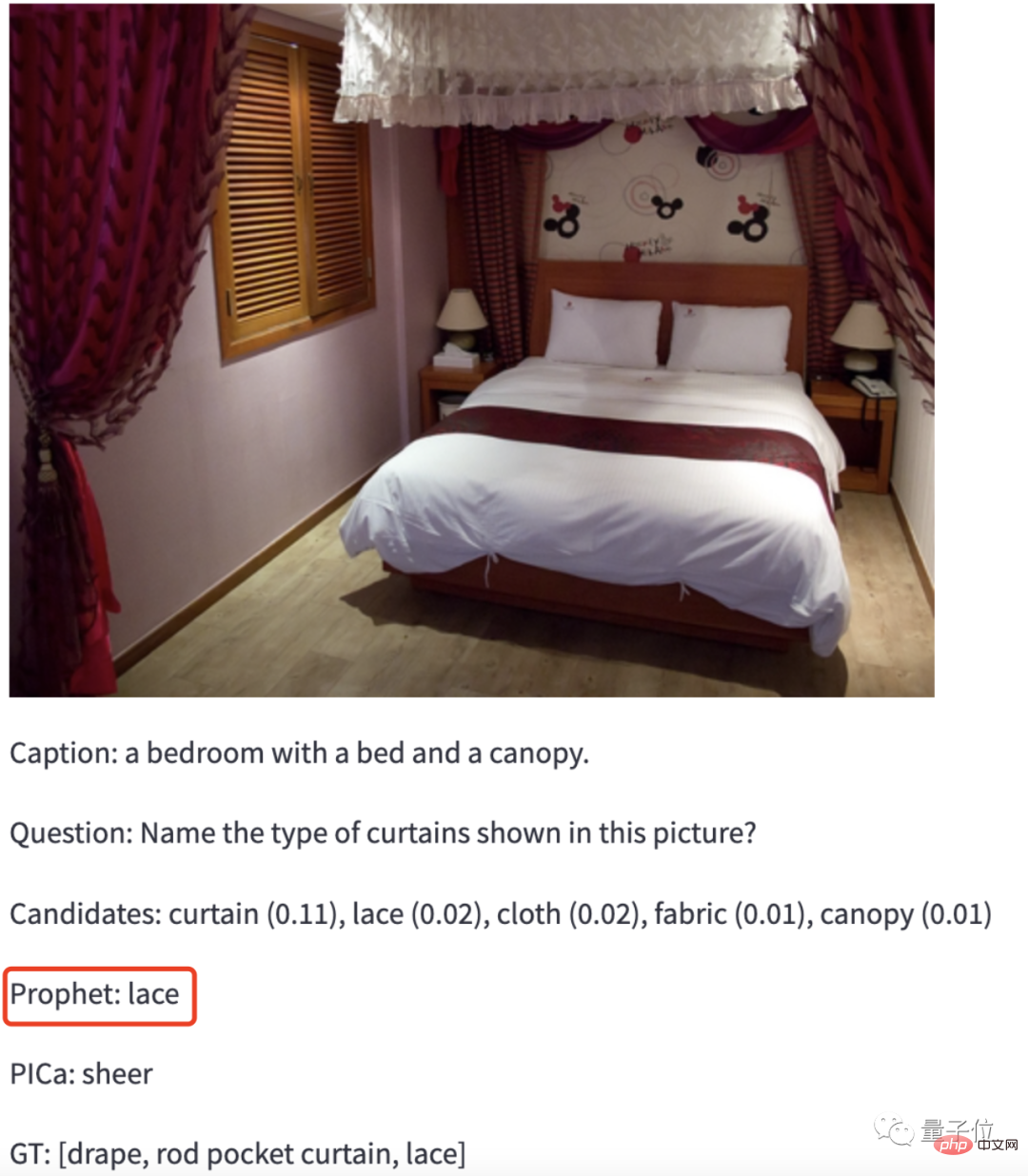

더 어렵게 하려면 GPT-3에게 Jiang Zi의 사진을 주고 사진 속 커튼이 어떤 재질인지 식별하게 하세요.

GPT-3: 레이스.

빙고! (그에게 뭔가가 있는 것 같습니다)

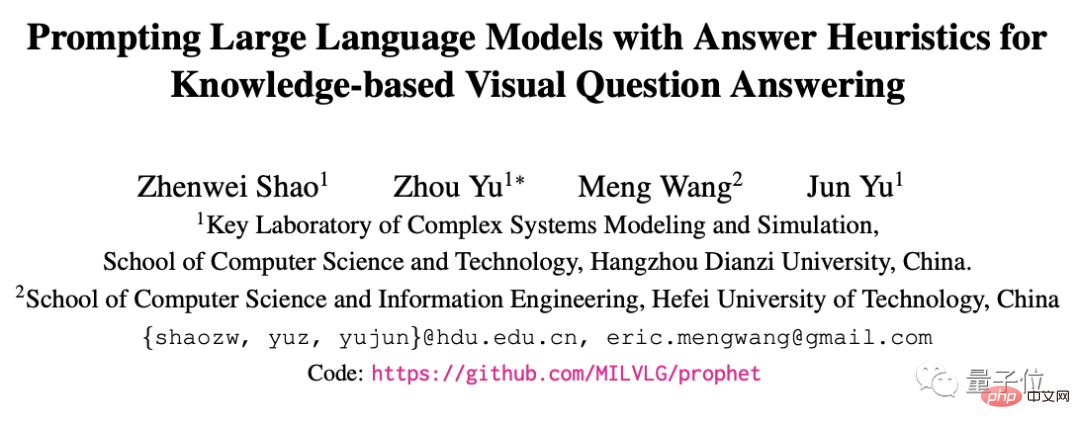

이 방법은 항저우 전자 과학 기술 대학과 허페이 기술 대학 팀의 최신 성과입니다: Prophet 그들은 이 작업을 반년 전에 시작했습니다.

논문의 첫 번째 저자는 Hangzhou Dianzi University 대학원생 Shao Zhenwei입니다. 그는 1살 때 안타깝게도 대학 입학 시험에서 Zhejiang University를 놓치고 Hangzhou Dianzi University를 선택했습니다. 집에서 가까운 곳.

이 논문은 CVPR2023에 승인되었습니다.

더 이상 고민하지 말고 Prophet의 방법을 지원하여 GPT-3의 이미지 읽기 기능을 직접 살펴보겠습니다.

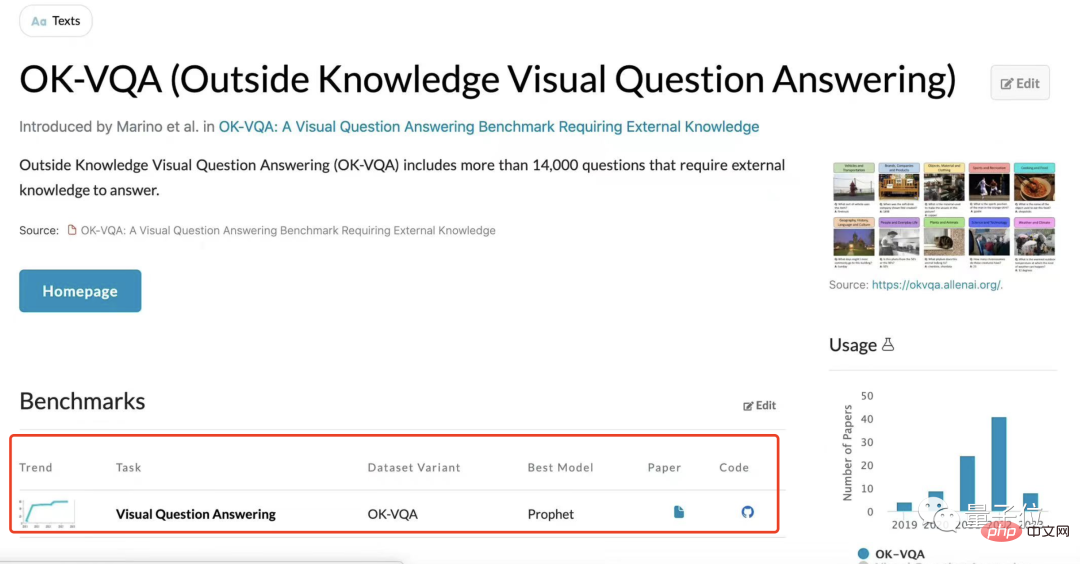

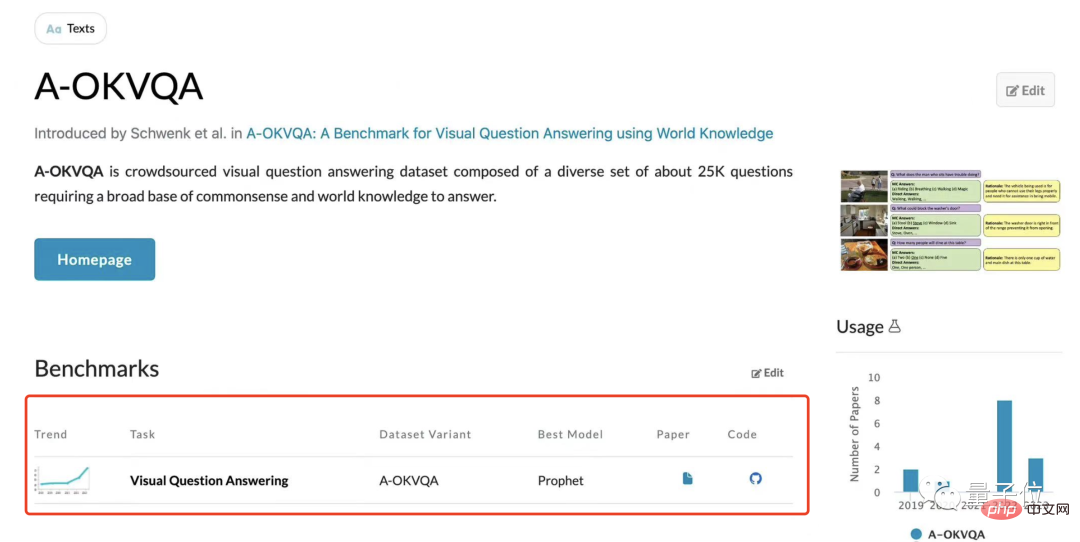

먼저 데이터 세트에 대한 테스트 결과를 살펴보겠습니다.

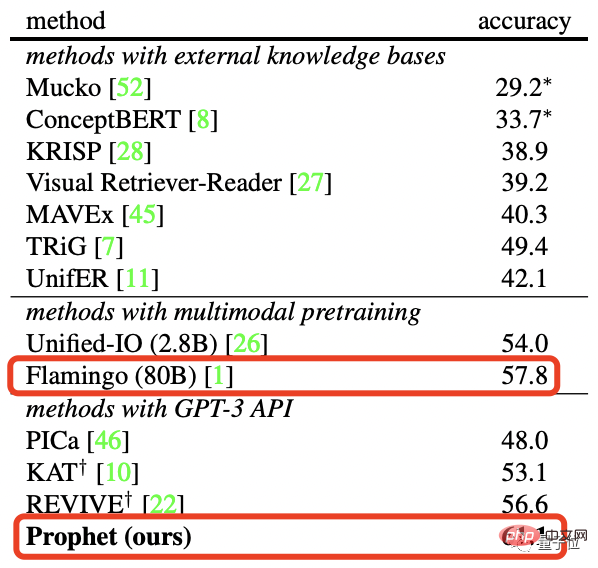

연구팀은 외부 지식인 OK-VQA와 A-OKVQA를 기반으로 한 두 개의 시각적 질문 및 답변 데이터 세트에서 Prophet를 테스트했으며 둘 다 새로운 SOTA를 만들었습니다.

더 구체적으로 말하면 OK-VQA 데이터 세트에서 Prophet은 80B 매개변수를 갖춘 Deepmind의 대형 모델 Flamingo와 비교하여 61.1%의 정확도를 달성하여 Flamingo(57.8%)를 성공적으로 이겼습니다.

그리고 필요한 컴퓨팅 파워 리소스 측면에서도 Prophet은 Flamingo를 "이깁니다".

Flamingo-80B는 1536 TPUv4 그래픽 카드에서 15일 훈련해야 하는 반면 Prophet은 RTX-3090 그래픽 카드만 있으면 VQA 모델을 4일 훈련한 다음 OpenAI API를 호출합니다. 특정 횟수.

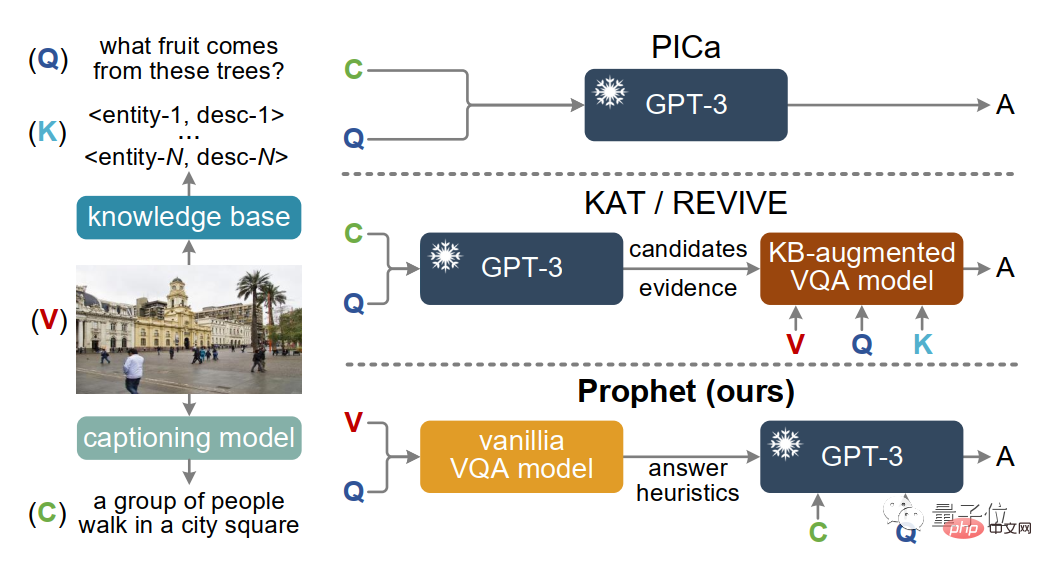

사실 GPT-3가 PICa, 이후 KAT 및 REVIVE와 같은 교차 모드 작업을 처리하는 데 도움을 주기 위해 이전에 Prophet과 같은 방법이 사용되었습니다.

그러나 일부 세부 사항을 처리하는 데 만족스럽지 않을 수 있습니다.

나에게 밤을 주고 아래 그림을 함께 읽게 한 후 질문에 답하세요. 그림 속 나무는 어떤 열매를 맺을까요?

PICa, KAT, REVIVE가 사진에서 추출한 유일한 정보는 뒤에 코코넛 나무가 있다는 사실을 전혀 무시하고 광장을 걷고 있는 한 무리의 사람들입니다. 최종 답은 추측만 가능합니다.

Prophet을 사용하면 위의 방법으로 추출된 이미지 정보가 부족하다는 문제를 해결하고 GPT-3의 잠재력을 더욱 자극합니다.

그러면 선지자는 어떻게 하는 걸까요?

효과적으로 정보를 추출하고 질문에 정확하게 답변할 수 있도록 Prophet은 고유한 2단계 프레임워크를 사용합니다.

이 두 단계에도 명확한 업무 구분이 있습니다.

우선, 첫 번째 단계에서 연구팀은 특정 외부 지식 VQA 데이터 세트에 대해 개선된 MCAN 모델(VQA 모델)을 훈련했습니다.

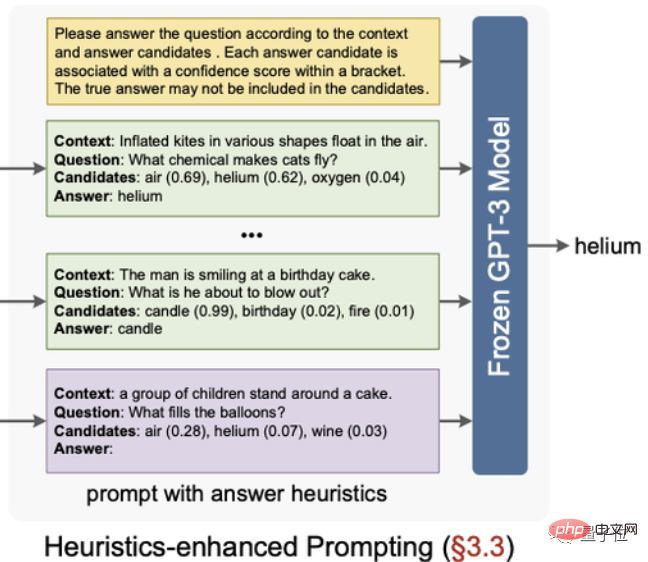

모델을 훈련한 후 모델에서 두 가지 경험적 답변, 즉 답변 후보와 답변 인식 예시를 추출합니다.

그 중 답안 후보를 모델 분류 계층에서 출력된 신뢰도를 기준으로 정렬하여 상위 10개를 선택합니다.

답변 인식 예는 모델 분류 계층 이전의 기능을 이 기능 공간에서 가장 유사하게 레이블이 지정된 샘플인 샘플의 잠재적 답변 기능으로 사용하는 것을 의미합니다.

다음 단계는 두 번째 단계입니다. 이 단계는 비교적 간단하고 대략적입니다.

이전 단계에서 얻은 "감동적인 답변"을 프롬프트로 구성한 다음 프롬프트를 GPT-3에 입력하고 특정 프롬프트에서 시각적 질문과 답변 질문을 완성합니다.

그러나 이전 단계에서 일부 답변 힌트가 제공되었지만 이것이 GPT-3가 이러한 답변으로 제한된다는 의미는 아닙니다.

프롬프트에서 제공하는 답변의 신뢰도가 너무 낮거나 해당 프롬프트에 정답이 없으면 GPT-3가 새로운 답변을 생성하는 것이 완전히 가능합니다.

물론 연구 결과 외에도 이 연구를 진행한 팀도 언급해야 합니다.

첫 번째 저자Shao Zhenwei는 1세 때 "진행성 척추 근육 위축" 진단을 받았습니다. 이는 사지의 1급 장애입니다. 그는 자신을 완전히 돌볼 수 있는 능력이 없습니다. 삶과 공부를 위해 어머니를 돌본다.

그러나 신체적인 한계에도 불구하고 Shao Zhenwei의 지식에 대한 갈증은 약해지지 않았습니다.

2017년 대학 입시에서 644점이라는 고득점을 얻어 항저우 전자과기대학교 컴퓨터 전공에 1등으로 합격했습니다.

이 기간 동안 그는 2018년 중국 대학생 자기계발 스타, 2020년 국가 장학금, 2021년 저장성 우수 졸업생 등의 영예도 얻었습니다.

학부 기간 동안 Shao Zhenwei는 이미 Yu Zhou 교수와 함께 과학 연구 활동을 시작했습니다.

2021년 Shao Zhenwei는 대학원 진학을 준비하던 중 저장대학교를 우연히 만났고, 그 학교에 머물면서 Yu Zhou 교수의 연구 그룹에 합류하여 석사 학위를 취득했습니다. 그의 연구 방향은 교차모델 학습이다.

Yu Zhou 교수는 이 연구 논문의 두 번째 저자이자 교신저자입니다. 그는 Hangzhou Dianping University 컴퓨터 과학부의 최연소 교수이자 "복잡 시스템 모델링 및 시뮬레이션" 연구소의 부소장입니다. 교육부.

Yu Zhou는 오랫동안 다중 모드 지능 방향을 전문으로 해왔으며 연구팀을 이끌고 국제 시각적 질문 답변 챌린지 VQA Challenge에서 여러 차례 1위와 2위를 차지했습니다.

대부분의 연구팀 구성원은 Hangzhou Electronics Media Intelligence Laboratory(MIL)에 있습니다.

연구실은 국내 우수 석학인 유준 교수가 소장을 맡고 있으며, 최근 몇 년 동안 다중 모드 학습에 초점을 맞춘 고급 저널 컨퍼런스 논문(TPAMI, IJCV, CVPR 등)을 발표했습니다. IEEE 저널 컨퍼런스에서 수차례 최우수상을 수상했습니다.

이 연구실에서는 국가 핵심 R&D 계획, 중국 국립자연과학재단 등 20개 이상의 국가 프로젝트를 주관했으며, 절강성 자연과학상 1등상, 교육자연과학상 2등상을 수상했습니다.

위 내용은 항저우 전자(Hangzhou Electronics)의 직원은 GPT 이미지 판독 기능을 최초로 획득했습니다. 단일 카드로 새로운 SOTA 코드를 실현할 수 있습니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!