RNN(Recurrent Neural Network)은 시퀀스 데이터를 입력으로 받아 시퀀스의 진화 방향으로 재귀를 수행하는 네트워크 유형으로, 모든 노드(순환 단위)가 체인으로 연결된 재귀 신경 네트워크입니다. 순환신경망에 대한 연구는 1980년대와 1990년대에 시작되었으며, 21세기 초 딥러닝 알고리즘 중 하나로 발전했으며, 그 중 Bi-RNN(BiDirectional RNN)과 LSTM(Long Short-Term Memory Networks)이 일반적인 순환 신경망(Common Recurrent Neural Network)입니다. (추천 학습:

웹프론트엔드 동영상 튜토리얼)

순환 신경망은 메모리, 매개변수 공유 및 튜링 완전성(Turing Completeness)을 갖기 때문에 비선형성을 처리할 수 있습니다. 시퀀스 기능은 학습할 때 특정 이점이 있습니다.  순환 신경망은 음성 인식, 언어 모델링, 기계 번역 및 기타 분야 등 자연어 처리(NLP)에 사용되며 다양한 시계열 예측에도 사용됩니다.

순환 신경망은 음성 인식, 언어 모델링, 기계 번역 및 기타 분야 등 자연어 처리(NLP)에 사용되며 다양한 시계열 예측에도 사용됩니다.

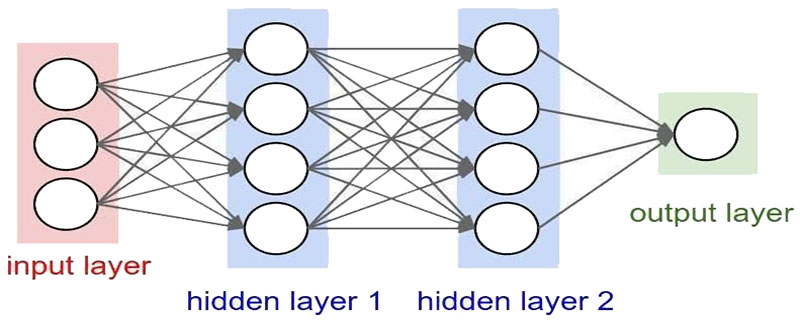

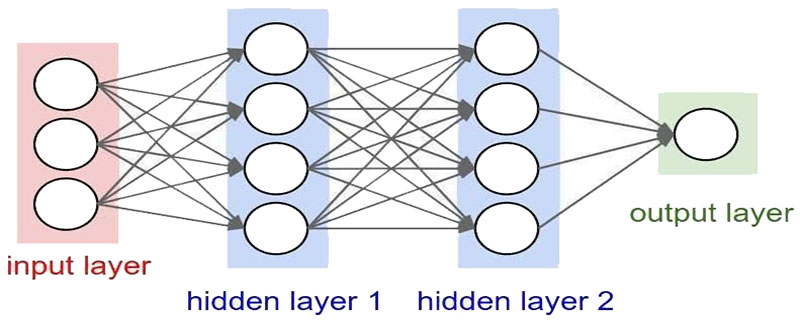

시퀀스 입력과 관련된 컴퓨터 비전 문제를 처리할 수 있는 순환 신경망을 구축하기 위한 컨볼루셔널 신경망(CNN)을 소개합니다.

SRN이 등장한 같은 시기에 순환 신경망의 학습 이론도 개발되었습니다. 역전파 알고리즘에 대한 연구가 주목을 받은 후[18], 학계에서는 BP 프레임워크 하에서 순환 신경망을 훈련시키려는 시도를 시작했습니다.

1989년 Ronald Williams와 David Zipser는 순환 신경망의 RTRL(실시간 순환 학습)을 제안했습니다. 그런 다음 Paul Werbos는 1990년에 순환 신경망을 위한 BPTT(BP Through Time)를 제안했습니다. RTRL과 BPTT는 오늘날에도 여전히 사용되고 순환 신경망을 학습하는 주요 방법입니다.

1991년 Sepp Hochreiter는 순환 신경망의 장기 의존성 문제를 발견했습니다. 즉, 시퀀스를 학습할 때 순환 신경망은 경사 소멸 및 경사 폭발 현상으로 인해 어려움을 겪게 됩니다. 장기간에 걸쳐 비선형 관계를 파악하는 것은 불가능합니다.

장기 의존성 문제를 해결하기 위해 수많은 최적화 이론이 도입되었으며 NHC(Neural History Compressor) 및 Long Short-Term Memory 네트워크를 포함하여 많은 개선된 알고리즘이 파생되었습니다. , LSTM), GRU(Gated Recurrent Unit Networks), 에코 상태 네트워크(Echo State Network), 독립 RNN 등

위 내용은 시계열 데이터 처리를 위한 신경망이란 무엇입니까?의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

순환 신경망은 음성 인식, 언어 모델링, 기계 번역 및 기타 분야 등 자연어 처리(NLP)에 사용되며 다양한 시계열 예측에도 사용됩니다.

순환 신경망은 음성 인식, 언어 모델링, 기계 번역 및 기타 분야 등 자연어 처리(NLP)에 사용되며 다양한 시계열 예측에도 사용됩니다.