REFT가 필요한 모든 것이 있습니까?

Feb 25, 2025 pm 07:49 PM

스탠포드의 2024 년 5 월 논문에 소개 된

2021 년에 도입 된 Lora의 단순성과 일반화는 미세 조정 LLM 및 확산 모델을위한 주요 기술이되었습니다. LORA는 모든 레이어 가중치를 조정하는 대신 저 순위의 매트릭스를 추가하여 훈련 가능한 매개 변수 (종종 0.3%미만)를 크게 줄이고 교육을 가속화하고 GPU 메모리 사용을 최소화합니다.

프롬프트 튜닝 : 이 방법은 "소프트 프롬프트"-문화 가능한 작업 별 임베딩을 접두사로 사용하여 각 작업의 모델을 복제하지 않고 효율적인 멀티 태스킹 예측을 가능하게합니다.

.

프롬프트 튜닝의 제한 주소 스케일로, 접두사 튜닝은 다양한 레이어에 훈련 가능한 프롬프트 임베딩을 추가하여 다른 수준에서 작업 별 학습을 허용합니다.

.

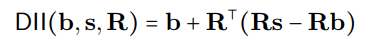

여기서

여기서  는 직교 예측을 나타내며, 분산 정렬 검색 (DAS)은 예상 반 상점 출력의 확률을 최대화하여 중재 후 하위 공간을 최적화합니다.

는 직교 예측을 나타내며, 분산 정렬 검색 (DAS)은 예상 반 상점 출력의 확률을 최대화하여 중재 후 하위 공간을 최적화합니다.

R

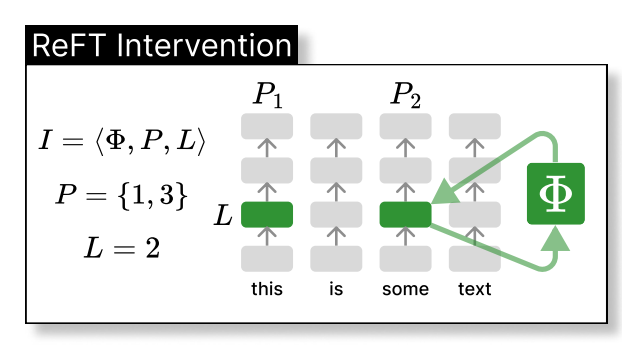

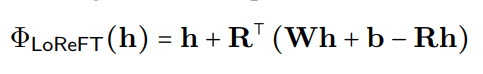

loreft (저급 선형 서브 스페이스 reft)가 배운 예상 출처를 소개합니다.

여기서

는 숨겨진 표현이며,

는에 의해 걸려있는 저 차원 공간에서  편집

편집

토론 REFT의 호소는 다양한 벤치 마크에서 Llama-Family Models와 인과 추상화의 근거가있는 Llama-Family 모델에 대한 우수한 성능에서 비롯되며, 이는 모델 해석 가능성을 돕습니다. REFT는 뉴런에 걸쳐 분포 된 선형 서브 스페이스가 수많은 작업을 효과적으로 제어 할 수 있음을 보여줍니다.

참조

Wu et al., Reft : 언어 모델에 대한 표현 미세 조정- Hu et al., Lora : 대형 언어 모델의 낮은 순위 적응 Zhuang et al., 시간 변동 Lora

- liu et al., p-tuning v2 Geiger et al. Lester et al. Pu et al.

- (참고 : 괄호 자리 표시자를 실제 연구 논문에 대한 실제 링크로 교체하십시오.)

위 내용은 REFT가 필요한 모든 것이 있습니까?의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

인기 기사

인기 기사

뜨거운 기사 태그

메모장++7.3.1

사용하기 쉬운 무료 코드 편집기

SublimeText3 중국어 버전

중국어 버전, 사용하기 매우 쉽습니다.

스튜디오 13.0.1 보내기

강력한 PHP 통합 개발 환경

드림위버 CS6

시각적 웹 개발 도구

SublimeText3 Mac 버전

신 수준의 코드 편집 소프트웨어(SublimeText3)

뜨거운 주제

7138

7138

9

9

1534

1534

14

14

1257

1257

25

25

1205

1205

29

29

1155

1155

46

46

MCP (Model Context Protocol) 란 무엇입니까?

Mar 03, 2025 pm 07:09 PM

MCP (Model Context Protocol) 란 무엇입니까?

Mar 03, 2025 pm 07:09 PM

MCP (Model Context Protocol) 란 무엇입니까?

Omniparser V2 및 Omnitool을 사용하여 지역 비전 에이전트 구축

Mar 03, 2025 pm 07:08 PM

Omniparser V2 및 Omnitool을 사용하여 지역 비전 에이전트 구축

Mar 03, 2025 pm 07:08 PM

Omniparser V2 및 Omnitool을 사용하여 지역 비전 에이전트 구축

활주로 ACT-One Guide : 나는 그것을 테스트하기 위해 스스로 촬영했다

Mar 03, 2025 am 09:42 AM

활주로 ACT-One Guide : 나는 그것을 테스트하기 위해 스스로 촬영했다

Mar 03, 2025 am 09:42 AM

활주로 ACT-One Guide : 나는 그것을 테스트하기 위해 스스로 촬영했다

Elon Musk & Sam Altman은 5 천억 달러 이상의 Stargate 프로젝트를 충돌시킵니다.

Mar 08, 2025 am 11:15 AM

Elon Musk & Sam Altman은 5 천억 달러 이상의 Stargate 프로젝트를 충돌시킵니다.

Mar 08, 2025 am 11:15 AM

Elon Musk & Sam Altman은 5 천억 달러 이상의 Stargate 프로젝트를 충돌시킵니다.

DeepSeek은 3FS 및 Smallpond 프레임 워크를 릴리스합니다

Mar 03, 2025 pm 07:07 PM

DeepSeek은 3FS 및 Smallpond 프레임 워크를 릴리스합니다

Mar 03, 2025 pm 07:07 PM

DeepSeek은 3FS 및 Smallpond 프레임 워크를 릴리스합니다

나는 Cursor AI와 함께 Vibe 코딩을 시도했는데 놀랍습니다!

Mar 20, 2025 pm 03:34 PM

나는 Cursor AI와 함께 Vibe 코딩을 시도했는데 놀랍습니다!

Mar 20, 2025 pm 03:34 PM

나는 Cursor AI와 함께 Vibe 코딩을 시도했는데 놀랍습니다!