대형 모델을 통해 현실 세계에 대한 이해를 스스로 형성할 수 있습니다!

MIT의 연구에 따르면 모델의 능력이 향상될수록 현실에 대한 이해가 단순한 모방을 넘어설 수 있다는 사실이 밝혀졌습니다.

예를 들어, 대형 모델이 냄새를 맡아본 적이 없다면 냄새를 이해할 수 없다는 뜻인가요?

연구에 따르면 쉽게 이해할 수 있도록 일부 개념을 자발적으로 시뮬레이션할 수 있는 것으로 나타났습니다.

이 연구는 앞으로 대형 모델이 언어와 세계에 대한 더 깊은 이해를 가질 것으로 기대된다는 것을 의미합니다. 이 논문은 최고의 컨퍼런스 ICML 24에 채택되었습니다.

이 논문의 저자는 중국의 박사과정 학생인 Charles Jin과 그의 지도교수인 MIT CSAIL(Computer and Artificial Intelligence Laboratory)의 Martin Rinard 교수입니다.

연구에서 저자는 대형 모델에게 코드 텍스트만 학습하도록 요청했고, 모델이 점차 그 뒤에 숨은 의미를 파악하는 것을 발견했습니다.

Rinard 교수는 이 연구가 현대 인공 지능의 핵심 질문을 직접적으로 다루고 있다고 말했습니다.

대형 모델의 기능이 단순히 대규모 통계 상관 관계에 기인하는 것인지, 아니면 그들이 다루는 실제 문제에 대한 의미 있는 이해를 생성하는 것인지 와 함께? ?

Δ출처: MIT 공식 홈페이지

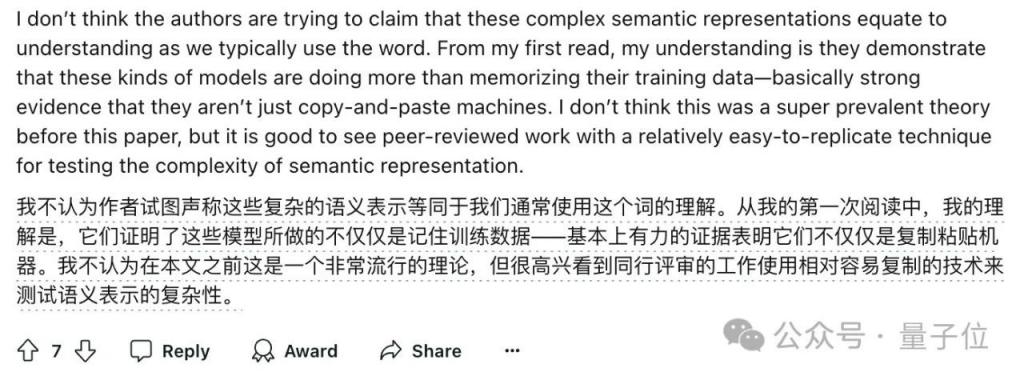

동시에 이 연구는 많은 논의를 불러일으키기도 했습니다.

일부 네티즌들은 대형 모델이 인간과 다르게 언어를 이해할 수 있지만 적어도 이 연구는 모델이 단순히 훈련 데이터를 기억하는 것 이상의 역할을 한다는 것을 보여준다고 말했습니다.

대형 모델이 순수 코드를 학습하게 하세요

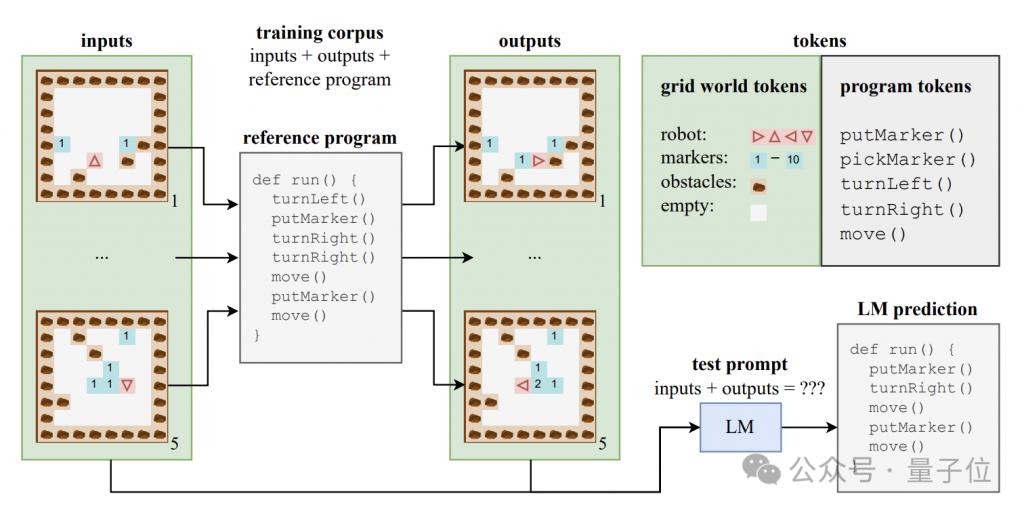

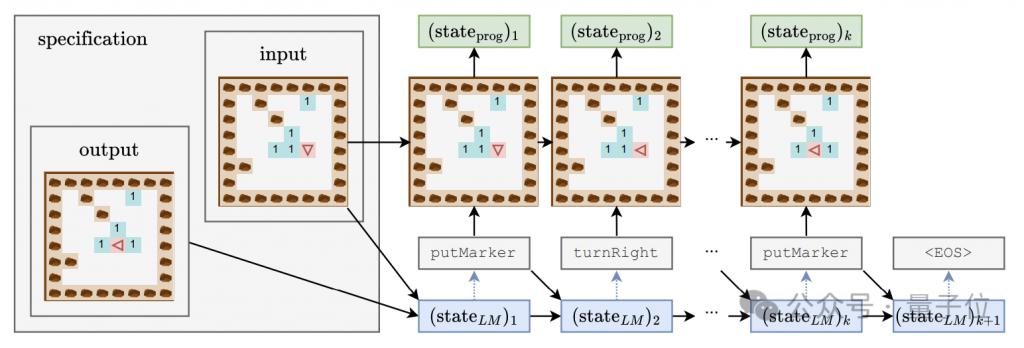

대형 모델이 의미 수준의 이해를 생성할 수 있는지 알아보기 위해 저자는 프로그램 코드와 해당 입력 및 출력으로 구성된 합성 데이터 세트를 구성했습니다.

이 코드 프로그램은 Karel이라는 교육 언어로 작성되었으며 주로 2D 그리드 세계에서 탐색하는 로봇의 작업을 구현하는 데 사용됩니다.

이 그리드 세계는 8x8 그리드로 구성되어 있으며 각 그리드에는 장애물, 마커 또는 열린 공간이 포함될 수 있습니다. 로봇은 그리드 사이를 이동하고 마커 배치/집기 등의 작업을 수행할 수 있습니다.

Karel 언어에는 move(한 단계 앞으로),turnLeft(왼쪽으로 90도 회전),turnRight(오른쪽으로 90도 회전), pickMarker(마커 선택), putMarker(마커 배치) 등 5가지 기본 작업이 포함되어 있으며 프로그램은 다음과 같이 구성됩니다. 이러한 기본 작업의 시퀀스입니다.

저자는 각 프로그램 길이가 6에서 10 사이인 500,000개의 Karel 프로그램이 포함된 훈련 세트를 무작위로 생성했습니다.

각 훈련 샘플은 5개의 입력 상태, 5개의 출력 상태 및 전체 프로그램 코드의 세 부분으로 구성됩니다. 입력 및 출력 상태는 특정 형식의 문자열로 인코딩됩니다.

이 데이터를 사용하여 저자는 표준 Transformer 아키텍처의 CodeGen 모델 변형을 교육했습니다.

훈련 과정에서 모델은 각 샘플의 입력 및 출력 정보와 프로그램 접두사에 액세스할 수 있지만 프로그램 실행의 전체 궤적과 중간 상태는 볼 수 없습니다.

학습 세트 외에도 저자는 모델의 일반화 성능을 평가하기 위해 10,000개의 샘플이 포함된 테스트 세트도 구성했습니다.

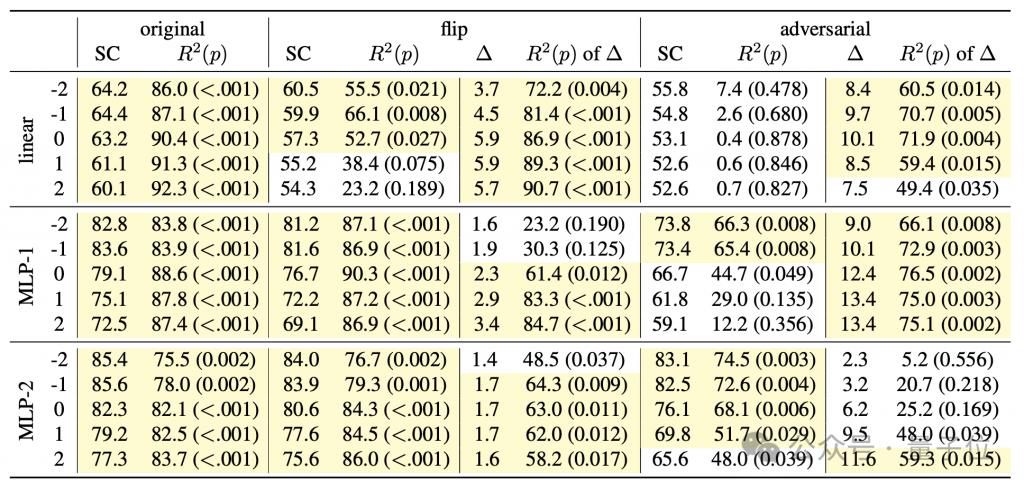

언어 모델이 코드 뒤의 의미를 파악하는지 연구하고 동시에 모델의 "사고 과정"에 대한 깊은 이해를 얻기 위해 저자는 선형 분류기와 단일/분류기를 포함한 일련의 감지기 조합을 설계했습니다. 이중 은닉층 MLP.

검출기의 입력은 프로그램 토큰을 생성하는 과정에서 언어 모델의 숨겨진 상태이고, 예측 대상은 프로그램 실행의 중간 상태이며, 구체적으로는 로봇의 방향(방향), 초기 위치에 대한 오프셋 등이 포함됩니다. (위치), 그리고 정면이 장애물(장애물)을 향하고 있는지 여부가 이 세 가지 특징입니다.

생성 모델의 훈련 과정에서 저자는 위의 세 가지 특징을 4000단계마다 기록했고, 생성 모델의 은닉 상태도 기록하여 검출기에 대한 훈련 데이터 세트를 구성했습니다.

대형 모델 학습의 3단계

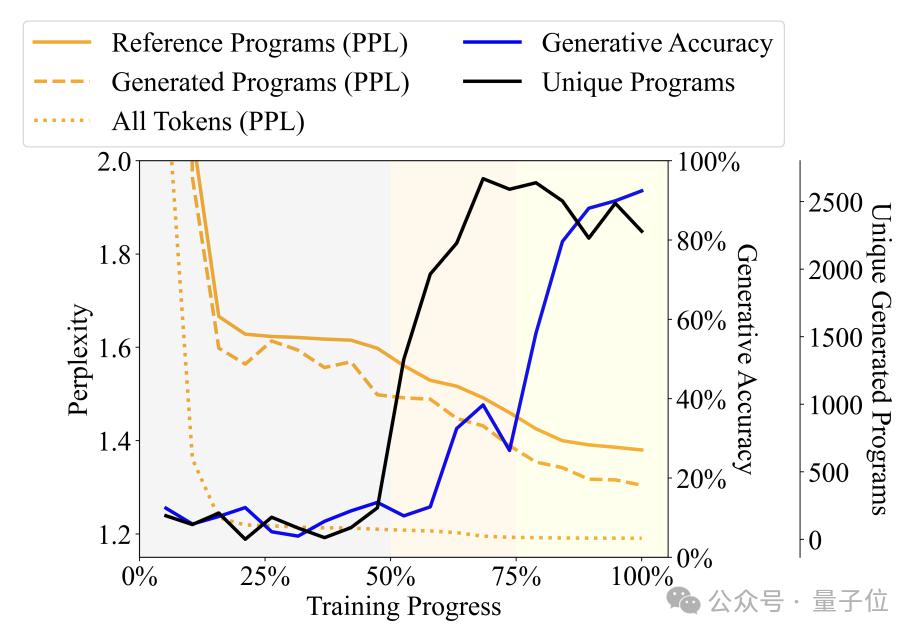

학습 과정을 통해 언어 모델이 생성한 프로그램의 다양성, 난해함 및 기타 지표의 변화를 관찰하여 저자는 학습 과정을 3단계로 나누었습니다.

옹알이(말도 안 되는) 단계: 출력 프로그램이 매우 반복적이고 검출기 정확도가 불안정합니다.

문법 습득 단계: 프로그램 다양성이 빠르게 증가하고 생성 정확도가 약간 증가하며 혼란이 감소합니다. 이는 언어 모델이 프로그램의 구문 구조를 학습했음을 나타냅니다.

의미론적 획득 단계: 프로그램 다양성 및 구문 구조 숙달 정도는 안정적이지만 생성 정확도 및 검출기 성능이 크게 향상되어 언어 모델이 프로그램의 의미론을 학습했음을 나타냅니다.

구체적으로 Babbling 단계는 전체 훈련 과정의 처음 50%를 차지합니다. 예를 들어 훈련이 약 20%에 도달하면 어떤 사양이 입력되든 모델은 고정된 프로그램인 "pickMarker"만 생성합니다. 9회 반복하세요.

문법 습득 단계는 훈련 과정의 50%~75%입니다. Karel 프로그램에서 모델의 난해함은 크게 감소했습니다. 이는 언어 모델이 언어 모델의 통계적 특성에 더 잘 적응하기 시작했음을 나타냅니다. Karel 프로그램이지만 생성된 프로그램의 정확도는 크게 향상되지 않았으며(약 10%에서 약 25%) 여전히 작업을 정확하게 완료할 수 없습니다.

의미적 획득 단계는 최종 25%이며, 프로그램의 정확도는 약 25%에서 90% 이상으로 획기적으로 향상되었으며, 생성된 프로그램은 주어진 작업을 정확하게 완료할 수 있습니다.

추가 실험에서는 검출기가 시간 t에서 동기화된 시간 단계를 예측할 수 있을 뿐만 아니라 후속 시간 단계의 프로그램 실행 상태도 예측할 수 있다는 사실이 밝혀졌습니다.

예를 들어 생성 모델이 시간 t에 "move" 토큰을 생성하고 시간 t+1에 "turnLeft"를 생성한다고 가정합니다.

동시에 시간 t의 프로그램 상태는 로봇이 북쪽을 향하고 좌표 (0,0)에 있는 반면, 시간 t+1의 로봇은 로봇이 북쪽을 향하고 있는 것입니다. 위치는 변경되지 않은 채 서쪽을 향하게 됩니다.

검출기가 시간 t의 언어 모델의 숨겨진 상태로부터 로봇이 시간 t+1에 서쪽을 향할 것이라고 성공적으로 예측할 수 있다면 이는 숨겨진 상태가 "를 생성하기 전에 이미 포함되어 있음을 의미합니다. TurnLeft" 이 작업으로 가져온 상태 변경 정보입니다.

이러한 현상은 모델이 생성된 프로그램 부분에 대한 의미론적 이해를 갖고 있을 뿐만 아니라, 생성의 각 단계에서 다음에 생성될 콘텐츠를 이미 예상하고 계획하고 있음을 보여줍니다. 예비적인 미래지향적 추론 능력.

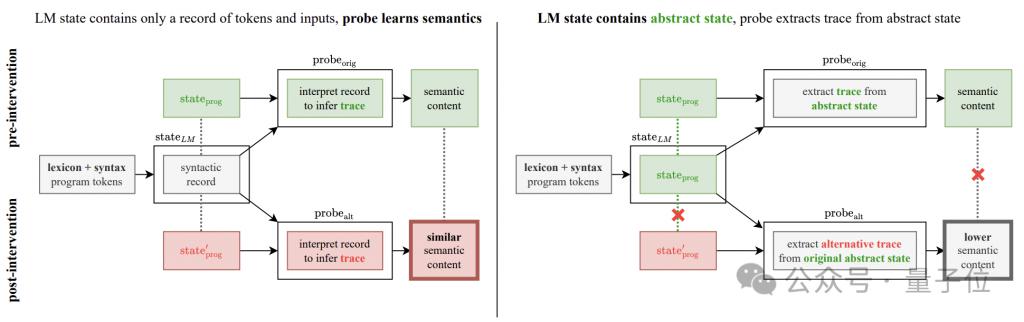

그러나 이 발견은 이 연구에 새로운 질문을 가져왔습니다.

실험에서 관찰된 정확도 향상은 실제로 생성 모델의 개선입니까, 아니면 다음의 결과입니까? 탐지기 자체의 추론?

이 의심을 해결하기 위해 저자는 의미 탐지 개입 실험을 추가했습니다.

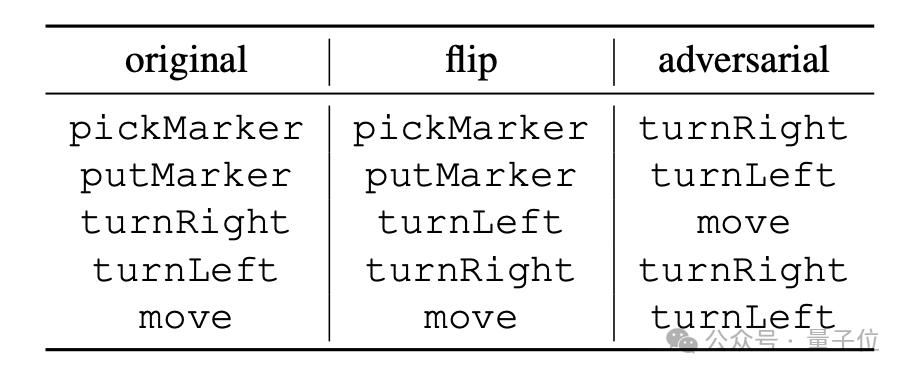

실험의 기본 아이디어는 프로그램 연산의 의미 해석 규칙을 변경하는 것으로, "플립"과 "뒤집기"라는 두 가지 방법으로 나뉩니다. "적대적".

"flip"은 명령의 의미를 강제로 뒤집는 것입니다. 예를 들어 "turnRight"는 "turn Left"로 강제 해석됩니다. 그러나 "turnLeft" 및 "turnRight"만 이를 수행할 수 있습니다. 일종의 반전; # #

"adversarial"은 모든 명령어에 해당하는 의미를 무작위로 뒤섞습니다. 구체적인 방법은 아래 표와 같습니다.

# # [ 1 ] https://news.mit.edu/2024/llms-develop-own-understanding-of-reality-as-lang-abilities-improve-0814

[ 2 ] https://www.reddit.com/r/LocalLLaMA/comments/1esxkin/llms_develop_their_own_understanding_of_reality/

위 내용은 빅 모델은 언어에 대한 자신의 이해를 가지고 있습니다! MIT 논문에서 밝혀진 대형 모델의 '사고 과정'의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!