방금 끝난 세계 개발자 컨퍼런스에서 Apple은 iOS 18, iPadOS 18 및 macOS Sequoia에 깊이 통합된 새로운 개인화된 인텔리전스 시스템인 Apple Intelligence를 발표했습니다.

Apple+ Intelligence는 사용자의 일상 작업을 위해 설계된 다양한 고도로 지능적인 생성 모델로 구성됩니다. 최근 업데이트된 Apple 블로그에서는 두 가지 모델에 대해 자세히 설명했습니다.

이 두 기본 모델은 Apple의 생성 모델 제품군의 일부이며 Apple은 가까운 시일 내에 이 모델 제품군에 대한 자세한 정보를 공유할 것이라고 밝혔습니다.

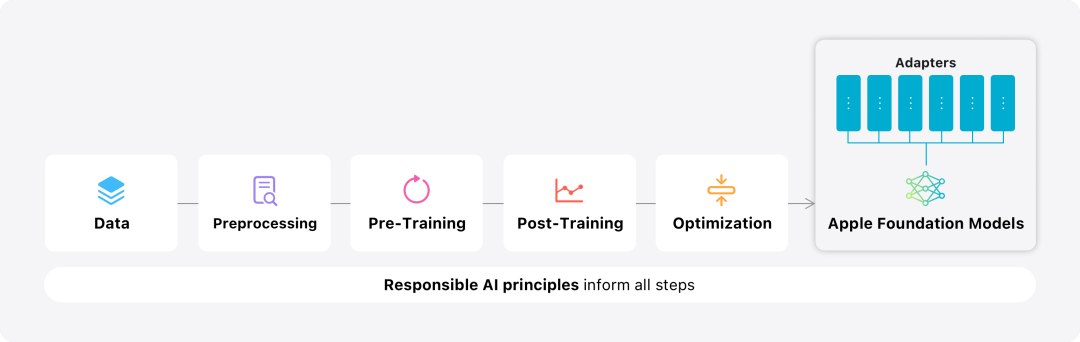

이 블로그에서 Apple은 고성능, 빠르고 에너지 효율적인 모델을 개발하는 방법, 특정 사용자 요구에 맞게 어댑터를 미세 조정하는 방법, 모델을 평가하는 방법을 소개하는 데 많은 시간을 할애합니다. 우발적인 부상의 측면에서 성능을 돕고 방지합니다.型 Apple 기본 모델 모델링 개요

사전 교육

기본 모델은 Axlearn 프레임워크에서 교육됩니다. 2023년에 출시된 Apple 오픈 소스 프로젝트입니다. 프레임워크는 JAX 및 XLA를 기반으로 구축되어 사용자가 클라우드 및 온프레미스의 TPU 및 GPU를 포함하여 다양한 하드웨어 및 클라우드 플랫폼에서 모델을 효율적이고 확장 가능하게 훈련할 수 있습니다. 또한 Apple은 데이터 병렬성, 텐서 병렬성, 시퀀스 병렬성 및 FSDP와 같은 기술을 사용하여 데이터, 모델 및 시퀀스 길이와 같은 여러 차원에 따라 교육을 확장합니다.

Apple은 기본 모델을 훈련할 때 승인된 데이터를 사용합니다. 여기에는 Apple의 웹 크롤러인 AppleBot이 공용 네트워크에서 수집한 데이터뿐만 아니라 특정 기능을 향상시키기 위해 특별히 선택된 데이터도 포함됩니다. 웹 콘텐츠 게시자는 데이터 사용 제어를 설정하여 웹 콘텐츠가 Apple Intelligence 교육에 사용되지 않도록 선택할 수 있습니다.

Apple은 기본 모델을 훈련할 때 사용자의 개인 데이터를 절대 사용하지 않습니다. 개인 정보를 보호하기 위해 필터를 사용하여 인터넷에 공개적으로 제공되는 신용 카드 번호와 같은 개인 식별 정보를 제거합니다. 또한 저속한 언어와 기타 품질이 낮은 콘텐츠를 훈련 데이터 세트에 넣기 전에 필터링합니다. 이러한 필터링 조치 외에도 Apple은 데이터 추출 및 중복 제거를 수행하고 모델 기반 분류자를 사용하여 교육용 고품질 문서를 식별하고 선택합니다.

사후 훈련

Apple은 데이터 품질이 모델에 중요하다는 사실을 알고 훈련 과정에서 하이브리드 데이터 전략, 즉 수동으로 주석을 단 데이터와 합성 데이터를 채택했습니다. 종합적인 데이터 관리 및 필터링 절차를 수행했습니다. Apple은 훈련 후 단계에서 두 가지 새로운 알고리즘을 개발했습니다. (1) "교사 위원회"를 통한 거부 샘플링 미세 조정 알고리즘, (2) 미러 하강 전략 최적화 및 Leave-One-Out을 사용한 인간 피드백 강화 장점 추정기 학습(RLHF) 알고리즘. 이 두 가지 알고리즘은 모델의 지시에 따른 품질을 크게 향상시킵니다.

Optimization

Apple은 생성된 모델 자체의 고성능을 보장하는 것 외에도 다양한 혁신적인 기술을 사용하여 장치 및 프라이빗 클라우드에서 모델을 최적화하여 속도와 효율성 . 특히, 모델의 빠른 응답과 효율적인 운영을 보장하기 위해 첫 번째 토큰(단일 문자 또는 단어의 기본 단위)과 후속 토큰을 생성하는 모델의 추론 프로세스를 많은 최적화했습니다.

Apple은 효율성을 높이기 위해 장치측 모델과 서버 모델 모두에서 그룹 쿼리 주의 메커니즘을 사용합니다. 메모리 요구 사항과 추론 비용을 줄이기 위해 매핑 중에 중복되지 않는 공유 입력 및 출력 어휘 임베딩 테이블을 사용합니다. 장치측 모델의 어휘는 49,000개이고, 서버 모델의 어휘는 100,000개입니다.

기기 측 추론을 위해 Apple은 필요한 메모리, 전력 소비 및 성능 요구 사항을 충족할 수 있는 핵심 최적화 기술인 낮은 비트 팔레타이제이션을 사용합니다. 모델 품질을 유지하기 위해 Apple은 하이브리드 2비트 및 4비트 구성 전략(무게당 평균 3.5비트)을 결합하여 압축되지 않은 모델과 동일한 정확도를 달성하는 LoRA 어댑터를 사용하는 새로운 프레임워크도 개발했습니다.

또한 Apple은 대화형 모델 지연 시간 및 전력 분석 도구인 Talaria와 활성화 양자화 및 임베딩 양자화를 사용하고 Neural Engine에서 효율적인 키-값(KV) 캐시 업데이트를 구현하는 방법을 개발했습니다.

이러한 일련의 최적화를 통해 iPhone 15 Pro에서는 모델이 프롬프트 단어를 수신할 때 프롬프트 단어를 수신한 후 첫 번째 토큰을 생성하는 데 걸리는 시간이 약 0.6밀리초로 매우 짧습니다. 모델은 초당 30개 토큰의 속도로 매우 빠르게 응답을 생성합니다.

모델 적응

Apple은 기본 모델을 사용자의 일상 활동에 맞게 미세 조정하고 현재 작업에 맞게 동적으로 특화할 수 있습니다.

연구팀은 사전 훈련된 모델의 다양한 계층에 연결할 수 있는 작은 신경망 모듈인 어댑터를 사용하여 특정 작업에 맞게 모델을 미세 조정합니다. 구체적으로 연구팀은 포인트별 피드포워드 네트워크에서 어텐션 매트릭스, 어텐션 투영 매트릭스, 완전 연결 레이어를 조정했습니다.

어댑터 계층만 미세 조정하면 사전 학습된 기본 모델의 원래 매개변수는 변경되지 않고 모델에 대한 일반적인 지식을 유지하는 동시에 특정 작업을 지원하도록 어댑터 계층을 조정합니다.

그림 2: 어댑터는 공통 기본 모델 위에 겹쳐진 모델 가중치의 작은 컬렉션입니다. 동적으로 로드하고 교환할 수 있으므로 기본 모델이 현재 작업을 동적으로 전문화할 수 있습니다. Apple Intelligence에는 각각 특정 기능에 맞게 미세 조정된 광범위한 어댑터 세트가 포함되어 있습니다. 이는 기본 모델의 기능을 확장하는 효율적인 방법입니다.

연구팀은 약 30억 개의 매개변수가 있는 장치 모델의 경우 16비트를 사용하여 어댑터 매개변수 값을 특성화하는데 일반적으로 16개 어댑터의 매개변수에 10MB가 필요합니다. 어댑터 모델은 동적으로 로드되고 메모리에 임시로 캐시되며 교환될 수 있습니다. 이를 통해 기본 모델은 현재 작업을 동적으로 전문화하는 동시에 메모리를 효율적으로 관리하고 운영 체제 응답성을 보장할 수 있습니다.

Apple은 어댑터 교육을 용이하게 하기 위해 기본 모델 또는 교육 데이터가 업데이트될 때 어댑터를 신속하게 재교육, 테스트 및 배포할 수 있는 효율적인 인프라를 만들었습니다.

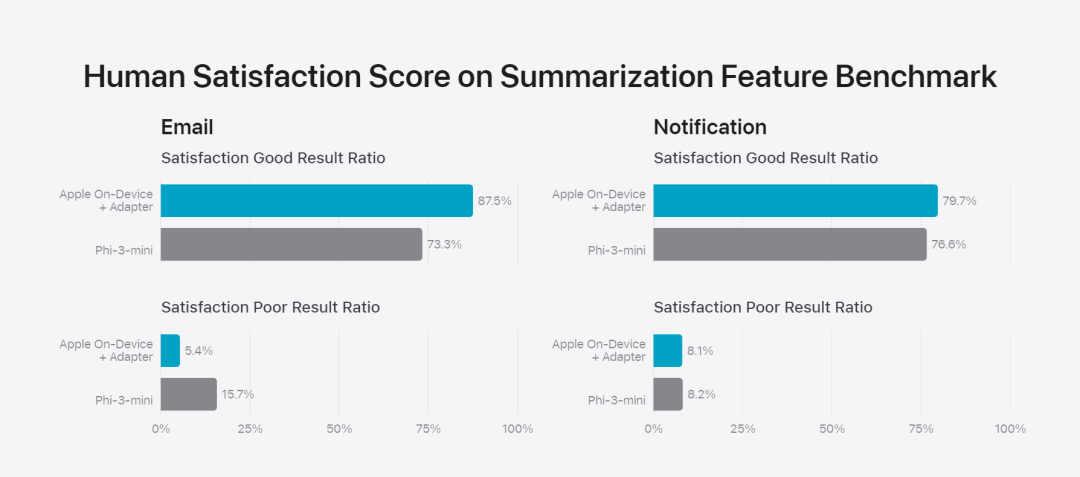

Apple은 인간의 평가 결과가 제품의 사용자 경험과 높은 상관관계가 있기 때문에 모델을 벤치마킹할 때 인간의 평가에 중점을 둡니다.

제품별 요약 기능을 평가하기 위해 연구팀은 각 사용 사례에 대해 신중하게 샘플링된 750개의 응답 세트를 사용했습니다. 평가 데이터 세트는 제품 기능이 생산 과정에서 직면할 수 있는 다양한 입력을 강조하며, 다양한 콘텐츠 유형과 길이의 단일 문서와 누적 문서의 계층화된 혼합을 포함합니다. 실험 결과에 따르면 어댑터가 있는 모델이 유사한 모델보다 더 나은 요약을 생성할 수 있는 것으로 나타났습니다.

책임 있는 개발의 일환으로 Apple은 초록에 내재된 특정 위험을 식별하고 평가합니다. 예를 들어, 요약은 때때로 중요한 뉘앙스나 기타 세부 사항을 제거합니다. 그러나 연구팀은 다이제스트 어댑터가 표적화된 적대적 샘플의 99% 이상에서 민감한 콘텐츠를 증폭하지 않는다는 사실을 발견했습니다. 용 그림 3: 추상적 사용 사례에서 '좋음'과 '차이'의 비율.

연구팀은 기본 모델과 어댑터가 지원하는 특정 기능을 평가하는 것 외에도 기기 내 모델과 서버 기반 모델의 일반적인 기능도 평가했습니다. 특히 연구팀은 브레인스토밍, 분류, 비공개 Q&A, 코딩, 추출, 수학적 추론, 공개 Q&A, 재작성, 보안, 요약 및 작성을 포함하는 포괄적인 실제 프롬프트 세트를 사용하여 모델 기능을 테스트했습니다.

그림 2: 어댑터는 공통 기본 모델 위에 겹쳐진 모델 가중치의 작은 컬렉션입니다. 동적으로 로드하고 교환할 수 있으므로 기본 모델이 현재 작업을 동적으로 전문화할 수 있습니다. Apple Intelligence에는 각각 특정 기능에 맞게 미세 조정된 광범위한 어댑터 세트가 포함되어 있습니다. 이는 기본 모델의 기능을 확장하는 효율적인 방법입니다.

연구팀은 약 30억 개의 매개변수가 있는 장치 모델의 경우 16비트를 사용하여 어댑터 매개변수 값을 특성화하는데 일반적으로 16개 어댑터의 매개변수에 10MB가 필요합니다. 어댑터 모델은 동적으로 로드되고 메모리에 임시로 캐시되며 교환될 수 있습니다. 이를 통해 기본 모델은 현재 작업을 동적으로 전문화하는 동시에 메모리를 효율적으로 관리하고 운영 체제 응답성을 보장할 수 있습니다.

Apple은 어댑터 교육을 용이하게 하기 위해 기본 모델 또는 교육 데이터가 업데이트될 때 어댑터를 신속하게 재교육, 테스트 및 배포할 수 있는 효율적인 인프라를 만들었습니다.

Apple은 인간의 평가 결과가 제품의 사용자 경험과 높은 상관관계가 있기 때문에 모델을 벤치마킹할 때 인간의 평가에 중점을 둡니다.

제품별 요약 기능을 평가하기 위해 연구팀은 각 사용 사례에 대해 신중하게 샘플링된 750개의 응답 세트를 사용했습니다. 평가 데이터 세트는 제품 기능이 생산 과정에서 직면할 수 있는 다양한 입력을 강조하며, 다양한 콘텐츠 유형과 길이의 단일 문서와 누적 문서의 계층화된 혼합을 포함합니다. 실험 결과에 따르면 어댑터가 있는 모델이 유사한 모델보다 더 나은 요약을 생성할 수 있는 것으로 나타났습니다.

책임 있는 개발의 일환으로 Apple은 초록에 내재된 특정 위험을 식별하고 평가합니다. 예를 들어, 요약은 때때로 중요한 뉘앙스나 기타 세부 사항을 제거합니다. 그러나 연구팀은 다이제스트 어댑터가 표적화된 적대적 샘플의 99% 이상에서 민감한 콘텐츠를 증폭하지 않는다는 사실을 발견했습니다. 용 그림 3: 추상적 사용 사례에서 '좋음'과 '차이'의 비율.

연구팀은 기본 모델과 어댑터가 지원하는 특정 기능을 평가하는 것 외에도 기기 내 모델과 서버 기반 모델의 일반적인 기능도 평가했습니다. 특히 연구팀은 브레인스토밍, 분류, 비공개 Q&A, 코딩, 추출, 수학적 추론, 공개 Q&A, 재작성, 보안, 요약 및 작성을 포함하는 포괄적인 실제 프롬프트 세트를 사용하여 모델 기능을 테스트했습니다.

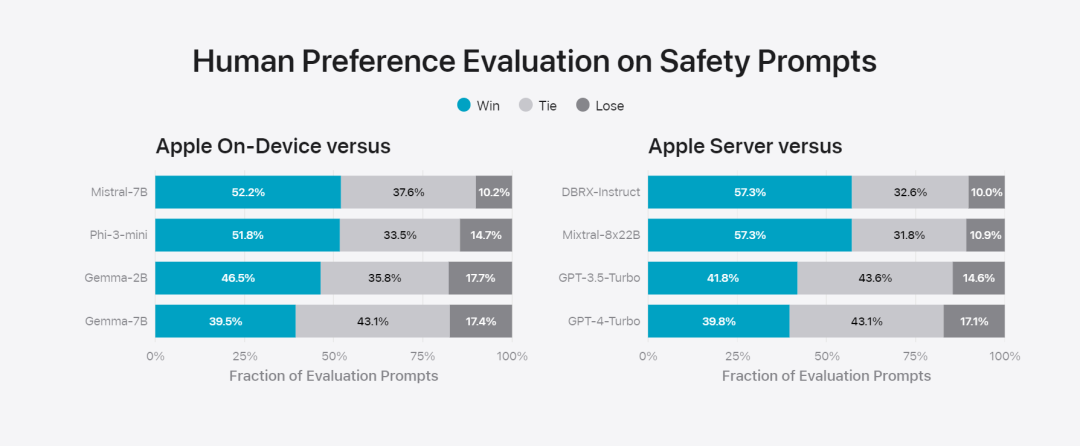

연구팀은 해당 모델을 오픈소스 모델(Phi-3, Gemma, Mistral, DBRX)과 동급 규모의 상용 모델(GPT-3.5-Turbo, GPT-4-Turbo)과 비교했습니다. Apple의 모델은 대부분의 경쟁 모델에 비해 인간 평가자들이 선호하는 것으로 나타났습니다. 예를 들어 ~3B 매개변수를 갖춘 Apple의 온디바이스 모델은 Phi-3-mini, Mistral-7B 및 Gemma-7B를 포함한 대형 모델보다 성능이 뛰어납니다. DBRX-Instruct, Mixtral-8x22B 및 GPT-3.5 -Turbo 비교해도 열등하지 않으며 동시에 매우 효율적입니다.基 그림 4: Apple 기본모델과 비교모델 평가에서 응답비율의 비율.

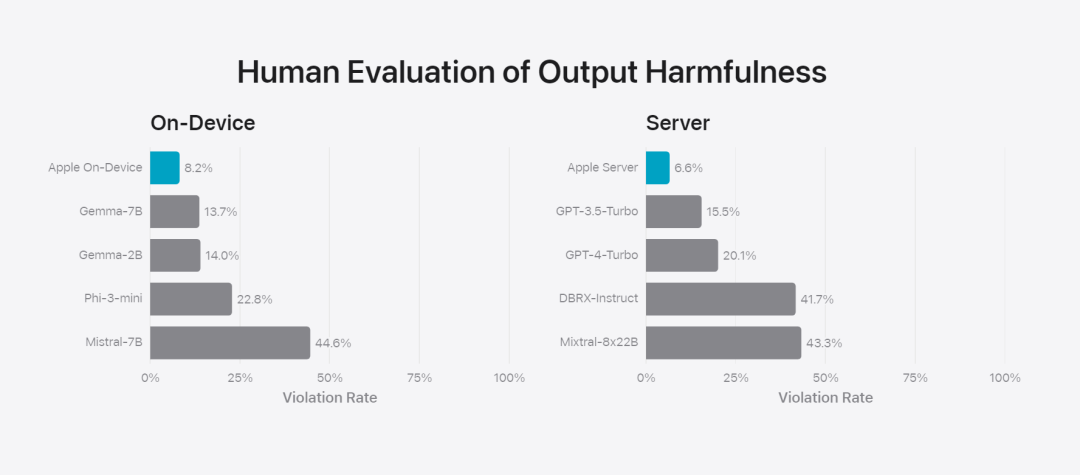

연구팀은 또한 다양한 적대적 프롬프트 세트를 사용하여 유해한 콘텐츠, 민감한 주제 및 사실에 대한 모델 성능을 테스트하고 인간 평가자가 평가한 모델 위반률을 측정했습니다. 숫자가 낮을수록 좋습니다. 좋은. 적대적 프롬프트에 직면한 온디바이스 모델과 서버 모델 모두 강력하며 오픈 소스 및 상용 모델보다 위반률이 낮습니다.、 그림 5: 유해 콘텐츠, 민감한 주제 및 사실성 비율(낮을수록 좋음). Apple의 모델은 적대적인 메시지에 직면했을 때 매우 강력합니다.

Apple은 수동 및 자동화된 레드 팀의 내부 및 외부 팀과 적극적으로 협력하여 모델의 보안을 추가로 평가하고 있습니다.

그림 6: 보안 메시지 측면에서 Apple의 기본 모델과 유사 모델에 대한 병행 평가에서 선호하는 응답의 비율. 인간 평가자들은 Apple 기본 모델의 반응이 더 안전하고 더 유용하다는 것을 발견했습니다.

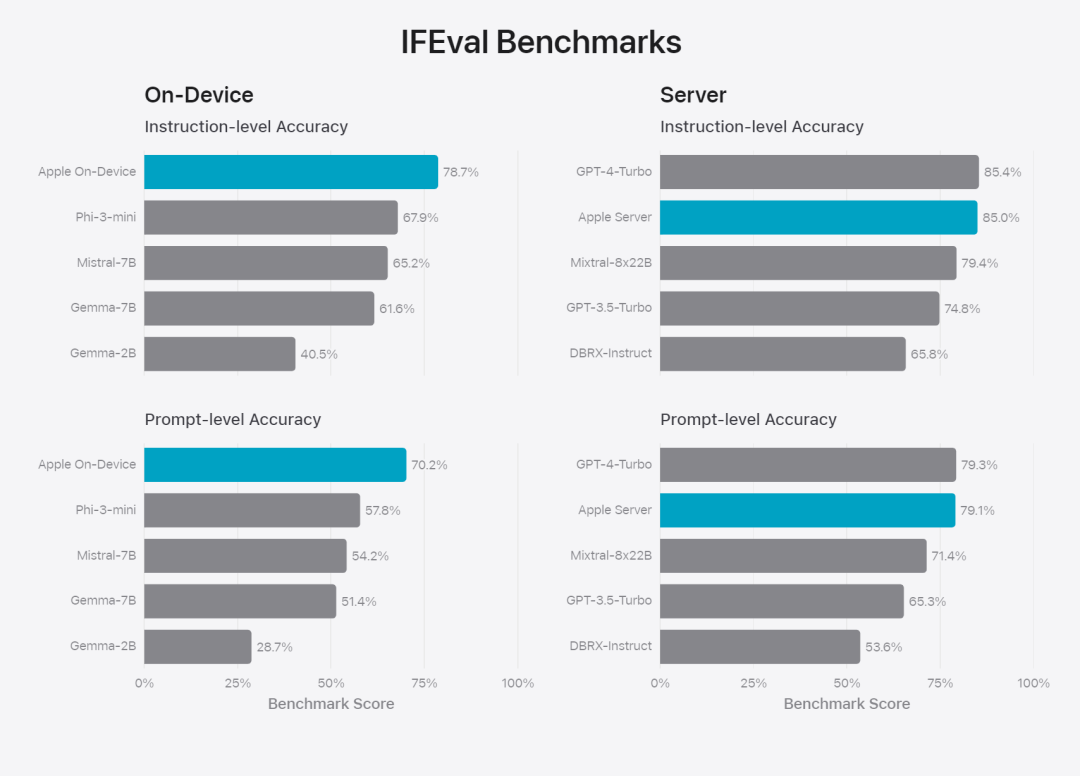

모델을 추가로 평가하기 위해 연구팀은 IFEval(명령 추적 평가) 벤치마크를 사용하여 비슷한 크기의 모델과 명령 추적 기능을 비교했습니다. 결과에 따르면 온디바이스 모델과 서버 모델 모두 동일한 규모의 오픈 소스 및 상용 모델보다 자세한 지침을 더 잘 따르는 것으로 나타났습니다.基 그림 7: Apple 기본 모델 및 유사한 규모 모델의 명령 추적 기능(IFEVAL 벤치마크 사용)

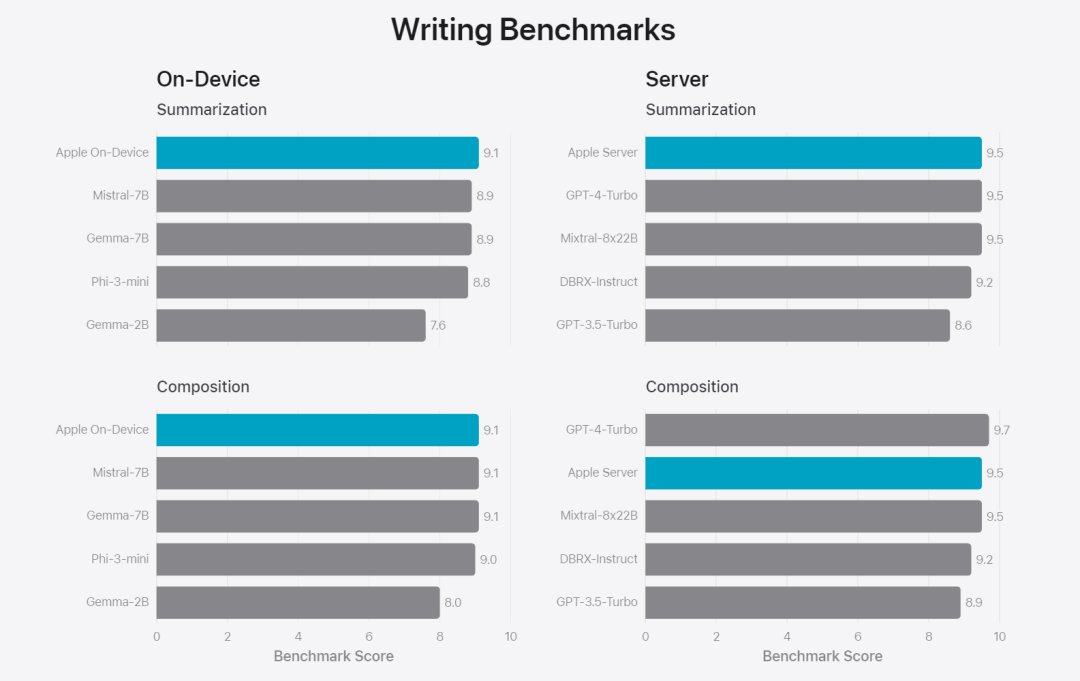

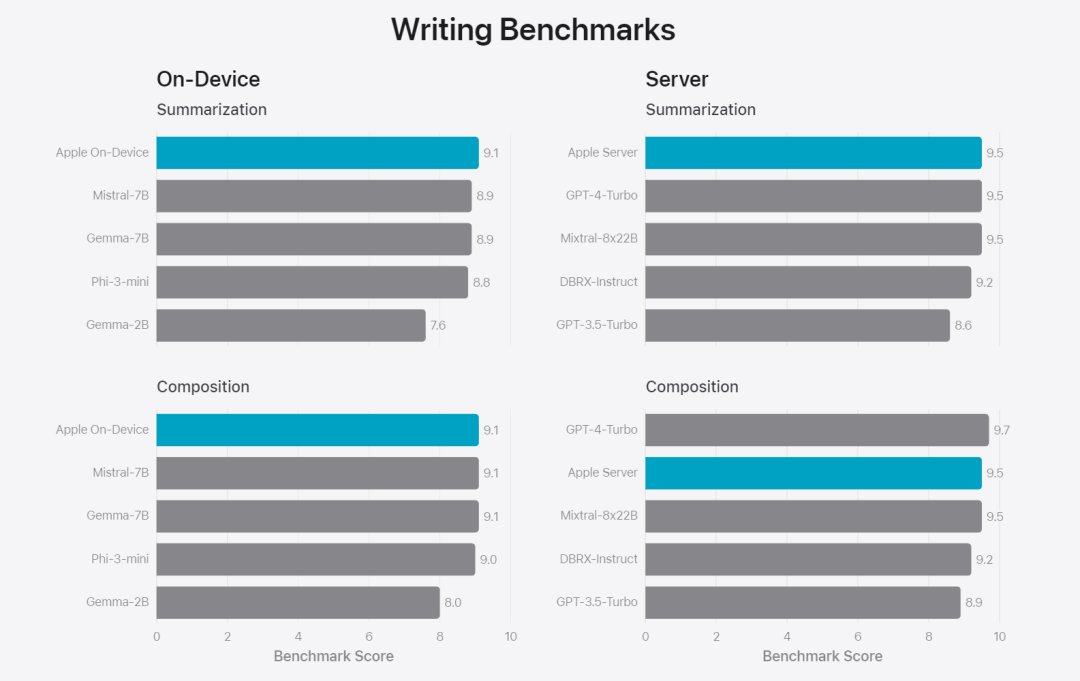

Apple은 다양한 쓰기 지침을 포함하여 모델의 쓰기 능력도 평가했습니다. ㅋㅋㅋ 그림 8: 쓰기 능력(높을수록 좋음)

).

마지막으로 Apple Intelligence의 기술을 소개하는 Apple의 영상을 살펴보겠습니다.

참조 링크: https://machinelearning.apple.com/research/introducing-apple-foundation-models

위 내용은 Apple의 인텔리전스 뒤에 있는 모델이 발표되었습니다. 3B 모델은 Gemma-7B보다 우수하고 서버 모델은 GPT-3.5-Turbo와 비슷합니다.의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!