AI 분야에서 스케일링 법칙은 LM 스케일링 추세를 이해하는 데 유용한 도구입니다. 이 법칙은 연구자에게 스케일링에 따라 언어 모델의 성능이 어떻게 변하는지 이해하는 데 중요한 지침을 제공합니다. 하지만 불행하게도 대부분의 연구자는 스케일링 법칙을 처음부터 구축할 수 있는 계산 리소스가 없고 개방형 모델의 트레이닝 스케일이 너무 적어서 신뢰할 수 있는 벤치마킹 및 사후 학습 연구에서는 스케일링 분석이 일반적이지 않습니다. 확장 예측. 스탠포드 대학, 토론토 대학 및 기타 기관의 연구원들은 언어 모델(LM)의 기능과 여러 모델 계열의 다운스트림 성능을 결합한 관찰 확장 법칙이라는 대안적인 관찰 방법을 제안했습니다. 표준 계산 확장 법칙의 경우와 마찬가지로 단일 계열입니다. 이 방법은 모델 교육을 우회하고 대신 공개적으로 사용 가능한 약 80개 모델을 기반으로 확장 법칙을 구축합니다. 그러나 이는 또 다른 문제로 이어집니다. 여러 모델군에서 단일 확장 법칙을 구성하는 것은 서로 다른 모델 간의 훈련 계산 효율성과 기능의 큰 차이로 인해 큰 어려움에 직면합니다. 그럼에도 불구하고 연구에 따르면 이러한 변화는 언어 모델 성능이 저차원 능력 공간의 함수이고 전체 모델 계열은 변환 효율성만 다른 단순하고 일반화된 척도법과 일치하는 것으로 나타났습니다. 계산을 능력으로 훈련합니다. 위의 방법을 사용하여 이 연구는 다른 많은 유형의 확장 연구의 놀라운 예측 가능성을 보여 주며 다음과 같은 사실을 발견했습니다. 일부 창발 현상은 부드러운 S자형 동작을 따르며 GPT-4와 같은 작은 모델에서 예측할 수 있습니다. 더 간단한 비에이전트 벤치마크를 통해 정확하게 예측할 수 있습니다. 또한 이 연구는 사고 사슬과 같은 교육 후 개입이 모델에 미치는 영향을 예측하는 방법을 보여줍니다. 연구에 따르면 작은 sub-GPT-3 모델만 사용하여 장착한 경우에도 관찰 가능한 확장 법칙이 창발적 용량, 에이전트 성능, 사고 체인과 같은 훈련 후 방법의 확장과 같은 복잡한 현상을 정확하게 예측하는 것으로 나타났습니다.

- 논문 주소: https://arxiv.org/pdf/2405.10938

- 논문 제목: Observational Scaling Laws and the Predictability of Language Model Performance

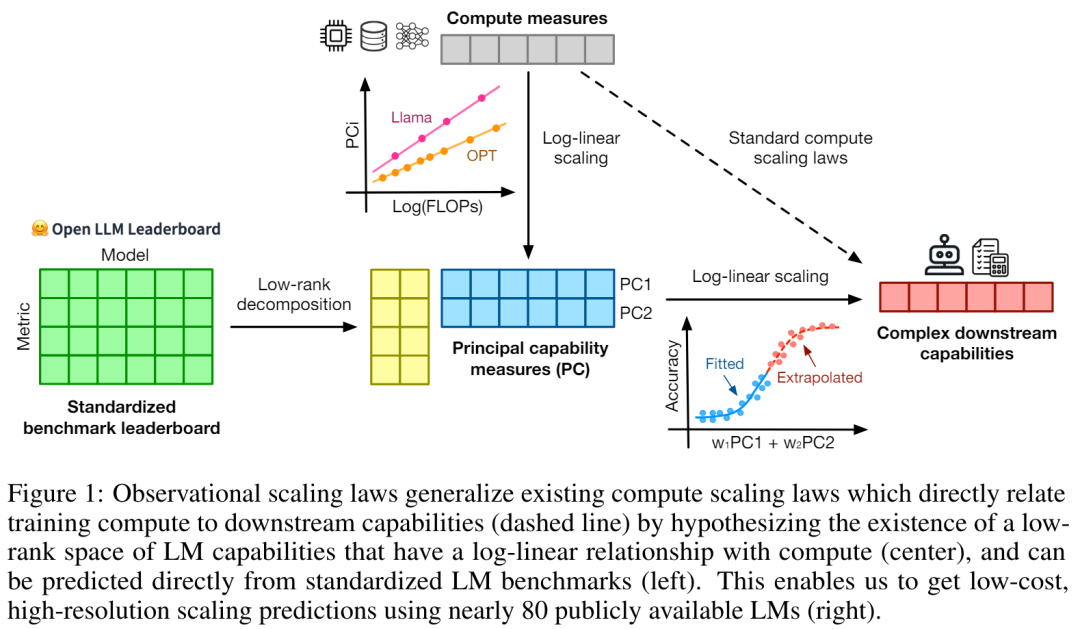

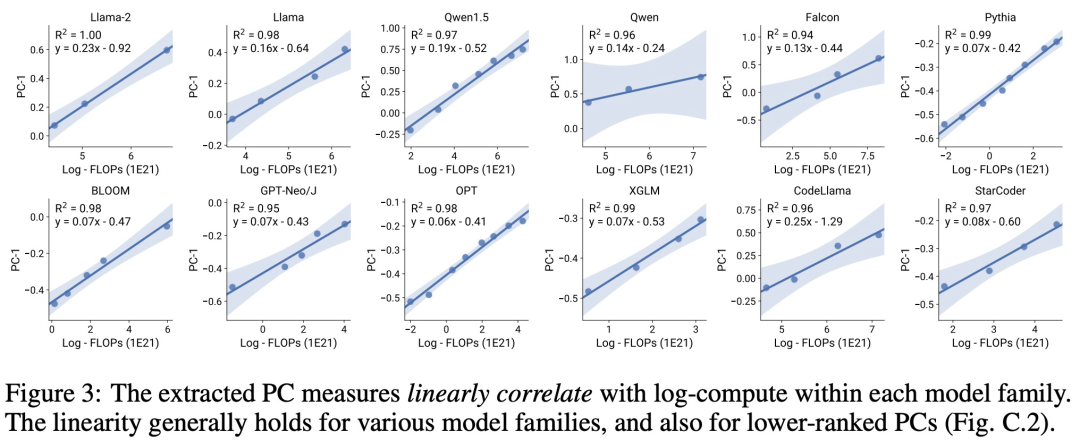

저자는 3명입니다. 의 논문 중 루안 양준(Yangjun Ruan)은 중국 저장대학교(Zhejiang University)에서 학사학위를 취득했습니다. 이 논문도 Thinking Chain의 제안자인 Jason Wei로부터 이 연구를 매우 좋아한다고 말했습니다. 연구에 따르면 현재 다양한 규모와 기능을 갖춘 수백 개의 개방형 모델이 존재하는 것으로 나타났습니다. 그러나 연구자들은 확장 법칙을 계산하기 위해 이러한 모델을 직접 사용할 수는 없지만(훈련의 계산 효율성은 모델 계열마다 크게 다르기 때문에), 연구자들은 모델 계열에 적용되는 보다 일반적인 확장 법칙이 있기를 바랍니다. 특히 본 논문에서는 LM의 다운스트림 성능이 저차원 기능 공간(자연어 이해, 추론, 코드 생성 등)의 함수이며 모델 패밀리는 효율성만 다르다고 가정합니다. 학습 계산을 이러한 기능으로 변환합니다. 이 관계가 사실이라면 모델군 전반에 걸쳐 저차원 기능에서 다운스트림 기능까지 로그 선형 관계가 있음을 의미합니다(이를 통해 연구자는 기존 모델을 사용하여 확장 법칙을 설정할 수 있음)(그림 1). 이 연구에서는 공개적으로 사용 가능한 거의 80개의 LM을 사용하여 저비용, 고해상도 확장 예측을 얻었습니다(오른쪽). 표준 LM 벤치마크(예: Open LLM Leaderboard)를 분석하여 연구자들은 모델 계열 내의 계산량(R^2 > 0.9)과 확장 법칙 관계가 있는 몇 가지 능력 측정을 발견했습니다(참조: 아래 그림 3), 이 관계는 다양한 모델군과 하위 지표 간에도 존재합니다. 이 기사에서는 이러한 확장 관계를 관찰 가능한 확장 법칙이라고 부릅니다. 마지막으로, 이 연구는 관찰 가능한 팽창 법칙을 사용하는 것이 저렴하고 간단하다는 것을 보여줍니다. 연구의 핵심 결과 중 많은 부분을 복제하기에 충분한 몇 가지 일련의 모델이 있기 때문입니다. 이 접근 방식을 사용하여 연구에서는 10~20개의 모델만 평가하면 기준선 및 교육 후 개입에 대한 확장 예측을 쉽게 달성할 수 있음을 발견했습니다.LM이 특정 계산 임계값에서 불연속적으로 발생하는 "긴급" 기능을 보유하고 있는지, 그리고 이러한 기능을 작은 모델을 사용하여 예측할 수 있는지에 대한 열띤 논쟁이 있어 왔습니다. 관찰 가능한 확장 법칙에 따르면 이러한 현상 중 일부는 매끄러운 S자형 곡선을 따르며 작은 하위 Llama-2 7B 모델을 사용하여 정확하게 예측할 수 있습니다. ” 관찰 가능한 스케일링 법칙을 통해 이 연구는 더 약한 모델(sub GPT-3.5)만을 사용하여 GPT-4의 성능을 정확하게 예측하고 에이전트 성능을 좌우하는 요인으로 프로그래밍 능력을 식별합니다.  사후 훈련 방법 확장 이 연구는 확장 법칙이 더 약한 모델(sub Llama-2 7B)에 장착된 경우에도 사후 훈련 방법을 안정적으로 예측할 수 있음을 보여줍니다. - 사고, 자기 일관성 등

사후 훈련 방법 확장 이 연구는 확장 법칙이 더 약한 모델(sub Llama-2 7B)에 장착된 경우에도 사후 훈련 방법을 안정적으로 예측할 수 있음을 보여줍니다. - 사고, 자기 일관성 등

전반적으로 이 연구의 기여는 계산, 간단한 공정 능력 측정 및 복잡한 하위 지표 간의 예측 가능한 로그-선형 관계를 활용하는 관찰 가능한 확장 법칙을 제안하는 것입니다.

관측 가능한 팽창 법칙의 검증

연구원들은 실험을 통해 이러한 팽창 법칙의 유용성을 확인했습니다. 또한 논문이 발표된 후 연구자들은 확장 법칙이 현재 모델에 과적합되는지 여부를 테스트하기 위해 미래 모델에 대한 예측도 사전 등록했습니다. 구현 프로세스 및 데이터 수집에 대한 관련 코드가 GitHub에 공개되었습니다:

GitHub 주소: https://github.com/ryoungj/ObsScaling

신발 능력의 예측 가능성

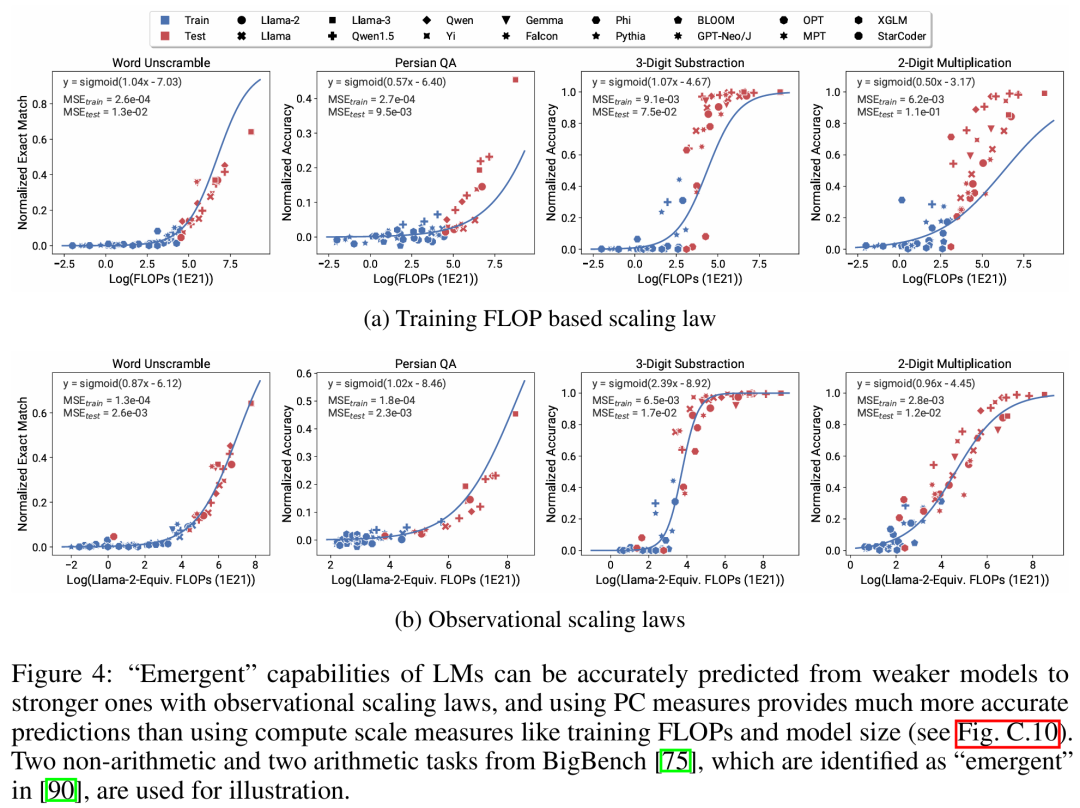

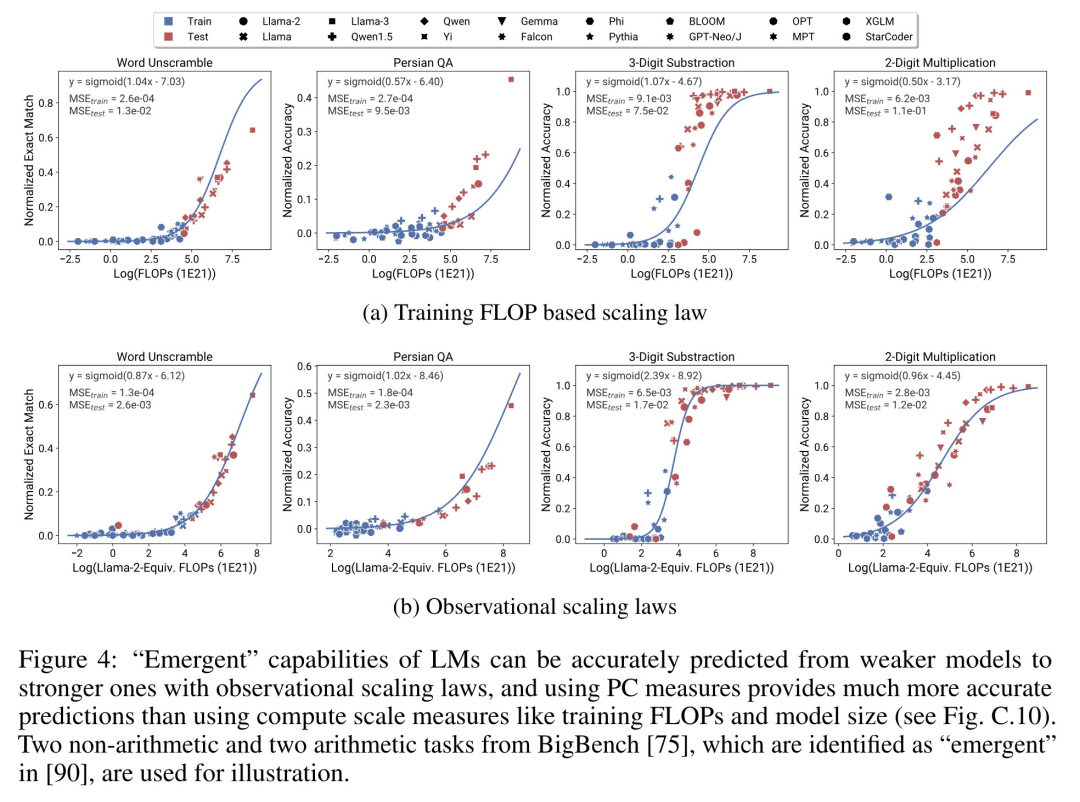

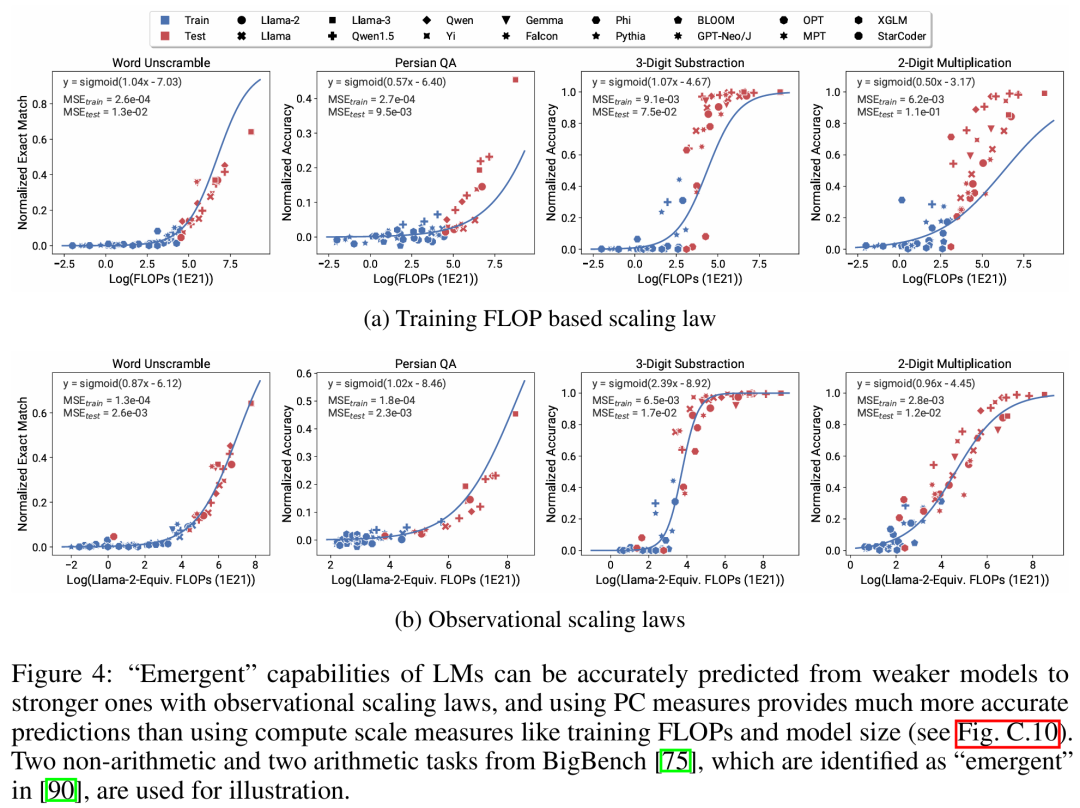

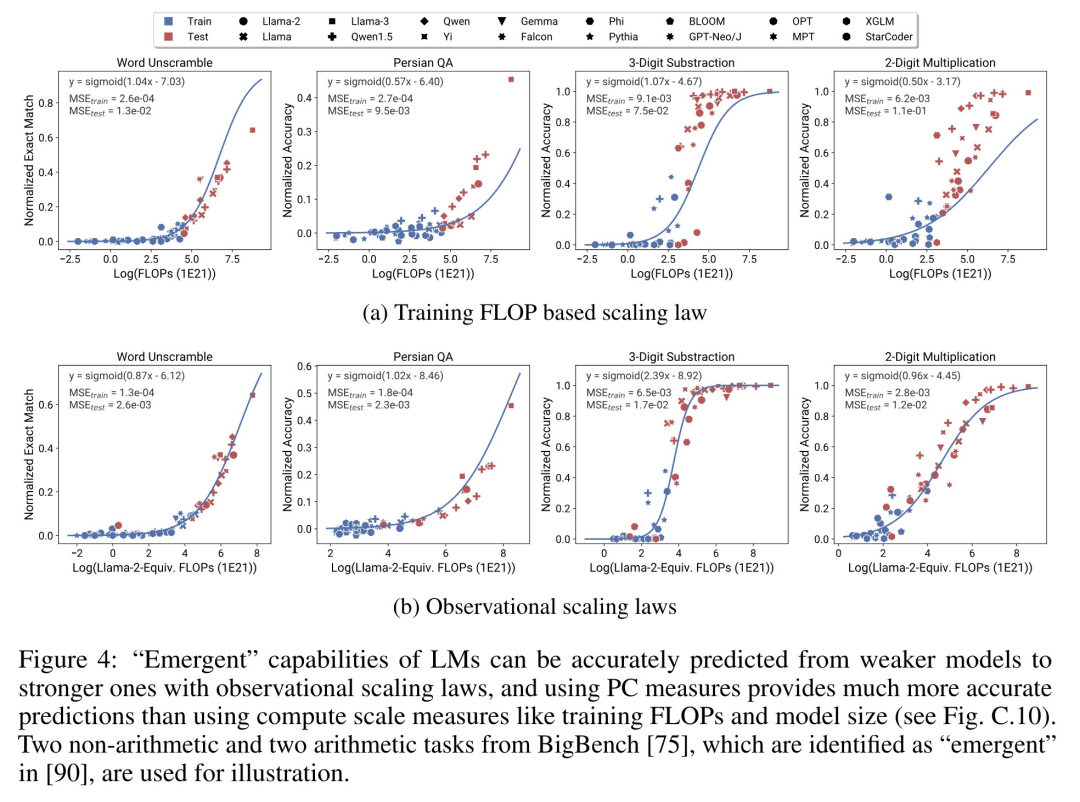

아래 그림 4는 PC(Principal Capability) 측정을 사용한 예측 결과와 학습 FLOP를 기반으로 한 예측 성능의 기본 결과를 보여줍니다. 성능이 낮은 모델만 사용하는 경우에도 PC 메트릭을 사용하여 이러한 능력을 정확하게 예측할 수 있음을 알 수 있습니다.

반대로 훈련 FLOP를 사용하면 더 높은 MSE 값에서 알 수 있듯이 테스트 세트에 대한 외삽이 훨씬 더 나빠지고 훈련 세트에 대한 적합도도 훨씬 더 나빠집니다. 이러한 차이는 다양한 모델 계열에 대한 FLOP 교육으로 인해 발생할 수 있습니다.

Agent Capability Predictability

아래 그림 5는 PC 메트릭을 사용한 관찰 가능한 확장 법칙의 예측 결과를 보여줍니다. 두 에이전트 벤치마크 모두에서 PC 지표를 사용하는 홀드아웃 모델(GPT-4 또는 Claude-2)의 성능은 성능이 약한(10% 이상의 격차) 모델로부터 정확하게 예측할 수 있음을 알 수 있습니다.

이는 LM의 더 복잡한 에이전트 기능이 기본 모델 기능과 밀접하게 관련되어 있으며 후자를 기반으로 예측을 할 수 있음을 보여줍니다. 이는 또한 백본 LM의 규모가 지속적으로 확장됨에 따라 LM 기반 에이전트 기능이 우수한 확장성 특성을 가지고 있음을 보여줍니다.

사후 훈련 기법의 영향

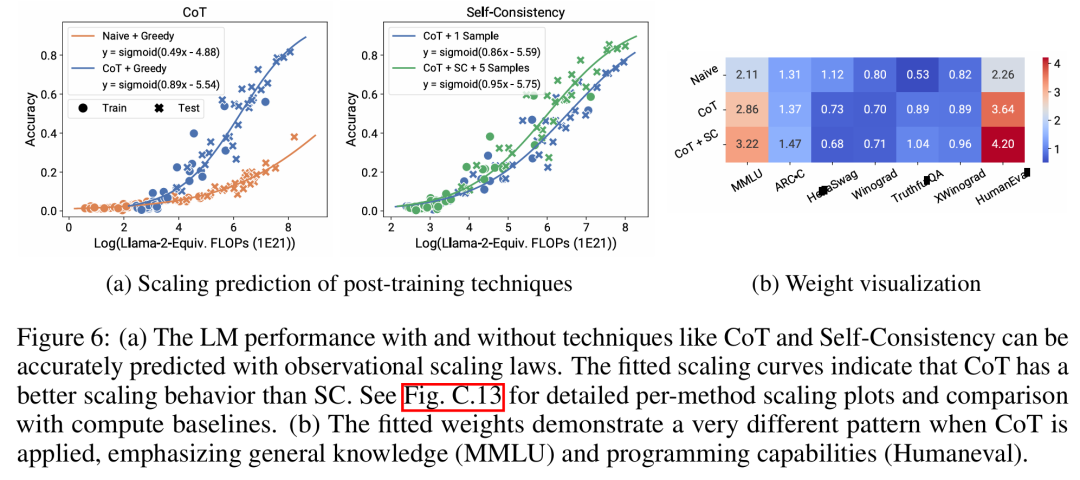

아래 그림 6a는 관찰 가능한 확장 법칙을 사용한 CoT 및 SC(Self-Consistency, self-consistency)의 확장 예측 결과를 보여줍니다. (순진한) 사후 훈련 기술 없이 CoT 및 CoT+SC를 사용하는 더 강력하고 큰 모델의 성능은 더 작은 계산 규모(예: 모델 크기 및 훈련 FLOP)를 사용하는 더 약한 모델에서 정확하게 예측할 수 있음을 알 수 있습니다.

두 기술 간에 스케일링 추세가 다르다는 점은 주목할 가치가 있으며, CoT는 CoT의 자체 일관성을 사용하는 것에 비해 더 분명한 스케일링 추세를 보여줍니다.자세한 기술적인 내용은 원본 문서를 참조하세요. 위 내용은 80개 모델로 스케일링 법칙 구축: 중국 박사 과정 학생의 신작, 사고 체인 저자의 강력 추천의 상세 내용입니다. 자세한 내용은 PHP 중국어 웹사이트의 기타 관련 기사를 참조하세요!

사후 훈련 방법 확장

사후 훈련 방법 확장