最近、海外テクノロジーメディア PiunikaWeb は、Google が発売中の Pixel タブレットに「Look and Sign」と呼ばれる新機能を導入する準備をしていることを明らかにしました。この革新的な動きは、ユーザーとデバイス AI の間のインタラクティブ エクスペリエンスをさらに最適化し、強化することを目的としています。

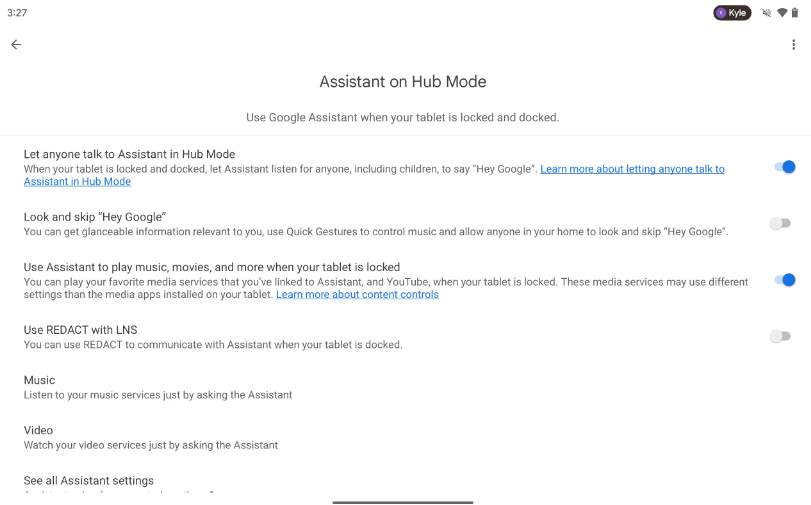

「Look and Sign」は、ユーザーが簡単なジェスチャーでコマンドを表現できるようにし、Google アシスタントとのより直接的な対話を可能にする機能の導入です。たとえば、ユーザーは親指を立てるなどの明らかなジェスチャーを通じて自分の意図を伝えることができるため、ユーザーとデバイス間のコミュニケーション プロセスが大幅に簡素化され、口頭での指示への依存が軽減されます。この機能の開始により、一般ユーザーにとってより便利なインタラクション手段が提供されるだけでなく、手話を使用するユーザーグループにとっても朗報となることが期待されます。アクセシビリティ機能が重要な機能になります。

Googleは以前、Nest Hub Maxデバイスでも同様の「Look and Talk」機能を導入しました。デバイスのカメラを利用することで、ユーザーは「OK Google」というウェイクワードを話す必要がなく、Nest Hub Max に向かって指定されたエリアに向かって話すだけで、デバイスが応答します。今日、「Look and Sign」機能の登場により、ユーザーとスマートデバイス間のインタラクションがさらに充実・拡大し、人工知能技術の応用がユーザーのニーズに近づくことは間違いありません。 「Look and Sign」機能を通じて、ユーザーとスマート デバイス間の対話モードがさらに充実し、拡張される可能性があり、間違いなく AI テクノロジー アプリケーションをユーザーのニーズに近づけることができます。

以上が革新的なインタラクティブな手法! Google Pixel タブレットは「Look and Sign」ジェスチャー コントロールをテストしますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。