4 月 7 日、Alibaba Cloud は、オープンソースの 320 億パラメータ モデル Qwen1.5-32B がパフォーマンス、効率、メモリ使用量のバランスを最大限に高め、企業や開発者によりコスト効率の高いモデルの選択肢を提供できると Qianwen に通知しました。現在、Notification Qianwen は合計 6 つの大規模な言語モデルをオープンソース化しており、国内外のオープンソース コミュニティでの累計ダウンロード数は 300 万件を超えています。

一般的な質問 Qianwen はこれまでに 5 億、18 億、40 億、70 億、140 億、720 億のパラメータ モデルを開発し、すべてバージョン 1.5 にアップグレードされました。その中でもいくつかの小型モデルはデバイス側で簡単に導入でき、720億パラメータモデルは業界トップクラスの性能を持ち、HuggingFaceなどのモデルリストに何度も掲載されています。オープンソースの 320 億パラメータ モデルは、パフォーマンス、効率、メモリ使用量の間でより理想的なバランスを実現します。たとえば、14B モデルと比較して、32B はエージェント シナリオにおける機能が強化されており、72B と比較して 32B の推論コストは低くなります。一般問題チームは、32B オープンソース モデルが下流のアプリケーションにより良いソリューションを提供できることを期待しています。

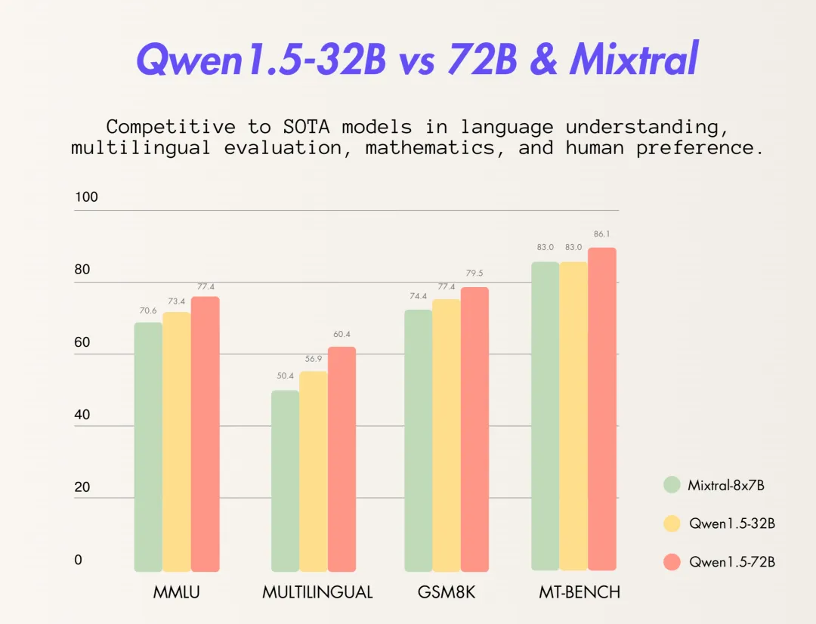

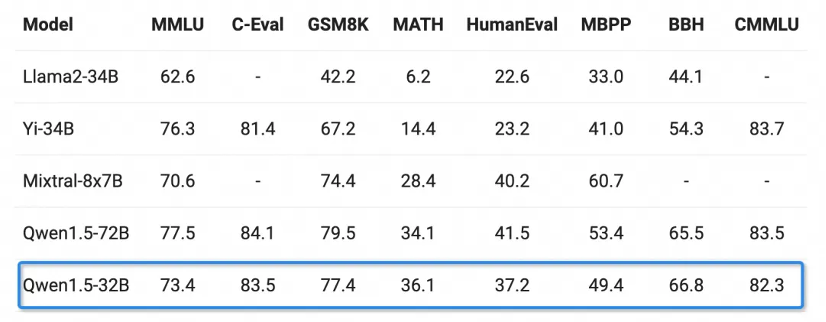

基本的な機能の点では、Qianwen 320 億パラメータ モデルは、MMLU、GSM8K、HumanEval、BBH などの複数のテストで良好なパフォーマンスを示しており、そのパフォーマンスはこれは、Qianwen の 720 億パラメータ モデルに近く、300 億レベルのパラメータ モデルをはるかに上回っています。

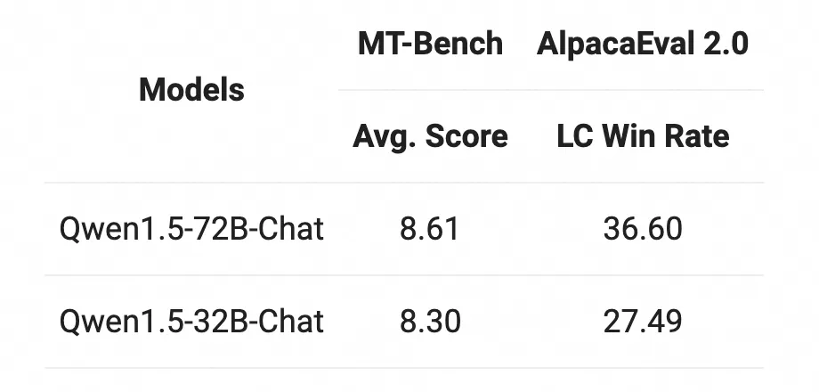

Chat モデルに関しては、Qwen1.5-32B-Chat モデルが MT-Bench の評価で 8 ポイント以上のスコアを獲得しており、Qwen1 に比べて大きく遅れをとっています。 5-72B-チャットは小さくなります。

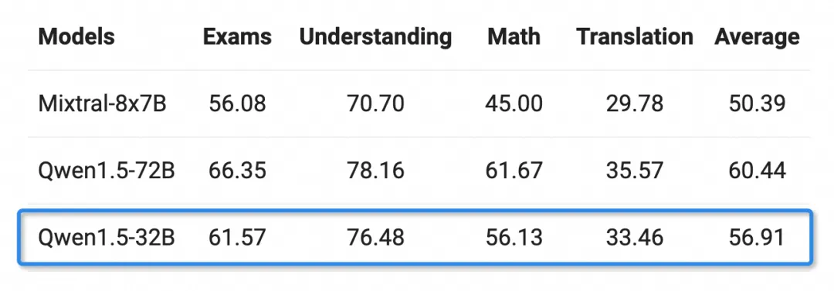

豊かな言語能力を持つ人は、アラビア語、スペイン語、フランス語、日本語、韓国語などを含む12の言語を選択できます。評価は理解力、数学などさまざまな分野で実施されました。そして翻訳。 Qwen1.5-32B の多言語機能は、一般的な Qwen 720 億パラメータ モデルに限定されています。

以上がTongyi Qianwen は 320 億のパラメータ モデルをオープンソース化し、7 つの主要な言語モデルをすべてオープンソースとして実現しました。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。