時系列予測は、小売、金融、製造、ヘルスケア、自然科学などのさまざまな分野で重要な役割を果たしています。小売業界では、需要予測の精度を向上させることで、在庫コストを効果的に削減し、収益を増やすことができます。これは、企業が顧客の需要をより適切に満たし、在庫の過剰と損失を削減しながら、売上と利益を増加できることを意味します。したがって、時系列予測は小売分野で非常に価値があり、企業に多大なメリットをもたらす可能性があります。

ディープラーニング (DL) モデルが「多変数時系列予測」タスクの大半を占めています。様々な競技や実践で優秀な成績を収めています。

同時に、自然言語処理 (NLP) タスクにおける大規模な基本言語モデルが大幅に進歩し、翻訳、検索拡張生成、検索拡張などのタスクが効果的に改善されました。コード補完のパフォーマンス。

NLP モデルのトレーニングは、クローラー、オープン ソース コードなど、さまざまなソースから取得される大量のテキスト データに依存します。トレーニングされたモデルは、言語内のパターンを認識し、サンプル学習の能力: たとえば、検索タスクに大規模なモデルを使用する場合、モデルは現在のイベントに関する質問に答え、それらを要約することができます。

ディープ ラーニング ベースの予測器は、トレーニングや推論コストの削減など、多くの点で従来の方法よりも優れていますが、克服する必要のある課題がまだいくつかあります。

多くの深層学習モデルは、新しい時系列でテストする前に、長時間にわたるトレーニングと検証を経ます。対照的に、時系列予測の基礎となるモデルには「すぐに使える予測」機能があり、追加のトレーニングなしで未知の時系列データに適用できます。この機能により、ユーザーは小売需要計画などの実際的な下流タスクの予測の改善に集中できます。

Google Research の研究者らは最近、TimesFM と呼ばれる時系列予測の基本モデルを提案しました。これは 1,000 億の現実世界の時点で事前トレーニングされました。現在の最先端の大規模言語モデル (LLM) と比較すると、TimesFM のサイズははるかに小さく、含まれるパラメーターはわずか 2 億です。

論文リンク: https://arxiv.org/pdf/2310.10688.pdf

実験その結果、TimesFM は、サイズが小さいにもかかわらず、さまざまなドメインおよび時間スケールにわたるさまざまな未トレーニングのデータセットに対して驚くべき「ゼロショット パフォーマンス」を示し、明確にトレーニングされた最先端の教師付きメソッドのパフォーマンスに近づいていることが示されています。データセット。

研究者らは、今年後半に Google Cloud Vertex AI で外部の顧客が TimesFM モデルを利用できるようにする予定です。

LLM は通常、次の 3 つのステップを含むデコーダのみの方法でトレーニングされます:

1。テキストは、トークン

2 と呼ばれるサブワードに分割されます。トークンは、積み重ねられた因果 Transformer レイヤーに供給され、各入力トークンに対応する出力で生成されます。このレイヤーは、対応する出力なしではトークンを処理できないことに注意してください。入力、つまり将来のトークン

3. i 番目のトークンに対応する出力は、前のトークンからのすべての情報を要約し、(i 1) 番目のトークンを予測します。

推論中、LLM は一度に 1 つのトークンの出力を生成します。

たとえば、「フランスの首都は何ですか?」というプロンプトを入力すると、モデルはトークン「The」を生成し、その後、このプロンプトを使用して、モデルが完全な答え「フランスの首都はパリです」 (フランスの首都はパリです) を生成するまで、条件に対して次のトークン「首都」を生成します。

時系列予測の基礎となるモデルは、事前トレーニングされた大規模なデータセットからデータをエンコードするのに十分な能力を備えながら、変数コンテキスト (モデルが観察するもの) と範囲 (クエリ モデルが予測するもの) の長さに適応する必要があります。パターン。

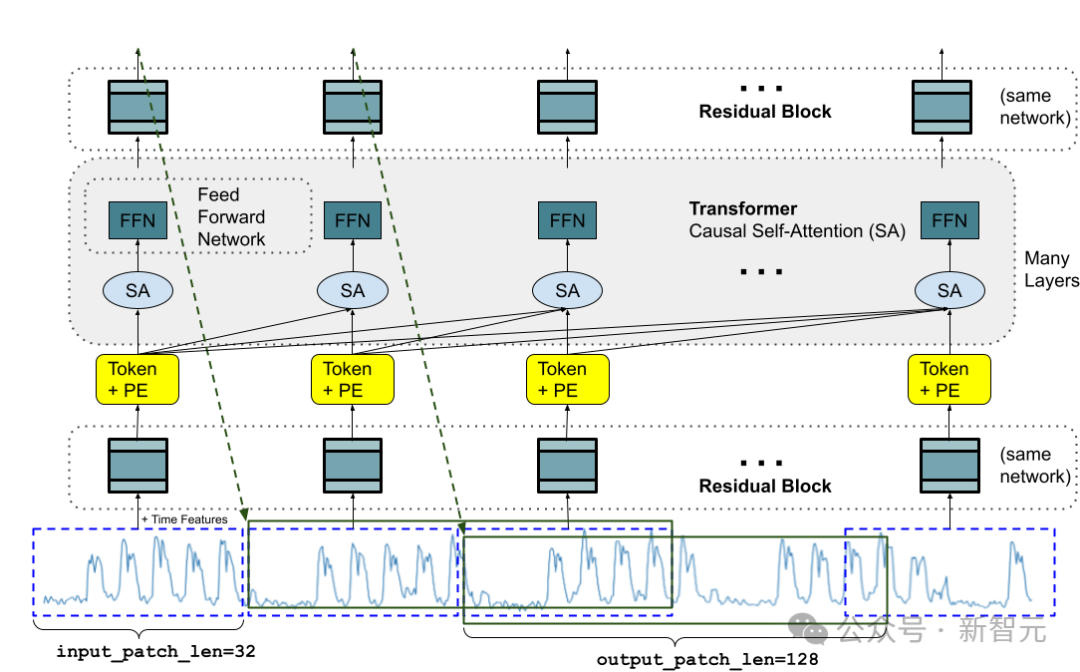

LLM と同様に、研究者らは、TimesFM モデルの主な構成要素として、スタックされた Transformer レイヤー (セルフ アテンション レイヤーとフィードフォワード レイヤー) を使用しました。 ; 時系列予測のコンテキストでは、パッチ (一連の連続した時点) がトークンとして使用されます。このアイデアは、最近の長期予測作業から来ています。具体的なタスクは、スタックされた Transformer の最後で予測することです。レイヤーでは、指定された th i 出力に対して (i 1) 番目の時点パッチを予測します

#ただし、TimesFM には言語モデルとの重要な違いがいくつかあります:

1. このモデルには、時系列パッチをトークンに変換するための残留接続を備えた多層パーセプトロン ブロックが必要です。トークンは、位置エンコーディング (PE) とともに Transformer 層に入力できます。これを行うために、長期予測における以前の研究と同様の残差ブロックを使用します。

2. スタックされた Transformer からの出力トークンを使用して、入力パッチの長さよりも長い後続の時点の長さを予測できます。つまり、出力パッチの長さは次のようになります。入力パッチの長さを超えています。

長さ 512 タイム ポイントの時系列を使用して、「入力パッチ長 32」および「出力パッチ長 128」で TimesFM モデルをトレーニングすると仮定します。

トレーニング中に、最初の 32 時点を使用して次の 128 時点を予測し、最初の 64 時点を使用して 65 ~ 192 の時点を予測し、最初の 96 時点を使用するようにモデルが同時にトレーニングされます。時点 97 ~ 224 などを予測します。

入力データが長さ 256 の時系列であり、そのタスクが将来の次の 256 時点を予測することであると仮定すると、モデルは最初に時点 257 の将来予測を生成します。次に、最初の 256 の長さの入力と生成された出力を条件として、時点 385 から 512 が生成されます。

一方、モデル内の出力パッチの長さが入力パッチの長さ 32 に等しい場合、同じタスクに対して、モデルは 8 つの生成ステップを実行します。 2、誤差の累積リスクが増加するため、実験結果では、出力パッチ長が長いほど長期予測パフォーマンスが向上することがわかります。

事前トレーニング データLLM がより多くのトークンで改善できるのと同じように、TimesFM は学習と改善のために大量の正規の時系列データを必要とします。トレーニング データ セットの作成と評価に多くの時間を費やしましたが、より良い 2 つの方法を見つけました:

合成データは基本をサポートします

統計モデルまたは物理シミュレーションを使用して、意味のある合成時系列データを生成でき、基本的な時間パターンに基づいてモデルが時系列予測の構文を学習できます。

#実世界のデータが現実世界の風味を加える

研究者たちは、利用可能な公開時系列データセットを徹底的に調査し、選択的に1,000 億のタイムポイントからなる大規模なコーパスをまとめました。データ セットには、Google トレンドと Wikipedia のページ ビューがあり、ユーザーが何に興味を持っているかを追跡し、他の多くの実世界の時系列の傾向やパターンをよく反映しています。これは、TimesFM が全体像を理解するのに役立ち、「トレーニング中に表示されなかったドメイン固有のコンテキスト」の汎化パフォーマンスを向上させることができます。

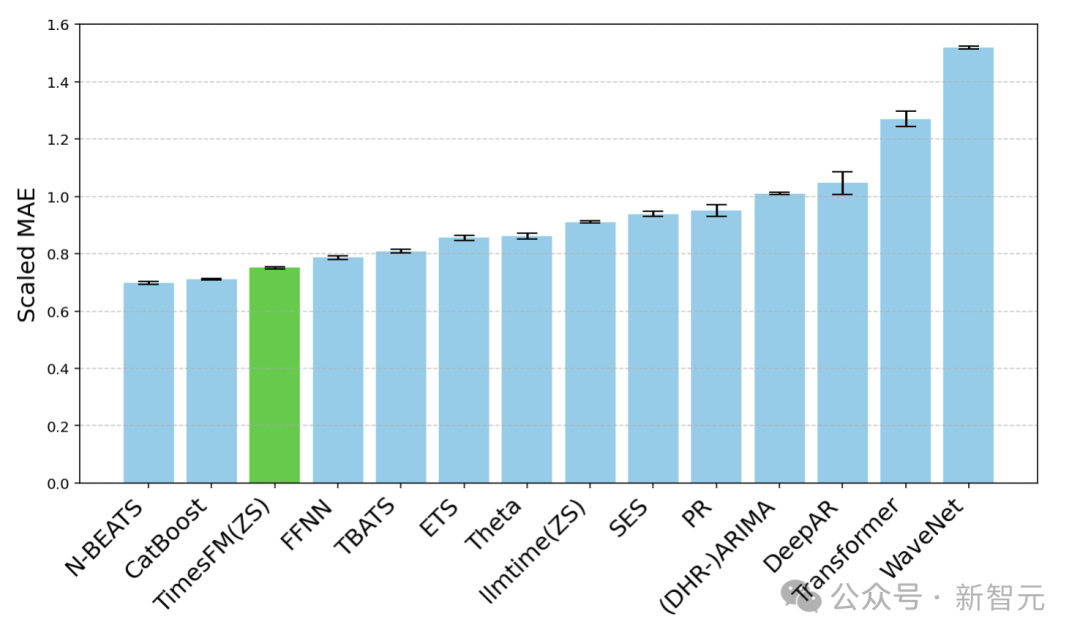

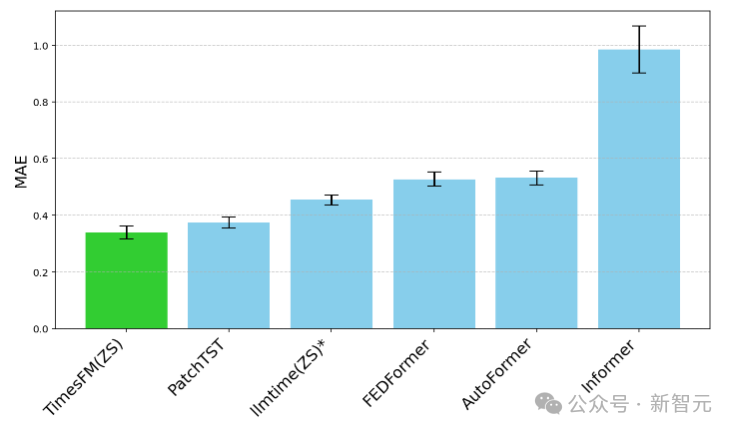

研究者らは、一般的に使用されている時系列ベンチマークを使用して、トレーニング中に見られなかったデータに対するTimesFMのゼロサンプル評価を実施しました。その結果、TimesFMのパフォーマンスが優れていることが観察されました。 ARIMA、ETS などのほとんどの統計手法よりも優れており、ターゲット時系列で明示的にトレーニングされた DeepAR、PatchTST などの強力な DL モデルと同等またはそれを上回るパフォーマンスを発揮できます。 研究者らは、Monash Forecasting Archive を使用して、交通、天気、需要などのさまざまなドメインからの数万の時系列を含むデータセットである TimesFM のすぐに使用できるパフォーマンスを評価しました。予測、カバレッジ頻度は数分から年間データまで多岐にわたります。 研究者らは、既存の文献に基づいて、データセット全体を平均するために適切にスケーリングされた平均絶対誤差 (MAE) を調べました。 ご覧のとおり、ゼロショット (ZS) TimesFM は、最近の深層学習モデルを含むほとんどの教師あり手法よりも優れたパフォーマンスを発揮します。また、llmtime (ZS) が提案する特定のヒント技術を使用した予測について、TimesFM と GPT-3.5 が比較されました。その結果、TimesFM のパフォーマンスが llmtime (ZS) よりも優れていることが証明されました。 ほとんどの Monash データセットは短いか中程度です。これは予測期間が長すぎないことを意味しており、研究者らはまた、最先端のベースライン PatchTST (およびその他の長期予測ベースライン) に対して、一般的に使用されているベンチマーク長期予測に対して TimesFM をテストしました。 研究者らは、将来の 96 時点と 192 時点を予測するタスクのために ETT データセットに MAE をプロットし、各データセットの最後のテスト ウィンドウでメトリクスを計算しました。 #TimesFM(ZS) と llmtime(ZS) のラスト ウィンドウ MAE (低いほど良い) と ETT データセット ベースラインの長期予測 結論 研究者らは、実世界の 1,000 億時点の大規模な事前トレーニング コーパス (そのほとんどが検索インタレストであった) を使用して、基本デコーダのみのモデルをトレーニングしました。 Google トレンドと Wikipedia ページビューからの時系列データ。 ゼロサンプル評価結果

以上がわずか 2 億パラメータで、ゼロサンプルのパフォーマンスは教師付きを上回ります。 Google、基本的な時系列予測モデルTimesFMをリリースの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。