本日、『Transformer』著者の 1 人である Aidan Gomez が共同設立した人工知能スタートアップ Cohere が、独自の大規模モデルのリリースを開始しました。

Cohere の最新リリース モデルは「Command-R」という名前で、35B のパラメータがあり、大規模な運用ワークロードを処理できるように設計されています。このモデルは、高効率と高精度のバランスを備えた「スケーラブル」カテゴリに分類され、企業ユーザーが概念実証を超えて実稼働環境に移行できるように支援します。

Command-R は、検索拡張生成 (RAG) およびその他のロングコンテキスト タスク用に最適化された生成モデルです。このモデルは、外部 API とツールを組み合わせることで、RAG アプリケーションのパフォーマンスを向上させることを目的としています。業界をリードする埋め込みおよび並べ替えモデルと連携して、エンタープライズ ユースケースに優れたパフォーマンスとクラス最高の統合機能を提供します。

Command-R は、最適化されたトランスフォーマー アーキテクチャを採用しており、自己回帰言語モデルです。事前トレーニングが完了すると、モデルは教師あり微調整 (SFT) と好みのトレーニングを通じて人間の好みとの一貫性を確保し、より優れた有用性と安全性を実現します。

具体的には、Command-R には次の機能的特徴があります。

Command-R は現在 Cohere のマネージド API で利用できます。主要なクラウド プロバイダーで間もなく開始されます。このリリースは、企業の大量導入に不可欠な機能を進化させるために設計された一連のモデルの最初のものです。

現在、Cohere は Huggingface でモデルの重みを公開しています。

Huggingface アドレス: https://huggingface.co/CohereForAI/c4ai-command-r-v01

検索拡張生成 (RAG) は、大規模な言語モデルの展開における重要なパターンとなっています。 RAG を使用すると、企業はモデルに、他の方法では利用できないプライベートな知識へのアクセスを提供し、プライベート データベースを検索し、関連情報を使用して応答を形成することができるため、精度と有用性が大幅に向上します。 RAG の主要なコンポーネントは次のとおりです。

Cohere の Embed モデルは、検索の場合、数百万、場合によっては数十億のドキュメントを検索することで、コンテキストと意味の理解を向上させ、検索ステップの実用性と精度を大幅に向上させます。同時に、Cohere の再ランク モデルは、取得した情報の価値をさらに高め、関連性やパーソナライゼーションなどのカスタム指標の結果を最適化するのに役立ちます。

強化された生成では、最も関連性の高い情報を特定することで、Command-R はこの情報を要約、分析、パッケージ化して、従業員の作業効率の向上や新しい製品エクスペリエンスの作成を支援できます。 Command-R は、モデルの出力に明確な引用が付いているという点で独特で、幻覚のリスクを軽減し、ソース素材からより多くのコンテキストをレンダリングします。

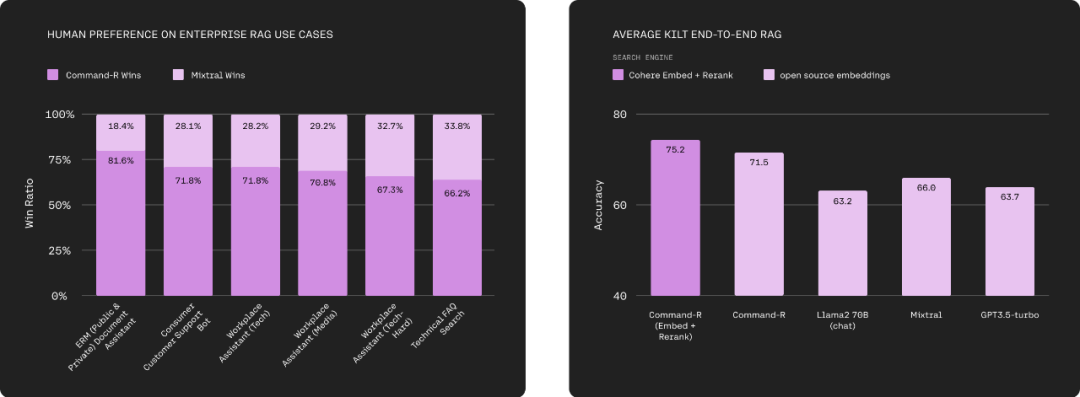

独自の埋め込みモデルと再ランク付けモデルを使用しなくても、Command-R はスケーラブルな生成モデル カテゴリの他のモデルよりも優れたパフォーマンスを発揮します。しかし、一緒に使用するとリードが大幅に広がり、より複雑なドメインでより高いパフォーマンスが可能になります。

下の左の図は、Command-R と Mixtral が、流暢性と回答を十分に考慮して、一連のエンタープライズ関連の RAG アプリケーションに対して全体的な人間の好みの直接評価を実施している様子を示しています。 . 有用性と引用。図の右側は、Command-R (Embed Rerank)、Command-R および Llama 2 70B (チャット)、Mixtral、GPT3.5-Turbo とその他のモデルの Natural question、TriviaQA、HotpotQA などのベンチマークでの比較結果を示しています。 。 Cohereの大型モデルが首位を獲得。

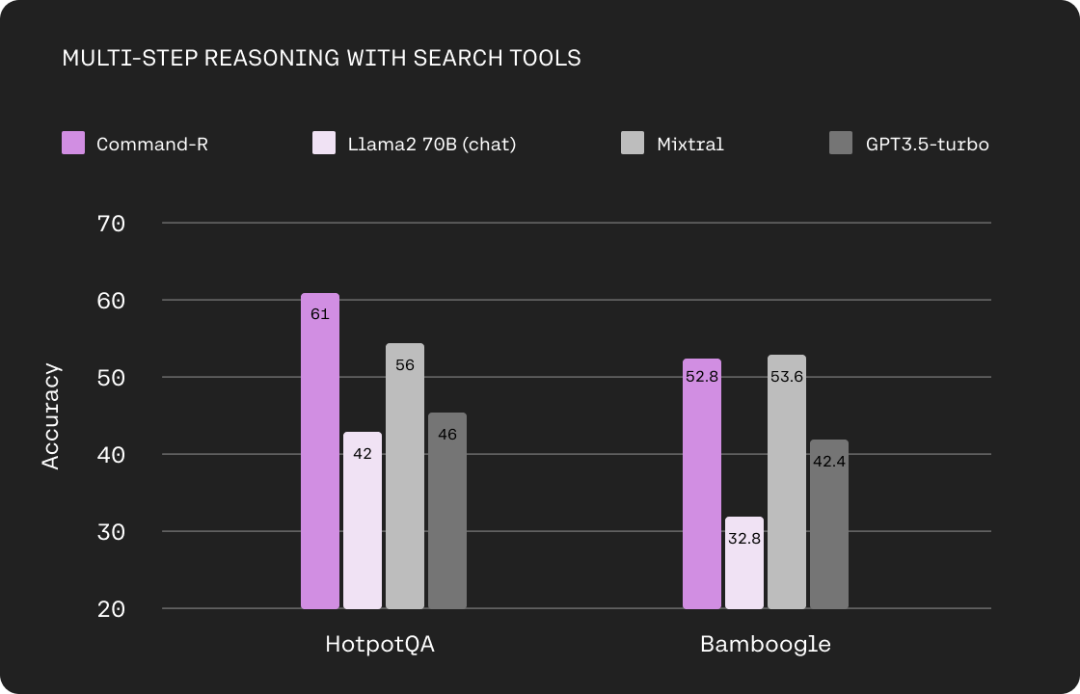

大規模な言語モデルは、テキスト マシンを抽出して生成するだけでなく、タスクを自動的に実行し、実際のアクションを実行できるコア推論エンジンである必要があります。 Command-R は、コード インタープリターやその他のユーザー定義ツールなどのツール (API) を使用して、モデルが非常に複雑なタスクを自動化できるようにすることでこの目標を達成します。

ツール使用機能を使用すると、企業開発者は Command-R を「データベースやソフトウェア ツールなどの内部インフラストラクチャ」だけでなく「CRM などの外部インフラストラクチャ」の使用をサポートするエンジンに変えることができます。 、検索エンジンなど」タスクとワークフローを自動化するためのツール。これにより、複数のシステムにまたがり、複雑な推論と意思決定を必要とする、時間のかかる手動タスクを自動化できます。

次の図は、検索ツールを使用した場合の Command-R と Llama 2 70B (チャット)、Mixtral、および GPT3.5-turbo の間のマルチステップ推論機能の比較を示しています。ここで使用されるデータセットは HotpotQA と Bamboogle です。

Command-R モデルは 10 の主要なビジネス言語に適しています英語、フランス語、スペイン語、イタリア語、ドイツ語、ポルトガル語、日本語、韓国語、アラビア語、中国語を含む世界中で。

さらに、Cohere の Embed モデルと Rerank モデルは 100 以上の言語をネイティブにサポートしています。これにより、ユーザーは幅広いデータ ソースから回答を導き出すことができ、言語に関係なく母国語で明確かつ正確な会話を実現できます。

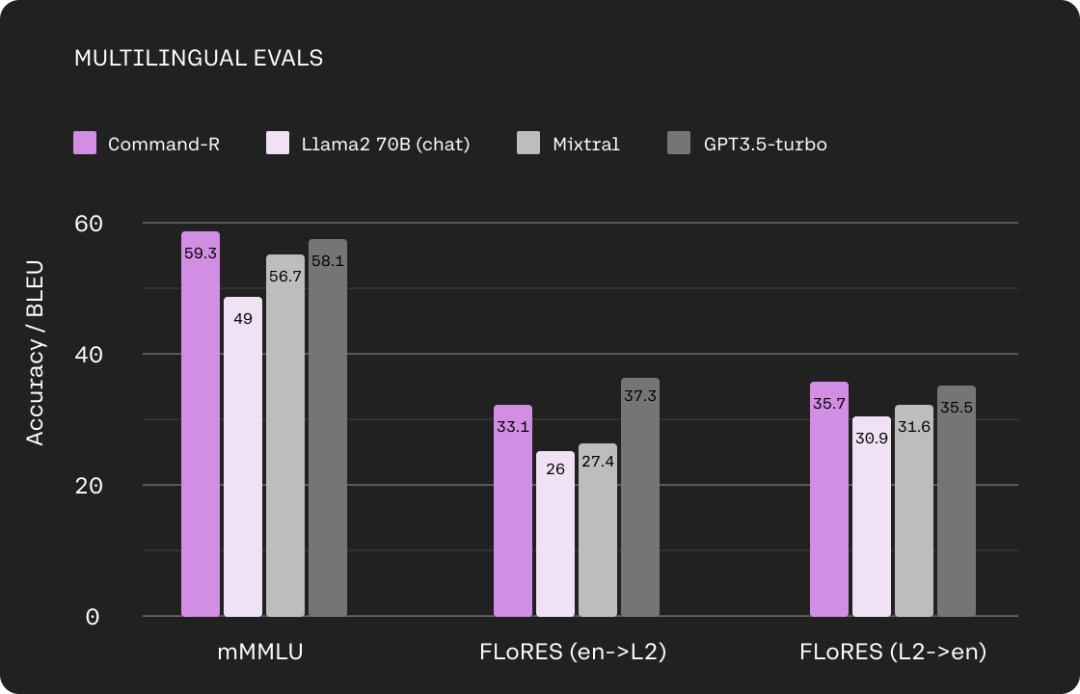

次の図は、Command-R と Llama 2 70B (チャット)、Mixtral、多言語 MMLU および FLORES での GPT3.5 ターボの比較を示しています。

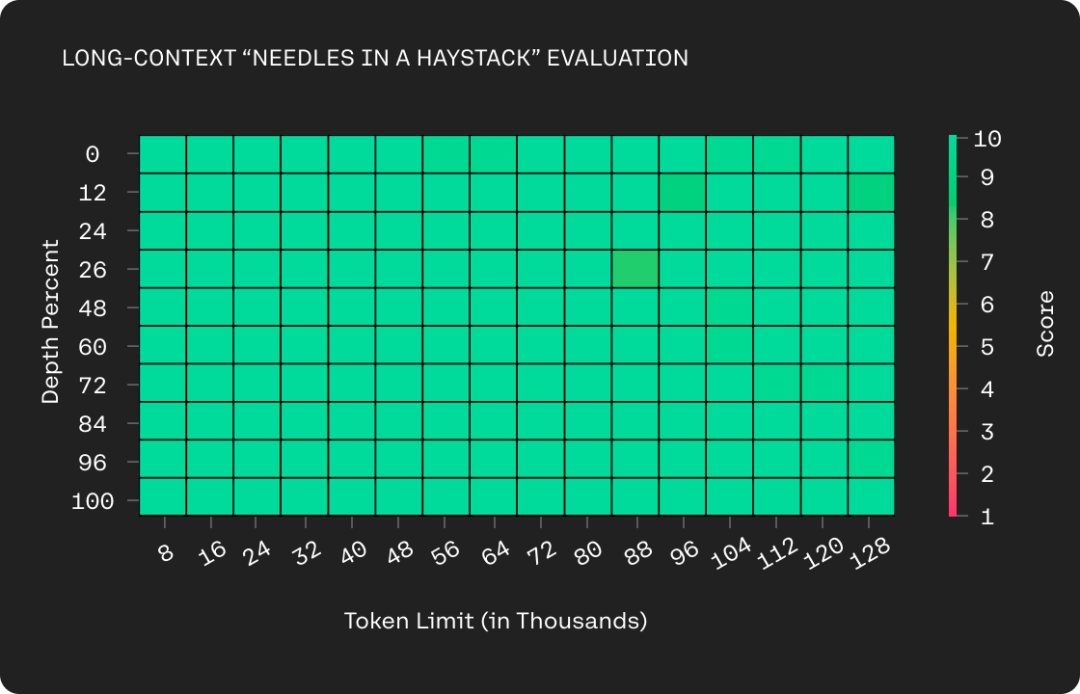

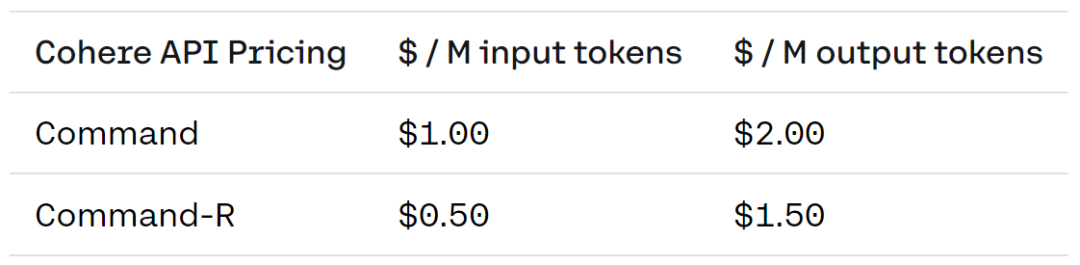

Command-R は、より長いコンテキスト ウィンドウ (128k トークン) をサポートします。このアップグレードにより、Cohere のマネージド API の価格も削減され、Cohere プライベート クラウド デプロイメントの効率が大幅に向上します。 Command-R は、より長いコンテキスト ウィンドウとより安価な価格設定を組み合わせることで、コンテキストを追加することでパフォーマンスを大幅に向上できる RAG ユース ケースを実現します。

具体的な価格は次のとおりです。コマンド バージョンの入力トークン 100 万個のコストは 1 米ドル、出力トークン 100 万個のコストは 2 米ドルです。 Command-R バージョンの費用は、100 万入力トークンに対して 0.5 米ドル、100 万出力トークンに対して 1.5 米ドルです。

Cohere は、モデルの詳細を示す短い技術レポートも間もなくリリースする予定です。

ブログアドレス: https://txt.cohere.com/command-r/

以上が350 億のパラメータとオープンウェイトを備えた Transformer の作者は、起業後、新しい大型モデルを立ち上げました。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。