Vision Pro にはもう 1 つの注目の新しい遊び方があり、今回は身体化された知性とリンクしています~

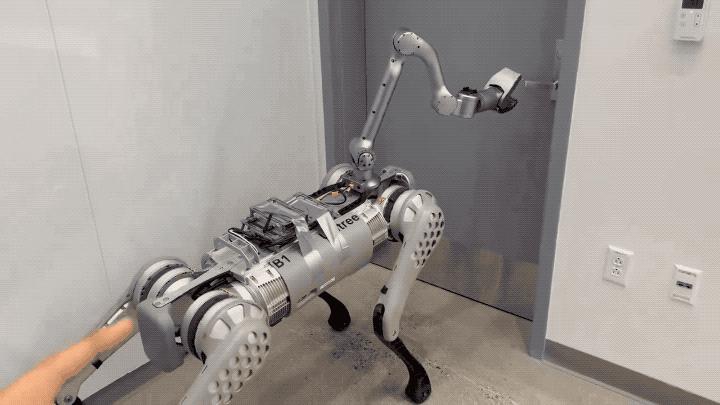

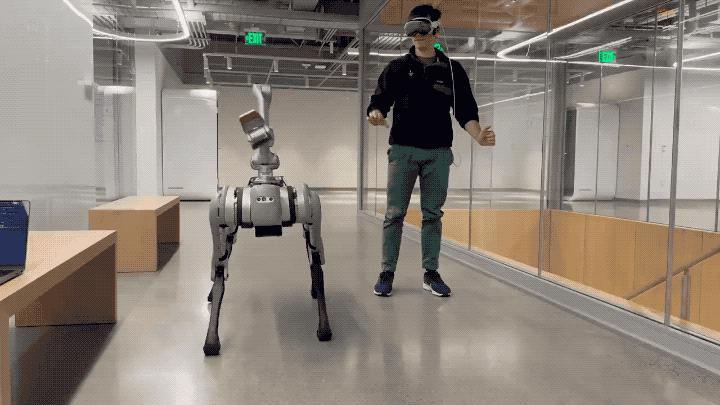

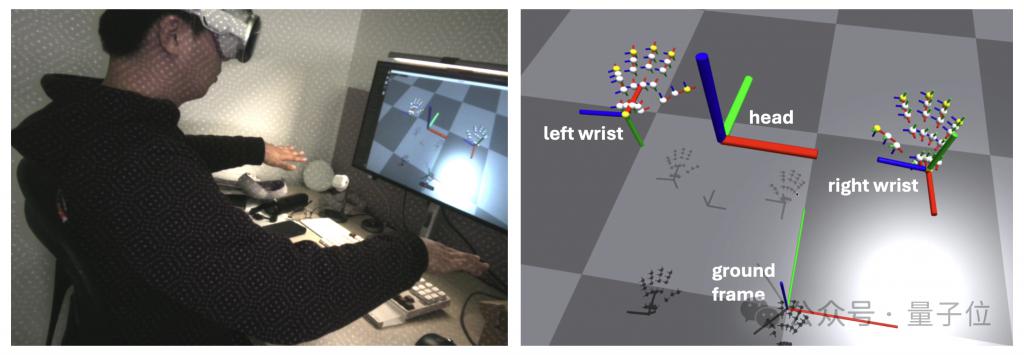

このように、MIT 担当者は Vision Pro のハンド トラッキング機能を使用して、ゲームの制御を実現することに成功しました。ロボット犬のリアルタイム制御。

#ドアを開けるなどのアクションを正確に取得できるだけでなく、ほとんどのことも取得できます。遅延なし。

# デモが公開されるとすぐに、ネチズンが Goose Meizi を賞賛しただけでなく、さまざまな具現化知能研究者も興奮しました。

たとえば、清華大学の博士課程の学生:

大胆に予測する人もいます: これが私たちが次世代のマシンと対話する方法です。

著者の弟が開発したアプリ、Tracking Steamer を詳しく見てみましょう。

著者の弟が開発したアプリ、Tracking Steamer を詳しく見てみましょう。

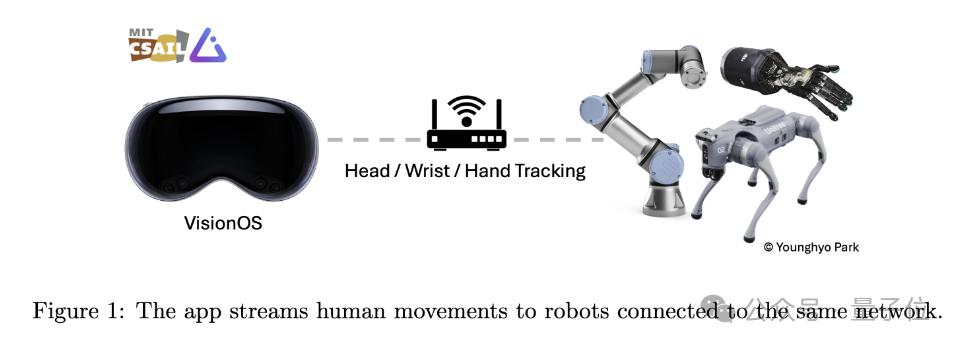

名前が示すように、このアプリケーションは、Vision Pro を使用して人間の動きを追跡し、これらの動きデータを同じ WiFi 下の他のロボット デバイスにリアルタイムで送信するように設計されています。

#モーション トラッキング部分は主に Apple の ARKit ライブラリに依存しています。

ヘッド トラッキングは queryDeviceAnchor を呼び出します。 Digital Crown を長押しすると、ヘッド フレームを現在の位置にリセットできます。

#ネットワーク通信に関しては、このアプリはデータをストリーミングするためのネットワーク通信プロトコルとして gRPC を使用します。これにより、Linux、Mac、Windows デバイスなど、より多くのデバイスでデータをサブスクライブできるようになります。

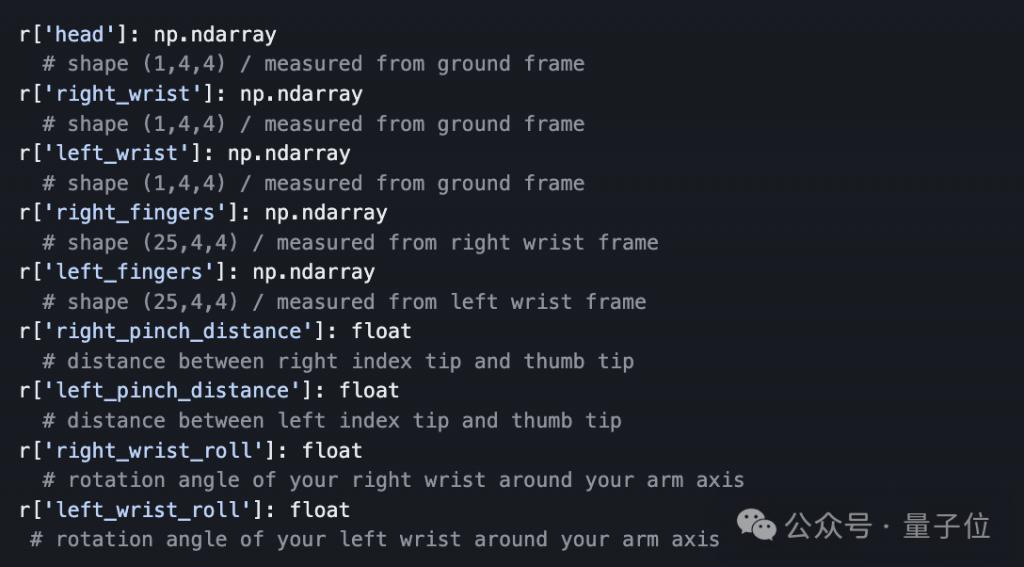

さらに、データ送信を容易にするために、開発者がプログラムによって Vision Pro からストリーミングされる追跡データをサブスクライブして受信できるようにする Python API も用意しました。

多くの専門家が指摘しているように、ロボット犬の動きが依然として人間によって制御されているかどうかに関係なく、実際には、「制御」自体と比較して、模倣 アルゴリズムを学習する過程では、人間はロボットのコーチに似てきます。

Vision Pro は、ユーザーの動きを追跡することで直感的でシンプルな対話方法を提供し、専門家でなくてもロボットに正確なトレーニング データを提供できるようにします。

Vision Pro Developer Strap (価格は $299)Xcode がインストールされた Mac コンピュータまあ、Apple はやはり最初に利益を上げる必要があるようです (doge )。 プロジェクトリンク: https://github.com/Improbable-AI/VisionProTeleop?tab=readme-ov-file参考リンク: https://twitter.com/younghyo_park/status/1766274298422161830

以上がVision Pro を使用してロボット犬をリアルタイムでトレーニングしましょう! MIT博士課程学生のオープンソースプロジェクトが人気の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。