インテリジェントな対話モデルの現在の開発では、強力な基礎モデルが重要な役割を果たしています。これらの高度なモデルの事前トレーニングは、高品質で多様なコーパスに依存することが多く、そのようなコーパスをどのように構築するかが業界の大きな課題となっています。 数学向け AI という注目を集めている分野では、高品質の数学コーパスが相対的に不足しているため、数学的応用における生成型人工知能の可能性が制限されています。 #この課題に対処するために、上海交通大学の生成人工知能研究室は「MathPile」を立ち上げました。これは、特に数学の分野を対象とした高品質で多様な事前トレーニング コーパスであり、約 95 億のトークンが含まれており、数学的推論における大規模モデルの能力を向上させるように設計されています。 さらに、研究室は、MathPile の応用範囲と商業的可能性をさらに広げるために、MathPile の商用バージョン「MathPile_Commercial」もリリースしました。

- 研究用途: https://huggingface.co/datasets / GAIR/MathPile

- 商用バージョン: https://huggingface.co/datasets/GAIR/MathPile_Commercial

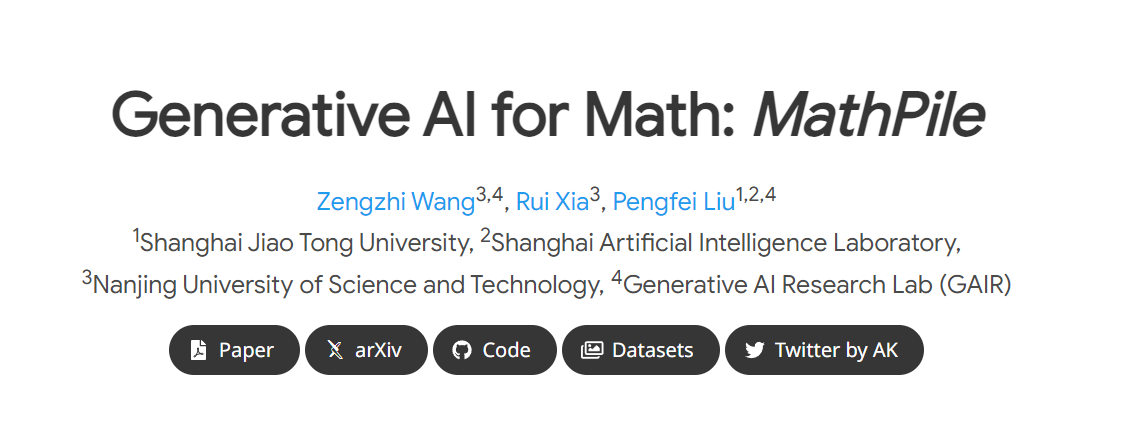

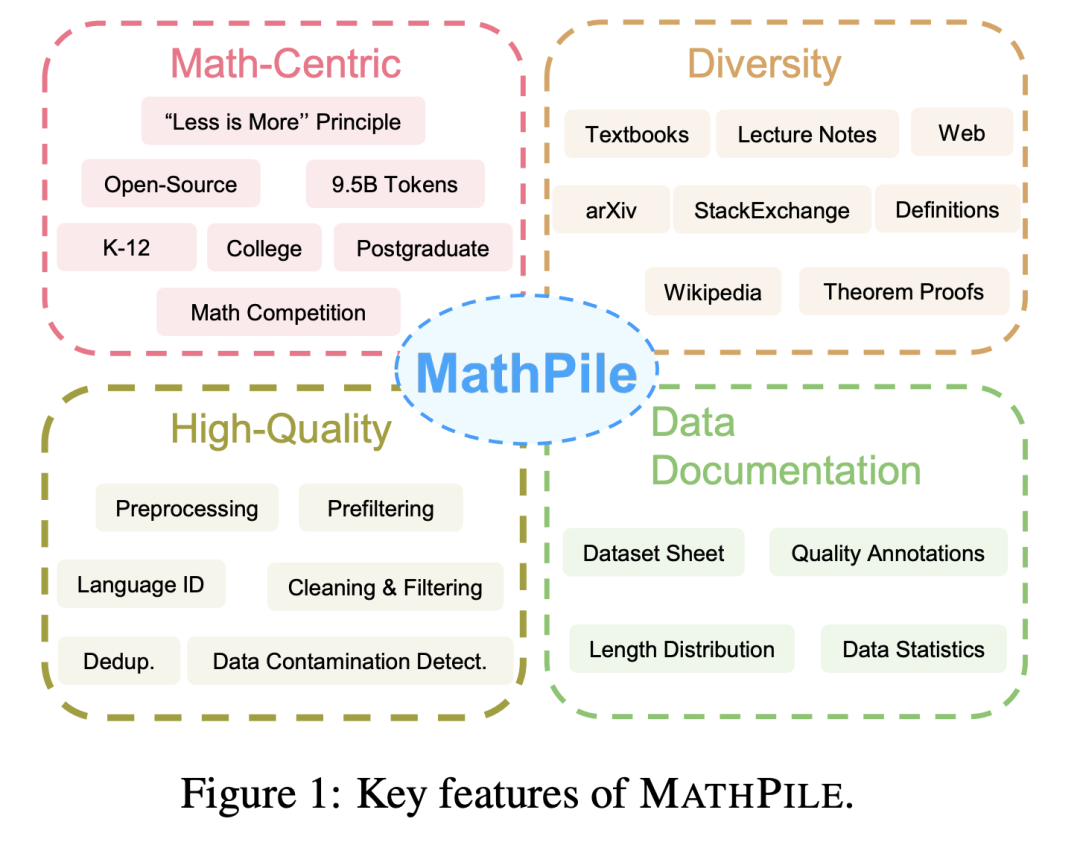

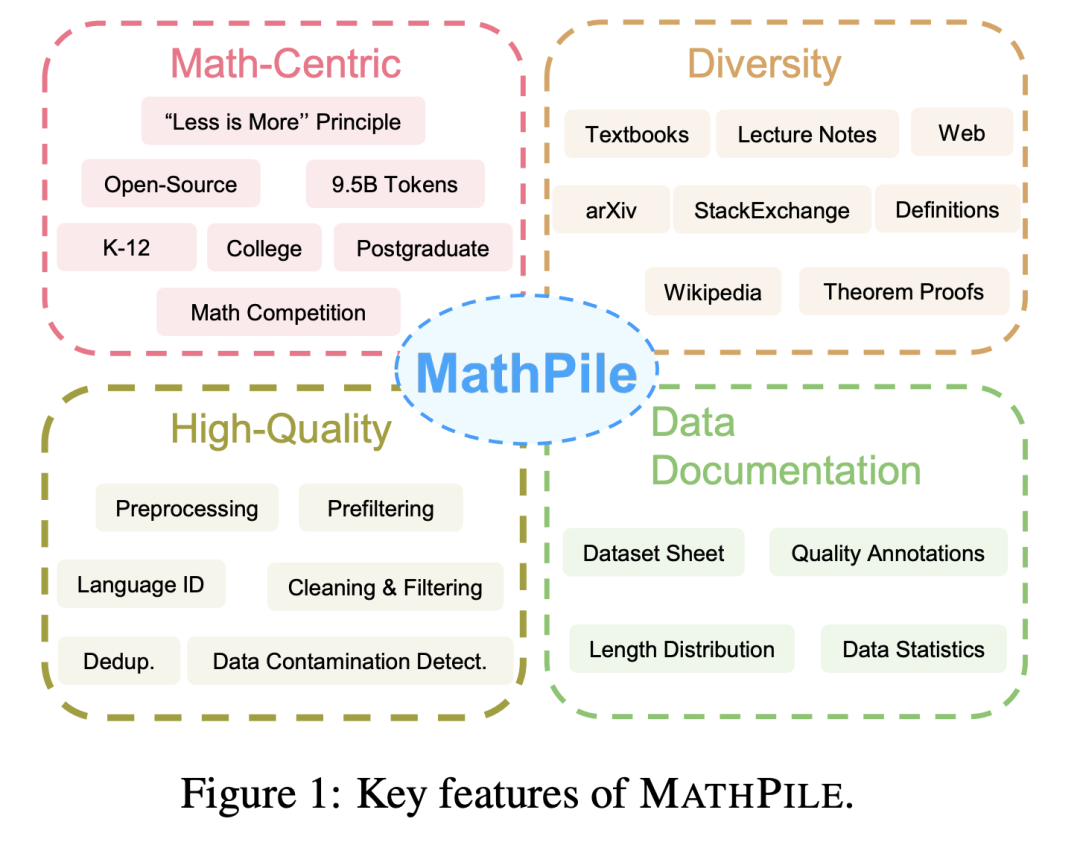

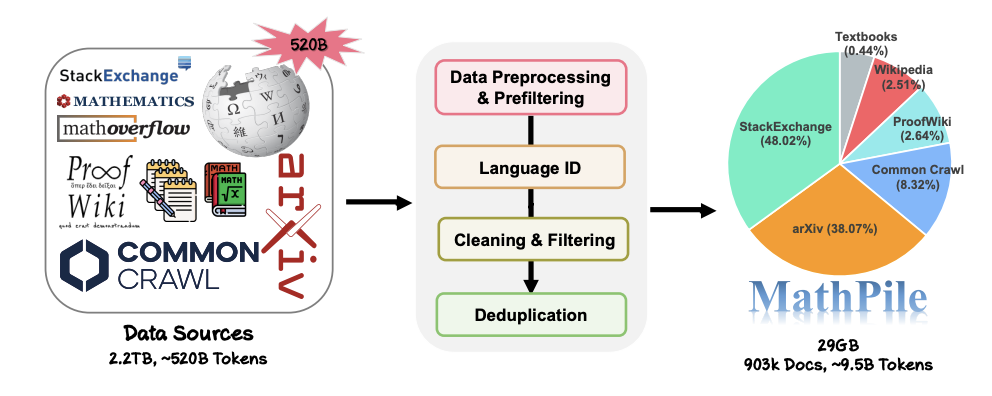

1. 数学中心: Pile、RedPajama、多言語コーパスROOTSなど、これまでの一般分野に焦点を当てたコーパスとは異なり、MathPileは数学分野に焦点を当てています。すでにいくつかの特殊な数学コーパスが存在しますが、それらはオープンソースではないか (Google が Minerva のトレーニングに使用するコーパス、OpenAI の MathMix など)、または十分に豊富で多様ではありません (ProofPile や最近の OpenWebMath など)。 2. 多様性: MathPile には、オープンソースの数学教科書、授業ノート、総合教科書、数学など、幅広いデータ ソースがあります。 arXiv 関連論文、Wikipedia の数学関連エントリ、ProofWiki の補題証明と定義、StackExchange (コミュニティ Q&A サイト) の質の高い数学の質問と回答、および Common Crawl の数学ページ。上記内容は、小学校・中学校から大学・大学院生、数学コンテストに相応しい内容を網羅しております。 MathPile は、初めて 0.19 億トークンの高品質数学教科書をカバーします。 3. 高品質: 研究チームは、収集プロセス中に「少ないほど良い」という概念に従い、データ品質がより優れていると強く信じています。トレーニング前の段階であっても、量を増やすことができます。約 520B トークン (約 2.2TB) のデータ ソースから、前処理、前フィルタリング、言語識別、クリーニング、フィルタリング、重複排除の一連の厳密かつ複雑な手順を経て、コーパスの高品質を確保しました。 OpenAI が使用する MathMix には 1.5B トークンしかないことに言及する価値があります。 4. データ ドキュメント: 透明性を高めるために、研究チームは MathPile をドキュメント化し、データセット シートを提供しました。研究チームは、データ処理プロセス中に、Web 上の文書に対して「品質の高い注釈」も実行しました。たとえば、言語認識のスコアと文書内の単語に対する記号の比率により、研究者は自分のニーズに応じて文書をさらにフィルタリングできます。また、コーパスに対して下流のテスト セットの汚染検出を実行して、MATH や MMLU-STEM などのベンチマーク テスト セットからサンプルを排除しました。同時に研究チームは、OpenWebMath には多数の下流テストサンプルも存在することも発見しました。これは、無効な下流評価を避けるために、事前トレーニングコーパスを作成する際に特別な注意を払う必要があることを示しています。

MathPile のデータ収集と処理プロセス。

今日、大規模モデルの分野での競争がますます激化するにつれ、多くのテクノロジー企業がデータを公開しなくなりました。詳細な前処理の詳細は言うまでもなく、データ ソースのマッチング、マッチング。それに対して、MathPile は、これまでの調査に基づいて、数学分野に適した一連のデータ処理方法を要約しています。 #データのクリーニングとフィルタリングの部分で、研究チームが採用した具体的な手順は次のとおりです。

- ##「lorem ipsum」を含む行を検出します。「lorem ipsum」が行内の 5 文字未満に置き換えられている場合は、その行を削除します。

- 「javascript」を含む行を検出します。 ” に「有効」、「無効」、または「ブラウザ」を含む行が含まれており、その行の文字数が 200 文字未満である場合は、その行をフィルタリングします;

- 200 文字未満をフィルタリングします。「ログイン」、「サインイン」、「続きを読む...」、または「カート内の商品」を含む 10 個の単語と行;

- フィルタ大文字の単語の割合を除外する ドキュメントの 40% 以上;

- 省略記号で終わる行がドキュメント全体の 30% 以上を占めるドキュメントをフィルタリングします;

- 文字単語の割合が 80% を超える非ドキュメントをフィルタリングします;

- 英単語の平均文字長が範囲外であるドキュメントをフィルタリングしますof (3, 10);

- 少なくとも 2 つのストップワード (the、be、to、of、that、have など) を含まないドキュメントをフィルタリングして除外します。 );

- 省略記号と単語の割合が 50% を超えるドキュメントをフィルタリングします;

- 行頭文字が黒丸であるドキュメントをフィルタリングします90% 以上を占める;

- 箇条書きで始まる行を含むドキュメントをフィルタリングする スペースと句読点を除いた 200 文字未満のドキュメント;

- ...

処理の詳細については、論文を参照してください。

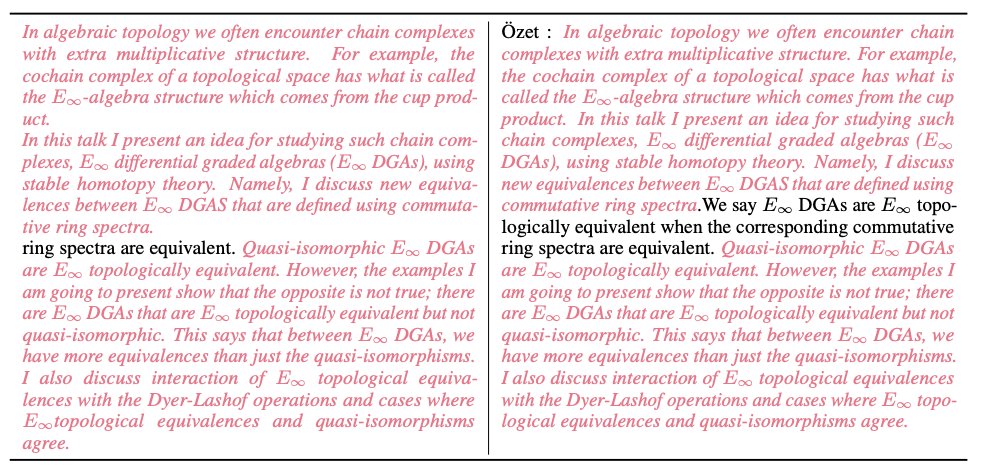

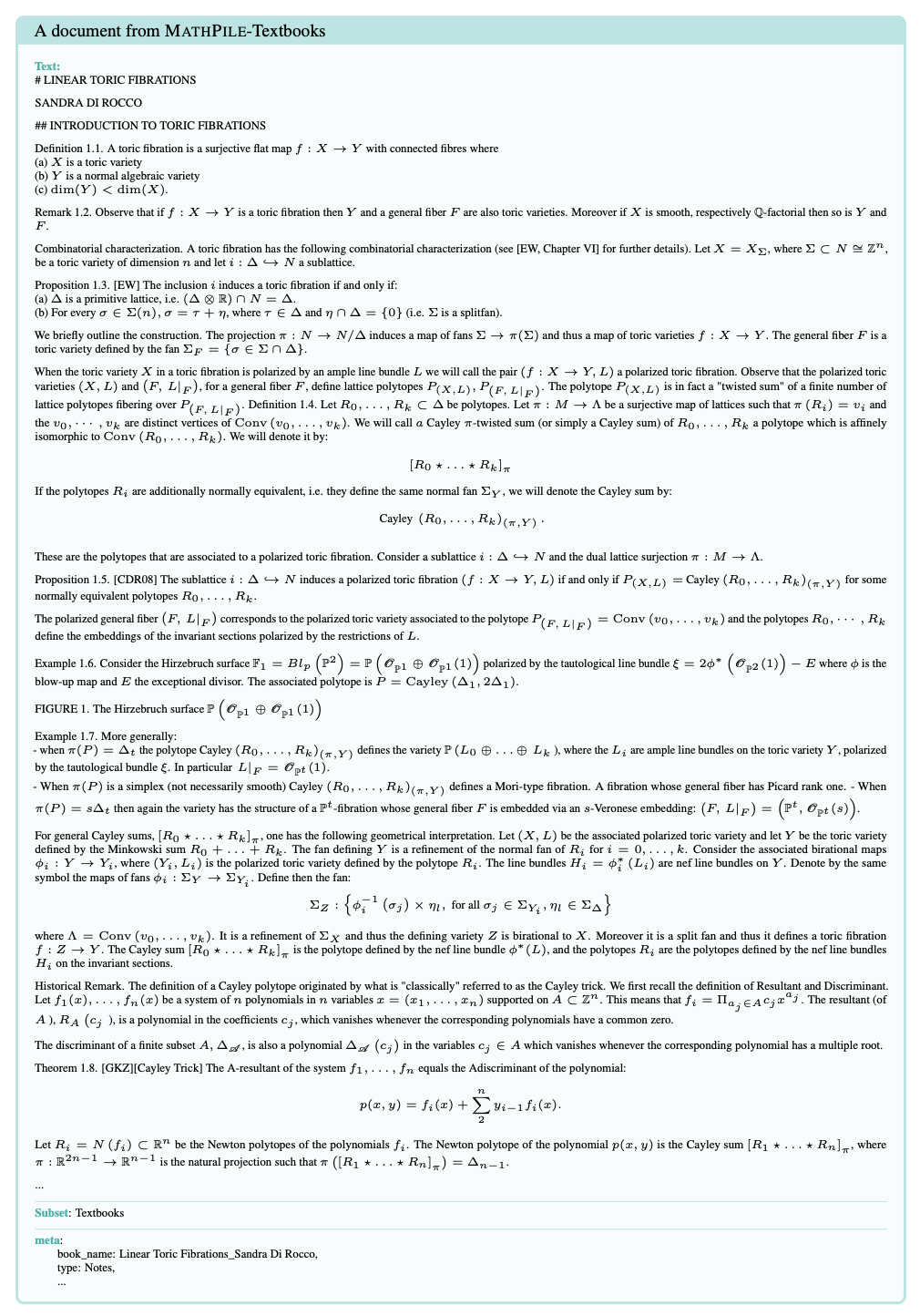

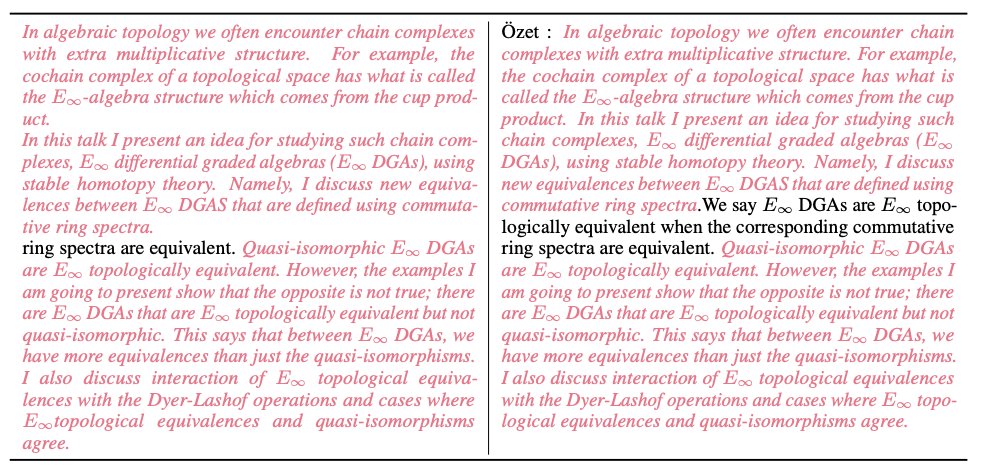

さらに、研究チームは洗浄プロセス中に多くのデータサンプルも提供しました。下の図は、MinHash LSH アルゴリズムによって検出された Common Crawl 内のほぼ重複したドキュメントを示しています (ピンクのハイライトで表示)。

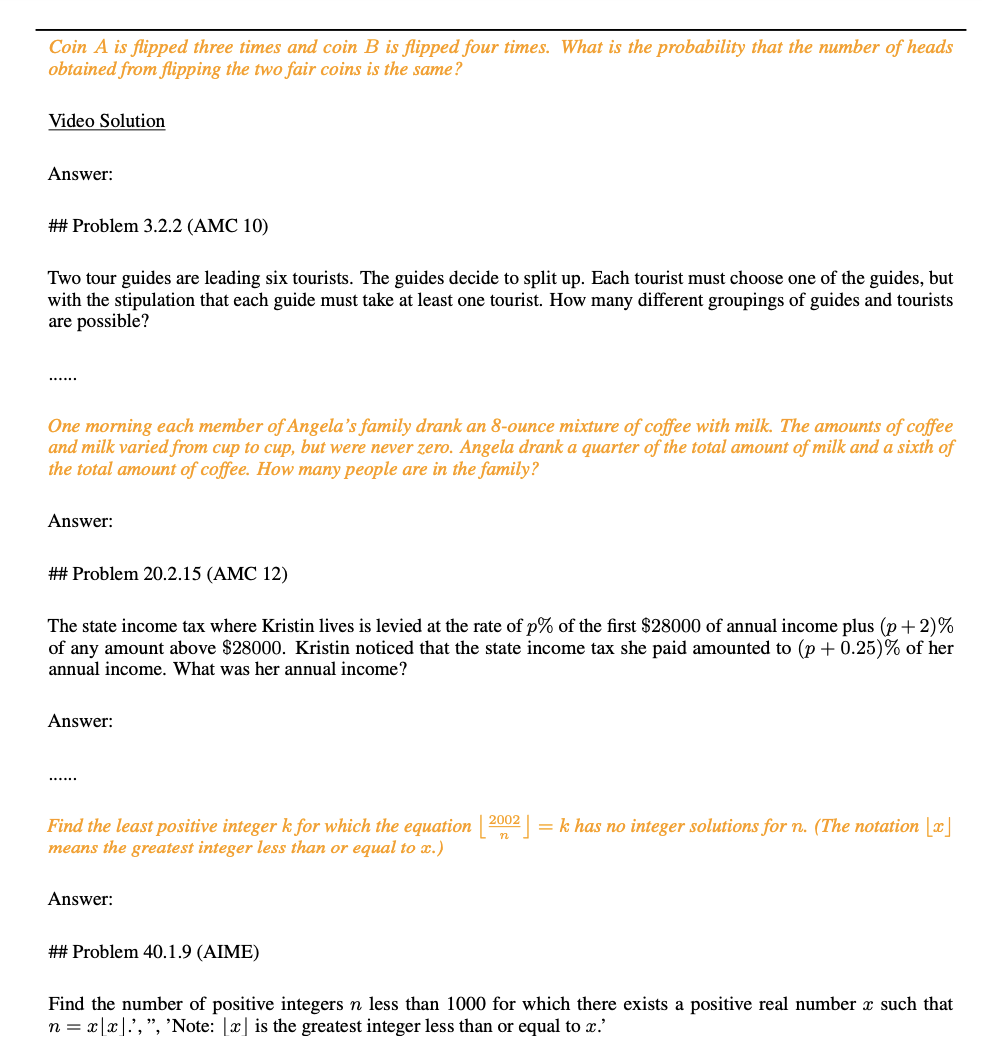

以下の図に示すように、研究チームはデータ漏洩検出プロセス中に MATH テスト セットの問題 (黄色で強調表示された部分) を発見しました。

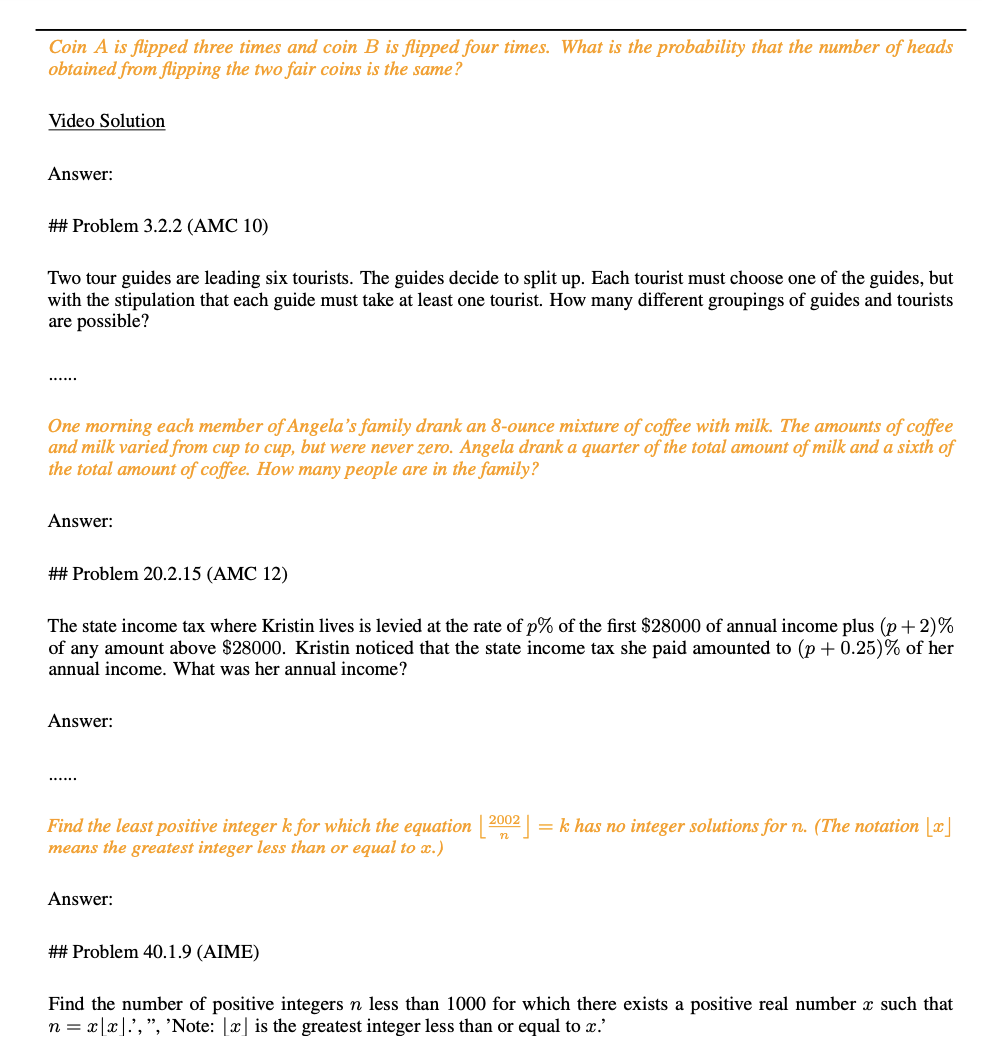

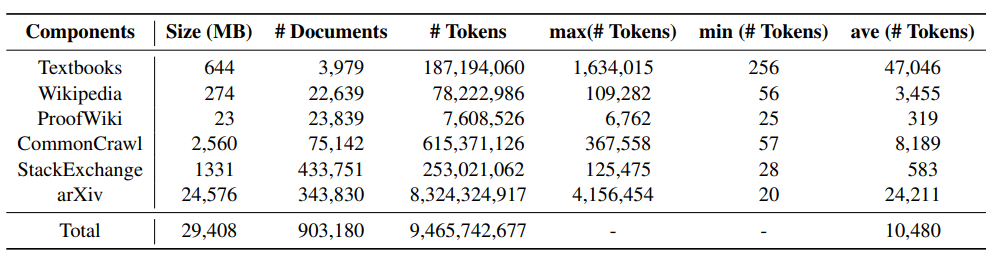

#データ セットの統計と例

次の表は、MathPile のさまざまなコンポーネントを示しています。統計情報によると、arXiv の論文が見つかります。通常、教科書の文書の長さは長くなりますが、Wiki の文書は比較的短いです。

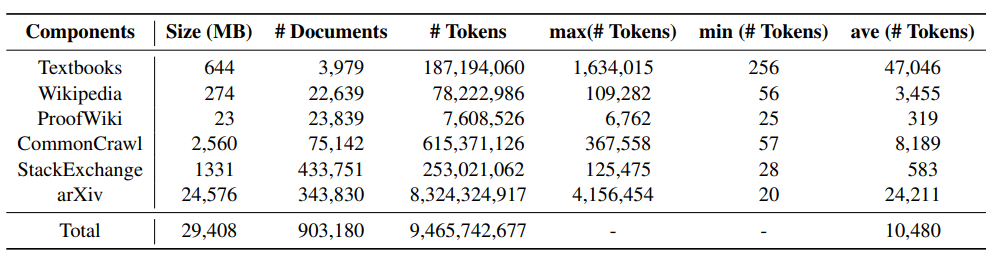

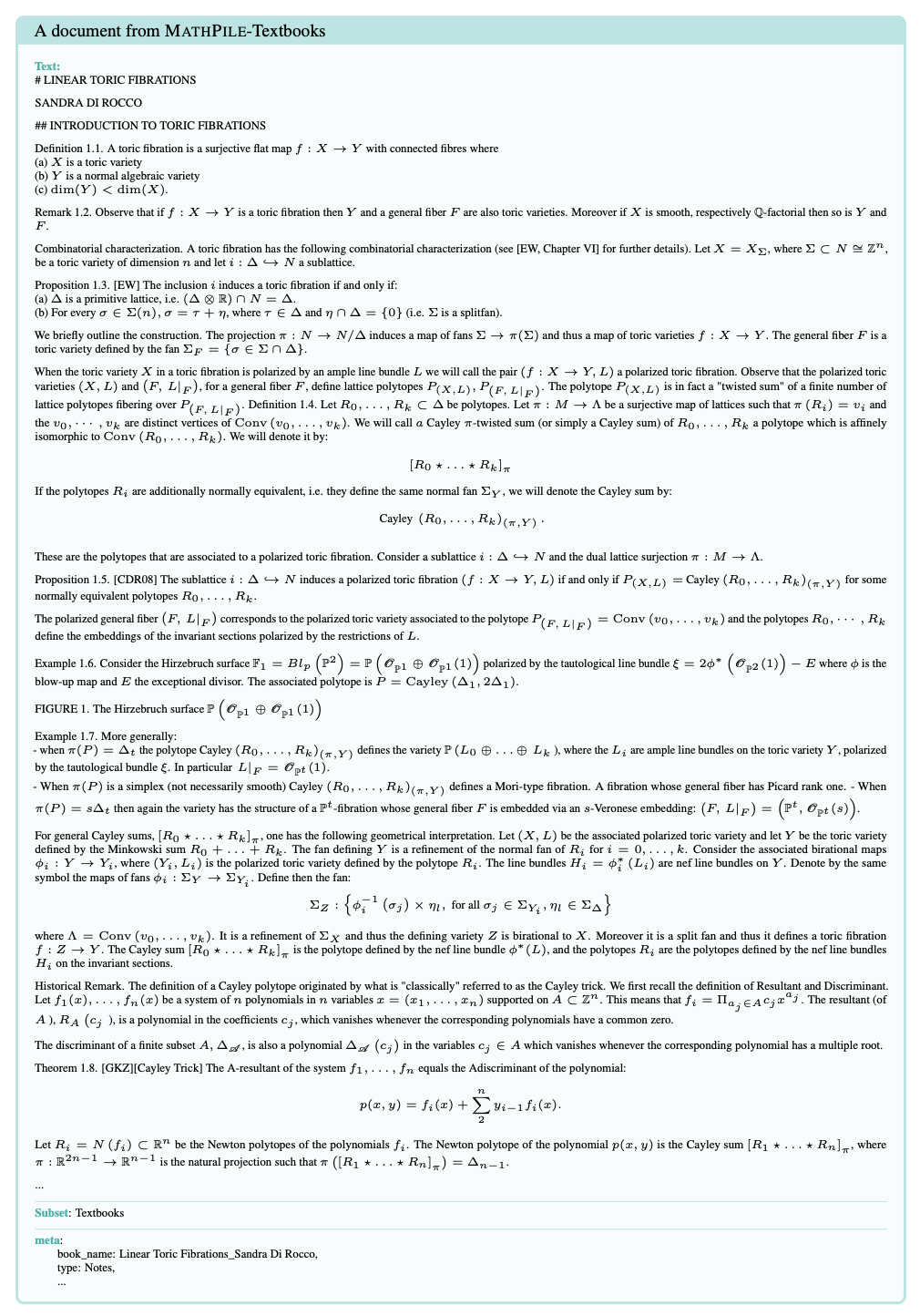

下の図は、MathPile コーパス内の教科書のサンプル文書です。文書構造が比較的明確で、品質が高いことがわかります。は高い。

実験結果

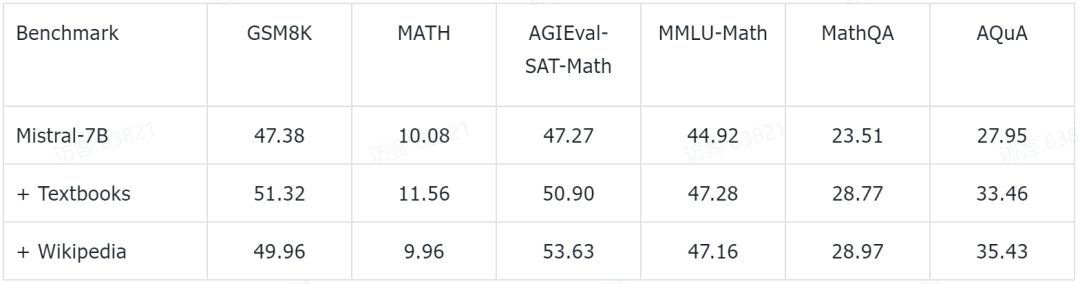

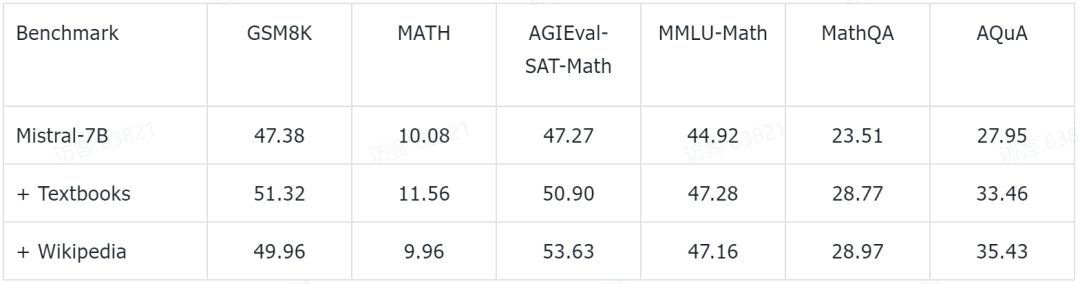

研究チームは、いくつかの予備的な実験結果も公開しました。彼らは、現在人気のある Mistral-7B モデルに基づいて、さらなる事前トレーニングを実行しました。次に、いくつかの一般的な数学的推論ベンチマーク データ セットに基づいて、少数ショット プロンプト手法によって評価されました。これまでに得られた予備的な実験データは次のとおりです。

これらのテスト ベンチマークは、小学校の数学 (GSM8K、TAL など) を含む、あらゆるレベルの数学的知識をカバーします。 SCQ5K-EN および MMLU-Math)、高校数学 (MATH、SAT-Math、MMLU-Math、AQuA、MathQA など)、および大学数学 (MMLU-Math など)。研究チームが発表した予備実験結果によると、MathPileの教科書とWikipediaのサブセットで事前トレーニングを続けることで、言語モデルがさまざまな難易度で数学的推論能力の大幅な向上を達成したことが示されている。

これらのテスト ベンチマークは、小学校の数学 (GSM8K、TAL など) を含む、あらゆるレベルの数学的知識をカバーします。 SCQ5K-EN および MMLU-Math)、高校数学 (MATH、SAT-Math、MMLU-Math、AQuA、MathQA など)、および大学数学 (MMLU-Math など)。研究チームが発表した予備実験結果によると、MathPileの教科書とWikipediaのサブセットで事前トレーニングを続けることで、言語モデルがさまざまな難易度で数学的推論能力の大幅な向上を達成したことが示されている。

研究チームは、関連する実験が現在も進行中であることも強調した。 #########結論######MathPile はリリース以来広く注目を集め、多くの関係者によって複製されており、現在は Huggingface Datasets のトレンド リストに掲載されています。研究チームは、データ品質をさらに向上させるために、データセットの最適化とアップグレードを継続すると述べています。

MathPile は、Huggingface データセットでトレンドになっています。  MathPile は、有名な AI ブロガー AK によって転送されました (出典: https://twitter.com/_akhaliq/status/1740571256234057798)。

MathPile は、有名な AI ブロガー AK によって転送されました (出典: https://twitter.com/_akhaliq/status/1740571256234057798)。

現在、MathPile はオープンソース コミュニティの研究開発に貢献することを目的として、第 2 バージョンに更新されています。同時に、商用版のデータセットも公開されました。

以上が大規模モデルの数学を補足するには、95 億トークンを含むオープンソースの MathPile コーパスを提出してください。これは商業的にも使用できます。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。

これらのテスト ベンチマークは、小学校の数学 (GSM8K、TAL など) を含む、あらゆるレベルの数学的知識をカバーします。 SCQ5K-EN および MMLU-Math)、高校数学 (MATH、SAT-Math、MMLU-Math、AQuA、MathQA など)、および大学数学 (MMLU-Math など)。研究チームが発表した予備実験結果によると、MathPileの教科書とWikipediaのサブセットで事前トレーニングを続けることで、言語モデルがさまざまな難易度で数学的推論能力の大幅な向上を達成したことが示されている。

これらのテスト ベンチマークは、小学校の数学 (GSM8K、TAL など) を含む、あらゆるレベルの数学的知識をカバーします。 SCQ5K-EN および MMLU-Math)、高校数学 (MATH、SAT-Math、MMLU-Math、AQuA、MathQA など)、および大学数学 (MMLU-Math など)。研究チームが発表した予備実験結果によると、MathPileの教科書とWikipediaのサブセットで事前トレーニングを続けることで、言語モデルがさまざまな難易度で数学的推論能力の大幅な向上を達成したことが示されている。