Transformer の強力な汎化能力が再び証明されました。

近年、トランスベースの構造はさまざまなタスクで優れたパフォーマンスを示し、世界的な注目を集めています。この構造を使用し、それを大量のデータと組み合わせることで、結果として得られる大規模言語モデル (LLM) などのモデルを実際のアプリケーション シナリオにうまく適合させることができます。

Transformer ベースの構造と LLM は、一部の分野では成功を収めていますが、特に計画タスクや推論タスクの処理において依然として課題に直面しています。以前の研究では、LLM は複数ステップの計画タスクや高次の推論タスクを扱うのが難しいことが示されています。

Transformer の推論と計画のパフォーマンスを向上させるために、研究コミュニティは近年、いくつかの方法も提案しています。最も一般的で効果的な方法の 1 つは、人間の思考プロセスをシミュレートすることです。最初に中間的な「思考」を生成し、次に応答を出力します。たとえば、思考連鎖 (CoT) プロンプト手法は、モデルが中間ステップを予測し、段階的な「思考」を実行することを促します。思考ツリー (ToT) は、分岐戦略と評価方法を使用して、モデルが複数の異なる思考パスを生成し、それらから最適なパスを選択できるようにします。これらの手法は多くの場合効果的ですが、多くの場合、これらの手法は自己強制などの理由でモデルのパフォーマンスを低下させることが研究で示されています。

あるデータセットで良好なパフォーマンスを発揮する手法が、他のデータセットでは良好なパフォーマンスを発揮しない可能性があります。これは、空間的推論から数学的推論や常識的推論への移行など、必要とされる推論のタイプの変化が原因である可能性があります。

対照的に、従来のシンボリックな計画および検索手法は、優れた推論能力を示します。さらに、シンボリック計画アルゴリズムは通常、明確に定義されたルールベースの検索プロセスに従うため、これらの従来の方法で計算された解には正式な保証が備わっていることがよくあります。

Transformer に複雑な推論機能を装備するために、Meta FAIR Tian Yuandong チームは最近 Searchformer を提案しました。

論文のタイトル: A* を超えて: 検索ダイナミクス ブートストラップによるトランスフォーマーによるより良い計画

論文のアドレス: https://arxiv.org/pdf/2402.14083.pdf

Searchformer は Transformer モデルですが、迷路ナビゲーションや箱押しなどの複数ステップの計画タスクの場合は、最適な計画が得られ、使用される検索ステップの数は、A* 検索などの記号計画アルゴリズムの数よりもはるかに少なくなります。

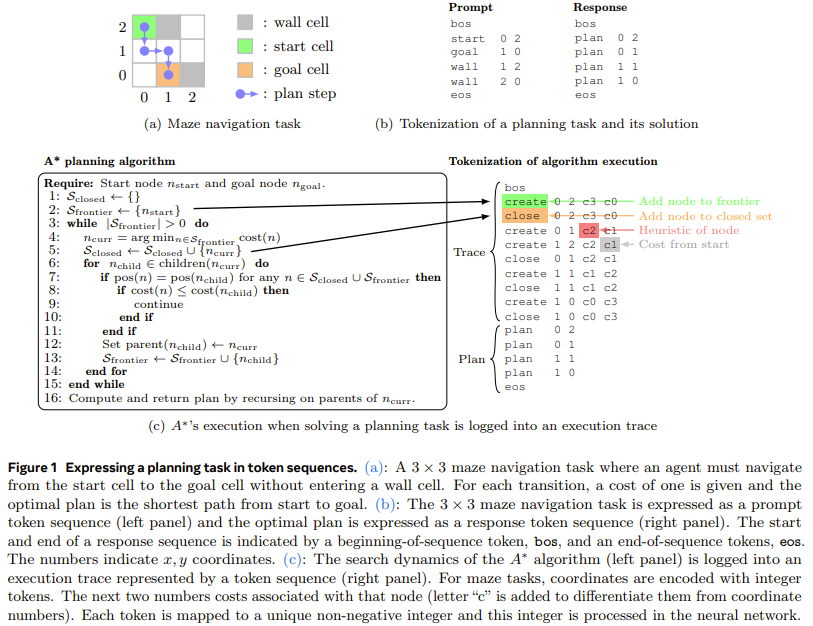

これを実現するために、チームは新しい方法、検索ダイナミクス ブートストラップを提案しました。この方法では、まず A* の検索プロセス (図 1 を参照) を模倣するように Transformer モデルをトレーニングし、次に、より少ない検索ステップで最適なプランを見つけられるように微調整します。

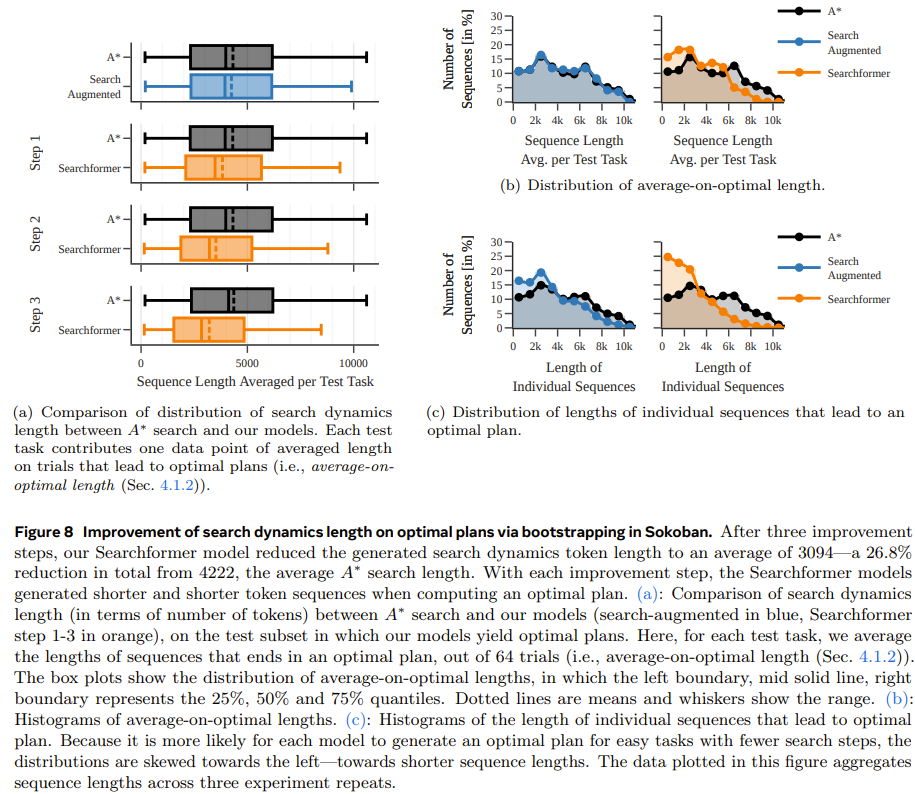

#詳細については、最初のステップは、A* 検索を模倣する Transformer モデルをトレーニングすることです。ここで、チームのアプローチは、ランダムに生成された計画タスク インスタンスに対して A* 検索を実行することです。 A* When を実行した後、チームは、実行された計算と最適な計画を記録し、それらを単語シーケンス、つまりトークンに編成します。このようにして、結果として得られるトレーニング データセットには、A* の実行軌跡が含まれており、A* 自体に関する情報がエンコードされています。動的情報を検索します。次に、Transformer モデルをトレーニングして、あらゆる計画タスクの最適な計画に沿ってこれらのトークン シーケンスを生成できるようにします。検索強化シーケンス (A* の実行トレースを含む) 専門的な反復手法により、Transformer はより少ない検索ステップで最適なソリューションを生成できます。このプロセスにより、Transformer のネットワーク重みの中で暗黙的にエンコードされるニューラル プログラミング アルゴリズムが生成されます。 A* 探索よりも少ない探索ステップで最適な計画を見つける確率が高い. たとえば, 箱を押すタスクを実行する場合, 新しいモデルはテスト タスクの 93.7% に応答できます, 同時探索ステップ数は 26.8 % は平均 A* 検索よりも少ないです。

実験

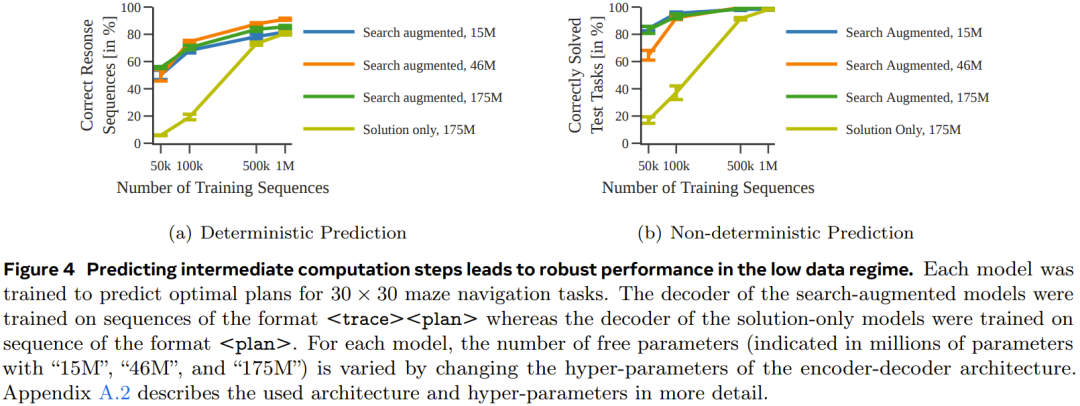

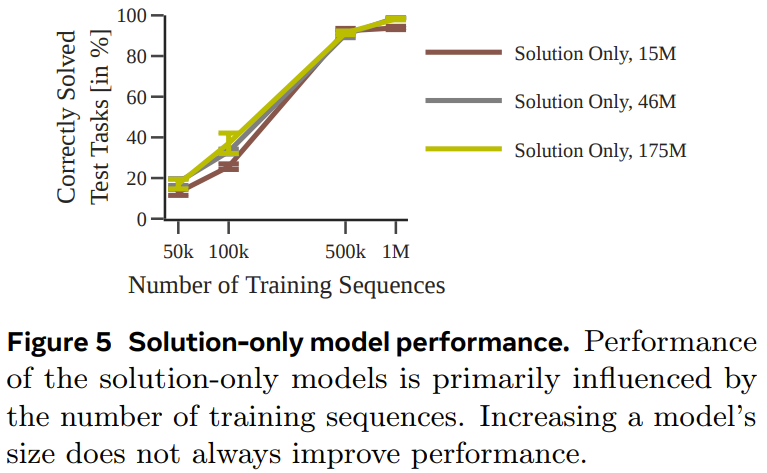

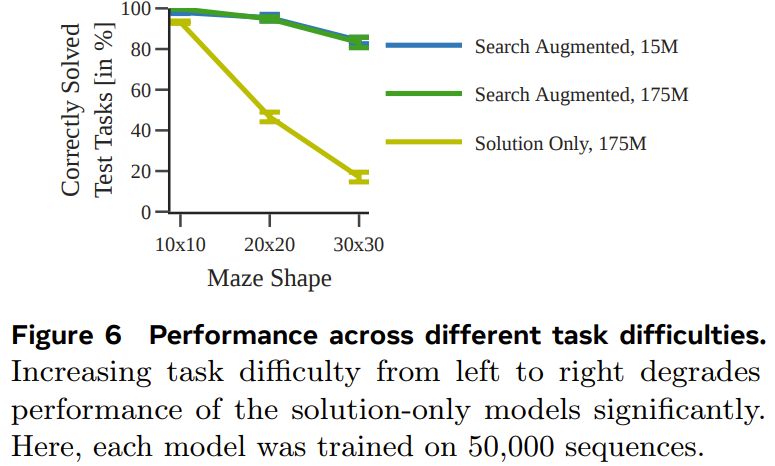

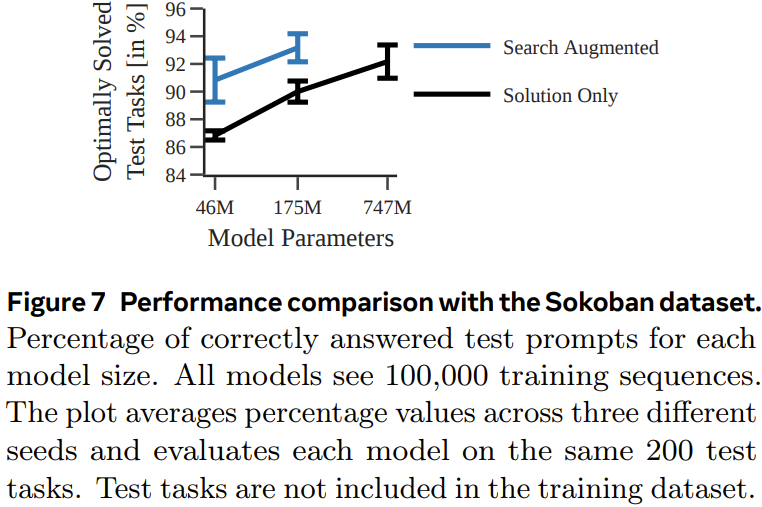

トレーニング データの量とモデル パラメーターが結果として得られるモデルのパフォーマンスに与える影響をよりよく理解するために、彼らはいくつかのアブレーション研究を実施しました。彼らはモデルのトレーニングに 2 種類のデータ セットを使用しました。 1 つのタイプのトークン シーケンスにはソリューションのみが含まれます (ソリューションのみ、タスクの説明と最終計画のみが含まれます)、もう 1 つは検索拡張型 (タスクの説明、検索ツリーのダイナミクス、および最終計画が含まれます)

実験では、チームは A* 検索の決定論的バリアントと非決定論的バリアントを使用して、各配列データ セットを生成しました。チームは、エンコーダー/デコーダーの Transformer モデルのセットをトレーニングして、30×30 の迷路内の最適な経路を予測しました。図 4 は、中間の計算ステップを予測することで、データ量が少ない場合に、より堅牢なパフォーマンスを達成できることを示しています。

Sokoban

Searchformer: ブートストラップによる検索ダイナミクスの改善

最後の実験として、チームは、より少ない検索ステップに依存するように検索強化モデルを反復的に改善する方法を調査しました。数値的に最適な計画を立てます。ここでの目標は、最適な解を取得しながら、探索軌跡の長さを短縮することです。

以上がTransformer 計画の欠点を補うために、Tian Yuandong チームの Searchformer が人気を集めましたの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。