時系列融合は、自動運転の 3D ターゲット検出の知覚能力を向上させる効果的な方法ですが、現在の方法を応用するとコストがかかります。実際の自動運転シナリオやその他の問題。最新の研究記事「3D オブジェクト検出のためのクエリベースの明示的モーション タイミング フュージョン」では、NeurIPS 2023 で新しいタイミング フュージョン手法を提案しました。この手法は、スパース クエリをタイミング フュージョンの対象とし、明示的なモーション情報を使用してタイミング アテンション マトリックスを生成し、それに適応します。大規模点群の特徴。この方法は、華中科技大学と Baidu の研究者によって提案されたもので、QTNet と呼ばれています。クエリと明示的なモーションに基づいて 3D ターゲットを検出するための時間融合方法です。実験により、QTNet はほとんどコストをかけずに点群、画像、およびマルチモーダル検出器のパフォーマンスを一貫して向上させることができることが証明されました。

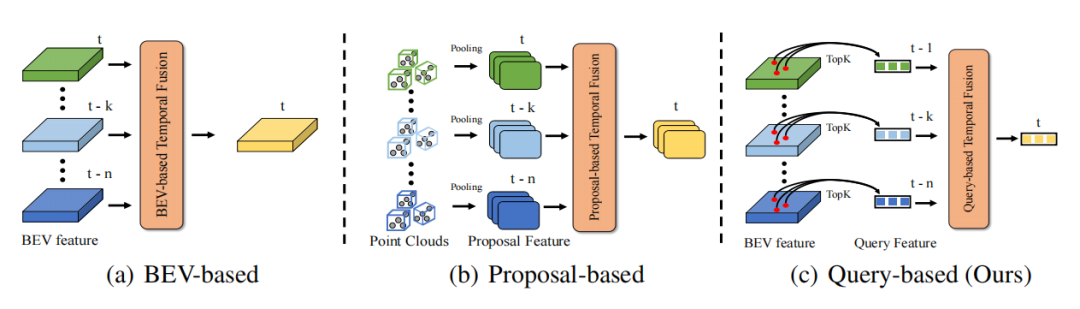

現実世界の時間的連続性のおかげで、時間次元の情報により知覚情報がより完全になり、それによってターゲット検出の精度とロバスト性が向上します。たとえば、タイミング情報はターゲット検出の問題の解決に役立ちます。オクルージョン問題を解決し、ターゲットの動作ステータスと速度情報を提供し、ターゲットの永続性と一貫性情報を提供します。したがって、タイミング情報をいかに効率的に活用するかが自動運転の知覚において重要な課題となる。既存のタイミング融合手法は主に 2 つのカテゴリに分類されます。 1 つは高密度 BEV 特徴に基づく時系列融合 (点群/画像時系列融合に適用)、もう 1 つは 3D プロポーザル機能に基づく時系列融合 (主に点群時系列融合手法を対象) です。 BEV の特徴に基づく時間融合の場合、BEV 上のポイントの 90% 以上が背景であるため、このタイプの方法では前景のオブジェクトにあまり注意が払われず、その結果、多くの不必要な計算オーバーヘッドが発生し、最適なパフォーマンスが得られません。 3D プロポーザルに基づく時系列融合アルゴリズムの場合、時間のかかる 3D RoI プーリングを通じて 3D プロポーザル フィーチャを生成します。特にターゲットが多く、点群の数が多い場合、3D RoI プーリングによって生じるオーバーヘッドは実際には非常に高くなります。申請しても受理されにくい場合が多いです。さらに、3D プロポーザル機能はプロポーザルの品質に大きく依存しており、複雑なシーンではプロポーザルの品質が制限されることがよくあります。したがって、現在の方法では、時間的融合を効率的に導入して、非常に低いオーバーヘッドの方法で 3D ターゲット検出のパフォーマンスを向上させることは困難です。

DETR は非常に優れたターゲット検出パラダイムであり、そのクエリ設計とセット予測のアイデアにより、後処理なしでエレガントな検出パラダイムを効果的に実現します。 DETR では、各クエリはオブジェクトを表し、クエリは密な特徴に比べて非常に疎です (通常、クエリの数は比較的小さい固定数に設定されます)。 Quey をタイミング融合の対象として使用すれば、計算オーバーヘッドの問題は当然低いレベルに下がります。したがって、DETR のクエリ パラダイムは、当然ながらタイミング融合に適したパラダイムです。時間的融合では、時間的コンテキスト情報の合成を達成するために、複数のフレーム間のオブジェクトの関連付けを構築する必要があります。したがって、主な問題は、クエリベースのタイミング フュージョン パイプラインを構築し、2 つのフレーム間のクエリ間の相関関係を確立する方法です。

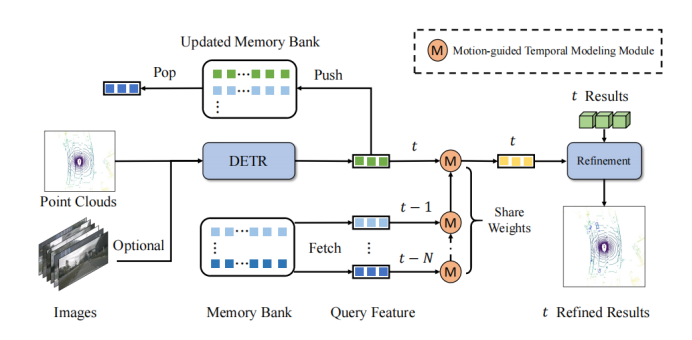

QTNet の中心的なアイデアは、メモリ バンクを使用して、履歴フレームで取得されたクエリ特徴とそれに対応する検出結果を保存することです。重複を避ける 過去のフレームのコストを計算します。クエリの 2 つのフレーム間で、リレーションシップ モデリングにモーション ガイド付きアテンション マトリックスを使用します

フレームワーク図に示されているように、QTNet には、3D DETR 構造を備えた 3D ターゲット検出器 (LiDAR、カメラ、マルチモーダルが利用可能)、メモリ バンク、およびタイミング融合のためのモーション ガイド付き時間モデリング モジュール (MTM) が含まれています。 。 QTNet は、DETR 構造の 3D ターゲット検出器を通じて、対応するフレームのクエリ特徴と検出結果を取得し、取得したクエリ特徴と検出結果を先入れ先出しキュー (FIFO) 方式でメモリ バンクに送信します。メモリ バンクの数は、タイミング フュージョンに必要なフレーム数に設定されます。タイミング融合の場合、QTNet は最も遠い時間から始めてメモリ バンクからデータを読み取り、MTM モジュールを使用してメモリ バンク内のすべての機能をフレームからフレームまで繰り返し融合します。現在のフレームのクエリ機能を強化し、強化されたクエリ機能に基づいて現在のフレームの対応する検出結果を調整します。

具体的には、QTNet はフレームとフレームのフレームとフレームのクエリ機能を融合します。フレームの拡張クエリ機能を取得します。次に、QTNet はフレームとフレームのクエリ機能を融合します。このようにして、繰り返しを通じてフレームに継続的に統合されます。ここで使用される MTM は、フレームからフレームまですべてパラメーターを共有していることに注意してください。

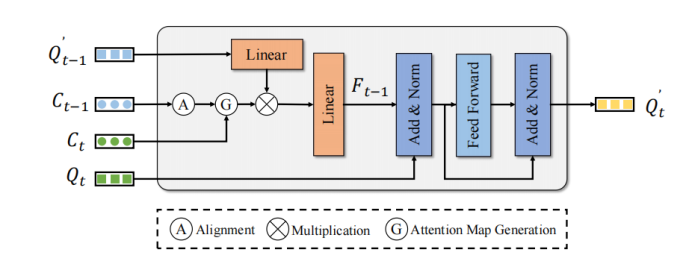

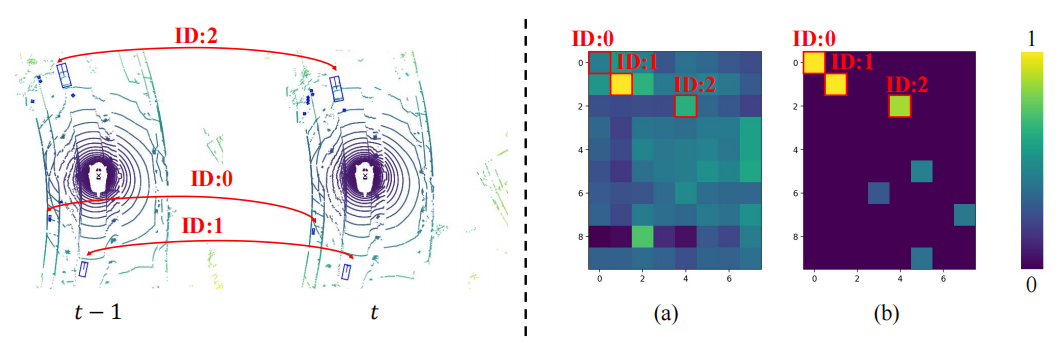

MTM は、オブジェクトの中心点の位置を使用して、明示的にフレームを生成しますクエリとフレーム クエリのアテンション マトリックス。エゴポーズ行列と、オブジェクトの中心点、および速度が与えられるとします。まず、MTM はエゴ ポーズとオブジェクト予測の速度情報を使用して、前のフレームのオブジェクトを次のフレームに移動し、2 つのフレームの座標系を揃えます。

次に、# を渡します。 ##フレーム オブジェクトの中心点とフレームの修正された中心点は、ユークリッド コスト行列を構築します。さらに、誤った一致の可能性を避けるために、この記事ではカテゴリと距離しきい値を使用してアテンション マスク:

Convert を構築します。コスト マトリックス 最終的な目標は、アテンション マトリックスを形成することです。 アテンション マトリックスをフレームの強化されたクエリ機能に適用して、集計します。強化する時間的特徴フレームのクエリ特徴:

最終的に強化されたフレームのクエリ特徴単純な FFN を通じて、対応する検出結果を洗練します検出性能の向上を実現します。

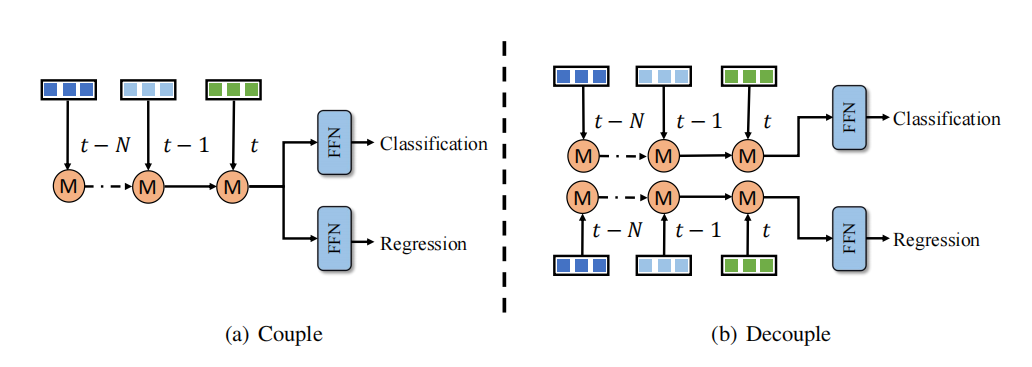

分離された時間融合構造 時間融合の分類と回帰学習に不均衡の問題があることが観察されています。ソリューション 時系列融合ブランチは、それぞれ分類と回帰のために設計されています。ただし、この分離アプローチでは、計算コストと待ち時間がさらに増加するため、ほとんどの方法では受け入れられません。対照的に、QTNet は効率的なタイミング フュージョン設計を利用しており、その計算コストと遅延は無視でき、3D 検出ネットワーク全体よりも優れたパフォーマンスを発揮します。したがって、この記事では、図

時間融合の分類と回帰学習に不均衡の問題があることが観察されています。ソリューション 時系列融合ブランチは、それぞれ分類と回帰のために設計されています。ただし、この分離アプローチでは、計算コストと待ち時間がさらに増加するため、ほとんどの方法では受け入れられません。対照的に、QTNet は効率的なタイミング フュージョン設計を利用しており、その計算コストと遅延は無視でき、3D 検出ネットワーク全体よりも優れたパフォーマンスを発揮します。したがって、この記事では、図

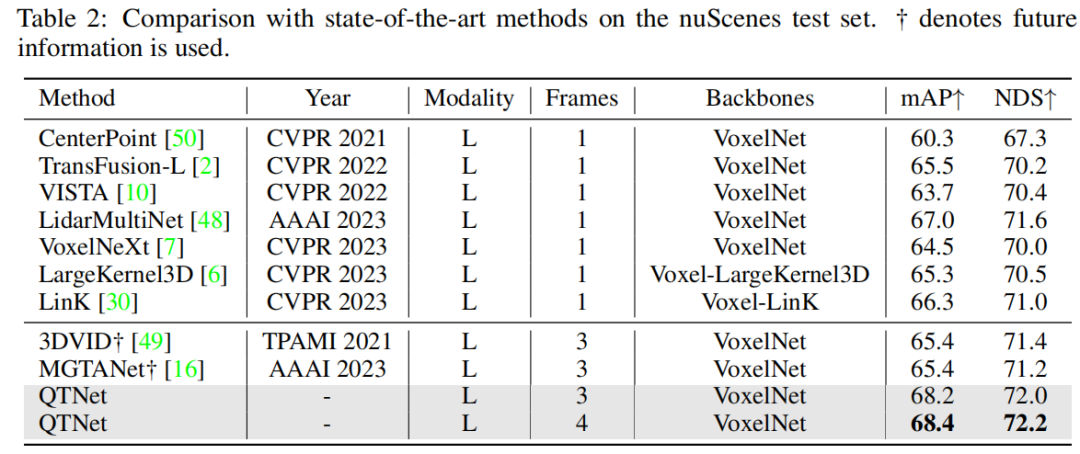

nuScenes データセットの検証後、QTNet は将来の When 情報、TTA、およびモデルが統合され、68.4 の mAP と 72.2 の NDS が達成され、SOTA パフォーマンスが達成されます。未来情報を使用する MGTANet と比較すると、3 フレーム タイミング フュージョンの場合、QTNet は MGTANet よりも優れたパフォーマンスを示し、それぞれ mAP が 3.0、NDS が 1.0 増加します

さらに、この記事は、マルチモーダルおよびリング ビューベースの方法でも検証されており、nuScenes 検証セットの実験結果は、さまざまなモダリティにおける QTNet の有効性を証明しています。

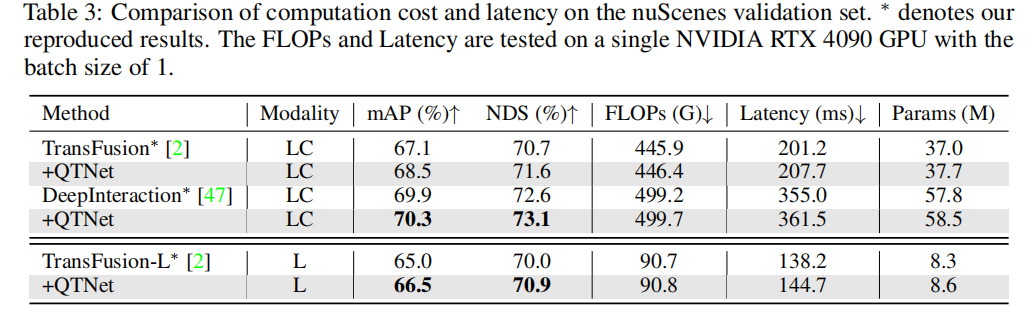

実際のアプリケーションでは、タイミング融合のコストのオーバーヘッドが非常に重要です。この記事では、QTNet について、計算量、遅延、パラメータ量の 3 つの側面から解析と実験を行います。結果は、ネットワーク全体と比較して、異なるベースラインによって引き起こされる QTNet の計算オーバーヘッド、時間遅延、パラメータ量が無視できるほど小さいことを示しています。特に計算量は 0.1G FLOP (LiDAR ベースライン) のみを使用します

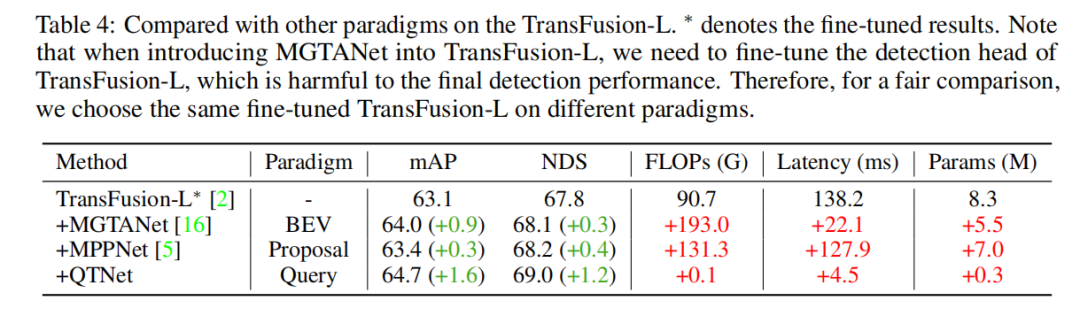

クエリベースのタイミング融合パラダイムの優位性を検証するために、さまざまな代表的なフロンティア タイミングを選択し、融合手法を比較しました。実験結果を通じて、クエリパラダイムに基づくタイミング融合アルゴリズムは、BEVおよび提案パラダイムに基づくものよりも効率的であることが判明した。 0.1G FLOP と 4.5ms オーバーヘッドのみを使用すると、QTNet はより優れたパフォーマンスを示しますが、パラメーター全体の量はわずか 0.3M

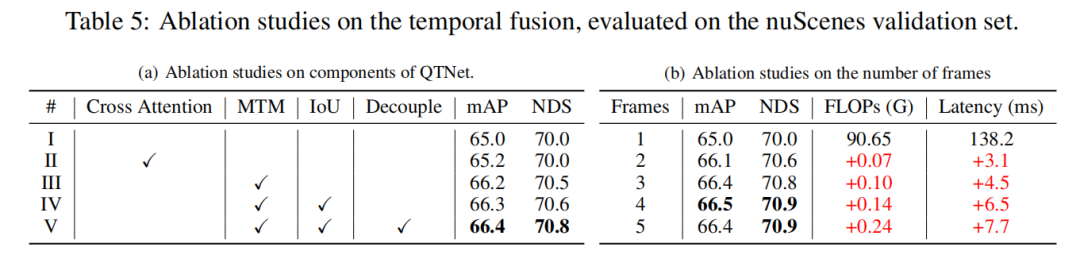

この研究では、nuScenes 検証セット上の LiDAR ベースラインに基づいて、3 フレームの時間融合によるアブレーション実験を実施しました。実験結果は、単にクロスアテンションを使用して時間的関係をモデル化しても明らかな効果がないことを示しています。ただし、MTM を使用すると、検出パフォーマンスが大幅に向上します。これは、大規模な点群における明示的なモーション ガイダンスの重要性を示しています。さらに、アブレーション実験を通じて、QTNet の全体的な設計が非常に軽量で効率的であることもわかりました。 4 フレームのデータをタイミング フュージョンに使用する場合、QTNet の計算量はわずか 0.24G FLOP、遅延はわずか 6.5 ミリ秒です。

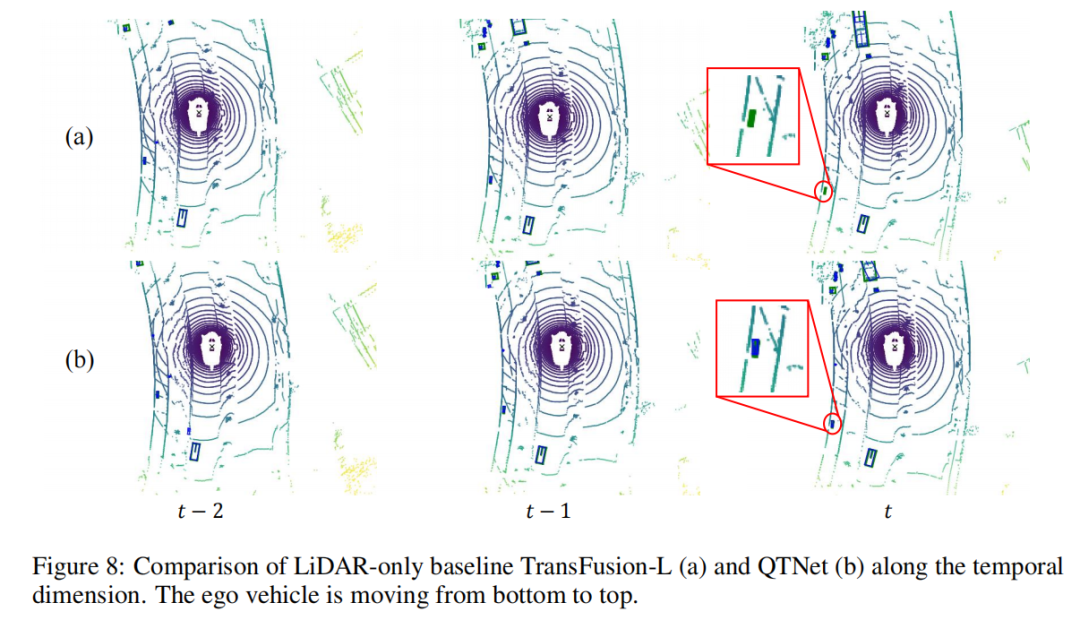

から開始して車両から急速に遠ざかり、ベースラインがフレームのオブジェクトを見逃していることがわかります。まだフレーム内で検出されますオブジェクトが検出されました。これは、時間融合における QTNet の有効性を証明しています。

#この記事の概要

#この記事の概要

書き直す必要がある内容は次のとおりです: 元のリンク: https://mp.weixin.qq.com/s/s9tkF_rAP2yUEkn6tp9eUQ

以上がQTNet: 点群、画像、マルチモーダル検出器用の新しい時間融合ソリューション (NeurIPS 2023)の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。