コーネル大学と Apple の最新の研究では、より少ない計算能力で高解像度の画像を生成するには、アテンション メカニズムを削除できると結論付けています。

##ご存知のとおり、アテンション メカニズムは Transformer アーキテクチャの中核コンポーネントであり、高品質のテキストと画像の生成に不可欠です。しかし、その欠陥も明らかです。つまり、シーケンスの長さが増加するにつれて、計算の複雑さが二次関数的に増加します。これは、長いテキストや高解像度の画像処理において厄介な問題です。

この問題を解決するために、この新しい研究では、従来のアーキテクチャのアテンション メカニズムをよりスケーラブルな状態空間モデル (SSM) バックボーンに置き換え、拡散状態空間モデルと呼ばれる新しいアーキテクチャを開発します。 (ディフューズ)。この新しいアーキテクチャは、より少ないコンピューティング能力を使用して、注目モジュールを備えた既存の拡散モデルの画像生成効果と同等またはそれを超え、優れた高解像度画像を生成できます。

先週の「Mamba」のリリースのおかげで、状態空間モデル SSM がますます注目を集めています。 Mamba の中核は、新しいアーキテクチャ「選択的状態空間モデル」の導入であり、これにより、Mamba は言語モデリングにおいて Transformer に匹敵する、あるいはそれを上回ることさえあります。当時、論文著者の Albert Gu 氏は、Mamba の成功により SSM の将来に自信が持てるようになったと述べました。さて、コーネル大学と Apple のこの論文には、SSM の応用可能性の新たな例が追加されているようです。

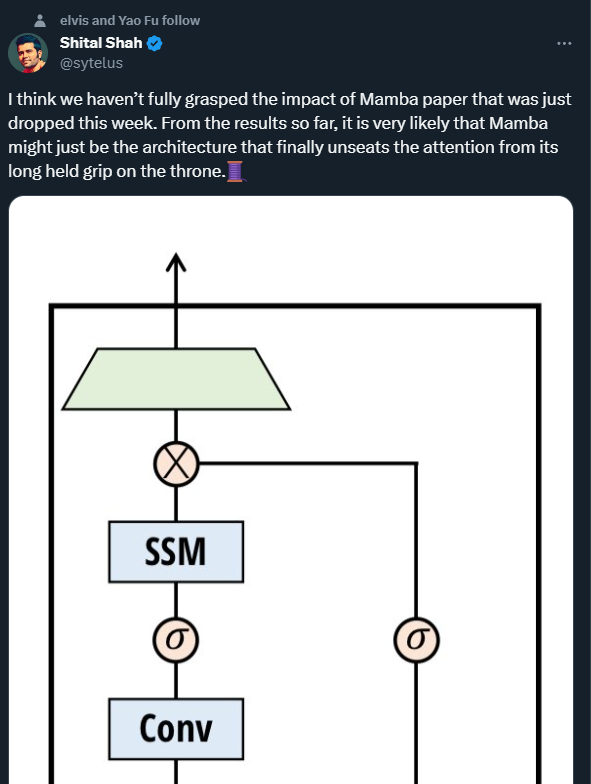

Microsoft の主任研究エンジニアである Shital Shah 氏は、注意喚起のメカニズムが、長い間座ってきた玉座から引きはがされる可能性があると警告しました。

画像生成分野の急速な進歩は、ノイズ除去拡散の恩恵を受けています。確率モデル (DDPM)。このようなモデルは、生成プロセスを反復ノイズ除去潜在変数としてモデル化し、十分なノイズ除去ステップが実行されると、忠実度の高いサンプルを生成できます。 DDPM は複雑な視覚的分布を捕捉できるため、高解像度でフォトリアリスティックな構成を実現するのに潜在的に有利です。

DDPM をより高い解像度に拡張するには、計算上の重大な課題が残っています。主なボトルネックは、高忠実度の生成を達成する際に自分自身の注意力に依存していることです。 U-Nets アーキテクチャでは、このボトルネックは ResNet とアテンション レイヤーを組み合わせることで発生します。 DDPM は敵対的生成ネットワーク (GAN) を超えていますが、マルチヘッド アテンション レイヤーを必要とします。 Transformer アーキテクチャでは、注意が中心的なコンポーネントであるため、最先端の画像合成結果を達成するために重要です。どちらのアーキテクチャでも、アテンションの複雑さはシーケンスの長さに応じて二次関数的に増加するため、高解像度画像を処理する場合には実行不可能になります。

計算コストのため、以前の研究者は表現圧縮手法を使用するようになりました。高解像度アーキテクチャでは、パッチ適用またはマルチスケール解像度が採用されることがよくあります。ブロッキングにより、粗粒度の表現が作成され、計算コストが削減されますが、重要な高周波空間情報と構造的完全性が犠牲になります。マルチスケール解像度は、アテンション レイヤーの計算を削減する一方で、ダウンサンプリングを通じて空間的な詳細も削減し、アップサンプリングが適用されるときにアーティファクトを生じさせます。

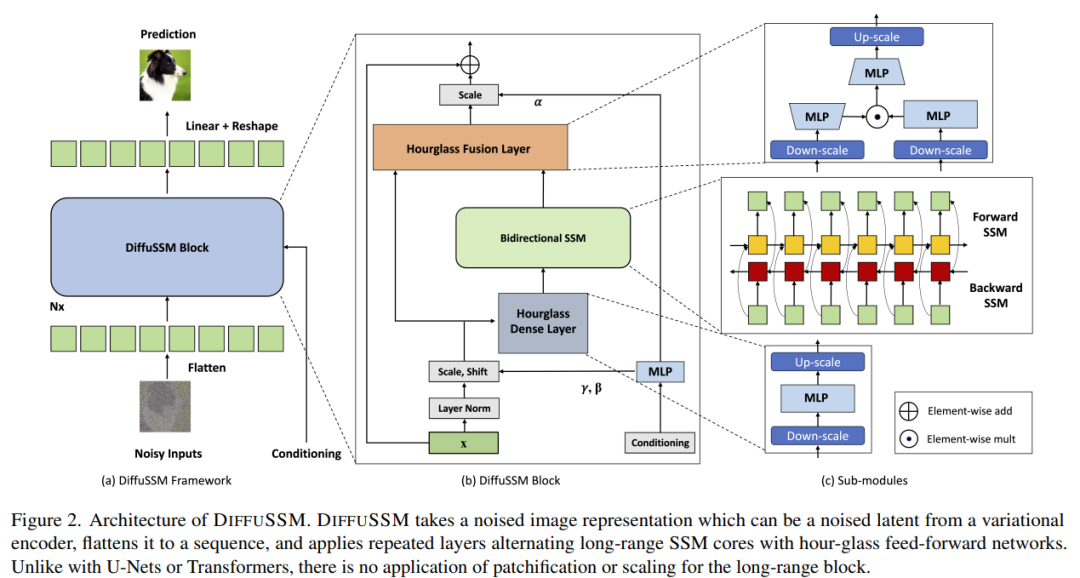

DIFFUSSM は、アテンション メカニズムを使用しない拡散状態空間モデルであり、高解像度画像合成でアテンション メカニズムを適用するときに発生する問題を解決するように設計されています。 DIFFUSSM は、拡散プロセスでゲート状態空間モデル (SSM) を使用します。これまでの研究では、SSM ベースのシーケンス モデルが効果的かつ効率的な一般的なニューラル シーケンス モデルであることが示されています。このアーキテクチャを採用することで、SSM コアがよりきめの細かい画像表現を処理できるようになり、グローバル タイルやマルチスケール レイヤーが不要になります。効率をさらに向上させるために、DIFFUSSM はネットワークの高密度コンポーネントに砂時計アーキテクチャを採用しています。

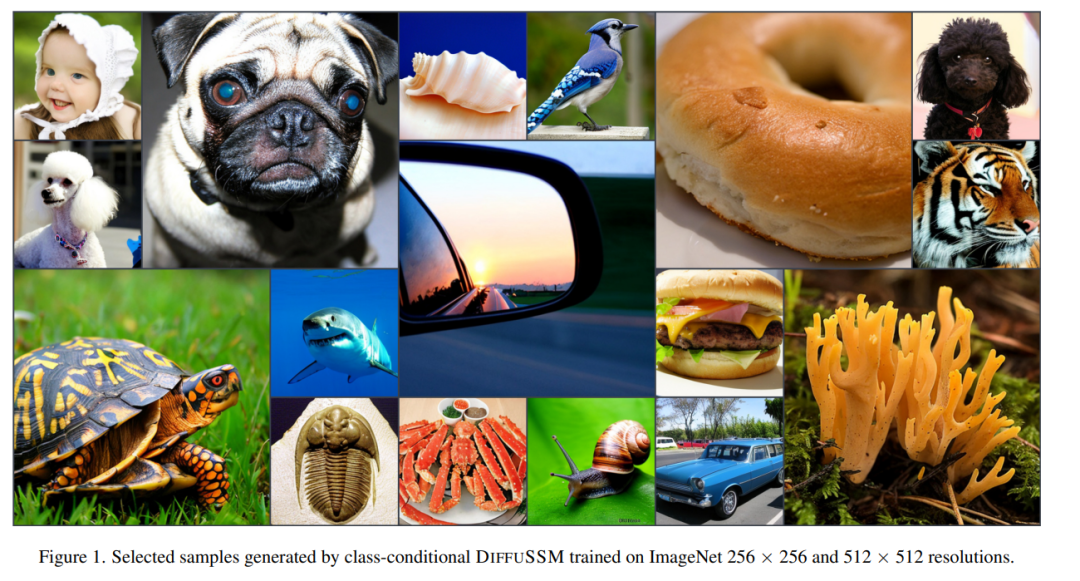

著者は、さまざまな解像度で DIFFUSSM のパフォーマンスを検証しました。 ImageNet での実験では、DIFFUSSM がさまざまな解像度で総 Gflops を減らしながら、FID、sFID、およびインセプション スコアの一貫した改善を達成することが実証されています。

#論文リンク: https://arxiv.org/pdf/2311.18257.pdf

元の意味を変えないように、内容を中国語に書き直す必要があります。 著者らの目標は、ブロッキングのような「長さの短縮」を必要とせずに、高解像度で長距離相互作用を学習できる拡散アーキテクチャを設計することでした。 DiT と同様に、このアプローチは画像を平坦化し、シーケンス モデリングの問題として扱うことで機能します。ただし、Transformer とは異なり、このメソッドは、このシーケンスの長さを処理するときに二次計算を使用します。

DIFFUSSM は、長いシーケンスを処理するために最適化されたゲートです。双方向 SSM のコア コンポーネント。効率を向上させるために、著者は MLP 層に砂時計アーキテクチャを導入しました。この設計は、MLP 内のシーケンス長を選択的に削減しながら、双方向 SSM の周囲でシーケンス長を交互に拡張および縮小します。完全なモデル アーキテクチャを図 2 に示します。

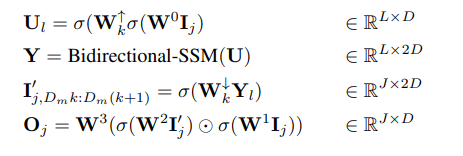

具体的には、各砂時計層は短縮され平坦化された入力シーケンス I ∈ R ^(J×D )、ここで M = L/J は縮小と拡大の比です。同時に、双方向 SSM を含むブロック全体が、グローバル コンテキストを最大限に活用して、元の長さに基づいて計算されます。この記事では、活性化関数を表すために σ を使用します。 l ∈ {1 . . . L} (j = ⌊l/M⌋、m = l mod M、D_m = 2D/M) の場合、計算式は次のとおりです。

#著者は、各層でスキップ接続を使用してゲート SSM ブロックを統合しています。著者らは、図 2 に示すように、クラス ラベル y ∈ R^(L×1) とタイム ステップ t ∈ R^(L×1) の組み合わせを各位置で統合します。

パラメータ: DIFFUSSM ブロック内のパラメータの数は、主に 9D^2 2MD^2 パラメータを含む線形変換 W によって決定されます。 M = 2 の場合、13D^2 パラメーターが生成されます。 DiT 変換ブロックのコア変換層には 12D^2 パラメータがありますが、DiT アーキテクチャの他の層コンポーネント (適応層正規化) にはさらに多くのパラメータがあります。研究者らは、追加の DIFFUSSM レイヤーを使用して実験のパラメーターを一致させました。

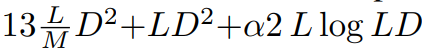

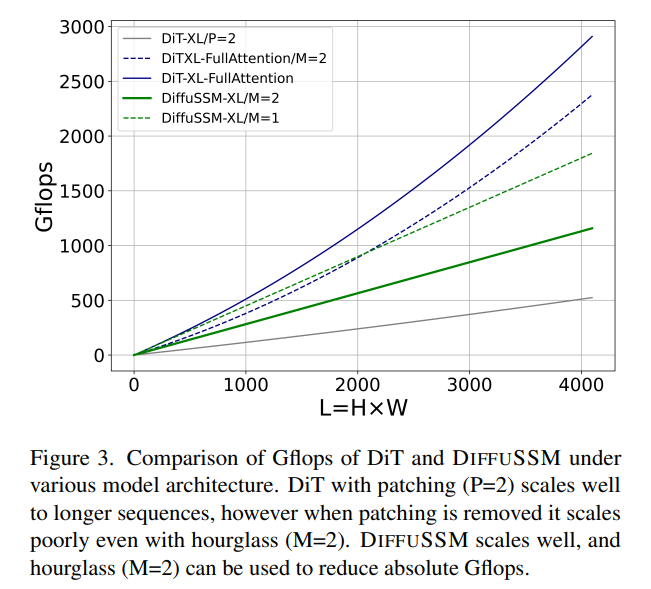

FLOPs: 図 3 は、DiT と DIFFUSSM の Gflops を比較しています。 DIFFUSSM 層の合計フロップは

です。ここで、α は FFT 実装の定数を表します。 M = 2 で線形層が計算の大半を占める場合、これにより約 7.5LD^2 Gflops が得られます。比較すると、この砂時計アーキテクチャで SSM の代わりにフルレングスのセルフ アテンションが使用される場合、追加の 2DL^2 フロップが存在します。

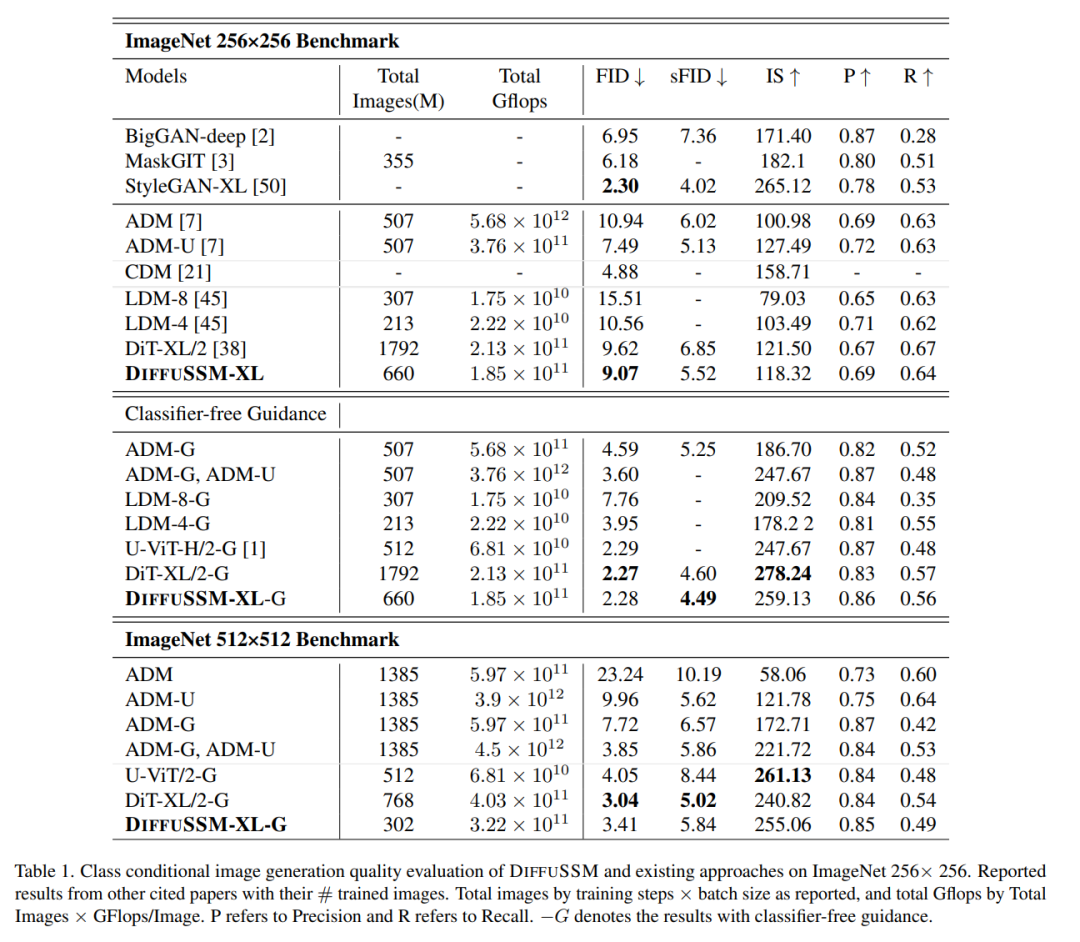

下表これは、分類子がない場合の DIFFUSSM と現在のすべての最先端のカテゴリ条件付き生成モデルとの比較結果です

ガイダンスを使用すると、DIFFUSSM は FID と sFID の両方で他の拡散モデルよりも優れたパフォーマンスを発揮し、以前の非分類器ガイド付き潜在拡散モデルの最適スコアを 9.62 から 9.07 に下げ、同時に使用されるトレーニング ステップの数を約 1/3 に削減しました。オリジナル。トレーニングされた合計 Gflops に関して、非圧縮モデルは DiT と比較して合計 Gflops を 20% 削減します。分類子を使用しないガイダンスが導入されると、このモデルはすべての DDPM ベースのモデルの中で最高の sFID スコアを達成し、他の最先端の戦略を上回り、DIFFUSSM によって生成された画像が空間歪みに対してより堅牢であることを示しています。

分類子を使用しないガイダンスを使用した場合の DIFFUSSM の FID スコアはすべてのモデルを上回り、DiT と比較した場合、かなり小さなギャップ (0.01) を維持します。合計 Gflops を 30% 削減してトレーニングした DIFFUSSM は、分類子なしのガイダンスを適用しなくても、すでに DiT を上回っていることに注意してください。 U-ViT も Transformer ベースのアーキテクチャですが、ブロック間の長いホップ接続を備えた UNet ベースのアーキテクチャを使用します。 U-ViT は、256×256 解像度で使用する FLOP が少なく、パフォーマンスが向上しますが、512×512 データセットではそうではありません。筆者は主に DiT と比較していますが、公平性を保つため、このロングホップ接続は採用していませんが、U-Vit を採用するというアイデアは DiT と DIFFUSSM の両方にとって有益である可能性があると著者は考えています。

著者らは、分類器を使用しないガイダンスを使用して、高解像度のベンチマークでさらに比較を実施しています。 DIFFUSSM の結果は比較的強力で最先端の高解像度モデルに近く、sFID では DiT よりも劣るだけであり、同等の FID スコアを達成します。 DIFFUSSM は 3 億 200 万枚の画像でトレーニングされ、画像の 40% を観察し、DiT よりも 25% 少ない Gflops を使用しました

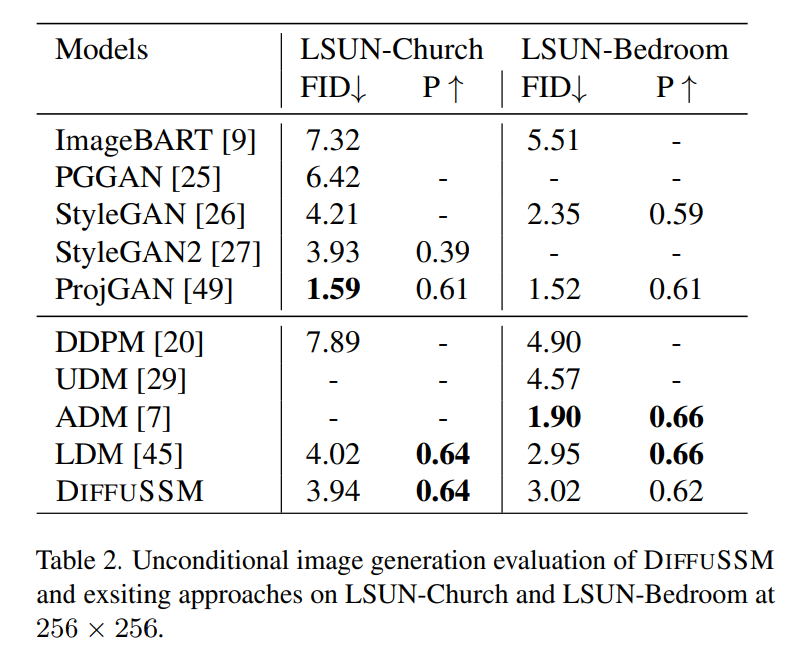

無条件画像生成

著者によるモデルの無条件画像生成機能の比較結果を表 2 に示します。著者らの研究では、DIFFUSSM が LDM と同等のトレーニング予算の下で同等の FID スコア (-0.08 と 0.07 の差) を達成したことがわかりました。この結果は、さまざまなベンチマークやさまざまなタスクにわたる DIFFUSSM の適用可能性を強調しています。 LDM と同様に、このメソッドは ADM の総トレーニング予算の 25% しか使用しないため、LSUN-Bedrooms タスクでは ADM より優れたパフォーマンスを発揮しません。このタスクでは、最適な GAN モデルがモデル カテゴリで拡散モデルよりも優れています。

詳細については元の論文を参照してください

以上がMamba の人気 SSM が Apple と Cornell の注目を集める: 気晴らしモデルを放棄の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。