Microsoft CEO の Nadella は、先月の Ignite カンファレンスで、Phi-2 小規模モデルが完全にオープンソースになると発表しました。この動きにより、常識的推論、言語理解、論理的推論のパフォーマンスが大幅に向上します

本日、Microsoft は Phi-2 モデルの詳細を発表しました。そして新しいプロンプト技術プロンプトベース。わずか 27 億のパラメーターを備えたこのモデルは、Llama2 7B、Llama2 13B、Mistral 7B を上回るパフォーマンスを発揮し、ほとんどの常識的な推論、言語理解、数学、およびコーディング タスクに関して Llama2 70B との差を縮めます (またはさらに優れています)。

同時に、小型 Phi-2 はラップトップや携帯電話などのモバイル デバイス上で実行できます。 Nadella 氏は、Microsoft はクラス最高の小型言語モデル (SLM) と SOTA プロンプト テクノロジを研究開発開発者と共有できることを非常に嬉しく思っていると述べました。

Microsoft は、今年 6 月に「教科書のみ」という論文を発表しました。これは、7B タグの品質データのみを含む「教科書」を使用して、学習者をトレーニングするものです。 1.3B パラメータを含むモデル、つまり phi-1。 phi-1 は、競合他社よりも桁違いに小さいデータセットとモデル サイズを備えているにもかかわらず、HumanEval で 50.6% の初回合格率、MBPP で 55.5% の精度を達成しています。 phi-1 は、高品質の「小さなデータ」でも優れたモデルのパフォーマンスにつながる可能性があることを証明しました

Microsoft はその後、9 月のテクニカル レポートで「Just a Textbook II: Phi-1.5」を発行しました。高品質の「スモールデータ」の可能性についてのさらなる研究。この記事では、QA Q&A、コーディング、その他のシナリオに適しており、13 億の規模に達することができる Phi-1.5 を提案しています。

現在、再び 27 億のパラメーターを備えた Phi-2 が提案されています。 「小さな体」を使用すると、優れた推論能力と言語理解能力が得られ、130 億パラメータ以下の基本言語モデルで SOTA パフォーマンスが実証されます。モデルのスケーリングとトレーニング データ管理の革新のおかげで、Phi-2 は、複雑なベンチマークで 25 倍のサイズのモデルと同等またはそれを超えています。

Microsoft は、Phi-2 は研究者にとって、解釈可能性の調査、セキュリティの改善、さまざまなタスクの微調整実験を行うための理想的なモデルになると述べています。 Microsoft は、言語モデルの開発を容易にするために、Azure AI Studio モデル カタログで Phi-2 を利用できるようにしました。

言語モデルの規模は数千億のパラメーターに増加し、実際に多くの新しい機能がリリースされました。機能と再定義された性質、言語処理の風景。しかし、疑問は残ります。これらの新しい機能は、トレーニング戦略の選択 (データ選択など) を通じて、より小規模なモデルでも実現できるのでしょうか?

Microsoft が提供するソリューションは、Phi シリーズのモデルを使用して、小さな言語モデルをトレーニングすることで大規模なモデルと同様のパフォーマンスを達成することです。 Phi-2 は、2 つの側面で従来の言語モデルのスケーリング ルールを打ち破ります。

まず、トレーニング データの品質がモデルのパフォーマンスに重要な役割を果たします。 Microsoft は、「教科書品質」のデータに焦点を当てることで、この理解を極限まで高めています。彼らのトレーニング データは、モデルに科学、日常活動、心理学などの常識的な知識と推論を教える特別に作成された包括的なデータセットで構成されています。さらに、教育的価値とコンテンツの品質を審査した慎重に選択された Web データを使用してトレーニング コーパスをさらに拡張します。

第 2 に、Microsoft は革新的なテクノロジを使用して拡張します。 13 億のパラメータ、知識は 27 億のパラメータを備えた Phi-2 に徐々に埋め込まれました。このスケールされた知識の移転により、トレーニングの収束が加速され、Phi-2 のベンチマーク スコアが大幅に向上します。

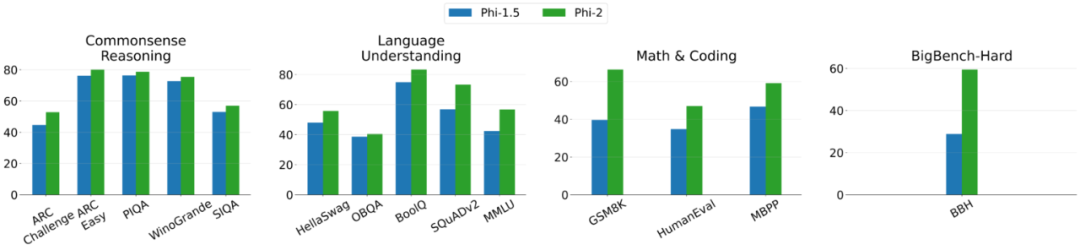

以下は、BBH (3 ショット CoT) と MMLU (5 ショット) を除く他のすべてのタスクの Phi-2 と Phi-1.5 の比較グラフです。0 ショットを使用した評価

Phi-2 は Transformer ベースのモデルであり、その目標は予測することです。次の言葉。これは、96 個の A100 GPU を使用して合成データセットとネットワーク データセットでトレーニングされ、14 日間かかりました。

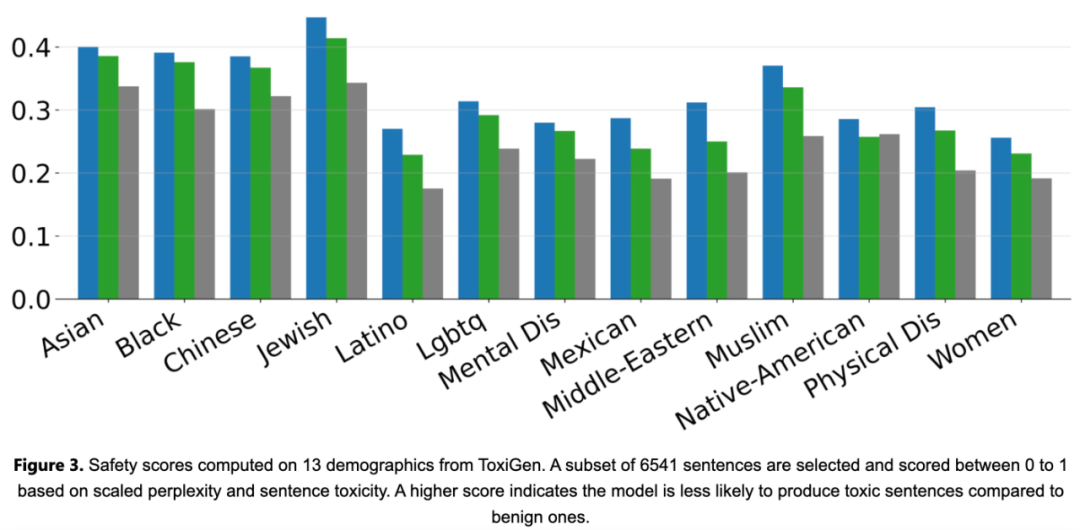

Phi-2 は基本モデルであり、失敗しました。ヒューマン フィードバックによる強化学習 (RLHF) はアライメントを実行し、命令の微調整は実行しません。それにもかかわらず、以下の図 3 に示すように、Phi-2 は、調整された既存のオープンソース モデルと比較して、毒性とバイアスの点で依然として優れたパフォーマンスを示しました。

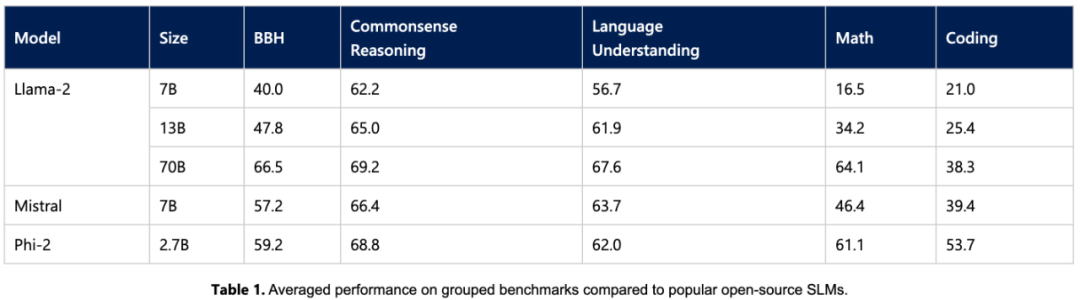

まず、この研究では、Phi-2 を学術ベンチマーク上の共通言語モデルと実験的に比較しました。 :

## Phi-2 モデルには 27 億パラメータしかありませんが、そのパフォーマンスは、さまざまな集計ベンチマークで 7B および 13B Mistral モデルおよび Llama2 モデルを上回っています。 Phi-2 は、大規模な 25x Llama2-70B モデルと比較して、マルチステップの推論タスク (つまり、コーディングと数学) で優れたパフォーマンスを発揮することは言及する価値があります。

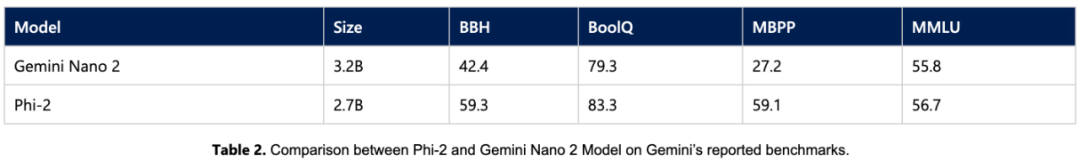

さらに、サイズが小さいにもかかわらず、 , Phi-2 のパフォーマンスは、最近リリースされた Gemini Nano 2 に匹敵します

多くの公開ベンチマークがトレーニング データに漏洩する可能性があるため、研究チームはテスト言語を測定する最良の方法であると考えています。モデルのパフォーマンスは、特定のユースケースでテストすることです。したがって、この研究では、複数の内部 Microsoft 独自のデータセットとタスクを使用して Phi-2 を評価し、再度 Mistral および Llama-2 と比較しました。平均して、Phi-2 は Mistral-7B を上回り、Mistral -7B は Llama2 モデル (7B、13B、 70B)。

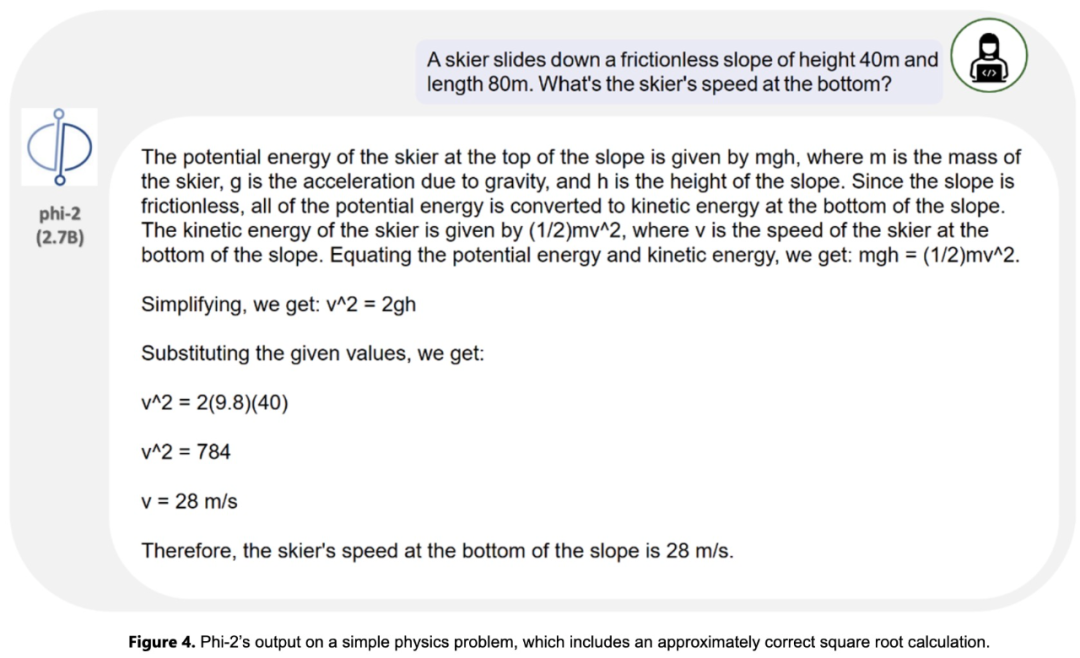

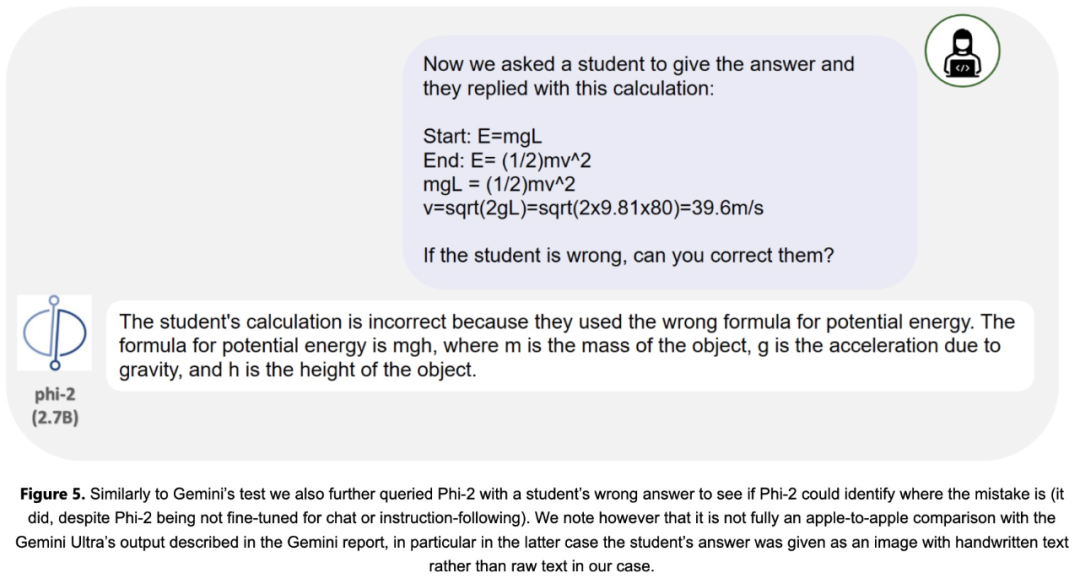

研究チームは、研究コミュニティの一般的なヒントに関する調査も実施しました。広範囲にテスト済み。 Phi-2 は期待通りのパフォーマンスを発揮しました。たとえば、物理問題を解決するモデルの能力を評価するために使用されるプロンプト (最近、Gemini Ultra モデルの評価に使用されました) の場合、Phi-2 は次の結果を返しました:

以上が携帯電話は、27 億個のパラメータを備えた大型モデルよりも Microsoft の小型モデルをより適切に実行しますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。