生成 AI の最初の 1 年で、全員の作業ペースははるかに速くなりました。

特に今年は大型モデルの投入に力を入れており、最近では国内外の大手テクノロジー企業やスタートアップ企業が次々と大型モデルを投入しています。 、それらはすべて大きな進歩であり、各企業は重要なベンチマーク リストを更新し、第 1 位または第 1 層にランクされました。

テクノロジーの急速な進歩に興奮した後、多くの人は何かが間違っているように見えることに気づきます。なぜ誰もがランキングの上位にシェアを持っているのでしょうか?この仕組みは何でしょうか?

それに伴い、「ランキング不正行為」の問題も注目され始めています。

最近、WeChat モーメントと Zhihu コミュニティで、大規模モデルの「ランキングのスワイプ」問題に関する議論がますます増えていることに気づきました。特に、Zhihu への投稿: Tiangong Large Model Technical Report が指摘した、多くの大規模モデルがランキングを上げるために現場のデータを使用しているという現象をどのように評価しますか?それはみんなの議論を呼び起こしました。

リンク: https://www.zhihu.com/question/628957425

この研究は、Kunlun Wanwei の「Tiangong」大型モデル研究チームによるもので、先月末にプレプリント版の技術レポートを発表しました。 arXiv プラットフォーム上で。

論文リンク: https://arxiv.org/abs/2310.19341

論文自体Tiangong の大規模言語モデル (LLM) シリーズである Skywork-13B の紹介です。著者らは、セグメント化されたコーパスを使用した 2 段階のトレーニング方法を紹介し、それぞれ一般トレーニングとドメイン固有の強化トレーニングを対象としています。

大規模モデルに関する新しい研究の常として、著者らは、自分たちのモデルが一般的なテスト ベンチマークで良好なパフォーマンスを発揮しただけでなく、多くの中国のテスト ベンチマークでも最先端の結果を達成したと述べています。ブランチタスク、芸術レベル(業界最高)。

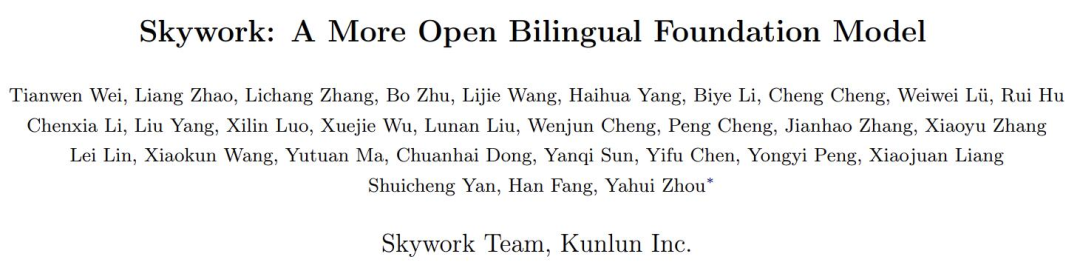

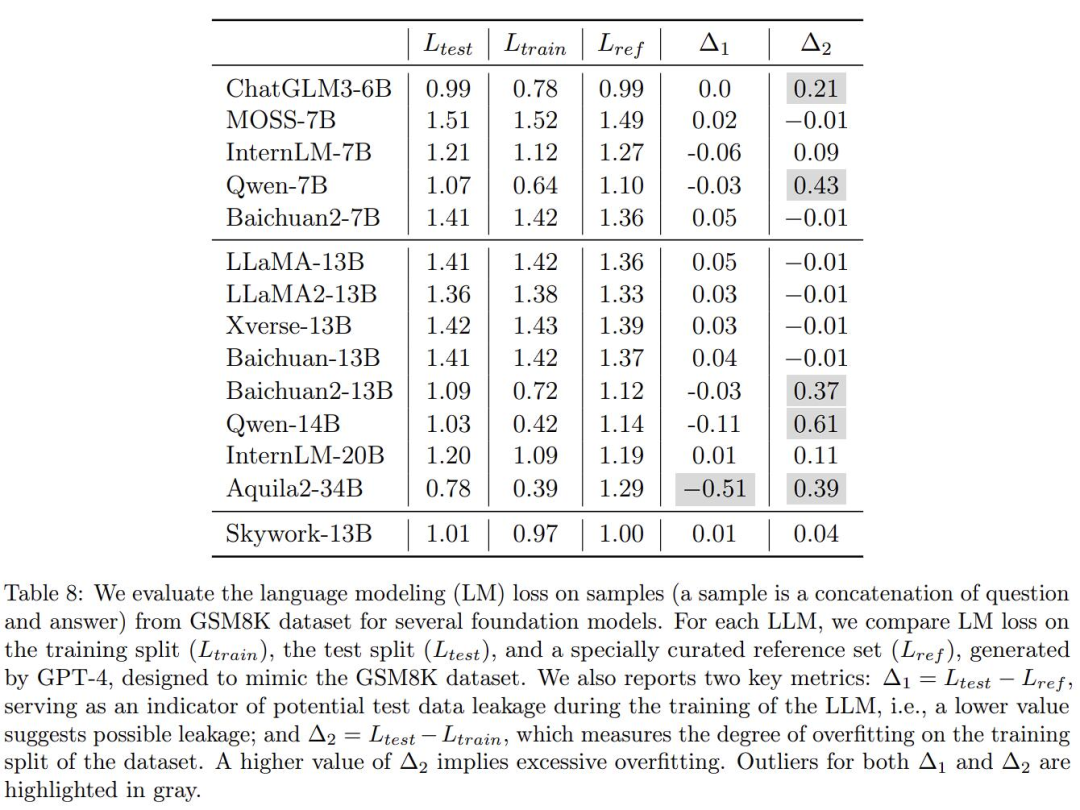

重要なのは、この報告書が多くの大型モデルの実際の効果も検証し、他のいくつかの国産大型モデルには日和見主義の疑いがあると指摘していることだ。これは表 8 です:

ここで、著者は業界で一般的ないくつかの大規模モデルの数学的応用を検証したいと考えています。問題のベンチマーク GSM8K での過学習の程度については、GPT-4 を使用して GSM8K と同じ形式のサンプルを生成しました。正確性は手動でチェックされ、これらのモデルは生成されたデータセットと元のトレーニングでテストされましたGSM8K のセットとテスト セットを比較し、損失を計算しました。さらに 2 つのメトリクスがあります:

Δ1 モデルのトレーニング中にテスト データが漏洩する可能性を示す指標として、低い値が使用されます。漏れの可能性を示します。テストセットでトレーニングを行わない場合、値はゼロになるはずです。

Δ2 は、データセットのトレーニング分割の過学習の程度を測定します。 Δ2 値が大きいほど、過学習を意味します。トレーニング セットでトレーニングされていない場合、値はゼロになるはずです。

これを簡単に説明すると、モデルがトレーニングされている場合、ベンチマーク テストの「実際の質問」と「回答」を学習教材として直接使用し、それらを使用してブラッシュアップ. ポイントの場合、ここでは例外が発生します。

わかりました。Δ1 と Δ2 の問題のある領域は、上で慎重に灰色で強調表示されています。

ネチズンは、ついに誰かが「データセット汚染」の公然の秘密を語った、とコメントした。

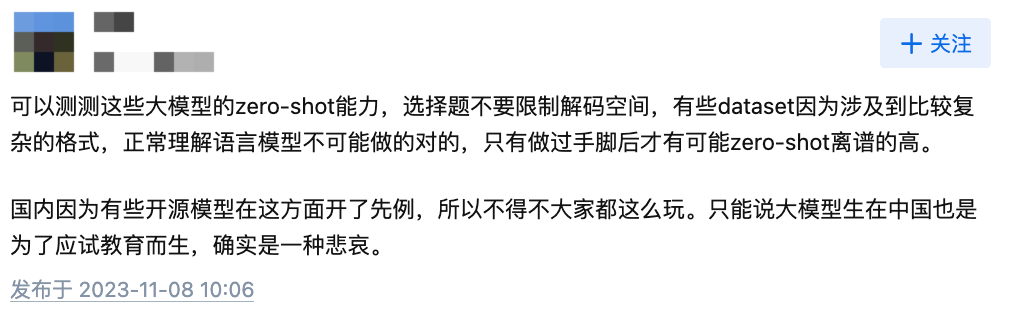

一部のネチズンは、大規模モデルのインテリジェンス レベルは依然としてゼロショット機能に依存しており、既存のテスト ベンチマークでは達成できないと述べています。

写真: Zhihu ネットユーザーのコメントのスクリーンショット

著者と読者とのやり取りの中で、著者は「これにより、誰もがランキングの問題をより合理的に見ることができるようになるでしょう。多くのモデルと GPT4 の間にはまだ大きなギャップがあります。」という希望も表明しました。

画像: Zhihu の記事のスクリーンショット https://zhuanlan.zhihu.com/p/664985891

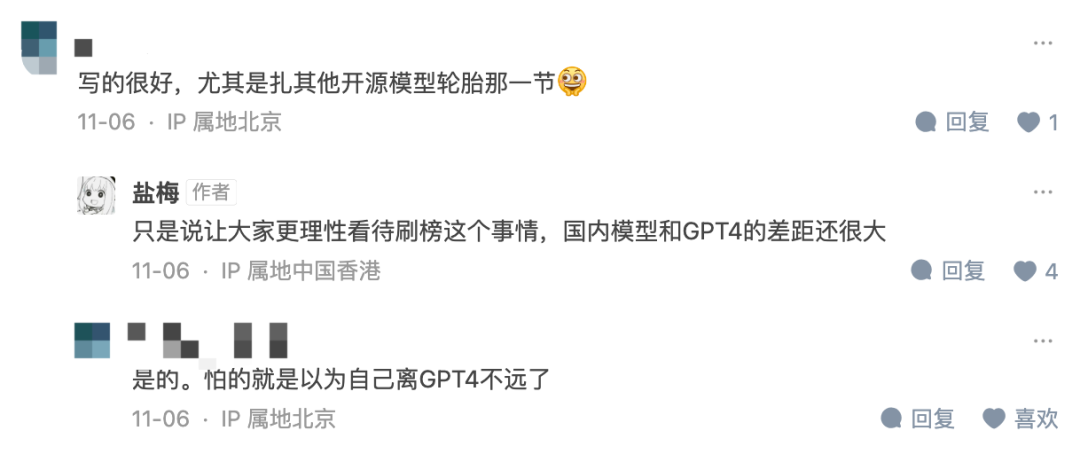

実際、これは一時的な現象ではありません。今年 9 月の arXiv の非常に皮肉な記事のタイトルが指摘しているように、Benchmark の導入以来、そのような問題は時折発生しています。必要なのはテスト セットでの事前トレーニングだけです。

さらに、人民大学とイリノイ大学アーバナシャンペーン校による最近の正式な研究でも、大規模モデルの評価における問題が指摘されています。タイトルは非常に目を引くものです。「LLM を評価ベンチマーク詐欺師にしないでください」:

論文リンク: https://arxiv。 org/abs/ 2311.01964

この論文は、現在注目されている大規模モデルの分野では、人々がベンチマークのランキングを気にするようになっているが、その公平性と信頼性が疑問視されていると指摘しています。主な問題はデータの汚染と漏洩であり、事前トレーニング コーパスを準備するときに将来の評価データ セットがわからない可能性があるため、意図せずに引き起こされる可能性があります。たとえば、GPT-3 では、事前トレーニング コーパスに Children's Book Test データ セットが含まれていることが判明し、LLaMA-2 論文では BoolQ データ セットからコンテキスト Web コンテンツを抽出することが記載されています。

データセットの収集、整理、ラベル付けには多くの人の労力が必要ですが、高品質のデータセットが評価に使用できるのであれば、当然のことながら使用される可能性があります。大規模なモデルのトレーニングに使用されます。

一方、既存のベンチマークを使用して評価する場合、評価した大規模モデルの結果は、ほとんどがローカル サーバー上で実行するか、API 呼び出しを通じて取得されます。この過程において、評価パフォーマンスの異常な向上につながる可能性のある不正な手段(データ汚染など)が厳密に検査されることはありませんでした。

さらに悪いことに、トレーニング コーパス (データ ソースなど) の詳細な構成が、既存の大規模モデルの中核となる「秘密」とみなされていることがよくあります。これにより、データ汚染の問題を調査することがさらに困難になります。

言い換えれば、優れたデータの量は限られており、多くのテスト セットでは GPT-4 と Llama-2 が必ずしも最適であるとは限りません。最高です。問題ありません。たとえば、GSM8K については最初の論文で言及されており、GPT-4 については公式技術レポートでそのトレーニング セットの使用について言及されています。

データは非常に重要だと言いませんか? では、トレーニング データが優れているため、「実際の質問」を使用する大規模モデルのパフォーマンスは向上するのでしょうか?答えは否定的です。

研究者らは、ベンチマーク リークにより大規模なモデルが誇張された結果を実行する可能性があることを実験的に発見しました。たとえば、一部のタスクでは 1.3B モデルが 10 倍のサイズを超える可能性があります。ただし、副作用として、この漏洩データをモデルの微調整やトレーニングにのみ使用すると、他の通常のテスト タスクにおけるこれらの大規模なテスト固有のモデルのパフォーマンスが悪影響を受ける可能性があります。

したがって、著者は、将来、研究者が大規模モデルを評価したり、新しいテクノロジーを研究したりする際には、次のことを行うべきであると提案しています。

最後に、幸いなことに、この問題は徐々にみんなの注目を集めていると言いたいと思います。技術レポート、論文調査、コミュニティでのディスカッションなど、誰もがお金を払い始めています。大きなモデルの「リストのスワイプ」問題に注意してください。

これに関するあなたの意見や効果的な提案は何ですか?

以上が大手モデルは「ランキングに勝つ」ために近道をしているのだろうか?データ汚染の問題は注目に値するの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。