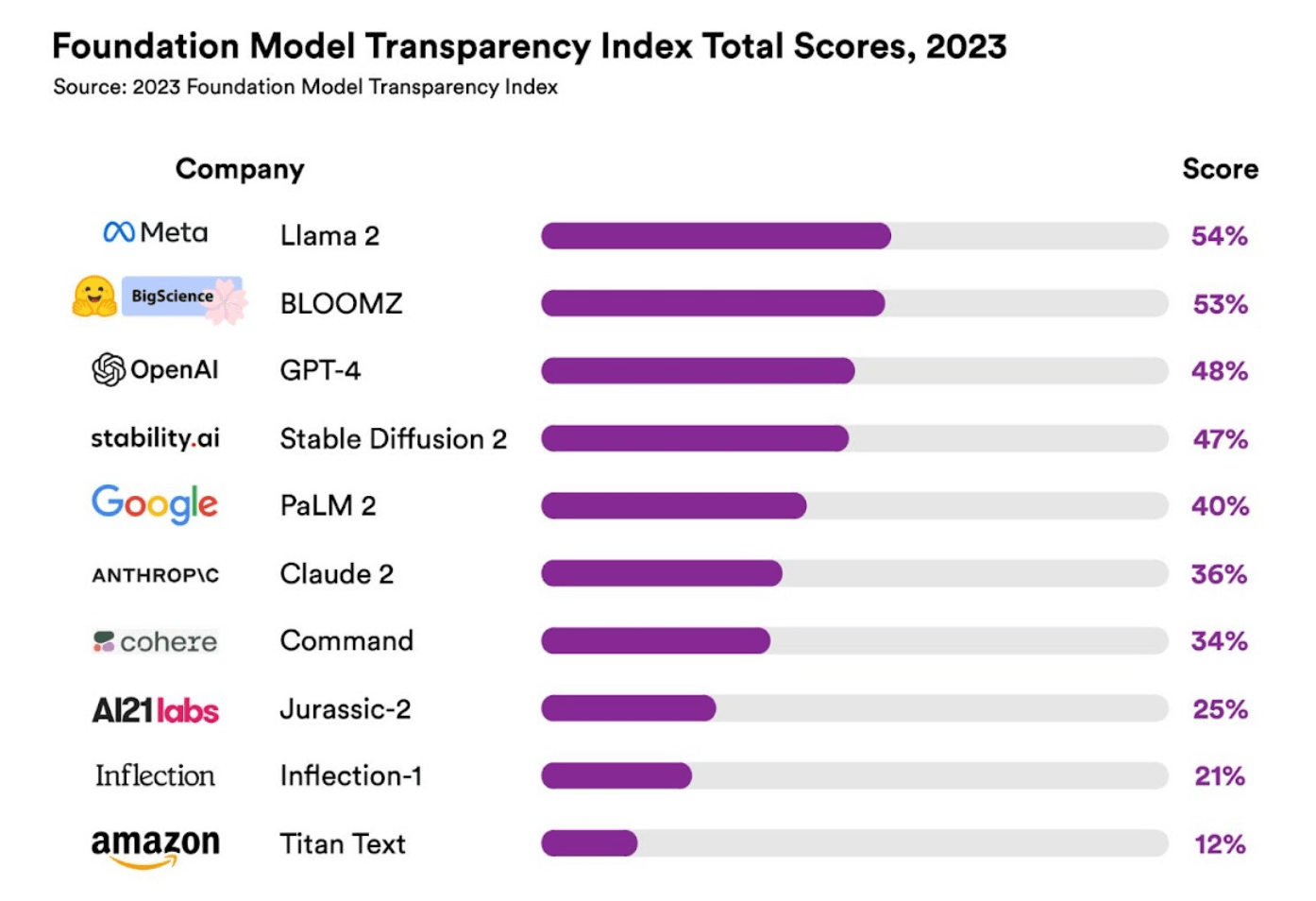

IT House News 10月20日、スタンフォード大学は最近、AI基本モデルの「透明性指数」を発表、最も高い表示指数はMetaのLama 2だが、関連する「透明性」は54%にすぎないため、研究者らは発表した。市場に出回っているほぼすべての AI モデルは「透明性に欠けている」と考えられています。

この研究は、HAI 基本モデル研究センター (CRFM) 所長であるリシ・ボンマサニ氏が主導し、海外で最も人気のある 10 個の基本モデルを調査したと報告されています。

リシ・ボンマサニ氏は、「透明性の欠如」が常に AI 業界が直面している問題であると考えています。特定のモデルの「透明性指標」に関して、IT ハウスは、関連する評価内容が主に「モデルのトレーニング データ」を中心に展開していることを発見しました。 「著作権の設定」、「トレーニング モデル 「使用されるコンピューティング リソース」、「モデルによって生成されたコンテンツの信頼性」、「モデル自体の機能」、「モデルが有害なコンテンツの生成を誘導されるリスク」、「モデルの使用に関するユーザーのプライバシー」 」など計100件。メタのラマ 2、

- BloomZ by BigScience、

- OpenAI の GPT-4、

- 安定性AIの安定した普及、

- クロード、人類 PBC の

- Google の PaLM 2、

- コヒアの命令、

- ジュラシック-2、

- AI21 Labs

語形変化 AI の語形変化、- アマゾンのタイタン。

最終調査では、Meta の Lama 2 が 54% の透明性でリストのトップに立ったのに対し、OpenAI の GPT-4 の透明性は 48% にとどまり、Google の PaLM 2 は 40% で 5 位にランクされました。

具体的な指標のうち、スコアパフォーマンスが「最高」の上位10モデルは「モデルの基礎」であり、この評価内容は主に「モデルの学習時にモデル、スケール、モデルが正確に導入されているか」が含まれます。 「アーキテクチャ」の平均透明度は 63% です。最もパフォーマンスが悪いのは Impact で、主に基本モデルが「評価のためにユーザー情報を取得する」かどうかを評価しており、平均透明性はわずか 11% です。

CRFMディレクターのパーシー・リャン氏は、ビジネスベースモデルの「透明性」はAI法制や関連業界、学界を推進する上で非常に重要であると述べた。

リシ・ボンマサニ氏は、モデルの透明性が低いと、企業が関連モデルを安全に信頼できるかどうかを判断することが難しくなり、研究者がこれらのモデルに頼って研究を行うことが難しくなると述べた。

リシ・ボンマサニ氏は最終的に、上記の 10 個の基本モデルは透明性の点ですべて「失敗」していると考えています。Meta の Llama 2 は最高のスコアを持っていますが、外部世界のニーズを満たすことはできません。「モデルの透明性は少なくとも 82 に達する必要があります。」 % 外部の世界に認識されるようにする。」

以上がスタンフォード大学がAI基本モデルの透明性指数を発表、Llama 2は1位だが「不合格」の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。