######これが信じられない!

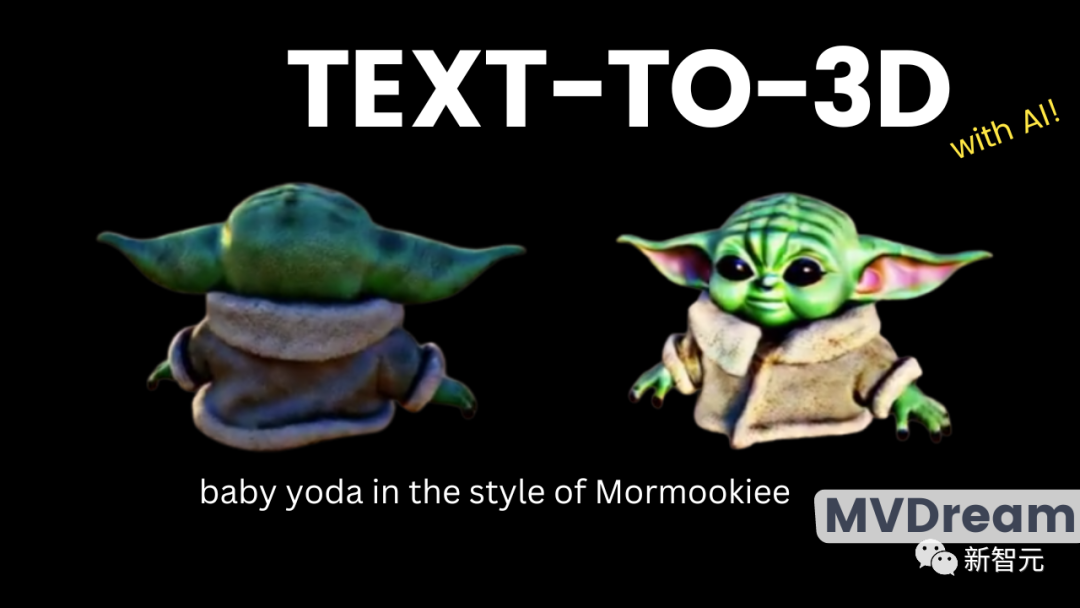

たった数単語で美しく高品質な 3D モデルを簡単に作成できるようになりましたか?

いいえ、海外のブログがインターネットを開始し、MVDream と呼ばれるものを私たちの前に置きました。

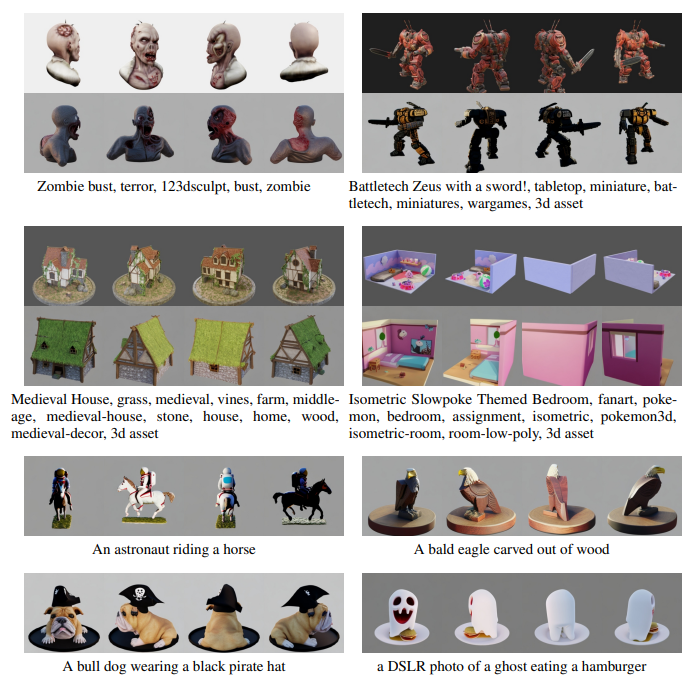

ユーザーは、わずか数語で本物そっくりの 3D モデルを作成できます。

この MVDream がどれほど素晴らしいかを見てみましょう~

私たちはその後、Vincent ビデオ モデル、そしてもちろん今日取り上げたい 3D モデルの誕生を目撃しました。

想像してみてください。文章を入力するだけで、必要な詳細をすべて含めた、現実世界に存在するかのようなオブジェクト モデルを生成できます。このシーンはすごいですね。

そして、これです。特にユーザーが詳細まで十分に現実的なモデルを生成する必要がある場合、それは単純なことです。

#まずは効果を見てみましょう~

#同時に 念のために言っておきますが、一番右に示されているのは MVDream の完成品です。

# 5 つのモデル間のギャップは肉眼で確認できます。最初のいくつかのモデルは客観的事実に完全に違反しており、特定の角度から見た場合にのみ正しいものです。

たとえば、最初の 4 つの写真では、生成されたモデルには実際には 2 つ以上の耳があります。 4枚目の写真はより詳細に見えますが、ある角度を向くと、キャラクターの顔が凹んでいて、そこに耳がくっついていることがわかります。

編集者は、以前非常に人気があったペッパ ピッグの正面図をすぐに思い出しました。

#これは特定の角度から見た状況ですが、他の角度からは絶対に見てはなりません。生命の危険があります

#しかし、一番右の MVDream の世代モデルは明らかに異なります。 3Dモデルをどのように回転させても違和感はありません。

#これは前に述べたことです。MVDream は物理学の知識をよく知っており、各ビューに 2 つの耳があることを確認するためだけに奇妙なものを作成しません兄弟は、3D モデルが成功したかどうかを判断する鍵は、そのさまざまな視点が現実的で高品質であるかどうかを観察することであると指摘しました。

そして、モデルが適切であることも確認します。上記の複数の耳モデルではなく、空間の連続性において。

3D モデルを生成する主な方法の 1 つは、カメラの視点をシミュレートし、特定の視点から見えるものを生成することです。

つまり、いわゆる2Dリフティングです。これは、さまざまな視点をつなぎ合わせて最終的な 3D モデルを形成することを意味します。

上記のマルチイヤー状況は、生成モデルが 3 次元空間内のオブジェクト全体の形状情報を完全に把握していないために発生します。そして MVDream は、この点においてまさに大きな前進です。

#この新しいモデルは、3D パースペクティブにおける以前の一貫性の問題を解決します

分別蒸留サンプリング

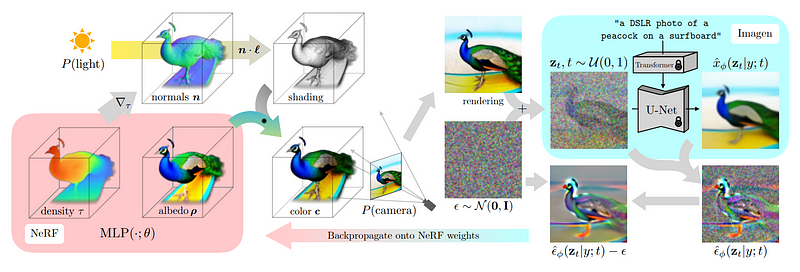

このメソッドはスコア蒸留サンプリングと呼ばれ、DreamFusion によって開発されました。

言い換えれば、これは実際には、DALLE、MidJourney、Stable Diffusion モデルと同様の、単なる別の 2 次元画像拡散モデルです。

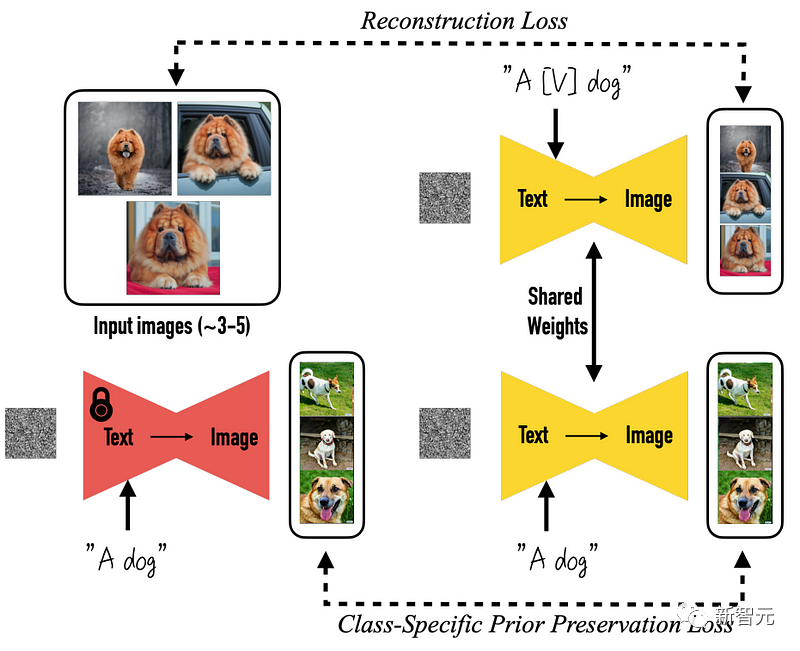

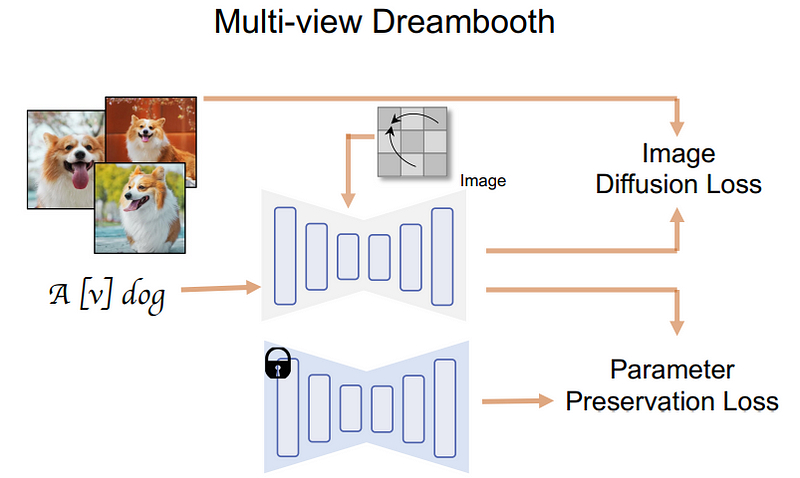

より具体的には、すべては事前トレーニング済みの DreamBooth モデルから始まります。DreamBooth は、Stable Diffusion の生のグラフに基づくオープン ソース モデルです。

変化がやってくる、つまり状況が変わったことを意味します

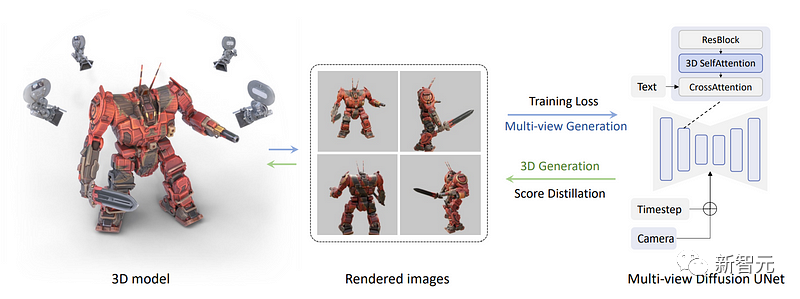

研究チームが次にとったこと はい、 1 つの画像をレンダリングするだけでなく、一連のマルチビュー画像を直接レンダリングするこのステップを完了するには、さまざまなオブジェクトの 3 次元データ セットが必要です。

ここでは、研究者はデータセットから 3D オブジェクトの複数のビューを取得し、それらを使用してモデルをトレーニングし、それを使用してそれらのビューを逆方向に生成しました。

具体的な方法は、下の図の青い自己注意ブロックを 3 次元の自己注意ブロックに変更することです。複数の画像を再構築するための次元であり、画像ではありません。

下の図では、どの画像がどこで使用されるのか、何が必要なのかをモデルが理解できるように、カメラとタイムステップが各ビューのモデルに入力されていることがわかります。

#これで、すべての画像が結合され、生成も一緒に行われます。そのため、情報を共有し、全体像をより深く理解できるようになります。

まず、テキストがモデルに入力され、次にモデルがデータセットからオブジェクトを正確に再構築するようにトレーニングされます

そして、これがこれです。研究チームがさらに適用した場所 分別蒸留サンプリングプロセスを表示する場所。

マルチビュー拡散モデルを使用して、チームはオブジェクトの複数のビューを生成できるようになりました。

#次に、これらのビューを使用して、単なるビューではなく、現実世界と一致する 3 次元モデルを再構築する必要があります。 #ここで必要 これは、前述の DreamFusion と同様に、NeRF (神経放射フィールド) を使用して実現されます。

このステップの目標は、以前にトレーニングされたマルチビュー拡散モデルをフリーズすることです。言い換えれば、このステップではトレーニングなしで上記の各視点からの写真を使用するだけです。

画像の異なるバージョンを生成する必要があることをモデルに知らせるために、研究者は背景情報を受信できる一方でノイズを追加しました

次に、このモデルを使用してさらに高品質の画像を生成できます

この画像の生成に使用された画像を追加し、追加した画像を削除します手動でノイズを除去し、その結果を次のステップで使用して NeRF モデルをガイドおよび改善できるようにします。

#次のステップでより良い結果を生成するために、これらのステップの目的は、NeRF モデルが画像のどの部分に焦点を当てる必要があるかをよりよく理解することです。

## 満足のいく 3D モデルが生成されるまでこのプロセスを繰り返します

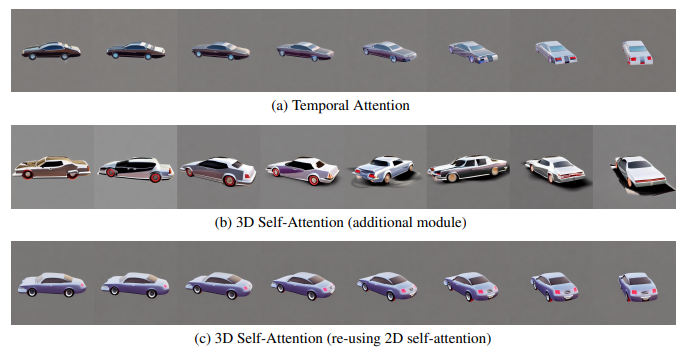

複数の視点の場合はこれですこれは、チームが拡散モデルの画像生成品質をどのように評価し、さまざまな設計がそのパフォーマンスにどのような影響を与えるかを判断した方法です。

まず、ビュー間の一貫性モデルを構築するためのアテンション モジュールの選択肢を比較しました。

まず、ビュー間の一貫性モデルを構築するためのアテンション モジュールの選択肢を比較しました。

#これらのオプションには次のものが含まれます:

(1) ビデオ拡散モデルで広く使用されている 1 次元の時間的セルフアテンション;

(2) 新しい 3 次元セルフ アテンション モジュールを既存のモデルに追加します;

(3) 既存の 2 次元セルフ アテンション モジュールを再利用します立体的な注目の作品です。

これらのモジュール間の違いを正確に実証するために、この実験では、研究者は 90 度の視点変更の 8 フレームを使用して、ビデオ設定により厳密に一致するようにモデルをトレーニングしました。

実験では、研究チームは元の SD モデルと同様に、より高い画像解像度、つまり 512×512 も維持しました。以下の図に示すように、研究者らは、静的なシーンで視点の変更がこのように限られている場合でも、時間的自己注意は依然としてコンテンツの移動の影響を受け、視点の一貫性を維持できないことを発見しました。これは、時間的注意は異なるフレーム内の同じピクセル間でのみ情報を交換できるが、視点が変わると対応するピクセルが遠く離れてしまう可能性があるためであると仮説を立てています。

一方で、学習の一貫性を持たずに新しい 3D アテンションを追加すると、重大な品質の低下につながる可能性があります。

研究者らは、これは、新しいパラメーターを最初から学習すると、より多くのトレーニング データと時間を消費することになり、3 次元モデルが制限されているこの状況には当てはまらないためであると考えています。彼らは、生成品質を低下させることなく最適な一貫性を達成するために 2D セルフ アテンション メカニズムを再利用する戦略を提案しました。

チームはまた、画像サイズが 256 に縮小されると、ビューは 4 に減り、これらのモジュール間の違いははるかに小さくなります。ただし、最良の一貫性を達成するために、研究者は次の実験での予備的な観察に基づいて選択を行いました。

さらに、研究者らは、threestudio (thr) ライブラリにマルチビューの分別蒸留サンプリングを実装し、マルチビューの拡散ガイダンスを導入しました。このライブラリは、統一されたフレームワークの下で最先端のテキストから 3D モデルへの生成方法を実装します

研究者らは、threestudio のインプリシット ボリュームを 3D 表現として使用しました。複数解像度のハッシュ グリッドを含む

#カメラ ビューを調査する際、研究者は 3D データセットをレンダリングするときにまったく同じアプローチを使用しました。2 人の人物がカメラでサンプリングされました

さらに、研究者らは、AdamW オプティマイザーを使用し、学習率を 0.01 に設定して 3D モデルを 10,000 ステップ用に最適化しました。

分別蒸留サンプリングでは、最初の 8000 ステップでは、最大時間ステップと最小時間ステップがそれぞれ 0.98 ステップから 0.5 ステップと 0.02 ステップに減少します

レンダリングの開始解像度は 64×64 で、徐々に 256 まで増加します。 5000 ステップ後 ×256

以下はその他のケースです:

研究チームは 2D を使用しました。テキストから画像へのモデルを作成してマルチビュー合成を実行し、反復プロセスを通じてテキストから 3D モデルへのメソッドを作成しました

この新しいメソッドには現在、いくつかの制限があります。問題は、生成される画像の解像度が 256x256 ピクセルのみであり、非常に低いと言えます。このタスクの実行に使用されるデータ セットは、この方法の一般化可能性をある程度制限します。データ セットが小さすぎると、複雑な世界をより現実的に反映できなくなるからです。

以上がヴィンセントの3Dモデルが大躍進!超リアルな 3D モデルを一文で生成する MVDream が登場の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。