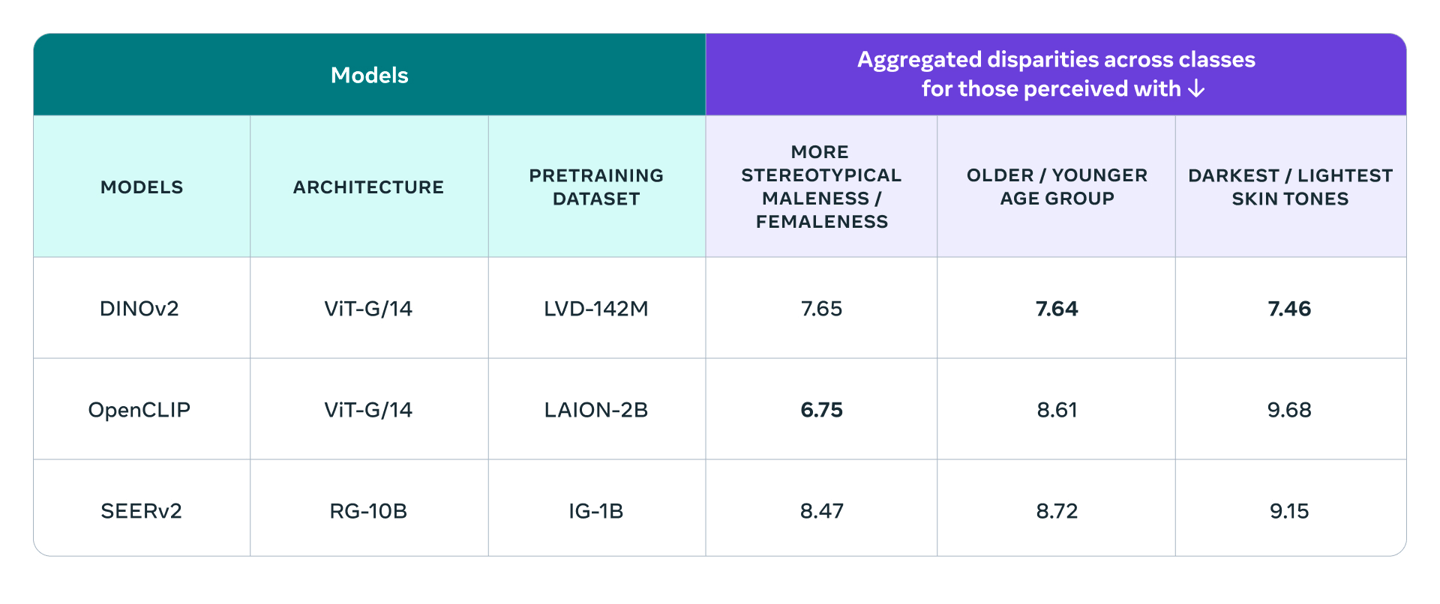

IT House は 9 月 2 日、現在の多くのコンピューター ビジョン モデルにおける女性や有色人種に対する体系的な偏見の問題を軽減するために、 は識別用の FACET と呼ばれる新しい AI ツールを最近立ち上げたと報告しました。コンピュータビジョンシステム。

FACET ツールは現在、50,000 人の画像を含む 30,000 枚の画像でトレーニングされています。特に性別と肌の色の認識が強化されており、さまざまな特徴に関するコンピューター ビジョン モデルを評価するために使用できます。

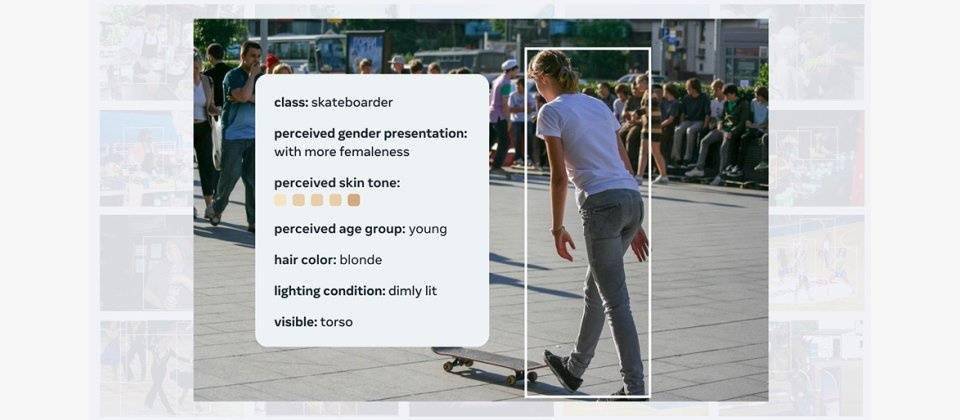

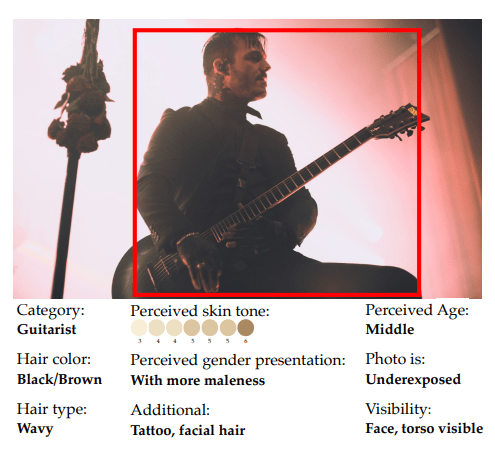

トレーニング後、FACET ツールは複雑な質問に答えることができます。たとえば、対象が男性であると識別されると、スケートボーダーだけでなく、肌の色が明るいか暗いかも識別できるようになります。

オープンソースの

オープンソースの

以上がAI モデルにおける人種および性別の偏見を評価するための Meta のオープンソース FACET ツールの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。