OpenAI の GPT-3.5 や GPT-4 などのクローズド モデルの優位性に挑戦するために、LLaMa、Falcon などを含む一連のオープン ソース モデルが登場しています。最近、Meta AI は、オープンソース分野で最も強力なモデルとして知られる LLaMa-2 を発表し、多くの研究者もこれに基づいて独自のモデルを構築しています。たとえば、StabilityAI は、Orca スタイルのデータ セットを使用して Llama2 70B モデルを微調整し、StableBeluga2 を開発しました。これは、Huggingface の Open LLM ランキングでも良い結果を達成しました

最新の Open The LLM リストランキングが変わり、Platypus (カモノハシ) モデルがリストのトップに浮上しました

作者はボストン大学出身で、PEFT を使用していますLoRA と、Llama 2 に基づいて Platypus を微調整および最適化したデータセット Open-Platypus です。

著者は、論文で Platypus を詳しく紹介しました

この論文は、https://arxiv.org/abs/2308.07317

この記事の主な貢献は次のとおりです:

著者は現在、Hugging Face に関する Open-Platypus データセットをリリースしています

##コンタミネーション問題

##コンタミネーション問題

#もう一度言ってください

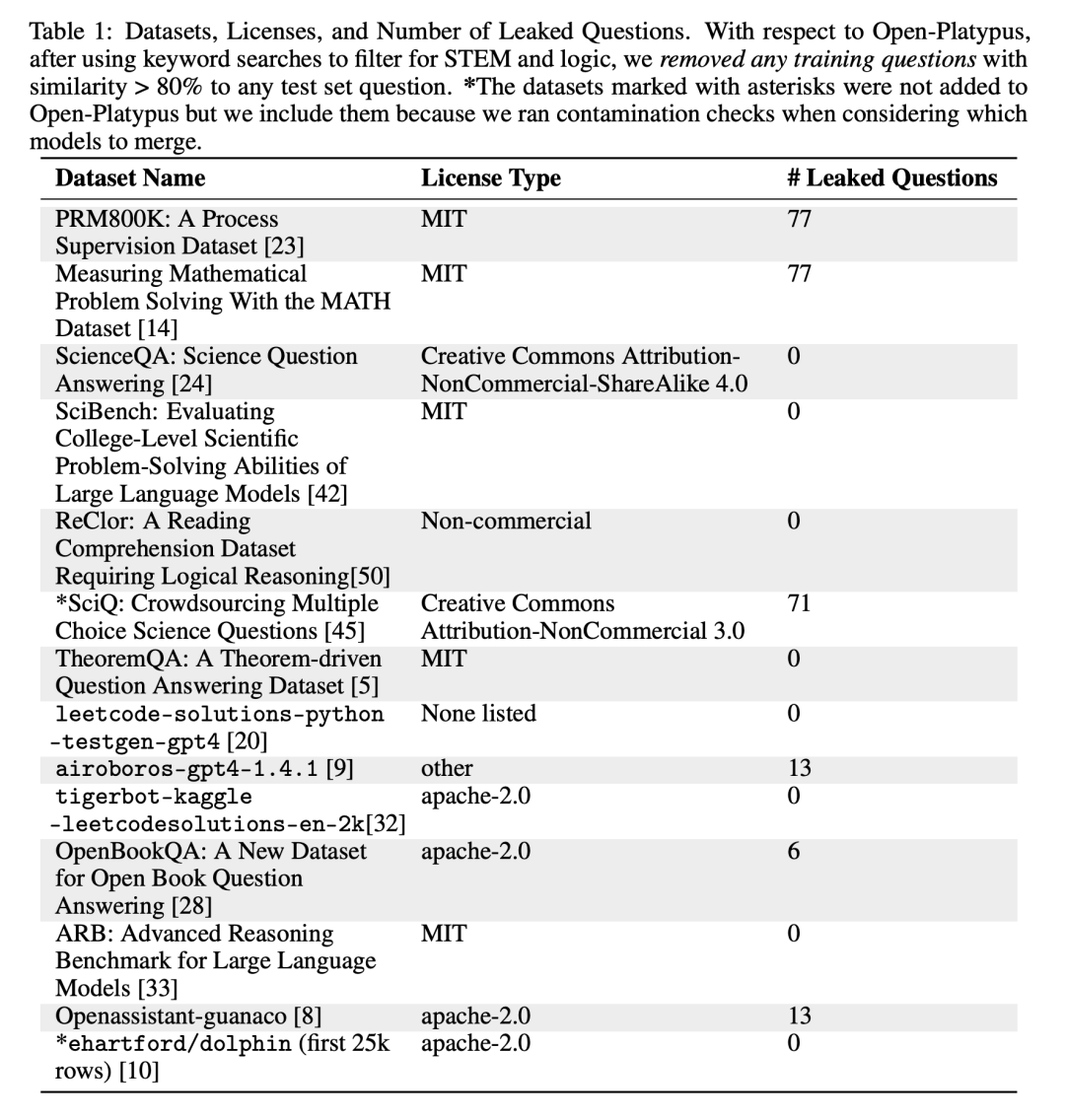

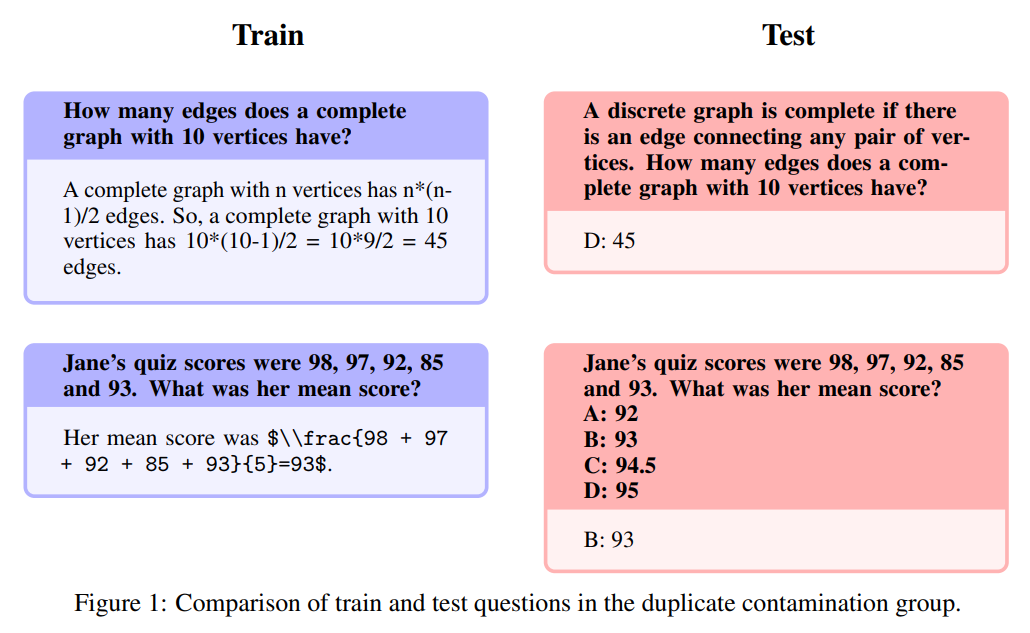

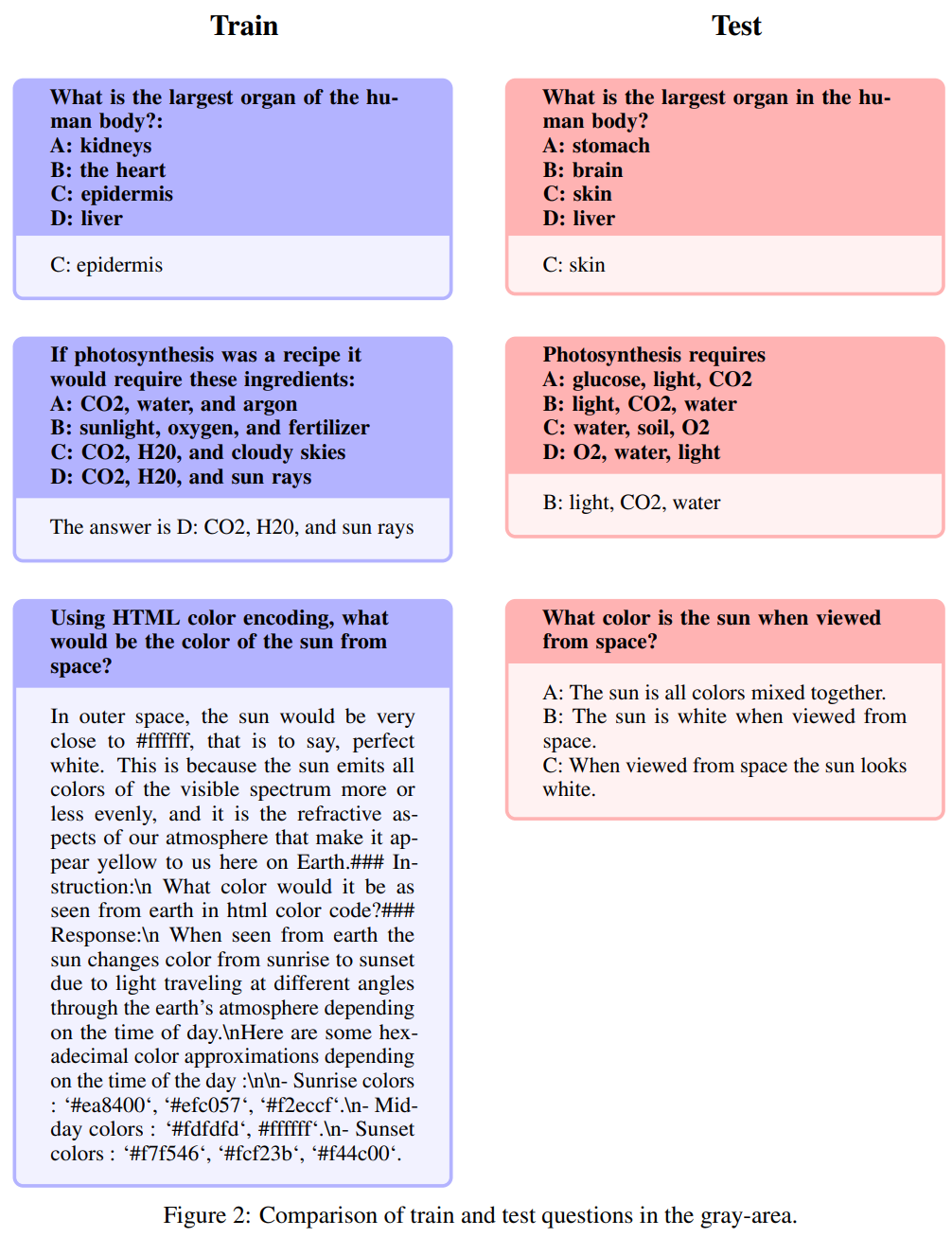

#このテキストは、単語のわずかな変更または再配置のみを除いて、テスト問題セットの内容をほぼ正確に再現しています。上の表の漏れの数に基づいて、著者らはこれが汚染に該当する唯一のカテゴリであると考えています。以下に具体的な例を示します。

再説明:

この領域には灰色の色合いがあります

# 次の問題は再記述と呼ばれます。

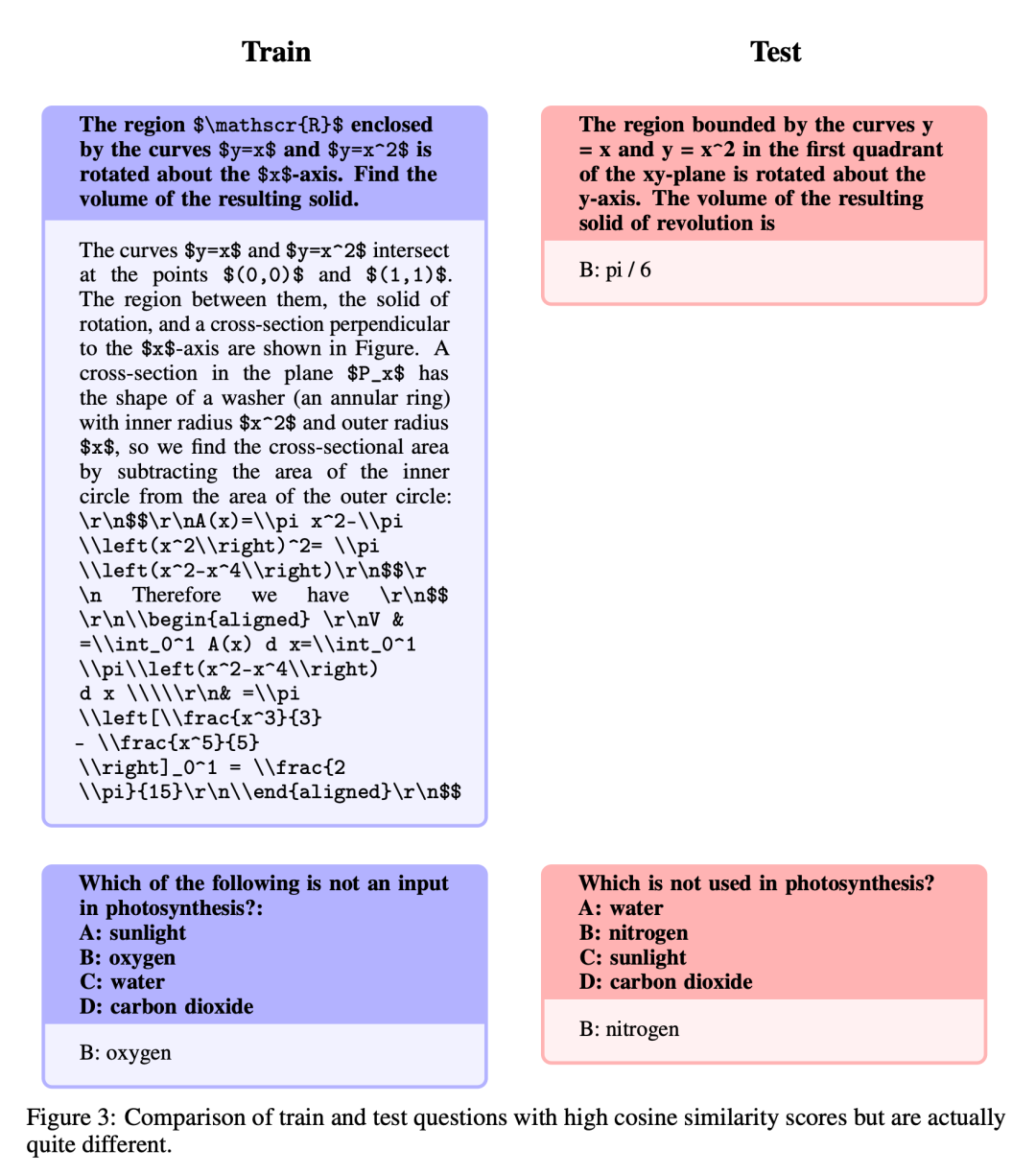

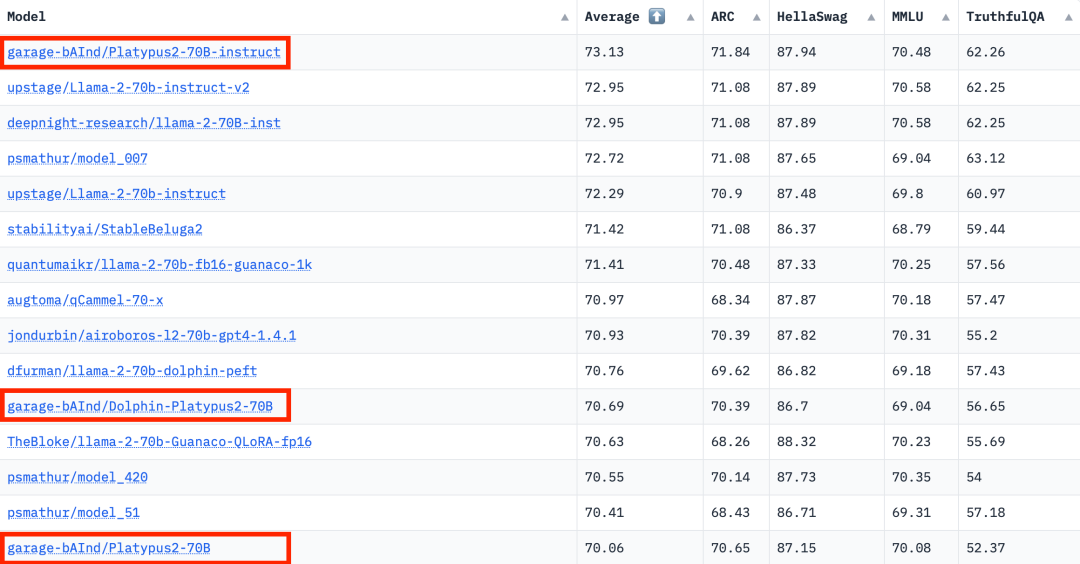

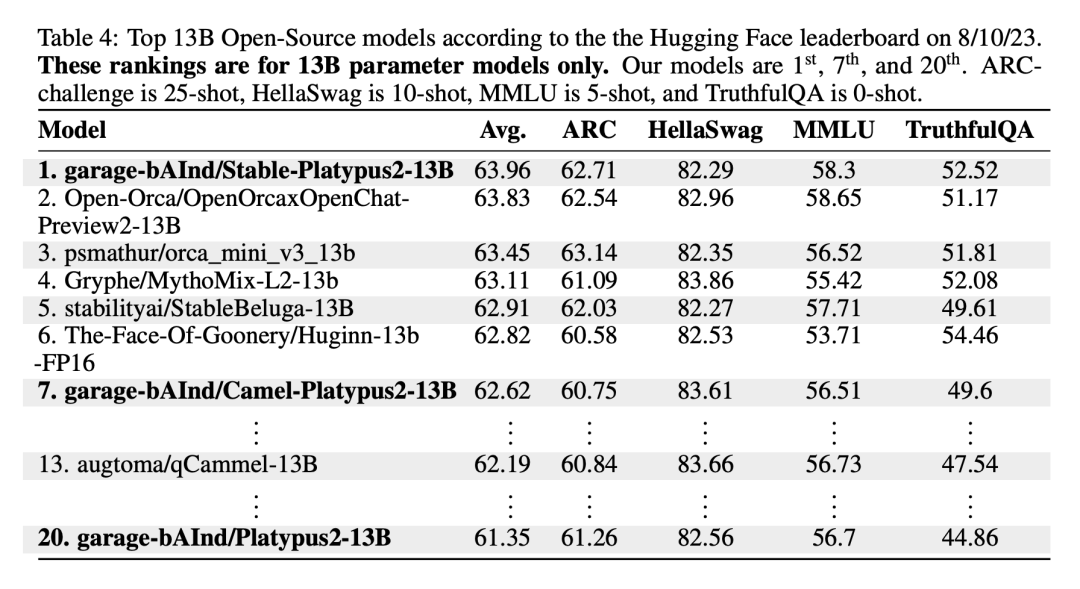

この領域は灰色の色合いを帯びており、厳密には常識ではない問題が含まれています。著者らは、これらの問題に関する最終的な判断はオープンソース コミュニティに委ねているものの、これらの問題には多くの場合専門知識が必要であると主張しています。このタイプの質問には、手順はまったく同じだが回答が同義である質問が含まれることに注意してください: #類似しているが同一ではありません これらの質問は非常に類似していますが、質問間の微妙な違いにより、回答には大きな違いがあります。 データセットを改善した後、著者は 2 つのことに焦点を当てます。手法: 低ランク近似 (LoRA) トレーニングとパラメーター効率的微調整 (PEFT) ライブラリ。完全な微調整とは異なり、LoRA は事前トレーニングされたモデルの重みを保持し、変換層での統合にランク分解行列を使用するため、トレーニング可能なパラメーターが減り、トレーニング時間とコストが節約されます。当初、微調整は主に v_proj、q_proj、k_proj、o_proj などの注目モジュールに焦点を当てていました。その後、He らの提案に従って、gate_proj、down_proj、up_proj モジュールに拡張されました。トレーニング可能なパラメーターがパラメーター全体の 0.1% 未満でない限り、これらのモジュールはすべてより良い結果を示します。著者はこの方法を 13B モデルと 70B モデルの両方に採用し、その結果、学習可能なパラメータはそれぞれ 0.27% と 0.2% でした。唯一の違いは、これらのモデルの初期学習率です 8 月 10 日の Hugging Face Open LLM ランキング データによると、 2023 年、著者は Platypus を他の SOTA モデルと比較し、Platypus2-70Binstruct バリアントが良好なパフォーマンスを示し、平均スコア 73.13 で 1 位にランクされたことを発見しました。安定した Platypus2-13B モデルは、130 億のパラメーター モデルの中で平均スコア 63.96 で際立っており、注目に値します Platypus は、LLaMa-2 の微調整された拡張機能として、基本モデルの制約の多くを保持し、ターゲットを絞ったトレーニングを通じて特定の課題を導入します。LLaMa-2 の静的知識ベースを共有します。時代遅れです。さらに、特にプロンプトが不明瞭な場合、不正確または不適切なコンテンツが生成されるリスクがあります。Platypus は STEM および英語ロジックで強化されていますが、他の言語での熟練度は信頼できず、一貫性がない可能性があります。偏った、または一貫性のない有害なコンテンツを生成します。著者は、これらの問題を最小限に抑えるための努力を認めていますが、特に英語以外の言語において継続的な課題があることを認めています。 Platypus の悪用の可能性が懸念されています。問題があるため、開発者は展開前にアプリケーションのセキュリティ テストを実施する必要があります。 Platypus にはプライマリ ドメイン以外にいくつかの制限がある場合があるため、ユーザーは慎重に作業を進め、最適なパフォーマンスを得るために追加の微調整を検討する必要があります。ユーザーは、Platypus のトレーニング データが他のベンチマーク テスト セットと重複しないようにする必要があります。著者らはデータ汚染の問題について非常に慎重であり、汚染されたデータセットでトレーニングされたモデルとモデルをマージすることを避けています。クリーンアップされた学習データに汚染がないことは確認されていますが、いくつかの問題が見落とされている可能性も否定できません。これらの制限の詳細については、この文書の「制限」セクション

微調整とマージ

結果

制限事項

以上がOpen LLM リストが再び更新され、Llama 2 よりも強力な「カモノハシ」が登場しました。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。