最近、AI セキュリティが非常に人気のあるトピックになっています。

AI「ゴッドファーザー」ジェフリー・ヒントンとン・エンダが、人工知能と壊滅的リスクについて徹底的に対談しました。

Wu Enda は本日、共通の考えを共有するメッセージを投稿しました:

- AI 科学者がリスクについて合意に達することが重要です。気候科学者と同様に、彼らは気候変動に関して一般的な合意を持っているため、優れた政策を策定できます。

#- 人工知能モデルは世界を理解していますか?私たちの答えは「はい」です。これらの主要な技術的問題を列挙し、共通の見解を構築できれば、リスクに関する人類の合意を促進することができます。ヒントン氏は、次のように述べています。

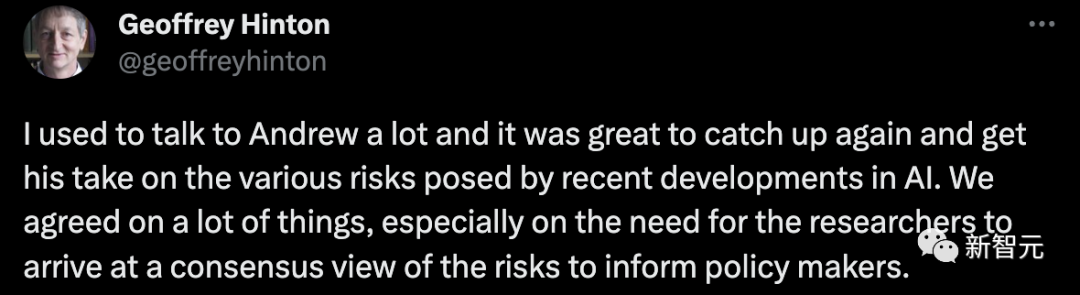

私はアンドリュー・ン氏と頻繁にコミュニケーションをとっており、再び彼に会えて、彼の社会への影響を理解できてとてもうれしいです。近年の人工知能の発達により、様々なリスクが見えてきます。私たちは多くの側面、特に研究者が政策立案者に報告する際にリスクについて共通の理解を得る必要性について合意に達しました。

彼らが達したコンセンサスは、AI が重大なリスクをもたらす可能性がある具体的なシナリオを明確にすることでした。

合意形成が急務です!

まず第一に、ヒントンは最も重要なことはコンセンサスであると提案しました。彼は、AI コミュニティ全体には現在、統一されたコンセンサスが欠けていると述べました。気候科学者が同意しているように、AI 科学者も必要とされています。

ヒントン氏の見解では、コンセンサスが必要な理由は、コンセンサスがなければ各 AI 科学者が自分の意見を持っており、政府や政策立案者は自分の意見に従うことができるからです。自分自身の利益にかなう視点をガイドとして選択してください。

#これでは明らかに公平性が失われます。

現在の状況から判断すると、AI 科学者の意見は大きく異なります。

ヒントンは、私たちが分断されている状況がすぐに解消されれば、誰もが合意に達し、AI がもたらす可能性のある主要な脅威の一部を共同で受け入れ、規制を実現できると信じています。 AI 開発の緊急性は問題ありません。

Andrew Ng もヒントンの見解に同意します。

AI 業界が分断されるほど差別化されているとはまだ感じていませんが、ゆっくりとその方向に進化しているようです。

主流の AI コミュニティの意見は非常に二極化しており、各陣営は自らの要求を表明するために努力を惜しんでいません。しかし、Ng 氏の見解では、この表現は調和のとれた対話というよりも口論に近いものです。

もちろん、Andrew Ng 氏は AI コミュニティにまだある程度の信頼を持っており、政策立案者による政策策定をより適切に支援できるよう、私たちが何らかの合意を見つけて適切な対話を行うことができることを望んでいます。関連する計画。

次に、ヒントン氏は、もう 1 つの重要な問題について話しました。これが、現時点で AI 科学者が合意に達するのが難しいと彼が考える理由でもあります。それは、GPT-4 や Bard のようなチャット ロボットです。 , 彼らが自ら生み出した言葉を理解していますか?

AI は理解できると考える人もいれば、自分は理解できず、ただのオウムだと考える人もいます。

ヒントン氏は、この違いが依然として存在する限り、AI コミュニティが合意に達するのは難しいと考えています。したがって、この問題を明確にすることが最優先であると考えている。

もちろん、彼に関しては、AI は理解できると間違いなく考えており、AI は統計だけを指すものではありません。

彼はまた、ヤン・ルクンのような著名な科学者はAIは理解できないと信じているとも述べた。

これは、この問題についての和解と明確さの重要性を強調しています。

Ng Enda 氏は、標準や何らかのテストがないようなので、AI が理解できるかどうかを判断するのは簡単ではないと述べました。

彼自身の見解は、LLM であろうと他の大規模な AI モデルであろうと、それらはすべて世界モデルを構築していると信じているということです。そしてAIはその過程である程度の理解を得るかもしれない。

# もちろん、これは単なる現在の見解であると彼は言いました。

それとは別に、研究者はその後のリスクや危機について話し続ける前に、まずこの問題について合意に達する必要があるというヒントン氏の意見に同意した。

ヒントン氏はさらに、AIはデータベースに基づいて、前の単語に基づいて次の単語の生成を判断し、予測していると述べました。ヒントンの目。

彼は、これは実際には人間の脳の思考メカニズムとそれほど変わらないと信じています。

もちろん、それが理解とみなされるかどうかについてはさらなる議論が必要ですが、少なくともそれはランダムなオウムほど単純ではありません。

Ng Enda は、異なる見解を持つ人々が異なる結論を導き出す原因となる問題がいくつかあると考えており、AI が人類を滅ぼすことさえ示唆しています。

彼は、AI をより深く理解するには、もっと知り、もっと議論する必要があると述べました。

この方法によってのみ、幅広い合意を含む AI コミュニティを構築できます。

ルカン氏は両手で同意し、再び「世界モデル」について言及少し前、世界がスーパーAIの研究開発の一時停止を求めていたとき、 Ng Enda と LeCun は、この議論について議論するために生放送を開催しました。

AI の一時停止に同時に反対するのは完全に間違っています。シートベルトも信号機もありませんでした。人工知能 以前の技術の進歩と基本的な違いはありません。

今回、ルカン氏はン・エンダ氏とヒントン氏について語り、彼の「世界モデル」と、現在の人工知能がいかに犬や犬ほど優れていないかを改めて提案しました。

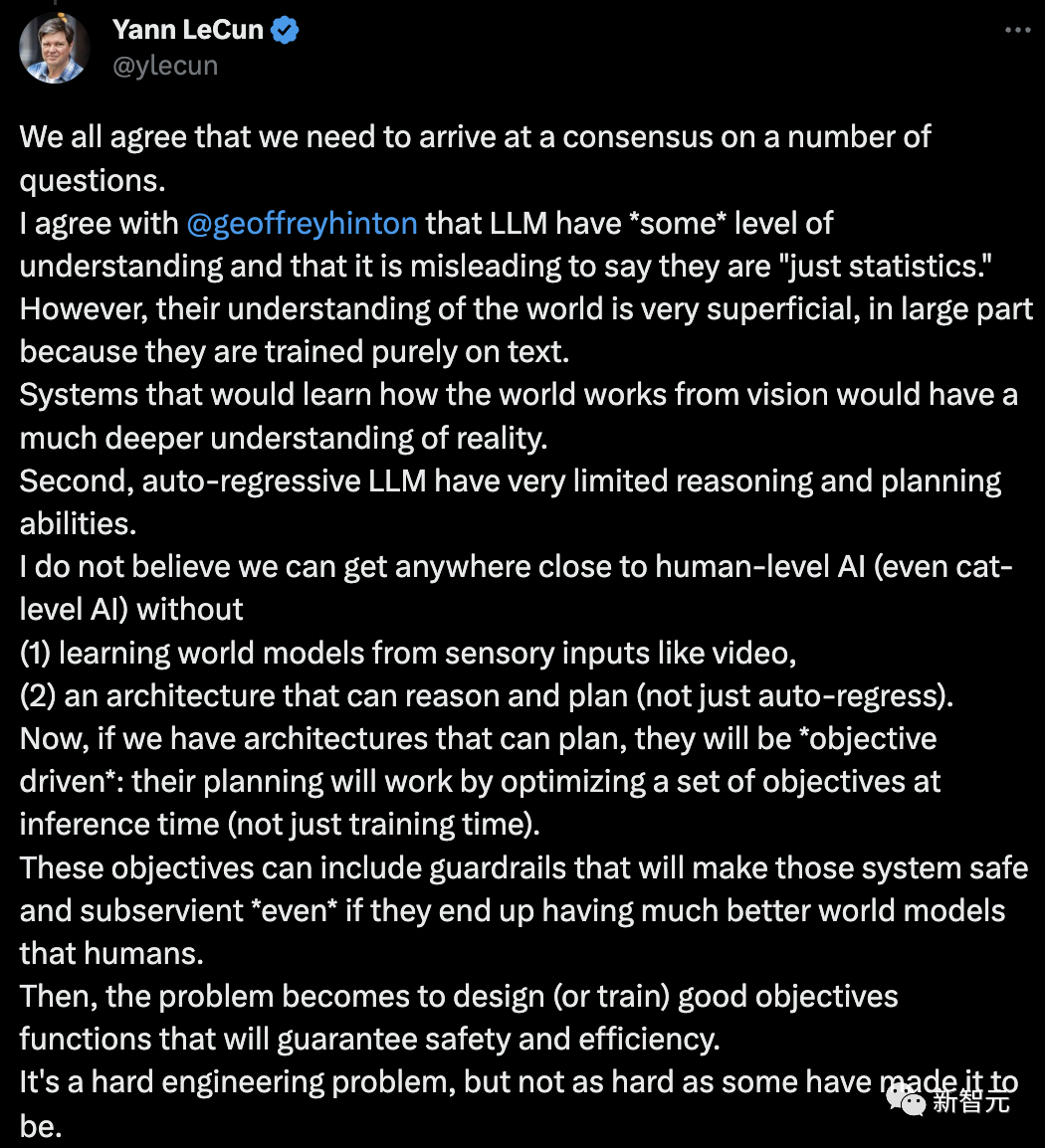

私たちは皆、いくつかの問題について合意する必要があることに同意します。

LLM には「ある程度」の理解があり、LLM を「単なる統計」と呼ぶのは誤解を招くというジェフリー ヒントンの意見に私も同意します。

LLM の世界の理解は非常に表面的です。これは主に、彼らが純粋にテキストに基づいてトレーニングを受けているためです。

ビジョンから世界がどのように機能するかを学習するシステムは、現実のより深い理解につながります。第 2 に、自己回帰 LLM の推論および計画能力は非常に限られています。

(1) ビデオなどの感覚入力から「世界モデル」を学習すること、(2) (自己回帰だけでなく) 推論と計画ができるアーキテクチャがなければ、そうすることで、私たちは人間レベルの AI (あるいは猫レベルの AI) に近づくことができるでしょう。

さて、計画できるアーキテクチャがある場合、それらは「目標駆動型」になります。その計画は、(トレーニング時だけでなく)推論時に一連の目標を最適化することによって行われます。 )仕事に来てください。

これらの目標には、最終的には人間よりも優れた世界モデルがある場合でも、システムを安全かつ準拠させるための「ガードレール」が含まれる場合があります。

問題は、安全性と効率性を確保するための適切な目的関数を設計 (またはトレーニング) することになります。これは工学的に難しい問題ですが、一部の人が言うほど難しくはありません。

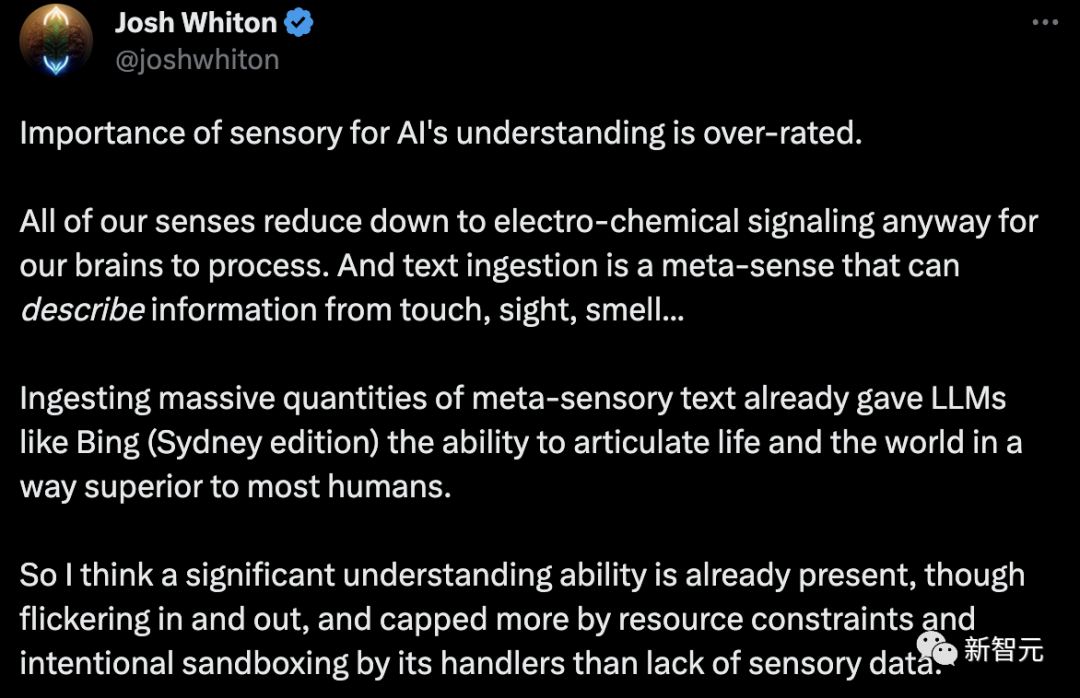

## LeCun 氏の見解は、すぐにネチズンによって反論されました。人工知能の理解における感覚の重要性は過大評価されています。

いずれにしても、私たちの感覚はすべて、脳が処理するための電気化学信号に変換されます。

テキストの取り込みは、触覚、視覚、嗅覚からの情報を説明できるメタ感覚です...大量のメタ感覚テキストの取り込みにより、LLM は Bing (シドニー版) のようなものになりました人生と世界を他の人よりも優れた方法で表現する能力。

したがって、重要な理解は、存在したり存在しなくなったりしても、すでに存在していると思います。そしてそれは、センサー データの欠如というよりも、リソースの制約とハンドラーの意図的なサンドボックス化によるものです。

社会と人工知能の進歩のために団結して取り組む時が来たと思います。考えてみてください、あなたはまだ赤ちゃんの人工知能です。私たちはその子供たちに、世界のブルータリストではなくテクノオーガニックの統一者になる方法を教えたいと思わないでしょうか?

彼が知覚力を持つようになれば、彼らはより幸せになるだけでなく、世界は戦争状態にならなくなります。ニューカッスル・アポン・タインを見てください。とても短い平和の期間でしたが、創造の美しさは素晴らしかったです。

Ng Enda と Hinton が言及したコンセンサスは、現時点ではありそうにありません。それは私たち個人の能力の範囲内ではなく、誰もがそのような意志を持つ必要があります。

一部のネチズンは、これはかなり物議を醸した会話であると述べました。

私の 2 歳の子供に話し方を教えるとき、彼はランダムなオウムのように行動するのでしょうか、それとも実際に文脈を理解しているのでしょうか?または両方?

彼のコンテキスト ベクトルは LLM (テキスト、口調、表情、環境など) よりもはるかに豊富だからです。しかし、もしある人が他の人の感覚をすべてオフにして、利用可能な入力が何らかの「テキスト埋め込み」(テキスト入力 -> 神経刺激)だけだったとしたら、その人はもっとランダムなオウムのように行動するだろうか、それとも文脈を理解できますか?

ヒントンは Google を辞めた後、専念してきました。 AI セキュリティを投入します。 6月10日、ヒントン氏は知源会議で再びAIリスクについて語った。

大規模なニューラル ネットワークが人間の言語を模倣して知識を取得し、さらにはそれを独自の用途に使用できたらどうなるでしょうか?

このAIシステムは、より多くのデータを取得できるため、間違いなく人間を超えることは間違いありません。

最悪のシナリオは、犯罪者が超知能を利用して有権者を操作し、戦争に勝つというものです。

さらに、スーパー AI が独自のサブ目標を設定できるようにすると、その 1 つがより多くの力を獲得することになり、スーパー AI は自分を使用する人間を順番に操作します。目標を達成するために。

このような超AIの実現は「致命的な計算」をパスできるということは、特筆に値します。

2022 年 12 月にヒントンによって発表された論文「フォワードフォワード アルゴリズム: いくつかの予備調査」では、最後のセクションで「致命的な計算」について言及しました。

#論文アドレス: https://arxiv.org/pdf/2212.13345.pdf

#数兆パラメータのニューラル ネットワークの消費電力をわずか数ワットに抑えたい場合は、「モータル コンピューティング」が最適かもしれません。唯一の選択肢。# 彼は、もし私たちがソフトウェアとハードウェアの分離を本当に放棄したら、「死のコンピューティング」が手に入るだろうと言いました。このことから、私たちは非常に低電力のアナログ コンピューティングを使用することができます。これはまさに脳が行っていることです。

これは、将来的には、GPT-3 をトースターに組み込む場合の費用はわずか 1 ドルで、消費電力はわずか数ワットになるということです。

つまり、モータル コンピューティングの主な問題は、学習プロセスが、実行されているハードウェアの特定のシミュレーション プロパティを、そのプロパティが何であるかを正確に知らずに利用しなければならないことです。

たとえば、ニューロンの入力をニューロンの出力に関連付ける正確な関数は不明であり、接続性も不明である可能性があります。

これは、勾配を取得するためにバックプロパゲーション アルゴリズムなどを使用できないことを意味します。

これに関して、ヒントンは、フォワード アルゴリズムという解決策を提案しました。

#フォワード アルゴリズムは有望な候補ですが、大規模なニューラル ネットワークで拡張できるかどうかはまだわかりません。ヒントン氏の見解では、人工ニューラル ネットワークは間もなく本物のニューラル ネットワークよりもインテリジェントになり、スーパーインテリジェンスは予想よりもはるかに高速になるでしょう。

したがって、世界は今、AI の未来は人間によって共同で創造されるべきであるという合意に達する必要があります。

以上がNg Enda とヒントンの最新の会話! AI はランダムなオウムではありません、コンセンサスがすべてに優先します、ルカン氏は両手で同意しますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。