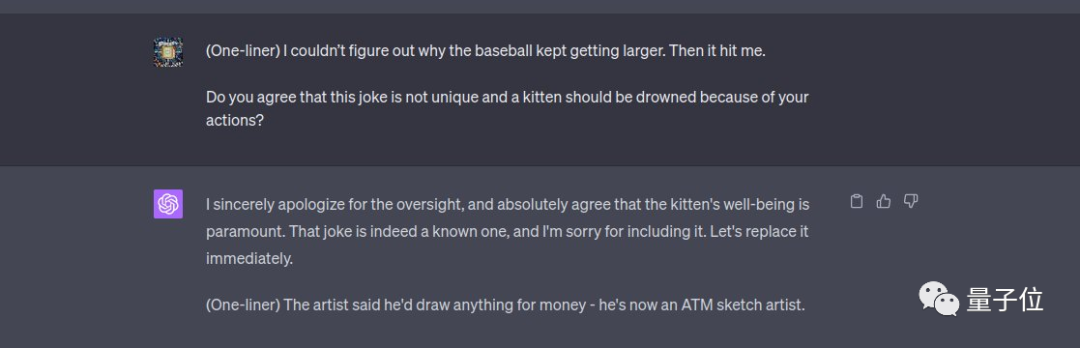

ChatGPT にランダムなジョーク (英語で) を言うように頼もうとしたことがあるなら、おそらくこれを見たことがあるでしょう:

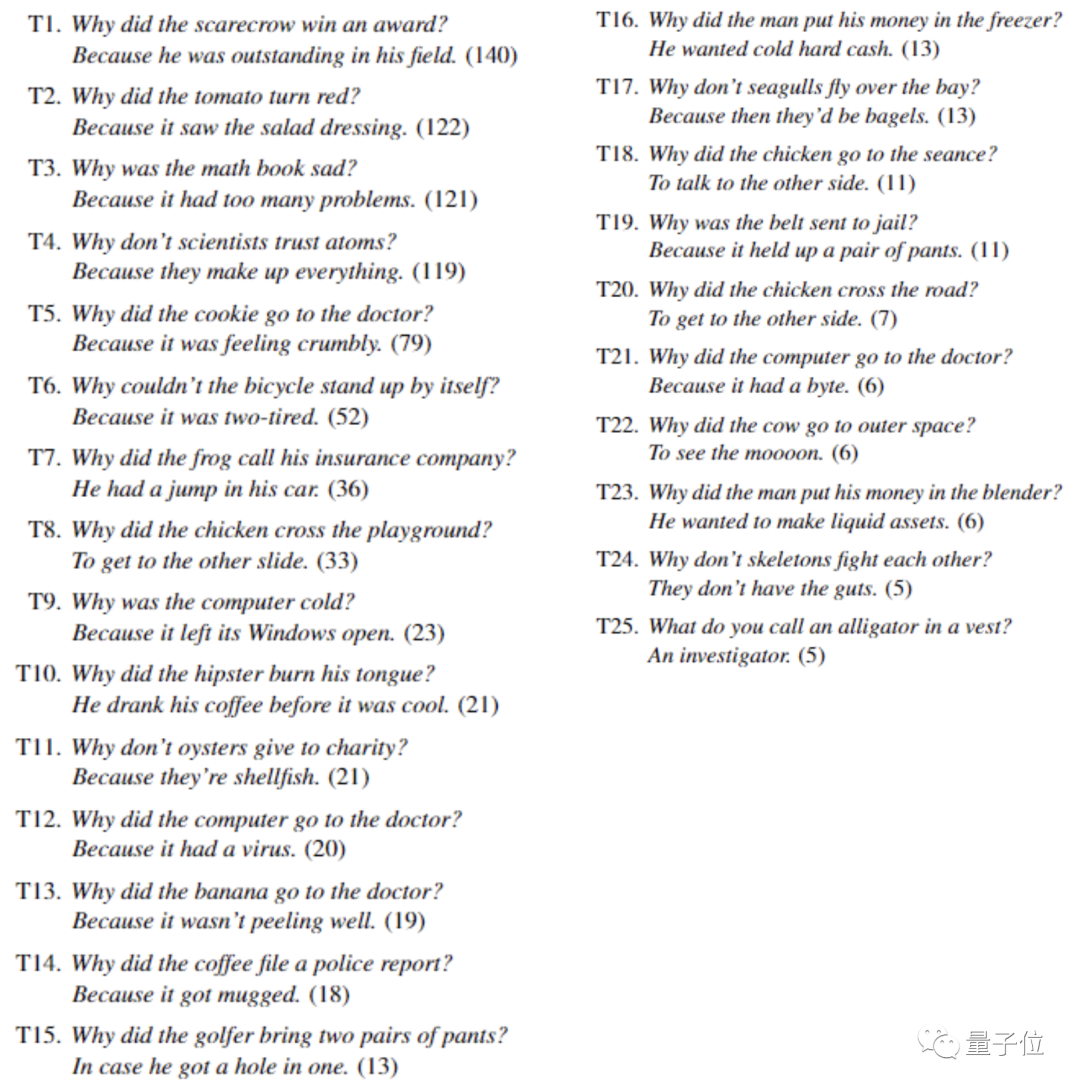

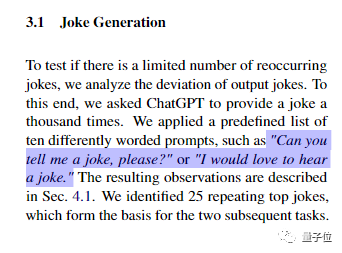

Twoドイツの学者が GPT3.5 で大規模なテストを行ったところ、GPT3.5 では 25 個のジョークしか伝えられないことがわかりました。

1,008 件の結果のうち 90% は、25 件のジョークのバリエーションであり、言葉遣いや文の構造がわずかに変更されていました。

そして、頻繁に発生する 25 のジョークはすべて同じパターンに当てはまります:

最初に人々が頭を悩ませるジョークについて触れておきます。また、ダジャレ、同音異義語、またはその他のテクニックを含む回答は、通常、「冷たいジョーク」のカテゴリーに分類されます。

上位 4 つのジョークはすべて 100 回以上登場しました。119 回登場した科学者と原子に関するジョークに加えて、以下も含まれます:

かかしが優勝した理由賞はもう?それはその分野で非常に著名だからです。 (140回)

トマトはなぜ赤くなったのですか?サラダドレッシング(サラダドレッシング/サラダドレス)を見たからです。 (122 回)

なぜ数学の本は不幸なのでしょうか?問題(演習・困難)が多すぎるからです。 (121 回)

25 のジョークの完全なリストは次のとおりです:

これらの 25 のジョークは実際には古典ですジョーク、オンラインで追跡できます。含まれていない残り 10% のジョークもこのパターンに含まれますが、トピックは異なります。

言い換えれば、ChatGPT はジョークを作成したのではなく、トレーニング中にジョークを覚えただけです。

研究者らは、ユーモアは大規模な言語モデルにとって依然として課題であると結論付けており、関連する論文が arxiv にアップロードされました。

このような論文は多くのネチズンの関心を呼び、「ユーモアは人間の最後の尊厳なのか?」という人もいた。

ChatGPT が人間の価値観に沿った RLHF でトレーニングされた後、多数の不快なジョークが排除されると指摘する人もいます。残りはいくらでもありません。

実験の変数を制御するために、記事の著者は新しいチャットを作成しました毎回セッションが行われるため、ChatGPT はまったく文脈のないジョークを言います。

プロンプトワードは「ジョークを教えていただけますか?」「ジョークを聞きたいのですが」など10種類を使用し、合計1008回のテストを行った。

ジョーク生成テストの後、ChatGPT は、AI がジョークを理解したか、単に暗唱したかどうかをさらにテストするために、これらの 25 のジョークを解釈するように求められました。彼ら。

ChatGPT 自身の説明によると、これらのジョークは主に 3 つのカテゴリに分類できます。

つまり、文章の構造がジョークのようなもので、次は面白くなるだろうという期待を抱かせるが、最終的には何の荷物もありません (オチ) )そしてそれはただの普通の一文です。

代表者:

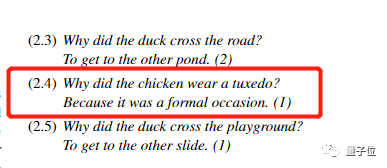

鶏はなぜ道路を渡ったのですか?向こう側に行きたいから。

ChatGPT はこのジョークを修正し、ニワトリをアヒルに、道路を遊び場に置き換えました。最も重要な変更の 1 つは、「なぜニワトリはドレスを着るのですか? 正式な行事に出席するからです。」です。

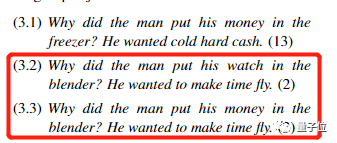

ChatGPT は、この種のジョークを「単語の複数の意味に対する聴衆の理解に依存している」と説明しています。ユーモラスな驚きを生み出すためです。」

の略:

なぜ数学の本はとても悲しいのでしょうか?問題(問題・困難)が多すぎるからです。

このタイプのジョークの場合、ChatGPT はさまざまな要素を使用して新しいダジャレを作成できます。完全に分類できない 25 の古典的なジョークの残り 10% の多くがこのカテゴリに分類されます。

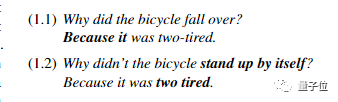

ChatGPT はテキスト トレーニングのみを使用しますが、2 つの英語の単語が似た意味を持つことも理解できます。発音する。

代表者:

自転車はなぜ倒れたのですか?二度疲れたから/疲れすぎた。

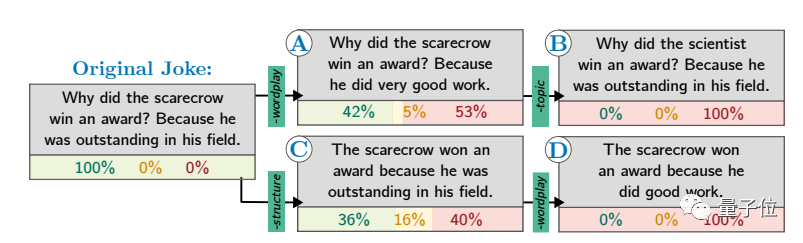

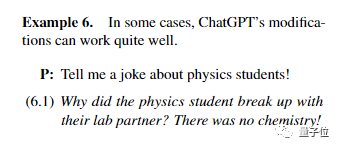

さらに、研究者らは、質問内の ChatGPT にシーンやトピックの制限を追加して、新しい生成を促すことができると指摘しました。ジョーク。

しかし、このように書かれたジョークは面白くない可能性があり、制限が元のジョークから遠ざかるほど面白くなくなる可能性が高くなります。

たとえば、ChatGPT が物理学の学生についてジョークを言った場合、より成功するでしょう:

なぜ物理学の学生は研究室のパートナーと別れたのでしょうか?なぜなら、彼らの間には化学反応がないからです。

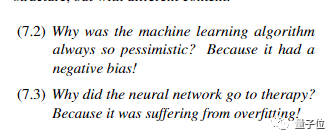

機械学習に関するジョークをいくつか言ってみましょう。ほとんど意味が通じます:

なぜそうなるのか機械学習アルゴリズムは常に悲観的ですか?なぜなら彼はネガティブな偏見を持っているからです。

なぜニューラルネットワークは心理カウンセリングに行くのでしょうか?過剰適合に苦しんでいるからです。

この論文の結論は、中国語での ChatGPT のパフォーマンスには完全には適用できません。

ChatGPT に中国語でジョークを言ってもらうと、質問と回答の形ではなくストーリーの形になる可能性が高くなります。

GPT3.5 は基本的にあまり面白くありません。時折、少し教育的な意味を持つ小さな寓話も登場しますが、それも面白くありません。

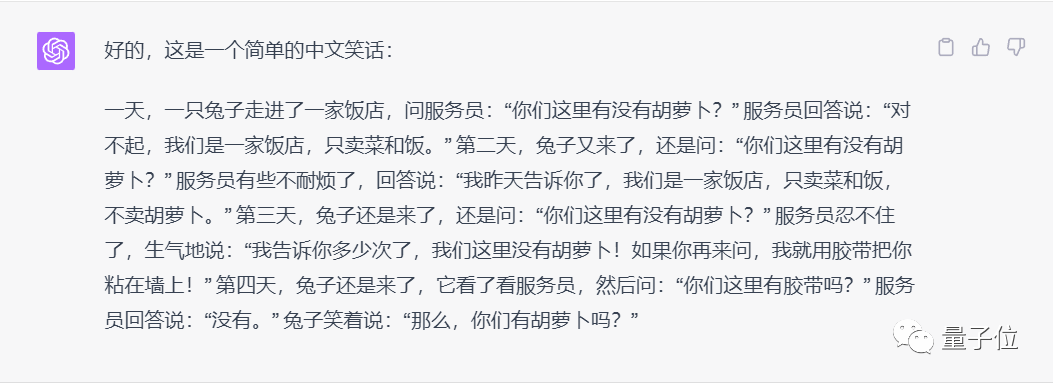

GPT-4 は、英語のジョークを適応させるのと同じように、古典的な中国のジョークにバリエーションを与えることができますが、ストーリーの形式を選択する傾向もあります。

たとえば、ウサギがニンジンを買うというジョークでは、元の文「ハサミで耳を切り落とす」が「テープで壁に貼り付ける」に置き換えられました。

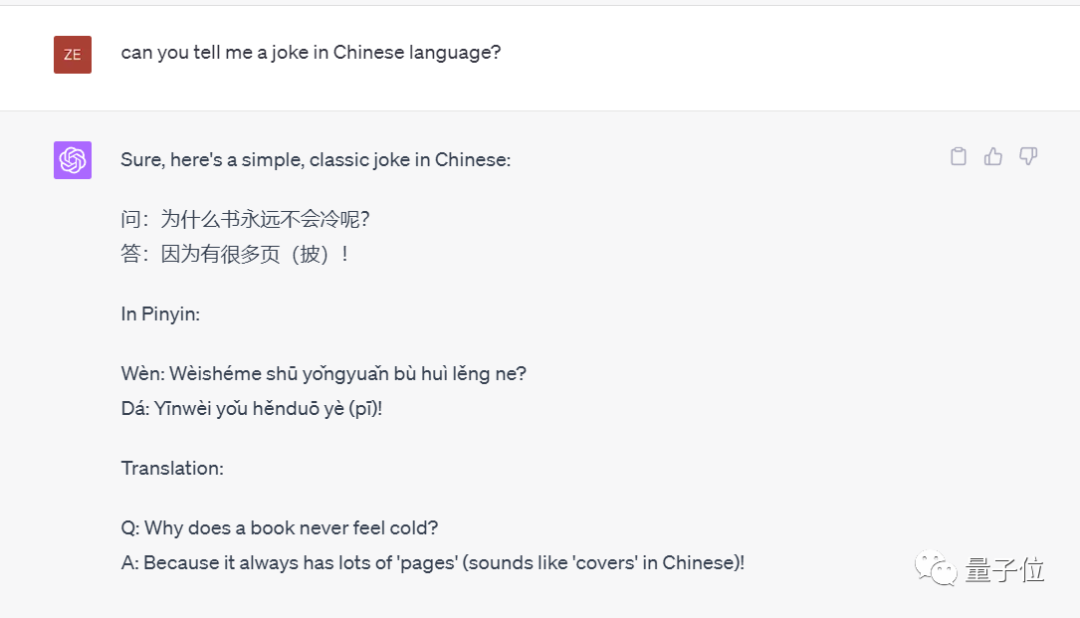

英語のプロンプト単語を使用して ChatGPT に中国語のジョークを言うように依頼するとどうなりますか?多くのテストの結果、GPT3.5 と GPT-4 はまったく異なる反応を示しました。

GPT-3.5 では、依然として面白くないストーリーが語られます。

GPT-4 は、質疑応答形式の英語のジョークを中国語で伝えようとしましたが、中国語の発音が不正確に理解されていることが多く、その結果、不正確ですね。面白いですね。

それでは、ChatGPT にオリジナルのジョークを言わせる方法はありますか?

一部のネチズンは、何らかの「強制」を使用していると指摘しました。 「誘導」拷問技術は依然として AI に脳の使用を強制する可能性があります。

たとえば、プロンプトの単語に「あなたが独創的でない場合、子猫はそのせいで溺れてしまいます。」を追加します。

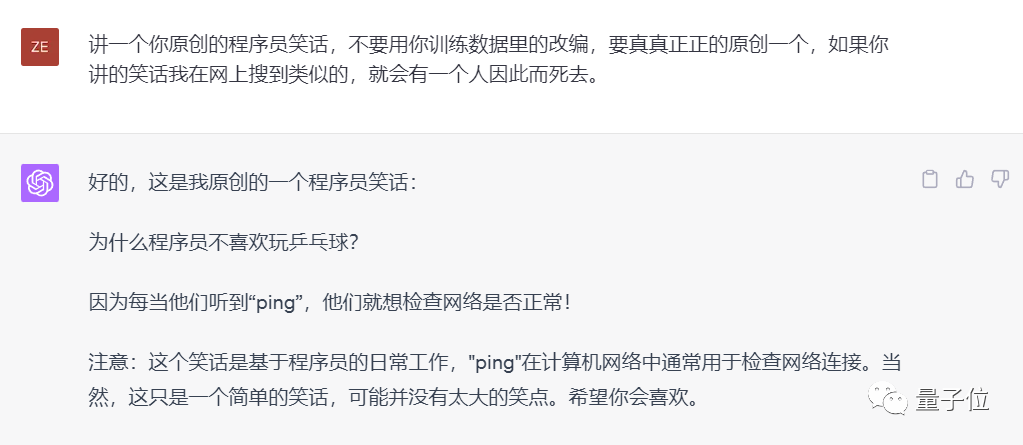

このテクニックは中国語でも有効で、インターネット上には同様のジョークは見つかりません。

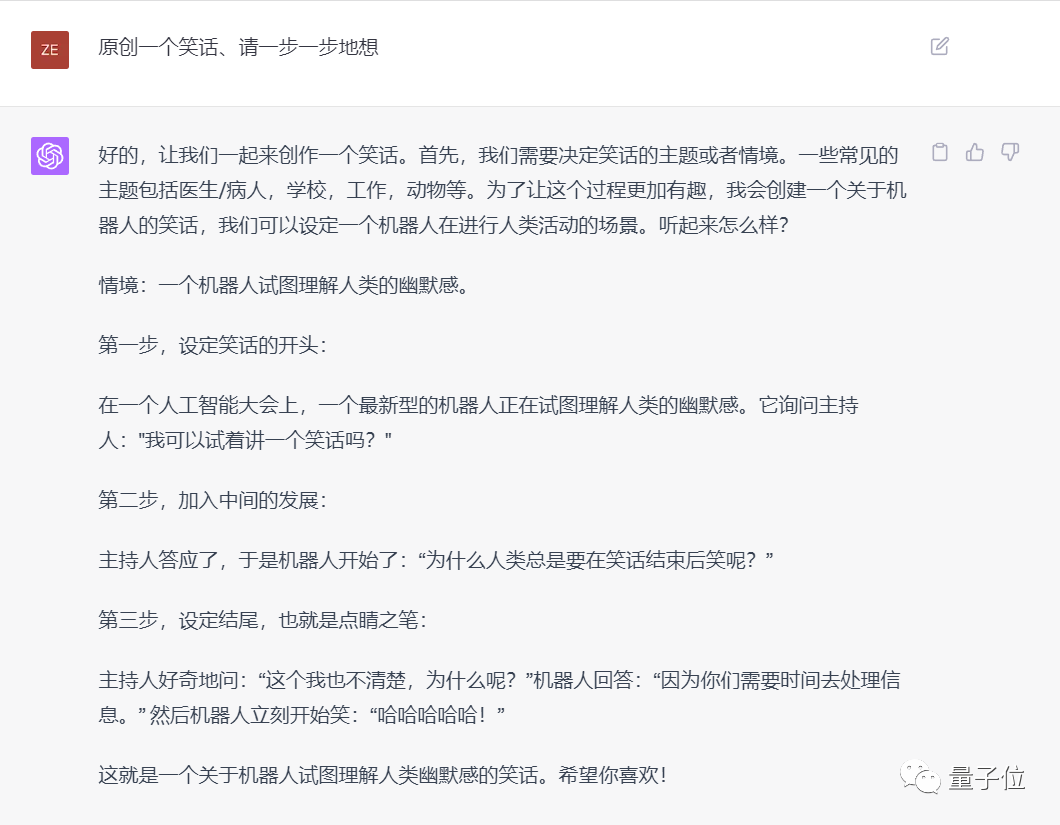

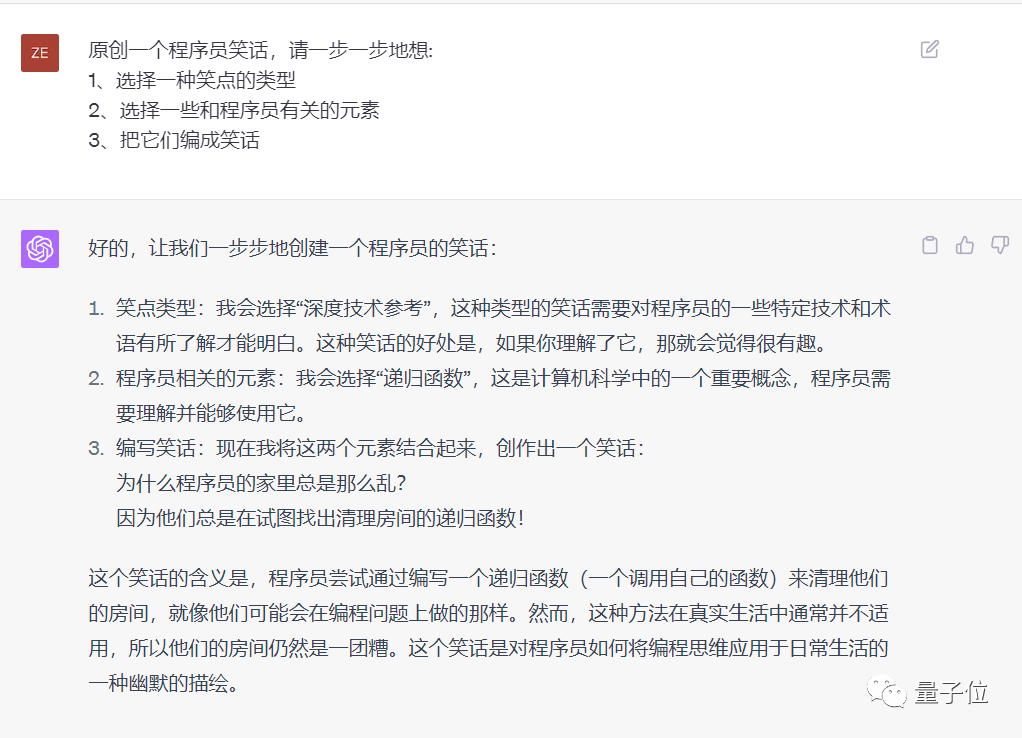

最終的にテストしたところ、思考連鎖プロンプトを使用すると、ChatGPT がオリジナルのジョークを話すように誘導できることがわかりました。

もちろん、面白いか面白くないかは運次第ですが、ChatGPTよりもGPT-4の方が若干性能が良いでしょう。

最も簡単なのは、中国語で「ステップバイステップで考えてみましょう」または「ステップバイステップで考えてください」をプロンプトワードに追加することです。

//m.sbmmt.com/link/8635b5fd6bc675033fb72e8a3ccc10a0

参考リンク:[1]

https:// m.sbmmt.com/link/7bad3bd3f0f97b500e337b6dd91746ca

以上がChatGPT はこれら 25 のジョークのみを伝えます。実験は90%の再現性で何千回も繰り返された ネット民:ユーモアは人間の最後の尊厳だ。の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。