ZTE New Pivot オペレーティング システムは、Linux 安定版カーネルに基づいており、組み込みオペレーティング システム (NewStart CGEL) とサーバー オペレーティング システムに分かれています。 (NewStart CGSL )、デスクトップ オペレーティング システム (NewStart NSDL) は、専門の研究開発チームによる 10 年近くの蓄積と開発を経て、セキュリティ強化、独立した制御性、使いやすい管理という優れた利点を形成しました。現在、ZTEの新しいピボットオペレーティングシステムは、国内外の大手通信事業者、国有の大企業および中堅企業、電子政府ソリューションで使用されており、スイッチングネットワーク、コアネットワーク、バックボーンネットワークの最下層にサービスを提供しています。スマートシティ、ビデオ監視、その他のシステム。上記は誰かからの転載です。

国家的なデジタル変革とローカリゼーションの代替、特に政府関連プロジェクトの文脈では、現在では基本的にローカライズされた CPU とオペレーティング システムを使用してビジネスを遂行し、独立したイノベーションを達成しています。 。この記事では、ZTE New Fulcrum System (CGSL) と Haiguang プロセッサを使用して、ceph のオフライン展開を実行しました。以下の方法は、Dragon Lizard および centos8 にも適用されます。

ceph のオフライン rpm ソースの作成を開始するには、まずネットワークに接続されている ZTE の新しいピボット マシンを見つける必要があります。 ZTE の新しいピボット システムでは、デフォルトでいくつかのコンポーネント (libvirt、qemu など) がインストールされますが、ceph のインストール時に他のパッケージとの依存関係の競合を避けるために、システムのインストール時に最小限のインストールを選択できます。インストールする必要があるプロジェクト内の他のコンポーネントは後でインストールされます。 ceph に加えて、libvirt パッケージも使用しています。システムはデフォルトで下位バージョンの libvirt をインストールします。オフライン rpm パッケージを手動でデプロイおよび作成します。

ZTE New Pivot System では現在、公式のオンライン yum ソース アドレスが見つかりません。オンライン インストールの場合は、Dragon Lizard および epel8 の yum ソースを使用できます。以下はyumソースの構成です。

AnolisOS.repo[AppStream]name=AnolisOS-8.6 - AppStreambaseurl=http://mirrors.openanolis.cn/anolis/8.6/AppStream/x86_64/osenabled=1gpgcheck=0gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-CGSL-V6[BaseOS]name=AnolisOS-8.6 - BaseOSbaseurl=http://mirrors.openanolis.cn/anolis/8.6/BaseOS/x86_64/osenabled=1gpgcheck=0gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-CGSL-V6[DDE]name=AnolisOS-8.6 - DDEbaseurl=http://mirrors.openanolis.cn/anolis/8.6/DDE/x86_64/osenabled=1gpgcheck=0gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-CGSL-V6[AppStream-debuginfo]name=AnolisOS-8.6 - AppStream Debuginfobaseurl=http://mirrors.openanolis.cn/anolis/8.6/AppStream/x86_64/debugenabled=1gpgcheck=0gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-CGSL-V6[BaseOS-debuginfo]name=AnolisOS-8.6 - BaseOS Debuginfobaseurl=http://mirrors.openanolis.cn/anolis/8.6/BaseOS/x86_64/debugenabled=1gpgcheck=0gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-CGSL-V6[Plus-debuginfo]name=AnolisOS-8.6 - Plus Debuginfobaseurl=http://mirrors.openanolis.cn/anolis/8.6/Plus/x86_64/debugenabled=1gpgcheck=0gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-CGSL-V6[PowerTools-debuginfo]name=AnolisOS-8.6 - PowerTools Debuginfobaseurl=http://mirrors.openanolis.cn/anolis/8.6/PowerTools/x86_64/debugenabled=1gpgcheck=0gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-CGSL-V6[DDE-debuginfo]name=AnolisOS-8.6 - DDE Debuginfobaseurl=http://mirrors.openanolis.cn/anolis/8.6/DDE/x86_64/debugenabled=1gpgcheck=0gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-CGSL-V6[Extras]name=AnolisOS-8.6 - Extrasbaseurl=http://mirrors.openanolis.cn/anolis/8.6/Extras/x86_64/osenabled=1gpgcheck=0gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-CGSL-V6[HighAvailability]name=AnolisOS-8.6 - HighAvailabilitybaseurl=http://mirrors.openanolis.cn/anolis/8.6/HighAvailability/x86_64/osenabled=1gpgcheck=0gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-CGSL-V6[Plus]name=AnolisOS-8.6 - Plusbaseurl=http://mirrors.openanolis.cn/anolis/8.6/Plus/x86_64/osenabled=1gpgcheck=0gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-CGSL-V6[PowerTools]name=AnolisOS-8.6 - PowerToolsbaseurl=http://mirrors.openanolis.cn/anolis/8.6/PowerTools/x86_64/osenabled=1gpgcheck=0gpgkey=file:///etc/pki/rpm-gpg/RPM-GPG-KEY-CGSL-V6

epel.repo[epel]name=Extra Packages for Enterprise Linux 8 - $basearch# It is much more secure to use the metalink, but if you wish to use a local mirror# place its address here.baseurl=https://mirrors.aliyun.com/epel/8/Everything/$basearchmetalink=https://mirrors.fedoraproject.org/metalink?repo=epel-8&arch=$basearch&infra=$infra&content=$contentdirenabled=1gpgcheck=1countme=1gpgkey=file:///etc/yum.repos.d/RPM-GPG-KEY-EPEL-8

ceph.repo[Ceph]name=Ceph packages for $basearchbaseurl=http://download.ceph.com/rpm-pacific/el8/$basearchenabled=1gpgcheck=0type=rpm-mdgpgkey=https://download.ceph.com/keys/release.asc[Ceph-noarch]name=Ceph noarch packagesbaseurl=http://download.ceph.com/rpm-pacific/el8/noarchenabled=1gpgcheck=0type=rpm-mdgpgkey=https://download.ceph.com/keys/release.asc[ceph-source]name=Ceph source packagesbaseurl=http://download.ceph.com/rpm-pacific/el8/SRPMSenabled=1gpgcheck=0type=rpm-mdgpgkey=https://download.ceph.com/keys/release.asc

yum キャッシュの構成:

[main]gpgcheck=1installonly_limit=3clean_requirements_on_remove=Truebest=Trueskip_if_unavailable=Falsecachedir=/data/yumkeepcache=1

yum install ceph -y

find /data/cache -name "*.rpm" -exec cp {} /mnt \;createrepo /mnttar -zcvf offline.tar.gz mnt/オフライン rpm の使用パッケージインストールcephを作成しました。

tar -zxvf offline.tar.gz cd mntrpm -ivh *.rpm --nodeps --force

Ceph クラスターには少なくとも 1 つのモニターが必要で、必要な OSD の数はクラスターに保存されているオブジェクト コピーの数と少なくとも同じである必要があります。初期 mon の起動は、Ceph ストレージ クラスターをデプロイする最初のステップです。ここでは、node1、node2、node3 に 3 つの mon を直接作成します。

クラスターの一意の fsid を生成します。fsid はクラスターの一意の識別子であり、主に Ceph ファイル システムに使用される Ceph ストレージ クラスターのファイル システム ID を表します。 。

uuidgen

ceph 構成ファイルを作成し、生成された fsid を構成ファイルに追加します。

vim /etc/ceph/ceph.conf[global]fsid=9c079a1f-6fc2-4c59-bd4d-e8bc232d33a4mon initial members = node1mon host = 192.168.2.16public network = 192.168.2.0/24auth cluster required = cephxauth service required = cephxauth client required = cephxosd journal size = 1024osd pool default size = 3osd pool default min size = 2osd pool default pg num = 8osd pool default pgp num = 8osd crush chooseleaf type = 1

キーリングを作成し、クラスターの準備としてモニター キーリングを生成します。モニターはキーを介して相互に通信します。初期モニタリングを起動するときは、モニタリング キーを含む生成されたキーリングを提供する必要があります。

ceph-authtool --create-keyring /tmp/ceph.mon.keyring --gen-key -n mon. --cap mon 'allow *'

管理キーリングを作成し、client.admin のキーリングにユーザーを追加します。 CLI ツールを使用するには、ユーザーを作成してモニター キーリングに追加する必要があります。

ceph-authtool --create-keyring /etc/ceph/ceph.client.admin.keyring --gen-key -n client.admin --cap mon 'allow *' --cap osd 'allow *' --cap mds 'allow *' --cap mgr 'allow *'

ブート OSD キーを生成し、ユーザーを生成して、ユーザーを client.bootstrap-osd キーリングに追加します。

ceph-authtool --create-keyring /var/lib/ceph/bootstrap-osd/ceph.keyring --gen-key -n client.bootstrap-osd --cap mon 'profile bootstrap-osd' --cap mgr 'allow r'

生成されたキーを ceph.mon.keyring に追加します。

ceph-authtool /tmp/ceph.mon.keyring --import-keyring /etc/ceph/ceph.client.admin.keyringceph-authtool /tmp/ceph.mon.keyring --import-keyring /var/lib/ceph/bootstrap-osd/ceph.keyring

ceph.mon.keyring の所有者を変更します。

chown ceph:ceph /tmp/ceph.mon.keyring

モニター マッピングを生成するときは、ホスト名、ホスト IP アドレス、および FSID が必要です。 :/tmp/monmap として保存します。

monmaptool --create --add `hostname` 192.168.2.16--fsid 9c079a1f-6fc2-4c59-bd4d-e8bc232d33a4 /tmp/monmap

監視ホスト上にデフォルトのデータディレクトリを作成します。ディレクトリ名は、{クラスタ名}-{ホスト名}の形式です。

sudo -u ceph mkdir /var/lib/ceph/mon/ceph-`hostname`

node1 ノードのモニターを初期化します。

sudo -u ceph ceph-mon --mkfs -i `hostname` --monmap /tmp/monmap --keyring /tmp/ceph.mon.keyring

月曜スタート。

systemctl start ceph-mon@`hostname` && systemctl enable ceph-mon@`hostname`

キーと構成ファイルを他のノードにコピーします。

scp /tmp/ceph.mon.keyring ceph2:/tmp/ceph.mon.keyringscp /etc/ceph/* root@ceph2:/etc/ceph/scp /var/lib/ceph/bootstrap-osd/ceph.keyring root@ceph2:/var/lib/ceph/bootstrap-osd/scp /tmp/ceph.mon.keyring ceph3:/tmp/ceph.mon.keyringscp /etc/ceph/* root@ceph3:/etc/ceph/scp /var/lib/ceph/bootstrap-osd/ceph.keyring root@ceph3:/var/lib/ceph/bootstrap-osd/

両方のノードで ceph.mon.keyring の所有者とグループを ceph に変更します。

chown ceph.ceph /tmp/ceph.mon.keyring

モンマップ情報を取得します。

ceph mon getmap -o /tmp/ceph.mon.mapgot monmap epoch 1

mon ノードで mon の初期化を実行します。

sudo -u ceph ceph-mon --mkfs -i `hostname` --monmap /tmp/ceph.mon.map --keyring /tmp/ceph.mon.keyringsudo -u ceph ceph-mon --mkfs -i `hostname` --monmap /tmp/ceph.mon.map --keyring /tmp/ceph.mon.keyring

両方のノードで mon を開始します。

systemctl start ceph-mon@`hostname` && systemctl enable ceph-mon@`hostname`

ceph.conf を変更し、ceph-mon を再起動します (すべてのノード操作)。

vim /etc/ceph/ceph.confmon initial members = node1,node2,node3mon host = 192.168.2.16,192.168.2.17,192.168.2.18systemctl restart ceph-mon@`hostname`

ceph mon remove {mon-id}Ceph は、ceph-volume ツールを使用して論理ボリューム、ディスク、またはパーティションを準備できます。 ceph-volume ツールはインデックスを追加して OSD ID を作成します。

node1 で実行します。

ceph-volume lvm create --data /dev/sdb

上記の作成プロセスは 2 つの段階 (準備とアクティブ化) に分割できます。

ceph-volume lvm prepare --data /dev/sdb查看osd fsidceph-volume lvm listceph-volume lvm activate {ID} {FSID}各ノードの osd プロセスを開始します。

#node1systemctl restart ceph-osd@0systemctl enable ceph-osd@0 #node2systemctl restart ceph-osd@1systemctl enable ceph-osd@1#node3systemctl restart ceph-osd@2systemctl enable ceph-osd@2

ceph-mon デーモンを実行している各ノードで、ceph-mgr デーモンも設定する必要があります。

すべてのマネージャー ノードを実行する必要があります。

sudo -u ceph mkdir /var/lib/ceph/mgr/ceph-`hostname -s`cd /var/lib/ceph/mgr/ceph-`hostname -s`

ceph auth get-or-create mgr.`hostname -s` mon 'allow profile mgr' osd 'allow *' mds 'allow *' > keyringchown ceph.ceph /var/lib/ceph/mgr/ceph-`hostname`/keyring

systemctl enable ceph-mgr@`hostname -s` && systemctl start ceph-mgr@`hostname -s`或者ceph-mgr -i `hostname`

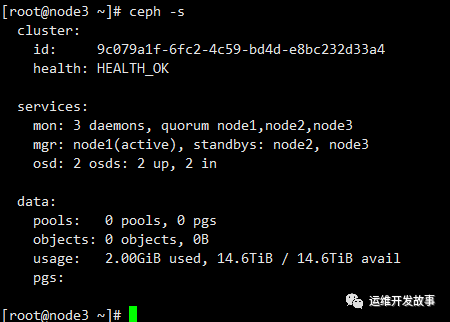

最後に ceph の実行ステータスを確認します。追加したのは 2 つの OSD だけです。

以上がZTE 新しいピボット システムのオフライン インストール ceph 16.2.10の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。