ターゲット検出は、コンピューター ビジョンにおける非常に重要な基本タスクです。一般的な画像分類/認識タスクとは異なり、ターゲット検出では、モデルが指定されたターゲット カテゴリに加えてターゲットの位置と位置をさらに与える必要があります。サイズ情報は、CV の 3 つの主要なタスク (識別、検出、セグメンテーション) において重要な役割を果たします。

現在普及しているマルチモーダル GPT-4 は、視覚的な目標認識能力のみを備えており、より困難な目標検出タスクを完了することはできません。画像やビデオ内のオブジェクトのカテゴリ、位置、サイズ情報を認識することは、自動運転における歩行者や車両の認識、セキュリティ監視アプリケーションにおけるフェイスロック、医療画像分析など、実際の生産における多くの人工知能アプリケーションの鍵となります。 、など。

YOLO シリーズ、R-CNN シリーズ、その他のターゲット検出アルゴリズムなどの既存のターゲット検出手法は、科学研究者の継続的な努力により、高いターゲット検出精度と効率を実現してきました。既存の手法では、モデルのトレーニング前に検出するターゲットのセット (閉セット) を定義する必要があるため、トレーニング セット外のターゲットを検出できません。たとえば、顔を検出するためにトレーニングされたモデルを車両の検出に使用することはできません。既存の手法は手動でラベル付けされたデータに大きく依存しているため、検出対象のカテゴリを追加または変更する必要がある場合、一方ではトレーニング データの再ラベル付けが必要になり、他方ではモデルのラベル付けが必要になります。再トレーニングには時間と労力がかかります。

考えられる解決策は、大量の画像を収集し、Box 情報とセマンティック情報を手動でラベル付けすることですが、これには非常に高額なラベル付けコストが必要となり、モデルのテストには大量のデータが使用されます。データのロングテール分布や手動アノテーションの不安定な品質などの要因は、検出モデルのパフォーマンスに影響を与えます。

CVPR 2021 で公開された記事 OVR-CNN [1] は、新しいターゲット検出パラダイム、つまりオープン語彙検出 (OVD、オープンワールドターゲット検出とも呼ばれる) を提案しています。前述の問題、つまりオープンワールドにおける未知のオブジェクトの検出シナリオです。

OVD は、注釈付きデータの量を手動で増やすことなく、任意の数とカテゴリのターゲットを識別して位置を特定できる機能により、提案されて以来、学界と産業界から継続的に注目を集めてきました。従来の目標検出タスクに新たな活力と新たな課題をもたらし、将来的には目標検出の新たなパラダイムとなることが期待されています。

具体的には、OVD テクノロジーでは、クラスフリー (クラスに依存しない) 領域検出器を変換することで、未知のカテゴリに対する検出モデルの検出能力を強化するために、大量の画像に手動でアノテーションを付ける必要はありません。大量のラベルなしデータでトレーニングされたクロスモーダル モデルと組み合わせて、画像領域の特徴と検出対象の説明テキストをクロスモーダルに配置することで、オープンワールドのターゲットを理解するターゲット検出モデルの能力を拡張します。

CLIP [2]、ALIGN [3]、R2D2 [4] など、クロスモーダルおよびマルチモーダルの大規模モデル作業の最近の開発は非常に急速です。また、その開発は、OVD の誕生と、OVD 分野における関連研究の急速な反復と進化を促進しました。

OVD テクノロジーには、2 つの重要な問題の解決が含まれます: 1) 領域情報とクロスモーダル大規模モデル間の適応を改善する方法; 2) パンカテゴリー ターゲットを改善する方法 検出器の新しいカテゴリに一般化する能力。これら 2 つの観点から、OVD 分野の関連研究を以下に詳しく紹介します。

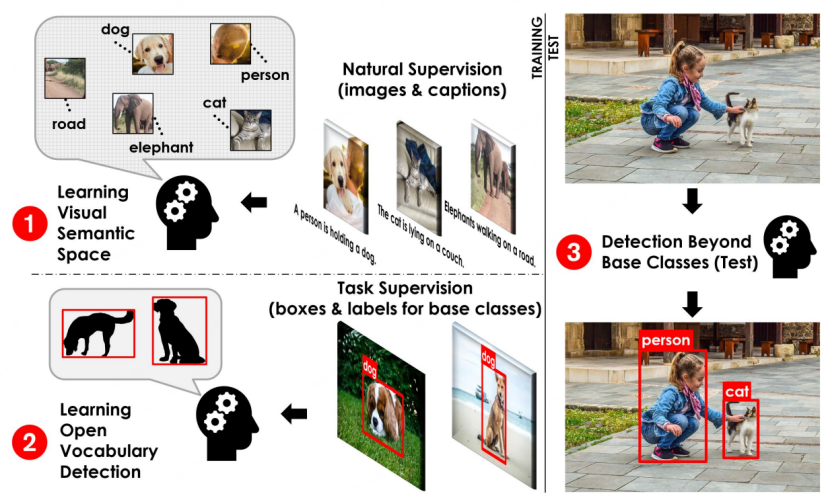

#OVD 基本プロセス図[1]

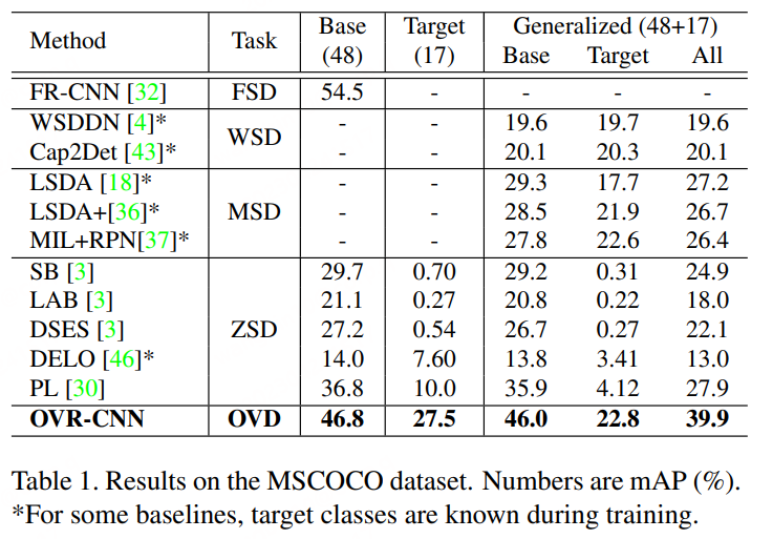

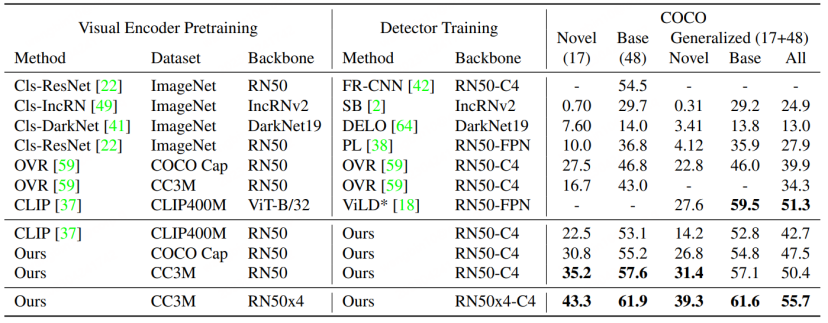

OVD の基本概念: OVD の使用には主に、少数ショットとゼロショットという 2 つのカテゴリのシナリオが含まれます。少数ショットとは、手動でラベル付けされた少数のトレーニング サンプルを含むターゲット カテゴリを指します。およびゼロショット 手動でラベル付けされたトレーニング サンプルが存在しないターゲット カテゴリを指します。一般的に使用される学業評価データセット COCO および LVIS では、データセットは Base クラスと Novel クラスに分割されており、Base クラスは少数ショットのシナリオに対応し、Novel クラスはゼロショットのシナリオに対応します。たとえば、COCO データ セットには 65 のカテゴリが含まれており、一般的な評価設定では、ベース セットには 48 のカテゴリが含まれており、これらの 48 カテゴリのみが少数ショット トレーニングで使用されます。 Novel セットには 17 のカテゴリが含まれており、トレーニング中にはまったく表示されません。テスト指標は主に Novel クラスの AP50 値を参照して比較しています。

論文 1: キャプションを使用したオープン語彙オブジェクトの検出

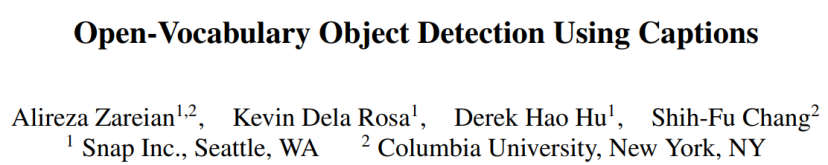

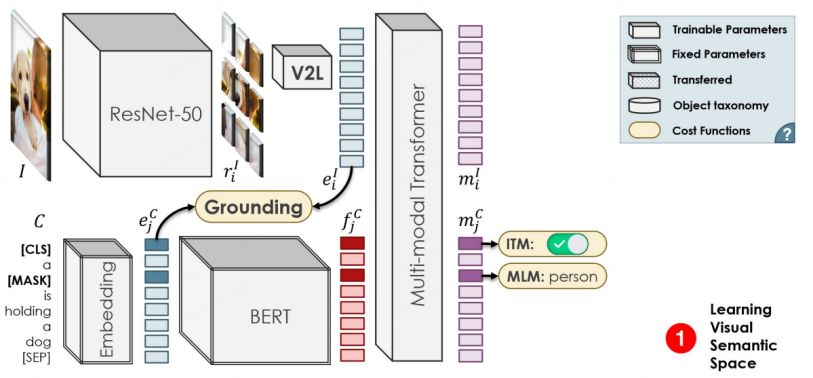

OVR-CNN は CVPR 2021 の口頭論文であり、OVD 分野の先駆的な研究です。その 2 段階のトレーニング パラダイムは、その後の多くの OVD 作品に影響を与えました。以下の図に示すように、最初のステージでは主に画像とキャプションのペアを使用してビジュアル エンコーダを事前トレーニングします。このステージでは、BERT (固定パラメータ) を使用してワード マスクを生成し、弱教師ありグラウンディング マッチングが ImageNet をロードした ResNet50 で実行されます。著者は、監視が弱いとマッチングが局所最適に陥ると考えているため、堅牢性を高めるために単語マスク予測にマルチモーダル Transformer を追加しています。

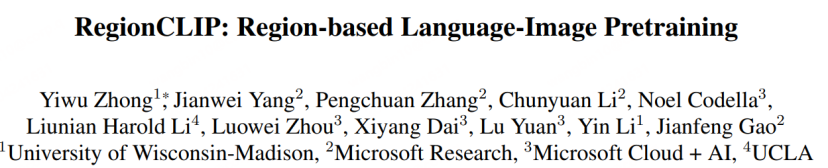

##文書アドレス: https://arxiv.org/abs/2112.09106

##文書アドレス: https://arxiv.org/abs/2112.09106

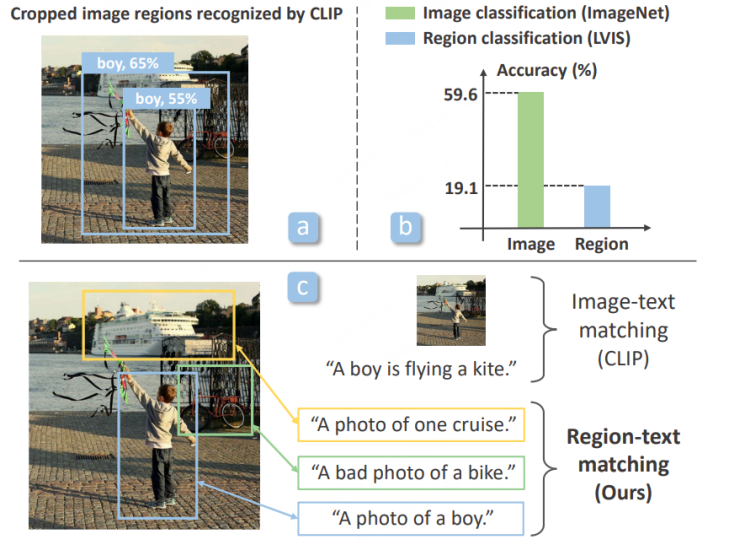

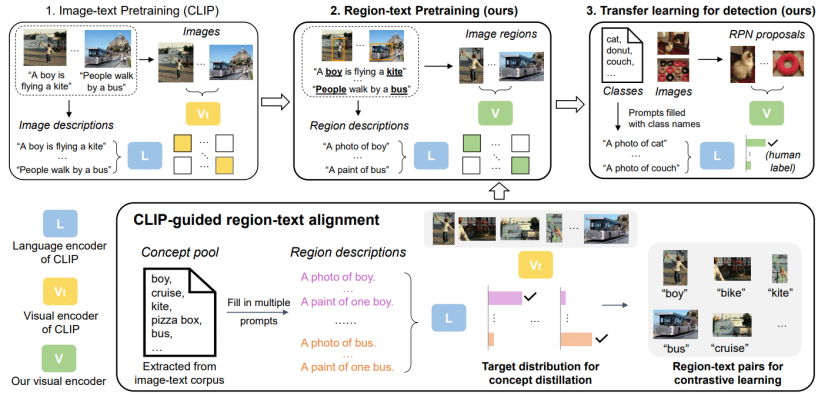

第一段階では、データセットは主に CC3M、COCO キャプション、その他の画像とテキストのマッチング データ セットを使用します。地域レベルの分析のための蒸留事前トレーニング。具体的には:

2. LVIS 事前トレーニングに基づく RPN を使用して提案領域を抽出し、元の CLIP を使用して、抽出されたさまざまな領域を準備された説明と照合および分類し、さらにそれらを偽造セマンティック ラベルに組み立てます。

3. 用意した提案領域と意味ラベルを用いて、新しいCLIPモデルに対して領域とテキストの比較学習を行い、領域情報に特化したCLIPモデルを取得します。

4. 事前トレーニングでは、新しい CLIP モデルは、蒸留戦略を通じて元の CLIP の分類能力も学習し、完全な画像レベルで画像とテキストの比較学習を実行します。 CLIPモデルは完全なイメージを表現する能力を持っています。

第 2 段階では、取得した事前学習モデルを検出モデルに転送して転移学習を行います。

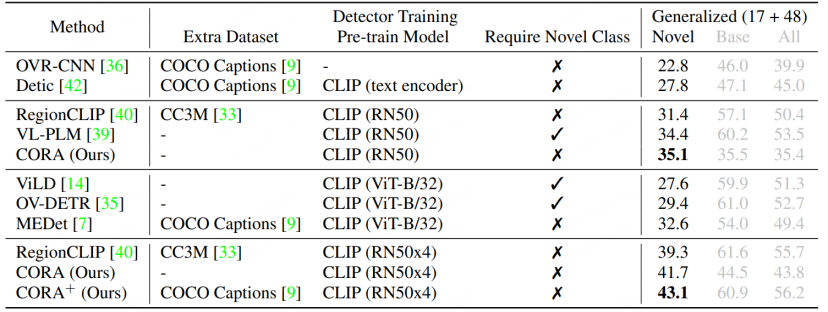

#RegionCLIP は、従来の検出モデル上で既存の大規模クロスモーダル モデルの表現機能をさらに拡張し、より優れたパフォーマンスを実現します。以下の図に示すように、RegionCLIP は OVR-CNN と比較して Novel カテゴリで大きな改善を達成しました。 RegionCLIP は、1 段階の事前トレーニングを通じて、領域情報とマルチモーダル大規模モデルの間の適応性を効果的に向上させますが、CORA は、1 段階のトレーニングに、より大きなパラメータースケールを持つより大きなクロスモーダル大規模モデルを使用すると、トレーニングコストが増加すると考えています。とても高くなります。

論文 3: CORA: 領域プロンプトとアンカーの事前マッチングによる未公開語彙検出のための CLIP の適応

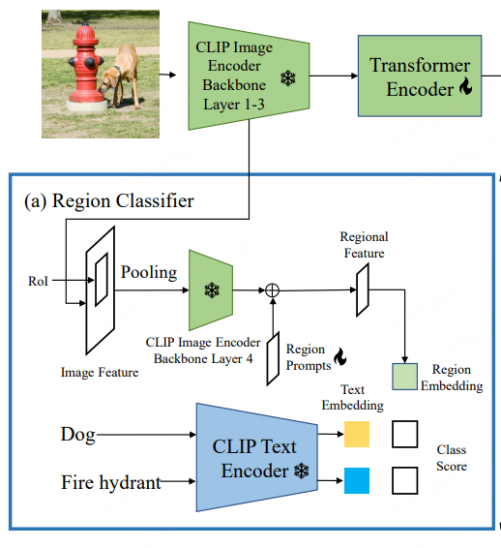

CORA [6] は CVPR 2023 に含まれています。CORA [6] が提案する現在の OVD タスクが直面する 2 つの障害を克服するために、DETR のような OVD モデルが設計されています。記事のタイトルに示されているように、モデルには主に領域プロンプティングとアンカー プレマッチングという 2 つの戦略が含まれています。前者は、Prompt 技術を使用して、CLIP ベースの地域分類器によって抽出された地域特徴を最適化し、全体と領域の間の分布ギャップを軽減します。後者は、DETR 検出手法のアンカー ポイント事前マッチング戦略を使用して OVD を改善します。新しいタイプのオブジェクトを配置するモデルの能力。

CLIP 画像全体の特徴と元のビジュアル エンコーダーの局所的特徴の間には分布ギャップがあり、その結果、分類精度が低くなります (これは、RegionCLIP の開始点と同様です)。したがって、CORA は、CLIP 画像エンコーダに適応し、地域情報の分類パフォーマンスを向上させるために、Region Prompting を提案します。具体的には、最初に画像全体が CLIP エンコーダの最初の 3 層を通じて特徴マップにエンコードされ、次に RoI Align によってアンカー ボックスまたは予測ボックスが生成され、領域特徴にマージされます。これは、CLIP 画像エンコーダの 4 番目の層によってエンコードされます。フル画像特徴マップと CLIP 画像エンコーダの地域特徴の間の分布ギャップを軽減するために、学習可能な地域プロンプトが設定され、第 4 層によって出力される特徴と結合されて、テキスト特徴で使用する最終的な地域特徴が生成されます。マッチングの場合、マッチング損失は単純なクロスエントロピー損失を使用し、CLIP に関連するパラメーター モデルはトレーニング プロセス中にすべてフリーズされます。

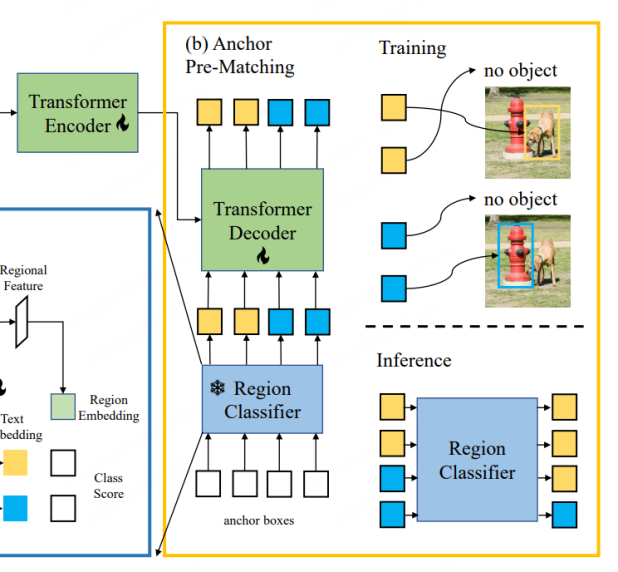

CORA は、DETR に似た DETR のような検出器モデルであり、アンカー事前マッチング戦略を使用して、フレーム回帰トレーニング用に事前に候補フレームを生成します。具体的には、アンカー プリマッチングでは、各ラベル ボックスを最も近いアンカー ボックスのセットと照合して、どのアンカー ボックスをポジティブ サンプルとみなすべきか、どのアンカー ボックスをネガティブ サンプルとみなすべきかを決定します。通常、このマッチング プロセスは IoU (交差対和集合比) に基づいており、アンカー ボックスとラベル ボックス間の IoU が事前に定義されたしきい値を超えている場合はポジティブ サンプルとみなされ、それ以外の場合はネガティブ サンプルとみなされます。 CORA は、この戦略が新しいカテゴリへのローカリゼーション能力の一般化を効果的に改善できることを示しています。

しかし、アンカー事前マッチング機構を使用すると、少なくとも 1 つのアンカー ボックスがラベル ボックスに一致する場合にのみトレーニングを正常に実行できるなど、いくつかの問題も発生します。それ以外の場合、ラベル ボックスは無視され、モデルの収束が妨げられます。さらに、ラベル ボックスがより正確なアンカー ポイント ボックスを取得したとしても、領域分類器の認識精度が限られているため、ラベル ボックスは依然として無視される可能性があります。つまり、ラベル ボックスに対応するカテゴリ情報は、ラベル ボックスに対応するカテゴリ情報と一致していません。 CLIP トレーニングに基づく領域分類子。したがって、CORA は CLIP-Aligned テクノロジーを使用して、CLIP の意味認識機能と事前トレーニングされた ROI の位置決め機能を利用して、少ない労力でトレーニング データ セット内の画像のラベルを再設定します。トレーニング より多くのタグ ボックスに一致します。

RegionCLIP と比較すると、CORA は COCO データ セットの AP50 値を 2.4 もさらに向上させます。

OVD テクノロジーは、現在人気のあるクロス/マルチモーダル大規模モデルの開発と密接に関連しているだけでなく、過去の科学研究者の目標も継承しています。検出分野における技術の蓄積は、従来の AI 技術と一般的な AI 機能の研究をうまく結び付けるものです。 OVDは、未来に向けた新たな目標検出技術であり、あらゆる目標を検出・位置特定できるOVDの能力は、マルチモーダル大型モデルのさらなる開発を促進し、マルチモーダルAGIの重要な基盤となることが期待されています。開発中。現在、マルチモーダル大規模モデルの学習データ ソースは、インターネット上の多数の大まかな情報ペア、つまりテキストと画像のペア、またはテキストと音声のペアです。 OVD テクノロジーを使用して、元の大まかな画像情報を正確に特定し、コーパスをフィルタリングするための画像の意味情報の予測を支援する場合、大規模モデルの事前トレーニング データの品質がさらに向上し、表現能力と理解能力が最適化されます。大型モデルの。

良い例は SAM (Segment Anything)[7] です。SAM を使用すると、科学研究者は一般的な視覚的な大規模モデルの将来の方向性を確認できるだけでなく、多くの思考のきっかけにもなります。 OVD テクノロジーを SAM とうまく連携させることで、SAM の意味理解能力を強化し、SAM に必要なボックス情報を自動的に生成することで、人的資源をさらに解放できることは注目に値します。 AIGC (人工知能生成コンテンツ) の場合と同様に、OVD テクノロジーはユーザーと対話する機能も強化できます。たとえば、ユーザーが写真内の特定のターゲットを指定して変更したり、ターゲットの説明を生成したりする必要がある場合、 OVD の言語理解機能と未知のターゲットを検出する OVD 機能を利用して、ユーザーが説明したオブジェクトを正確に特定し、より高品質のコンテンツ生成を実現します。 OVD 分野の関連研究は現在活況を呈しており、OVD 技術が将来の汎用 AI 大型モデルにもたらす可能性のある変化には期待に値します。

以上が大量のデータにラベルを付ける必要がなく、ターゲット検出 OVD の新しいパラダイムはマルチモーダル AGI をさらに一歩進めますの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。