2017 年、Google Brain チームは論文「Attending Is All You Need」で Transformer アーキテクチャを独創的に提案しました。それ以来、この研究はデバッグされ、NLP 分野で最も人気のあるモデルの 1 つになりました。 1 つは、さまざまな言語タスクで広く使用されており、多くの SOTA 成果を達成していることです。

それだけでなく、NLP の分野をリードしてきた Transformer は、コンピュータ ビジョン (CV) や音声認識などの分野を瞬く間に席巻し、優れた成果を上げてきました。画像分類、ターゲット検出、音声認識などのタスクが発生します。

#論文アドレス: https://arxiv.org/pdf/1706.03762 .pdf

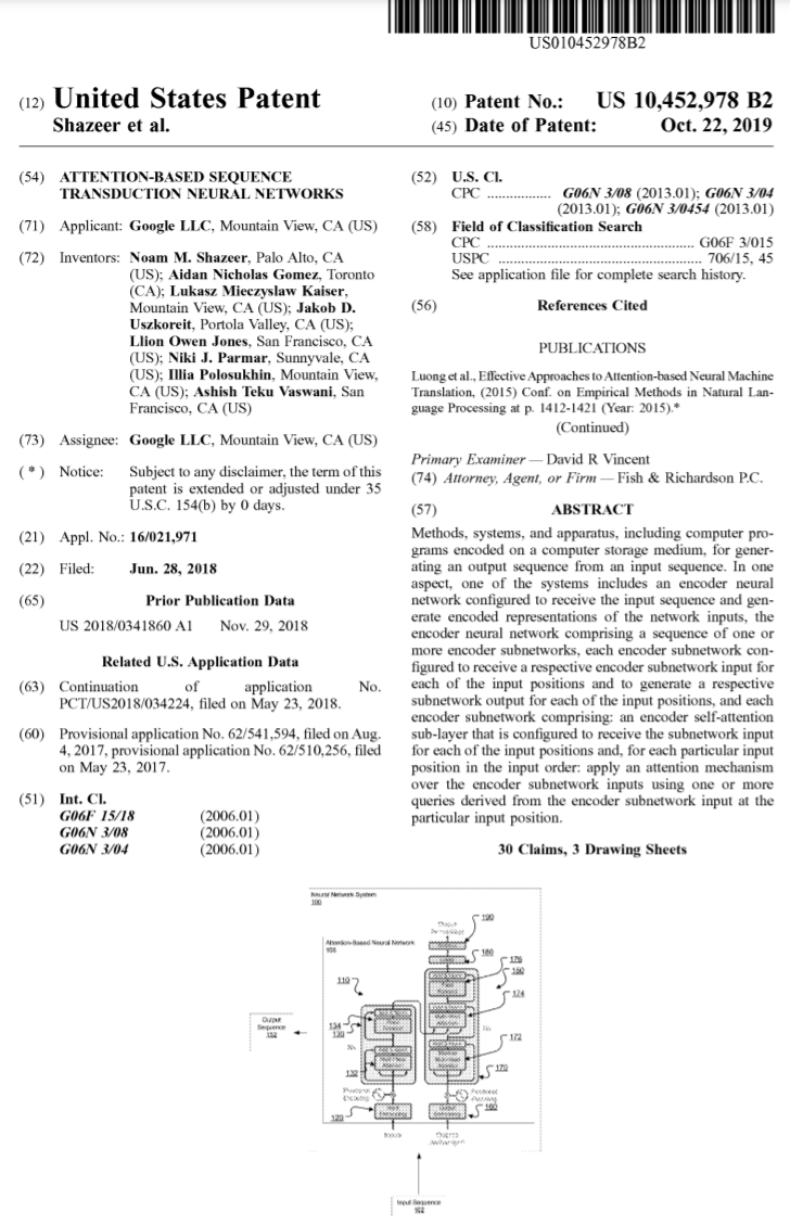

#発表以来、Transformer は多くのモデルのコア モジュールとなり、たとえば、おなじみの BERT、T5 などにはすべて Transformer が搭載されています。最近人気の ChatGPT も、すでに Google が特許を取得している Transformer に依存しています。

出典: https://patentimages.storage.googleapis.com /05 /e8/f1/cd8eed389b7687/US10452978.pdf

また、OpenAI がリリースした一連のモデル GPT (Generative Pre-trained Transformer) には、名前に Transformer が含まれています。トランス GPTシリーズの核となるモデルです。同時に、OpenAI の共同創設者である Ilya Stutskever 氏は最近、Transformer について話した際、Transformer が最初にリリースされたとき、実際には論文が公開されてから 2 日目だったと述べました。以前の研究を Transformer に切り替えるのを待って、GPT が導入されました。 Transformer の重要性は自明のことであることがわかります。

過去 6 年間にわたり、Transformer に基づいたモデルは成長し、開発を続けてきました。しかし今、誰かが元の Transformer 論文の誤りを発見しました。

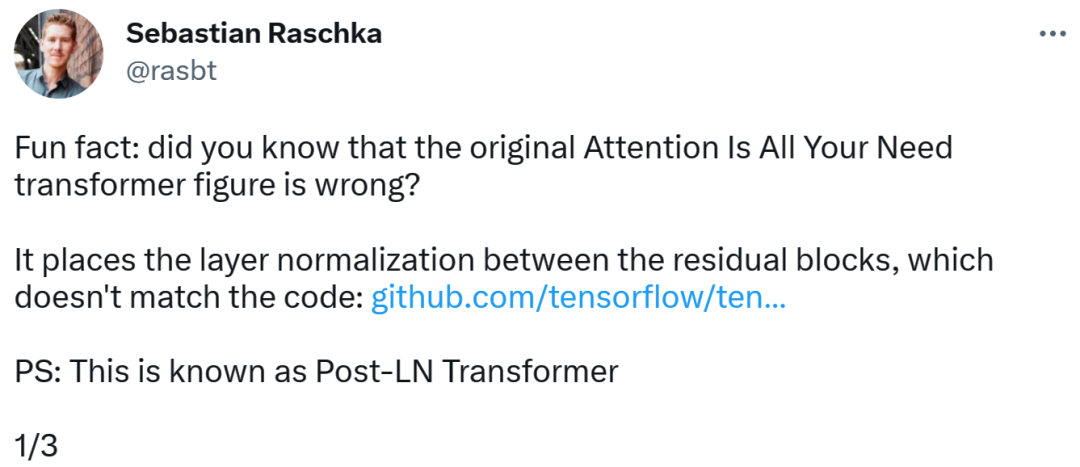

Transformer のアーキテクチャ図とコードは「一貫性がない」

エラーを発見したのは、著名な機械学習と AI 研究者であり主任 AI 教育者である Sebastian です。スタートアップ Lightning AI の Raschka。彼は、元の Transformer 論文のアーキテクチャ図が間違っており、残余ブロックの間に層正規化 (LN) が配置されており、コードと矛盾していると指摘しました。

矛盾しているコード部分は、82行目で「layer_postprocess_sequence="dan"」という実行シーケンスが記述されており、後処理ではdropout、residual_add、layer_normを順番に実行することを意味しています。上の図の左中央にある add&norm が次のように理解される場合: add は Norm の上にある、つまり、最初に Norm を付けてから add する場合、コードは確かに図と矛盾します。

コードアドレス:

https://github.com/tensorflow/tensor2tensor/commit/ f5c9b17e617ea9179b7d84d36b1e8162cb369f25#diff-76e2b94ef16871bdbf46bf04dfe7f1477bafb884748f08197c9cf1b10a4dd78e…

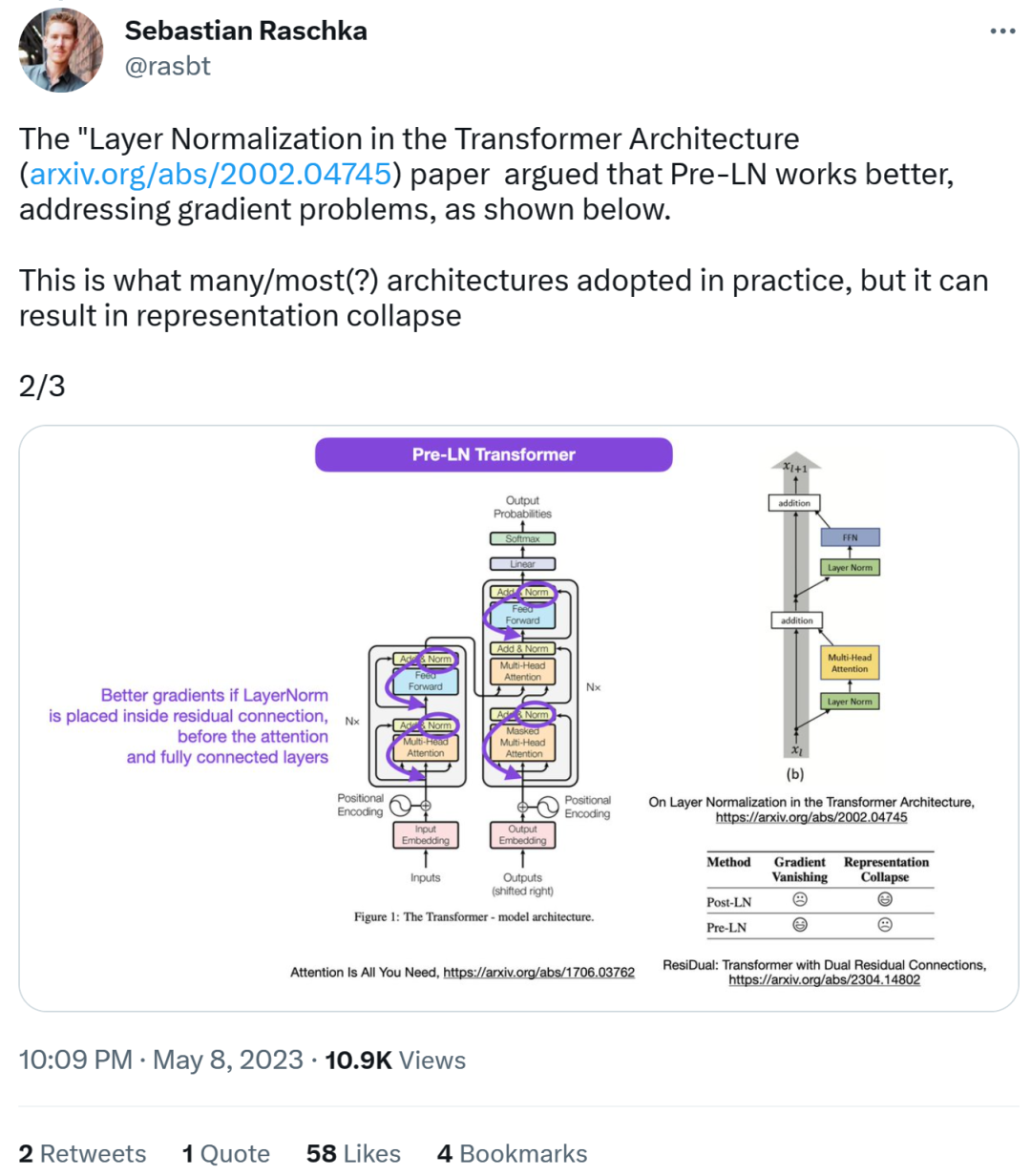

次に、Sebastian 氏は、論文「On Layer Normalization in the Transformer Architecture」では、Pre-LN のパフォーマンスが向上し、次のような問題を解決できると考えています。勾配の問題です。これは実際には多くのアーキテクチャで行われていることですが、表現の破損につながる可能性があります。

注目層と完全に接続された層の前の残りの接続に層の正規化を配置すると、より良い勾配を実現できます。

したがって、Post-LN または Pre-LN についての議論が続く一方で、別の論文がこれら 2 つの点をまとめて取り上げています。 「ResiDual: デュアル残留接続を備えたトランス」[2]。

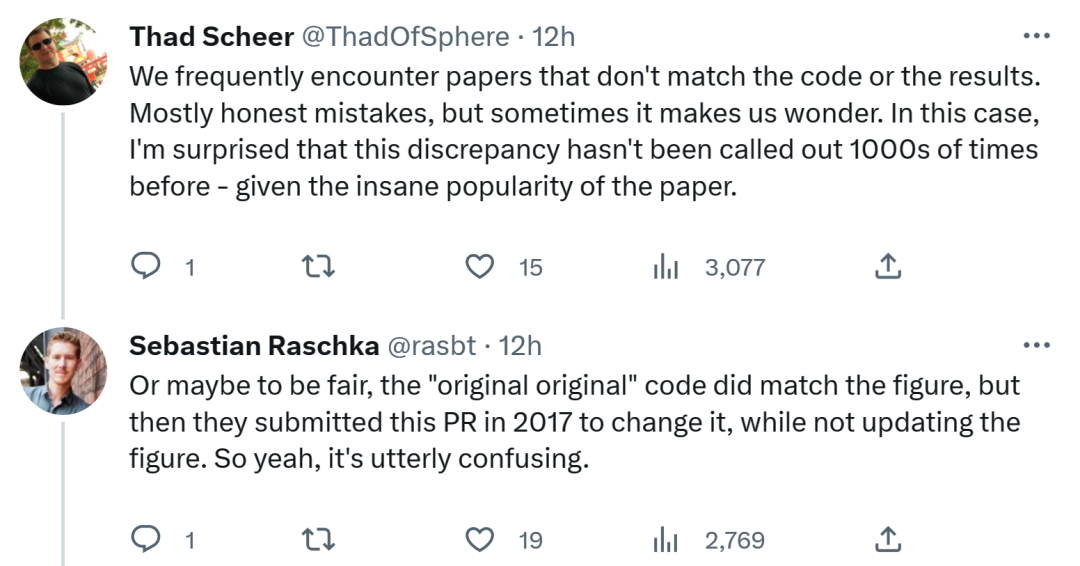

Sebastian の発見に関して、コードや結果と矛盾する論文に頻繁に遭遇すると考える人もいます。ほとんどは正直ですが、時には奇妙なこともあります。 Transformer 論文の人気を考慮すると、この矛盾については何千回も言及されるべきでした。

セバスチャンは、公平を期すために言うと、「最もオリジナルな」コードは確かにアーキテクチャ図と一致しているが、2017 年に提出されたコードのバージョンは変更されており、アーキテクチャ図は更新されていないと答えました。 。したがって、これは本当に混乱します。

あるネチズンはこう言いました、「コードを読むことに関して最悪なのは、コードを読んでしまうことだ」 #Google は今後どうするのだろうか コードを更新するのか、アーキテクチャ図を更新するのか、様子見です。

以上が「画像はコードと矛盾している。Transformer の論文に誤りが見つかった。ネットユーザー:1,000 回指摘されるべきだった。」の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。