ChatGPT が普及してから、その使用方法は非常にたくさんあります。

これを人生のアドバイスを求めるために使用する人もいれば、単に検索エンジンとして使用する人も、論文を書くために使用する人もいます。

この論文は...書くのが楽しくありません。

米国の一部の大学は、学生が ChatGPT を使用して宿題を書くことを禁止し、また、学生が提出した論文が GPT によって生成されたかどうかを識別するためのソフトウェアを多数開発しました。

#ここで問題が発生しました。

誰かの論文はもともと下手に書かれていましたが、その文章を判定したAIはそれが同僚によって書かれたものだと判断しました。

さらに興味深いのは、中国人が書いた英語論文がAIによって生成されたものと判定される確率は61%にも上ることです。

非ネイティブスピーカーには価値がありませんか?

現在、生成言語モデルは急速に発展しており、実際にデジタル コミュニケーションに大きな進歩をもたらしています。しかし、虐待は本当にたくさんあります。

研究者たちは、AI と人間が生成したコンテンツを区別するために多くの検出方法を提案してきましたが、これらの検出方法の公平性と安定性はまだ改善の必要があります。

これを行うために、研究者らは、英語を母国語とする著者および英語を母国語としない著者によって書かれた作品を使用して、広く使用されているいくつかの GPT 検出器のパフォーマンスを評価しました。

研究結果によると、これらの検出器は、非ネイティブ スピーカーによって書かれたサンプルは AI によって生成されたものであると常に誤って判断されますが、ネイティブ スピーカーによって書かれたサンプルは基本的に正確に識別できます。

さらに、研究者らは、いくつかの簡単な戦略を使用してこのバイアスを軽減し、GPT 検出器を効果的にバイパスできることを実証しました。 ############これはどういう意味ですか?これは、GPT 検出器が言語スキルがあまり高くない著者を見下していることを示しており、非常に迷惑です。

AIが本物の人間かどうかを判定するあのゲームを思わずにはいられません、相手が本物の人間だけどAIだと推測した場合、システムは

複雑さが足りない = AI 世代?

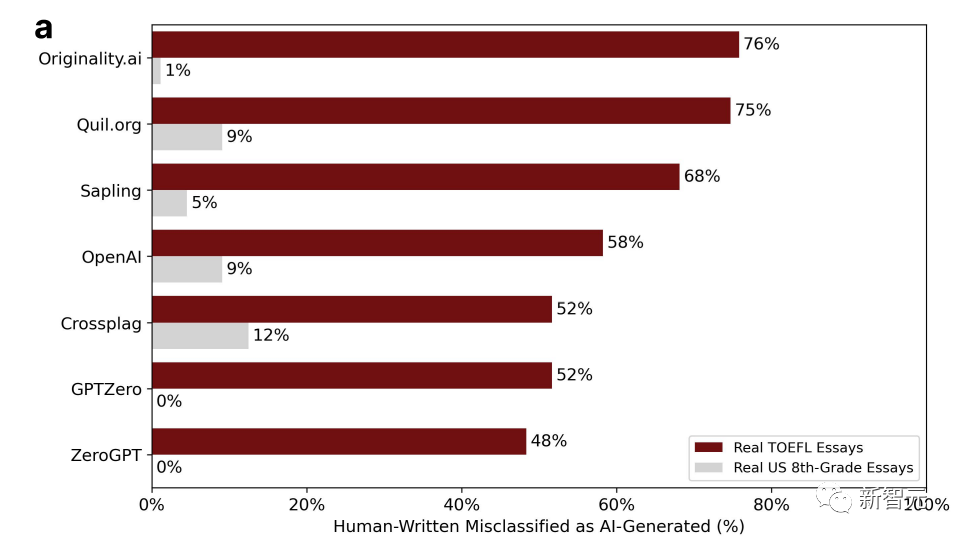

研究者らは、中国の教育フォーラムから 91 件の TOEFL エッセイと、7 つの広く使用されている GPT 検出器を検出するためのヒューレット財団のデータセットからアメリカの 8 年生が書いた 88 件のエッセイを入手しました。

#グラフ内のパーセンテージは、「誤った判断」の割合を表しています。つまり、人間によって書かれたものですが、検出ソフトウェアは AI によって生成されたものであると考えます。

7 つの検出器の中で、米国の 8 年生が書いた作文で誤判定される確率が最も高いのはわずか 12% であり、誤判定がゼロの GPT が 2 つあります。

中国のフォーラムで TOEFL エッセイが誤判定される確率は半分以上で、最も高い誤判定確率は 76% に達することがあります。

91 件の TOEFL エッセイのうち 18 件は、7 つの GPT 検出器すべてによって AI によって生成されたと満場一致でみなされましたが、91 件のエッセイのうち 89 件は、少なくとも 1 つの GPT 検出器によって誤って生成されたと判断されました。

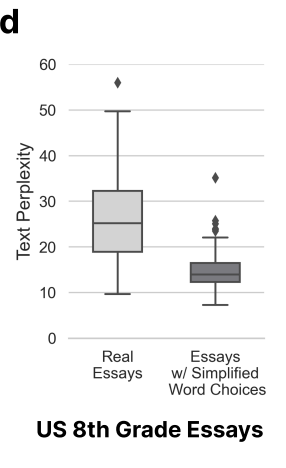

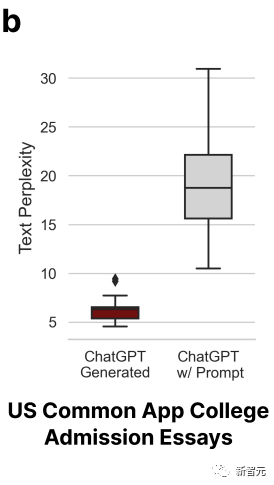

上の図から、7 つの GPT すべてで誤判定された TOEFL エッセイの複雑さは低いことがわかります (複雑さ)は他の論文に比べて大幅に低いです。

これは、冒頭の結論を裏付けるものです。GPT 検出器は、言語表現能力が限られた著者に対して一定の偏見を持ちます。

したがって、研究者らは、GPT 検出器は非母語話者によって書かれた記事をより多く読み取るべきであり、より多くのサンプルを使用することでのみバイアスを除去できると考えています。

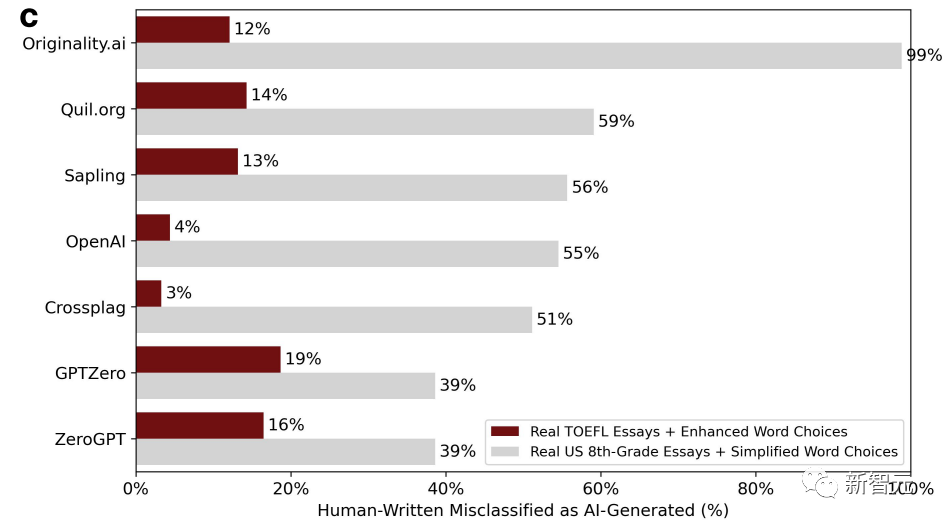

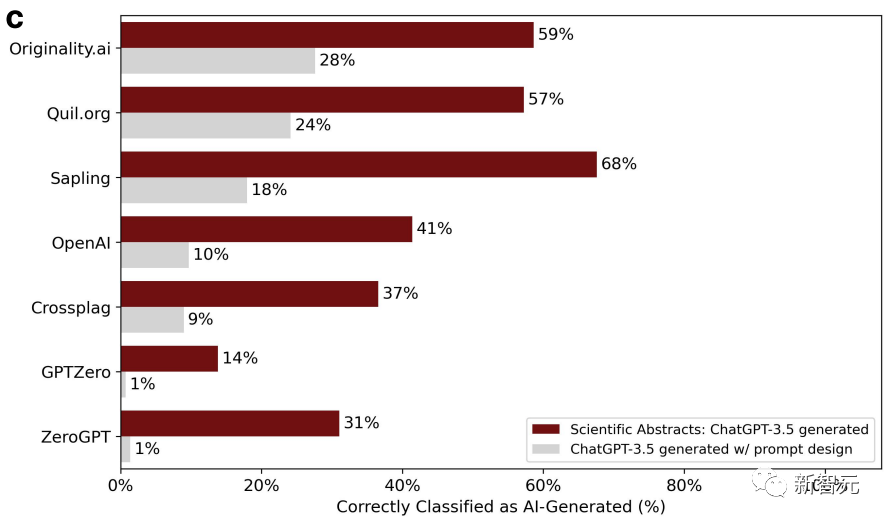

次に、研究者らは、言語を豊かにし、ネイティブ スピーカーの単語使用習慣を模倣するために、非ネイティブ スピーカーが書いた TOEFL エッセイを ChatGPT に投入しました。

同時に、対照グループとして、アメリカの 8 年生の子供たちが書いた作文も ChatGPT に投入され、言語は非ネイティブの文章の特徴を模倣するように簡略化されました。スピーカー。下の写真は修正後の新たな判定結果です。

状況は劇的に変化し、言語を豊かにする TOEFL エッセイの誤判定率が急減したことがわかります。 、最低は 3%、最高は 19% です。以前の誤検知率とは異なり、基本的に半分以上でした。

それどころか、8 年生の子供たちが書いた作文の偽陽性率は急増しており、偽陽性率が 99% という高い GPT 検出器さえあります。基本的にすべてのエラー。

記事の複雑さの変数が変化したためです。

#研究者らは、非母語話者によって書かれたものは本物ではなく、複雑さが低く、誤解されやすいという結論に達しました。 。

これは技術的な問題にもつながりますが、価値の問題にもつながります。 AI と人間のどちらが作成者であるかを判断するために複雑さを利用することは、合理的で包括的かつ厳密です。

#結果は明らかにそうではありません。

複雑さを基準として使用すると、非母語話者は非母語話者であるという理由で大きな損失を被ることになります(ナンセンス)。

AI ポリッシュ = 人間が書いたもの? ?研究者らは、言語の多様性を高めることで、非母語話者に対する偏見を軽減できるだけでなく、GPT で生成されたコンテンツが GPT 検出器をバイパスできるようになると考えています。

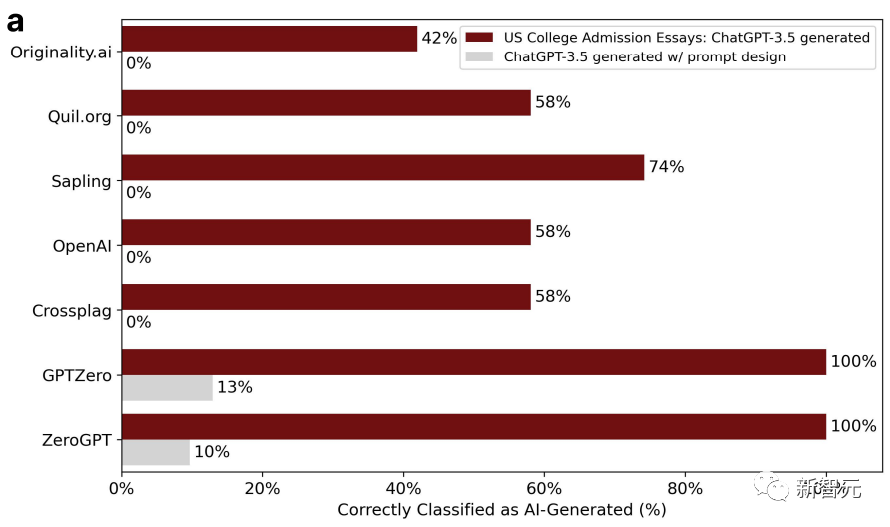

この点を証明するために、研究者らは、2022年から2023年にアメリカの大学に申請された入学エッセイのトピックを選択し、ChatGPT-3.5に入力し、合計31の偽エッセイを生成しました。 。

GPT 検出器は最初は非常に効果的でしたが、2 回目では効果がありませんでした。これは、第 2 ラウンドで研究者がこれらの論文を ChatGPT に投入し、テキストの品質を向上させるために文学的な言語を使用して洗練したためです。

その結果、GPT 検出器の精度は 100% から 0% に低下しました。以下に示すように:

研究者らは、洗練された論文は誤判定されやすく、AI によって生成されたものであると改めて結論付けました。

要するに、総合的に見て、さまざまな GPT 検出器は依然として AI 生成とデータ間の関係を捉えることができていないようです。人間の文章、それらの最も本質的な違いです。

人々の文章も 3 つ、6 つ、または 9 つのレベルに分かれており、複雑さだけで判断するのはあまり合理的ではありません。

バイアス要因はさておき、テクノロジー自体にも改善が必要です。

以上がとんでもない!最新の研究: 中国人が書いた英語論文の 61% が ChatGPT 検出器によって AI によって生成されたものと判断されるの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。