研究や商業目的で言語アプリケーションを作成するための包括的なリソースを個人に提供する、オープンソース言語モデルのエコシステムが成長しています。

この記事では、GPT4ALL について詳しく説明します。GPT4ALL は、ChatGPT のようなチャットボットを誰でも開発できるようにする包括的な構成要素を提供することで、特定の使用例を超えています。

GPT4ALL は、最先端のオープンソースの大規模言語モデルを使用する際に必要なサポートをすべて提供できます。オープンソースのモデルとデータセットにアクセスし、提供されたコードを使用してそれらをトレーニングおよび実行し、Web インターフェイスまたはデスクトップ アプリケーションを使用してそれらを操作し、分散コンピューティングのために Langchain バックエンドに接続し、簡単に統合するために Python API を使用できます。

開発者は最近、Apache-2 ライセンスの GPT4All-J チャットボットをリリースしました。このチャットボットは、単語による質問、複数回の会話、コード、詩、歌、物語など、アシスタントとの対話の大規模で精選されたコーパスでトレーニングされています。アクセスしやすくするために、Python バインディングとチャット UI もリリースされ、ほぼ誰でも CPU 上でモデルを実行できるようになりました。

ローカル チャット クライアントをデスクトップにインストールして、自分で試すことができます。

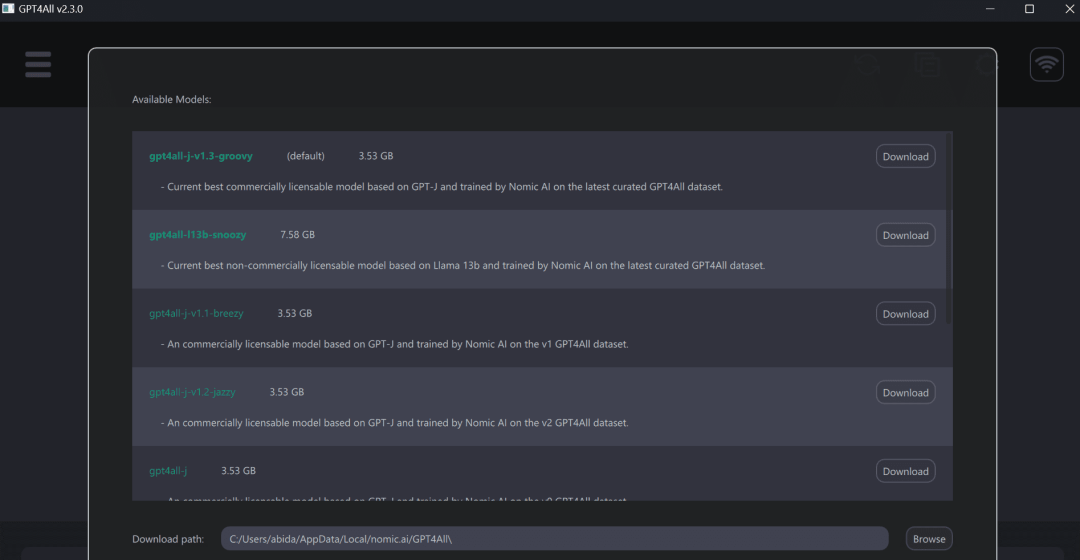

その後、GPT4ALL プログラムを実行し、選択したモデル自体をダウンロードします。ここ (https://github.com/nomic-ai/gpt4all-chat#manual-download-of-models) でモデルを手動でダウンロードし、GUI のモデル ダウンロード ダイアログで示された場所にインストールすることもできます。

GPT4ALL を使用すると、ラップトップでのエクスペリエンスが向上し、高速かつ正確な応答が得られます。 GPT4ALL は非常に使いやすいため、技術者でなくても簡単に使用できます。

GPT4ALL には、Python、TypeScript、Web チャット インターフェイス、および Langchain バックエンドが含まれています。

このセクションでは、nomic-ai/pygpt4all を使用してモデルにアクセスするための Python API について説明します。

<code>pip install pygpt4all</code>

<code>from pygpt4all.models.gpt4all import GPT4Alldef new_text_callback(text):print(text, end="")model = GPT4All("./models/ggml-gpt4all-l13b-snoozy.bin")model.generate("Once upon a time, ", n_predict=55, new_text_callback=new_text_callback)</code>さらに、コンバータを使用して推論をダウンロードして実行することもできます。モデル名とバージョンを入力するだけです。この記事の例では、改良された最新の v1.3-groovy モデルにアクセスしています。

<code>from transformers import AutoModelForCausalLMmodel = AutoModelForCausalLM.from_pretrained("nomic-ai/gpt4all-j", revisinotallow="v1.3-groovy")</code>nomic-ai/gpt4all リポジトリでは、トレーニングと推論のためのソース コード、モデルの重み、データセット、ドキュメントを入手できます。最初にいくつかのモデルを試してから、Python クライアントまたは LangChain を使用してそれらを統合できます。

GPT4ALL は、CPU 定量化された GPT4All モデル チェックポイントを提供します。アクセスするには、次の手順を実行する必要があります:

Linux :cd チャット;./gpt4all-lora-quantized-linux-x86

以上がGPT4ALL: 究極のオープンソース大規模言語モデル ソリューションの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。