過去 10 年間の AI の急速な発展は、大学、企業、個人開発者の協力の恩恵を受けており、 人工知能の分野はオープンソース コード、データ、チュートリアルで溢れています。 。

Google は AI 業界のリーダーでもあり、自然言語処理、コンピューター ビジョン、強化学習などの分野にわたる論文を発表し、AI 業界に貢献してきました。 Transformer、Bert、PaLM、その他多くの基本モデルとアーキテクチャ。

しかし、OpenAI はゲームのルールを破りました。 は Transformer で ChatGPT を開発しただけでなく、# などの新興企業の利点にも依存しました。 ## 法律と世論によって保護されている 影響は少ない , トレーニング データ、モデル サイズ、アーキテクチャ などの情報を開示する必要はなく、 Google などの大手企業から多くの従業員を引き抜いた、Google は立場を失いつつあります。

武道の倫理を持たない OpenAI を前にすると、Google は受動的に打ち負かすことしかできません。匿名の情報源から提供された情報によると、今年 2 月、

Google AI 責任者のジェフ ディーン は会議で次のように述べました。

Google は独自の AI の発見を活用し、研究成果が製品になった後にのみ論文を共有しますGoogle は独自の AI の発見を活用し、論文のみを共有しますラボでの作業が製品に変わった後

#Google は独自の AI の発見を利用し、ラボの作業が製品に変わった後にのみ論文を共有する 論文はラボの結果後にのみ共有される製品へと生まれ変わりました。

「防衛国家」に転じたGoogleは、同様のAI企業をすべて排除し、中核となる検索事業と株価をよりよく守りたいと考えているのかもしれない。

しかし、もし AI がこれらの大企業のようなオープンソースの精神を欠き、独占に転じたとしても、人工知能の分野におけるこれまでの開発の奇跡は依然として起こるのでしょうか?

Google が盗まれたのは「責任がありすぎる」ためです。数十億人のユーザーを抱える Google のような企業では、たとえ小規模な実験でも可能です。数百万人に影響を与えるでしょう。これが、Google がチャットボットの導入に消極的であり、「責任ある AI」という最終ラインに固執してきた理由です。

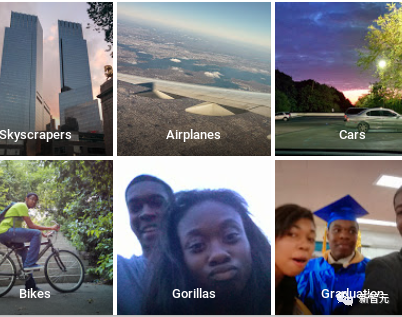

2015 年、Google フォトが画像分類機能を開始し、黒人男性をゴリラと誤分類したため、Google はすぐさま広報危機に陥り、すぐに謝罪と是正を行いました。

Googleの是正措置は、ゴリラのタグを直接削除し、プードルも削除することです。チンパンジー、サル、その他のカテゴリ。

その結果、画像分類器は黒人をオランウータンとして識別できなくなりましたが、本物のオランウータンを識別することはできなくなりました。

Google は長年人工知能技術の開発に多額の資金を投資してきましたが、ニューラル ネットワークはブラック ボックスで説明できないため、製品化後の制御性を完全に保証することはできません。これにより、より長いセキュリティ テストが必要となり、先行者利益が失われます。

今年 4 月、Google の CEO サンダー・ピチャイは、「60 Minutes」プログラムへの参加中に、人々は人工知能について注意する必要があると明言しました。社会への影響、フェイク画像や動画などの大きな被害。

Google が「責任を軽減する」ことを選択した場合、より多くの規制当局、人工知能研究者、ビジネスリーダーの注目を集めるのは避けられません。

しかし、ディープマインドの共同創設者ムスタファ・スレイマン氏は、それは彼らが慎重すぎるからではなく、既存の収益源やビジネスモデルを破壊したくないからだと語った。外部の脅威があったときにのみ目覚め始めます。

そして、この脅威はすでに到来しています。

Google に残された時間はあまり多くありません2010 年以来、Google は人工知能の新興企業を買収し、関連テクノロジーを徐々に自社製品に統合し始めました。

2013 年、Google はディープ ラーニングの先駆者でチューリング賞受賞者のヒントン氏を参加に招待しました (彼はちょうど辞任したばかりでした)。その 1 年後、Google はスタートアップの DeepMind

を 625 ドルで買収しました。Google の CEO に任命された直後、ピチャイ氏は、Google が基本戦略として「AI ファースト」を採用し、人工知能技術をすべての製品に統合すると発表しました。

###長年にわたる集中的な育成により、Google の人工知能研究チームは多くの進歩を遂げましたが、同時に、いくつかの小規模な新興企業も人工知能の分野で成果を上げています。

OpenAI はもともと、人工知能分野の企業買収における大手テクノロジー企業の独占をチェックするために設立されました。小規模企業の利点により、OpenAI は監視が少なく、人工知能モデルを一般ユーザーの手に迅速に提供したいという意欲があります。

つまり、人工知能の軍拡競争は監督なしで激化しており、競争に直面すると、大企業の「責任」は徐々に弱まる可能性があります。

Google の経営陣は、DeepMind がサポートする「人工知能技術のマッチング」や「超人的な知能」などの一般的な人工知能の概念の見通しも選択する必要があります。

今年 4 月 21 日、ピチャイ氏は、もともとジェフ ディーン氏が経営していた Google Brain と、以前に買収した DeepMind 社の合併を発表し、DeepMind の共同創設者兼 CEO を同社に任命しました。デミス・ハサビス氏: 人工知能分野における Google の進歩を加速するため。

ハサビス氏は、数年以内に、人工知能のレベルは、ほとんどの専門家の予測よりも人間の知能のレベルに近づく可能性があると考えています。

海外メディアが Google の現従業員および元従業員 11 名に実施したインタビューによると、ここ数カ月間、Google は人工的なシステムに変更を加えてきました。インテリジェンス ビジネスの見直しが行われ、主な目標は、製品を迅速に発売すること、実験的な AI ツールを小規模なユーザー グループに展開するための敷居を下げること、そして公平性などの分野で一連の新しい評価指標と優先順位を開発することです。

Pichai 氏は、Google が研究開発を加速しようとする試みは手抜きを意味するものではないと強調しました。

私たちは、一般的な人工知能の責任ある開発を確実にするために、より有能で安全、より責任あるシステムを構築することを目的とした新しい部門を設立しています。

1月に大量解雇の波で解雇された元Google Brain AI研究者のブライアン・キフン・リー氏は、その変化をGoogleが「平時」から「戦時」に移行していると表現した。激しく、すべてが変わります。戦時下では、競合他社の市場シェアの拡大も重要です。

Google の広報担当ブライアン ガブリエル氏は次のように述べています。Google は 2018 年に内部管理構造と包括的なレビュー プロセスを確立し、これまでにさまざまな製品分野で数百件のレビューを実施してきました。 Google は今後もこのプロセスを AI ベースのテクノロジー全体に適用し、責任を持って AI を開発することが同社にとっての最優先事項であり続けます。

しかし、AI 製品の市場投入時期を決定する基準の変化も、従業員の間で不安を引き起こしています。たとえば、Google は Bard のリリースを決定した後、実験的な AI 製品のグレードを下げました。テストのスコア基準は社内従業員の反対を引き起こしている。

2023 年初頭、Google は、Bard を中心とする 2 つの人工知能チーム (責任あるイノベーションと責任ある AI) によって設定された約 20 のポリシーを発表しました。従業員は一般に、これらの規制が非常に明確で完全であると信じていました。

また、一部の従業員は、これらの標準は外部向けのパフォーマンスのように策定されていると考えています。ユーザーがより明確に理解できるように、公開トレーニング データまたはオープンソース モデルを作成する方がよいでしょう。モデルの機能の説明。

研究開発を加速するという Google の決定は、従業員にとっては喜ばしいことでもあります。

幸いなことに、非科学研究職の従業員は概して楽観的で、この決定が Google の優位性を取り戻すのに役立つと信じています。

しかし、研究者にとっては、関連する人工知能の研究結果を発表する前に追加の承認を得る必要があるということは、急成長している生成人工知能の分野での最初の発表を逃すことになる可能性があります。 。 チャンス。

また、Google の倫理 AI チームが主導し、Timnit Gebru と Margaret Mitchell が共著した 2020 年の研究など、物議を醸す論文を Google が密かに抑圧するのではないかという懸念もあります。大規模な言語モデルの危険性。

過去 1 年間、多くのトップの人工知能研究者が新興企業に引き抜かれてきました。その理由の 1 つは、Google が研究者の研究を軽視し、過度に精査していることです。

論文の承認を得るには、上級研究者による厳密な反復が必要になる場合がある、と元 Google 研究者は述べています。 Googleは多くの研究者がこの分野のより広範な研究テーマに継続的に参加できるよう尽力しており、出版規制により別の研究者グループが離脱を余儀なくされる可能性がある。

Googleが開発を加速する中、大手人工知能メーカーに対し開発速度を落とすよう求め、この技術の開発速度が低下するとの考えから、あまり調和的ではない声もある。発明者の予想を上回りました。

ディープ ラーニングのパイオニアであるジェフリー ヒントンは、人間の制御から逃れる可能性のある超インテリジェント AI の潜在的な危険性に対する懸念の中で Google を退職しました。

消費者は、人工知能が事実を捏造する傾向など、大規模な言語モデルのリスクと限界を徐々に理解し始めていますが、ChatGPT の小さな活字の免責事項はそうではありません。制限を明確にします。

ChatGPT に基づくダウンストリーム アプリケーションでは、さらに多くの問題が明らかになりました。たとえば、スタンフォード大学のパーシー リャン教授がかつて調査を行ったところ、New Bing が提供する参考文献のうち正しいものは 70% のみであることがわかりました。 。

5 月 4 日、ホワイトハウスは Google、OpenAI、Microsoft の CEO を招いて会合を開き、AI テクノロジーと AI の規制方法に関する国民の懸念について話し合いました。

米国大統領バイデンは招待状の中で、AI企業は製品を一般に公開する前に製品の安全性を確保する必要があると明言した。

以上がGoogleはパニックになっています!論文を出版したい場合は、承認を得て製品開発を優先する必要があります。ChatGPT は人工知能分野の白鳥の歌ですか?の詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。