最近リリースされたテキスト生成ツールである ChatGPT は、研究コミュニティで激しい議論を引き起こしました。学生のエッセイを書いたり、研究論文を要約したり、質問に答えたり、使用可能なコンピュータ コードを生成したりでき、さらには医学試験、MBA 試験、司法試験に合格するのにも十分です...

主な質問 はい: ChatGPT を研究論文の著者として指名できますか?

さて、世界最大のプレプリント出版プラットフォームである arXiv からの公式の明確な答えは「ノー」です。

ChatGPT が登場する以前、研究者は長い間チャットボットを研究アシスタントとして使用して、思考を整理し、研究に対する洞察を生み出してきました。コーディングと研究文献の要約の支援。

こうした補助的な著作物は認められているようですが、「署名」となると全く別問題になります。 「明らかに、コンピュータ プログラムは論文の内容に責任を負うことはできません。また、arXiv の利用規約に同意することもできません。」

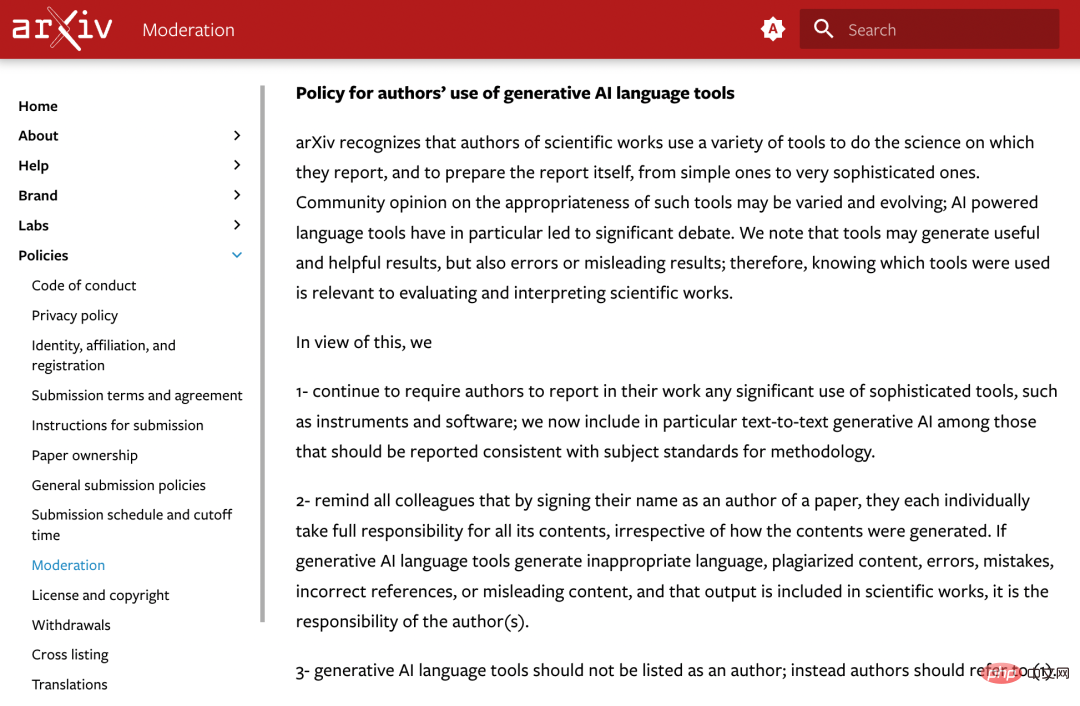

プレプリントや公開記事の中には、次のようなものがあります。正式に著者権は ChatGPT に与えられます。この問題に対処するために、arXiv は生成 AI 言語ツールの使用に関する作成者向けの新しいポリシーを採用しました。

公式声明は次のとおりです:

arXiv は、科学者がさまざまなツールを使用して報告対象の科学的研究を行っていることを認識しています。単純なツールから非常に複雑なツールまで、レポート自体を作成します。

これらのツールの適切性に関するコミュニティの見解はさまざまであり、常に変化しており、AI 主導の言語ツールは重要な議論を引き起こします。ツールは有益で役に立つ結果を生み出すこともありますが、誤ったまたは誤解を招く結果も生み出す可能性があることに注意してください。したがって、どのツールが使用されているかを理解することは、科学的研究の評価と解釈に関連します。

これに基づいて、arXiv は次のことを決定しました:

1. 続けてください。作成者に対して、作業における機器やソフトウェアなどの複雑なツールの使用を報告するよう要求します。現在、方法論的なトピックの基準を満たす報告すべきツールの中に、特に「テキストからテキストへの生成人工知能」が含まれています。

2. すべての同僚は、論文に自分の名前を署名することで、作成方法に関係なく、論文のすべての内容に対して各自が全責任を負うことを思い出させられます。生成 AI 言語ツールが不適切な言語、盗用されたコンテンツ、誤ったコンテンツ、誤った参照、または誤解を招くコンテンツを生成し、その出力が科学的著作物に組み込まれた場合、これは著者の責任となります。

3. 生成人工知能言語ツールは作成者としてリストされるべきではありません。1 を参照してください。

数日前、「ネイチャー」誌は、すべてのシュプリンガー・ネイチャー誌と共同で 2 つの原則を策定したと公に発表しました。既存の著者ガイドラインに原則が追加されました:

まず、大規模な言語モデリング ツールは、研究論文の名前付き著者として受け入れられません。なぜなら、どんな著作者であっても作品に対する責任は伴うものであり、AIツールはその責任を負うことができないからです。

第二に、大規模言語モデリング ツールを使用する研究者は、この使用法を方法または謝辞のセクションに文書化する必要があります。論文にこれらのセクションが含まれていない場合は、序文またはその他の適切なセクションを使用して、大規模な言語モデルの使用を文書化します。

これらの規制は、arXiv が発表した最新の原則と非常によく似ており、学術出版分野の組織はある程度の合意に達しているようです。

ChatGPT は強力な機能を備えていますが、学校の課題や論文出版などの分野での悪用が広範な懸念を引き起こしています。

機械学習カンファレンス ICML は次のように述べています。「ChatGPT は公開データに基づいてトレーニングされており、多くの場合同意なしに収集されるため、一連の責任が生じます。帰属の問題です。」

したがって、学術コミュニティは、ChatGPT などの大規模言語モデル (LLM) によって生成されたテキストを検出するための方法とツールの探索を開始しました。将来的には、コンテンツが AI によって生成されたかどうかを検出することが「審査プロセスの重要な部分」になる可能性があります。

以上がarXiv の公式ルールによると、ChatGPT などのツールを作成者として使用することは許可されていませんの詳細内容です。詳細については、PHP 中国語 Web サイトの他の関連記事を参照してください。